Skript "Quantitative Auswertung analytisch

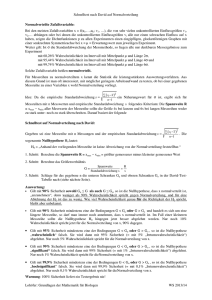

Werbung