K¨unstliche und Biologische Neuronale Netze

Werbung

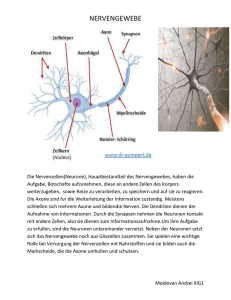

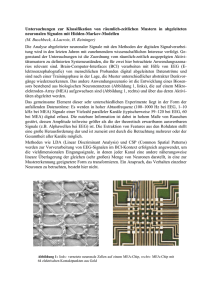

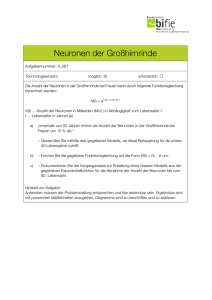

16 Künstliche und Biologische Neuronale Netze Forschungen zur Architektur Künstlicher Neuronaler Netze haben entscheidende Anregungen von Ergebnissen der Neurophysiologie erfahren. So hat sich gezeigt, dass über 90% der menschlichen Großhrinrinde sehr homogen aus sechs Schichten aufgebaut sind, innerhalb derer die Neuronen säulenförmig gekoppelt sind. Im Großen ergibt sich folgendes Bild: Neuronen in einer Säule erregen sich gegenseitig, erregen schwächer diejenigen in Nachbarsäulen und hemmen die Neuronen in weiter entfernten Säulen. Diese Eigenschaften werden in sog. KohonenNetzwerken simuliert, die in der Lage sind, Eingabemuster wie auf einer Karte zu repräsentieren. Die Struktur der Karten bildet sich dabei nach Ähnlichkeit und Häufigkeit der Eigabemuster selbsttätig aus; die selbstorganisierenden Kohonenkarten sind also ein Beispiel für das unüberwachte Lernen. Beim Menschen sind solche Karten im Kortex bekannt, die u.a. die Körperoberfläche des Menschen abbilden, wobei sensorisch sensibleren Teilen wie z.B. Händen und Lippen eine entsprechend größere Fläche korrespondiert. Die Informationsverarbeitung mit diesen Karten erfolgt in modularer Weise: Eine Karte bildet ein Modul in einer Gruppe von Modulen, die miteinander zusammenarbeiten. Dies hat offensichtlich Effizienzvorteile. In diesem Zusammenhang sei noch eine weitere Besonderheit des menschlichen Kortex erwähnt: Was ihn auszeichnet, ist seine Plastizität. Anhand der Unteruchung behinderter Menschen konnte bei verschiedenen Behinderungen nachgewiesen werden, dass offensichtlich erhebliche Reorganisationsprozesse im Kortex stattfinden. So etwa im Gefolge der Amputation von Gliedmassen oder bei Blinden, bei denen sich die Kortexfläche für den lesenden Zeigefinger mit dem Erlernen der Blindenschrift nachweisbar vergößert. Es wird vermutet, dass aufgrund der gleichförmigen Organsiation des Kortex dies nicht nur für sensorische Kortexareale gilt, sondern auch für höhere“, die für weitere kognitive Prozesse massgeblich ” sind. Künstliche Neuronale Netzwerke, in denen jedes Neuron mit allen anderen Neuronen verbunden ist, wurden 1982 zuerst von dem Physiker John Hopfield entworfen. Diese autoassoziativen Netzwerke werden deshalb auch als HopfieldNetzwerke bezeichnet. Sie haben in Verbindung mit der Hebbschen Lernregel die folgenden Eigenschaften: (1) Ein Eingangssignal in Form eines räumlich verteilten Musters von Aktivierung und Nicht-Aktivierung kann als Aktivierungsmuster aktivierter und inaktivierter Neuronen gespeichert werden. Werden einige Neuronen angeregt, geben sie diese Anregung weiter und empfangen ihrerseits Anregungen von anderen Neuronen. Mit der korrespondierenden Veränderung der Synapsengewichte kann sich ein solches Netzwerk in einen stabilen Zustand entwickeln, der als assoziatives Speicherabbild interpretierbar ist. In der Sprache der dynamischen Systeme wird ein solcher Zustand auch Attraktor genannt. (2) HopfieldNetze können mehr als einen Attraktor ausbilden. Es wurde gezeigt, dass die maximale Anzahl speicherbarer Muster bei ca. 13% der Gesamtzahl der Neuronen liegt. (3) Der Zugriff auf die gespeicherten Muster kann über die die Vorlage eines Teils des gspeicherten Musters erfolgen. Sind etwa Bilder von menschlichen Gesichtern gespeichert, so genügt ein Teilbild oder ein verrauschtes Bild eines Gesichts, um es anhand der gespeicherten Muster zu vervollständigen. (4) Entspricht das vorgelegte Muster nicht exakt einem der gespeicherten, sondern ist es einem solchen nur hinsichtlich bestimmter Merkmalsausprägungen ähnlich, so 17 konvergiert der Aktivierungszustand des Netzwerks in Richtung dieses Musters. Man spricht in diesem Zusammenhang auch von der Generalisierungsfähigkeit von Hopfield-Netzen. Mit ihnen kann also die Ausbildung neuronaler Verbindungsstrukturen in biologischen Neuronennetzen simuliert werden. Versucht man, rückgekoppelte Netzwerke im Schema von Reiz und Rekation zu charakterisieren, so kann man sagen, dass ihr Verhalten“, dargestellt durch den Wechsel ihrer Aktivierungs” zustände in der Zeit, nicht nur von den Eingabemustern abhängt, sondern auch von den unmittelbar vorangegangenen Aktivierungen — die ja auch ein Teil der Eingabe sind. Damit können solche Netzwerke grundsätzlich zeitliche Muster, d.h. Regelmäßigkeiten in Folgen verarbeiten. Nicht mehr einzelne Muster, sondern ihre Abfolge ist für die Verarbeitung entscheidend. Damit ist eine neue Qualitätsstufe erreicht: Es wurde der Übergang von der statischen, isolierten Musterklassifikation zur Musterklassifikation im zeitlichen Kontext vollzogen. Sofern die Gehirnanalogie“ Künstlicher Neuronaler Netze nicht nur auf ei” ne oberflächliche Ähnlichkeit rekurriert, sondern trotz ihres hohen Abstraktionsgrads und damit einhergehender erheblicher Vereinfachungen — wenn man an die physikalisch-chemischen Detailprozesse biologischer Neuronen denkt — als Paradigma der Netzwerkforschung gesehen wird, ergeben sich für die Zukunft enorm spannende, aber auch höchst komplizierte Herausforderungen. Wir hatten gesehen, dass jede Synapse zwei Arten der Verarbeitung leistet. In einfacher Weise gesehen, verarbeitet sie Signale, indem sie diese über die Zeit summiert. Das heißt, sie ist fähig, erst dann eine Ausgabe zu erzeugen, wenn mehrere Impulse kurz aufeinander folgend eintreffen. Synapsen können aber auch räumlich summieren: Eine Eingabe an einer Synapse muss noch keine Ausgabe bewirken, sondern diese erfolgt erst dann, wenn mehrere Signale zu etwa der gleichen Zeit bei verschiedenen Synapsen desselben Neurons eintreffen. Die zweite Art der Verarbeitung — neben der zeitlichen und räumlichen Summation — besteht darin, dass eine Synapse ihre Verarbeitungskapazität, also Qualität, als Ergebnis ihrer Erfahrungen“ verändern kann, wodurch sie die Verschaltung“ und damit das ” ” Verhalten des Gehirns verändert. Darin, so glaubt man, liegt die Voraussetzung für adaptives Lernen. Weiterhin hat man detaillierte Kenntnisse über die Zuordnung bestimmter Regionen der Großhirnrinde zu bestimmten kognitiven Leistungen wie Sehen, Hören und Sprechen sowie über die hauptsächlichen Charakteristika der linken und rechten Gehirnhälfte. Seit den Untersuchungen von Broca und Wernicke im 19. Jahrhundert weiss man, dass die menschliche Sprachfähigkeit von der Funktionstüchtigkeit bestimmter Regionen der Großhirnrinde der linken Gehirnhälfte abhängt. Detaillierten Aufschluss gaben Versuche mit elektrischen Reizungen bestimmter Partien durch Penfield u.a. um 1959. Auch über die Aufgabenteilung“ bei ” der kognitiven Verarbeitung hat man detailliertes Wissen aufgrund der Erkenntnis, dass das Zentralnervensystem hierarchisch organisiert ist, ableiten können, z.B., dass ein bestimmtes Muster der kortikalen Organisation allgemein zu sein scheint: Interpretierende Regionen der Gehirnrinde liegen in unmittelbarer Nähe zu den Zonen, die Sinnesreize empfangen, und dieses Organisationsprinzip gilt für alle Formen der Wahrnehmung. Jede der beiden Gehirnhälften ist hochgradig parallel organisiert, doch ist jede in anderer Weise — was durchaus ökonomisch erscheint — spezialisiert“: Offenbar weisen sie unterschiedliche Modalitäten des ” Denkens auf. Der linken Hemisphäre ist primär das analytische, systematische Denken eigen, während die rechte eher ganzheitlich“, holistisch arbeitet. So ge” 18 schieht die Sprachverarbeitung überwiegend im Zentrum der linken, die räumliche Orientierung und die Produktion und Aufnahme von Musik überwiegend in der rechten Hemisphäre. Beide Hälften sind durch eine Brücke, das sog. corpus callosum verbunden, das aus ca. 200 Millionen Nervenfasern besteht und über das beide Hemisphären mit ca. vier Milliarden Impulsen pro Sekunde kommunizieren. Da die Reize körperlicher Empfindungen jeder Körperseite in die jeweils gegenüberliegende Gehirnhälfte geleitet werden, ist diese Verbindung auch für die menschliche Sprachverarbeitung von außerordentlicher Bedeutung, denn die rechte Hemisphäre hat nicht dasselbe Potential für Sprachverarbeitung wie die linke. Was schon für normale Rechner gilt, muss erst recht auf die kognitive Verarbeitung zutreffen: Aus einer Untersuchung des Verlaufs der Signale in einer Schaltung kann nicht auf Sinn und Bedeutung des ablaufenden Programms geschlossen werden. Ob es je gelingen wird, diese Lücke zu schliessen, ist sicher nicht nur eine empirische Frage der Neurophysiologie, sondern ebenso auch eine methodische.