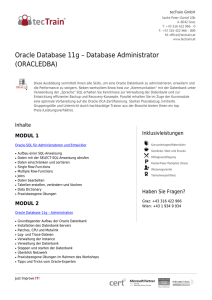

K omprimierung in der Datenbank

Werbung