Effektkodierung in der Varianzanalyse

Werbung

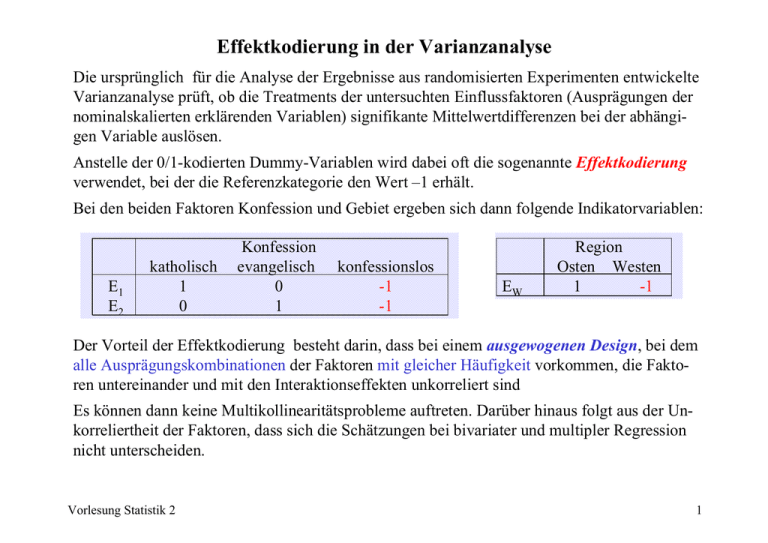

Effektkodierung in der Varianzanalyse Die ursprünglich für die Analyse der Ergebnisse aus randomisierten Experimenten entwickelte Varianzanalyse prüft, ob die Treatments der untersuchten Einflussfaktoren (Ausprägungen der nominalskalierten erklärenden Variablen) signifikante Mittelwertdifferenzen bei der abhängigen Variable auslösen. Anstelle der 0/1-kodierten Dummy-Variablen wird dabei oft die sogenannte Effektkodierung verwendet, bei der die Referenzkategorie den Wert –1 erhält. Bei den beiden Faktoren Konfession und Gebiet ergeben sich dann folgende Indikatorvariablen: E1 E2 katholisch 1 0 Konfession evangelisch 0 1 konfessionslos -1 -1 EW Region Osten Westen 1 -1 Der Vorteil der Effektkodierung besteht darin, dass bei einem ausgewogenen Design, bei dem alle Ausprägungskombinationen der Faktoren mit gleicher Häufigkeit vorkommen, die Faktoren untereinander und mit den Interaktionseffekten unkorreliert sind Es können dann keine Multikollinearitätsprobleme auftreten. Darüber hinaus folgt aus der Unkorreliertheit der Faktoren, dass sich die Schätzungen bei bivariater und multipler Regression nicht unterscheiden. Vorlesung Statistik 2 1 Effektkodierung in der Varianzanalyse Um dies zu demonstrieren, werden anstelle der 3353 Fälle aus jeder der sechs Ausprägungskombinationen von Konfession und Region 50 Fälle zufällig ausgewählt. Region Konfession Westen keine Westen protestantisch Westen katholisch Osten keine Osten protestantisch Osten katholisch Insgesamt Mittelwert alle Fälle 1.51 2.09 2.48 1.02 1.56 1.81 1.85 Mittelwert n=6×50 1.68 2.02 2.68 0.92 1.52 1.76 1.76 Deskriptive Statistiken Mittelwert Standardab weichung 1.76 1.666 300 .00 .818 300 .00 .818 300 .00 1.002 300 .00 .00 .818 .818 300 300 Y Ablehnung von Schwangerschaft sabbrüchen e1 Katholik (Effektkodierung) e2 Protestant (Effektkodierung) ew Region (Effektkodierung) e1w E1 mal EW e2w E2 mal EW Vorlesung Statistik 2 N Wie die SPSS-Ausgabe der univariaten Statistiken zeigt, sind bei Effektkodierung und gleichen Fallzahlen in allen Gruppen die Mittelwerte aller Prädiktoren (E1, E2, EW) einschlißlich der der Modellierung von Interaktionseffekte (E1W = E1·EW, E2W = E2·EW) null. 2 Effektkodierung in der Varianzanalyse Korrelationen Korrelation nach Pearson Y Ablehnung von Schwangerschaft sabbrüchen e1 Katholik (Effektkodierung) e2 Protestant (Effektkodierung) ew Region (Effektkodierung) e1w E1 mal EW e2w E2 mal EW Y Ablehnung von Schwangersc haftsabbrüche n e1 Katholik (Effektkodie rung) e2 Protestant (Effektkodieru ng) ew Region (Effektkodie rung) 1.000 .226 .115 -.218 -.020 .032 .226 1.000 .500 .000 .000 .000 .115 .500 1.000 .000 .000 .000 -.218 .000 .000 1.000 .000 .000 -.020 .032 .000 .000 .000 .000 .000 .000 1.000 .500 .500 1.000 e1w E1 mal EW e2w E2 mal EW Darüber hinaus sind die Designvariablen verschiedener Faktoren (E1 mit EW, E2 mit EW) und die Korrelationen mit den Prädiktoren der Interaktionseffekte (E1 mit E1W, E1 mit E2W, E2 mit E1W, E2 mit E2W, EW mit E1W, EW mit E2W) unkorreliert. Korrelationen gibt es nur unter den Designvariablen eines Faktors (E1 mit E2 und E1W mit E2W). Daher sind die Regressionsgewichte bivariater und multipler Regression identisch. Vorlesung Statistik 2 3 Effektkodierung in der Varianzanalyse Koeffizientena Modell 1 (Konstante) ew Region (Effektkodierung) Nicht standardisierte Koeffizienten Standardf B ehler 1.763 .094 -.363 .094 Standardisie rte Koeffizienten Beta -.218 T 18.751 Signifikanz .000 -3.864 .000 Effektkodierung: Bivariate Regression von Y auf Region: b1 = –0.363. a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Koeffizientena Modell 1 (Konstante) e1 Katholik (Effektkodierung) e2 Protestant (Effektkodierung) ew Region (Effektkodierung) e1w E1 mal EW e2w E2 mal EW Nicht standardisierte Koeffizienten Standardf ehler B 1.763 .092 Standardisie rte Koeffizienten Beta T 19.173 Signifikanz .000 .457 .130 .224 3.511 .001 .007 .130 .003 .051 .959 -.363 .092 -.218 -3.951 .000 -.097 .113 .130 .130 -.047 .056 -.743 .871 .458 .384 Effektkodierung: Multiple Regression von Y auf Region: b3 = –0.363. a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Vorlesung Statistik 2 4 Effektkodierung in der Varianzanalyse Region Konfession Westen keine Westen protestantisch Westen katholisch Osten keine Osten protestantisch Osten katholisch Insgesamt Koeffizienten Konstante E1 (katholisch) E2 (protestantisch) EW (Region:Osten) E1×EW E2×EW b0 b1 b2 b3 b4 b5 1.76 0.46 0.01 –.36 –.10 0.11 Mittelwert alle Fälle 1.51 2.09 2.48 1.02 1.56 1.81 1.85 Mittelwert n=50 1.68 2.02 2.68 0.92 1.52 1.76 1.76 1.76 0.46 = (2.68+1.76)/2 – 1.76 0.01 = (2.02+1.52)/2 – 1.76 –0.36 = (0.92+1.52+1.76)/3 – 1.76 –0.10 = 1.76 –(1.76 +0.46 –0.36) 0.11 = 1.52 –(1.76 +0.01 –0.36) Gesamtmittelwert (Grand Mean) mittlere Aweichung der Katholiken mittlere Aweichung der Protestanten mittlere Aweichung im Osten Aweichung Kathol. im Osten Aweichung Prot. im Osten Zur Unterscheidung von den Interaktionseffekten werden die einfachen Effekte der Faktoren in der Varianzanalyse üblicherweise als Haupteffekte bezeichnet. Die Regressionsgewichte der Haupteffekte geben die Abweichungen vom Gesamtmittelwert (engl.: grand mean) wieder, die Regressionsgewichte der Interaktionseffekte die Abweichungen vom jeweiligen Gruppenmittelwert. Vorlesung Statistik 2 5 Effektkodierung in der Varianzanalyse Für die F-Tests der Varianzanalyse werden folgende Regressionsmodelle geschätzt: M1: Y = β0 + β1·E1 + β2·E2 + β3·EW +β4·(E1·EW) + β5·(E2·EW) M2: Y = β0 + β4·(E1·EW) + β5·(E2·EW) M3: Y = β0 + β3·EW +β4·(E1·EW) + β5·(E2·EW) M4: Y = β0 + β1·E1 + β2·E2 + β4·(E1·EW) + β5·(E2·EW) M5: Y = β0 + β1·E1 + β2·E2 + β3·EW + U1 + U2 + U3 +U4 + U5 alle Effekte nur Interaktionseffekte ohne Konfession ohne Region ohne Interaktionseffekte Die Modelle führen zu folgenden Variationszerlegungen: Variation der Modell Vorhersagewerte M1 84.177 M2 2.247 M3 41.850 M4 44.574 M5 81.930 df 5 2 3 4 3 Variation der Residuen df 746.020 294 827.950 297 788.347 296 785.623 295 748.267 296 Beschreibung alle Effekte nur Interaktionseffekte ohne Konfession ohne Region ohne Interaktionseffekte Ein Effekt wird getestet, indem jeweils mit einem F-Test geprüft wird, ob die Erklärungskraft des Modells ohne den zu prüfenden Faktor sich vom Modell mit allen Effekten unterscheidet. Vorlesung Statistik 2 6 Effektkodierung in der Varianzanalyse Variation der Modell Vorhersagewerte M1 84.177 M2 2.247 M3 41.850 M4 44.574 M5 81.930 F= (SSE0 − SSE1 ) / J SSE1 /(n − K − J − 1) Test von Konfess+Region Konfess Region Interaktionseffekte Gesamtmodell Vorlesung Statistik 2 Variation der Residuen df 746.020 294 827.950 297 788.347 296 785.623 295 748.267 296 df 5 2 3 4 3 = R − R )/J ( = /(n − K − J − 1) (1 − R ) /(n − K − J − 1) (SS SSE1 Vergleich von M2 mit M1 M3 mit M1 M4 mit M1 M5 mit M1 M1 Beschreibung alle Effekte nur Interaktionseffekte ohne Konfession ohne Region ohne Interaktionseffekte ˆ Y1 − SSY0 ˆ )/J 2 1 2 0 2 1 Teststatistik F = (84.177–2.247)/(5–2) / 746.020/294 F = (84.177–41.850)/(5–3) / 746.020/294 F = (84.177–44.574)/(5–4) / 746.020/294 F = (84.177–81.930)/(5–3) / 746.020/294 F = 84.177/5 / 746.020/294 = 10.763 = 8.340 = 15.607 = 0.443 = 6.635 7 Effektkodierung in der Varianzanalyse Test von Konfess+Region Konfess Region Interaktionseffekte Gesamtmodell Vergleich von M2 mit M1 M3 mit M1 M4 mit M1 M5 mit M1 M1 Teststatistik F = (84.177–2.247)/(5–2) / 746.020/294 F = (84.177–41.850)/(5–3) / 746.020/294 F = (84.177–44.574)/(5–4) / 746.020/294 F = (84.177–81.930)/(5–3) / 746.020/294 F = 84.177/5 / 746.020/294 = 10.763 = 8.340 = 15.607 = 0.443 = 6.635 ANOVAa,b Y Ablehnung von Schwangerschaft sabbrüchen Haupteffekte 2-WegWechselwirkungen Modell Residuen Insgesamt (Kombiniert) konfess Konfession W Region (Osten) konfess Konfession * W Region (Osten) Quadrats umme 81.930 42.327 39.603 df Eindeutige Methode Mittel der F Quadrate 3 27.310 10.763 2 21.163 8.340 1 39.603 15.607 Sig. .000 .000 .000 2.247 2 1.123 .443 .643 84.177 746.020 830.197 5 294 299 16.835 2.537 2.777 6.635 .000 a. Y Ablehnung von Schwangerschaftsabbrüchen nach konfess Konfession, W Region (Osten) b. Alle Effekte gleichzeitig eingegeben Statistikprogramme zur Varianzanalyse berechnen die F-Statistiken auf effizientere Weise, kommen aber zum gleichen Ergebnis. Die Varianzanalyse zeigt wiederum, das der Interaktionseffekt (in der SPSS-Ausgabe als „2Weg-Wechselwirkungen“ bezeichnet) nicht signifikant ist. Vorlesung Statistik 2 8 Varianzanalyse mit Dummy-Kodierung Deskriptive Statistiken Y Ablehnung von Schwangerschafts abbrüchen d1 Katholik d2 Protestant W Region (Osten) d1w D1 mal W d2w D2 mal W Mittelwert Standardab weichung 1.76 1.666 300 .33 .33 .50 .17 .17 .472 .472 .501 .373 .373 300 300 300 300 300 N Im Unterschied zur Effektkodierung sind bei der Dummy-Kodierung die Mittelwerte der Prädiktoren nicht null und die Faktoren korrelieren mit den Interaktionseffekten. Korrelationen Korrelation nach Pearson Vorlesung Statistik 2 Y Ablehnung von Schwangerschafts abbrüchen d1 Katholik d2 Protestant W Region (Osten) d1w D1 mal W d2w D2 mal W Y Ablehnung von Schwangersc haftsabbrüche n d1 Katholik d2 Protestant W Region (Osten) 1.000 .194 .003 -.218 -.001 -.065 .194 .003 -.218 -.001 -.065 1.000 -.500 .000 .632 -.316 -.500 1.000 .000 -.316 .632 .000 .000 1.000 .447 .447 .632 -.316 .447 1.000 -.200 -.316 .632 .447 -.200 1.000 d1w D1 mal W d2w D2 mal W 9 Varianzanalyse mit Dummy-Kodierung Dies hat zur Folge, dass sich die Regressionskoeffizienten bei der bivariaten Regression und der multiplen Regression mit Interaktionseffekten unterscheiden. Koeffizientena Modell 1 (Konstante) W Region (Osten) Nicht standardisierte Koeffizienten Standardf ehler B 2.127 .133 -.727 .188 Standardisie rte Koeffizienten Beta -.218 T 15.991 -3.864 Signifikanz .000 .000 Dummy-Kodierung: Bivariate Regression von Y auf Region: b1 = –0.727. a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Koeffizientena Modell 1 (Konstante) d1 Katholik d2 Protestant W Region (Osten) d1w D1 mal W d2w D2 mal W Nicht standardisierte Koeffizienten Standardf ehler B 1.680 .225 1.000 .319 .340 .319 -.760 .319 -.160 .451 .260 .451 Standardisie rte Koeffizienten Beta .283 .096 -.228 -.036 .058 T 7.457 3.139 1.067 -2.386 -.355 .577 Signifikanz .000 .002 .287 .018 .723 .564 Dummy-Kodierung: Multiple Regression von Y auf Region: b3 = –0.760. a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Vorlesung Statistik 2 10 Modellierung nichtlinearer Beziehungen im multiplen Regressionsmodell Ablehnung von Schwangerschaftsabbruch (Y) 5 4 3 alte Bundesländer 2 1 neue Bundesländer 0 -1 -1 0 1 2 3 4 5 Religiosität (X) In Regressionsmodellen mit Interaktionseffekten sind die Beziehungen zwischen der abhängigen Variablen und den erklärenden Variablen nicht mehr linear-additiv. Es ist sogar möglich, noch einen Schritt weiterzugehen und nichtlineare Beziehungen zu schätzen. Vorlesung Statistik 2 11 Quadratische Regressionsfunktion Die eingezeichneten Kurven weisen auf einen parabelförmigen Verlauf hin. Algebraisch lässt sich eine Parabel durch eine quadratische Funktion, ein sogenanntes Polynom zweiter Ordnung, darstellen. Bei einer solchen Beziehung würde für die Vorhersagewerten gelten: Ŷ = b0 + b1 ⋅ X + b 2 ⋅ X 2 Im Modell der multiplen Regression lässt sich eine solche parabelförmige Beziehung dadurch realisieren, dass zusätzlich zur erklärenden Variablen X das Quadrat von X (XX = X⋅X) als weiterer Prädiktor in das Modell aufgenommen wird. Wenn die Religiosität einen quadratischen Effekt auf die Ablehnung von Schwangerschaftsabbrüchen hat, kann also folgendes Regressionsmodell angenommen werden: Y = β0 + β1 ⋅ X + β2 ⋅ W + β3 ⋅ X 2 + U Die Regressionskoeffizienten dieses Modells können wiederum mit der OLS-Methode geschätzt werden, indem eine analoge Gleichung für die Stichprobe aufgestellt wird und die Summe der quadrieren Residuen minimiert wird: Y = b 0 + b1 ⋅ X + b 2 ⋅ W + b3 ⋅ X 2 + E ∑ e = ∑ ( yi − yˆ i ) = ∑ ( yi − b0 + b1 ⋅ x i + b2 ⋅ w i + b3 ⋅ x i2 ) n i =1 n 2 i i =1 2 n 2 i =1 Die Koeffizienten können z.B. mit SPSS berechnet werden. Vorlesung Statistik 2 12 Quadratische Regressionsfunktion Modellzusammenfassung Modell 1 R R-Quadrat .376a .142 Standardf ehler des Schätzers 1.640 Korrigiertes R-Quadrat .141 a. Einflußvariablen : (Konstante), XX X mal X, W Region (Osten), X Religiosität (Kirchgang) ANOVAb Modell 1 Regression Residuen Gesamt Quadrats umme 1543.182 9349.999 10893.181 df 3 3477 3480 Mittel der Quadrate 514.394 2.689 F 191.289 Signifikanz .000a a. Einflußvariablen : (Konstante), XX X mal X, W Region (Osten), X Religiosität (Kirchgang) b. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Koeffizientena Modell 1 (Konstante) X Religiosität (Kirchgang) W Region (Osten) XX X mal X Nicht standardisierte Koeffizienten Standardf B ehler 1.763 .055 .118 .062 -.698 .064 .071 .015 Standardisie rte Koeffizienten Beta .085 -.183 .204 T 32.121 1.893 -10.953 4.671 Signifikanz .000 .058 .000 .000 a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Vorlesung Statistik 2 13 Ablehnung von Schwangerschaftsabbruch (Y) Quadratische Regressionsfunktion 5 4 3 2 1 0 -1 0 1 2 3 4 5 Religiosität (X) Die Erklärungskraft dieses Modells ist mit einem Determinationskoeffizienten von R2 = 0.142 etwas höher als im linear-additiven Modell, wo die Erklärungskraft nur R2 = 0.136 betrug. Da der T-Wert des Regressionsgewichts b3 bei einer Irrtumswahrscheinlichkeit von 5% signifikant ist, ist dieser Anstieg der Erklärungskraft signifikant von null verschieden. Die Beziehung zwischen der Ablehnung von Schwangerschaftsabbrüchen und der Religiosität ist daher in der Population vermutlich nicht linear, sondern eher quadratisch. Vorlesung Statistik 2 14 Quadratische Regressionsfunktion Bei der Interpretation der Regressionskoeffizienten ist zu beachten, dass die erklärende Variable Religiosität (X) mit zwei Regressionsgewichten für X und X2 in die Modellgleichung eingeht Da beide Koeffizienten hier das gleiche Vorzeichen aufweisen, bedeutet dies, dass der Anstieg der Regressionskurve bei zunehmender Religiosität (Kirchgangshäufigkeit) immer mehr zunimmt. Wäre das Regressionsgewicht b3 dagegen negativ, würde der Anstieg immer geringer und könnte sich schließlich sogar umkehren. Gelegentlich wird versucht, die relative Stärke des linearen und des quadratischen.Effekts durch einen Vergleich der standardisierten oder unstandardisierten Regressionskoeffizienten b1 und b3 zu vergleichen. Dies ist insofern nicht sinnvoll, als beide Prädiktoren X und X2 ja zusammen den Effekt einer einzigen erklärenden Variablen beschreiben und eine Aufteilung in lineare und quadratische Komponenten willkürlich ist, da die beiden Prädiktoren hoch miteinander korrelieren. Im Beispiel der Daten aus dem Allbus 1996 korrelieren X und X2 mit einem Wert von 0.931. Bei der Spezifikation nichtlinearer Beziehungen über Polynome kann es daher sehr leicht Multikollinearitätsprobleme bei der Schätzung geben. Diese werden reduziert, wenn X zunächst zentriert (mittelwertbereinigt) wird. Vorlesung Statistik 2 15 Quadratische Regressionsfunktion Deskriptive Statistiken Mittelwert Standardab weichung 1.90 1.769 3481 1.21 .32 3.07 1.269 .465 5.124 3481 3481 3481 Y Ablehnung von Schwangerschaftsabbrüc hen X Religiosität (Kirchgang) W Region (Osten) XX X mal X N Korrelationen Korrelation nach Pearson Y Ablehnung von Schwangerschaftsabbrüc hen X Religiosität (Kirchgang) W Region (Osten) XX X mal X Y Ablehnung von Schwangersc haftsabbrüche n X Religiosität (Kirchgang) W Region (Osten) XX X mal X 1.000 .332 -.256 .325 .332 -.256 .325 1.000 -.308 .931 -.308 1.000 -.229 .931 -.229 1.000 Der Mittelwert von X (Religiosität) beträgt 1.21. Das Regressionsmodell mit zentrierter Variable X lautet dann: Y = β0 + β1 ⋅ ( X − 1.21) + β2 ⋅ W + β3 ⋅ ( X − 1.21) + U 2 Vorlesung Statistik 2 16 Quadratische Regressionsfunktion bei zentrierten Prädiktor Deskriptive Statistiken Mittelwert Standardab weichung 1.90 1.769 3481 .00 .32 1.61 1.269 .465 2.524 3481 3481 3481 Y Ablehnung von Schwangerschafts abbrüchen Z X - 1.21 W Region (Osten) zz Z mal Z N Korrelationen Korrelation nach Pearson Y Ablehnung von Schwangerschafts abbrüchen Z X - 1.21 W Region (Osten) zz Z mal Z Y Ablehnung von Schwangersc haftsabbrüche n Z X - 1.21 W Region (Osten) zz Z mal Z 1.000 .332 -.256 .257 .332 -.256 .257 1.000 -.308 .674 -.308 1.000 -.091 .674 -.091 1.000 Die Korrelation zwischen dem linearen Prädiktor Z (= X–1.21) und seinem Quadrat wird dadurch von 0.931 auf 0.674 reduziert. Vorlesung Statistik 2 17 Quadratische Regressionsfunktion bei zentrierten Prädiktor Modellzusammenfassung Modell 1 R R-Quadrat a .376 .142 Korrigiertes R-Quadrat .141 Standardf ehler des Schätzers 1.640 a. Einflußvariablen : (Konstante), zz Z mal Z, W Region (Osten), Z X - 1.21 ANOVAb Modell 1 Regression Residuen Gesamt Quadrats umme 1543.182 9349.999 10893.181 df 3 3477 3480 Mittel der Quadrate 514.394 2.689 F 191.289 Signifikanz .000a a. Einflußvariablen : (Konstante), zz Z mal Z, W Region (Osten), Z X - 1.21 b. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Koeffizientena Modell 1 (Konstante) Z X - 1.21 W Region (Osten) zz Z mal Z Nicht standardisierte Koeffizienten Standardf B ehler 2.009 .040 .289 .031 -.698 .064 .071 .015 Standardisie rte Koeffizienten Beta .207 -.183 .101 T 50.133 9.186 -10.953 4.671 Signifikanz .000 .000 .000 .000 a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Vorlesung Statistik 2 18 Quadratische Regressionsfunktion bei zentrierten Prädiktor Bei der Schätzung ändern sich die Regressionskoeffizienten, aber nicht die Erklärungskraft und die Varianzzerlegung, da die Zentrierung nur zu einer Reparametrisierung des Modells führt. Dass beide Schätzungen zum gleichen Ergebnis führen, wird deutlich, wenn die Modellgleichung des zweiten Modells ausmultipliziert wird: Ŷ = 2.009 + 0.289 ⋅ ( X − 1.21) − 0.698 ⋅ W + 0.071 ⋅ ( X − 1.21) 2 = 2.009 + 0.289 ⋅ X − 0.289 ⋅1.21 − 0.698 ⋅ W + 0.071 ⋅ X 2 + 0.071 ⋅1.212 − 0.071 ⋅ 2 ⋅ X ⋅1.21 = 1.763 + 0.117 ⋅ X − 0.698 ⋅ W + 0.071 ⋅ X 2 Bis auf Rundungsfehler ist die Vorhersagegleichung mit der Schätzung der Regressionskoeffizienten beim ursprünglichen Modell mit nichtzentrierten Variablen identisch. Entsprechend sind auch die Erklärungskraft und die Variationen der Vorhersagewerte und der Residuen identisch. Unterschiede gibt es jedoch bei den standardisierten Regressionsgewichten von X und (X–1.21), die 0.085 und 0.207 betragen. Ähnliches gilt für die standardisierten Gewichte des quadratischen Terms mit Werten von 0.204 und 0.101. Unterschiede gibt es schließlich auch noch bei den T-Werten von b1, die im nichtzentrierten Modell 1.893 und im zentrierten Modell 9.186 betragen. Vorlesung Statistik 2 19 Interaktionseffekte bei quadratischer Regressionsfunktion Im ersten Modell könnte man auf die Idee kommen, den Prädiktor X des „linearen“ Effekts aus dem Modell zu entfernen, da er auf dem 5%-Niveau nicht signifikant ist. Im Modell mit (X–1.21) als Prädiktor ist der Effekt dagegen „hochsignifikant“. Eine getrennte Betrachtung des „linearen“ Effekts von X und des „quadratischen“ Effekts von X2 ist indess nicht angemessen, solange X nicht auf Ratio-Skalen-Niveau gemessen ist und dann eine Verschiebung der Skala nach links oder rechts eine unzulässige Transformation wäre. Die beiden parabelförmigen Regressionskurven für die alten und die neuen Länder verlaufen parallel, Religiosität und Region wirken also weiterhin additiv auf die Ablehnung von Schwangerschaftsabbrüchen. Die bedingten Stichprobenmittelwerte weisen jedoch darauf hin, dass die Kurve für die neuen Länder steiler verlaufen sollte als die Kurve für die alten Länder. Ob dies auch die die Population angenommen werden kann, kann getestet werden, wenn zusätzlich Interaktionsterme zwischen Religiosität und Region spezifiziert werden. Die Modellgleichung lautet dann: Y = β0 + β1 ⋅ X + β2 ⋅ W + β3 ⋅ X 2 + β4 ⋅ ( X ⋅ W ) + β5 ⋅ ( X 2 ⋅ W ) + U Vorlesung Statistik 2 20 Interaktionseffekte bei quadratischer Regressionsfunktion Die SPSS-Ausgabe ergibt: Koeffizientena Modell 1 2 (Konstante) X Religiosität (Kirchgang) W Region (Osten) XX X mal X (Konstante) X Religiosität (Kirchgang) W Region (Osten) XX X mal X XW X mal W XXW X mal X mal W Nicht standardisierte Koeffizienten Standardf B ehler 1.763 .055 .118 .062 -.698 .064 .071 .015 1.760 .062 .160 .074 -.687 .088 .056 .017 -.235 .140 .100 .038 Standardisie rte Koeffizienten Beta .085 -.183 .204 .115 -.180 .161 -.082 .113 T 32.121 1.893 -10.953 4.671 28.408 2.143 -7.761 3.186 -1.677 2.619 Signifikanz .000 .058 .000 .000 .000 .032 .000 .001 .094 .009 a. Abhängige Variable: Y Ablehnung von Schwangerschaftsabbrüchen Von den beiden Interaktionseffekten ist nur der Interaktionseffekt der Region mit dem Quadrat der Religiosität signifikant von null verschieden. Vorlesung Statistik 2 21 Interaktionseffekte bei quadratischer Regressionsfunktion Die Vorhersagegleichungen sind: Ŷ = 1.760 + 0.160 ⋅ X − 0.678 ⋅ W + 0.056 ⋅ X 2 − 0.235 ⋅ ( X ⋅ W ) + 0.100 ⋅ ( X 2 ⋅ W ) = 1.760 + 0.160 ⋅ X + 0.056 ⋅ X 2 im Westen = 1.082 − 0.075 ⋅ X + 0.156 ⋅ X 2 im Osten Auch der F-Test auf Zuwachs an Erklärungskraft weist auf einen signifikanten Interaktionseffekt hin: Modellzusammenfassung Änderungsstatistiken Modell 1 2 R R-Quadrat .376a .142 b .380 .144 Korrigiertes R-Quadrat .141 .143 Standardf ehler des Schätzers 1.640 1.638 Änderung in R-Quadrat .142 .002 Änderung in F 191.289 4.831 df1 3 2 df2 3477 3475 Änderung in Signifikanz von F .000 .008 a. Einflußvariablen : (Konstante), XX X mal X, W Region (Osten), X Religiosität (Kirchgang) b. Einflußvariablen : (Konstante), XX X mal X, W Region (Osten), X Religiosität (Kirchgang), XXW X mal X mal W, XW X mal W Vorlesung Statistik 2 22 Interaktionseffekte bei quadratischer Regressionsfunktion Ablehnung von Schwangerschaftsabbruch (Y) 5 4 3 2 1 0 -1 0 1 2 3 4 5 Religiosität (X) Im Osten startet die Regressionskurve aus einem tieferen Niveau; sie steigt erst langsamer, dann schneller an als im Westen. Vorlesung Statistik 2 23 Überprüfung der Angemessenheit der Modellspezifikation Interessant ist, dass erst im nichtlinearen Modell der Interaktionseffekt mit der Region signifkant ist, während er im linearen Modell nicht signifikant war. Dies verdeutlicht die Wichtigkeit einer korrekten Modellspezifikation: Schlussfolgerungen können falsch (Artefakte) sein, wenn das statistische Modell die Daten nicht angemessen beschreibt. Bei der Prüfung der Angemessenheit eines Modells ist wie in der bivariaten Regression eine Analyse der Residuen hilfreich. Die bedingten Mittelwerte der Residuen sollen stets null sein und die bedingten Standardabweichungen der standardisierten Residualvarianzen in etwa gleich groß. In wie weit diese Bedingungen erfüllt sind, wird nacheinander bei den folgenden Modellen überprüft: M1: Y = b0 + b1·X + b2·W + E1 M2: Y = b0 + b1·X + b2·W + b3· (X·W) + E2 M3: Y = b0 + b1·X + b2·W + b3· (X·X) + E3 M4: Y = b0 + b1·X + b2·W + b3· (X·X) + b4·(X·W) + b5·(X·X·W) + E4 Vorlesung Statistik 2 24 Residuenanalyse Deskriptive Statistiken der standardisierten Residuen in Modell M1: linear-additives Modell Bericht W Region (Osten) 0 Westen 1 Osten Insgesamt X Religiosität (Kirchgang) 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt Vorlesung Statistik 2 Mittelwert Y Ablehnung von Schwangersc se1 haftsabbrüche Studentized n Residual 1.71 .0461844 2.05 .0140797 2.28 -.0803301 2.53 -.1646560 3.41 .1309705 3.96 .2318008 2.21 .0000116 1.08 .0561125 1.13 -.1485509 1.51 -.1554806 2.41 .1535619 3.45 .5543566 4.13 .7262365 1.23 .0000228 1.38 .0513388 1.81 -.0289567 2.16 -.0925373 2.52 -.1305612 3.41 .1747005 3.98 .2955989 1.90 .0000151 Standardabweichung Y Ablehnung von Schwangersc se1 haftsabbrüche Studentized n Residual 1.703 1.03593367 1.693 1.02983665 1.718 1.04491086 1.785 1.08596711 1.720 1.04667798 2.145 1.30621781 1.797 1.05043279 1.366 .83122079 1.412 .85864327 1.563 .95071716 1.907 1.16040783 1.870 1.13889710 2.532 1.54301507 1.504 .88152478 1.569 .93489565 1.673 .98965716 1.717 1.02980121 1.795 1.09620871 1.732 1.06160863 2.177 1.33550820 1.769 1.00015946 Zunächst M1: Die Mittelwerte der standardisierten Residuen sind bei starker Religiosität deutlich von Null verschieden: Das Modell scheint daher nicht angemessen zu sein. 25 Residuenanalyse Standardisierte Residuen in Modell M2: Interaktion zwischen Religiosität und Gebiet. Bericht W Region (Osten) 0 Westen 1 Osten Insgesamt X Religiosität (Kirchgang) 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt Vorlesung Statistik 2 Mittelwert Y Ablehnung von Schwangersc se2 haftsabbrüche Studentized n Residual 1.71 .0401139 2.05 .0121251 2.28 -.0781626 2.53 -.1583741 3.41 .1413750 3.96 .2463751 2.21 .0000155 1.08 .0663224 1.13 -.1544473 1.51 -.1776075 2.41 .1156601 3.45 .5022261 4.13 .6606021 1.23 .0000988 1.38 .0537206 1.81 -.0319544 2.16 -.0943160 2.52 -.1290133 3.41 .1786460 3.98 .2998237 1.90 .0000418 Standardabweichung Y Ablehnung von Schwangersc se2 haftsabbrüche Studentized n Residual 1.703 1.03589155 1.693 1.02974420 1.718 1.04481838 1.785 1.08592708 1.720 1.04674634 2.145 1.30650297 1.797 1.05036839 1.366 .83127026 1.412 .85860582 1.563 .95131257 1.907 1.16281622 1.870 1.14381440 2.532 1.55439339 1.504 .88183517 1.569 .93497465 1.673 .98970556 1.717 1.03009181 1.795 1.09529095 1.732 1.06004217 2.177 1.33414721 1.769 1.00019932 Dann M2: Die Mittelwerte der standardisierten Residuen sind bei starker Religiosität wiederum deutlich von Null verschieden: Auch dieses Modell scheint nicht angemessen zu sein. 26 Residuenanalyse Standardisierten Residuen in Modell M3: quadratischer Effekt von Religiosität. Bericht W Region (Osten) 0 Westen 1 Osten Insgesamt X Religiosität (Kirchgang) 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt Vorlesung Statistik 2 Mittelwert Y Ablehnung von se3 Schwangersc Studentized haftsabbrüche Residual n 1.71 -.0307909 2.05 .0592486 2.28 .0006639 2.53 -.1339104 3.41 .0264305 3.96 -.0952267 2.21 -.0000106 1.08 .0093719 1.13 -.0736645 1.51 -.0444810 2.41 .2155190 3.45 .4812978 4.13 .4317630 1.23 .0000236 1.38 -.0099396 1.81 .0240763 2.16 -.0066693 2.52 -.0964716 3.41 .0734121 3.98 -.0272280 1.90 .0000002 Standardabweichung Y Ablehnung von se3 Schwangersc Studentized haftsabbrüche Residual n 1.703 1.03917056 1.693 1.03296190 1.718 1.04819149 1.785 1.08923622 1.720 1.05007040 2.145 1.31335300 1.797 1.05199028 1.366 .83374644 1.412 .86132086 1.563 .95382952 1.907 1.16397585 1.870 1.14244642 2.532 1.55077493 1.504 .87758670 1.569 .93798544 1.673 .99179914 1.717 1.03281290 1.795 1.10039997 1.732 1.06619075 2.177 1.34401455 1.769 1.00018972 M3: Die Mittelwerte der standardiesierten Residuen sind nun nur noch im Osten bei starker Religiosität deutlich von Null verschieden: Das Modell scheint daher nur in den neuen Bundesländer nicht angemessen zu sein. 27 Residuenanalyse Standardisierten Residuen in Modell M4: quadratischer Effekt und Interaktionseffekte Bericht W Region (Osten) 0 Westen 1 Osten Insgesamt X Religiosität (Kirchgang) 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt 0 nie 1 <= 1 / Jahr 2 2-11 / Jahr 3 1-3 /Monat 4 1 /Woche 5 >1 /Woche Insgesamt Vorlesung Statistik 2 Mittelwert Y Ablehnung von se4 Schwangersc Studentized haftsabbrüche Residual n 1.71 -.0290800 2.05 .0449264 2.28 -.0114562 2.53 -.1255111 3.41 .0741466 3.96 .0101821 2.21 -.0000001 1.08 .0039550 1.13 -.0127568 1.51 -.0204911 2.41 .0996528 3.45 .1224535 4.13 -.2849755 1.23 -.0000384 1.38 -.0119293 1.81 .0296619 2.16 -.0129238 2.52 -.1013864 3.41 .0791360 3.98 -.0279028 1.90 -.0000122 Standardabweichung Y Ablehnung von se4 Schwangersc Studentized haftsabbrüche Residual n 1.703 1.04047655 1.693 1.03411153 1.718 1.04942653 1.785 1.09053549 1.720 1.05136860 2.145 1.31562754 1.797 1.05299648 1.366 .83482962 1.412 .86261734 1.563 .95586327 1.907 1.16769380 1.870 1.15261627 2.532 1.59492753 1.504 .87526853 1.569 .93911064 1.673 .99156929 1.717 1.03403594 1.795 1.09883927 1.732 1.05947315 2.177 1.34377735 1.769 1.00027501 M4: Da die bedingten Mittelwerte der abhängigen Variable recht genau reproduziert werden, sind die Mittelwerte der Residuen fast null. Die Residualvarianzen scheinen bei hoher Religiosität leicht zuzunehmen. 28 Linearisierung nicht-linearer Beziehungen Die Spezifikation von Interaktionseffekten, quadratischen Regressionskurven und Varianzanalysen demonstriert die Vielfalt des multiplen Regressionsmodells. Im Prinzip ist das multiple lineare Regressionsmodell immer dann anwendbar, wenn durch Transformationen nichtlineare Regressionsfunktionen als lineare Gleichungen dargestellt werden können. Man bezeichnet solche nur scheinbar lineare Regressionsgleichungen als linear in den Parametern. Dies gilt für Polynome beliebigen Grades, wie z.B. die kubische Regressionsfunktion: μ Y X = β0 + β1 ⋅ X + β2 ⋅ X 2 + β 4 ⋅ X 3 Die Anwendungsmöglichkeiten erhöhen sich weiter, wenn auch die abhängige Variable transformiert wird. So kann die exponentielle Regressionsfunktion: μ Y X = α ⋅βX durch Logarithmieren in eine lineare Regressionsfunktion umgewandelt werden: ( ) ln μ Y X = ln ( α ⋅βX ) = ln ( α ) + ln (β ) ⋅ X Allerdings haben solche Transformationen Auswirkungen auf die unterstellten Residualvariablen. Wird nämlich zu der logarithmierten Regressionsfunktion ein Residuum addiert, entspricht dies im Ursprungsmodell einem multiplikativen Residuum: ln ( Y ) = ln ( α ) + ln ( β ) ⋅ X + U ⇔ Y = α ⋅β X ⋅ e U Vorlesung Statistik 2 29 Grenzen linearer Regression Allerdings sind nicht alle Regressionsgleichungen linearisierbar. So kann die exponentelle Rergressionsfunktion mit additiven Residualvariable Y = μY X + U = a ⋅ bX + U nicht als lineare Funktion von Prädiktoren formuliert werden. Die Logarithmierung ergibt nämlich ( ) ln ( Y ) = ln μ Y X + U = ln ( a ⋅ b X + U ) ≠ ln ( a ⋅ b x ) + ln ( U ) = ln ( a ) + x ⋅ ln ( b ) + ln ( U ) In solchen Situationen müssen die Regressionskoeffizienten nichtlinearer Regressionsmodelle mit alternativen Schätzmethoden berechnet werden. Vorlesung Statistik 2 30 Logistische Regression für dichotome abhängige Variablen Da Regressionsmodelle Mittelwerte abhängiger Variablen als lineare oder nichtlineare Funktion von Prädiktoren darstellen, wird zumindest bei der abhängigen Varable metrisches Messniveau vorausgesetzt, da für Messungen auf Nominal- und Ordinalskalenniveau Mittelwerte nicht definiert sind. Ein Grenzfall ergibt sich bei einer dichotomen Variable. Sind die Ausprägungen einer solchen Variable mit den Werten „0“ und „1“ kodiert, so lässt sich der Mittelwert als relative Häufigkeit bzw. bei Zufallsvariablen als Wahrscheinlichkeit interpretieren, mit der die Ausprägung „1“ realisiert wird. Für dichotome abhängige Variablen können daher Regressionsmodelle spezifiziert werden. Als Beispiel soll die abhängige Variable „Wahlverhalten“ mit den Ausprägungen „Wahl der SPD“ (Kode: 1) und „Wahl der CDU/CSU“ (Kode: 0) in einer linearen Regression durch das Erhebungsgebiet (Variable „region“) mit den Ausprägungen „0“ für die alten und „1“ für die neuen Bundesländern, Bildung („educ“) mit den Ausprägungen „0“ für „kein Schulabschluss“, „1“ für „Hauptschulabschluss“, „2“ für „mittlere Reife“, „3“ für „(Fach-) Abitur“ und „4“ für „Hochschulabschluss“ sowie die Selbstpositionierung auf einer zehnstufigen Links-Rechts-Skala („f030“) mit den Polen „links“ (Kode: 1) und „rechts“ (Kode: 11) vorhergesagt werden. Die Ergebnisse der OLS-Regression zeigt die folgende Tabelle. Vorlesung Statistik 2 31 Beispiel einer linearen Regression für dichotome abhängige Variablen Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 1.379 *** –0.060* –0.027* –0.139*** Standard- standardisierte Varianzzerlegung: fehler Koeffizienten Quelle Variation df 0.044 -Regression 90.466 3 0.026 0.056 Residuen 229.048 1289 0.011 –0.056 Total 319.514 1292 0.006 –0.539 R2: .283, R2adj.: .281, F: 169.7*** (Daten: Nachwahlbefragung BTW 2005, Berechnungen mit SPSS) Mit über 28% ist die Erklärungskraft des Modells recht hoch, wobei aus den standardisierten Regressionsgewichten zu erkennen ist, dass insbesondere die Links-RechtsSelbsteinstufung einen sehr hohen Einfluss hat: Je weiter rechts sich eine Person einordnet, desto stärker sinkt die Neigung, SPD statt CDU zu wählen. Negative Effekte haben auch Bildung und Region: je höher die Bildung, desto weniger oft wird SPD statt CDU gewählt. Zudem wird in den neuen Ländern bei Kontrolle von Bildung und Selbstpositionierung eher CDU statt SPD gewählt. Alle erklärenden Variablen sind signfifikant von Null verschieden, Region und Bildung bei einer Irrtumswahrscheinlichkeit von 5%, die Selbstpositionierung auch bei einer Irrtumswahrscheinlichkeit von 0.1%. Vorlesung Statistik 2 32 Probleme der linearen Regression für dichotome abhängige Variablen Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 1.379 *** –0.060* –0.027* –0.139*** Standard- standardisierte Varianzzerlegung: fehler Koeffizienten Quelle Variation df 0.044 -Regression 90.466 3 0.026 0.056 Residuen 229.048 1289 0.011 –0.056 Total 319.514 1292 0.006 –0.539 R2: .283, R2adj.: .281, F: 169.7*** (Daten: Nachwahlbefragung BTW 2005, Berechnungen mit SPSS) So naheliegend das lineare Regressionsmodell zu sein scheint, ist es doch streng genommen ungeeignet. • Bei einer dichotomen erklärenden Variablen ist die Homoskedastizitätsannahme notwendigerweise verletzt: Bei einer dichotomen Variblen mit der relativen Häufigkeit p1 der einen Kategorie beträgt die Varianz p1·(1–p1). Wenn die Regressionsgewichte ungleich null sind, dann variieren die relativen Häufigkeiten mit den Werten der Prädiktoren und damit auch die bedingten Varianzen. Dann können zwar die Schätzungen der Regressionskoeffizienten konsistent und unverzerrt sein, die Standardfehler sind jedoch verzerrt und damit ist auch die inferenzstatistische Absicherung hinfällig. Vermutlich sind die Standardfehler falsch und es ist gar nicht sicher, ob die Regressionsgewichte signifikant sind. Vorlesung Statistik 2 33 Probleme der linearen Regression für dichotome abhängige Variablen Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 1.379 *** –0.060* –0.027* –0.139*** Standard- standardisierte Varianzzerlegung: fehler Koeffizienten Quelle Variation df 0.044 -Regression 90.466 3 0.026 0.056 Residuen 229.048 1289 0.011 –0.056 Total 319.514 1292 0.006 –0.539 R2: .283, R2adj.: .281, F: 169.7*** (Daten: Nachwahlbefragung BTW 2005, Berechnungen mit SPSS) So naheliegend das lineare Regressionsmodell zu sein scheint, ist es doch streng genommen ungeeignet. • Es ist nicht garantiert, dass die Vorhersagewerte zwischen „0“ und „1“ liegen. Werden die Vorjersagewerte für eine Person aus den neuen Bundes-ländern (region=1) mit Hochschulabschluss (educ=4) und einer Position ganz rechts (f030=11) berechnet, ergibt sich folgender Vorhersagewert: ŷ = 1.379 + ( −0.060 ) ⋅1 + ( −0.027 ) ⋅ 4 + ( −0.139 ) ⋅ 11 = −0.318 Analog gilt für eine Person aus den alten Bundesländern (region=0) ohne Schluabschluss (educ=0), die sich ganz links positioniert: ŷ = 1.379 + ( −0.060 ) ⋅ 0 + ( −0.027 ) ⋅ 0 + ( −0.139 ) ⋅ 1 = 1.24 Vorhersagewerte kleiner „0“ oder größer „1“ können jedoch keine bedingten Mittelwerte sein: Die Regressionsfunktion ist daher vermutlich nicht linear. Vorlesung Statistik 2 34 Logistische Regression für dichotome abhängige Variablen: Modellgleichung Die Probleme der linearen Regression bei einer dichotomen abhängigen Variablen lassen sich lösen, wenn zwei Modifikationen des linearen Regressionsmodells vorgenommen werden: (1) Um zu verhindern, dass negative Vorhersagewerte auftreten, wird die lineare Vorhersagegleichung L = β0 + β1·X1 + β2·X2 + ..+ βK·XK zunächst antilogarithmiert (exponentiert): L → e L = exp ( β0 + β1 ⋅ X1 + ... + βK ⋅ X K ) (2) Um darüber hinaus auch zu verhindern, dass Vorhersagewerte größer eins auftreten, wird die antilogarithmierte Vorhersagegleichung sodann durch die Summe aus 1 plus sich selbst geteilt: exp ( β0 + β1 ⋅ X1 + ... + βK ⋅ X K ) eL µYˆ = Pr ( Y = 1) = = 1 + e L 1 + exp ( β0 + β1 ⋅ X1 + ... + β K ⋅ X K ) Durch diese Modifikationen wird sichergestellt, dass alle Vorhersagewerte stets zwischen 0 und 1 liegen. Der Minimalwert 0 wird (theoretisch) ereicht wenn die Werte der erklärenden Variablen in der linearen Gleichung den Wert –∞ ergeben, da exp(–∞) = 0 und 0/(1+0) = 0 ist. Der Maximalwert 1 wird (theoretisch) ereicht wenn die Werte der erklärenden Variablen in der linearen Gleichung den Wert +∞ ergeben, da exp(+∞) = +∞ und +∞/(1+∞) = 1 ist. Durch diese Transformation wird also anstelle der ursprünglich linearen Regressionsfunktion eine nichtlineare Regressionsfunktion erzeugt. Vorlesung Statistik 2 35 Logistische Regression für dichotome abhängige Variablen: Odds Da die Funktion F(X) = eX/(1+eX) die Verteilungsfunktion der logistischen Verteilung ist, wird diese spezifische nichtlinearen Regressionsfunktion als logistische Regression bezeichnet. Die logistische Regressionsfunktion lässt sich so umformen, dass auf der rechten Seite der Gleichung die lineare Funktion L steht. Dazu wird zunächst das Verhältnis der beiden Ausprägungen der dichotomen abhängigen Variable berechnet: K e / (1 + e ) ∑ β k ⋅X k Pr ( Y = 1) Pr ( Y = 1) β0 β k ⋅X k L k =1 e e e e = = = = = ⋅ ∏ Pr ( Y = 0 ) 1 − Pr ( Y = 1) (1 + e L ) − e L / (1 + e L ) k =1 L ( L β0 + K ) Aus der logistischen Regressionsfunktion folgt also, dass das Verhältnis des Auftretens der beiden Ausprägungen der abhängigen Variable der Antilogarithmus der linearen Vorhersagefunktion L ist. Nach dem englischen Wort für „Wette“ wird ein (Wahrschenlichkeits-) Verhältnis in der Statistik als Odd bezeichnet. Im Beispiel berechnen sich die Odds SPD statt CDU zu wählen als Antilogarithmus einer linearen Funtion von Region, Bildung und Links-Rechts-Selbstpositionierung. Vorlesung Statistik 2 36 Logistische Regression für dichotome abhängige Variablen: Logits Werden die Odds logarithmiert, ergeben sich die Log-Odds oder Logits: K ⎛ Pr ( Y = 1) ⎞ ⎛ Pr ( Y = 1) ⎞ = ln ⎜ = β0 + ∑ β k ⋅ X k ln ⎜ ⎜ Pr ( Y = 0 ) ⎟⎟ ⎜ 1 − Pr ( Y = 1) ⎟⎟ k =1 ⎝ ⎠ ⎝ ⎠ Im Beispiel sind die Logits, SPD statt CDU zu wählen, eine lineare Funktion von Region, Bildung und Links-Rechts-Selbstpositionierung. Nach der Bezeichnung „Logit“ werden logistische Regressionsmodelle auch als Logitmodelle bezeichnet. ML-Schätzung eines logistischen Regressionsmodells Bei der Schätzung der Regressionskoeffizienten eines logistischen Regressionsmodells kann die OLS-Methode nicht angewendet werden, da bei einem einzelnen Fall i das Verhältnis ln(Yi/(1–Yi)) nicht berechnebar ist, wenn Yi=1 ist. Wenn Y=0, ist es dagegen immer null. Anstelle der OLS-Methode wird hier die Maximum-Likelihood-Methode (ML-Schätzung) angewendet: Bei der ML-Schätzung werden die Koeffizienten so bestimmt, dass die tatsächlich aufgetretenen Fälle der Stichprobe bei gegebenen Regressionskoeffizienten eine maximale Auftretenswahrscheinlichkeit haben. Die Berechnung der Regressionskoeffizienten b0, b1, ..., bK nach der ML-Methode ist aufwendig und erfolgt daher üblicherweise mit Computern, wobei anstelle der Maximierung der sog. Likelihood-Funktion die negative logarithmierte Likelihood-Funktion minimiert wird. Vorlesung Statistik 2 37 Logistische Regression für dichotome abhängige Variablen: ML-Schätzung Da der Wert der negativen Log-Likelihoodfunktion eng mit der Devianz der abhängigen Variable zusammenhängt, wird bei der ML-Schätzung faktisch die Devianz der abhängigen Variable minimiert. Die SPSS-Berechnung für das Beispiel der Wahl von SPD statt CDU ergibt folgende Koeffizienten: Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Bei der Interpretation kommt es darauf an, auf welcher Ebene man sich bewegt, der der Logits, der der Odds oder der Auftretenswahrscheinlichkeiten. Ausgangspunkt ist die lineare Vorhersagegleichung für die Logits. Bei einer Person aus den neuen Bundesländern (region = 1) mit mittlerer Reife (educ = 2) und einer mittleren Selbstpositinierung (f030 = 6) berechnet sich das Logit SPD statt CDU zu wählen nach: ⎛ Pr ( SPD ) ⎞ ln ⎜ = 5.109 + ( −0.339 ) ⋅1 + ( −0.162 ) ⋅ 2 + ( −0.810 ) ⋅ 6 = −0.414 ⎜ Pr ( CDU ) ⎟⎟ ⎝ ⎠ Vorlesung Statistik 2 38 Logistische Regression für dichotome abhängige Variablen: ML-Schätzung Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. ⎛ Pr ( SPD ) ⎞ ln ⎜ = 5.109 + ( −0.339 ) ⋅1 + ( −0.162 ) ⋅ 2 + ( −0.810 ) ⋅ 6 = −0.414 ⎜ Pr ( CDU ) ⎟⎟ ⎝ ⎠ Das Odd, also das Verhältnis von SPD-Wählern zu CDU-Wählern beträgt dann: Pr ( SPD ) = exp ( 5.109 + ( −0.339 ) ⋅1 + ( −0.162 ) ⋅ 2 + ( −0.810 ) ⋅ 6 ) = e −0.414 = 0.661 Pr ( CDU ) Die Wahrscheinlichkeit, SPD zu wählen. ist schließlich: e −0.414 = 0.398 Pr ( SPD ) = −0.414 1+ e Vorlesung Statistik 2 39 Logistische Regression für dichotome abhängige Variablen: ML-Schätzung Links-Rechts 1 2 3 4 5 6 7 8 9 10 11 Logit 3.636 2.826 2.016 1.206 0.396 –0.414 –1.224 –2.034 –2.844 –3.654 –4.464 Differenz Pr(SPD) / Pr(CDU) Veränderungsfaktor Pr(SPD) Differenz 37.940 0.445 0.974 –0.810 16.878 0.445 0.944 –0.030 –0.810 7.508 0.445 0.882 –0.062 –0.810 3.340 0.445 0.770 –0.112 –0.810 1.486 0.445 0.598 –0.172 –0.810 0.661 0.445 0.398 –0.200 –0.810 0.294 0.445 0.227 –0.171 –0.810 0.131 0.445 0.116 –0.111 –0.810 0.058 0.445 0.055 –0.061 –0.810 0.026 0.445 0.025 –0.030 –0.810 0.012 0.445 0.011 –0.014 Analog lassen sich die Vorhersagewerte der Logits, Odds und der Wahrscheinlichkeit SPD zu wählen für den gesamten Wertebereich der Links-Rechts-Skala für Befragte aus den neuen Bundesländern mit mittlerer Reife berechnen. Der Anstieg auf der Links-Rechts-Skala um +1 Einheit führt nur auf der Ebene der Logits zu einer gleichmäßigen Veränderung in Höhe des Regressionskoeffizienten (–0.810). Auf der Ebene der Odds und der Wahrscheinlichkeiten sind die Veränderungen nicht linear. Auf der Ebene der Odds ist allerdings der Veränderungsfaktor Pr(Y=1|X=x+1)/Pr(Y=0|X=x+1) / Pr(Y=1|X=x)/Pr(Y=0|X=x) = exp(bX) konstant und gleich dem Antilogarithmus des Regressionskoeffizienten (e–0.810 = 0.445). Vorlesung Statistik 2 40 Logistische Regression für dichotome abhängige Variablen: Interpretation Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Für die Interpretation bedeutet dies: (a) Die Regressionskoeffizienten beziehen sich auf die Logits: Verglichen mit den alten Bundesländern sinken in den neuen Bundesländern bei Kontrolle von Bildung (educ) und Links-Rechts-Selbstpositionierung (f030) die Logits um 0.339. Bei jeder Erhöhung des Bildungsabschlusses sinken die Logits um 0.162 Einheiten. Bei einer Veränderung um +1 Einheit nach rechts, sinken die Logits um 0.810 Einheiten. Die Regressionskonstante gibt die geschätzten Logits für Personen an, die bei allen erklärenden Variablen den Wert Null aufweisen. Da der Wertebereich der Selbstpositionierung erst bei 1 beginnt, kann es eine solche Ausprägungskombination der erklärenden Variablen nicht geben, weswegen die Konstante nicht interpretiert werden sollte. Vorlesung Statistik 2 41 Logistische Regression für dichotome abhängige Variablen: Interpretation Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. (b) Die letze Spalte der Tabelle gibt die Antilogarithmen der Koeffizienten exp(bk) wieder. Diese Werte geben die Veränderungsraten der Odds an. Verglichen mit den alten Bundesländern ist in den neuen Bundesländern das Verhältnis von SPD zu CDU um den Faktor 0.712 oder 29.8% (=100% – 71.2%) geringer. Pro Bildunsgabschluss sinkt das Verhältnis von SPD zu CDU um 15% (=100% – 85.0%). Bei einem Anstieg um +1 Einheit auf der Links-Rechts-Skala sinkt das Verhältnis von SPD zu CDU sogar um 55.5% (=100% – 44.5%). (c) Auf der Ebene der Auftretenswahrscheinlichkeiten lassen sich keine eindeutigen Effekte angeben, da diese in Abhängigkeit von den Ausgangswerten variieren. Am geringsten sind die Veränderungen bei sehr kleinen und sehr großen Wahrscheinlichkeiten, am größten bei einer Wahrscheinlichkeit von 0.5. Vorlesung Statistik 2 42 Logistische Regression für dichotome abhängige Variablen: Interpretation 1.3 1.2 1.1 1.0 0.9 0.8 0.7 0.6 0.5 0.4 0.3 0.2 0.1 0.0 -0.1 -0.2 -0.3 Lineare Trendlinie Bedingte Stichprobenmittelwerte Logistische Regressionsfunktion 0 1 2 3 4 5 6 7 8 9 10 11 In der Abbildung sind neben den empirischen Stichprobenmittelwerten der abhängigen Variablen für alle Ausprägungen der Links-Rechts-Selbstpositionierung die logistische Regressionsfunktion und die lineare OLS-Regressioneingezeichnet, wobei für die Ausprägungen der Region und der Bildung jeweils die Stichprobenmittelwerte eingesetzt sind. Deutlich sichtbar ist der s-förmige Verlauf der logistischen Regressionsfunktion, die die empirischen Mittelwerte deutlich besser erfasst als dies die Vorhersagewerte der linearen Regression tut. Vorlesung Statistik 2 43 Logistische Regression für dichotome abhängige Variablen: Tests Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Wenn die Stichprobe Ergebnis einer einfachen Zufallsauswahl ist und das logistische Regressionsmodell die Regressionsfunktion in der Population korrekt beschreibt, dann ist die MLSchätzung konsistent, asympototisch erwartungstreu und effizient. Außerdem sind die geschätzten Regressionskoeffizienten um den zu schätzenden Populationswert asymptotisch normalverteilt, wobei die Standardfehler aus den Daten geschätzt werden können. Mit Hilfe der Standardfehler lassen sich analog zur OLS-Regression (ohne Normalverteilungsannahme der Residuen) asymptotische Standardfehler und Tests berechnen. Anstelle der Z-Test werden in der SPSS-Ausgabe allerdings Wald-Tests der Nullhypothese, dass ein Regressionskoeffizient in der Population Null ist, berechnet. Die Teststatisitk ist das Quadrat der T-bzw. Z-Statistik: ⎛ bk ⎞ 2 W =Z =⎜ ⎜ σˆ ( b ) ⎟⎟ k ⎠ ⎝ Vorlesung Statistik 2 2 44 Logistische Regression für dichotome abhängige Variablen: Tests Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Bei zutreffender Nullhypothese ist die Wald-Statistik asymptotisch mit df=1 Freiheitsgraden chiquadratverteilt. Wird das Regressionsgewicht der Region durch seinen Standardfehler geteilt und quadriert, ergibt sich der Wert 5.195 ≈ (–0.339/0.149)2. Abweichungen sind Folge von Rundungsfehlern. Bei df=1 Freiheitsgrad beträgt dann die empirische Signifikanz der Nullhypothese, H0: β1 = 0 vs. H1: β1 ≠ 0 Sig.=0.023. Bei einer Irrtumswahrscheinlichkeit von 5% ´ (0.05) ist die Nullhypothese also abzulehnen. Die Wald-Tests weisen darauf hin, dass alle drei Regressionsgewichte bei einer Irrtumswahrscheinlichkeit von 5% signifikant von null verschieden sind. Der Vorteil des Wald-Tests gegenüber dem üblichen Z-Test besteht darin, dass er leicht auf den simultanen Test mehrerer Regressionskoeffizienten ausgeweitet werden kann. Vorlesung Statistik 2 45 Logistische Regression für dichotome abhängige Variablen: Konfidenzintervalle Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Über die Standardfehler lassen sich auch Konfidenzintervalle berechnen: c.i.( βk ) = b k ± σˆ ( βk ) ⋅ z1−α / 2 Das 95%-Konfidenzintervall des Regressionsgewichts der Bildung beträgt so: c.i.(βBildung) = –0.162 ± 0.065·1.96 = –0.289 bis –0.035. Bei einer Irrtumswahrscheinlichkeit von 5% ist zu vermuten, dass der Populationswert etwa zwischen –0.289 und –0.035 liegt. Bezogen auf die Odds ergibt sich das entsprechende Konfidenzintervall wieder durch Antilogarithmieren: b ±σˆ β ⋅z c.i. eβk = e k ( k ) 1−α / 2 ( ) Bei der Bildung liegen die Werte für den Veränderungsfaktor der Odds vermutlich zwischen 0.749 (= e–.289) und 0.966 (= e–.035). Vorlesung Statistik 2 46 Logistische Regression für dichotome abhängige Variablen: einseitige Tests Variablen in der Gleichung Schritt a 1 region educ f030 Konstante Regressions koeffizientB -.339 -.162 -.810 5.109 Standardf ehler .149 .065 .050 .336 Wald 5.195 6.312 262.872 231.312 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .712 .850 .445 165.526 a. In Schritt 1 eingegebene Variablen: region, educ, f030. Statistische Tests sollten sich auch dann auf die Regressionsgewichte beziehen, wenn die Nullhypothese Werte für die Odds postuliert. Im Beispiel kann etwa die Nullhypothese geprüft werden, dass ein Anstieg bei der Selbtspositionierung um +1 Einheit die Odds von SPD zu CDU mehr als halbiert. Das zu prüfende Hypothesenpaar lautet dann: H0: exp(β3) ≥ 0.5 vs. H1: exp(β3) < 0.5 Durch Logarithmieren ergibt sich die korrespondierende Hypothese für die Logits: H0: β3 ≥ ln(0.5) = –0.693 vs. H1: β3 < ln(0.5) = –0.693. Die Teststatistik berechnet sich dann analog zur der bei der linearen Regression: b − β −0.810 − ( −0.693) Z= k = = −2.34 ˆσ ( b k ) 0.050 Vorlesung Statistik 2 47 Logistische Regression für dichotome abhängige Variablen: einseitige Tests Bei einem einseitigen Test nach unten und einer Irrtumswahrscheinlichkeit α wird die Nullhypothese abgelehnt, wenn die Teststatistik kleiner/gleich dem (1–α)-Quantil der Standardnormalverteilung ist. Bei einer Irrtumswahrscheinlichkeit von 5% wird im Beispiel die Nullhypothese abgelehnt, wenn die Teststatistik kleiner/gleich –1.645 ist. Da dies bei Z= –2.34 der Fall ist, ist die Nullhypothese zu verwerfen. Bei einer Irrtumswahrscheinlichkeit von 5% kann davon ausgegangen werden, dass sich die Odds von SPD zu CDU mehr als halbieren, wenn die Links-Rechts-Position um +1 Einheit (nach rechts) ansteigt. Vergleich von relativen Einflussstärken Die nach der ML-Methode gescätzten Regressionskoeffizienten lassen sich nur dann in ihrer Größenordnung vergleichen, wenn die erklärenden Variablen auf der gleichen Messskala gemessen werden. Dies ist oft nicht der Fall. Analog zu standardisierten Regressionskoeffizienten im linearen Regressionsmodell lassen sich aber auch bei der logstischen Regression standardisierte Koeffizienten berechnen, wenn die erklärenden Variablen standardisiert werden. Da die abhängige Variable dichotom ist, macht bei ihr eine Standardisierung allerdings keinen Sinn, so dass nur die erklärenden Variablen mit der Z-Transformation standardisiert werden. Vorlesung Statistik 2 48 Logistische Regression für dichotome abhängige Variablen: standardisierte Lösung Variablen in der Gleichung Schritt a 1 Zregion Zeduc Zf030 Konstante Regressions koeffizientB -.155 -.171 -1.557 .301 Standardf ehler .068 .068 .096 .067 Wald 5.195 6.312 262.872 20.073 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .856 .843 .211 1.351 a. In Schritt 1 eingegebene Variablen: Zregion, Zeduc, Zf030. Die Tabelle zeigt die entsprechende Schätzung: Wenn die Region um +1 Standardabweichung ansteigen würde, würden die Logits um –0.155 sinken; würde die Bildung um +1 Standardabweichung ansteigen, würden die Logits um –0.171 sinken; würde die Links-Rechts-Selbstpositionierung um +1 Standardabweichung ansteigen, würden die Logits um –1.557 sinken. Aus diesen Werten folgt, dass die Links-Rechts-Positionierung den relativ größten Effekt und die Region den relativ geringsten Effekt hat. Der relative Effekt der Bildung ist allerdings kaum höher als der der Region. Zum gleichen Ergebns kommt man bei der Betrachtung der Veränderungsraten: Der Effekt einer Veränderung um +1 Standardabweichung reduziert das Odd um 14.45% (=1–0.856) bei der Region, um 15.7% (=1–0.843) bei der Bildung und um 78.9% (=1–0.211) bei der LinksRechts-Selbstpositionierung. Vorlesung Statistik 2 49 Logistische Regression für dichotome abhängige Variablen: standardisierte Lösung Variablen in der Gleichung Schritt a 1 Zregion Zeduc Zf030 Konstante Regressions koeffizientB -.155 -.171 -1.557 .301 Standardf ehler .068 .068 .096 .067 Wald 5.195 6.312 262.872 20.073 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .856 .843 .211 1.351 a. In Schritt 1 eingegebene Variablen: Zregion, Zeduc, Zf030. Im Unterschied zum standardisierten linearen Regressionsmodell, bei dem die Regressionskonstante notwendigerweise den Wert Null aufweist, kann die Regressionskonstante im LogitModell mit standardisierten erklärenden Variablen ungleich Null sein. Die Regressionskonstante gibt hier den Wert des Odds an, wenn die Werte aller erklärenden Variablen gerade gleich ihrem Mittelwert sind: K βˆ Z0 = βˆ 0 + ∑ βˆ k ⋅ x k ; 0.301 = 5.109 + ( −0.339 ) ⋅ 0.30 + ( −0.162 ) ⋅ 1.998 + ( −0.810 ) ⋅ 5.41 k =1 Aus dieser Konstante lassen sich somit auch die durchschittliche Wahrscheinlichkeit der Ausprägungen der abhängigen Variablen berechnen: e0.301 1.351 Pr ( SPD region = 0.30,educ = 1.998,f 030 = 5.41) = = = 0.575 0.301 1+ e 1 + 1.351 Vorlesung Statistik 2 50 Logistische Regression für dichotome abhängige Variablen: standardisierte Lösung Variablen in der Gleichung Schritt a 1 Zregion Zeduc Zf030 Konstante Regressions koeffizientB -.155 -.171 -1.557 .301 Standardf ehler .068 .068 .096 .067 Wald 5.195 6.312 262.872 20.073 df 1 1 1 1 Sig. .023 .012 .000 .000 Exp(B) .856 .843 .211 1.351 a. In Schritt 1 eingegebene Variablen: Zregion, Zeduc, Zf030. Beim Vergleich der Veänderungsraten ist zu beachten, dass Faktoren >1.0 anders zu bewerten sind als Faktoren <1.0. So bewirkt der Veränderungsfaktor 2.0 eine Verdopplung der Odds, also eine Erhöhung um 100% (=100·(2–1)). Bei einem Faktor <1.0 entspricht dies einer Veränderung um den Faktor 0.5 oder 50%, der zu einer Halbierung der Odds führt. Sollen positive und negative Veränderungen verglichen werden, entspricht ein Faktor >1 dem Kehrwert eines Faktors <1. So ist im Beispiel 1/0.5 = 2.0 Es ist nicht unbedingt nötig, das Logit-Modell mit den standardisierten Werten neu aus den Daten zu schätzen, da die Koeffizienten auch direkt aus dem unstandardisierten Modell berechnet werden können. Notwendig sind dazu nur die Standardabweichungen der erklärenden Variablen: s( X k ) b Zk = b k ⋅ s ( X k ) ; exp b Zk = exp ( b k ⋅ s ( X k ) ) = ( exp ( b k ) ) ( ) Vorlesung Statistik 2 51 Logistische Regression für dichotome abhängige Variablen: LR-Tests Wie bei der linearen Regression will man auch bei der logistischen Regression oft wissen, ob das Modell überhaupt Erklärungskraft aufweist. Anstelle des F-Tests wird bei der ML-Schätzung üblicherweise ein LR-Test (LikelihoodQuotienten-Test) angewendet. Bei einem LR-Test werden zwei hierrarchisch geschachtelte Logit-Modelle verglichen. Zum einen ein sog. Nullmodell M0, in dem nicht alle Regressionskoeffizienten werden, und zum anderen ein umfassenderes Modell M1 mit allen Regressionskoeffizienten. Hier wird im Modell M0 nur die Regressions-konstante geschätzt, in Modell M1 die Regressionskonstante plus alle Regressionsgewichte. Die Teststatistik L2 ist die zweifache Differenz der negativen Log-Likelihoodfunktionen der beiden Modelle: L2 = –2· ( lnL(M0) – lnL(M1) ) Im Beispiel der Wahl von SPD bzw. CDU ergibt sich für das Konstantenmodell ein Wert von 1777.507 und für das vollständige Modell ein Wert von 1344.394. Die Teststatistik beträgt dann: L2 = 1777.507 – 1344.394 = 433.111 Wenn die Nullhypothese zutrifft und dann alle (zusätzlichen) Regressionsgewichte der erklärenden Variablen aus Modell M1 in der Population Null sind, dann ist die Teststatistik L2 chiquadratverteilt, wobei die Zahl der Freiheitsgrade gleich der Zahl der erklärenden Variablen ist, im Beispiel also df = 3. Ist die Nullyhpothese falsch, ist die Teststatistik nichtzentral chiquadratverteilt. Vorlesung Statistik 2 52 Logistische Regression für dichotome abhängige Variablen: LR-Test Omnibus-Tests der Modellkoeffizienten Schritt 1 Schritt Block Modell Chi-Quadrat 433.113 433.113 433.113 df 3 3 3 Sig. .000 .000 .000 Die Teststatistik wird in der SPSS-Ausgabe als "Omnibus-Test der Modellkoeffzienten" bezeichnet. Der Ausgabe ist zu entnehmen, dass die Nullhypothese auch bei einer Irrtumswahrscheinlichkeit von 0.1% abgelehnt wird. Stärke der Erklärungskraft Als Analogon zum Determinationskoeffizienten R-Quadrat (R2) kann in der logistischen Regression die relative Devianzreduktion R‘ berechnet werden: −2ln L(M1 ) L2 L2 433.113 R ' =1− = = = = 0.244 2 −2ln L(M 0 ) −2ln L(M 0 ) −2ln L(M1 ) + L 1344.394 + 433.113 Dieses Maß wird auch als McFaddens Pseudo-R-Quadrat bezeichnet. Vorlesung Statistik 2 53 Logistische Regression für dichotome abhängige Variablen: LR-Test Modellzusammenfassung Omnibus-Tests der Modellkoeffizienten Chi-Quadrat Schritt 1 Schritt 433.113 Block 433.113 Modell 433.113 df 3 3 3 Sig. .000 .000 .000 Schritt 1 -2 Cox & Snell LogR-Quadrat Likelihood a 1344.394 .285 Nagelkerkes R-Quadrat .381 a. Schätzung beendet bei Iteration Nummer 5, weil die Parameterschätzer sich um weniger als .001 änderten L2 433.113 R'= = = 0.244 2 −2ln L ( M1 ) + L 1344.394 + 433.113 Anstelle der Devianzreduktion berechnet SPSS zwei andere Pseudo-R-Quadrat-Maße, nämlich die Maße von Cox und Snell und von Nagelkerke, die vor allem bei großen Fallzahlen zu höheren Werten führen: ⎛ − L2 ⎞ ' −433.113/1293 R Cox&Snell = 1 − exp ⎜ = 0.285 ⎟ = 1− e ⎝ n ⎠ R 'Nagel ker ke = 1 − exp ( − L2 / n ) ( 1 − exp − ( −2ln L ( M 0 ) ) / n ) = 0.285 1 − e −1777.507 /1293 = 0.381 Im Beispiel sind alle Maße relativ hoch, was für einen durchaus starken Zusammenhang spricht. Vorlesung Statistik 2 54 Vergleich logistischer und linearer Regression Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 5.109 *** –0.339* –0.162* –0.810*** Standard- standardisierte Effekt. fehler Koeffizienten exp(bk) 0.336 0.301 165.5 0.149 –0.155 0.712 0.065 –0.171 0.850 0.050 –1.557 0.445 Globaltest –2lnL M0 1777.507 M1 1344.394 L2 433.113 R‘ 24.4%*** df 1 4 3 (Daten: Nachwahlbefragung BTW 2005, n=1293, Berechnungen mit SPSS) Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 1.379 *** –0.060* –0.027* –0.139*** Standard- standardisierte Varianzzerlegung: fehler Koeffizienten Quelle Variation df 0.044 -Regression 90.466 3 0.026 0.056 Residuen 229.048 1289 0.011 –0.056 Total 319.514 1292 0.006 –0.539 R2: .283, R2adj.: .281, F: 169.7*** (Daten: Nachwahlbefragung BTW 2005, Berechnungen mit SPSS) Der Vergleich der ML-Schätzung des Logitmodells mit der OLS-Schätzung des linearen Modells zeigt, dass sich zwar die geschätzten Koeffizienten sehr unterscheiden, die Interpretation aber zum gleichen Ergebnis kommt: • In beiden Modellen weisen die erklärenden Variablen negative Effekte auf. • Die Links-Rechts-Skala hat einen deutlich stärkeren Effekt als Region und Bildung. Allerdings zeigt nur das Logit-Modell, dass die Bildung auch einen etwas stärkeren Effekt hat als die Region. Vorlesung Statistik 2 55 Vergleich logistischer und linearer Regression Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 5.109 *** –0.339* –0.162* –0.810*** Standard- standardisierte Effekt. fehler Koeffizienten exp(bk) 0.336 0.301 165.5 0.149 –0.155 0.712 0.065 –0.171 0.850 0.050 –1.557 0.445 Globaltest –2lnL M0 1777.507 M1 1344.394 L2 433.113 R‘ 24.4%*** df 1 4 3 (Daten: Nachwahlbefragung BTW 2005, n=1293, Berechnungen mit SPSS) Y=Wahlverhalten Prädiktor Konstante (b0) Region (b1) Bildung (b2) Links-Rechts unstandard. Koeffizienten 1.379 *** –0.060* –0.027* –0.139*** Standard- standardisierte Varianzzerlegung: fehler Koeffizienten Quelle Variation df 0.044 -Regression 90.466 3 0.026 0.056 Residuen 229.048 1289 0.011 –0.056 Total 319.514 1292 0.006 –0.539 R2: .283, R2adj.: .281, F: 169.7*** (Daten: Nachwahlbefragung BTW 2005, Berechnungen mit SPSS) • In beiden Modellen ist die Erklärungskraft (gemessen in R‘ bzw. R2) recht hoch. • In beiden Modell sind alle Koeffizienten und das Gesamtmodell bei einer Irrtumswahrscheinlichkeit von 5% signifikant. Die Standardfehlern und Tests des linearen Modells sind aber bei einer dichotomen ahängigen Variable verzerrt, so dass den Ergebnissen des Logit-Modells hier eher getraut werden kann. Vorlesung Statistik 2 56 Aufgabe Die Ergebnisse der trivariaten Regression des Einkommens auf Region und Bildungsabschluss ergab im Allbus 1996 folgendes Resultat: Vorhersagewerte Residuen: Variation df 1057889850.981 2 5423000773.603 2194 Prädiktor b Konstante 1690.62 Bildungsabschluss 520.71 Region −835.18 SE T 72.25 23.4 30.72 17.0 69.01 −12.1 R²: 16.3% R²adj: 16.2% F: 214.0 (p < 0.001) Sign.(T) b* < 0.001 < 0.001 0.331 < 0.001 −0.236 Gegen die Analyse wird eingewendet, dass Bildung keine metrische Variable sei. Um dem Rechnung zu tragen wird die Bildung rekodiert, so dass anstelle der Abschlüsse Bildungsjahre resultieren. Befragten ohne Abschluss werden 7 Jahre zugeordnet, Befragten mit Hauptschulabschluss 9 Jahre, mit mittlerer Reife 10 Jahre, mit Abitur 13 Jahr und mit Hochschulabschluss 17 Jahre. Vorlesung Statistik 2 57 Übungsaufgaben Die Regression führt nun zu folgenden Ergebnissen: Vorhersagewerte Residuen: Prädiktor Konstante Bildungsjahre Region Variation df 1142062630.056 2 5338827994.528 2194 b 347.51 214.50 −780.08 SE T 135.8 2.6 11.87 18.1 68.50 −11.4 R²: 17.6% R²adj: 17.5% F: 234.7 (p < 0.001) Sign.(T) b* < 0.001 < 0.001 0.350 < 0.001 −0.2221 a) Interpretieren Sie die Ergebnisse und vergleichen Sie diese mit der ursprünglichen Regression. Welche Kodierung ziehen Sie vor? Begründen Sie Ihre Antwort. Um das Skalierungsproblem der Bildung zu lösen, wird schließlich vorgeschlagen, die Bildung wie bei einer nominalskalierten Variablen in 0/1-kodierte Dummy-Variablen aufzulösen, die den Wert eins aufweisen, wenn eine Person den entsprechenden Bildungsabschluss aufweist. Als Referenzkategorie wird der Hauptschulabschluss verwendet Vorlesung Statistik 2 58 Übungsaufgaben Die Regression führt nun zu folgenden Ergebnissen: Vorhersagewerte Residuen: Variation df 1262107788.435 5 5218782836.147 2191 Prädiktor Konstante kein Abschluss Mittlere Reife Abitur Hochschulabschl. Region b SE T 2301.97 54.96 41.9 −475.71 207.25 −2.3 340.19 80.05 4.3 214.19 112.30 1.9 1918.57 101.45 18.9 −830.85 69.34 −12.0 R²: 19.5% R²adj: 19.3% F: 106.0 (p < 0.001) Sign.(T) b* < 0.001 0.022 −0.045 < 0.001 0.091 0.057 0.039 < 0.001 0.388 < 0.001 −0.235 b) Interpretieren Sie dieses Ergebnis der multiplen Regression. Vergleichen Sie es mit den Ergebnissen der ersten beiden Regressionsanalysen. Welches der drei Regressionsmodelle beschreibt die empirischen Daten am besten? Vorlesung Statistik 2 59 Übungsaufgaben Es soll geprüft werden, ob der Bildungseffekt als linear angenommen werden kann. Dazu werden in einer schrittweisen Regression zunächst das Ausgangsmodell mit Bildungsabschluss und Region (Ost) als erklärende Variablen „geschätzt“ und dann zusätz lich drei der vier Dummy-Variablen aus dem multiplen Regressionsmodell aus dem letzten Modell in die Gleichung aufgenommen. Es resultieren folgende Ergebnisse: Vorhersagewerte Residuen: Variation df 1262107788.435 5 5218782836.147 2191 R²: 19.5% R²adj: 19.3% F: 106.0 (p < 0.001) Prädiktor b SE T Sign.(T) b* Konstante 1826.26 202.74 9.0 < 0.001 Bildungsabschluss 475.71 207.25 2.3 0.022 0.302 Mittlere Reife −135.51 233.74 −0.6 0.562 −0.036 Abitur −737.22 441.11 −1.7 0.095 −0.133 Hochschulabschl. 491.46 624.08 0.8 0.444 0.099 Region −830.85 69.34 −12.0 < 0.001 −0.235 c) Prüfen Sie mit einer Irrtumswahrscheinlichkeit von 5 %, ob das erweiterte Modell eine signifikant höhere Erklärungskraft hat als das Ausgangsmodell. d) Welche Schlussfolgerungen ergeben sich aus der Gegenüberstellung der Erklärungskraft von Ausgangs- und erweitertem Modell? Vorlesung Statistik 2 60