PDF - NEWSolutions

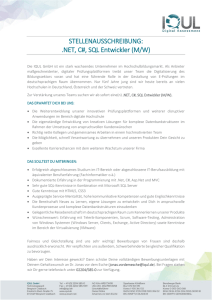

Werbung