Internetsupplement

Werbung

Statistik

Testverfahren

Internetsupplement

Heinz Holling & Günther Gediga

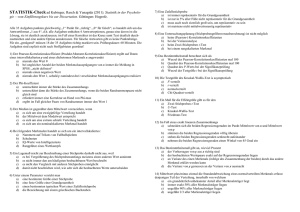

Inhaltsverzeichnis

1

Ableitungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1

1.2

1.3

1.4

1.5

1.5.1

1.5.2

1.5.3

1.6

1.7

1.8

1.9

Einseitige und zweiseitige p-Werte (2 / S. 38) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

Gütefunktion bei zweiseitigen Tests (2 / S. 57) . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

Gauß-Test: UMP (einseitig) und nicht UMP (zweiseitig) (2 / S. 58) . . . . . . 7

Beispiele zur Güte statistischer Tests (2 / S. 58) . . . . . . . . . . . . . . . . . . . . . . . . . . 8

Weitere Einstichprobentests (3 / S. 68) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

Test der Schiefe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

Test der Kurtosis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

Gemeinsamer Test von Schiefe und Kurtosis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

Zur Anwendbarkeit des zentralen Grenzwertsatzes (3 / S. 69) . . . . . . . . . . . 10

Zusammenhang von Intervallschätzung und Testverfahren (3 / S. 70) . . 12

Der randomisierte Binomialtest (3 / S. 81) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

Varianz der Teststatistik des Wilcoxon-Vorzeichen-Rangtests bei Rangbindungen (3 / S. 88) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

Vergleich von Testgütefunktionen bei Einstichprobentests (3 / S. 91) . . . . 14

Überprüfung der bivariaten Normalverteilung (5 / S. 125) . . . . . . . . . . . . . . . . 15

Monte-Carlo-Verfahren bei Randomisierungstests (5 / S. 130) . . . . . . . . . . . 15

Normalverteilungsapproximation der Testverteilung von Kendall’s τ

bei Rangbindungen (5 / S. 134) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

Post-hoc-Tests in der Kontingenztafelanalyse (5 / S. 140) . . . . . . . . . . . . . . . . 16

Der Fisher-Yates-Test und die hypergeometrische Verteilung (5 / S. 142) 17

Exakte Tests bei k × m-Tabellen (5 / S. 143) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

Normalverteilungsapproximation der Testverteilung des Log-Odds-Ratios

(5 / S. 144) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

Ausreißer und große Schiefe und der zentrale Grenzwertsatz (6 / S.

160) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

Die Deffizienz im Zweistichprobenfall (6 / S. 166) . . . . . . . . . . . . . . . . . . . . . . . . . 21

Die White-Korrektur im linearen Modell (6 / S. 175 und 9 / S. 361) . . . . . . 21

Asymptotische Konsistenz des thom -Tests bei Heteroskedastizität (6 /

S. 176) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

Beispiel für einen Lokationsunterschied bei undefinierten Erwartungswerten (6 / S. 183) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

Berechnung der Verteilung des Wilcoxon-Rangsummentests (6 / S. 183) 24

Teststatistik des Wilcoxon-Rangsummentests (6 / S. 184) . . . . . . . . . . . . . . . 25

Der Fligner-Policello-Test (6 / S. 190) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

Normalverteilungsapproximation der Teststatistik für den WilcoxonVorzeichen-Rangtest für abhängige Stichproben (6 / S. 197) . . . . . . . . . . . . 29

1.10

1.11

1.12

1.13

1.14

1.15

1.16

1.17

1.18

1.19

1.20

1.21

1.22

1.23

1.24

1.25

1.26

6

4

1.27

1.28

1.29

1.30

1.31

1.32

1.33

1.34

1.35

1.36

1.37

1.38

1.39

1.40

1.41

1.42

1.43

1.44

1.45

1.46

1.47

1.48

1.49

1.50

1.51

1.52

Kapitel 0

Symmetrie-Tests (6 / S. 198) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Der Fligner-Policello-Test (6 / S. 213) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Berechnung der Mittelwerte im Fall gleich großer Gruppen in der einfaktoriellen Varianzanalyse (7 / S. 230) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

χ 2 -Verteilung von SSBG /σ 2 in der einfaktoriellen Varianzanalyse (7 /

S. 231) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Die Deffizienz in der einfaktoriellen Varianzanalyse (7 / S. 235) Beispiele für notwendige Stichprobenumfänge bei ungleich besetzten Zellen in der einfaktoriellen Varianzanalyse (7 / S. 235) . . . . . . . . . . . . . . . . . . . . . .

Verteilung eines Kontrastes unter der Nullhypothese (7 / S. 238) . . . . . . . .

Zur Schätzung des Standardfehlers bei homogenen Varianzen (7 / S.

243) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Beispiel zum REGWQ-Verfahren (7 / S. 247) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Äquivalenz des zweiseitigen Wilcoxon-Rangsummen-Tests und des

Kruskal-Wallis-Tests bei zwei Stichproben (7 / S. 249) . . . . . . . . . . . . . . . . . . .

Schätzer der mehrfaktoriellen Varianzanalyse bei gleichen Zellenbesetzungen (7 / S. 259) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Mehrfaktorielle Varianzanalyse bei ungleichen Zellenbesetzungen im

allgemeinen linearen Modell (7 / S. 260) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Verteilung der Quadratsummen in der zweifaktoriellen Varianzanalyse

(7 / S. 263) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Varianzanteile in der zweifaktoriellen Varianzanalyse (7 / S. 265) . . . . . . .

Einzelvergleiche in der Varianzanalyse mit Messwiederholung (8 / S.

286) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Test für zufällige Personeneffekte in der einfaktoriellen Varianzanalyse mit Messwiederholung (8 / S. 288) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Feste vs. zufällige Effekte in der Varianzanalyse (8 / S. 288); (8 / S. 289)

Der Tukey-Test auf Linearität (8 / S. 289) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Zur Sphärizitätsannahme (8 / S. 292) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Der Mauchly-Test (8 / S. 293) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Zur Greenhouse-Geisser-Korrektur (8 / S. 293) . . . . . . . . . . . . . . . . . . . . . . . . . . .

Dreifachinteraktion (παβ )i jk in der zweifaktoriellen Varianzanalyse

mit Messwiederholung (8 / S. 297) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Notwendige Kovarianzstruktur in der zweifaktoriellen Varianzanalyse

mit Messwiederholung (8 / S. 299) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Testverteilung der Effekte in der zweifaktoriellen Varianzanalyse mit

Messwiederholung (8 / S. 304) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Zu den Voraussetzungen der Varianzanalyse mit Messwiederholung

(8 / S. 307) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Interaktion bei nur einer Beobachtung pro Zelle und Fehlervarianz im

Split-Plot-Design (8 / S. 309) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Notwendige Kovarianzstruktur im Split-Plot-Design (8 / S. 310) . . . . . . . . .

29

30

30

30

31

32

33

33

36

37

38

39

42

43

43

44

46

47

51

52

52

54

54

54

54

54

Inhaltsverzeichnis

1.53

5

1.69

1.70

1.71

1.72

Berechnung der Freiheitsgrade für die Fehlerquadratsummen im SplitPlot-Design (8 / S. 313) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Fehlerterme im Split-Plot-Design (8 / S. 314) . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Der Box-Test (8 / S. 316) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Zu den Voraussetzungen der Varianzanalyse mit einem Between- und

einem Within-Subjects-Faktor (8 / S. 316) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Lineare Abhängigkeit und lineare Unabhängigkeit (9 / S. 328) . . . . . . . . . . .

Varianz von β̂0 (9 / S. 329) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Erwartungswerte und χ 2 -Verteilungen in der mehrfaktoriellen Varianzanalyse (9 / S. 331) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Matrizenschreibweise zur Beschreibung von linearen Hypothesen (9

/ S. 334) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

F -Test beim Vergleich linearer Modelle (9 / S. 335) . . . . . . . . . . . . . . . . . . . . . . .

Regressionskoeffizienten und Kodiervariablen (9 / S. 337), (9, S. 341) .

R2 bei der Regression ohne Interzept und Bezug zu η 2 (9 / S. 346) . . . .

Kodierungen für das Split-Plot-Design im linearen Modell (9 / S. 347) . .

Quadratsummen der kodierten Variablen einer zweifaktoriellen Varianzanalyse (9 / S. 350) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Weitere Typen der Variationszerlegung (9 / S. 350) . . . . . . . . . . . . . . . . . . . . . . .

Effekt der Kovariaten auf das Ergebnis der Kovarianzanalyse (9 / S.

358) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Tests zur Überprüfung von Abhängigkeiten in der linearen Regression

(9 / S. 360) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

White-Korrektur (9 / S. 361) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Transformationen zur Stabilisierung und Normalisierung (9 / S. 361) . . . .

Der Breusch-Pagan-Test (9 / S. 362) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Literatur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

Tabellen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

2.1

2.2

2.3

2.4

2.5

2.6

Normalverteilungstabelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Quantile der χ 2 -Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Quantile der t -Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Quantile der F -Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Binomialtest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Wilcoxon-Rangsummentest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.54

1.55

1.56

1.57

1.58

1.59

1.60

1.61

1.62

1.63

1.64

1.65

1.66

1.67

1.68

55

55

56

56

56

56

57

57

58

58

60

61

63

63

64

65

66

66

66

67

70

73

77

79

90

92

Kapitel 1

Ableitungen

1.1 Einseitige und zweiseitige p-Werte (2 / S. 38)

Ist die Prüfverteilung für eine Teststatistik V symmetrisch wie im Falle von Normalverteilung oder t-Verteilung, ist die Umrechnung von einseitigen zu zweiseitigen

p-Werten möglich. Wir betrachten hier eine solche Prüfverteilung mit E(V ) = 0, die

immer erzeugt werden kann, indem von den Werten der ursprünglichen Prüfverteilung der ursprüngliche Erwartungswert abgezogen wird.

Im Fall einer zweiseitigen Hypothese wird H0 abgelehnt, wenn gilt: |v| > v1−α/2 .

Hier gilt: pz = P(|T | > v0 ). Im Fall einer einseitigen „noch oben gerichteten“ Hypothese, wird H0 abgelehnt, wenn gilt: v > v1−α . Hier gilt: pe = P(T > v0 ). Betrachten

wir zwei Fälle. Im ersten Fall geht die Teststatistik unter der einseitigen H0 in die

erwartete Richtung, d. h. v0 > 0, und im zweiten Fall geht sie nicht in die erwartete

Richtung, d. h. v0 ≤ 0.

Im ersten Fall mit p0 > 0 gilt: pz = P(|T | < v0 ) = P(T < v0 ) + P(T > v0 ). Wegen

der Symmetrie gilt: P(T > v0 ) = P(T < v0 ). Hier ist pe = P(T > v0 ) und damit folgt:

pe = P(T ) > v0 = pz /2.

Im zweiten Fall mit p0 ≤ 0 gilt: pz = P(|T | < v0 ) = P(T > v0 ) + P(T < v0 ) und

ebenso: P(T > v0 ) = P(T < v0 ). Hier ist pe = P(T > −v0 ) und damit folgt: pe =

1 − (P(T ) > v0 ) = 1 − (P(T > v0 ) + P(T < v0 ))/2 = 1 − pz /2.

Der Fall einer einseitigen „noch unten gerichteten“ Hypothese kann völlig analog

gezeigt werden.

1.2 Gütefunktion bei zweiseitigen Tests (2 / S. 57)

Zunächst einmal ist bei einem zweiseitigen Test zu beachten, dass zfwar die Hypothese zweiseitig aufgestellt werden kann – und somit mit zwei kritischen Werten links

Kapitel 1 Ableitungen

7

und rechts vom Erwartungswertwert der Teststatistik versehen ist – aber ein Effekt

immer nur eine Größe haben kann.

In der im Buch benutzten Beispielanwendung (Gauß-Test) ist der Effekt durch die

√

Größe δ n auf die Verteilung der Teststatistik abzubilden. Alle Werte von Y , die

unter H0 kleiner sind als zα/2 haben unter Gültigkeit der H1 die Wahrscheinlichkeit

√ √ P Y < zα/2 − δ n = φ zα/2 − δ n

Alle Werte von Y , die größer sind als z1−α/2 haben unter Gültigkeit der H1 die Wahrscheinlichkeit

√ √ P Y > z1−α/2 − δ n = 1 − φ z1−α/2 − δ n

Wegen der Symmetrie der Normalverteilung gilt

φ (x) = 1 − φ (−x)

sowie

z p = −z1−p

Damit gilt:

√ √ P Y > z1−α/2 − δ n = 1 − φ z1−α/2 − δ n

√ = 1 − 1 − φ −zα/2 + δ n

√ = φ zα/2 + δ n

Die Gütefunktion für den zweiseitigen Test ergibt sich damit wie folgt:

√ √ g(δ ) = P Y < zα/2 − δ n + P Y > z1−α/2 − δ n

√ √ = φ zα/2 − δ n + φ zα/2 + δ n

√ √ = φ −z1−α/2 − δ n + φ −z1−α/2 + δ n

Die Nutzung von z1−α/2 in der endgültigen Formel liegt darin begründet, dass diese

Werte größer als Null sind und in der Regel vertafelt vorliegen.

1.3 Gauß-Test: UMP (einseitig) und nicht UMP (zweiseitig) (2 / S. 58)

Wir zeigen hier, dass der zweiseitige Gauß-Test kein UMP-Test ist. Die beiden einseitigen Gauß-Tests sind UMP-Tests (vgl. z. B. Shao, 2003). Wir stellen hier nochmals zusammenfassend den zweiseitigen Gauß-Test dar sowie die beiden einseitigen

Gauß-Tests, hier jedoch mit der Nullhypothese als einfache Hypothese.

8

Kapitel 1

Gauß-Test

Annahmen:

Y1 , ...,Yn i.i.d. N(µ, σ )-verteilt, Standardabweichung σ bekannt

Testprobleme

Teststatistik

1. H0 : µ = µ0 gegen H1 : µ 6=

µ0

Z=

2. H0 : µ = µ0 gegen H1 : µ >

µ0

3. H0 : µ = µ0 gegen H1 : µ <

Y −µ

√0

σ/ n

Ablehnung der H0

1. |z| > z1−α/2

2. z > z1−α

3. z < −z1−α

µ0

Nehmen wir an, es gäbe einen UMP-Test für das zweiseitige Testproblem, wie es

beim einseitigen Gauß-Test der Fall ist. Ein solcher UMP-Test wäre zugleich auch ein

UMP-Test für die beiden oben dargestellten einseitigen Testprobleme. Daher müsste die Testfunktion eines UMP-Test für das zweiseitige Testproblem mit den Testfunktionen der beiden einseitigen Gauß-Tests übereinstimmen, wenn diese jeweils

zu einer Annahme bzw. Ablehnung der Nullhypothese führen.

Nehmen wir an, dass die Teststatistik kleiner als −z1−α ausfällt. Dann muss die Nullhypothese für das zweiseitige Problem H0 : µ = µ0 gegen H1 : µ 6= µ0 abgelehnt werden und für das einseitige Problem H0 : µ = µ0 gegen H1 : µ ≤ µ0 angenommen werden. Ausgehend von solchen Daten könnte aber die Testfunktion eines UMP-Tests für

das zweiseitige Testproblem nicht mit beiden Testfunktionen der einseitigen GaußTests übereinstimmen. Dieser Widerspruch zeigt, dass es keinen UMP-Test für das

obige zweiseitige Testproblem geben kann.

1.4 Beispiele zur Güte statistischer Tests (2 / S. 58)

Wir verweisen hier auf Kap. 5.3, in dem die Testgüte von Einstichprobentests vergleichend diskutiert wird.

Kapitel 1 Ableitungen

9

1.5 Weitere Einstichprobentests (3 / S. 68)

1.5.1 Test der Schiefe

Zur numerischen Erfassung der Schiefe metrischer Daten wurde in Band 1 (Holling

& Gediga, 2011) der Schiefekoeffizient gm definiert:

gm =

n2

∑ni=1 (yi − y)3

(n − 1)(n − 2)

nsY3

Aufgrund der Definition der Schiefe gilt:

gm = 0

für symmetrische Verteilungen

gm > 0

für rechtsschiefe Verteilungen

gm < 0

für linksschiefe Verteilungen

Will man testen, ob eine Verteilung symmetrisch ist oder schief, testet man:

H0 : gm = 0 gegen H1 : gm 6= 0

Für normalverteilte Zufallsvariablen ist

g2m

6

χ 2 -verteilt mit einem Freiheitsgrad (Jarque & Bera, 1980). Bei Ablehnung der Nullhypothese ist somit die empirisch festgestellte Schiefe nicht plausibel durch zufällige

Abweichungen von der Normalverteilung zu erklären.

1.5.2 Test der Kurtosis

Der für metrische Daten einschlägige Kurtosiskoeffizient γ ist wie folgt definiert (Holling & Gediga, 2011):

n

γ =

n2 (n + 1)

(n − 1)(n − 2)(n − 3)

∑ (yi − ȳ)4

i=1

nsY4

−3

(n − 1)2

(n − 2)(n − 3)

Es gilt:

γ = 0 ⇒ mesokurtische Verteilung (annähernd normalverteilt)

γ > 0 ⇒ leptokurtische Verteilung

γ < 0 ⇒ platykurtische Verteilung

10

Kapitel 1

Will man testen, ob eine Verteilung mesokurtisch ist oder nicht, testet man:

H0 : γ = 0 gegen H1 : γ 6= 0

Für normalverteilte Zufallsvariablen ist

γ2

24

χ 2 -verteilt mit einem Freiheitsgrad (Jarque & Bera, 1980). Bei Ablehung der Nullhypothese ist somit die empirisch festgestellte Kurtosis nicht plausibel durch zufällige

Abweichungen von der Normalverteilung zu erklären.

1.5.3 Gemeinsamer Test von Schiefe und Kurtosis

Jarque und Bera (1980) fassen die beiden Tests auf symmetrische und mesokurtische

Verteilung zusammen mit der Teststatik

JB =

g2m γ 2

+

6

24

Unter der Annahme der Normalverteilung ist BJ χ 2 -verteilt mit 2 Freiheitsgraden.

Nach Simulationsstudien von Bera and Jarque (1981) ist dieser Test gut geeignet

Abweichungen von der Normalverteilung zu entdecken.

Dieser Test findet sich beispielsweise im SPSS-System unter dem Menüpunkt explorative Datenanalysen oder im R-Paket lawstat mit der Funktion rjb.test. Im

Paket lawstat ist neben der klassischen Variante, die hier vorgestellt wurde, auch

eine Variante mit robusten (ausreißerresistenten) Schätzern implementiert, die für eine erste Analyse von Daten vorzuziehen ist. Details hierzu findet man in Gel und

Gastwirth (2008).

1.6 Zur Anwendbarkeit des zentralen Grenzwertsatzes (3 / S. 69)

Die zur Anwendbarkeit des zentralen Grenzwertsatzes dargestellten Empfehlungen

sind sehr allgemein gehalten. Klare allgemeingültige Regeln lassen sich jedoch hier

nicht aufstellen. Der Grund dafür liegt darin, dass der zentrale Grenzwertsatz für beliebige Wahrscheinlichkeitsverteilungen (mit Erwartungswert und Varianz) gilt, wobei die in Holling und Gediga (2013, S. 189) genannten Voraussetzungen noch abgeschwächt werden.

Eine entscheidende Frage ist, ab welchem Stichprobenumfang die Approximation der

Verteilung der Mittelwerte duch die Normalverteilung hinreichend gut ist, bzw. anders ausgedrückt, wie hoch die Konvergenzgeschwindigkeit für bestimmte zu Grunde

Kapitel 1 Ableitungen

11

liegende Verteilungen ist. Bei einigen Verteilungen ist die Approximation schon bei

einem sehr geringen Stichprobenumfang, z. B. N = 10, hinreichend gut, bei anderen

Wahrscheinlichkeitsverteilungen, wie z.B. der Gamma-Verteilung mit einem sehr geringen Shape-Parameter ist ein Stichprobenumfang von N = 300 nicht ausreichend.

Die Regel, dass der Stichprobenumfang größer/gleich 30 sein sollte, ist aber für viele

in der Praxis auftretende Fälle eine gute Daumenregel. Nichtsdestotrotz sollte man

sich darüber im Klaren sein, dass ein Stichprobenumfang von N = 30 in bestimmten

Fällen zu gering sein kann. Die Konvergenzgeschwindigkeit hängt sehr stark von der

Schiefe und auch von der Kurtosis der zu Grunde liegenden Verteilung ab. Ist die

Verteilung der Stichprobendaten sehr schief oder zeichnet sie sich durch eine hohe

Kurtosis aus, sind viele Ausreißer zu erwarten (vgl. Boos & Hughes-Oliver, 2000).

Dann werden höhere Stichprobenumfänge erforderlich, um eine genügend gute Approximation zu erzielen.

Neben der Konvergenzgeschwindigkeit ist jedoch ein zweiter Aspekt zu beachten.

Selbst wenn die Verteilung der Mittelwerte eine gute Approximation an die Normalverteilung darstellt, kann die Anwendung des zentralen Grenzwertsatzes bei der Berechnung von Konfidenzintervallen und der Durchführung von Tests zu fehlerhaften

Ergebnissen führen, wenn der Stichprobenumfang zu gering ist. In der Regel ist die

Standardabweichung der zu Grunde liegenden Verteilung nicht bekannt und muss anhand der Stichprobendaten geschätzt werden. Dann sind die Mittelwerte t-verteilt.

Führt nun die zu Grunde liegende Verteilung mit einer hohen Wahrscheinlichkeit zu

Ausreißern, wird die Standardabweichung ungenau geschätzt und die Approximation der Mittelwertsverteilung durch eine t-Verteilung ist dann unzureichend. Eine

ausführliche Diskussion dieser Thematik findet sich in Wilcox (2012). Fassen wir

einige wesentliche Aussagen dieses Autors hier kurz zusammen.

Wilcox (2012) unterscheidet vier Arten von Verteilungen: (1) symmetrische Verteilungen mit relativ wenig Wahrscheinlichkeitsmasse an den Rändern (light-tailed), (2)

symmetrische Verteilungen mit relativ viel Wahrscheinlichkeitsmasse an den Rändern (heavy-tailed), (3) schiefe Verteilungen mit relativ wenig Wahrscheinlichkeitsmasse an den Rändern und (4) schiefe Verteilungen mit relativ viel Wahrscheinlichkeitsmasse an den Rändern.

Bei Verteilungen der Klasse (1), die sich durch eine eher geringe Kurtosis auszeichnen, liegen Ausreißer selten vor, in diesem Fall ist eine gute Approximation durch

die t-Verteilung zu erwarten. Damit liegen relativ genaue Konfidenzintervalle bzw. –

äquivalent dazu – Tests mit weitgehend adäquaten Fehlerraten vor.

Symmetrische Verteilungen mit relativ viel Wahrscheinlichkeitsmasse an den Rändern, wie z. B. bei der t-Verteilung mit zwei Freiheitsgraden, führen eher zu großen

Varianzen bei den Stichprobendaten und damit zu übermäßig breiten Konfidenzintervallen, wenn nicht hinreichend große Stichprobenumfänge vorliegen.

12

Kapitel 1

Schiefe Verteilungen mit relativ wenig Wahrscheinlichkeitsmasse an den Rändern,

wie z. B. lognormale Verteilungen, können bei einem zu geringen Stichprobenumfang

dazu führen, dass der Erwartungswert der Mittelwertsverteilung ungleich 0 ist und

insofern auch keine adäquate Konfidenzintervalle resultieren.

Schiefe Verteilungen mit relativ viel Wahrscheinlichkeitsmasse an den Rändern führen in der Regel zu relativ vielen Ausreißern, weshalb hier besonders große Stichprobenumfänge erforderlich sind, um eine hinreichend gute Approximation der Mittelwertsverteilung durch die t-Verteilung zu erzielen.

1.7 Zusammenhang von Intervallschätzung und Testverfahren (3 / S.

70)

Wir betrachten hier den Zusammenhang zwischen dem einseitigen Gauß-Test H0 :

µ ≤ µ0 gegen H1 : µ > µ0 und dem entsprechenden einseitigen Konfidenzintervall.

Der Annahmebereich des obigen einseitigen Gauß-Tests lässt sich wie folgt umformen:

Y − µ0 √

n ≤ +z1−α

σ

σ

−∞ ≤ Y − µ0 ≤ +z1−α √

n

−∞

≤ −µ0

σ

Y − z1−α √

n

≤

≤

σ

−Y + z1−α/2 √

n

µ0

≤

∞

Die Grenzen dieses Intervalls sind bekannt als die Grenzen des

(1−α)-Konfidenzintervalls für µ bei einem normalverteilten Merkmal mit bekannter

Varianz:

√

n

Y − z1−α

,∞

σ

1.8 Der randomisierte Binomialtest (3 / S. 81)

Randomisierte Tests wurden entwickelt, um das Signifikanzniveau voll auszuschöpfen. Sie stellen eine Erweiterung der Signifikanztestes dar und beinhalten diese als

Spezialfälle und sind insbesondere bei diskreten Testfunktionen indiziert.

Kapitel 1 Ableitungen

13

Wir betrachten nun einen randomisierten Binomialtest, der auf dem in Band 3 (S. 81)

dargestellten Signifikanztest beruht. Hier wurde der kritische Wert für einen einseitigen Test

H0 : π ≤ π0 = .25 gegen H1 : π > π0 = .25

zum Signifikanzniveau α = .05 bestimmt. Für U ∼ B(10, .25) sind die entsprechende

diskrete Dichte und Verteilungsfunktion in der Tabelle auf S. 81 dargestellt.

Für das einseitige Testproblem

H0 : π ≥ .25

gegen

H1 : π < .25

zu einem Signifikanzniveau α = .10 wurde der kritische Wert bu,.10 (10, .25) so festgelegt, dass gilt:

P(U < bu,.10 (10, .25)) < α und P(U < bu,.10 (10, .25) + 1) ≥ α

So wurde im vorliegenden Signifikanztest als kritischer Wert 1 bestimmt. Damit wird

jedoch die Nullhypothese lediglich mit einer Wahrscheinlichkeit von .0563 und nicht

wie vorgegeben mit .10 abgelehnt.

Die Randomisierung erlaubt es nun, die Nullhypothese exakt mit der vorgegebenen

Wahrscheinlichheit von .10 abzulehnen. Dazu muss die Nullhypothese zusätzlich zur

Wahrscheinlichkeit von .0563 mit einer Wahrscheinlichkeit von .100-.0563 = .0437

abgelehnt werden. Wir ermitteln daher die bedingte Wahrscheinlichkeit, die Nullhypothese abzulehnen, gegeben die Testfunktion nimmt den Wert 1 an, sodass die

Nullhypothese insgesamt mit einer Wahrscheinlichkeit von .10 abgelehnt wird.

Die Testfunktionen nimmt eine 1 mit einer Wahrscheinlichkeit von .2440 - .0563 =

.1887 an. Somit ist die bedingte Wahrscheinlichkeit, die Nullhypothese abzulehnen,

wenn eine 1 aufgetreten ist, .0437/.1887 = .2316.

Die Entscheidungsvorschrift beim Randomisierungstest lautet nun wie folgt: Tritt

bei einem Test eine 0 auf, wird die Nullhypothese abgelehnt. Tritt ein Wert von größergleich 2 auf, wird die Nullhypothese beibehalten. Im Fall einer 1 wird ein weiterer künstlicher Test, ein einseitiger Binomialtest mit der Verteilung B(1, .2316),

durchzuführt, sodass in 23% aller Fälle, wenn eine 1 bei der Testfunktion auftritt, die

Nullhypothese verworfen wird. In der Praxis wird dazu häufig eine gleichverteilte

Zufallszahl zwischen 0 und 1 gezogen. Fällt diese Zufallszahl kleiner als .2316 aus,

wird die Nullhypothese abgelehnt, ansonsten beibehalten.

Der Randomisierungstest ist insgesamt ein zweistufiges Verfahren, bei dem man in

der ersten Phase analog zum Signifkanztest verfährt. Im Unterschied zum Signifkanztest bestimmt man für die erste Phase neben dem Annahme- und Ablehnungsbereich

einen dritten Bereich, den sogenannten Randomisierungs- bzw. Indifferenzbereich.

Nimmt die Testfunktion einen Wert aus dem Indifferenzbereich an, ist ein weiterer

Binomialtest analog zu dem oben dargestellten Beispiel durchzuführen, sodass das

Signifikanzniveau exakt eingehalten wird.

14

Kapitel 1

1.9 Varianz der Teststatistik des Wilcoxon-Vorzeichen-Rangtests bei

Rangbindungen (3 / S. 88)

Im Falle von Rangbindungen werden für identische Werte mittlere Ränge vergeben.

Jede Beobachtung i erhält eine „Bindungsbewertung“, die auf der Anzahl der Beobachtungen basiert, die den gleichen Wert aufweisen. Ist ti diese Anzahl, so ist die

Bindungsbewertung durch

t2 − 1

bi = i

48

zu bestimmen. Ist ti = 1 (gibt es also keine weitere Beobachtung mit identischem

Wert), ist bi = 0, ansonsten ist bi > 0.

Die Varianz der Teststatistik W ist unter Gültigkeit der Nullhypothese:

Var(W ) =

n

n 2

n(n + 1)(2n + 1)

n(n + 1)(2n + 1)

t −1

− ∑ bi =

−∑ i

24

24

i=1

i=1 48

Da bei Rangbindungen ∑ni=1 bi > 0 ist, wird die Varianz von W bei Berücksichtigung

der Rangbindungen kleiner.

Fasst man die K Fälle mit Rangbindungen zusammen, so hat jeder Fall die Häufigkeit

tk und die Bestimmung der Varianz beschleunigt sich etwas durch die Berechnung

Var(W ) =

K t3 − t

n(n + 1)(2n + 1)

k

−∑ k

24

k=1 48

Es gilt damit

W − 41 n(n + 1)

q

n(n+1)(2n+1)

24

t 3 −t

− ∑Kk=1 k48 k

∼ N(0, 1).

Wird die Rangbindungskorrektur der Varianz nicht genutzt, entscheidet der Test konservativ, d. h. zu häufig zugunsten der Nullhypothese.

1.10 Vergleich von Testgütefunktionen bei Einstichprobentests (3 / S.

91)

Die in Abbildung 3.4 (Bd 3, S. 91) dargestellten Testgütekurven zeigen, dass die Testgüte umso höher ist, je mehr Voraussetzungen die Tests machen. Wie im Zusammenhang mit dem zentralen Grenzwertsatz ausgeführt wurde, mag die Anwendung des tTest insbesondere, wenn Ausreißer vorliegen, erst bei höheren Stichprobenumfängen

gerechtfertigt sein. Insofern ist dementsprechend bei geringeren Stichprobenumfängen auch die Testgüte mit Vorsicht zu betrachten. Schiefe Stichprobenverteilungen

Kapitel 1 Ableitungen

15

mögen aus schiefen Populationsverteilungen stammen. Sprechen theoretische Gründe oder bisherige empirische Untersuchungen gegen symmetrische Verteilungen, ist

man auf alle Fälle auf der sicheren Seite, wenn man die Poweranalysen ausgehend

vom Vorzeichentest durchführt.

1.11 Überprüfung der bivariaten Normalverteilung (5 / S. 125)

Ein Test auf Gültigkeit der bivariaten Normalverteilung kann als Spezialfall eines

Tests auf Gültigkeit der multivariaten Normalverteilung durchgeführt werden. Bekannte Tests dafür sind die Tests von Mardia, Henze-Zirkler oder Royston (s. Korkmaz, Goksuluk & Zararsiz, 2016). Die Durchführung dieser Tests kann z. B. anhand

des R-Programms MVN von Korkmaz, Goksuluk und Zararsiz (2016) erfolgen.

1.12 Monte-Carlo-Verfahren bei Randomisierungstests (5 / S. 130)

Exakte Randomisierungstests verlangen oft auch schon bei kleinen Stichproben viel

Computerzeit. Eine Möglichkeit diese Tests (dann wiederum aber nur approximativ)

durchzuführen, ist die Simulation der Teststatistik unter der zu testenden Hypothesen.

Will man etwa eine Korrelation überprüfen, erzeugt man eine Kollektion von „zufällig“ erzeugten Permutationen der Messwerte der Variable Y , die wir mit perm(Y1 ), ...,

perm(YK ) bezeichnen. Die Korrelationen r1 = r(X, perm(Y1 )), ..., rK = r(X, perm(YK ))

sowie r0 = r(X,Y ) erzeugen eine simulierte Verteilung der Korrelationskoeffizienten

unter Gültigkeit der Nullhypothese.

Zählt man nun die Anzahl der Korrelationen, die größer-gleich der beobachteten Korrelation r0 in dieser simulierten Verteilung (inklusive r0 ) sind und relativiert diese

Anzahl mit möglicher Maximalzahl K + 1, so erhält man eine Abschätzung für den

p-Wert unter Gültigkeit der Nullhypothese.

In der Regel wird K = 999 oder mehr genutzt, um eine stabile Schätzung für den

p-Wert zu erhalten.

In R kann man mithilfe der Bibliothek boot sehr einfach und sehr flexibel derartige

Simulationen für frei wählbare Statistiken erzeugen.

16

Kapitel 1

1.13 Normalverteilungsapproximation der Testverteilung von

Kendall’s τ bei Rangbindungen (5 / S. 134)

Der Erwartungswert von Kendalls τ ist bei Gültigkeit der Nullhypothese immer 0.

Die Ableitung der Varianz ist hingegen sehr aufwändig. Mit Sillito (1947) kann die

Berechnung nachvollzogen werden. Die Konvergenz der Testverteilung gegen die

Normalverteilung ist auch hier früh (n > 10) gegeben, wenn die Anzahl der Rangbindungen nicht extrem hoch ist.

1.14 Post-hoc-Tests in der Kontingenztafelanalyse (5 / S. 140)

Fällt eine Kontingenztafelanalyse signifikant aus, stellt sich die Frage, welche Häufigkeiten in den Zellenkombinationen „weit“ von ihren Erwartungswerten entfernt

sind. Hierfür werden sog. standardisierte adjustierte Residuen für interessante (oder

alle) Zellenkombinationen berechnet. Ist ni j die Zellenhäufigkeit, ni. und n. j die Randsummen sowie N die Gesamtzahl aller Beobachtungen, so ist

ni j − ni. n. j /N

RESi j = p

ni. n. j /N(1 − ni. /N)(1 − n. j /N)

die Berechnungsformel für das standardisierte adjustierte Residuum.

Der Erwartungswert ei j ist durch ni. n. j /N bestimmt. Deshalb gilt ebenfalls

ni j − ei j

RESi j = p

ei j (1 − ni. /N)(1 − n. j /N)

Unter Gültigkeit der Nullhypothese ist jedes RESi j näherungsweise N(0, 1)-verteilt

(Haberman, 1978, S. 121).

Will man nun nur eine Zelle überprüfen, kann man anhand der Normalverteilung entscheiden, ob die Häufigkeit für diese Zelle signifikant vom Erwartungswert entfernt

ist.

Will man mehrere (oder alle) Zellen überprüfen, sollte eine Bonferroni-Adjustierung

(oder Bonferroni-Holm-Adjustierung) genutzt werden, um die kritischen Zellen zu

identifizieren.

Bei diesem Test muss man die Anzahl der Freiheitsgrade mit berücksichtigen. So

erübrigt sich das Verfahren für 2 × 2-Tabellen, da alle Residuen (bis auf das Vorzeichen) identisch sind. Bei einer J × 2-Tabelle ist eine der beiden Spalten zu betrachten,

da die Residuen in den Zeilen jeweils vom Betrag her identisch sind. Analog sind in

2 × K-Tabellen nur eine der beiden Zeilen zu betrachten, da die Residuen in den

Spalten jeweils vom Betrag her identisch sind.

Kapitel 1 Ableitungen

17

1.15 Der Fisher-Yates-Test und die hypergeometrische Verteilung (5 /

S. 142)

Wird bei einer 2 × 2-Tabelle

A=1

A=2

Spaltensumme

B=1

n11

n21

n.1

B=2

n12

n22

n.2

Zeilensumme

n1.

n2.

n

ein hypergeometrisches Sampling angenommen, d.h. wird angenommen, dass die

Randsummen n1. , n2. , n.1 , n.2 feste Werte sind, dann ist bei fehlender Assoziation

zwischen A und B (Nullhypothese), die Wahrscheinlichkeit P(h11 = n11 ) durch die

hypergeometrische Verteilung zu bestimmen.

Hierfür sei an die Einführung der hypergeometrischen Verteilung (Holling & Gediga,

2013) erinnert: Zieht man ohne zurücklegen n1. Kugeln aus einer Urne mit n Kugeln,

von denen n.1 Kugeln schwarz und n.2 Kugeln eine andere Farbe haben, so ist die

Wahrscheinlichkeit genau n11 schwarze Kugeln bei n1. Ziehungen zu erhalten durch

die hypergeometrische Verteilung, also

P(h11 = n11 ) =

n1. !n2. !n.1 !n.2

n!n11 !n12 !n21 !n22 !

zu berechnen.

Das Urnenmodell beschreibt damit exakt die Annahmen bei fehlender Assoziation

in einer 2 × 2-Tabelle und die hypergeometrische Verteilung ist damit die adäquate

Verteilung der Teststatistik n11 für diesen Fall.

1.16 Exakte Tests bei k × m-Tabellen (5 / S. 143)

Die Logik exakter Tests für allgemeine k × m-Tabellen ist ähnlich wie die bei Fisher’s exaktem Test. Zunächst wird auch in diesem Fall mit dem hypergeometrischen

Testmodell gerechnet, d.h. ein bedingter Test bei Annahme gleicher Randsummen

durchgeführt.

Als Teststatistik wird der χ 2 -Wert mit den Ausgangsdaten berechnet:

χ2 = ∑

i, j

(oi, j − ei, j )2

ei, j

18

Kapitel 1

Hierbei sind oi, j die beobachteten Häufigkeiten und ei, j die erwarteten Häufigkeiten.

Um die Wahrscheinlichkeit

P χ 2 ≤ χ 2 (H0 )

auszurechnen (also den p-Wert der χ 2 -Statistik), bestimmt man alle möglichen Tabellen T , die die gleichen Randsummen aufweisen wie die beobachteten Randsummen. Für diese Tabellen sind die Erwartungswerte pro Zelle ebenfalls ei, j und für die

Berechnung des p-Werts nutzen wir alle die Tabellen T , für die gilt

χ 2 (T ) = ∑

i, j

(ti, j − ei, j )2

≥ χ2

ei, j

Die Wahrscheinlichkeit P χ 2 ≤ χ 2 (H0 ) lässt sich dann im Prinzip einfach ausrechnen. Sie ist:

P χ 2 ≤ χ 2 (H0 ) =

∑ P(T )

T mitχ 2 ≤χ 2 (T )

Die Wahrscheinlichkeit P(T ) lässt sich mit einer verallgemeinerten hypergeometrischen Verteilung berechnen und die Erzeugung aller Tabellen T zu festen Randsummen ist möglich – wenngleich algorithmische Schwerstarbeit.

Für SPSS ist das Model Exact tests entwickelt worden, dass die exakte Berechnung des p-Wertes vornimmt. Die Berechnung ist allerdings auf N ≤ 30 begrenzt, da

die Anzahl der möglichen Tabellen sehr schnell sehr groß wird.

Eine einfache (approximative) Lösung bieten Simulationsansätze (ähnlich denen bei

Randomisierungstests). Hier wird eine feste Menge von Tabellen T per Zufall generiert (z.B. kT Tabellen) und der p-Wert wird nun approximativ bestimmt mittels

!

kT

1

1 + ∑ Ind χ 2 ≤ χ 2 (kT )

1 + kT

i=1

Ind() ist hier wieder die Indikatorfunktion, die den Wert 1 liefert, wenn die Bedingung erfüllt ist, und 0 sonst. In SPSS ist diese Simulation für Kreuztabellen abrufbar.

Für R kann das Paket coin genutzt werden.

1.17 Normalverteilungsapproximation der Testverteilung des

Log-Odds-Ratios (5 / S. 144)

Viele Testverteilungen von Funktionen von Zufallsvariablen werden durch einen Linearisierungansatz erzeugt, der Delta-Methode genannt wird. Im Falle multinomialverteilter Zufallsvariablen erhält man für eine Funktion f , die von den Wahrschein-

Kapitel 1 Ableitungen

19

lichkeiten f (π1 , ...πk ) abhängt, folgende Approximation für die Funktion basierend

auf den Schätzern der Wahrscheinlichkeiten:

k

∂f

(πb1 , . . . , πbk ) · (πbi − πbi ),

i=1 ∂ πi

i

h

Var( f (πb1 , . . . , πbk )) ≈ E ( f (πb1 , . . . , πbk ) − f (πb1 , . . . , πbk ))2

"

#

k

∂f

≈ E (∑

(πb1 , . . . , πbk ) · (πbi − πbi ))2 .

i=1 ∂ πi

f (πb1 , . . . , πbk ) ≈ f (πb1 , . . . , πbk ) + ∑

Die Terme ∂∂πfi (πb1 , . . . , πbk ) sind konstant, da hier keine Zufallseinflüsse eingehen. Mit

dieser Linearisierung erfolgt die Approximation der Varianz von f (πb1 , . . . , πbk ):

Var[∑ Yi ] = ∑ Var[Yi ] + 2 ∑ COV[Yi ,Y j ],

i> j

i

i

2

Var[cY ] = c Y,

COV[cYi , dY j ] = c · d COV[Yi ,Y j ],

und damit:

∂f 2

∂f ∂f

Var( f (πb1 , . . . , πbk )) ≈ ∑ Var(πbi ) ·

+ 2 ∑ COV(πbi , πbj ) ·

·

∂ πi

∂ πi ∂ π j

i> j

i=1

k

∂f ∂f

∂f 2

2

+ 2 ∑ COV(πbi , πbj ) ·

·

.

= ∑ SE(πbi ) ·

∂ πi

∂ πi ∂ π j

i> j

i=1

k

Damit folgt

k

πi (1 − πi )

Var( fˆ) ≈ ∑

n

i=1

∂f

∂ πi

2

πi π j ∂ f ∂ f

·

·

.

∂ πi ∂ π j

i> j n

−2∑

d fˆ) zu berechnen, ersetzen wir πbi für die unbekannten Terme πi .

Um nun Var(

Allgemein gilt, dass für Maximum-Likelihood-Schätzer eines Parameters θ nicht nur

θ̂ approximativ normalverteilt ist, sondern auch f (θ̂ ), wenn f eine stetige und differenzierbare Funktion ist. Damit gilt aber auch, dass g( f (θ̂ )) approximativ normalverteilt ist. Man hat also die Freiheit mittels g eine Funktion zu finden, für die die

Approximation auch für kleines n schon sehr gut ist. Im Fall von

f = OR =

π11 π22

π12 π21

ist die Logarithmus-Funktion ein guter Kandidat.

20

Kapitel 1

Wir nutzen also die Delta-Methode für die Funktion

π11 π22

log( f ) = log

π12 π21

= log(π11 ) + log(π22 ) − log(π12 ) − log(π22 )

Die für die Delta-Methode notwendigen Ableitungen von f sind nun:

∂f

∂ π11

∂f

∂ π22

∂f

∂ π12

∂f

∂ π21

1

π11

1

=

π22

1

=−

π12

1

=−

π21

=

Damit folgt

π11 (1 − π11 ) 1

π22 (1 − π22 ) 1

+

2

2

n

n

π11

π22

π12 (1 − π12 ) 1

π21 (1 − π21 ) 1

+

+

2

2

n

n

π12

π21

π11 π12 1 −1

π11 π22 1 1

−2

−2

n π11 π22

n π11 π12

π11 π21 1 −1

π22 π12 1 −1

−2

−2

n π11 π21

n π22 π12

π22 π21 1 −1

π12 π21 −1 −1

−2

−2

n π22 π21

n π12 π21

(1 − π11 ) (1 − π22 ) (1 − π12 ) (1 − π21 ) 4

=

+

+

+

+

n · π11

n · π22

n · π12

n · π21

n

1

1

1

1

=

+

+

+

n · π11 n · π22 n · π12 n · π21

1 1

1

1

1

=

+

+

+

n π11 π22 π12 π21

Var( fˆ) ≈

Damit ist die Schätzung

\ =1

d ln(OR))

Var(

n

1

1

1

1

+

+

+

π̂11 π̂22 π̂12 π̂21

gegeben, die wir im Buch genutzt haben.

Kapitel 1 Ableitungen

21

1.18 Ausreißer und große Schiefe und der zentrale Grenzwertsatz (6 /

S. 160)

Wir verweisen hier auf die obigen Ausführungen zur Anwendbarkeit des zentralen

Grenzwertsatzes (3 / S. 69).

1.19 Die Deffizienz im Zweistichprobenfall (6 / S. 166)

Für den t-Test für heterogene Varianzen ist es nicht optimal, für beide Gruppen einen

gleich großen Stichprobenumfang zu verwenden. Unter der Voraussetzung normalverteilter Daten sollte hier der Stichprobenumfang für die Gruppe mit der größeren

Standardabweichung proportional größer sein. Es gilt: nn21 = σσ12 (vgl. z. B. Dette &

O´Brien, 2004).

1.20 Die White-Korrektur im linearen Modell (6 / S. 175 und 9 / S. 361)

Ein lineares Modell lässt sich mithilfe der Matrizenschreibweise kompakt wie folgt

darstellen:

y = Xβ + ε

Hierbei wird angenommen, dass E(ε) = 0 ist und dass die Matrix E(εε 0 ) = Ψ positiv

definit ist.

In diesem Fall ist

β̂ = (X 0 X)−1 X 0 y

der beste lineare unverzerrte Schätzer für β mit der Varianz-Kovarianz-Matrix

Var(β̂ ) = (X 0 X)−1 X 0 ΨX(X 0 X)−1

Im homoskedastischen Fall ist Ψ = σ 2 I und wir erhalten

Var(β̂ ) = σ 2 (X 0 X)−1

Üblicherweise wird σ 2 durch das mittlere Fehlerquadrat MSE geschätzt.

Mit der Schätzung

\

Var(β̂ ) = MSE · (X 0 X)−1

lassen sich dann die Konfidenzbänder für die β -Gewichte oder der F-Test für die

Regression berechnen.

\

Im heteroskedastischen Fall wird Var(β̂ ) folgendermaßen besser geschätzt.

22

Kapitel 1

Nach White (1980) ist

HC0 = (X 0 X)−1 X 0 diag(ε̂i2 )X(X 0 X)−1

\

ein asymptotisch konsistenter Schätzer für Var(β̂ ). Dieser Schätzer hat jedoch den

Nachteil, dass die Asymptotik erst spät einsetzt, d. h. dass er große Stichproben benötigt, um brauchbare Schätzungen zu produzieren.

Es wurden in der Folge weitere Schätzer vorgeschlagen, die auch für kleinere Stichproben bereits gute Ergebnisse erzielen. Wir diskutieren hier zwei weitere (beide

vorgeschlagen von MacKinnon und White, 1985):

2 ε̂i

0

−1 0

HC2 = (X X) X diag

X(X 0 X)−1

1 − hii

und

ε̂i2

X(X 0 X)−1

HC3 = (X X) X diag

(1 − hii )2

Hierbei ist hii ein Diagonalelement der sog. Hat-Matrix, das durch

0

−1

0

hii = xi (X 0 X)−1 xi0

berechnet werden kann.

Das lineare Modell mittels HC2 und der t − Test für homogene Stichproben sind bei

gleichen Stichprobengrößen äquivalent. Da dies auch für den heteroskedastischen

Fall gilt, kann der Test mithilfe des HC2-Schätzers den t-Test in diesem Fall ersetzen

(s. Holling & Gediga, Bd 3, S. 175 ff. und den nächsten Abschnitt). Dies gilt nicht für

den HC3-Schätzer, der in diesem Fall konservativ testet, d.h. im homoskedastischen

Fall unter Gültigkeit der Nullhypothese weniger signifikante Ergebnisse anzeigt, als

vorgegeben. Liegen nominalsaklierte Prädiktoren vor, scheint somit HC2 der günstigste Schätzer zu sein. Für den allgemeinen Fall zeigen jedoch die Simulationen von

Long und Ervin (2000), dass HC3 den anderen Schätzern überlegen ist.

Im dem hier zugrunde liegenden Buch wurde die Software zur Berechnung der HCSchätzer für das Programmpaket R ausgiebig dargestellt. Für SPSS liegen Makros

vor (Hayes & Cai, 2007), die man unter

http://afhayes.com/spss-sas-and-mplus-macros-and-code.html

finden kann.

1.21 Asymptotische Konsistenz des thom -Tests bei Heteroskedastizität

(6 / S. 176)

Die Hat-Matrix H berechnet sich durch

h = X(X 0 X)−1 X 0

Kapitel 1 Ableitungen

23

Nutzt man die Effektkodierung für den t-Test mit gleich großen Stichproben – also

n/2 Einträge mit der 1 für Gruppe a und n/2 Einträge mit der −1 für Gruppe b – so

ergibt sich für die Diagonalelemente der Wert

hi,i = 2/n

Damit ist

HC2 =

1

1−2/n

und

HC0 =

=

=

=

1

(X 0 X)−1 X 0 diag(ε̂i2 )X(X 0 X)−1

1 − 2/n

n n

n − 2 n2

n/2

∑ (yi − ȳa )2 + ∑

i=1

!

n

(yi − ȳb )2

i=n/2+1

1

(n/2 − 1)s2a + (n/2 − 1)s2b

n−2

(na − 1)s2a + (nb − 1)s2b

na + nb − 2

HC2 entspricht damit exakt dem Quadrat des Standardfehlers im t-Test für homogene

Varianzen.

Ist Varianzhomogenität gegeben, dann ist HC2 für ein 2-Gruppen-Design die beste

Korrektur unter allen HC-Korrekturen, so fällt die Testvarianz bei Verwendung von

HC3 um den Faktor 1/(1 − 2/n) zu gross aus – der Test ist dann folglich konservativ.

Andererseits sieht man, dass der t-Test für homogene Varianzen bei gleich großen

Stichproben auch dann genutzt werden darf, wenn die Varianzen in der Population

unterschiedlich sind. Der t-Test ist asymptotisch konsistent, da er mit der asymptotisch konsistenten HC2-Korrektur zusammenfällt.

1.22 Beispiel für einen Lokationsunterschied bei undefinierten

Erwartungswerten (6 / S. 183)

Die Verteilung mit der Dichte

f (y) =

1

bπ 1 +

y−a 2

b

24

Kapitel 1

wird als Cauchy-Verteilung bezeichnet. Die Verteilung ist symmetrisch um den Parameter a und die Breite der Verteilung wird mit dem Parameter b eingestellt.

Die t-Verteilung mit einem Freiheitsgrad ist eine Cauchy-Verteilung mit a = 0 und

b = 1.

Will man den Erwartungswert dieser Verteilung berechnen, so stellt man fest, dass

dies nicht möglich ist, da das Ergebnis der Integration „∞ − ∞“ ist. Die Verteilung

besitzt damit keinen berechenbaren Erwartungswert. Der Median ist wegen der Symmetrie um a mit dem Wert a gegeben.

Hat man nun zwei Populationen vorliegen, in denen eine Variable mit einer CauchyVerteilung gemessen wird, so können die Mediane dieser beiden Variablen eine Differenz aufweisen, was man etwa mit einem Wilcoxon-Rangsummentest überprüfen

kann (wenn in beiden Populationen die Breite der Verteilungen identisch ist). Offensichtlich ist hier ein t-Test nicht angemessen, da der Populationsparameter µ nicht

existiert.

Da der Erwartungswert nicht bestimmt werden kann, ist im übrigen auch die Varianz

der Verteilung nicht bestimmbar. Dennoch kann die Breite der Cauchy-Verteilung

mit dem Parameter b verändert werden – d.h. b ist ein Variationsparameter (nur eben

keine Varianz).

1.23 Berechnung der Verteilung des Wilcoxon-Rangsummentests (6 /

S. 183)

Insgesamt erhalten für die zwei Gruppen n + m Beobachtungen. Es gibt damit

n+m

n

unterschiedliche Rangvergaben für Gruppen mit n Beobachtungen (wir wählen praktischerweise hier die kleinere Gruppe für die Berechungen). Unter Gültigkeit der

Nullhypothese sind alle diese Möglichkeiten gleich wahrscheinlich.

Die Wahrscheinlichkeit einen bestimmten Rangsummenwert w zu erhalten ist somit

anzahl(w)

P(W = w|H0 ) =

n+m

n

Beispiel: Ist n = 2 und m = 3, gibt es insgesamt 2+3

= 10 unterschiedliche Rang2

vergaben. Die Auszählung der Möglichkeiten ergibt:

Kapitel 1 Ableitungen

w

3

4

5

6

7

8

9

Rangwerte

(1,2)

(1,3)

(1,4), (2,3)

(1,5), (2,4)

(1,6), (3,4)

(3,5)

(4,5)

25

P(W = w)

.1

.1

.2

.2

.2

.1

.1

Wie bereits im Buch betont, hängt die Berechnung der Verteilung der Teststatistik

nicht von den Daten ab.

Für das Beispiel kann die obige Tabelle wie folgt ausgewertet werden:

P(W ≤ 3|H0 ) = .1 oder P(W ≥ 9|H0 ) = .1.

1.24 Teststatistik des Wilcoxon-Rangsummentests (6 / S. 184)

Die Rangsummenstatistik W ist durch

n+m

W=

∑ i · Zi

i=1

gegeben. Hierbei ist Zi = 1, wenn der entsprechende Rang der kleineren Gruppe (mit

n Beobachtungen) zugeordnet wurde und Zi = 0 sonst. Um es etwas übersichtlicher

zu gestalten, definieren wir mit N := n + m die Größe der Gesamtstichprobe.

Es gilt

E(Zi ) =

Var(Zi ) =

Cov(Zi , Z j ) =

n

N

n·m

N2

−n · m

2

N (N − 1)

für (i 6= j)

Der Erwartungswert ist damit

N

E(W ) = ∑ iE(Zi ) =

i=1

n N

n N(N + 1) n(N + 1)

i=

=

∑

N i=1

N

2

2

26

Kapitel 1

Für die Varianz gilt

n+m

Var(W ) = Var

!

∑ i · Zi

i=1

N

=

N

N

∑ i2Var(Zi ) + ∑ ∑

i=1

i · j ·COV (Zi , Z j )

i=1 j=1;i6=i

n·m

n·m N N

− ∑ ∑ i· j 2

2

N

N

(N

− 1)

i=1 j=1;i6=i

i=1

!

n·m N 2

1 N N

∑i − N −1 ∑ ∑ i· j

N 2 i=1

i=1 j=1;i6=i

!2

N

N

N

1

n·m

1

i2 +

i2 −

∑

∑

∑i

2

N

N

−

1

N

−

1

i=1

i=1

i=1

!2

N

N

1

n·m

1

1+

i2 −

∑

∑i

2

N

N − 1 i=1

N − 1 i=1

!2

N

N

n·m N

1

∑ i2 − N − 1 ∑ i

N2

N − 1 i=1

i=1

!2

N

N

n·m

N ∑ i2 − ∑ i

N 2 (N − 1)

i=1

i=1

N

=

=

=

=

=

=

=

=

=

=

=

=

=

=

∑ i2

!

N(N + 1)(2N + 1)

N(N + 1) 2

N

−

6

2

2

N (N + 1)(2N + 1) N 2 (N + 1)2

n·m

−

N 2 (N − 1)

6

4

n · m(N + 1) 2N + 1 N + 1

−

N −1

6

4

n · m(N + 1) 2(2N + 1) 3(N + 1)

−

N −1

12

12

n · m(N + 1) 4N + 2 − 3N − 3

N −1

12

n · m(N + 1) N − 1

N −1

12

n · m(N + 1)

12

n · m(n + m + 1)

12

n·m

N 2 (N − 1)

Kapitel 1 Ableitungen

27

Im Falle von Rangbindungen ändert sich der Erwartungswert der Teststatistik bei

Gültigkeit der Nullhypothese nicht. Wie im Fall der Rangvorzeichentests ist die Varianz allerdings kleiner. Zur Korrektur werden wieder die unterschiedlichen K gebundenen Ränge gezählt (unabhängig von der Zuordnung zu der Stichprobe) und mit der

t 3 −t

Wertung bk = Nk3 −Nk die Varianz mittels

Var(W )korr =

Var(W )

t 3 −t

1 − ∑Kk=1 Nk3 −Nk

korrigiert.

Alternativ kann man auch für n > 25 und m > 25 den asymptotischen t-Test nutzen.

1.25 Der Fligner-Policello-Test (6 / S. 190)

Liegt bei dem Vergleich von zwei Gruppen Varianzheterogenität vor bzw. – allgemeiner – unterscheiden sich die beiden Verteilungen, dann ist der Wilcoxon-Rangsummentest

(bzw. der U-Test) nicht zulässig, wobei dieser dieselben Probleme aufweist wie der

thom -Test.

Als Alternative haben Fligner und Policello (1981) einen Test entwickelt, der neben

der Annahme symmetrischer Verteilungen um den Gruppenmedian keine weiteren

Annahmen braucht, also für stark unterschiedliche Verteilungen in den Gruppen anwendbar ist.

Für die Messwerte der x1 , ..., xnX der ersten Gruppe und y1 , ..., ynY werden sogenannte

Plazierungssummen gebildet:

nY

PS(xi ) =

1

∑ IND(y j < xi ) + 2 IND(y j = xi )

j=1

nX

PS(y j ) =

1

∑ IND(xi < y j ) + 2 IND(xi = y j )

i=1

Hierbei ist IND(·) die Indikatorfunktion, die den Wert 1 aufweist, wenn die Bedingung zutrifft, und 0 sonst. Unter Gültigkeit der Nullhypothese (gleiche Mediane)

ist

nX

FP =

nY

∑ PS(xi ) − ∑ PS(y j )

i=1

j=1

approximativ normalverteilt mit Erwartungswert 0 und einer Varianz, die durch

Var(FP) = 4 (VX +VY + PSX PSY )

28

Kapitel 1

geschätzt werden kann, mit

PSX

PSY

=

=

1

nX

1

nY

nX

∑ PS(xi )

i=1

nY

∑ PS(y j )

j=1

nX

VX

=

∑ (PS(xi ) − PSX )2

i=1

nY

VY

=

∑ (PS(y j ) − PSY )2

j=1

Die folgende R-Funktion kann zur Berechnung des Fligner-Policello-Tests genutzt

werden:

fligner.policello.test <- function(x,y)

{ nx<-length(x); ny<-length(y)

px<-x; py<-y

meanpx <- 0

for (i in 1:nx)

{ px[i]<-0

for (j in 1:ny)

{ if (y[j]< x[i]) px[i] <- px[i]+1

if (y[j]==x[i]) px[i] <- px[i]+0.5

}

meanpx<-meanpx + px[i]/nx

}

meanpy<-0

for (j in 1:ny)

{ py[j]<-0

for (i in 1:nx)

{ if (x[i]< y[j]) py[j] <- py[j]+1

if (y[j]==x[i]) py[j] <- py[j]+0.5

}

meanpy<-meanpy + py[j]/ny

}

Vx<-0

for (i in 1:nx)

{ Vx <- Vx + (px[i] - meanpx)*(px[i] - meanpx)

}

Vy<-0

Kapitel 1 Ableitungen

29

for (j in 1:ny)

{ Vy <- Vy + (py[j] - meanpy)*(py[j] - meanpy)

}

z <- (ny*meanpy-nx*meanpx)/

(2*sqrt(Vx+Vy+meanpx*meanpy))

p <- pnorm(z); if (p>0.5) p<-(1-p); p<-2*p

retval<-list(p,z,meanpx,meanpy,Vx,Vy)

names(retval)<-c("p","z","meanpx","meanpy","Vx","Vy")

return (retval)

}

1.26 Normalverteilungsapproximation der Teststatistik für den

Wilcoxon-Vorzeichen-Rangtest für abhängige Stichproben (6 / S.

197)

Diese Thematik wurde bereits im Zusammenhang mit (3 / S. 88) behandelt.

1.27 Symmetrie-Tests (6 / S. 198)

Wie in Holling und Gediga (2011) gezeigt, kann anhand des Abstands Ȳ − Ymed abgelesen werden, ob eine Verteilung schief ist.

Cabilio und Masaro (1996) nutzen als Teststatistik

C=

Ȳ −Ymed

S

wobei S die Standardabweichung der Daten schätzt. C ist hierbei (bei normalverteilten Daten) N(0, 0.5708)-verteilt.

Da ein Symmetrie-Test zu Beginn des Datenanalyseprozesses genutzt wird, können

noch Ausreißer in den Daten vorliegen. Man ersetzt dann besser (Miao, Gel & Gastwirth, 2006) S durch die robuste Schätzung J mit

r

π ∑ j |Yi −Ymed |

J=

·

.

2

n

Hierbei schätzt J in normalverteilten Populationen wieder die Standardabweichung

und

Ȳ −Ymed

CJ =

J

ist bei Normalverteilung wieder N(0, 0.5708)-verteilt.

30

Kapitel 1

1.28 Der Fligner-Policello-Test (6 / S. 213)

Diese Thematik wurde schon unter den Ausführungen zum Fligner-Policello-Test (6

/ S. 190) behandelt.

1.29 Berechnung der Mittelwerte im Fall gleich großer Gruppen in der

einfaktoriellen Varianzanalyse (7 / S. 230)

Y •• =

Bei gleich großen Gruppen gilt:

Damit resultiert:

1

n

=

Y •• =

=

=

nj

J

1

n

∑ ∑ Yi j

j=1 i=1

1

J×n j .

1

J ×nj

1

J

J

nj

∑ ∑ Yi j

j=1 i=1

nj

J

∑i=1 Yi j

∑

nj

j=1

1 J

∑Y•j

J i=1

1.30 χ 2 -Verteilung von SSBG /σ 2 in der einfaktoriellen Varianzanalyse

(7 / S. 231)

Ausgangspunkt bildet die Zerlegung der Abweichungsquadrate der Gruppenmittelwerte vom Populationsmittelwert µ:

J

I ∑ Y•j − µ

2

j=1

J

= I ∑ Y • j −Y ••

j=1

2

J

= I ∑ Y • j −Y •• +Y •• − µ

j=1

J

+ I ∑ Y •• − µ

j=1

J

= I ∑ Y • j −Y ••

j=1

2

2

2

J

+ 2I ∑ Y • j −Y •• )(Y •• − µ

j=1

+ IJ Y •• − µ

2

Kapitel 1 Ableitungen

31

Der letzte Term in der vorletzten Gleichung fällt weg, weil die Summe der Abweichungen der Gruppenmittelwerte vom Gesamtmittelwert 0 ist. Der zweite Term in

der letzten Gleichung ergibt sich dadurch, dass J mal über eine Konstante summiert

wird.

J

I ∑ Y • j −Y ••

2

+ IJ Y •• − µ

2

= SSBG + IJ Y •• − µ

2

j=1

Der erste Term wird nun durch SSBG ersetzt. Anschließend wird auf beiden Seiten

der Gleichung durch σ 2 geteilt.

I ∑Jj=1 Y • j − µ

σ2

2

SSBG IJ Y •• − µ

= 2 +

σ

σ2

2

Y •• − µ

SSBG

= 2 +

σ

σ 2 /IJ

∑Jj=1 Y • j − µ

σ 2 /I

2

2

√

Da alle Y • j unter der Nullhypothese i.i.d. N( µ,σ / I) verteilt sind, ist der Term auf

der linken Seite der Gleichung χ 2 -verteilt mit J Freiheitsgraden. Der zweite Term

auf der rechten Seite der Gleichung ist χ 2 -verteilt mit einem Freiheitsgrad. Weil die

beiden Terme auf der rechten Seite der Gleichung statistisch unabhängig sind und

aufgrund der Additivität der χ 2 -Verteilung folgt, dass SSBG /σ 2 unter der Nullhypothese χ 2 -verteilt ist mit J-1 Freiheitsgraden.

1.31 Die Deffizienz in der einfaktoriellen Varianzanalyse (7 / S. 235)

Beispiele für notwendige Stichprobenumfänge bei ungleich

besetzten Zellen in der einfaktoriellen Varianzanalyse (7 / S.

235)

Betrachtet man die Power für die generelle Nullhypothese in der einfaktoriellen wie

auch mehrfaktoriellen Varianzanalyse in Abhängigkeit von den Stichprobenumfängen der Gruppen, so ergibt sich eine maximale Power, wenn gleich große Stichprobenumfänge für die Gruppen, d. h. ein balanciertes Design, gewählt werden. Das

gleiche Resultat gilt für die D-Optimalität, d. h. der Minimierung des Volumens der

Konfidenzellipsoide für die Parameterschätzungen bzw. die Miminierung der korrespondierenden Deffizienz. Gezeigt wurde dieses Resultat bereits für den t-Test für

homogene Varianzen, der ein Spezialfall der Varianzanalyse ist. Formal ist für die

32

Kapitel 1

Erzielung der D-Optimalität das Produkt der Stichprobenumfänge ∏Jj=1 n j zu minimieren. Diese Produkt wird im Falle gleich großer Stichprobenumfänge n j minimal

(vgl. Silvey, 1980).

Beim t-Test für homogene Varianzen konnte der Verlust der Power bzw. Deffizienz

einfach als Funktion des prozentualen Stichprobenumfangs einer der beiden Gruppen

dargestellt werden. Bei der Varianzanalyse ist aber das Verhältnis des Stichprobenumfangs mehrerer Gruppen zu berücksichtigen. Hier kann man für bestimmte Fälle

die Deffizienz anhand bestimmter EDV-Programme zur Berechnung der Power für

unbalancierte (und damit natürlich auch für balancierte) Fälle bestimmen, wie z. B.

anhand des Moduls zur Powerberechnung des Programmpakets STATA.

Wir zeigen als Beispiel die Deffizienz anhand eines 2 x 4-Designs. In der folgenden

Tabelle sind unterschiedliche Designs dargestellt, wobei das Design 1 balanciert ist,

d. h. gleich große Stichprobenumfänge besitzt. Für die übrigen unbalancierten Designs ist jeweils die Deffizienz angegeben.

1

Factor B

2

3

4

Deffizienz

Factor A

Design 1

1

2

0.125

0.125

0.125

0.125

0.125

0.125

0.125

0.125

Design 2

1

2

0.175

0.075

0.175

0.075

0.175

0.075

0.175

0.075

1.092

Design 3

1

2

0.200

0.200

0.150

0.150

0.100

0.100

0.050

0.050

1.130

Design 4

1

2

0.250

0.125

0.200

0.100

0.150

0.050

0.100

0.025

1.225

1.32 Verteilung eines Kontrastes unter der Nullhypothese (7 / S. 238)

Wie bereits ausgeführt wurde, sind die Schätzer Y • j statistisch unabhängig. Weiterhin

√

gilt Y • j ∼ N(µ, σ / n j ). Da es sich bei dem Schätzer L̂ = ∑Jj=1 c jY • j somit um

eine Linearkombination unabhängig normalverteilter Zufallsvariablen handelt, ist er

ebenfalls normalverteilt (Sahai & Ageel, 2000, S. 67). Daher gilt:

Kapitel 1 Ableitungen

33

√(L̂−L)

√(L̂−L)

(L̂ − L)

z

Var(L̂)

Var(L̂)

q

=q

=q

= t(J − 1)

=q

q

2

d

χ (n−J)

(n−J)Var(L̂)/Var(L̂)

d L̂)

d L̂)/ Var(L̂)

Var(

Var(

n−J

n−J

d L̂) ein Schätzer für Var(L̂) mit n − J Freiheitsgraden ist.

Dies folgt, weil Var(

Vgl. hierzu auch Kirk (1995, S. 124 – 125, S. 129 – 131).

1.33 Zur Schätzung des Standardfehlers bei homogenen Varianzen (7 /

S. 243)

MSW , ein erwartungstreuer und konsistenter Schätzer für σ , schöpft die gesamte Information aus und nicht nur die Information, die auf zwei Gruppen beruht.

1.34 Beispiel zum REGWQ-Verfahren (7 / S. 247)

Das REGWQ-Verfahren bezeichnet eine top-down Testprozedur für alle paarweisen

Vergleiche einer Gruppe von Mittelwerten. Die Stärke des Verfahrens liegt in der Verwendung adjustierter α-Niveaus für verschiedene Stufen des Testverfahrens. Für die

Adjustierung des α-Niveaus werden zunächst die m Mittelwerte der Größe nach geordnet. Das α-Niveau variiert dann als eine Funktion der Schritte, durch die zwei Mittelwerte voneinander getrennt sind. Die Differenz der beiden Mittelwerte, die durch

r = m Schritte getrennt sind, (also der größte und der kleinste Mittelwert) wird zum

Signifikanzniveau α getestet. Anschließend werden alle Mittelwerte, die durch r = m

- 1 Schritte getrennt sind, ebenfalls zum Signifikanzniveau α getestet. Mittelwerte,

die durch r = m - 2, m - 3, . . . , 2 Schritte getrennt sind, werden zum adjustierten Signifikanzniveau ar = 1 − (1 − a)r/m getestet. Fällt ein Vergleich zweier Mittelwerte

nicht signifikant aus, so sind durch Implikation alle paarweisen Vergleiche, die durch

diese Mittelwerte eingeschlossen werden, nicht signifikant.

Die Teststatistik des REGWQ-Verfahrens bildet die studentisierte Range-Statistik:

• j−Y • k

Q = Yq

MS

W

I

34

Kapitel 1

Der kritische Wert, mit dem diese Teststatistik verglichen wird, ist qar (r, v). Dabei

bezeichnet qar das ar Quantil der stundentisierten Range Verteilung, r die Anzahl der

Schritte zwischen Y • j und Y • k und v bezeichnet die Anzahl der Freiheitsgrade, die

mit MSW assoziiert sind, d.h. v = n − J. Die Nullhypothese H0 : µ j − µk = 0 wird

abgelehnt, wenn Q betragsmäßig größer ist als qar (r, v) und der Paarvergleich nicht

durch Implikation eines Paarvergleichs auf höherer Stufe nicht signifikant ist.

Ein Beispiel soll die Durchführung des REGWQ-Verfahrens verdeutlichen. Die folgenden Mittelwerte seien in einem einfaktoriellen Experiment mit fünf Faktorstufen

beobachtet worden.

Y • 1 = 36.7

Y • 2 = 48.7

Y • 3 = 43.4

Y • 4 = 47.2

Y • 5 = 40.3

In dem Experiment wurden 45 Versuchspersonen zufällig den einzelnen Faktorstufen zugewiesen. Für jede der Faktorstufen kann Normalverteilung angenommen werden. Weiterhin sind die Varianzen der Faktorstufen homogen. MSW ergibt sich zu

29.0322.

Zunächst müssen die Mittelwerte nach ihrer Größe geordnet werden. Der Einfachheit

halber, werden die Indizes der Mittelwerte so geändert, dass Y • 1 den kleinsten Mittelwert bezeichnet und Y • 5 den größten.

Y • 1 = 36.7

Y • 2 = 40.3

Y • 3 = 43.4

Y • 4 = 47.2

Y • 5 = 48.7

Die folgende Tabelle zeigt die Differenzen der Mittelwerte für alle möglichen Paarvergleiche.

Y • 1 = 36.7

Y • 2 = 40.3

Y • 3 = 43.4

Y • 4 = 47.2

Y • 5 = 48.7

Y • 1 = 36.7

-

Y • 2 = 40.3

3.6

-

Y • 3 = 43.4

6.7

3.1

-

Y • 4 = 47.2

10.5

6.9

3.8

-

Y • 5 = 48.7

12.0

8.4

5.3

1.5

-

Es wird deutlich, dass keine weiteren signifikanten Ergebnisse zu erwarten sind, wenn

der Vergleich von Y • 1 und Y • 5 nicht signifikant ausfällt. Indem über spätere Vergleiche durch Implikation früherer Vergleiche entschieden wird, wird ein kohärentes

Kapitel 1 Ableitungen

35

Vorgehen gesichert. Außerdem kann sich der Rechenaufwand z.T. erheblich reduzieren.

Die sequenzielle Testprozedur wird durch die folgende Tabelle verdeutlicht. Die kritischen Werte der studentisierten Range Verteilung lassen sich dabei z.B. mit der

Funktion qtukey im Programmpaket R berechnen. In der Tabelle lässt sich erkennen,

dass die Hypothesen µ1 − µ5 = 0, µ1 − µ4 = 0, µ2 − µ5 = 0 und µ2 − µ4 = 0 abgelehnt

werden können. Da die Hypothesen µ1 − µ3 = 0 und µ3 − µ5 = 0 beibehalten werden

müssen, werden auch die übrigen Hypothesen durch Implikation beibehalten. Denn

wenn z.B. die Differenz von Y • 1 und Y • 3 nicht signifikant ist, kann die Differenz von

Y • 1 und Y • 2 nicht signifikant sein.

Anzahl

der

Schritte

zwischen

den

Mittelwerten

Hypothese

|Q|

5

µ1 − µ5 = 0

6.68

4

4

µ1 − µ4 = 0

µ2 − µ5 = 0

5.85

4.68

3

3

3

µ1 − µ3 = 0

µ2 − µ4 = 0

µ3 − µ5 = 0

3.73

3.84

2.95

2

2

2

2

µ1 − µ2 = 0

µ2 − µ3 = 0

µ3 − µ4 = 0

µ4 − µ5 = 0

2.00

1.73

2.12

0.84

REGWQ kritischer Wert und

Testentscheidung

q.05 (5, 40) = 4.04

S

q.05 (4, 40) = 3.79

S

S

q.0303 (3, 40) =

3.75

NS

S

NS

q.0203 (2, 40) =

3.42

NSI

NSI

NSI

NSI

Anmerkung: S = signifikant, NS = nicht signifikant, NSI = nicht signifikant durch

Implikation

Die Ausführungen in diesem Abschnitt sind an Kirk (1995, S. 150 – 154) angelehnt.

Dort werden auch das REGWF- und das REGWFQ-Verfahren vorgestellt. Die Abweichungen in der letzten Tabelle ergeben sich dabei durch eine genauere Berechnung der α-Werte.

36

Kapitel 1

1.35 Äquivalenz des zweiseitigen Wilcoxon-Rangsummen-Tests und

des Kruskal-Wallis-Tests bei zwei Stichproben (7 / S. 249)

H=

12

n(n + 1)

R2j

∑ − 3(n + 1)

j=1 n j

J

Hierbei waren mit R j die Summen der Ränge in den Gruppen 1, . . . , J bezeichnet.

Die Teststatistik des Wilcoxon-Rangsummen-Tests ist

n1

W = ∑ rg(xi ) = R1

i=1

Um den zweiseitigen Wilcoxon-Rangsummen-Test kompakt zu beschreiben, betrachten wir den Abstand der Rangsumme vom Erwartungswert der Rangsumme

W ∗ = R1 −

n1 (n + 1)

2

Für den zweiseitigen Test ist das Quadrat von W ∗ die adäquate Teststatistik. Für zwei

Gruppen gilt

H=

12 R21

+

n(n + 1) n1

n(n+1)

2

− R1

2

n2

− 3(n + 1)

Wir setzen zunächst alle Konstanten, die einen monotonen Zusammenhang nicht verändern, auf leicht zu bearbeitende Werte und erhalten eine modifizierte Statistik

h=

R21

n1

+

n(n+1)

2

− R1

n2

2

Kapitel 1 Ableitungen

37

einsetzen von W ∗ ergibt

h =

=

=

=

=

=

=

=

2

W ∗ + n1 (n+1)

2

n1

2

W ∗ + n1 (n+1)

2

n1

n21

+

+

n+1 2

n(n+1)

2

−W ∗ − n1 (n+1)

2

2

n2

n2 (n+1)

2

−W ∗

2

n2

2

n+1

∗

2

2 −W /n2

+ n2

n2

2

2

n+1

n+1

∗

+ n2

−W /n2

W ∗ /n1 + 2

n1

n1 W ∗ /n1 +

2

2

2

(n + 1)

(n + 1)2

∗

2

∗

∗

∗

2

n1 (W /n1 ) +

+ (n + 1)W /n1 + n2

− (n + 1)W /n2 + (W /n2 )

4

4

n2 (n + 1)2

n1 (n + 1)2

+ (n + 1)W ∗ +

− (n + 1)W ∗ +W ∗2 /n2

W ∗2 /n1 +

4

4

n1 (n + 1)2 n2 (n + 1)2

W ∗2 /n1 +

+

+W ∗2 /n2

4

4

1

1

n(n + 1)2

∗2

W

+

+

n1 n2

4

Da h und W ∗2 positiv linear miteinander verknüpft sind, sind H und W (im zweiseitigen Testfall) äquivalente Statistiken.

1.36 Schätzer der mehrfaktoriellen Varianzanalyse bei gleichen

Zellenbesetzungen (7 / S. 259)

Da bei gleicher Zellenbesetzung n = I × J × K gilt (Kutner, Nachtsheim, Neter & Li,

2005, S. 830), ergibt sich

Y ••• =

=

=

1 I J K

∑ ∑ ∑ Yi jk

n i=1

j=1 k=1

I J K

1

∑ ∑ ∑ Yi jk

I × J × K i=1

j=1 k=1

1

J ×K

∑Ii=1 Yi jk

I

j=1 k=1

J

K

∑∑

38

Kapitel 1

=

=

J

1

J ×K

1

J ×K

K

∑ ∑ Y • jk

j=1 k=1

J

K

∑ ∑ µ̂ jk = µ̂

j=1 k=1

Entsprechend ergeben sich

Y • j• =

=

1 K ∑Ii=1 Yi jk

∑ I

K k=1

=

=

1 I K

∑ ∑ Yi jk

I × K i=1

k=1

1 K

∑ Y • jk

K k=1

1 K

∑ µ̂ jk = µ̂ j•

K k=1

und

Y ••k =

=

=

1 I J

∑ ∑ Yi jk

I × J i=1

j=1

1

J

∑Ii=1 Yi jk

I

j=1

=

1

J

1

J

J

∑

J

∑ Y • jk

j=1

J

∑ µ̂ jk = µ̂•k

j=1

1.37 Mehrfaktorielle Varianzanalyse bei ungleichen Zellenbesetzungen

im allgemeinen linearen Modell (7 / S. 260)

Wir verweisen hier auf Kutner, Nachtsheim, Neter und Li (2005, S. 953 – 964).

Kapitel 1 Ableitungen

39

1.38 Verteilung der Quadratsummen in der zweifaktoriellen

Varianzanalyse (7 / S. 263)

SST /σ 2 folgt einer χ 2 -Verteilung mit IJK − 1 Freiheitsgraden, da gilt:

2

2

2

∑Ii=1 ∑Jj=1 ∑Kk=1 (Y i jk −Y ••• )

∑Ii=1 ∑Jj=1 ∑Kk=1 (Y i jk − µ)

(Y ••• − µ)

=

+

σ2

σ2

σ 2 /IJK

SSA /σ 2 folgt einer χ 2 -Verteilung mit J − 1 Freiheitsgraden, da gilt:

J

IK ∑ Y • j• − µ

2

j=1

J

= IK ∑ Y • j• −Y •••

j=1

2

J

= IK ∑ Y • j• −Y ••• +Y ••• − µ

2

j=1

J

+ IK ∑ Y ••• − µ

2

j=1

J

= IK ∑ Y • j• −Y •••

2

J

+ 2IK ∑ (Y • j• −Y ••• ) Y ••• − µ

j=1

+ IJK Y ••• − µ

2

j=1

Der Kreuzterm fällt weg, weil die Summe der Abweichungen der Gruppenmittelwerte vom Gesamtmittelwert 0 ist. Nun wird der erste Term auf der rechten Seite der

Gleichung durch SSA ersetzt.

J

IK ∑ Y • j• −Y •••

2

+ IJK Y ••• − µ

2

= SSA + IJK Y ••• − µ

2

j=1

Anschließend werden beide Seiten der Gleichung durch σ 2 geteilt.

IK ∑Jj=1 Y • j• − µ

σ2

2

SSA IJK Y ••• − µ

= 2 +

σ

σ2

2

2

Y ••• − µ

∑Jj=1 Y • j• − µ

SSA

= 2 +

σ 2 /IK

σ

σ 2 /IJK

2

√

Da alle Y • j• unter der Nullhypothese i.i.d. N(µ, σ / IK) verteilt sind, entspricht die

linke Seite der Gleichung einer χ 2 -Verteilung mit J Freiheitsgraden. Der zweite Term

auf der rechten Seite der Gleichung folgt einer χ 2 -Verteilung. Aus der Additivität der

χ 2 -Verteilung folgt, dass SSA /σ 2 χ 2 -verteilt ist mit J − 1 Freiheitsgraden.

40

Kapitel 1

Analog lässt sich zeigen, dass SSB einer χ 2 -Verteilung mit K − 1 Freiheitsgraden

folgt.

SSAB /σ 2 folgt einer χ 2 -Verteilung mit (I − 1)(J − 1) Freiheitsgraden, da gilt:

J

K

I∑

∑

Y • jk − µ

2

J

K

K

2

Y

+

â

−

â

+

β̂

−

β̂

+Y

−Y

−

µ

∑ • jk j j k k ••• •••

j=1 k=1

j=1 k=1

=I∑

J

=I ∑

2

∑ (Y • jk +2Y • jk â j −2Y • jk â j +2Y • jk β̂k −2Y • jk β̂k +2Y jkY ••• −2Y • jkY ••• −2Y • jk µ

j=1 k=1

+2â2j − 2â2j + 4â j β̂k − 4â j β̂k + 4â jY ••• − 4â jY ••• − 2â j µ

+2â j µ + 2β̂k2 + 4β̂kY ••• − 4β̂kY ••• − 2β̂k µ − 2β̂k2

2

2

+2β̂k µ + 2Y ••• − 2Y ••• − 2Y ••• µ + 2Y ••• µ + µ 2 )

J

= I∑

K

2

∑ ((Y • jk − 2Y • jk â j − 2Y • jk β̂k − 2Y • jkY ••• +â2j + β̂k2

j=1 k=1

2

2

+Y ••• ) + â2j + β̂k2 + Y ••• − 2Y ••• µ + µ 2 + (2Y • jk â j

2

−2â2j + 2Y • jk β̂k − 2β̂k2 + 2Y • jkY ••• − 2Y ••• − 2Y • jk µ + 2Y ••• µ))

Der Term in der letzten Klammer auf der rechten Seite der Gleichung ist 0, denn:

J

K

I∑

∑ (2Y • jk β̂k − 2β̂k2 ) = 0

j=1 k=1

J

I∑

K

J

2

∑ (2Y • jkY ••• − 2Y ••• ) = 2Y ••• I ∑

J

∑ (Y • jk −Y ••• ) = 2Y ••• I · 0 = 0

j=1 k=1

j=1 k=1

I∑

K

K

J

K

∑ (−2Y • jk µ + 2Y ••• µ) = − 2µI ∑ ∑

j=1 k=1

j=1 k=1

Der Rest der obigen Gleichung ergibt sich zu:

Y • jk −Y ••• = −2µI · 0 = 0

Kapitel 1 Ableitungen

J

K

41

2

∑ ((Y • jk − 2Y • jk â j − 2Y • jk β̂k − 2Y • jkY ••• +â2j + β̂k2

I∑

j=1 k=1

2

2

+Y ••• ) + â2j + β̂k2 + (Y ••• − 2Y ••• µ + µ 2 ))

J

=I∑

K

2

2

Y • jk − â j − β̂k −Y ••• + â2j + β̂k2 + Y ••• − µ )

∑(

j=1 k=1

J

=I∑

K

∑ ( Y • jk −Y • j • −Y • • k +Y •••

2

2

+ â2j + β̂k2 + Y ••• − µ )

j=1 k=1

J

=I∑

K

2

∑ (SSAB + SSA + SSB + IJK(Y ••• − µ) )

j=1 k=1

Nun werden beide Seiten der Gleichung durch σ 2 geteilt:

∑Jj=1 ∑Kk=1 Y • jk − µ

σ 2 /I

2

2

=

SSAB SSA SSB (Y ••• − µ)

+ 2 + 2 +

σ2

σ

σ

σ 2 /IJK

SSW /σ 2 folgt einer χ 2 -Verteilung mit JxKx(I − 1) Freiheitsgraden, da gilt:

Ausgehend von der Quadratsummenzerlegung (s. a. nächsten Abschnitt dieses Internetsupplements)

SST = SSA + SSB + SSAB + SSW

teilt man beide Seiten der Gleichung durch σ 2 :

SSA SSB SSAB SSW

SST

= 2 + 2 + 2 + 2

2

σ

σ

σ

σ

σ

Es wurde gezeigt, dass SSA /σ 2 , SSB /σ 2 und SSAB /σ 2 jeweils χ 2 -verteilt sind mit J −

1, K − 1 und (J − 1) × (K − 1) Freiheitsgraden. Aus der Additivität der χ 2 -Verteilung

und der Unabhängigkeit der Terme auf der rechten Seite der Gleichung folgt daher,