Eine Formel verändert die Welt - Lehrstuhl für Informationsübertragung

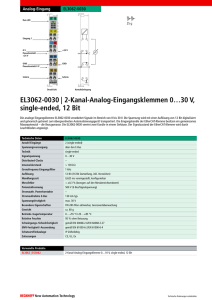

Werbung

Eine Formel verändert die Welt

gewidmet

Herrn Prof. Dr. Heinz Gerhäuser

anlässlich seiner Verabschiedung in den

Ruhestand

Johannes Huber

Lehrstuhl für Informationsübertragung

Friedrich-Alexander-Universität Erlangen-Nürnberg

26. Oktober 2011

Eine Formel verändert die Welt

gewidmet

Herrn Prof. Dr. Heinz Gerhäuser

anlässlich seiner Entpflichtung von Dienstaufgaben

Johannes Huber

Lehrstuhl für Informationsübertragung

Friedrich-Alexander-Universität Erlangen-Nürnberg

26. Oktober 2011

Eine Formel verändert die Welt

gewidmet

Herrn Prof. Dr. Heinz Gerhäuser

anlässlich der Verlagerung der Schwerpunkte seiner

Aktivitäten

Johannes Huber

Lehrstuhl für Informationsübertragung

Friedrich-Alexander-Universität Erlangen-Nürnberg

26. Oktober 2011

Eine Formel verändert die Welt

gewidmet

Herrn Prof. Dr. Heinz Gerhäuser

anlässlich dessen, dass sich wohl nichts ändert in seinem

Leben

Johannes Huber

Lehrstuhl für Informationsübertragung

Friedrich-Alexander-Universität Erlangen-Nürnberg

26. Oktober 2011

Eine Formel verändert die Welt

Inhaltsübersicht

1. Die Säulen des Informationszeitalters

2. Die Kapazitätsformel

3. Grundlagen der Informationstheorie

A.

B.

Gesetz der großen Zahlen

Kugeln im vieldimensionalen Raum

4. Information und Energie

A.

B.

Minimale Energie pro bit Information bei thermischem Rauschen

Information und der 2. Hauptsatz der Thermodynamik (Maxwellscher Dämon)

5

Eine Formel verändert die Welt

5.

Folgerungen aus der Shannonschen Kapazitätsformel

A.

B.

C.

6.

Leistungs- und Bandbreiteneffizienz bei der digitalen Übertragung

Digitalisierung analoger Werte

Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung

analoger Signale

Nicht-transparente Informationsübertragung: Quellencodierung

A.

B.

C.

Redundanzreduktion

Irrelevanzreduktion

Vergleich analoger und digitaler Übertragung beim Audio-Rundfunk

7.

Formeln verändern die Welt

8.

Persönliche Anmerkungen

6

Eine Formel verändert die Welt

Äquivalenz von Masse und Energie: E = m · c2

7

1. Die Säulen des Informationszeitalters

Radio des Jahres 1960

Quelle: http://www.flickr.com/photos/31146530@N06/5001551130/ Author: stevepamer

8

1. Die Säulen des Informationszeitalters

Inneres des I-Phones 2010

Wodurch wurde diese Entwicklung innerhalb von 50 Jahren ermöglicht?

9

1. Die Säulen des Informationszeitalters

Inneres des I-Phones 2010

Erlaubnis muss noch erfragt werden.

Quelle:

Wodurch wurde diese Entwicklung innerhalb von 50 Jahren ermöglicht?

10

1. Die Säulen des Informationszeitalters

•

•

Erfindung des Transistors

Bardeen, Brattain, Shockley, AT & T Bell Labs, Murray Hill, New Jersey,

1947/48

⇒ Entwicklung der Mikroelektronik

Lösung des Problems: Wie können informationstechnische Systeme

effizient implementiert werden?

Entwicklung der Informationstheorie durch

Claude E. Shannon (1916 – 2001)

AT & T Bell Labs, Murray Hill, New Jersey, 1948 (publiziert)

Antwort auf die Frage: Was ist ein effizientes informationstechnisches

System, aus welchen Komponenten soll es bestehen, welche Methoden

sind anzuwenden?

⇒ Einleitung des Wandels von der analogen zur digitalen

Informationstechnik durch eine

Mathematische Theorie

11

1. Die Säulen des Informationszeitalters

Claude Elwood Shannon

1916 - 2001

Quelle:

12

1. Die Säulen des Informationszeitalters

The Father of

Information Age

Quelle:

13

1. Die Säulen des Informationszeitalters

14

1. Die Säulen des Informationszeitalters

15

Eine Formel verändert die Welt

Inhaltsübersicht

1. Die Säulen des Informationszeitalters

2. Die Kapazitätsformel

3. Grundlagen der Informationstheorie

A.

B.

Gesetz der großen Zahlen

Kugeln im vieldimensionalen Raum

4. Information und Energie

A.

B.

Minimale Energie pro bit Information bei thermischem Rauschen

Information und der 2. Hauptsatz der Thermodynamik (Maxwellscher Dämon)

16

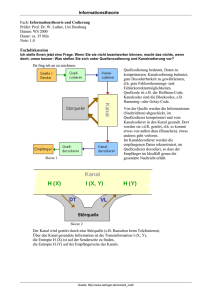

2. Die Kapazitätsformel

Eine Formel hat die Welt grundlegend verändert:

unabhängige Gauß sche

Störvariable

gestörte

Nachrichtenübertragung

X

W σ W2 = N

σ X2 = S

Y

σ Y2 = S + N

bit

1

S

C = log 2 1 +

2

N Wert

C: Informationsübertragungskapazität des zeitdiskreten Kanals

bei additiver Gauß scher Störung

S: Varianz des Nutzsignals (Nutzsignalleistung: Signal Power)

N: Varianz der Störung (Störsignalleistung: Noise Power)

17

2. Die Kapazitätsformel

Durch Anwendung des Abtasttheorems:

Bei einem auf die Spektralbandbreite B bandbegrenztem Signal sind

maximal 2 · B Werte je Sekunde frei wählbar.

folgt

S

bit

S

CT = B log 2 1 + = B log 2 1 +

N

BN 0 Sekunde

CT: Informationsübertragungskapazität des zeitkontinuierlichen,

bandbegrenzten Übertragungskanals mit Störung durch weißes,

Gauß´sches Rauschen

B: (einseitige) spektrale Signalbandbreite

N0: (einseitige) spektrale Rauschleistungsdichte

18

2. Die Kapazitätsformel

Fundamentale Einsichten:

Beim Vorhandensein von Störungen kann auch durch analoge, d.h.

wertkontinuierliche Signalwerte nur eine begrenzte Anzahl unterschiedlicher

Informationen repräsentiert und übertragen werden:

⇒ Information ist in digitaler Form zu repräsentieren

und zu übertragen

Trotz Störungen kann aber Information zuverlässig, absolut fehlerfrei

übertragen werden:

⇒ eine effiziente Informationstechnik ist eine digitale

Informationstechnik

19

2. Die Kapazitätsformel

Fundamentaler Unterschied zwischen analoger und digitaler

Informationstechnik:

analog: Nutzsignal und Störung sind empfangsseitig nicht

mehr trennbar

digital: Nutzsignal und Störung sind prinzipiell

wieder trennbar.

Digitale Informationstechnik erlaubt Signalregeneration: Fehlerfreie Detektion

der digitalen Symbolsequenzen und erneutes Senden des störungsfreien

Sendesignals.

Beispiele: Kopieren von CDs (im Vergleich zu analogen Audiokassetten)

Telefonieren nach Australien

20

Eine Formel verändert die Welt

Inhaltsübersicht

1. Die Säulen des Informationszeitalters

2. Die Kapazitätsformel

3. Grundlagen der Informationstheorie

A.

B.

Gesetz der großen Zahlen

Kugeln im vieldimensionalen Raum

4. Information und Energie

A.

B.

Minimale Energie pro bit Information bei thermischem Rauschen

Information und der 2. Hauptsatz der Thermodynamik (Maxwellscher Dämon)

21

3. Grundlagen der Informationstheorie

A. Gesetz der großen Zahlen

Wird ein Zufallsexperiment (statistisch unabhängig) sehr oft wiederholt,

dann nähern sich relative Häufigkeiten Wahrscheinlichkeiten an,

Mittelwerte streben gegen Erwartungswerte usw.

Wiederholung reduziert die Zufälligkeit

(vgl. Versicherungen)

22

3. Grundlagen der Informationstheorie

Beispiel: Fairer Münzwurf, Zufallsereignis: Wappen (Kopf) oder Zahl

Wahrscheinlichkeit für W Wappen bei n Würfen Pr (W) = ( W ) 2-n

n

n = 1000

100000

10000

100

10

nn==100

10

0

0

10

1

20 2

30 3

404

50

5

660

7 70

8 80

9 90

10

100

23

3. Grundlagen der Informationstheorie

Beispiel: Fairer Münzwurf, Zufallsereignis: Wappen (Kopf) oder Zahl

Wahrscheinlichkeit für W Wappen bei n Würfen Pr (W) = ( W ) 2-n

n

n = 100

n = 100

0

10

20

30

40

50

60

70

80

90

100

24

3. Grundlagen der Informationstheorie

Beispiel: Fairer Münzwurf, Zufallsereignis: Wappen (Kopf) oder Zahl

Wahrscheinlichkeit für W Wappen bei n Würfen Pr (W) = ( W ) 2-n

n

n = 1000

100000

25

3. Grundlagen der Informationstheorie

Beispiel: Fairer Münzwurf, Zufallsereignis: Wappen (Kopf) oder Zahl

Wahrscheinlichkeit für W Wappen bei n Würfen Pr (W) = ( W ) 2-n

n

n = 10000

26

3. Grundlagen der Informationstheorie

Beispiel: Fairer Münzwurf, Zufallsereignis: Wappen (Kopf) oder Zahl

Wahrscheinlichkeit für W Wappen bei n Würfen Pr (W) = ( W ) 2-n

n

n = 100000

10000

·105

27

3. Grundlagen der Informationstheorie

B.

Kugeln in vieldimensionalen Euklidischen Räumen ℝn

Ein Punkt x = ( x1 , x2 , x3 ,, xn ) im ℝn wird durch n Koordinaten spezifiziert.

n

Def.: Kugel mit Radius R: Menge aller Punkte x mit ∑ xi2 = R 2

i =1

x2 R

.

Beispiel n = 2

x1

x12

Volumen V einer Kugel mit Radius R im ℝn

V=

π n/2

(n / 2 ) !

n=2

⋅ Rn

n=3

+

x22

=R

2

Satz von

Pythagoras!

V = π R2

V=

π 3/ 2

(3 / 2)!

R3 =

4

π R3

3

Für eine sehr große Zahl n von Dimension (n >> 1) gilt:

Das Kugelvolumen wird im Wesentlichen durch oberflächennahe Punkte

dominiert.

28

3. Grundlagen der Informationstheorie

(Mittelwertfreie) informationstragende Signalwerte xi: Zufallswerte mit

Varianz σ x2 = E{x 2 } = S (mittlere Signalleistung)

xi

2

1

3

4

5

i

1 n 2

1

x

⋅ nσ x2 = σ x2 = S

Gesetz der großen Zahlen: ∑ i strebt für n → ∞ nach

n i =1

n

Für jede lange Folge von Signalwerten xi besitzt der zugehörige Vektor x

den Betrag

x ≅ n ⋅ σ x2

⇒ Alle informationstragenden langen Folgen liegen im ℝn auf der

Oberfläche bzw. in einer Kugel mit dem Radius

R=

n⋅S

29

3. Grundlagen der Informationstheorie

x2

x1

x3

30

3. Grundlagen der Informationstheorie

Einfaches Übertragungsmodell

Addition statistisch unabhängiger Störwerte

X

Y

gesendeter Wert

mit Varianz σ x2 = S

Wi

empfangener Wert

mit Varianz σ 2y = S + N

Störung mit

Varianz σ w2 = N

Übertragung langer Folgen von Werten (n >> 1) :

Alle empfangenen Folgen y = ( y1 , y 2 , y3 , , y n ) bilden im ℝn Punkte auf, bzw.

in einer Kugel mit dem Radius n ⋅ ( S + N ) und dem Volumen Vy .

Alle Störungen w = ( w1 , w2 , , wn ) bilden im ℝn Punkte auf bzw. in einer Kugel

mit dem Radius nN und dem Volumen Vw .

Um jeden gesendeten Punkt x bildet die Störung eine Rauschkugel,

innerhalb derer der empfangene Punkt y für n → ∞ zu finden ist.

31

3. Grundlagen der Informationstheorie

Illustration n = 2

w

x2

x2

x1

In einer großen Kugel mit dem Volumen Vy

haben maximal L = Vy /Vw kleine Kugeln

mit dem Volumen Vw Platz

w

x1

Damit können höchstens

π n/2

L=

Vy

Vw

=

(n / 2)!

(n ⋅ ( S + N ) )n / 2

π n/2

(n / 2)!

(n ⋅ N )n / 2

S

= 1 +

N

n/2

unterschiedliche Nachrichten trotz des Vorhandenseins von Störungen

fehlerfrei unterscheidbar übertragen werden, wenn sich die zugehörigen

Rauschkugeln für n → ∞ nicht wechselseitig durchdringen.

(„Sphere Hardening“) .

32

3. Grundlagen der Informationstheorie

NB: Für die Bezeichnung (Adressierung) von L Elementen einer Menge benötigt

man log2 (L) Binärsymbole (Bits: High/Low oder 0/1 oder schwarz/weiß)

Zahl der durch ein Wort der Länge n übertragbaren Bits

Z ≤ log 2 (L )

Zahl der je einzelnem Wert übertragbaren Bits

1

Z n ≤ log 2 (L ) = log 2 L1/ n

n

( )

1/ n

n

S

Z ≤ log 2 1 +

N

S

1

Z ≤ log 2 1 +

2

N

S

= log 2 1 +

N

bit

Kanalbenutzung

(Umkehrung des Kanalcodierungstheorems)

33

3. Grundlagen der Informationstheorie

Methode zum Beweis des Kanalcodierungstheorems:

Für Gauß-verteilte Zufallsvariablen xi erhält man im ℝn, n → ∞, auf der

Oberfläche einer Kugel mit dem Radius n ⋅ σ x2

gleichmäßig verteilte Signalpunkte

Eine Auswahl von L = (1 + S/N)n/2 Punkten x ist damit so möglich, dass sich

die zugehörigen „Rauschkugeln“ nicht durchdringen und eine fehlerfreie

Unterscheidung der L Nachrichten möglich wird.

1

S

C = log 2 1 +

2

N

bit

Kanalbenutzung

34

Eine Formel verändert die Welt

Inhaltsübersicht

1. Die Säulen des Informationszeitalters

2. Die Kapazitätsformel

3. Grundlagen der Informationstheorie

A.

B.

Gesetz der großen Zahlen

Kugeln im vieldimensionalen Raum

4. Information und Energie

A.

B.

Minimale Energie pro bit Information bei thermischem Rauschen

Information und der 2. Hauptsatz der Thermodynamik (Maxwellscher Dämon)

35

4. Information und Energie

A. Minimale Energie pro bit bei thermischem Rauschen

Störung:

Störleistung N = N0 · B mit N0: (einseitige) Rauschleistungsdichte von

thermischen Rauschen, B: Signalbandbreite

W

Boltzmannklassische Physik: N0 = kB Tabs mit kB = 1,38 10−23

Hz K

Konstante

Tabs = 292 K : N0 = 4 · 10

−21

W

Hz

Nutzsignal: Eb: Energie pro bit Information; Tb: Zeit pro bit: Eb = S · Tb

Datengeschwindigkeit (Datenrate) RT = 1 / Tb

RT

Spektrale Effizienz

Γd =ˆ

B

E

⇒ CT = B log 2 1 + Γd b

N0

bit

s

[bit/s

]

Hz

36

4. Information und Energie

!

Ideales digitales Übertragungssystem RT = CT

⇒ Eb =

(

)

1 Γd

2 − 1 ⋅ N0

Γd

Shannon-Grenze der digitalen Übertragung

Minimum für Γd → 0 bzw. B → ∞

(

)

e x ln 2 − 1

e x ln 2

1 x

NR: lim

2 − 1 = lim

= ln (2 ) lim

= ln (2 ) = 0,69315...

1

x

x

x →0

x →0

x →0

Eb, min = ln(2) N0 = ln(2) kB · Tabs

Minimale Energie zur Repräsentation bzw. Übertragung

von einem bit Information im Umfeld thermischen Rauschens

37

4. Information und Energie

Materie

Masse m

Energie

E = mc2

Energie E

Information

Tabs = 293 K:

Eb,min = 2,793 · 10−21 J

mb,min = 3,10 · 10−38 kg

aber:

Quantenphysikalische Effekte berücksichtigen!

38

4. Information und Energie

B. Information und der 2. Hauptsatz der Thermodynamik

2. Hauptsatz der Thermodynamik:

In einem abgeschlossenen System kann die Entropie nur

zunehmen, allenfalls gleichbleiben, nie abnehmen.

Entropie: Maß für die Unordnung im System und somit Maß für den

Aufwand zur Beschreibung des Systemzustandes

Wärmeenergie ist weniger „edel“ als Bewegungsenergie

Gegenthese zum 2. Hauptsatz: Maxwellscher Dämon

Glaszylinder

reibungsfrei

Gasmolekül in

thermischer Bewegung

beweglicher, aber

dichter Kolben

Beobachter

(Maxwellscher Dämon)

39

4. Information und Energie

1 bit Information: Molekül momentan in

linker Hälfte des Gefäßes

rechter

Falls links: Energieverlustfreies Einschieben des Kolbens bis zur Mitte

möglich, da kein Gasgegendruck vorhanden ist

Ladephase:

0

l/2

l

s

l/2

Arbeitsphase: Austreibung des Kolbens nach rechts durch Stöße des

thermisch bewegten Moleküls gegen den Kolben

⇒ Vollständige Umsetzung von thermischer Energie

in Bewegungsenergie mit Hilfe von Information!

Widerlegung des 2. Hauptsatzes der Thermodynamik?

40

4. Information und Energie

Gegen den 2. Hauptsatz gewonnene Bewegungsenergie EMD

l

E MD = ∫

F ( s ) ⋅ ds

l /2

Kraft mal Weg

41

4. Information und Energie

Isotherme Expansion: Boyle-Mariottsches Gesetz (1662, 1676) für das ideale

Gas und Maxwell-Boltzmann-Verteilung (1860)

p · V = z · kB Tabs hier z = 1 (Energie je Molekül)

Druck p = F(s)/A mit A: Querschnittsfläche des Zylinders

Volumen V(s) = A · s ⇒ F(s) · s = kB · Tabs ⇒ F ( s ) =

l

E MD = ∫

l /2

k B Tabs

ds = k B Tabs ln( s )

s

l

l /2

k B ⋅ Tabs

s

l

= k B Tabs ln

= k B Tabs ln (2 )

l /2

EMD = ln(2) kB · Tabs = ln(2) N0 = Eb,min

42

4. Information und Energie

Es wird durch 1 bit Information genau die Energie im Widerspruch zum

2. Hauptsatz der Thermodynamik gewonnen, die zur Repräsentation, bzw.

Übertragung von 1 bit Information minimal notwendig ist.

⇒ Maxwellscher Dämon ist widerlegt.

Fundamentaler Zusammenhang zwischen Energie und Information bestätigt!

Beispiel zur Ästhetik der Wissenschaften

43

Eine Formel verändert die Welt

5.

Folgerungen aus der Shannonschen Kapazitätsformel

A.

B.

C.

6.

Leistungs- und Bandbreiteneffizienz bei der digitalen Übertragung

Digitalisierung analoger Werte

Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung

analoger Signale

Nicht-transparente Informationsübertragung: Quellencodierung

A.

B.

C.

Redundanzreduktion

Irrelevanzreduktion

Vergleich analoger und digitaler Übertragung beim Audio-Rundfunk

7.

Formeln verändern die Welt

8.

Persönliche Anmerkungen

44

5. Folgerungen aus der Shannonschen Kapazitätsformel

A. Zusammenhang zwischen Leistungs- und

Bandbreiteneffizienz bei der digitalen Übertragung

Shannon-Grenze:

(

)

Eb

1

2 Γd − 1

≥

Γd

N0

10log10(Eb/N0) [dB] →

← power efficiency

45

5. Folgerungen aus der Shannonschen Kapazitätsformel

A. Zusammenhang zwischen Leistungs- und

Bandbreiteneffizienz bei der digitalen Übertragung

Shannon-Grenze:

(

)

Eb

1

2 Γd − 1

≥

Γd

N0

10log10(Eb/N0) [dB] →

← power efficiency

46

5. Folgerungen aus der Shannonschen Kapazitätsformel

A. Zusammenhang zwischen Leistungs- und

Bandbreiteneffizienz bei der digitalen Übertragung

Shannon-Grenze:

(

)

Eb

1

2 Γd − 1

≥

Γd

N0

10log10(Eb/N0) [dB] →

← power efficiency

47

5. Folgerungen aus der Shannonschen Kapazitätsformel

B. Optimale Digitalisierung

Analogwerte

X

X∈ ℝ

Digitalisierung

Daten

Diskrete Werte

Y

Y∈{y1, y2, ..., yM}

Rekonstruktion

R bit/Wert

Kapazität für eine digitale Übertragung

C = 1/2 log2 (1 + S/N)

{ }

Signalleistung S = E X 2 = σ x2

Störung

Störleistung N = E{(Y – X)2}

W =Y − X

S

Signal-Stör-Leistungsverhältnis (Signal to Noise Ratio): SNR =

N

•

Offensichtlich gilt: Je Wert X kann (im Mittel) nicht mehr Information

von Ende zu Ende (X → Y) übertragen werden, als Information in

Form von Daten transportiert wird (Data Processing Theorem).

R ≥ C = R ≥ 1/2 log2 (1 + SNR)

48

5. Folgerungen aus der Shannonschen Kapazitätsformel

B.

Optimale Digitalisierung

SNR ≤ 22R − 1

Rate-Distortion Grenze für die

Digitalisierung unabhängiger Zufallswerte!

Weg zur optimalen Digitalisierung: Vektorquantisierung im ℝn mit n → ∞

49

5. Folgerungen aus der Shannonschen Kapazitätsformel

C. Optimaler Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung analoger Signale

analoges

Quellensignal

x(t)

Bandbreite BNF

Sendesignal

Sender

AWGN-Kanal

e(t)

s(t)

Bandbreite BHF

Rekonstruiertes

Quellensignal

Empfangssignal

Empfänger

y(t)

Störung

CHF = BHF log2 (1 + SNRHF)

CNF = BNF log2 (1 + SNRNF)

SNRNF: Signal-Stör-Leistungsverhältnis für das niederfrequente Quellensignal

SNRHF: Signal-Stör-Leistungsverhältnis für das hochfrequente Quellensignal

Offensichtlich gilt: CNF ≤ CHF mit „=“ für optimales Sender-Empfängerpaar

Def.: Bandbreiteneffizienz der analogen Übertragung: Γa =

BNF

BHF

50

5. Folgerungen aus der Shannonschen Kapazitätsformel

C.

Optimaler Austausch von Leistungs- und Bandbreiteneffizienz bei

der Übertragung analoger Signale

Shannon-Grenze der analogen Übertragung CNF = CHF

SNRNF = (1 + SNRHF)1/Γa − 1

Das gleiche Resultat gilt für die Kombination „Optimale Digitalisierung“ mit

„optimaler digitaler Übertragung“:

⇒ Theorem der Trennbarkeit von Quellencodierung

und digitaler Übertragung

51

5. Folgerungen aus der Shannonschen Kapazitätsformel

Leistungs-Bandbreiten-Diagramm für die Übertragung analoger Signale

52

5. Folgerungen aus der Shannonschen Kapazitätsformel

Leistungs-Bandbreiten-Diagramm für die Übertragung analoger Signale

53

Eine Formel verändert die Welt

5.

Folgerungen aus der Shannonschen Kapazitätsformel

A.

B.

C.

6.

Leistungs- und Bandbreiteneffizienz bei der digitalen Übertragung

Digitalisierung analoger Werte

Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung

analoger Signale

Nicht-transparente Informationsübertragung: Quellencodierung

A.

B.

C.

Redundanzreduktion

Irrelevanzreduktion

Vergleich analoger und digitaler Übertragung beim Audio-Rundfunk

7.

Formeln verändern die Welt

8.

Persönliche Anmerkungen

54

6. Nicht-Transparente Übertragung

Die Shannon-Grenze gilt für die transparente Übertragung analoger Signale,

also für jedes Quellensignal mit einer Bandbreite ≤ BNF

⇒ Einschränkung auf typische Signale, z.B. Audiosignale

⇒ Nicht-transparente Verfahren

55

6. Nicht-Transparente Übertragung

A.

Quellencodierung zur Redundanz-Reduktion:

Übertragung von typischen Symbolfolgen oder Signalen

Repräsentation langer Folgen durch nH anstelle n log2(M) Binärsymbole

Menge aller Mn Folgen

56

6. Nicht-Transparente Übertragung

A.

Quellencodierung zur Redundanz-Reduktion:

Übertragung von typischen Symbolfolgen oder Signalen

Repräsentation langer Folgen durch nH anstelle n log2(M) Binärsymbole

Menge aller Mn Folgen

Teilmenge der von

der Quelle typischen

2nH Folgen

57

6. Nicht-Transparente Übertragung

B.

Quellencodierung zur Irrelevanz-Reduktion:

Der Empfänger ist nicht in der Lage, alle möglichen Mn unterschiedlicher

Folgen zu unterscheiden, sondern nur 2 nH irr

Menge aller Mn Folgen

Redundanz + Irrelevanz-Reduktion: Es reichen im Mittel H – (log2(M) – Hirr)

Binärsymbole je Quellensymbol

58

6. Nicht-Transparente Übertragung

B.

Quellencodierung zur Irrelevanz-Reduktion:

Der Empfänger ist nicht in der Lage, alle möglichen Mn unterschiedlicher

Folgen zu unterscheiden, sondern nur 2 nH irr

Menge aller Mn Folgen

Teilmenge der vom

Empfänger

unterscheidbaren

2nH irr Folgen

Redundanz + Irrelevanz-Reduktion: Es reichen im Mittel H – (log2(M) – Hirr)

Binärsymbole je Quellensymbol

59

6. Nicht-Transparente Übertragung

B.

Quellencodierung zur Irrelevanz-Reduktion:

Der Empfänger ist nicht in der Lage, alle möglichen Mn unterschiedlicher

Folgen zu unterscheiden, sondern nur 2 nH irr

Menge aller Mn Folgen

Teilmenge der vom

Empfänger

unterscheidbaren

2nH irr Folgen

Teilmenge für die

typischen vom

Empfänger

unterscheidbaren

Folgen

Redundanz + Irrelevanz-Reduktion: Es reichen im Mittel H – (log2(M) – Hirr)

Binärsymbole je Quellensymbol

60

6. Nicht-Transparente Übertragung

61

6. Nicht-Transparente Übertragung

62

6. Nicht-Transparente Übertragung

63

6. Nicht-Transparente Übertragung

64

6. Nicht-Transparente Übertragung

C. Vergleich: Für Rundfunk (Audio/Mono) Reduktion des erforderlichen

HF-Störabstandes bei gleichem Versorgungsgebiet und

gleicher Qualität 10log10(SNRNF) = 60 dB

a.

Vom AM-Radio zum Digitalradio (DRM), Γa = 0,5,

AM DSB

transparent digital

nicht-transparent

75 dB

33 dB

7,8 dB

42 dB

Digitale Übertragung

500 kW

25 dB

Quellencodierung

Sendeleistung

32 W

0,1 W

65

6. Nicht-Transparente Übertragung

Vergleich: Für Rundfunk (Audio/Mono) Reduktion des erforderlichen

HF-Störabstandes bei gleichem Versorgungsgebiet und

gleicher Qualität 10log10(SNRNF) = 60 dB

b.

Vom FM-Radio zum Digitalradio (DAB), Γa = 0,07,

FM

transparent digital

nicht-transparent

54,3 dB

13,7 dB

4,9 dB

40,6 dB

Digitale Übertragung

100 kW

8,8 dB

Quellencodierung

Sendeleistung

8,7W

1,15 W

Sender Dillberg Quelle:

66

Eine Formel verändert die Welt

5.

Folgerungen aus der Shannonschen Kapazitätsformel

A.

B.

C.

6.

Leistungs- und Bandbreiteneffizienz bei der digitalen Übertragung

Digitalisierung analoger Werte

Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung

analoger Signale

Nicht-transparente Informationsübertragung: Quellencodierung

A.

B.

C.

Redundanzreduktion

Irrelevanzreduktion

Vergleich analoger und digitaler Übertragung beim Audio-Rundfunk

7.

Formeln verändern die Welt

8.

Persönliche Anmerkungen

67

7. Formeln verändern die Welt

Technische Revolutionen wurden und werden immer durch

fundamentale theoretische Leistung

erreicht, nicht durch Tüftler und Bastler etc.

Thermodynamik (Carnotscher Kreisprozess):

Elektrodynamik (Maxwellsche Gleichungen):

Quantenmechanik (Festkörperphysik):

Informationstheorie:

effiziente Wärmekraftmaschinen

Elektrotechnik

Mikro-/Nano-Elektronik

Digitale Informationstechnik

„Eine gute Theorie ist das praktischste, was es gibt“

(G. R. Kirchhoff, 1824 – 1887)

Shannon: „I never in my life tried to do anything useful.“ ...

68

7. Formeln verändern die Welt

Nicht „Produkte“ der Finanzwelt,

nicht Ideologien,

nicht Fußballstars und auch nicht andere Stars,……

verändern die Welt so sehr wie

Formeln und die hieraus folgende Technik

aber:

Technik ist grundsätzlich ambivalent

Naturwissenschaftler und Techniker haben keine Macht darüber, wozu

Formeln und die hieraus entstehende Technik benutzt werden.

⇒ Komplexere Technik erfordert zugleich eine

höhere kulturelle Entwicklung der Gesellschaft.

Die zentralen Aufgaben der Geisteswissenschaften:

Wertedefinitionen, Wertevermittlung statt Werteverlust!

69

Eine Formel verändert die Welt

5.

Folgerungen aus der Shannonschen Kapazitätsformel

A.

B.

C.

6.

Leistungs- und Bandbreiteneffizienz bei der digitalen Übertragung

Digitalisierung analoger Werte

Austausch von Leistungs- und Bandbreiteneffizienz bei der Übertragung

analoger Signale

Nicht-transparente Informationsübertragung: Quellencodierung

A.

B.

C.

Redundanzreduktion

Irrelevanzreduktion

Vergleich analoger und digitaler Übertragung beim Audio-Rundfunk

7.

Formeln verändern die Welt

8.

Persönliche Anmerkungen

70

8. Persönliche Anmerkungen

Der wissenschaftliche Weg von

Prof. Dr. Heinz Gerhäuser

ist geprägt vom Übergang vom Industrie- zum Informationszeitalter,

vom Basteln analoger AM- und FM-Radios zum digitalen Rundfunk

DAB, World-Space, XM-Radio, Sirius, DRM und vieles andere mehr…

via

MP3

auf den Säulen

Mikroelektronik und digitale Informationstechnik

71

8. Persönliche Anmerkungen

Heinz Gerhäuser

−

−

−

Wissenschaftlicher Weg über Lehre, Polytechnikum zur Universität,

Industrie: Verbindung zwischen Theorie und Praxis

Wissenschaftsmanager und erfolgreicher Unternehmer

offen, ehrlich, vermittelnd zwischen verschiedenen Interessen,

stets dem Wohl von Institut, Lehrstuhl und deren Mitarbeitern

verpflichtet handelnd

Förderer seiner Mitarbeiter auf allen Ebenen

Verbindungen zwischen Technik- und Geisteswissenschaften

niemals vom Eigeninteresse geleitet

Gesellschaftliches und soziales Engagement

Förderung des ländlichen Raumes (z.B. Forschungscampus und

Kolpinghaus in Waischenfeld)

Engagement für Kunst und Kultur,

Einsatz bei sozialen Notfällen

72

8. Persönliche Anmerkungen

Heinz Gerhäuser

−

bewundernswerte menschliche Qualitäten

trotz vollem Terminplan immer für seine Mitmenschen da

klar zielorientiert, aber dabei geduldig und ausgleichend

sicher und kontrolliert

Handeln auf der Basis klarer ethischer Grundsätze in

allen Situationen ist das (offene) Geheimnis seines

großen Erfolges

Deshalb ein Vorbild für mich und viele andere.

Herzlichen Dank!

73