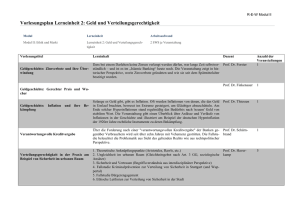

Übersicht Blockvorlesung: Machinelles Lernen

Werbung

Übersicht Blockvorlesung: Machinelles Lernen Inhaltsverzeichnis Montag: 1.+2. Lerneinheit 1. Übersicht und Entscheidungsbäume 1.1 Organisatorisches 1.2 Definition Machine Learning 1.3 Klassen von maschinellen Lernverfahren a) Supervised Learning / Überwachtes Lernen b) Unsupervised Learning / Unüberwachtes Lernen c) Reinforcement Learning / Verstärkendes Lernen 1.4. Nomenklatur a) Das Modell: Was wird gelernt? c) Features, Attribute, Deskriptoren? d) Abstraktion und Generalisierung e) Abstandsmaße: Metrische und normierte Rüume 1.5 Entscheidungsbäume (ID3) 1.6 Entropie einer Zufallsquelle 1.7 Information Gain zur Auswahl von Attributen 1.8 Overfitting 1.9 Erweiterungen in C4.5. 2. Partitionierendes Clustering 2.1 Beispiele partitionierendes Clustering 2.2 Clustering durch Varianzminimierung 2.3 Clustering durch k-means (Mediode, Centroide) 2.4 Inter- und Intraclusterabstände: TD²-Wert 2.5 k-fache Kreuzvalidierung 2.6 Bewertung Lernverfahren: Konfluenzmatrix 2.7 True/False Positives, True/False Negatives 2.8 Präzision (Accuracy), F1-Measure Dienstag: 3.+4. Lerneinheit 3. Hierarchisches Clustering 3.1 Hierarchisches Clustering mit Dentogramm 3.2 Verbindung Hierarchisches / Partitionierendes Clustern 3.3 Kernobjekte und Dichte-Verbundenheit, 3.4 Algorithmen: CLEARNS und DBSCAN 3.5 Silhouetten-Koeffizient und Erreichbarkeitsdiagramme 4. Markov Ketten und HMMs 4.1 Einführung Wahrscheinilichkeitstheorie 4.2 Ereignisse und Zufallsvariablen 4.3 Kolmogorov Axiome 4.3 Bedingte Wahrscheinlichkeit und Venn-Diagramme 4.4 Markov-Annahme k-ter Stufe 4.5 Umdrehen der Bedingung: Bayes Theorem 4.6 Markov Ketten: Probabilistische Modellierung von Zustandsübergängen 4.7 Initiale Wahrscheinlichkeitsverteilung 4.6 Hidden Markov Modelle: Beobachtungen 4.7 Transitionsmatrix, Beobachtungsmatrix Mittwoch: 5.+6. Lerneinheit 5. Lineare Regression und Klassifikation 5.1 Lineare Regressionsgleichung 5.2 Regularisierung zur Vermeidung von Overfitting 5.3 Analytische Lösung des Regressionsproblem 5.4 Lineare Klassifikation 5.5 Perceptron Algorithmus und Dualität 5.6 Der Kern-Trick 5.7 Linearer, Quadratischer bzw. RBF-Kern 6. Naive Bayes 6.1 Graphische Systeme 6.2.Bedingte Wahrscheinlichkeit und Kausalität 6.2 Formel Naive Bayes 6.3 Bedingte Unabhängigkeit Donnerstag: 7.+8. Lerneinheit 7. Bayes’sche Netze 7.1 Probabilistische Inferenz (PI) in Belief-Netzen 7.2 NP-Vollständigkeitsbeweis PI durch Reduktion auf 3-SAT 7.3 Bucket-Elimination Algorithmus für Belief-Netze 8. SVMs 7.1 Support Vector Maschine und Bit Vector Maschine, 7.2 Parameter-Tuning mit Grid-Suche 7.3 Primal/Dual Definition SVM 7.4 Herleitung aus Hinge Loss 7.5 Kernelintegration 7.6 Soft Margin SVM (Rauschen) Freitag: 9.+10. Lerneinheit 9. MDPs 9.1 Definition Markov Decision Process (MDPs) 9.2 Horizoneffekte und Discount 9.3 Bellmann-Gleichung und -Optimalitätsprinzip 9.4 Reinforement Learning Algorithmen 9.5 Value Iteration Algorithmus 9.6 Speicherplatzreduktion und externe Berechnung 9.7 Vom MDP zum POMDP 10. Randomisierte Suche mit MCTS 10.1 Exploitation vs. Exploration 10.2 k-armige Banditen 10.3.Upper Confidence Bound (UCB) 10.4 UCB applied to Trees (UCT) 10.5 Monte-Carlo Baumsuche in Optimierungsproblemen 10.6 Schachtelung der Suche 10.7 Nested Monte-Carlo Suche 10.8 Nested Rollout Policy Adaptation 10.9 Erhöhung der Diversität 10.10 Anwendungen Montag: 11.+12. Lerneinheit 11. Concept Learning 11.1 Das Lernen von Konzepten 11.2 Hypothesenbildung, Konzepte 11.3 Totale und partielle Ordnung 11.4 Find-S Algorithmus: Vor- und Nachteile 11.5 Der Candidate-Elimination Algorithmus 12. GAs und (S)GD 12.1 Klassen globaler Optimierungsverfahren 12.2 Ameisenalgorithmen, Particleswarm-Optimierung, Simulated Annealing 12.3 Genetische Algorithmen: Mutation, Recombination, Selektion 12.4 Potential und Grenzen Genetischer Algorithmen: Das Schema Theorem 12.5 Gradientenabstieg: Gradient Decent 12.6 Stochastic Gradient Decent Dienstag: 13.+14. Lerneinheit 13. Regellernen 13.1 Data Mining und Predictive Analytics 13.2 Die Warenkorb-Analyse: Einkaufszettel 13.3 Support und Konfidenz 13.4 Assoziationsregeln, A Priori-Algorithmus 14. Recommender Systeme 14.1 Collaborative Filtering 14.2 Additive / Multiplikative Modelle und Link Prediction 14.3 Erkennung von Latent Features 14.4 Anwendungen - Netflix Preis 14.5 Matrix-Dekomposition Verfahren 14.6 SGD Implementierung 14.6 Stufen des KDD-Prozesses Mittwoch: 15.+16. Lerneinheit 15. CBR und NN 15.1 Case-based Reasoning und k-nächste Nachbarn 15.2 Voronoi-Diagramme und Delaunay Triangulierung 15.3 On-Line vs. Off-Line Berechnung 15.4 Das Lokalisationsproblem 15.5 Nearest Neighbor Algorithmen a) exakte Berechnung nächster Nachbarn: Full-Delaunay-Hierarchie (FDH), b) approximative Berechnung nächster Nachbarn: Fractal-NN 15.6 kd-Bäume: Mediane 15.7 Erweiterung von NN auf unterschiedliche Mengen 16. SVD und PCA 16.1 Eigenwerte: Die Feinstruktur im Vektorraum 16.2 Potentierung von Matrizen durch Spektralanalyse 16.3 Gründe riesige Feature-Mengen: Sliding Windows 16.4 Auswahl von Features 16.5 Singular Value Decomposition 16.6 Principle Component Analysis (Hauptkomponentenanalyse). Donnerstag: 17.+18. Lerneinheit 17. Strings 17.1 Maschinelles Lernen und Mustererkennung 17.2 Approximative Zeichenketten-/Teilstringsuche 17.3 Grenzen des Lernens von Automaten 17.4 Automatenlernen mit (I)ID 17.5 Dynamic Time Warp (DTW) 17.6 Datenreihen zu Strings: (i)SAX 17.7 Lernen von Abkürzungen Aho-Corasick 17.8 Der Makroproblemlöser: Nahe dem Menschlichem Lösen 18. Neuronale Netze 18.1 Menschliche Neuronale Netze 18.2 Artifizielle Neuronale Netze 18.3 Hopfield Netze zur kombinatorischen Optimierung 18.3 Self-Organizing Maps zum Lernen geometischer Formen 18.4 Multilayer Neural Nets, 18.5 Darstellungssätze: Boolesche und Allgemeine Funktionen 18.6 Backpropagation-Verfahren zum Berechnen des Gradientens 18.7 Convolutional Neural Nets und Deep Learning Freitag: 19.+20. Lerneinheit 19. Anwendungen Machine Learning 19.1 Lernen von Mustern in Spielen 19.2 Lernen von Netzwerkdaten 19.3 Lernen von Videoartefakten 19.4 Lernen von Backergebnissen 19.5 Lernen von Gesten 19.6. Lernen fürs 3D Drucken 19.7 Lernen von Sequenzalignierungen 19.8 Lernen von Straßenkarten 20. Grundzüge der Lerntheorie 20.1 Shatter und VC-Dimension 20.2 Definition PAC-Lernbarkeit 20.3 Fundamentalsatz der Lerntheorie 21. Wrap-Up, Questionaire Klausur 17.3.2017, 12-13:30 Uhr