x zeichen

Werbung

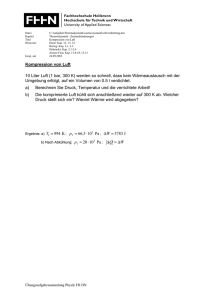

Kapitel 7

Bayes- oder Optimalklassifikator

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

1

Der Entwurf eines optimalen

Klassifikators

• Letztes Glied in der Mustererkennungskette

• Der Klassifikator hat die Aufgabe einer optimalen Zuordnung

eines Merkmalsvektors zu einer Bedeutungsklasse

• Grundlage für den Entwurf: Statistische Entscheidungstheorie

• Beschreibung des Erkennungssystems in Analogie zu einem

Nachrichtenübertragungssystem:

Störung

Quelle

Codierer

gesendetes

abstraktes

Zeichen

Kanal

ideales

Zeichenbild

H. Burkhardt, Institut für Informatik, Universität Freiburg

Decodierer

reales

Zeichenbild

̂

Senke

rekonstruiertes

abstraktes

Zeichen

ME-I, Kap. 7a

2

Über die einzelnen Komponenten

Codierer: aus einem abstrakten Quellzeichen K entsteht ein

Schriftzeichen: z.Bsp. OCR-B

Störung: beinhaltet alle Veränderungen wie z.B. eigentlicher Druckoder Schreibvorgang, mögliche Verschmutzungen, Fehler des

Scanners usw.

Decodierer: Lesemaschine, Entscheider, rekonstruiert das gesendete

Zeichen, übergibt Entscheidung an Senke

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

3

Aufbau des Decodierers

reales

Zeichen

Merkmalsbildung

x

H. Burkhardt, Institut für Informatik, Universität Freiburg

̂

Erkennung

Klassifikation

ME-I, Kap. 7a

4

Stochastisches Modell

Der zeichenerzeugende Prozeß erzeugt jeweils miteinander

verbundene Wertepaare (,x)

Störung

Quelle

Codierer

Kanal

Merkmalsbildung

x

Seine statistischen Eigenschaften werden vollständig durch die

Verbundverteilung beschrieben:

p ( , x ) p ( x, )

{ i } i 1, 2, K

diskret, x kontinuierlich

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

5

Optimalitätskriterium

Gesucht ist ein Klassifikator, welcher „bestmöglich“ nach einem vorgegebenen

statistischen Gütekriterium klassifiziert (Optimalklassifikator)

Wählt man als Optimalitätskriterium die Minimierung von Fehlentscheidungen

bei vielen Versuchen, so ergibt sich ein Klassifikator, welcher die Aposteriori-Wahrscheinlichkeit maximiert (Maximum-A-PosterioriKlassifikator):

max{P ( k | x)}

MAP- oder Bayes-Klassifikator

K

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

6

Theorem von Bayes

A4

A1

Ai seien sich gegenseitig ausschliessende

(disjunkte) Ereignisse

B

n

S Ai

Ereignisraum (sample space)

i 1

A2

A3

B sei ein beliebiges Ereignis. Dann gilt:

P ( Ai | B )

P ( Ai , B )

P(B)

P ( B | Ai ) P ( Ai )

S

n

P(B | A )P( A )

j

j

j 1

P ( Ai | B ) P ( B ) P ( Ai , B ) P ( B | Ai ) P ( Ai )

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

7

Beispiel

Die Anwendung des Theorems soll nun durch ein Beispiel veranschaulicht werden. Im Beispiel tritt das

Ereignis B ,,Die Reifen eines Autos quietschen'' mit der Wahrscheinlichkeit P(B)=0,05 auf; die Hypothese

A ,,Die Bremsen des Autos sind schlecht eingestellt'' mit der Wahrscheinlichkeit P(A)=0,02.

Nehmen wir des weiteren an, dass schlecht eingestellte Bremsen oft, aber nicht immer, ein Quietschen der

Räder verursachen. Die bedingte Wahrscheinlichkeit dafür ist P(B|A)=0,7. Wenn man nun ein Quietschen

der Reifen beobachtet, so kann man mit Hilfe des Bayes'schen Theorem die Wahrscheinlichkeit berechnen,

dass die Bremsen schlecht eingestellt sind:

P ( B | A) P ( A) 0, 7 0, 02

P( A | B)

0, 28

P( B)

0, 05

Man führt die W. P(Ursache | Ereignis) auf die einfacher zu berechnende W. P(Ereignis | Ursache) zurück.

Durch die Beobachtung des Ereignisses B hat sich die Wahrscheinlichkeit der Hypothese A von 0,02 auf

0,28 erhöht. Die Berechnung von P(A|B) ausgehend von P(A) kann als Neubewertung der Hypothese A

beim Eintreten des Ereignisses B aufgefaßt werden.

Darin liegt die Stärke dieses Theorems. Mit ihm läßt sich die Fortpflanzung der Unsicherheit berechnen. Der

Nachteil ist jedoch, dass zu jedem Ereignis und zu jeder Hypothese die Wahrscheinlichkeit und die

entsprechenden bedingten Wahrscheinlichkeiten gespeichert werden müssen. Dies erfordert eine große

Datenmenge, die häufig schwer zu beschaffen ist und auch oft nicht mit mathematischer Exaktheit beschafft

werden kann. [Gottlob1990]

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

8

Grundlage der Optimalentscheidung ist die a-posteriori- oder

Rückschlusswahrscheinlichkeit P(k|x). Dies ist die bedingte

Wahrscheinlichkeit, dass bei bei einem beobachteten Wert x das

Zeichen k vorlag.

Diese kann mit dem Bayes-Theorem wie folgt umgewandelt werden:

p ( x, k ) p ( x | k ) P ( k )

P ( k | x )

p (x)

p ( x)

mit der Randverteilung:

p ( x) p ( x, k ) p ( x | k )P (k )

K

K

Die a-posteriori oder Rückschlusswahrscheinlichkeit zur Entscheidung der

Klassenzugehörigkeit wird zurückgeführt auf die klassenspezifischen

Verteilungsdichten, welche gemessen werden können!

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

9

Bayes- oder Maximum-A-Posteriori (MAP)

Klassifikator

Die Maximierung der a-posteriori oder Rückschlusswahrscheinlichkeit zur

Entscheidung der Klassenzugehörigkeit wird zurückgeführt auf die

klassenspezifischen Verteilungsdichten, welche gemessen werden können:

max P (i | x )

i

P (i | x )

? P ( j | x )

p ( x | i ) P (i ) ? p ( x | j ) P ( j )

p (x)

p ( x)

p(x) auf beiden Seiten gleich!

Bayes- oder

MAP-Klassifikator

Bei gleichwahrscheinlicher a-priori-Verteilung P(i)= P(j) erhält man daraus:

? p(x | )

p ( x | i )

j

H. Burkhardt, Institut für Informatik, Universität Freiburg

MLE-Klassifikator

(Maximum-Likelihood Estimation)

ME-I, Kap. 7a

10

Optimalklassifikatoren

max{ P ( k | x )}

k

max{ p ( x | k ) P ( k )}

Bayes- oder MAPKlassifikator

k

Das MAP-Kriterium wird zurückgeführt auf klassenspezifische Verteilungsdichten,

welche gemessen werden können.

max{ p ( x | k )}

K

Maximum-Likelihood-Klassifikator

(p(x|k) Bed. Wahrscheinlichkeit von x bzgl. k)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

11

Zwei-Klassen-Problem mit Gaußverteilungsdichten und

einem skalaren Merkmal x

Die Auftretenswahrscheinlichkeit

von x unter der Annahme, dass

2 gesendet wurde ist größer als

die von der Annahme, dass 1

gesendet wurde.

p (x) p ( x | k ) P (k )

P ( k | x) p ( x) p ( x, k ) p ( x | k ) P ( k )

K

p ( x | 2 ) P ( 2 )

p ( x | 1 ) P (1 )

p ( x | 1 ) P (1 )

x

p ( x | 2 ) P ( 2 )

x

1

x

x

Merkmalsraum

2

? p ( x | ) P ( )

p ( x | i ) P (i )

j

j

p(x|k) Klassenspezifische Verteilungsdichte für den Merkmalsvektor x, die der Klasse

k zuzuordnen sind.

A-priori-W. für die Häufigkeit der Quellsymbole: P(k)

(Quellstatistik, Auftretens-W. für die Ereignisse k, z.Bsp. Buchstaben in einer Sprache)

Die W., dass x gemessen wird ergibt sich aus der Überlagerung der Auswirkungen, dass

k gesendet wurde: p (x) p(x | 1 ) P(1 ) p( x | 2 ) P( 2 ) p( x | k ) P( k )

K

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

12

MAP-Entscheidung

1

0.9

P (1 | x)

0.8

p ( x | 1 ) P (1 )

p (x)

P (2 | x)

p ( x | 2 ) P (2 )

p (x)

0.7

0.6

0.5

0.4

0.3

p ( x | 2 ) P ( 2 )

P ( 2 | x )

p ( x | 1 ) P (1 )

0.2

Normalverteilung:

0.1

0

-2

p( x)

0

2

4

6

p ( x) p ( x, k ) p ( x | k )P (k )

K

K

H. Burkhardt, Institut für Informatik, Universität Freiburg

8

10

12

1

2 x

e

1 xx

2 x

2

p ( x | 1 ) P (1 ) 0, 2 p ( x 1) 0, 3 p ( x 4)

p ( x | 2 ) P ( 2 ) 0, 5 p ( x 8)

ME-I, Kap. 7a

13

Entscheidung mit Log-Likelihood

y1 später mit

Anstatt: y2

dx

log-likelihood einfacher: d x2

1

y2

y1

d x1

x

xs

d x2

x

1

H. Burkhardt, Institut für Informatik, Universität Freiburg

x

2

ME-I, Kap. 7a

14

Normalverteilte klassenspezifische

Merkmale p(x|k)

Eindimensionaler Fall (nur ein Merkmal):

p(x)

p( x)

1

2 x

1

2 x

e

1

2

1

2 x

e

1 xx

2 x

2

x

x

x

Erwartungswert von x:

x E{x}

x

Varianz:

var( x) x2 E{( x x ) 2 }

x p ( x )dx

x

( x x ) 2 p ( x) dx

x

Standardabweichung:

x var( x)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

15

N-dimensionale Normalverteilung

Erwartungswert: x=E(x)

(Vektor)

Statt Varianz 2 nun Autokovarianzmatrix:

K C xx E{( x μ x )(x μ x )T } R xx μ x μ xT

N-dimensionale Normalverteilung: p ( x )

K1,1

K

2,1

K

K N ,1

K1,2

K 2,2

K N ,2

K1, N

K 2, N

K N , N

H. Burkhardt, Institut für Informatik, Universität Freiburg

1

(2 ) N det(K )

e

1

( x μ x )T K 1 ( x μ x )

2

K m , n E{( xm xm )( xn xn )}

K n , n E{( xn xn ) 2 }

K : a) symmetrisch

b) positiv semidefinit

ME-I, Kap. 7a

16

N-dimensionale Normalverteilung

Aus der Positiv-Semidefinitheit folgt:

aT Ka 0 für beliebige a 0

Falls eine oder mehr Komponenten Linearkombinationen von anderen sind, ist K

semidefinit, andernfalls positiv definit (soll hier i.allg. angenommen werden).

Falls K pos. definit, dann auch K-1 => det(K)>0 und det(K-1)>0 .

Ortskurven konstanter Wahrscheinlichkeitsdichten p(x):

Q ( x x )T K 1 ( x x ) const .

Diese quadratische Form ergibt Kegelschnitte und für pos. def. K-1 erhält man

N-dimensionale Ellipsoide.

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

17

N=2: Ellipsen

Aus der Eigenwertgleichung:

Kb b [K I ]b 0

Ergeben sich die

Eigenwerte: 1, 2

und die Eigenvektoren: b1, b2

b2

x1

1

b1

2

x

x1

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

18

Der Bayes-Klassifikator

max P (i | x)

i

Annahme: Klassenspezifische

Gauß-Verteilungen

Zweidimensionaler Merkmalsraum

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

19

Optimales Erkennungssystem

klassenspezifische Verteilungen

im Merkmalsraum

x

p(x|1)

p(x|2)

p(x|K)

Auftretenswahrscheinlichkeiten

der Symbole

P(1)

P(2)

P(K)

p(x|1) P(1)

ˆ k

p ( x | ˆ k ) P (ˆ k )

p(x|2) P(2)

Rückweisungsprüfung

Maximumsuche

p(x|K) P(K)

Hilfsgröße für die

Entscheidung

Zurückweisung

Zurückweisungsprüfung

Zurückweisung falls:

d.h. P (ˆ k | x)

ˆ k

p(x)

p ( x) p ( x | ˆ k ) P (ˆ k )

p ( x | ˆ k ) P (ˆ k ) p ( x)

Rückweisungsschwelle

Falls maximale klassenspez. W. im Vergleich zur absoluten

Auftretens-W. (rel. Mass) einen zu geringen Wert hat

Zurückweisung (sonst wäre Entscheidung sehr unsicher)

(typisch in der Nähe der Klassengrenzen !)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

20

Zur Positiv-Definitheit der Kovarianzmatrix K

Man erwartet, dass die Beobachtungen des Zufallsprozesses unabhängig sind.

Beh.: Q z T Kz 0 für z 0

Bew:

Q z T E{( x )( x )T }z

2

E{z T ( x )( x )T z} E{[( x )T z ] }

w (Skalar)

E{w 2 } 0 für w 0

Der singuläre Fall Q=0 bedeutet, dass der Zufallsprozess (x-) z steht, d.h. er

belegt nur einen linearen Unterraum des N-dimensionalen Beobachtungsraumes N. Dies ist dann der Fall, wenn die Zufallsvariablen nicht den ganzen

Raum aufspannen, d.h. wenn ein Vektor linear abhängig ist von anderen (z.B.

wenn die Beobachtungen im dreidimensionalen Raum immer nur in einer

Ebene liegen).

Für einzelne Vektoren darf die Orthogonalität (x-)z gegeben sein, jedoch nicht

für das ganze Ensemble, so dass E{...}=0.

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

21

Konsequenzen der PositivDefinitheit von K

•

•

•

•

•

K ist regulär und es existiert K-1

det(K)>0

K-1 ist ebenfalls positiv definit

det(K-1)>0

Die Eigenwerte von K sind positiv

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

22

Fall 1: Klassenweise beliebige

normalverteilte Merkmale

Mit dieser Annahme kann das MAP-Kriterium weiter spezifiziert

werden:

p ( x, k ) p ( x | k ) P ( k )

Der zeichenerzeugende Prozess zerfällt in K voneinander

unabhängige Teilprozesse {p(x|k)} mit den Kenngrößen:

xk E{x | k }

klassenspezifischer Erwartungswert

K k E{( x xk )( x xk )T | k } klassenspezifische Kovarianzmatrix

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

23

Berechnet man die k-te Entscheidungsfunktion des MAPKriteriums, so ergibt sich:

Dk ( x) p ( x | k ) P ( k )

P (k )

(2 ) det(K k )

N

e

12 ( x xk )T K k1 ( x xk )

Mit Hilfe einer monotonen Abbildung ln(...), welche die

Größenverhältnisse nicht verändert, ergibt sich:

1

1

Dk ( x ) ln P ( k ) ln(det( K k )) [( x xk ) T K k1 ( x xk )]

2

2

mit abschließendem Maximumvergleich.

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

24

Die Grenzen zwischen den Klassengebieten ergeben sich zu:

!

Di( x) D j ( x)

daraus ergibt sich die Grenzfläche g ij ( x) 0, mit:

det K i

P ( i )

g ij ( x ) ln

2 ln

det K j

P ( j )

( x xi )T K i1 ( x xi ) ( x x j )T K j 1 ( x x j )

Aus der Differenz zweier quadratischen Formen ergibt sich eine

gemeinsame quadratische Form der Gestalt:

g ij ( x) g 0 ( x x 0 )T M 1 ( x x 0 )

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

25

mit:

det K i

P ( i )

g 0 ln

2 ln

Txi K i1 xi

det K j

P ( j )

Tx j K j 1 x j xT0 M 1x 0

x 0 M[K i1 xi K j 1 x j ]

M [K i1 K j 1 ]1 K i [K j K i ]1 K j

K j [K j K i ]1 K i

Die die quadratische Form charakterisierende Matrix M-1 ist nun

nicht mehr zwingend pos. definit => die Grenzflächen zwischen

den Gebieten sind allgemeine Kegelschnitte (bei N=2: Ellipsen,

Parabeln, Hyperbeln, Geraden)

Die Unterscheidungsfunktionen D´k(x) sind in Bezug auf den

Merkmalsvektor quadratische Funktionen oder Polynome

zweiten Grades (quadratischer oder Polynomklassifikator)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

26

Klassenweise normalverteilte Merkmale

(aus J. Schürmann: „Polynomklassifikatoren für die Zeichenerkennung“, Oldenbourg Verlag)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

27

Fall 2: Klassenweise normalverteilte Merkmale

mit identischen Kovarianzmatrizen K

x2

2

1

3

x1

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

28

Fall 2: Klassenweise normalverteilte Merkmale

mit identischen Kovarianzmatrizen K

Entscheidungsfunktion:

1

1

Dk ( x ) ln P ( k ) ln(det K ) [( x xk )T K 1 ( x xk )]

2

2

Dk 2 Dk ln(det K )

Dk 2 ln P ( k ) ( x xk )T K 1 ( x xk )

Für gleiche Auftretenswahrscheinlichkeiten P ( k ) 1/ K folgt:

Dk Dk 2 ln K

Dk d

2

M

1

( x xk ) K ( x xk )

T

Mahalanobis-AbstandsKlassifikator

Dies ist eine allgemeine gewichtete quadratische Metrik.

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

29

Formulierung als linearer Klassifikator

Die Entscheidungsfunktion enthält noch einen quadratischen Term. Dieser ist

jedoch für jede Klasse identisch und kann somit eliminiert werden. Damit

kommt man zu einer linearen Formulierung des Klassifikators.

Alternativ ergibt sich:

1

Dk Dk [ln(det K ) xT K 1x]

2

1 T 1

Dk ln P ( k ) xk K xk Txk K 1x

2

Dieser Ausdruck ist linear in x !

Dk( x ) a0 k a x a0 k a k , x

T

k

Hyperebene als

Trennfläche !

mit:

1 T 1

a0 k ln P ( k ) xk K xk

2

a k K 1 xk

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

30

Fall 3: Klassenweise normalverteilte Merkmale mit der

Einheitsmatrix als Kovarianzmatrix K=2I

(sphärisch invariante Verhältnisse, Hyperkugeln)

Entscheidungsfunktion:

Dk ( x ) ln P ( k ) N ln

1

2

Für konstante A-priori-W. folgt:

Dk x xk

( x xk ) T ( x xk )

Euklidsche Metrik

Minimum-Abstands-Klassifikator

2

Auch hier formuliert als linearer Klassifikator:

Dk

1

2

( x Dk)

2

Dk( x ) a0 k aTk x

mit:

Dk

1

2

2

( x ( x xk

2

2

2

1

2 x, xk )) xk xk , x

2

ak

a0 k

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

31

Kurven konstanter a) Euklidscher- und b) MahalanobisDistanz dM zum Erwartungswert der jeweiligen Klasse

x2

x2

2 2 c v 2

μ1

a)

x1

H. Burkhardt, Institut für Informatik, Universität Freiburg

μ2

b)

2 1 cv1

x1

ME-I, Kap. 7a

32

Bayes-Entscheidungsgrenzen für

normalverteilte Musterklassen

• Allgemeiner Fall: matlab-Bayes-Fall1.bat

• Mahalanobis: matlab-Bayes-Fall2.bat

• Euklid: matlab-Bayes-Fall3.bat

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

33

Transformation der Mahalanobis-Metrik auf

sphärisch invariante Verhältnisse

Die Kovarianzmatrix kann mit einer KLT diagonalisiert werden:

Λ diag( 1 , 2 , , N ) A T KA

bzw:

K AΛA T

Die unitäre Matrix erfüllt: AT A 1

Die Eigenwerte sowie die Eigenvektoren von K definieren die

Diagonalmatrix und die Eigenvektoren die Tansformationsmatrix:

A e1 , e2 ,, eN

Kurven konstanter Mahalanobisdistanz ergeben sich zu:

( x i )T AΛ 1A T ( x i ) c 2

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

34

Transformation auf sphärisch invariante

Verhältnisse

Einführung einer Koordinatentransformation: x A T x

Damit werden die ursprünglichen Koordinaten auf die Eigenvektoren projeziert und

man kommt dann zu den folgenden Kurven konstanter Mahalanobis-Distanz:

( x1 i1 ) 2

1

)2

( xN iN

N

c2

Dies ist ein Hyperellipsoid in dem neuen Koordinatensystem.

Mit xk xk / k und ik ik / k erhält man

sphärisch invariante (Euklidsche) Verhältnisse:

) 2 c 2

( x1 i1 ) 2 ( xN iN

(Kugeln)

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

35

Beispiel: Zweiklassenproblem der Dimension 2

Die Kovarianzmatrix und die Erwartungswerte seien gegeben mit:

1.1 0.3

K

0.3

1.9

μ1 0 0

μ 2 3 3

T

T

Klassifiziere die Beobachtung x 1.0 2.2 nach Bayes.

T

Die soll durch Berechnung der Mahalanobisdistanz zu den beiden

Erwartungswerten geschehen:

d (1 , x ) ( x 1 ) K ( x i ) 1.0

2

M

T

1

2

0.95 0.15 1.0

2.2

2.2 2.952

0.15

0.55

1

enstprechend:

d M2 ( 2 , x ) ( x 2 )T K 1 ( x 2 ) 2.0

0.95 0.15 2.0

0.8

3.672

0.15 0.55 0.8

D.h. die Beobachtung wird der Klasse 1 zugeordnet.

Man beachte, dass die Beobachtung bzgl. der Euklidschen Distanz näher an Klasse 2 liegt!!

x 1

2

5.84

x 2

2

4.64

H. Burkhardt, Institut für Informatik, Universität Freiburg

Siehe dazu auch:

http://www.cs.mcgill.ca/~mcleish/644/main.html

Applet für Bayessche Entscheidungen

ME-I, Kap. 7a

36

Das Voronoi-Diagramm im zweidimensionalen Raum

als Entscheidungsgrenzen für die Euklidsche Distanz

R2

x2

R1

x3

x1

Zerlegung der Ebene in Regionen Ri

für eine Menge von Punkten xi. Jede

Region enthält genau die Punkte,

welche näher sind zu den jeweiligen

Punkten (Erwartungswerten) als

irgend ein anderer Punkt:

x4

Ri {x : d ( x, x i ) d ( x, x j ) für i j}

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

37

Wahrscheinlichkeit einer Fehlklassifikation bei einem Zwei-KlassenProblem mit Normalverteilungen und einem skalaren Merkmal

2

1

d

p (x | 2 )

p( x )

1 1

1

( x ) 2 / 2 2

e

g ( x)

2 2

2

p ( x | 1 )

x

d/2 x

x

1

x

2

Die W. dass 1 gesendet wurde und bei gemessenen Werten x zugunsten von 2

entschieden wird, entspricht der W. dass x oberhalb von d/2 liegt (schraffierte Fläche).

Ebenso für 2 1 . D.h. die W. einen Fehler bei der Klassifikation zu machen ergibt

sich aus der doppelten Fläche:

1

P( E ) 2

g ( u )du

2 x d / 2

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

38

Mit der kumulativen Verteilungsfunktion F ( x0 ) P ( x x0 ) gilt:

1

x x

g

(

u

)

du

(1

erf

2

2

x

F ( x)

)

und mit der Gauß'schen Fehlerfunktion

x

2

erf( x )

t

e

dt (analytisch nicht integrierbar)

2

0

bzw. komplementären Fehlerfunktion

2

erfc( x )

t

e

dt 1 erf( x)

2

x

erhält man die Fehler-W. zu:

P( E )

g (u ) du 1 F ( x d / 2)

xd / 2

1

x x

(1 erf

2

2

1

x x

)

erfc

xd / 2 2

2 x d / 2

x 0

1

d /2

P ( E ) erfc

2

2

x 0

Die W. für eine Fehlklassifikation sinkt mit

wachsendem Klassenabstand und steigt mit

wachsender Streuung der Merkmale

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

39

Die Gesamtfehlerwahrscheinlichkeit im N-dimensionalen

Merkmalsraum berechnet sich aus der minimalen

Distanz dmin zu (Forney):

1

d min / 2

P ( E ) const erfc

2

2

(ohne Beweis)

d min

H. Burkhardt, Institut für Informatik, Universität Freiburg

ME-I, Kap. 7a

40