functional programming in python

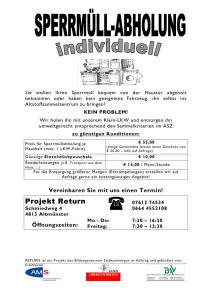

Werbung

Nichtprozedurale Programmierung

in Python und anderen Sprachen

Thomas Letschert

FH Giessen–Friedberg

Version 1.0 vom 25. August 2005

Inhaltsverzeichnis

1

Funktionale Programme

1

1.1

Prozedurale und Nicht–Prozedurale Programmierung . . . . . . . . . . . . . . . . . . . . . . . .

5

1.1.1

Prozedurale Programmierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.1.2

Deklarative Programmierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.1.3

Typen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

1.1.4

Compilierte und Interpretierte Sprachen . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

Ausdrücke und ihre Auswertung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

16

1.2.1

Definitionen und Ausdrücke . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

16

1.2.2

Statische und Dynamische Bindung . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

1.2.3

Statische und Dynamische Typisierung . . . . . . . . . . . . . . . . . . . . . . . . . . .

22

1.2.4

Kopiersemantik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

26

1.2.5

Funktionen und ihre Definition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

1.2.6

Auswertung von Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

31

1.2.7

Weitere Notationen und Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . .

35

Funktionales Programmieren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

37

1.3.1

Algorithmenschemata . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

37

1.3.2

Numerisches . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

39

1.3.3

Listen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

40

1.3.4

Daten und Datenstrukturen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

1.3.5

Datenabstraktion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

1.3.6

Verwaltung von Zustandsvariablen im funktionalen Stil . . . . . . . . . . . . . . . . . . .

51

Funktionen in OO–Sprachen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

1.4.1

Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

1.4.2

Funktionen als Parameter . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

56

1.4.3

Funktionale Objekte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

1.4.4

Dynamisch erzeugte Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

60

1.4.5

Konstruktion Funktionaler Objekte . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

1.4.6

Closures, Funktionale Objekte und Bindungen . . . . . . . . . . . . . . . . . . . . . . .

67

Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

1.5.1

Rekursion, Induktion, Iteration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

1.5.2

Rekursive Daten und rekursive Funktionen . . . . . . . . . . . . . . . . . . . . . . . . .

73

1.2

1.3

1.4

1.5

2

Th Letschert, FH Giessen–Friedberg

1.6

1.7

2

1.5.3

Klassifikation der Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

74

1.5.4

Fortsetzungsfunktionen und die systematische Sequentialisierung . . . . . . . . . . . . .

81

1.5.5

Entwicklung Rekursiver Programme . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

Iteratoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

91

1.6.1

Iteratoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

91

1.6.2

Iteratoren in Python . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

94

1.6.3

Bäume und Baum–Besucher . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

95

1.6.4

Bäume und Baum–Iteratoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

98

Generatoren und Datenströme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

1.7.1

Generatoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

1.7.2

Generator–Beispiele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 105

1.7.3

Implementierung von Generatoren durch Threads . . . . . . . . . . . . . . . . . . . . . . 107

1.7.4

Datenströme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 114

Relationale Programme

2.1

2.2

2.3

2.4

3

118

Sprachen mit Mustererkennung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 119

2.1.1

Reguläre Ausdrücke: Reguläre Textstrukturen erkennen . . . . . . . . . . . . . . . . . . . 119

2.1.2

XML . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124

Suche, Nichtderminismus, Relationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

2.2.1

Mustererkennung als Suchproblem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

2.2.2

Nichtdeterministische Programme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 139

2.2.3

Relationale Programme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 142

Logik–Programme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

2.3.1

Prolog . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

2.3.2

Unifikation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 150

2.3.3

Prolog–Interpreter . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 155

Constraint Programmierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 159

2.4.1

Programmieren mit Beschränkungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 159

2.4.2

Lösungssuche . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 159

Kapitel 1

Funktionale Programme

1

2

Nichtprozedurale Programmierung

“Sie sind doch geschickt darin, Wörter zu erklären, Herr Goggelmoggel”,

sagte Alice. “Können Sie mir freundlicherweise sagen,

was das Gedicht Der Zipferlake bedeutet?”

“Nur heraus damit”, sagte Goggelmoggel.

“Ich kann alle Gedichte erklären, die jemals gedacht worden sind –

und noch eine ganze Menge, bei denen das Erdenken erst noch kommt.”

Lewis Carroll, Alice hinter den Spiegeln

Vorbemerkung

Die Entwicklung der Programmiersprachen wurde in der Vergangenheit stets aus zwei Richtungen beeinflusst

und vorangetrieben. Zum einen von der Seite der Hardware, zum anderen von der Seite der Theorie mit ihrem

Nachdenken darüber, was denn ein Programm eigentlich ist und was es ausdrücken soll. In den frühen Jahren der

Informatik war der Einfluss von Seiten der Hardware absolut dominant. Die ersten Programmiersprachen waren

nichts anderes, als das Instruktionsrepertoir bestimmter Maschinen und sie sollten nichts anderes zum Ausdruck

bringen können, als deren elementare Operationen; und die waren und sind prinzipiell recht einfach. Die Maschinen hatten bestimmte prinzipielle Charakteristika, an denen sich im Laufe der Jahre wenig änderte: im Regelfall

hat man es mit Hardware zu tun, die heute, so wie vor 50 Jahren, der sogenannten “Von–Neumann–Architektur”

entspricht, und deren Funktionsweise sich über viele Abstraktionsstufen in den Programmiersprachen und Programmen wiederfindet.

Vektorrechner, Parallelrechner, verteilte Systeme und Ähnliches an Hardwarestrukturen drängt allerdings zunehmend nach vorn und es ist zumindest zweifelhaft, ob der von–Neumann–Rechner, als Grundmuster eines Rechners

und der Programmierung, für alle Zeiten ohne ernsthafte Alternativen bleiben sollte. Schon heute folgt also die

Hardware gar nicht mehr so recht dem klassischen Vorbild und es kommt vor, dass die Programmierer den Parallelismus einer Problemstellung beim Verfassen eines sequenziellen Programms mühsam eliminieren und dieses

Programm dann aufwändig vom Compiler in ein Maschinenprogramm übersetzt wird, das den Parallelismus der

Hardware auszunutzen versucht. Da wäre es vielleicht doch angemessen die parallele Problemlösung direkt auf

die parallele Hardware zu bringen.

Ein Rechner der klassischen Bauart besteht, sehr abstrakt gesehen, aus einer Menge von Speicherplätzen, deren Inhalt durch Befehle modifiziert, hin– und herkopiert sowie von externen Quellen eingelesen und dorthin ausgegeben

werden kann. Die Modifikation ist dabei bei einer “Von–Neumann–Architektur” auf Register beschränkt, also auf

sehr wenige schnelle Speicherstellen innerhalb der CPU. Sie werden von einem Maschinenprogramm zyklisch mit

Werten aus den anderen Speicherstellen im Hauptspeicher “geladen”, ihr Inhalt wird verarbeitet und das Ergebnis

wieder gespeichert.

Während die Techniker mit Programmen als Sequenzen von Lade–, Verarbeite– und Speicherbefehlen zufrieden

waren, wollten die Anwender sich von der Maschine lösen und Notationen nutzen, die der Problemwelt angemessener sind, d.h. sie wollten in “höheren Sprachen” programmieren. Das älteste Hilfsmittel der höheren Programmierung ist die Prozedur. Bereits in den 40–er Jahren entwickelten Computerpioniere wie Turing und Zuse

unabhängig von einander Programmiertechniken, bei denen größre Aufgaben mit Hilfe von speziellen oder standardisierten Unterroutinen gelöst wurden. Eine Unterroutine, eine Prozedur, war dabei nichts anderes, als eine

Sequenz von Maschinenanweisungen. Auch wenn die Programmierung mit Hilfe von Prozeduren erheblich vereinfacht wurde, so blieben die Programme doch weiterhin bis weit in die 50–er (jetzt strukturierte) Sequenzen

von Maschinen–Anweisungen. Es waren und blieben rein prozedurale Programme: Programme deren Inhalt die

Beschreibung einer Folge von Speicherplatzmanipulationen darstellt.

Nach und neben den Prozeduren wünschten sich die Autoren der frühen Programme, dass sie mathematische

Berechnungen in der gewohnten Art durch Formeln ausdrücken können. FORTRAN FORmula TRANslator bot,

als erste erfolgreiche Programmiersprache, die Möglichkeit arithmetische Ausdrücke in mathematischer Notation zu verwenden. Mit diesen “Formeln” enthielten FORTRAN–Programme Elemente die definitiv nicht von der

Hardware und ihren Konzepten hergeleitet waren, sondern aus dem Problembereich kamen. Die erste “höhere”

Programmiersprache war geboren und sie enthielt mit den arithmetischen Ausdrücken, den “Formeln”, ein nicht-

Th Letschert, FH Giessen–Friedberg

3

prozedurales Element.

Gleichzeitig mit der Entwicklung von FORTRAN, also noch in den 50–ern, konzipierte der Visionär McCarthy

eine Programmiersprache namens LISP (LISt Processor) die den Weg, weg von der Maschine, hin zu einer problemorientierten Formulierung von Programmen, weit radikaler ging. LISP–Programmierer wollten sich nicht nur

dem damals üblichen Geschäft des Lösens schnöder Rechenaufgaben widmen. Ihr Anspruch war weit umfassender: “Wissen” sollte dargestellt und verarbeitet werden, die Maschinen sollten “intelligent” werden. Die “wissenden” und “denkenden” Programme waren zunächst nichts anderes als Programme, die sich nicht wie damals auf

die Manipulation numerischer Werte beschränkten, sondern allgemeine Datenstrukturen mit alphanumersichen

Werten verarbeiteten. Die grundlegende Datenstruktur in LISP war und ist immer noch der, “Liste” genannte,

Binärbaum. Eine gleichzeitig mächtige wie allgemeine und einfache Datenstruktur. Aus heutiger Sicht ist die Idee,

mit Datenstrukturen und Zeichenketten zu arbeiten, eher trivial und die Verknüpfung dieser Idee mit Intelligenz

und Wissen klingt nach Hybris und Größenwahn. Man sollte jedoch bedenken, dass die Idee einer Datenstruktur damals völlig neu war und erst die Perspektive eröffnete, Computer zu anderem als zum Rechnen oder dem

Verwalten von Inventarlisten auf Magnetbändern zu verwenden.

Neben der Innovation der Liste, als Datenstruktur ohne direke Entsprechung in der Hardware, demonstrierte McCarthy, dass sich auch die Kontrollstruktur der Programme von den Vorgaben der Maschine lösen kann. In Lisp

geben die von der Mathematik inspirierten Funktionen den Takt der Programme an. Variablen, Anweisungen,

Schleifen, Sprünge sind bestenfalls noch als unterprivilegierte Kellerkinder geduldet. Wegen dieser Bedeutung der

Funktionen werden LISP und seine Verwandten funktional genannt. Sie waren von Anfang an in engem Kontakt

zur künstlichen Intelligenz und blieben es über die Jahre.

In der Folge kam es dann zu einem permanenten Wettstreit zwischen den Verfechtern des prozeduralen Stils

mit ihrem von “der Maschine” abgeleiteten Konzept eines Programms und den Verfechtern alternativer, nicht–

prozeduraler Programmierstile, die dafür plädieren, dass Programme in einer “natürlichen” und dem “Problem

angemessenen” Form formuliert werden sollten. Mit den intellektuellen Großwetterlagen schwankte der Zeitgeist

zwischen den Lagern. Als in den 80–ern die damals dominierende Technologie–Macht Japan die Entwicklung von

Computern der “fünften Generation” ankündigte, die ungeahnte Dinge mit Konzepten der künstlichen Intelligenz

bewerkstelligen sollten, hatte auch die funktionale Programmierung ein Jahrhundert–Hoch. Künstliche Intelligenz

und funktionale Sprachen entstammen schließlich dem gleichen intellektuellen Umfeld. Die Vorstellung geheimnisvoller asiatischer Supercomputer und Roboter ließ amerikanische und europäische Politiker Unmengen von

Fördergeldern in die aride1 Landschaft der KI-Forscher streuen.

Eine etwas bescheidenere Blüte hatten die funktionalen Sprachen kurz vorher, Ende der 70–er. Es ging dabei nicht,

wie bei der KI, um grandios–schaurige Visionen, sondern um tröge Programm–Korrektheit. Nach einer, damals

schon seit Jahren anhaltenden “Software–Krise”, mit Kuren wie Programmverifikation, systematischem Programmieren, abstrakten Datentypen, Spezifikationssprachen, etc. wurden immer noch schlechte und fehlerhafte Programme geschrieben. Nun, so meinten viele, war es Zeit für eine Radikalkur: Die alten schlechten Programmiermethoden können nur dann mit Stumpf und Stiel ausgerissen werden, wenn die Quelle allen Übels, der prozedurale

Stil, eliminiert wird. Programme haben dann die Reinheit und Klarheit mathematischer Formeln. Von diesen weiß

jeder, der niemals ernsthaft Mathematik betrieben hat, dass sie von allen kompetenten Wissenschaftlern schnell

und sicher in richtig und falsch geschieden werden können. Wenn Programme wie mathematische Funktionen

geschrieben werden, dann kann man endlich jeden Fehler mehr oder weniger sofort entdecken. In diesem Argument steckt ein wahrer Kern, aber zu glauben, dass die Abschaffung der Zuweisung letztlich alle Probleme des

Software–Engineering löst, ist schlicht lächerlich – wenn auch nicht wesentlich lächerlicher als der Gedanke, dass

die allgemeine Verwendung von UML die ultimative Lösung aller Probleme darstellt.

Mit den Kursen japanischer Aktien schmolz die Begeisterung für KI und damit für funktionale Programmierung

dann dahin. Im trockenen Wind von Prädikatenlogik, Lambda–Kalkül und Gödelschen Beweistechniken verdorrten die Förderoasen der KI nach dem Ausbleiben der Subventionswässer. Die Software-Techniker fanden mit der

Objekt–Orientierung auch schnell ein Betätigungsfeld mit höherem Sexappeal als Korrektheitsargumente bieten

können. Die funktionale Sicht der Welt, mit Programmen als Folgen von Eingabe, Verarbeitung und Ausgabe, war

auch jetzt einfach von altmodischer Beschränktheit im Vergleich zu den moderneren Konzepten der Verteiltheit

oder der reaktiven Programmierung. In der Softwaretechnik wurden die mit dem funktionalen Stil verbundenen und

kurz zuvor noch hochgelobten “strukturierten Techniken” von objektorientierter Analyse und Entwurf abgelöst und

1

arid = “trocken”, aus dem Lateinischen, botanische Bezeichnung für den Charakter von Wüsten und Halbwüsten.

4

Nichtprozedurale Programmierung

zu Weisheiten graubärtiger alter Männer. Der für die Informatik so typischen maßlosen Überschätzung von damals

stand plötzlich und bis heute andauernd eine ebenso typische übertriebene Ignoranz gegenüber. Alle “abweichenden” Konzepte werden von der aktuellen Inkarnation des prozeduralen Stils, der prozeduralen Programmierung,

der Objektorientierung, plattgewalzt. Konzepte, die zwar nicht die ultimative Lösung aller Probleme bringen, aber

einen wichtigen Bestandteil des Wissens– und Erfahrungsschatzes der Informatik darstellen, werden weitgehend

ignoriert.

FORTRAN, die erste erfolgreiche höhere Programmiersprache umfasste interessanterweise gleichzeitig funktionale und prozedurale Ausdrucksstile. Es gab Ausdrücke, die uns heute so selbstverständlich als Programmelemente

sind, aber damals einen revolutionären Bruch im Programmierstil darstellten. Ebenso gab es die damals gewohnten

Anweisungen: Zuweisungen, Sprünge und bedingten Anweisungen. Lisp und seine Verwandten und Nachfolger

mit rein funktionalem Charakter führen und führten schon immer ein Randdasein. Umgekehrt ist die Vorstellung,

Anwendungen in rein prozeduralen Sprachen zu schreiben, also beispielsweise ohne Ausdrücke, völlig absurd. Radikale Positionen sind im Streit der Programmierstile so unsinnig wie auch sonst im Leben. Die Objektorientierung

ist heute zweifellos das dominierende Konzept. Funktionale Programmiertechniken sind keine Konkurrenz zur Objektorientierung. Die Konzepte sind orthogonal.2 Beide Stile liefern komplementäre Denkmuster von bleibendem

Wert.

Der Autor dankt allen kritischen Lesern des Skripts und Teilnehmern der Veranstaltung, für die von

ihnen aufgedeckten Unrichtigkeiten, Nachlässigkeiten und Missverständlichkeiten und, noch mehr,

für ihren nüchtern skeptischen Enthusisasmus mit dem sie zu Inhalt und Qualität der Veranstaltung

beigetragen haben.

2 “Orthogonal” bedeutet senkrecht zueinander. Im übertragenen Sinn sind orthogonale Konzepte solche, die sich nicht gegenseitig in die

Quere kommen.

Th Letschert, FH Giessen–Friedberg

1.1

5

Prozedurale und Nicht–Prozedurale Programmierung

Computer science is no more about computers

than astronomy is about telescopes.

E.W. Dijkstra

1.1.1

Prozedurale Programmierung

Variablen und Werte

Die Welt besteht aus Dingen, die sich im Laufe der Zeit verändern können. Auf dieser Grundüberzeugung beruht

die prozedurale Programmierung. In einem einfachen prozeduralen Programm sind die veränderlichen Dinge die

Variablen. Sie werden von Anweisungen verändert. Wer eine prozedurale Sprache erlernt, muss als erstes dieses

Konzept der Variablen und Anweisungen verstehen. Die meisten von uns haben nach Jahren der Programmiererfahrung vergessen, dass dies mit einer gewissen Anstrengung verbunden war. Je erfolgreicher der Mathematikunterricht war, umso fester hat sich im Bewußtsein des Programmierlehrlings festgesetzt, dass eine Variable einen

Wert bezeichnet. Im Programmierunterricht muss dann wieder umgelernt werden: Das mathematische Konzept der

Variablen muss ersetzt werden durch Variablen, deren Wert vom Zustand des Programms abhängt.

2.0

a

mathematische Variable

2.0

a

Variable in einem prozeduralen Programm

Abbildung 1.1: Variablen mit ein- und zweistufiger Wertzuordnung

Dies wird meist mit dem “Behälterkonzept” der Variablen erläutert (siehe Abbildung 1.1).

• In der Mathematik sind Variablen Namen für Werte.

• In (prozeduralen) Programmen sind Variablen die Namen von Behältern (Speicherplätzen) die mit Werten

belegt sind.

Damit wird die Beziehung von Namen zu Werten zweistufig. Ein Name bezeichnet einen Speicherplatz und dieser

ist mit einem Wert belegt (siehe Abbildung 1.2). Die Beziehung von Namen zu Speicherplätzen ist relativ fest. Die

von Speicherplätzen zu Werten ändern sich häufig und schnell.

2.0

a

Name

Wert

mathematische Variable

2.0

a

Name

Behälter

Wert

Variable in einem prozeduralen Programm

Abbildung 1.2: Ein– und zweistufige Zuordnung von Werten

6

Nichtprozedurale Programmierung

Deklarationen ändern die Bedeutung von Namen. Anweisungen ändern die Belegung von Speicherplätzen. Die

aktuelle Belegung der Speicherplätze nennt man oft (Programm–) Zustand. Anweisungen transformieren damit

den Zustand und ein Programm ist eine Beschreibung von möglichen Zustandsänderungen (siehe Abbildung 1.3).

a −> 1

b −> 3

if (a>0)a=a+b; b=a/2;

a −> 4

b −> 2

prozedurales Programm

Zustand

Zustand

Abbildung 1.3: Das Grundkonzept eines prozeduralen Programms

Prozeduren

Komplexe Zustandsänderungen, also komplexe Programme, werden als Sequenzen elementarer Zustandsänderungen, den Anweisungen, aufgebaut. Dabei können beliebige Teilsequenzen zu Prozeduren zusammengefasst werden, die dann selbst wieder als Bestandteile komplexerer Prozeduren dienen können. Dieses Prinzip der prozeduralen Abstraktion bildet die Basis aller klassischen prozeduralen Sprachen. Ein Programm beschreibt das Verhalten

einer Maschine als Übergang von einem Ausgangs– zu einem Endzustand. Ein Programm gliedert sich dabei in

Unterprogramme (Prozeduren), Unter–Unterprogramme und so weiter. Das Gesamtprogramm kann man dann als

hypothetische Maschine verstehen, deren Ausgangszustand sich abhängig von der Eingabe in einen Endzustand

transformiert (siehe Abbildung 1.4). Das Gesamtprogramm entspricht einer hypothetischen Maschine, deren Verhalten von der realen Maschine auf Basis ihrer Beschreibung – des Programms – simuliert wird.

a −> 0

b −> 0

cin >> a >> b;

if (a>0)a=a+b; b=a/2;

cout >> b;

Programm im Ausgangszustand

Programmlauf mit Eingabe 1 und 3

a −> 4

b −> 2

cin >> a >> b;

if (a>0)a=a+b; b=a/2;

cout >> b;

Programm im Endzustand

Abbildung 1.4: Prozedurale Programme als hypothetische Maschinen

Ein prozedurales Programm definiert ein Objekt

Das Gesamtprogramm definiert damit ein Objekt: Etwas mit einem Zustand und einem Verhalten. Der Zustand

ist die aktuelle Variablenbelegung. Das Verhalten ist die Veränderung des Zustands bei Eingabe eines Wertes.

Das Objekt “Gesamtprogramm” ist in der klassischen prozeduralen Programmierung aus Prozeduren aufgebaut.

Prozeduren sind als “Verhaltensmuster” zu verstehen.

Die prozedurale Programmierung hat den großen Vorteil, sehr nahe an der realen Maschine zu sein. Jeder Rechner

ist ein physikalisches Objekt, das sich bei Programmstart in einem bestimmten Zustand befindet, der sich im Laufe

der “Rechenarbeit” verändert. Das Konzept einer Maschine, die sich in wechselnden Zuständen befindet, ist sehr

intuitiv. Der Mensch bewegt sich seit Jahrtausenden in einem Umfeld von Objekten mit Zustand und Verhalten.

Th Letschert, FH Giessen–Friedberg

7

Objektorientierte Programme: Objekte mit Unterobjekten

In der klassischen Programmierung ist nur das Gesamtprogramm eine Maschinenbeschreibung, also ein Objekt.

Seine Komponenten, die Prozeduren, sind dagegen Verhaltensbeschreibungen. In der objektorientierten Programmierung wird die Intuition der Maschine noch weiter getrieben. Nicht nur das Gesamtprogramm ist jetzt eine

Maschine, auch die Teile sind Maschinen. Das Programm ist ein Objekt: eine “Maschine” mit einem bestimmten

Verhalten – die sich selbst wieder aus Objekten, den “Untermaschinen” zusammensetzt. Die Objektorientierung

ist damit der ultimative Höhepunkt der prozeduralen Programmierung: Programme sind Objekte, Dinge mit einem

Zustand und einem Verhalten das sich beim Einfluss äußerer Einwirkungen als Änderung dieses Verhaltens zeigt.

Das Programm und all seine Objekte können selbst wieder aus Objekten zusammengesetzt sein.

1.1.2

Deklarative Programmierung

Funktionale Programmierung

Die prozedurale Programmierung hat das Konzept der Maschine verwendet und, in sukzessiver Ablösung und Entfernung von der realen Grundlage der Hardware, weiterentwickelt zum Paradigma eines Programms und seiner

Komponenten als hypothetischen Maschinen (Objekten). Die Entwicklung der nicht–prozeduralen Sprachen hat

dagegen gleich in den luftigen Höhen der Abstraktion mit der Überzeugung begonnen, dass eine höhere Programmiersprache vollständig frei sein sollte von allen Bezügen zu einem realen Rechner und seinem Maschinencode.

Es war naheliegend die gesuchte universelle “maschinen–ferne” Notation bei den reichhaltigen und teilweise jahrhundertelang erprobten Ausdrucksmöglichkeiten der Mathematik zu suchen. Als erstes wurden arithmetische Formeln wie etwa 2 + a ∗ (b − c) als elegante, übersichtliche und bewährte Art entdeckt, Rechenvorschriften zu

formulieren. Das Problem, derartige Formeln in elementare Maschinenbefehle zu übersetzen, war bereits Anfang

der 50–er gelöst und bald erschienen die ersten höheren Programmiersprachen, in denen arithmetische Ausdrücke

in Zuweisungen verwendet werden konnten. Sprachen deren Programme also den direkten Bezug zum Maschinencode verloren hatten und nur nach einer komplexeren Übersetzung oder durch einen Interpreter ausführbar waren.

Prominentester Vertreter dieser Sprachen ist FORTRAN mit den ersten Implementierungen ab Mitte der 50–er.

Arithmetische Ausdrücke lassen sich nahtlos in prozedurale Programme einbetten. Sie wurden darum anstandslos akzeptiert. Funktionen als primäres Ausdrucksmittel einer Programmiersprache taten sich etwas schwerer.

Das praktisch gleichzeitig mit FORTRAN konzipierte LISP hatte Funktionen und Ausdrücke als einzige Ausdrucksmittel und Paare (Binärbäume) als einzige Datenstruktur.3 Es ist erstaunlich, dass dieses minimalistische

Sprachkonzept ausreicht, komplexeste Programme zu schreiben. Weniger erstaunlich ist, dass sich nicht jeder für

diesen Minimalismus begeistern kann. Die Abwesenheit von Schleifen beispielsweise erzwingt den Einsatz von

Rekursion als Ersatz in einem Ausmaß, das die Produktivität nicht jedes Programmierers steigert.

Ein Beispiel für ein funktionales Programm in Lisp ist:

(define (quadrat x) (* x x))

-- Def. Funktion quadrat

(define (quadratsumme x y) (+ (quadrat x) (quadrat y))) -- Def. Funktion quadratsumme

(quadratsumme 3 4)

-- Funktionsaufruf

Dieses Programm liefert den Wert 25 (25 = 3 ∗ 3 + 4 ∗ 4 = quadrat(3) + quadrat(4) = quadratsumme(3, 4))

Zuerst wird die Funktion quadrat mit Parameter x und quadratsumme mit den Parametern x und y definiert,

dann wird die zweite Funktion auf 3 und 4 angewandt. Lisp verwendet eine irritierende Fülle an Klammern und

eine nicht wesentlich weniger irritierende Prefix–Notation bei Operatoren und Funktionsaufrufen. So hätte man

statt

(+ (quadrat x) (quadrat y))

(Prefix–Notation)

in anderen Sprachen sicher

quadrat(x) + quadrat(y)

(übliche Aufruf– und Infix–Notation)

geschrieben. Diese Extravaganzen sind nicht essentiell für das funktionale Programmieren. Sie haben vielmehr mit

3

LISP war allerdings die erste Sprache die überhaupt eine Datenstruktur zu bieten hat.

8

Nichtprozedurale Programmierung

der Philosophie von Lisp zu tun, alle Daten, auch die Programme selbst, als Listen darstellen zu wollen, sowie der

Priorität der Einfachheit der Analyse gegenüber der Lesbarkeit.

Sieht man von Dogmatikern der Objektorientierung ab, dann ist das Konzept der (freien) Funktionen allgemein

bekannt und wird oft eingesetzt. Funktionale Sprachen werden darum allgemein nicht als etwas angesehen, das

neue Ausdrucksmöglichkeiten bietet, sondern als Beschränkung, als etwas Mangelhaftes, dem es an bekannten und

guten Ausdrucksmitteln fehlt. Variablen sind wie in der Mathematik Bezeichner für Werte und nicht wie üblich

“Behälter” für Werte. Als Konsequenz gibt es keine Zuweisung. Der Begriff eines sich ändernden Zustands des

Gesamtprogramms oder seiner Teil–Objekte ist den mathematisch orientierten funktionalen Sprachen fremd. Das

schlägt sich nieder als Fehlen von Anweisungssequenzen, speziell als Fehlen von Schleifen. Man kann versuchen

diesen Mangel als Vorteil zu verkaufen. Das Fehlen des Zustandskonzepts macht die Analyse von Programmen

einfacher und erhöht so die Chance korrekte Programme zu schreiben. Wirklich überzeugend ist dieses Argument

aber nicht.

Relationale Programmierung: Programmieren mit Prädikation und Relationen

Die Definition und Verwendung von Funktionen als Mittel zur Formulierung von Algorithmen ist intuitiv einsichtig, wenn auch etwas gewöhnungsbedürftig. Vor allem, wenn sie das einzige Ausdrucksmittel ist und dazu noch,

wie in Lisp, alles konsequent vollständig geklammert und in Prefix–Notation zu verfassen ist. Bei der logischen

Programmierung wird die Sache etwas exotischer. Statt Funktionen werden Ausdrücke der Prädikatenlogik aus

der Mathematik übernommen und als algorithmische Notation verwendet. Nehmen wir als Beispiel den Satz des

Pythagoras:

a2 + b2 = c2

hier wird eine Beziehung (Relation) zwischen a, b und c definiert. Diese Beziehung kann als Prädikat pythagoras

aufgefasst werden:

pythagoras(a, b, c) gdw. a2 + b2 = c2

So, wie eine Funktion in einer funktionalen Sprache (aber nicht nur dort) benutzt werden kann, um einen Wert zu

berechnen, z.B. den Wert in Lisp:

(quadratsumme 3 4) -> 25

so kann ein Prädikat dazu benutzt werden, um den Wahrheitsgehalt einer Aussage zu testen, z.B. in einer logischen

Sprache wie PROLOG (PROgramming in LOGic):

phytagoras(3,4,5) -> true

Das Prädikat wird hierbei wie eine Funktion mit Booleschem Ergebnis verwendet. Der Aufruf wird etwas interessanter, wenn eines der Argumente eine Variable ist. Das System sucht dann eine Belegung der Variablen, für die

die Aussage wahr wird. Z.B:

phytagoras(3,4,c) -> c = 5

aber auch:

phytagoras(3,b,5) -> b = 4

und sogar

phytagoras(a,b,5) -> a = 3, b = 4

Bei logischen Programmen sucht das System also nicht, wie bei einer Funktion, ausgehend von den Argumenten “vorwärts” nach dem Wert, sondern versucht “rückwärts” vom Ergebnis Variablenbelegungen zu finden, für

die die Aussage wahr ist. Die logische Programmierung ist somit in gewisser Weise eine Verallgemeinerung der

funktionalen Programmierung.

Bei der funktionalen und der logischen Programmierung werden Algorithmen nicht direkt angegeben. Man deklariert statt dessen gewisse Sachverhalte, eine Funktion oder ein Prädikat. Logische und funktionale Sprachen

nennt man darum auch deklarative Sprachen. Sie gelten oft als “höherwertig”, weil in ihnen nicht das Wie einer

Berechnung, sondern das Was angegeben wird.4 Im Gegensatz dazu werden bei der prozeduralen Programmierung

4

Die Grenzen zwischen Was und Wie sind letztlich natürlich fließend.

Th Letschert, FH Giessen–Friedberg

9

Algorithmen in Form zustandverändernder Anweisungen angegeben. Prozedurale Sprachen heißen darum auch

imperativ (= befehlend).

Programmiersprachen

prozedurale Sprachen

(imperative Sprachen)

nichtprozedurale Sprachen

(deklarative Sprachen)

. . . andere deklarative Stile . . .

klassisch prozedural

objektorientiert

funktional

logisch

z.B. C

z.B. C++

z.B. Lisp

z.B. Prolog

Abbildung 1.5: Klassifikation der Programmiersprachen

SQL: Programme beschreiben Relationen

Eine deklarative Programmiersprache, die in der Bedeutung sowohl Lisp als auch Prolog bei weitem übertrifft ist

SQL. In SQL werden Relationen durch Selektion (WHERE), Projektion (SELECT), Vereinigung (JOIN) aus anderen Relationen gebildet. Die Konstruktion von Relationen (Tabellen) wird dabei nicht algorithmisch in Schleifen

und Zuweisungen ausprogrammiert, sondern in Form von SQL–“Anweisungen” deklariert. Mit einem Ausdruck

wie etwa

SELECT StudentId, Note

FROM KlausurErgebnisse

WHERE Kurs="NPP"

wird eine Relation auf eine andere abgebildet. Man deklariert das gewünschte Ergebnis ohne die zu dessen Berechnung notwendige Schleife über komplexen Datenstrukturen explizit (prozedural) anzugeben. Das Konzept der

relationalen Datenbanken und SQL sind sicherlich bekannt. Wir gehen darum nicht weiter darauf ein.

SQL basiert auf der Theorie relationaler Datenbanken. Beides, SQL und die relationalen Datenbanken, sind innerhalb der Informatik mit die wichtigsten Belege dafür, dass nichts so praktisch ist wie eine gute Theorie. Im

praktischen und alltäglichen Umgang mit Datenbank–Tabellen vergisst man es leicht, aber relationale Datenbanken

basieren auf dem klaren, mathematisch orientierten Konzept der Relationen–Algebra, das vor der Implementierung

und dem praktischen Einsatz entwickelt wurde.5

XSLT: Programme definieren Baum-Muster und ihre Transformationen

Neben Lisp, Prolog und SQL wurden und werden weiterhin eine Vielzahl deklarativer Sprachen definiert. In letzter

Zeit machen speziell XML–Technologien von sich reden. Ein XML–Dokument wie etwa folgendes

<?xml version="1.0" encoding="UTF-8"?>

<gedicht>

<autor>

<name>

Busch

</name>

<vorname> Wilhelm </vorname>

</autor>

<titel> Langeweile </titel>

<strophe>

<zeile> Guten Tag Frau Eule!

</zeile>

<zeile> Habt Ihr Langeweile? - </zeile>

5 Eine Vorgehensweise, die trotz (wegen ?) der inflationären Vermehrung wissenschaftlich ausgebildeter Informatiker leider vollkommen

aus der Mode gekommen ist.

10

Nichtprozedurale Programmierung

<zeile> Ja eben jetzt,

<zeile> solang Ihr schwaetzt.

</strophe>

</gedicht>

</zeile>

</zeile>

stellt einen Baum dar (siehe Abbildung 1.6).

Gedicht

autor

titel

Name

vorname

Text

Text

Text

strophe

zeile

zeile

zeile

zeile

Text

Text

Text

Text

Abbildung 1.6: XML Dokument als Baum

Im Fall von SQL haben wir es mit Ausdrücken zu tun, die Relationen verarbeiten und zu neuen Relationen verknüpfen. XML–Dokumente sind hierarchisch strukturierte Informationen – kurz Bäume.6 Die Verarbeitung von

Bäumen, Baumtransformationen also, kann man ebenso wie die von Relationen deklarativ beschreiben. Ein Programm in der deklarativen Sprache XSLT, das eine XHTML–Version des Gedichts von oben erzeugt ist:

<?xml version="1.0" encoding="UTF-8"?>

<xsl:stylesheet

version="1.0"

xmlns:xsl="http://www.w3.org/1999/XSL/Transform">

<xsl::output method="html">

<xsl:template match="/">

<html>

<head><title>Gedicht</title></head>

<body>

<xsl:apply-templates select="gedicht"/>

</body>

</html>

</xsl:template>

<xsl:template match="gedicht">

<p>

<h1><xsl:apply-templates select="titel"/></h1>

<xsl:apply-templates select="strophe"/>

</p>

</xsl:template>

.... etc ....

<xsl:template match="zeile">

<li><xsl:value-of select="."/></li>

</xsl:template>

</xsl:stylesheet

6 In der irrealen Welt außerhalb der Informatik versteht man unter “Baum” nicht etwa hierarchisch strukturierte Information, sondern ein

unklar definiertes Konzept der Botanik: eine Unterklasse der Klasse Flora, deren Exemplare aus unerfindlichen Gründen stets auf dem Kopf

stehen. Dies ist für uns Informatiker jedoch ohne jede Bedeutung und ohne jeden Bezug zu richtigen Bäumen.

Th Letschert, FH Giessen–Friedberg

11

Ohne zu sehr ins Detail gehen zu wollen, sehen wir hier eine Folge von Baum-Mustern. Das letzte Muster ist

<xsl:template match="zeile">

<li><xsl:value-of select="."/></li>

</xsl:template>

Es passt zu allen Zeilen–Knoten und definiert eine Aktion auf diesen Knoten, hier die Ausgabe von

<li>Inhalt des Zeilen–Knotens</li>

Das XSLT–Programm insgesamt beschreibt ein Durchwandern des XML–Baums mit einer Aktivierung dieser

Muster. Es ist an dieser Stelle nicht notwendig diesen Mechanismus im Detail zu verstehen. Man sieht aber, dass

ein XSLT–Programm eine komplexe Datenstruktur durchwandert. Dies wird nicht mit prozeduralen Elementen,

Schleifen, Variablen, Zeigern, etc. programmiert, sondern durch einem System von Baummustern mit zugehörigen

Aktionen. Für jeden Teilbaum, auf den ein angegebenes Muster passt, wird die entsprechende Aktion aktiviert.

Fassen wir zusammen. In Programmen in deklarativem Stil wird das gewünschte Ziel definiert, ohne anzugeben,

wie das Ziel zu erreichen ist. Das kann sehr unterschiedliche Formen annehmen und in ganz unterschiedlichen

Anwendungsbereichen auftreten. Einige Beispiele wurden hier genannt. Darunter waren solche wie Prolog die

nur völlig vergeistigte Informatiker anlocken und solche für Anwender, die Programmen normalerweise nur im

Schutzanzug und mit Schweißerbrille gegenüber treten. Man nennt deklarative Programmierstile auch nichtprozedural. Allen nichtprozeduralen Sprachen ist gemeinsam, dass sie von der Anwendung her kommen und prozedurale Konzepte wie Variablen als Namen von Speicherplätzen oder Anweisungen gar nicht, oder nur widerwillig

unterstützen.

1.1.3

Typen

Typen von Werten, Ausdrücken und Variablen

Typen sind Kategorien von Dingen. Jede ganze Zahl gehört zur Kategorie der ganzen Zahlen und hat folglich den

Typ ganze Zahl. Ein Typ ist zunächst einmal etwas, das einem Wert zukommt. Ein Wert, die Zahl eins beispielsweise, hat einen Typ. Typen geben Operationen einen Sinn. So ist die Operation + in x+y davon abhänig, ob x und

y Zeichenketten, Listen, oder Integerwerte bezeichnen. Viele Operationen sind nicht möglich, weil die Typen der

Operanden nicht passen, man braucht die Werte gar nicht anzusehen, schon ihr Typ sagt, dass die Operation nicht

gelingen kann. Allen Varianten von Programmiersprachen kennen diese Art von Typen als Attribute von Werten.

Typ des Ausdrucks

Typ der Variable

Typ des Wertes

2.0

a

Ausdruck (hier Name)

Behälter

Wert

Abbildung 1.7: Typkonzepte

Sehr oft hat man dieses rein semantischen Konzept von Typ erweitert und auf die syntaktische Ebene der Programmkonstrukte übertragen: Ausdrücke wie “1” oder “2*f(12,4)+3” wird dort ebenfalls ein Typ zugewiesen.

Das ist eine abgeleitete Konstruktion, die aber in vielen Programmiersprachen – vor allem in prozeduralen aber

auch in manchen nicht–prozeduralen – definiert ist und die der Korrektheit und der Effizienz der Programme dient:

• Korrektheit Stellt sich bei der Analyse des Programms durch einen Compiler heraus, dass einem Ausdruck

kein Typ zugewiesen werden kann, dann gilt das Programm als falsch: Der Fehler wurde frühzeitig entdeckt.

• Effizienz Ist der Typ jeden Ausdrucks bekannt, dann können viele Verarbeitungsprozesse schon zur Übersetzungszeit stattfinden. Ist beispielseise schon von x und y und damit von x+y als Ausdruck der Typ Integer

12

Nichtprozedurale Programmierung

bekannt, dann muss nicht zur Laufzeit, jedes Mal wenn x+y ausgeführt wird, aufwändig analysiert werden,

welche Art von Addition auszuführen ist.

Beides hat seinen Preis. Der Compiler geht auf Nummer sicher und lehnt alles ab, was nicht garantiert korrekt

ist – unabhängig davon, ob zur Laufzeit ein entsprechender Typfehler tatsächlich auftreten würde oder nicht. Die

Programmiererin hat dafür zu sorgen, dass alle Ausdrücke die richtigen Typen haben und muss dazu oft intellektuell

anspruchsvolle Typsysteme für die Programme erfinden.

Wir wollen hier nicht in die komplexe Welt der Typen einsteigen, aber zumindest klar unterscheiden, was da einen

Typ hat:

• Typ eines Werts: natürliches Konzept.

• Typ eines Ausdrucks: (allgemeinster) Typ aller Werte, die der Ausdruck jemals im Laufe des Programms

haben kann.

• Typ einer Variablen: (allgemeinster) Typ aller Werte, die jemals im Laufe des Programms die Variable belegen können.

In der exakten Beschreibung einer Programmiersprache wird meist nur Ausdrücken ein Typ zugewiesen. Bezeichnern (Namen), als elementaren Ausdrücken, wird in prozeduralen Sprachen in der Regel ein fester Typ zuordnet.

Aus den Typen der Bezeichner wird dann der Typ der komplexeren Ausdrücke abgeleitet. Hinter dem formalen

Typ von Bezeichnern steckt die Intuition, dass Variablen einen Typ haben: den Typ der Werte die sie aufnehmen

können oder dürfen.

In nicht–prozeduralen Sprachen wird meist auf den “abgeleiteten” Begriff von Typ verzichtet. Werte haben auch

dort einen Typ, Ausdrücke, inklusive Bezeichner (Namen), dagegen nicht.

1.1.4

Compilierte und Interpretierte Sprachen

Compilierte und Interpretierte Sprachen

Programme in klassischen Programmiersprachen wie C, C++, Pascal, Java, etc. werden in Dateien abgespeichert,

von einem Compiler intensiv untersucht, in Zwischen– und/oder Maschinencode übersetzt und dieser wird dann

schließlich von einer realen oder virtuellen Maschine ausgeführt. Interpreter führen dagegen dagegen das Quellprogramm direkt aus. Ohne sich lange mit irgendwelchen Analysen des Quellprogramms aufzuhalten, werden dessen

Anweisungen oder Ausdrücke sofort ausgeführt. Sprachen, deren Programme vor der Ausführung typischerweise

von Compilern übersetzt werden, nennt man compilierte Sprachen, die anderen sind die interpretierten Sprachen.

Im Prinzip lassen sich die Programme jeder Programmiersprache in beiden Varianten bearbeiten. Der Charakter

einer Sprache und die Art der Verarbeitung hängen aber so eng zusammen, dass im Regelfall nur entweder die

Übersetzung oder die Interpretation sinnvoll ist.

Klassische Compilierte Sprachen

Die klassische Art, ein Programm auszuführen, ist, es in Maschinencode zu übersetzen und diesen dann von einer

realen Maschine interpretieren zu lassen. Reale Maschinen, richtige Hardware also, die ein Programm einer höheren Programmiersprache direkt ausführen können, mögen theoretisch denkbar sein, technologische und ökonomische Gründe sprechen aber dagegen, dies wirklich zu versuchen. Die Programme müssen also übersetzt werden.

Dabei versucht man in jedem Fall so viel Arbeit wie nur irgend möglich von der Ausführungszeit in Übersetzungszeit zu verlagern. Compilierte Sprachen sind auch stets so konzipiert, dass tatsächlich viel zur Übersetzungszeit

passieren kann. Dieses Ziel beeinflusst den Charakter einer Sprache ganz wesentlich. Bei einer Zuweisung wie

x = y

die möglicherweise sehr oft ausgeführt wird, muss beispielsweise jedesmal festgestellt werden, wie viele Bytes

ab wecher Adresse zu welcher Adresse zu bewegen sind und dann müssen sie bewegt werden. Das tatsächliche

Bewegen der Bytes kann nur bei jeder Ausführung der Anweisung erfolgen. Bei einer compilierten Sprache wird

Th Letschert, FH Giessen–Friedberg

13

Quellcode

Compiler: Analyse,

Optimierung,

Transformation

reale Maschine (CPU)

(Interpreter des

Cods): Ausfuehren

Maschinen−Code

Abbildung 1.8: Compilierte Sprache der klassischen Art

aber bestrebt sein, dass die Quell– und Zieladressen und die Anzahl der Bytes schon bei der Übersetzung festliegen. Derartige statischen Berechnungen7 sind aber möglich, wenn die Sprache in ihren Ausdruckmöglichkeiten

eingeschränkt wird.

Bei einer interpretierten Sprache nutzt es nichts oder nur wenig, wenn bei jeder Ausführung einer bestimmten

Zuweisung immer die gleiche Zahl von Bytes von der gleichen Quell– zur gleichen Zieladresse bewegt werden.

Interpretierte Sprachen haben es dagegen nicht nötig, den Charakter ihrer Programme so zu beschränken, dass viel

Arbeit zur Übersetzungszeit getan werden kann – es gibt ja keine Übersetzungszeit.

Die Entscheidung zwischen Flexiblität auf der einen und Effizienz und Sicherheit auf der anderen Seite ist immer

eine Gradwanderung. Klassische compilierte Sprachen bieten ihren Programmierern die Möglichkeit mit Konversionen, Zeigern, Polymorphismus und Ähnlichen aus ihrem engen Gehäuse auszubrechen.

Quellcode

Compiler: Analyse,

Optimierung,

Transformation

Daten

Zwischen−Code

reale Maschine (CPU)

(Interpreter des

Cods): Ausfuehren

virtuelle Maschine /

Common Language Runtime (CLR)

Anweisungen

Madchinen−Code

Abbildung 1.9: Compilierte Sprache der modernen Art

7

Als statisch bezeichnen die Compilerleute alles, was vor der Laufzeit des Programm festliegt, bzw. festgestellt (berechnet) werden kann.

14

Nichtprozedurale Programmierung

Compilierte Sprachen der modernen Art

Heute gibt es mit Java und C# compilierte Sprachen, die interpretiert werden. Von ihrem Grundcharakter her

sind beide immer noch compilierte Sprachen. Der Compiler versucht viel an Prüfung und Vorausberechnung zu

übernehmen und die Sprachen sind so konzipiert, dass dies auch möglich ist. Der erzeugte Zwischencode ist ein

abstrakter Maschinencode, der eine Unabhängigkeit von der realen Hardware und der Betriebsumgebung liefern

soll und der dadurch auch relativ leicht “im Fluge” (oder just in time) in echten Maschinencode umgewandelt

werden kann.

Compiler und Typen

Das Typsystem des Programms spielt eine wichtige Rolle beim Zurechtstutzen einer Sprache auf Compilationstauglichkeit. Allen Variablen, formalen Parameter und Funktionsergebnissen müssen eindeutige Typen zugewiesen

werden. Die Typen sind nicht nur eine enorme Hilfe bei der Konzeption der Programme im Kopf der Programmierer, sie ermöglichen es dem Compiler auch, eine Vielzahl von Programmierfehlern zu entdecken und für die

Konstrukte effiziente Übersetzungen in Maschinen– (oder Zwischen–) Code zu finden.

Die Typen der Ausdrücke sind dabei letztlich nichts anderes, als die – zur Übersetzungszeit verfügbaren – kondensierten Informationen über die – zur Laufzeit – möglichen Werte der Ausdrücke. Diese Informationen können

zu Prüf– und Optimierungzwecken eingesetzt werden. In ernsthaften Programmen sind die Typen ihrer Konstrukte

aber keineswegs trivial, im Gegenteil, die Kunst des Programmierens in einer compilierten Sprache besteht ganz

wesentlich darin, ein geeignetes Typsystem zu erfinden, in dessen Rahmen jedem Ausdruck ein eindeutiger Typ

zukommt.

Das Einzwängen in ein Typsystem bringt immer eine Beschränkung der Ausdrucksmöglichkeiten mit sich. Je

flexibler und fostgeschrittener das System ist, um so geringer sind diese Beschränkungen. Man kann dann so etwas

wie

...

x = new Viereck;

x = new Dreieck;

sagen, erkauft sich das aber damit, dass man einen Typ GeometrischesObjekt für x erfinden und eine Programmiersprache beherrschen muss, in der dies möglich ist.

1. x = new Viereck;

2. x = new Dreieck;

1

0. GeoObjekt = ????

1. GeoObjekt x;

X

2

2. x = new Viereck;

3. x = new Dreieck;

X

2

1

GeoObjekt

3

Abbildung 1.10: Nicht-typisierte und typisierte Programmierung

Interpretierte Sprachen

Compilierte Programmiersprachen spielen eine dominierende Rolle in der Ausbildung – und das zu Recht. Die

hohe Kunst der Informatiker, die Konstruktion großer und effizienter Programmsysteme, braucht Sprachen mit

deren Eigenschaften.

Nun sind aber nicht alle nützlichen Programme groß. Effizienz ist auch nicht immer ein Thema und Nicht–

Informatiker sind oft von den Typ–Konzepten moderner Hochsprachen überfordert. Für diese Anwendungsfälle

und Anwender gibt es eine Vielzahl an alternativen Sprach–Konzepten. Diese kleinen, leichten Sprachen für ad–

hoc Anwendungen und ad–hoc Programmierer werden meist von einem Interpretierer verarbeitet. Das hat zwei

wichtige Gründe: das Verhältnis von Aufwand und Ertrag bei der Übersetzung und die Natur der kleinen Sprachen.

Th Letschert, FH Giessen–Friedberg

15

Zunächst einmal will man einen kleinen Auftrag eingeben und sofort seine Ausführung sehen, statt mühsam einen

Compiler zu aktivieren und dann das erzeugte Programm zu starten. Selbst wenn die sofortige Ausführung – die

Interpretation – durch einen Interpretierer um den Faktor 1000 langsamer sein sollte, als die Ausführung von äquivivalentem Maschinencode, bei winzigen Programmen lohnt sich der Aufwand der Übersetzung trotzdem nicht.

In weitverbreiteten und unter Nicht–Informatikern oft und gerne benutzten Systemen, wie etwa MATLAB, gibt

man einen mathematischen Ausdruck ein und das System berechnet ihn sofort, bzw. erzeugt sofort eine graphische

Darstellung. Der Gedanke, diesen Ausdruck in ein zu übersetzendes Programm einbetten zu müssen, ist für die Anwender solcher Systeme völlig absurd. Unter Informatikern bekanntere Skript–Sprachen wie Perl, TCL, Python,

AWK, etc. liegen auf der gleichen Linie. Die Shell eines Unix–artigen Systems ist ebenfalls eine Programmiersprache, die eingegebene Kommandos sofort verarbeitet.

Die Verarbeitung der genannten Sprachen durch einen Interpreter hat nicht nur ergonomische Gründe. Die Sprachen selbst machen die Verarbeitung durch einen Compiler schwierig bis sinnlos.8 Klassischen Programmiersprachen liegt das “Behälter–Konzept” von Variablen zugrunde. Behälter haben einen Typ. Das schränkt die Varianz

der in ihnen speicherbaren Werte ein. Der Compiler kann die Typinformationen zur Übersetzungszeit verwenden,

um korrekten und effizienten Code zu erzeugen. Informatikern mag das Behälterkonzept in Fleisch und Blut übergegangen sein, für “normale Menschen” ist aber eine Variable ein Name für einen Wert. Der Typ eines Behälters

macht Sinn, nicht aber der Typ eines Namens für Werte. Wenn Variablen aber Namen für Werte sind, dann ist es

unsinnig zu verlangen, dass es beim Wechsel der Bedeutung einer Variablen eine Typbeschränkung geben sollte.

Warum soll nicht etwa a einen Integer–Wert bezeichnen, dann eine dreidimensionale Matrix und schließlich eine

Funktion.

Prozedural und Compiliert, Deklarativ und Interpretiert

Funktionale und andere deklarative Sprachen sind typischerweise interpretierte Sprachen. Die strenge Typisierung ist ein Konzept das ursprünglich von der Maschine kam, vom Ziel einen Compiler schreiben zu können,

der effizienten Code erzeugt. Deklarative Sprachen kommen dagegen von der Anwendungsseite. Ihnen liegt das

mathematische Konzept einer Variablen zugrunde. Variablen sind Namen für Werte. Eine Variable kann dann

konsequenterweise jeden beliebigen Wert bezeichnen, Typbeschränkungen gibt es nicht. Die Übersetzung wird

unter diesen Bedingungen schwierig und sie bringt auch nicht so viel an Effizienzgewinn. Die Werte selbst haben

natürlich weiterhin Typen, aber wenn Variablen kein Typ zugeordnet wird, dann kann zur Übersetzungszeit nicht

mehr vorausgesehen werden, welchen Typ der Wert einer Variablen zur Laufzeit haben wird – die entsprechende

Information muss dynamisch verwaltet werden.

Kurz und gut, dekarative Sprachen sind meist nicht typisiert, d.h. ihre Ausdrücke haben keine fixen im Voraus

bestimmbaren Typen und sie werden meist interpretiert. Beides ist aber kein unbedingtes Muss. Deklarative Sprachen können und sind gelegentlich streng typisiert und compiliert und Typen kommen zwar von den Compiler–

Techniken in die Programmiersprachen, Typen sind aber weit mehr als nur Hilfsmittel für Compiler.

8

Aber nicht unmöglich: alles was interpretiert werden kann, kann auch übersetzt werden.

16

Nichtprozedurale Programmierung

1.2

Ausdrücke und ihre Auswertung

Abstrahieren heißt die Luft melken.

F. Hebbel

1.2.1

Definitionen und Ausdrücke

Ausdrücke

Ein funktionales Programm ist im einfachsten Fall ein Ausdruck. Die Ausführung des Programms besteht schlichtweg darin, dass dieser Ausdruck ausgewertet wird. So ist beispielsweise

2+3∗4

ein triviales funktionales Programm das zu 14 ausgewertet wird. Wenn auch nicht jede funktionale Sprache interpretiert wird und nicht jede interpretierte Sprache funktional ist, so ist es doch ein typisches Charakteristikum

funktionaler Sprachen, dass sie einen Interpretierer zur Verfügung stellen. Dieser erlaubt es, solche Ausdrücke

interaktiv auszuführen. Ihre Programme werden entweder interaktiv eingegeben oder in einer Datei gespeichert. In

ein Datei gespeichert, nennt man sie gelegentlich “Skripte” und die entsprechenden Sprachen “Skript–Sprachen”.

Manche Sprachen bestehen auf einer besonderen Notation für ihre Ausdrücke. Lisp beispielsweise will alle Ausdrücke vollständig geklammert und in Präfix-Notation sehen. Statt 2 + 3 ∗ 4 übergibt man also dem Interpreter

>>> (+ 2 (* 3 4))

zur Auswertung ein und erhält die Antwort

14

Die vollständig geklammerte Präfix–Notation in Lisp hat ihre besonderen Gründe, die aus ganz speziellen Eigenschaften und der Historie dieser Sprache folgen und nicht auf einem allgemeinen Prinzip funktionaler Sprachen beruhen. Python ist eine prozedurale Skript-Sprache mit den wesentlichen Möglichkeiten einer funktionalen

Sprache, ohne auf das “Funktionale” beschränkt zu sein. Sie erlaubt Ausdrücke in normaler Infix–Notation mit

Präzedenz–Regeln:

> python

Python 2.2.2 ...

>>> 2+3*4

14

>>>

Definitionen

Ausdrücke allein sind etwas langweilig als Programme. Sie werden etwas interessanter, wenn ihnen Definitionen

vorausgehen. Beispielsweise werden in folgendem Pythoncodestück zwei Namen definiert x und f, die dann im

darauf folgenden Ausdruck verwendet werden:

def f(n):

if n==0:

return 1

else:

return n*f(n-1)

x=5

f(x)+f(x-1)

Th Letschert, FH Giessen–Friedberg

17

Freie und gebundene Variablen

Definitionen sind dazu da, um freien Variablen eine Bedeutung zu geben. In

f(x)+f(2*x)

sind sowohl x als auch f frei. Nur mit diesem Ausdruck allein haben sie keinen Wert und damit ist der ganze

Ausdruck undefiniert. Klar, wir müssen die Definitionen hinzunehmen, um dem Ausdruck insgesamt einen Wert

zuweisen zu können.

Frei oder gebunden sind relative Begriffe. In f(x)+f(x-1) sind die Variabelen f und x. Im gesamten Programm

dagegen nicht. Die Definitionen vorher binden sie an eine Bedeutung. Alle Variablen sind damit gebunden.

Ähnlich verhält es sich in der Funktionsdefinition. In

n==0

ist n frei. In der gesamten Funktionsdefinition ist es an die Bedeutung “Funktionsparameter” gebunden.

Ein– und Zweistufige Wertzuordnung

Definitionen ordnen Namen eine Bedeutung (einen Wert) zu. Beispielsweise wird in folgendem C–Beispiel dem

Namen x ein Speicherplatz als Wert/Bedeutung zugeordnet:

int x;

In einem zweiten Schritt kann dann der Speicherplatz mit einem Wert belegt werden:

x = 5;

Vom Namen zum Wert 5 gelangt man dann in zwei Schritten:

x → Variable/Speicherplatz → 5

Um die beiden “Werte” von x zu unterscheiden spricht man in C und C++ vom l-Wert und vom r–Wert. Der l–Wert

ist der Speicherplatz und der r–Wert die 5. Der l-Wert eines Namens ist relativ stabil, der r–Wert kann dagegen mit

jeder Zuweisung wechseln. Aber Achtung, nicht nur Namen haben l-Werte, auch ein Ausdruck kann einen l-Wert

haben. In

a[x+i] = 5;

hat a[x+i] einen l–Wert der höchst dynamisch sein kann.

In typfreien Sprachen wie Python wird nicht zwischen l– und r–Wert unterschieden. Einem Namen wird eine

einzige Bedeutung zugeordnet.

x = 5

Vom Namen zum Wert gelangt man dann in einem Schritt:

x→5

Umgebung

Die von einer oder mehreren Definitionen erzeugte Abbildung von Namen auf ihre Bedeutung nennt man Umgebung. Die Umgebung enthält die Bedeutung (Definition) der freien Variablen eines Ausdrucks. In

f(x)+f(2*x)

sind f und x frei. Der Ausdruck enthält damit freie Variablen und kann darum nur in einer Umgebung ausgewertet

werden, die x und f definiert. In der von den Definitionen

def f(n):

if n==0:

return 1

else:

return n*f(n-1)

18

Nichtprozedurale Programmierung

x=5

erzeugten Umgebung u mit

u = [f → 5, f → F akultätsf unktuion]

hat f(x)+f(2*x) den Wert 144.

Andere Definitionen erzeugen andere Umgebungen, die zu anderen Werten des gleichen Ausdrucks führen.

Zustand

In Sprachen mit zweistufigem Variablenkonzept gibt es zwei Abbildungen. Die erste ordnet einem Namen einen

Speicherplatz zu, die zweite dem Speicherplatz einen Wert. Die erste wird Umgebung genannt. Die zweite ist der

aktuelle Maschinen–Zustand oder kurz Zustand. In C muss man, um den Wert eines Ausdrucks wie

2*x

zu bestimmen, wissen welche Speicherstelle (l–Wert) mit x gemeint ist – das ist die Umgebung. Kennt man dann

noch die aktuelle Belegung (r–Wert) dieser Speicherstelle – das ist der Zustand – dann lässt sich der Wert berechnen. Also: in einer Umgebung, in der x sich auf die Speicherstelle 0x4711 bezieht und einem aktuellen

Mascheinzustand, in dem 0x4711 den Wert 5 hat, wird 2*x zu 10 ausgewertet.

1.2.2

Statische und Dynamische Bindung

Statische Bindung

In allen relevanten Programmiersprachen können Prozeduren bzw. Funktion definiert werden und in der Regel

dürfen sie freie Variablen (freie Bezeichner) enthalten. In der C–Funktion

inf f(int x) { return x+y; }

ist beispielsweise y frei. Generell stellt sich die Frage, was ein freier Bezeichner zu bedeuten hat, oder an welche

Definition seine Verwendung, jeweils gebunden ist?

In unserem kleinen C–Programm oben, sind in return x+y; sowohl x und y frei – es sind Verwendungsstellen

der Bezeichner x und y. Die Bindungsregeln von C sagen, dass x in return x+y; an die Parameterdefinition

im Kopf der Funktion gebunden wird. Einfach ausgedrück, mit x ist der Parameter gemeint. y hat keine Bindung

innerhalb der Funktionsdefinition. Es ist nicht nur, wie x, im Funktionskörper, sondern in der gesamten Funktionsdefinition frei. Jeder C–Programmierer weiß, und die anderen ahnen, wie zu diesem freien y eine Bindung zu

suchen ist: Es kann nur eine globale Variable sein und man kann sie ausfindig machen, indem man den Programmtext analysiert. Wir brauchen dazu auch gar nicht Bedracht zu ziehen, wo wann oder ob die Funktion f jemals

aktiviert wird.

In C und ähnlichen Sprachen ist die Bindung eines Bezeichners immer klar durch den Programmtext bestimmt.

Ein freier Bezeichner in einer Funktion bezieht sich immer auf das, was an deren Definitionsstelle gültig ist. Im

C–Beispiel oben ist mit y der Speicherplatz gemeint auf den sich y an der Definitionsstelle von f bezieht, egal in

welchem Kontext f aufgerufen wird und welche Definition von y dort zuletzt ausgeführt worden sein mag. Die

“Bindung” von y erfolgt an der Definitionsstelle. Sie ist unveränderlich und kann zur Übersetzungszeit bestimmt

werden: sie ist “statisch”.

C, C++, Java, und viel andere Sprachen definieren eine statische Bindung der freien Bezeichner. Folgendes C++–

Programm gibt darum den Wert 10 (und nicht -7) aus:

#include <iostream>

using namespace std;

Th Letschert, FH Giessen–Friedberg

19

int x = 10;

void f(){

cout<<x<<endl;

}

void g(){

int x = -7;

f();

}

int main() {

g();

}

Statische Bindung ist dadurch charakterisiert, dass die Umgebung jeden Ausdrucks statisch, d.h. zur Übersetzungszeit rein aus Betrachtung des Quellcodes und seiner textuellen (Gültigkeits–) Bereiche, bestimmt werden

kann. Statische Bindung macht Programme “berechenbarer”und einfacher zu verstehen und im Allgemeinen auch

einfacher und effizienter zu übersetzen. Sie wird bei praktisch allen aktuellen Programmiersprachen verwendet.

Dynamische Bindung

Bei dynamischer Bindung bestimmt die aktuelle Situation während des Programmlaufs die Umgebung in der nach

der Bedeutung (Bindung) freier Variablen gesucht wird. Im Beispiel oben ist x in der Funktion f frei. f wird

von g aus aufgerufen. g hat ein lokales x. Es enthält also Umgebung in der x definiert ist. Dieser Umgebung

würde bei dynamischer Bindung der Vorzug vor der globalen Umgebung Umgebung gegeben. Zum Zeitpunkt der

Auswertung von f() ist die Umgebung von g die “aktuellste”, die ein x enthält. Würde C++ mit dynamischer

Bindung arbeiten, dann würde obiges Beispielprogramm also -7 ausgeben.

Fassen wir die Unterschiede der beiden Bindungsarten noch einmal kurz zusammen:

• Statische Bindung: Die Bindungsstelle (Definition) eines Bezeichners kann aus dem Text des Programms

(statisch) bestimmt werden. Typischerweise ist ein Bezeichner an die textuelle nächstgelegene äussere Definition gebunden.

• Dynamische Bindung: Die Bindungsstelle (Definition) eines Bezeichners kann erst zur Laufzeit des Programms (dynamisch) bestimmt werden. Typischerweise ist ein Bezeichner an die zuletzt ausgeführte Definition gebunden.

Bestimmt also der Programmtext, die Prgrammstatik, oder die Programmausführung, die Prgrammdynamik, welche Bindung gültig ist.

Die Bindungsart von Python

Um zu testen, welche Bindungsart Python verwendet, muss obiges Testprogramm nur entsprechend umgesetzt

werden:

x = 10

def f():

print x

def g():

x = -7

f()

g()

Dieses Testprogramm liefert uns mit der Wert 10 die beruhigende Erkenntnis, dass auch Python statische Bindung

verwendet. Das x in f ist immer das globale x, von wo und wann auch immer f auch aktiviert werden mag.

20

Nichtprozedurale Programmierung

Wir dürfen uns nicht davon irritieren lassen, dass jede Modifikation des gloablen x sich auf f auswirkt. Das

Programm

x = 10

def f():

print x

def g():

x = -7

f()

x=0

g()

würde selbstverständlich 0 ausgeben – aber im C++–Beispiel gilt das genauso.

In Python definiert also jede Funktion ihren eigenen Gültigkeitsbereich und erzeugt somit ihre eigene Umgebung.

Ein Name kann darum in mehreren unterschiedlichen Umgebungen definiert sein. Freie Variablen werden in der

Umgebung gesucht (= gebunden), die ihrer Verwendungstelle statisch (textuell) am nächsten ist.

Lokal und Global in Python

In C++ werden Definitionen und Zuweisungen unterschieden. Wenn in einer Funktion ein globales x mit einem

Wert belegen werden soll, dann schreibt man

...

void f(){

x = 5;

...

}

...

Soll dagegen ein lokales x erzeugt und belegt werden, dann schreibt man

void f(){

int x = 5;

...

}

In Python gibt es den Unterschied zwischen Definition und Zuweisung nicht. Jede erste Zuweisung in einem

Gültikeitsbereich wird als Definition interpretiert.

x = 0

x = 5

def f():

x = 5

x = 6

}

# Definion globales x

# Zuweisung an globales x

# Definition eines lokalen x

# Zuweisung an lokales x

Will man auf eine nicht–lokale Variable schreiben zugreifen, dann muss explizit gesagt werden, dass es sich nicht

um eine Definition handelt. Der Zugriff auf einen globalen Namen muss explizit gekennzeichnet werden. Mit

def f():

x = 5

...

wird ein lokales x erzeugt und gleichzeitig mit einem Wert versehen. Will man das nicht, dann muss man es sagen.

Mit

Th Letschert, FH Giessen–Friedberg

21

def f():

global x

x = 5

...

bezieht sich jede Verwendung von x in f auf das x der globalen Umgebung, es wird keine lokale Variable erzeugt.

Verschachtelte Gültigkeitsbereiche in Python

Gültigkeitsbereiche können üblicherweise verschachtelt werden. In

int x = 3;

void f () {

int z = 2;

for ( int z=1; z<10; ++z ) {

x = y + z;

}

}

haben wir beispielsweise drei verschachtelte Güligkeitsbereiche (global, Funktion, for–Block) mit jeweils einer

Definition. C und verwandte Sprachen erlauben es Gültigkeitsbereiche beliebig tief zu verschachteln. Allerdings

ist es bei C und all seinen nahen und fernen Verwandten nicht erlaubt Funktionen innerhalb anderer Funktionen zu

definieren.

void f (int x) {

// Funktion in Funktion

int g(int y) { // VERBOTEN

return x + y;

}

...

}

In Python gibt es diese Beschränkung nicht. In Funktionen können ohne weiteres andere Funktionen definiert

werden. So gibt

def f(x):

def g(y):

return x+y

return g(x)

print f(2)

ohne jede Beschwerde den Wert 4 aus. Das Spiel kann weiter getrieben werden. So kann in g noch ein h definiert

werden

def f(x):

def g(y):

def h(z):

return x+y+z

return h(y)

return g(x)

und so weiter.

Python ist statisch gebunden und es gilt die üblichen Bindungsregel, nach der die Bindung eines freien Bezeichners

stets von innen nach aussen in umfassenden Gültigkeitsbereichen gesucht wird. Dabei gibt es allerdings eine subtile Beschränkung. Auf eine Variable eines umfassenden Bereichs kann nur dann schreibend zugegriffen werden,

wenn der umdassende Bereich der globale Bereich ist, denn global ist die einzige mögliche Kennzeichnung mit

der etwas als nicht lokal deklariert werden kann. Damit ist ein schreibender Zugriff auf Variablen in “Zwischenbereichen” nicht möglich. Entweder man verwendet global und bezieht sich auf eine globale Variable

22

Nichtprozedurale Programmierung

x = 5

# globales x

def f():

x = 6

# f::x, das x von f -- in g nicht schreibend zugreifbar

def g(y):

global x

x = 0

# das globale x wird 0

...

oder man lässt global weg und bezieht sich auf eine neue lokale Variable:

x = 5

def f():

x = 6

def g(y):

x = 0

...

# globales x

# f::x, das x von f -- in g nicht schreibend zugreifbar

# ein neues lokales g::x wird 0

Diese Beschränkung ist nicht zufällig, sie hat ihren Sinn auf den wir an anderer Stelle noch einmal zu sprechen

kommen werden.

1.2.3

Statische und Dynamische Typisierung

Typisierung: Statisch oder Dynamisch

Unter Typisierung versteht man die Zuordnung eines Typs zu einem Ausdruck. Auch hier hat man die beiden

grundsätzlichen Optionen einer statischen oder einer dynamischen Typisierung. Während bei Frage der Bindung

allgemeiner Konsens herrscht, dass statische Bindung vernünftig ist, werden darüber, wann und wie die Typisierung

eines Programms zu erfolgen hat, heftige Debatten geführt. Die Positionen sind dabei oft genug dogmatisch fix

und werden mit religösen Eifer vertreten. Dieser Eifer hat durchaus seine Berechtigung. Die Art der Typisierung

ist von fundamentaler Bedeutung für den Charakter der Sprache und damit für den Programmierstil.

Auf der einen Seite gibt es die Mehrheitsfraktion der statischen Typisierer. Sie sind der Meinung, dass Programme

statisch, zur Übersetzungzeit, typisiert werden können und müssen: Jedem syntaktischen Konstrukt, d.h. jedem

Ausdruck und jedem Teilausdruck in einem Programm, muss ein fester Typ zugeordnet werden können, der sich

während des Programmlaufs niemals ändert. Der Compiler stellt die Typen fest, prüft die korrekte Zusammenstellung des Programms in Bezug auf die Typen und benutzt die Typ–Information um effiziente Maschinenprogramme

zu generieren.

Bei der dynamischen Typisierung werden Typinformationen zur Laufzeit verarbeitet. Entsprechende Sprachen

Sprachen werden oft auch (nicht ganz korrekt) typfrei genannt. Ausdrücke haben auch hier Werte und diese haben einen Typ. Im Gegensatz zu Sprachen mit statischer Typisierung kann der Typ dieser Werte aber zur Laufzeit

beliebig wechseln und dazu noch bei manchen Programmläufen korrekt sein und bei anderen fehlerhaft.

Kommt in einem Programm mit statischer Typisierung beispielsweise irgendwo so etwas wie

a[i]+i

vor, dann kann ich und der Compiler, allein aus der Betrachtung des Programms, schlı̈eßen, welchen Typ a[i] hat

und ob a[i]+i insgesamt ein korrekter Ausdruck ist: Irgendwo sind a und i definiert und aus diesen Definitionen

kann dann geschlossen werden, ob a[i]+i auswertbar ist oder nicht.

Bei Sprachen mit dynamischer Typisierung gilt das nicht. Der Typ von a[i] ist der Typ seines Wertes und welcher

das ist, ist nicht vorhersehbar. In Python etwa ist folgendes Programmstück völlig legal:

a = {’hoho’:’hallo’, 1:2, 2:’welt’}

i = input()

print a[i]+i

Für manche Eingaben von i ist es korrekt, für andere bricht es mit einem Typfehler ab.

Hinter den beiden Vorstellungen zur Typisierung stecken folgende Sprachkonzepte:

Th Letschert, FH Giessen–Friedberg

23

• Statische Typisierer sind der Überzeugung, dass jeder Ausdruck und jeder Teilausdruck in einem Programm

einen ganz bestimmten festen Typ hat, und jeder Wert, den dieser Ausdruck oder Teilausdruck in einem

Programmlauf annehmen kann, hat ebenfalls diesen Typ.9

• Dynamische Typisierer sind dagegen der Meinung, dass “Typ eines Ausdrucks” ein unsinniges Konzept ist.

Ausdrücke haben keine Typen. Sie haben wechselnde Werte und nur diese Werte haben einen Typ.

Bei Programmen mit statischer Typisierung kann der Compiler viele Programmierfehler aufdecken und deutlich

effizientere Programme erzeugen. Dafür muss der Programmierer ein Typsystem definieren, bei dem die Typen der

Ausdrücke und die ihrer Werte in der richtigen Beziehung stehen. Programme in Sprachen mit dynamischer Typisierung sind meist wesentlich kürzer und einfacher zu schreiben. Die Konstruktion eines passenden Typsystems

für die Ausdrücke entfällt. Dafür sind sie aber langsamer und fehlerträchtiger.

Der schlimmste Makel von Sprachen mit dynamischer Typisierung ist vielleicht, dass sie als Sprachen von Hobby–

Programmierern gelten. Typen sind schwierige Konstrukte. Jeder Ausdruck muss in ein Typsystem passen. Speziell

in modernen Sprachen mit statischer Typisierung ist dazu ein Typsystem von gewisser Komplexität notwendig, das

dazu auch noch vom Programmierer selbst definiert werden muss. Wer diese Definition durch die Verwendung

einer Sprache mit dynamischer Typisierung vermeidet, gerät leicht in Ruf, zu ihr nicht fähig gewesen zu sein.

Python ist eine dynamisch typisierte Sprache

Interpretierte (“Skript”–) Sprachen arbeiten normalerweise ohne explizite Typangaben in ihren Programmen (Ausdrücken). Das heißt nicht, dass es keine Typen gibt, sondern dass man darauf verzichtet syntaktischen Konstrukten

im Quelltext explizit einen Typ zuzuweisen. Es gibt trotzdem Typen, alle Werte haben einen Typ und auch Ausdrücke haben einen Typ. Der Typ der Ausdrücke ist aber nicht statisch im Quelltext festgelegt, er wechselt mit dem

Typ den der Wert des Ausdrucks zur Laufzeit annimmt.

Im folgenden Beispiel wird der Python–Interpretierer mit Ausdrücken unterschiedlichen Typs konfrontiert. Die Typen der Teilausdrücke bestimmen die Typen des Gesamtausdrucks und die Art der Operationen. Typfehler werden

dabei festgestellt und zurückgewiesen:

>>> 2 + 3

5

>>> ’hallo’ + ’Welt’

’halloWelt’

>>> 3 * 4

12

>>> 3 * ’hallo’

’hallohallohallo’

>>> 3 * 3.1415

9.4245000000000001

>>> 3 * ’hallo’ + 4

Traceback (most recent call last):

File "<stdin>", line 1, in ?

TypeError: cannot concatenate ’str’ and ’int’ objects

Ohne irgendwelche Deklarationen und Definitionen interpretiert das System die Operatoren hier jeweils in der

richtigen Weise als Operation auf Int–, Float, oder Stringwerten. Der Typfehler im letzten Ausdruck wird auch

nicht bei einer Übersetzung oder sonstigen Analyse entdeckt, sondern bei dessen Ausführung.

Der Typ eines Werts kann zwar nicht festgelegt, aber mit Hilfe der type–Funktion explizit abgefragt werden:

>>> type(3 * ’hallo’)

<type ’str’>

9 Das “hat diesen Typ” kann auch eine komplexe Vererbungsbeziehung oder eine Instanzierung eines Templates, oder sonst eine Relation

in einem beliebig komplexen Typsystem sein.

24

Nichtprozedurale Programmierung

Basistypen

Wie jede andere Sprache hat auch Python eine Grundmenge an einfachen und zusammengesetzten Datentypen mit

den jeweils zugehörigen Operatoren und Operationen. Die Datentypen sind:

• Zahlen

– Ganze Zahlen

mit Literalen in C/C++–Notation, 1, 02 (oktal), 0x13 (hexadezimal) und Werten im Bereich der Int–

Werte von C.

– Lange ganze Zahlen

sind ganze Zahlen, die keine Größenbeschränkung haben. Sie werden durch ein angehängtes L gekennzeichnet, Z.B. 9999999999999999L.

– Fließkomma–Zahlen

ebenfalls mit Literalen im C–Stil (z.B. 1.0 oder 12.3E-10) und Werten die double–Werten in C

entsprechen.

– Komplexe Zahlen

√

mit Fließkomma–Literalen denen ein “j” als Zeichen für −1 angehängt wird. Z.B.: 2.5j, oder 0j,

sie werden durch ein Paar von Fließkomma–Werten dargestellt werden.

>>> 0.5j + 2

(2+0.5j)

– Boolesche Werte

Werden wie in C als Int–Werte behandelt. Ab Version 2.3 gibt einen eigenständigen Typ für boolesche

Werte mit den Literalen True und False.

• Sequenzen

– Zeichenketten (strings)

sind in einfache oder doppelte Hochkommas eingeschlossene Folgen von Zeichen, z.B. ’hallo’

– Tupel

sind unveränderliche Folgen fester Länge, z.B. (1, 2.0, ’hallo’). Ein Tupel kann Elemente

von unterschiedlichem Typ enthalten.

– Listen

sind veränderliche Folgen variabler Länge, z.B. [1, 2.0, ’hallo’]. So wie Tupel können Listen

Elemente unterschiedlichen Typs enthalten.

• Abbildungen (Dictionaries)

sind Zuordnungen von Werten (beliebigen Typs) zu Schlüsseln fast beliebigen Typs,

z.B.: {1:’hallo’, ’hallo’:’hugo’} Abbildungen sind veränderlich. Auch bei ihnen ist ein Typmix

erlaubt.

In Python sind Listen und Abbildungen Objekte, d.h. veränderliche Dinge. Ein Konzept, das der “reinen” funktionalen Programmierung zuwider läuft. Dort gibt es nur richtige Werte, die im mathematischen Sinn ewig und

unveränderlich sind. Alles Veränderliche ist ein Objekt, etwas aus der Welt der prozeduralen Programmierung.

Selbstverständlich können Listen und Abbildungen auch in rein funktionalen Programmen verwendet werden,

folgt doch aus der Tatsache, dass Listen und Abbildungen verändert werden können, nicht, dass sie verändert

werden müssen.

Details und weitere Beispiele entnehme man der Literatur oder einem Python–Tutorium.

Vordefinierte Operatoren und Funktionen

Auf den numerischen Werten sind die üblichen arithmetischen und relationalen Operatoren definiert, z.B.:

Th Letschert, FH Giessen–Friedberg

25

>>> 5.0/2 > 5/2

1

>>> 5.0/2 < 5/2

0

An diesem Beispiel erkennen wir, dass es eine ganzzahlige und eine Fließkomma–Version der Division gibt, und

dass boolesche Werte als Integerwerte bestimmt werden. Beides entspricht, so wie die weiteren Operatoren in

Python, dem Vorbild C.

Auf Listen– und Tupel–Elemente wird mit der Index–Notation zugegriffen:

>>> [1, 2, 3][1]

2

>>> (2, 3.14, ’hallo’)[2]

’hallo’

in gleicher Weise wird der Wert zu einem Schlüssel in einer Abbildung selektiert:

>>> {1:’hallo’, ’hallo’:’hugo’, 2.0:1}[’hallo’]

’hugo’

Listen und Tupel können mit + zusammengefügt werden:

>>> [1, 2] + [’hugo’, ’egon’]

[1, 2, ’hugo’, ’egon’]

>>> (’hugo’, ’egon’) + (’emilie’, ’karla’)

(’hugo’, ’egon’, ’emilie’, ’karla’)

Tupeln und Listen dürfen dabei nicht vermischt werden.

Selbstverständlich gibt es auch in Python vordefinierte Funktionen. Mathematische Funktionen werden im Modul

math definiert. Z.B.:

>>> import math

>>> math.cos(3.1415926) + math.sqrt(3.1415926)

0.77245383578811577

oder

>>> from math import sin

>>> sin(3.1415)

9.2653589660490244e-05

Mächtige Ausdrücke

Bei der ersten Begegung mit Sprachen wie Python fällt auf, dass dort mit sehr mächtigen Ausdrücken gearbeitet

werden kann. Man schreibt einfach

m = {1:[’hugo’, ’emil’], 2:[’karla’, ’charlotte’], 3:[]}