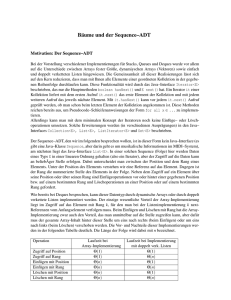

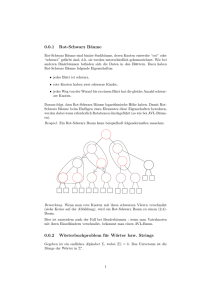

Algorithmische Bioinformatik: Bäume und Graphen Skript

Werbung