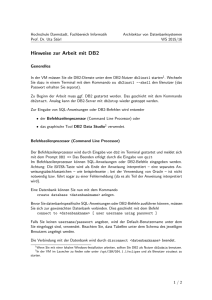

Der Datentyp XML in DB2 for z/OS aus Performance

Werbung