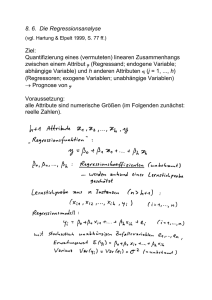

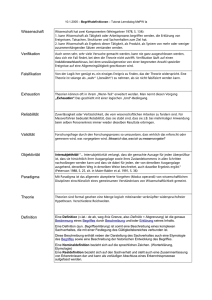

Kapitel 2 Grundlagen der deskriptiven Regressionsanalyse – OLS

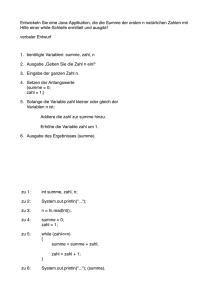

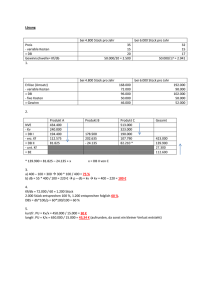

Werbung