Mikro-¨Okonometrie: Large-Sample Inferenz mit OLS

Werbung

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 2

Konsistenz eines Schätzers

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

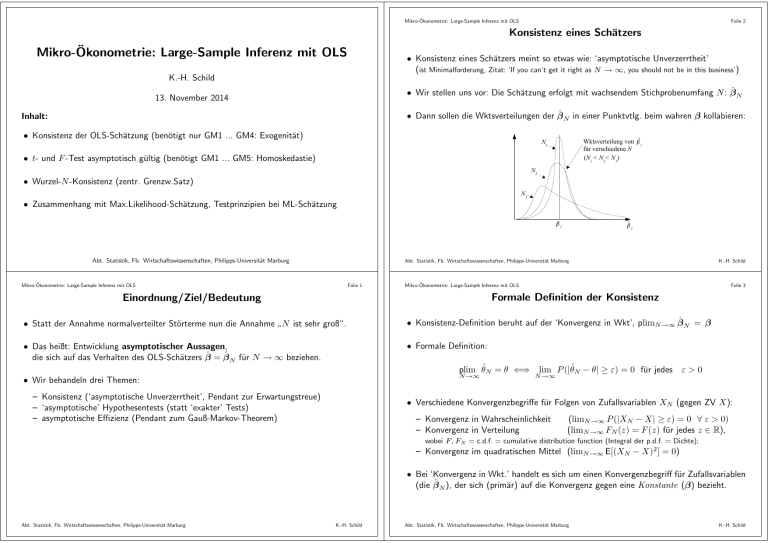

• Konsistenz eines Schätzers meint so etwas wie: ‘asymptotische Unverzerrtheit’

(ist Minimalforderung, Zitat: ‘If you can’t get it right as N → ∞, you should not be in this business’)

K.-H. Schild

• Wir stellen uns vor: Die Schätzung erfolgt mit wachsendem Stichprobenumfang N : β̂ N

13. November 2014

• Dann sollen die Wktsverteilungen der β̂ N in einer Punktvtlg. beim wahren β kollabieren:

Inhalt:

• Konsistenz der OLS-Schätzung (benötigt nur GM1 ... GM4: Exogenität)

Wktsverteilung von Žŝ j

für verschiedene N

(N1 < N2< N3)

N3

• t- und F -Test asymptotisch gültig (benötigt GM1 ... GM5: Homoskedastie)

N2

• Wurzel-N -Konsistenz (zentr. Grenzw.Satz)

N1

• Zusammenhang mit Max.Likelihood-Schätzung, Testprinzipien bei ML-Schätzung

Žj

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Žŝ j

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 1

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 3

Formale Definition der Konsistenz

Einordnung/Ziel/Bedeutung

• Statt der Annahme normalverteilter Störterme nun die Annahme N ist sehr groß“.

”

• Konsistenz-Definition beruht auf der ‘Konvergenz in Wkt’, plimN →∞ β̂ N = β

• Das heißt: Entwicklung asymptotischer Aussagen,

die sich auf das Verhalten des OLS-Schätzers β̂ = β̂ N für N → ∞ beziehen.

• Formale Definition:

plim θ̂N = θ ⇐⇒

N →∞

• Wir behandeln drei Themen:

– Konsistenz (‘asymptotische Unverzerrtheit’, Pendant zur Erwartungstreue)

– ‘asymptotische’ Hypothesentests (statt ‘exakter’ Tests)

– asymptotische Effizienz (Pendant zum Gauß-Markov-Theorem)

lim P (|θ̂N − θ| ≥ ε) = 0 für jedes ε > 0

N →∞

• Verschiedene Konvergenzbegriffe für Folgen von Zufallsvariablen XN (gegen ZV X):

– Konvergenz in Wahrscheinlichkeit

– Konvergenz in Verteilung

(limN →∞ P (|XN − X| ≥ ε) = 0 ∀ ε > 0)

(limN →∞ FN (z) = F (z) für jedes z ∈ R),

wobei F, FN = c.d.f. = cumulative distribution function (Integral der p.d.f. = Dichte);

– Konvergenz im quadratischen Mittel (limN →∞ E[(XN − X)2] = 0)

• Bei ‘Konvergenz in Wkt.’ handelt es sich um einen Konvergenzbegriff für Zufallsvariablen

(die β̂ N ), der sich (primär) auf die Konvergenz gegen eine Konstante (β) bezieht.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 4

Konsistenz von OLS (unter GM1,. . .,GM4)

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Konsistenz-Nachweis (Fortsetzung)

• Die beiden plim’s auf der rechten Seite haben klare statistische Interpretationen: Nach dem Gesetz der

großen Zahlen ist

1

XcXc

N →∞ N

plim

• (Bereits) unter GM1, ..., GM4 ist die OLS-Schätzung konsistent.

• Also: Gleiche Voraussetzungen wie diejenigen, die Erwartungstreue garantieren, d.h.

←− natürlich

– Korrekte Spezifikation des Modells

(funktionale Form (GM1), keine Kollinearität (GM3))

– Vernünftige Datenerhebung: Zufallsstichprobe (GM2)

– Exogenität der Regressoren

– Homoskedastie wird nicht benötigt.

Folie 6

= Var(X),

1

Xcu

N →∞ N

plim

= cov(X, u)

wobei Var(X) die K ×K -Varianzmatrix der Regressoren x1, . . . , xK ist und der K -Vektor cov(X, u) =

(cov(x1, u), . . . , cov(xK , u)) deren Kovarianzen mit u enthält.

• Im Ergebnis entsteht also:

−1

cov(X, u)

plim β̂ = β + Var(X)

N →∞

−1

Der ’asymptotische Bias’ ist also Var(X)

cov(X, u).

Das ist 0 und OLS damit konsistent, falls

– Die Varianzmatrix der Regressoren, Var(X), regulär ist

– dies ist die Annahme GM3 der linearen Unabhängigkeit der Regressoren in der Population

– die Regressoren nicht mit den Störtermen korrelieren, cov(xj , u) = 0 für alle j

– dies ist die Exogenitätsannahme GM4 auf Populationsniveau

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 5

Beweisskizze für ‘Konsistenz von OLS unter GM1,. . .,GM4’

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

Folie 7

Asymptotische Normalität unter GM1, ... ,GM5

• Wie bei der Erwartungstreue schreiben wir

β̂ = (X X)

−1

X y = (X X)

−1

X (Xβ + u) = β + (X X)

−1

Xu

(wir müssten jetzt eigentlich einen Index N bei β̂ , X und u setzen, unterdrücken das aber)

• Es folgen zwei Tricks:

1 Die OLS-Schätzung β̂ (mit einer Konstanten) ist invariant unter einer Zentrierung der Regressoren,

d.h. anstatt X können wir auch die Matrix Xc verwenden, in der die Spalten xj durch xcj = xj − x̄j

ersetzt sind.

2 Wir ‘erweitern den Quotienten’ (X X)−1 X mit N1 :

(X X)

−1

X = (XcXc)

−1

Xc =

−1 1 1

N Xc Xc

N Xc

−1 1 β̂ = β + N1 XcXc

N Xc u

und die Bildung des plim liefert (mit einigen ‘Stetigkeitsargumenten’)

• Zum Glück muss man diesen Aufwand nicht betreiben, wenn der Stichprobenumfang N

genügend groß ist.

Grund: Auch bei nicht-normaler Verteilung der Störterme unterscheiden sich die kritischen Werte der Teststatistiken bei großem N kaum von denen bei Normalverteilung.

−1 · plim

plim β̂ = β + plim N1 XcXc

N →∞

N →∞

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

• In viele Fällen ist diese Annahme unrealistisch (nicht mal annähernd erfüllt).

Aber dann: Die β̂j sind nicht perfekt normalverteilt.

Konsequenz: Die gesamten Inferenzmöglichkeiten gehen flöten (weder ist die t-Statistik unter

der Nullhypothese exakt t-verteilt, noch ist die F -Statistik exakt F -verteilt usw.)

• Möglicher Ausweg: Für jede von der Normalverteilung abweichende Verteilung der

Störterme die Verteilung der Teststatistiken neu ermitteln (Arbeitsbeschaffungsprogramm für

Mathematiker)

• Wir haben also

• Die Hypothesentests des letzten Kapitels beruhen auf der Annahme normalverteilter

Störterme (GM6)

←− normalverteilt gegeben X

1

Xcu

N →∞ N

K.-H. Schild

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 8

Zentraler Grenzwertsatz

Sei (Yn)n=1,2,... eine Folge von i.i.d. Zufallsvariablen mit Erw.Wert μ und Varianz σ 2

i.i.d = independent identically distributed; Vorstellung dazu: Yn = Realisierung einer zufällig fluktuierenden

Größe Y in n-ter (unabhängiger) Wiederholung des (gleichen) Experiments

1

N

N

n=1 Yn

Folie 10

Asymptotische Normalverteilung und Wurzel-N -Konsistenz von OLS

• Theoretischer Hintergrund dafür ist der zentrale Grenzwertsatz (ZGWS):

Sei außerdem ȲN :=

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

= der Mittelwert aus den ersten N der Yn.

• Eine analoge Aussage gilt für die OLS-Schätzung β̂ = β̂ N :

Satz: Unter den GM-Annahmen 1 bis 5 gilt für die OLS-Schätzung β̂:

i) β̂ ist Wurzel-N -konsistent für β und asymptotisch normalverteilt,

√

Dann ist

ȲN − μ

√

←− auf E[ȲN∗ ] = 0, Var(ȲN∗ ) = 1 standardisiertes Y N

σ/ N

a

asymptotisch standard normalverteilt – geschrieben ȲN∗ ∼ N (0, 1) – d.h. es gilt:

z

1 2

1

∗

Φ(z) := √

e− 2 z̃ dz̃

lim P (ȲN ≤ z) = Φ(z) ∀ z ∈ R,

N →∞

2π −∞

a

d

Anstatt ȲN∗ ∼ N (0, 1) schreibt man auch ȲN∗ −→ N (0, 1) (‘Konverg. in Verteilung’)

N (β̂ − β) ∼ N (0, σ 2 V )

1

(X X)−1)

N →∞ N

a

(mit V = p lim

ȲN∗ =

• ZGWS inhaltlich: Durch Mittelung vieler unabhängiger Beobachtungen (Konzentration

vieler Daten Y1, . . . , YN auf ein Datum ȲN ) entsteht annähernd eine Normalverteilung.

√

Die Varianz der ȲN klingt dabei wie 1/N ab, ihre Std.Abweichung also wie 1/ N .

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

Folie 9

Wurzel-N -Konsistenz + asymptotische Normalverteilung

β̂j − βj

se(β̂j )

a

∼ N (0, 1)

iii) Die kritischen Werte der t- und F -Statistik konvergieren für N → ∞ gegen

diejenigen, die sich bei unterstellter Normalverteilung der Störterme ergeben.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 11

Beweis und Konsequenzen der asymptotischen Normalverteilung

• Der zentr. Grenzw.satz drückt die Wurzel-N -Konsistenz von ȲN als Schätzer für μ

aus:

√

d

N (ȲN − μ) −→ N (0, σ 2)

• Das ist informativer als die reine Konsistenz (plimN →∞ ȲN = μ), da man sieht, dass

– die Schätzung ȲN asymptotisch normalverteilt ist um den Erw.Wert μ = plimN →∞ ȲN ,

√

– wobei die Standardabweichung sd(ȲN − μ) wie 1/ N für N → ∞ abklingt.

• Beweis des Satzes:

√ Recht technisch, Anwendung des ZGWS;

Nachweis der N -Konsistenz in i) beruht auf

√ −1 √ 1 N β̂ − β) = N1 X X

N NX u

ZGWS

Dabei entspricht N1 X u der Differenz ȲN − μ im ZGWS (betrachte z.B. die erste Komponente von

in einem Modell mit Konstante: sie lautet N1

i ui , was man als ū − 0 lesen kann)

1

NX u

• Praktische Konsequenz der asymptotischen Normalität:

• Anmerkungen:

– Es ist sd(ȲN − μ) = sd(ȲN ) = se(ȲN ), wobei

√ se(ȲN ) den Standardfehler von ȲN (als

konsistentem Schätzer für μ) meint. Die N -Konsistenz besagt √

also:

Der Standardfehler des Schätzers klingt asymptotisch wie 1/ N ab für N → ∞.

– Wenn wir die Regression von Y auf (nur) eine Konstante (nur β0 im Modell)

durchführen, dann ist β̂0 = ȲN .

Der folgende Satz (allg. für OLS) ist i.W. der zentr. Grenzw.Satz in diesem Spezialfall.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

ii) Für jedes j gilt:

K.-H. Schild

Sofern N genügend groß ist, kann man, selbst bei nicht-normalverteilten Störtermen,

die gleichen Teststatistiken und kritischen Werte wie bei unterstellter Normalverteilung verwenden.

• Praktische Konsequenz der Wurzel-N -Konsistenz:

√

Standardfehler sollten für N → ∞ wie 1/ N abklingen.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Beispiel zur

√

Folie 12

N -Konsistenz (I)

• Man schreibt if Subsample-Bedingung hinter den (regress-)Befehl , z.B.

. regress lnwage male school exper

lnwage |

Coef.

Std. Err.

t

P>|t|

[95% Conf. Interval]

-------------+---------------------------------------------------------------male |

.2425688

.020453

11.86

0.000

.2024669

.2826707

school |

.1233607

.0062296

19.80

0.000

.1111465

.1355749

exper |

.0354122

.0045137

7.85

0.000

.0265622

.0442622

_cons | -.2593468

.0883222

-2.94

0.003

-.4325189

-.0861748

-----------------------------------------------------------------------------N = 3294, R^2 = 0.1374, \hat\sigma = .57861, F(3,3290) = 174.74 (p-Wert < 10^{-4})

• Nur für die Beobachtungen mit gerader Datensatznr. (regress ... if mod( n,2)==0):

. regress lnwage male school exper if mod(_n,2)==0

lnwage |

Coef.

Std. Err.

t

P>|t|

[95% Conf. Interval]

-------------+---------------------------------------------------------------male |

.2471934

.0298907

8.27

0.000

.1885656

.3058212

school |

.1228051

.0089354

13.74

0.000

.1052791

.1403311

exper |

.0349422

.0065673

5.32

0.000

.0220609

.0478234

_cons | -.2605464

.1264648

-2.06

0.040

-.5085955

-.0124972

-----------------------------------------------------------------------------N = 1647, R^2 = 0.1338, \hat\sigma = .59789, F(3,1643) = 84.60 (p-Wert < 10^{-4})

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Beispiel zur

√

K.-H. Schild

Folie 13

N -Konsistenz (II)

• Nochmalige Zusammenstellung der gesch. Regr.Koeffizienten u. ihrer Stdfehler (Stata-Code unten):

Variable |

N=1647

N=3294

-------------+-----------------------------male |

0.2472

0.2426

|

0.0299

0.0205

school |

0.1228

0.1234

|

0.0089

0.0062

exper |

0.0349

0.0354

|

0.0066

0.0045

_cons |

-0.2605

-0.2593

|

0.1265

0.0883

-------------+------------------------------

regress y x if x > 0 // Führt Regr. y ~ x nur für die Datensätze mit x > 0 durch

regress y x if _n < 100 // Führt Regr. y ~ x nur mit ersten 99 Datensätzen durch

regress y x if mod(_n,2)==1 // Führt die Regr. y ~ x nur für ungerades i durch

Anmerkungen:

n: die Nr. i des Datensatzes; Achtung bei Umsortierung der Datensätze (= Einheiten)

mod(a,b): Rest der Ganzzahldivision a ÷ b (Beispiel: mod(23,7) ergibt 2)

‘==’ (statt nur ‘=’) verwenden für Test auf Gleichheit

‘!=’ testet auf Ungleichheit (! ⇐⇒ aussagenlogisches nicht/non/not)

‘<=’ testet auf kleiner gleich“ (äquivalent: ‘!>’ ⇐⇒ ‘nicht größer’)

”

Ergebnis von a==b, a < b usw. vom Boole’schen Typ (Wert ist true (1) od. false (0))

• Man kann auch in Datenbereich hinter den (regress-)Befehl schreiben. z.B.

regress y x in 1/99 // Führt Regr. y ~ x nur auf ersten 99 Datensätzen durch

• Löschen von Datensätzen (für ges. Session):

drop if !Subsample-Bedingung

Beibehalten von Datensätzen (für ges. Session): keep if Subsample-Bedingung

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

Folie 15

Speichern und Ausgabe mehrerer Regressionsergebnisse in Stata

(estimates store | table | restore | ...)

In Stata kann man komplette Regressionsergebnisse mit dem Befehl estimates store

REGNAME im Arbeitsspeicher unter dem (selbstgewählten) Namen REGNAME hinterlegen

Mit dem Befehl estimates restore REGNAME lassen sie sich restaurieren“ (zum aktuellen

”

Ergebnis machen).

Mit dem Befehl estimates table REGListe lassen sich die in REGListe angegebenen

(zuvor gespeicherten) Regr.Ergebnisse vertikal nebeneinander tabelliert ausgeben, z.B.:

legend: b/se

• Auswirkung der Konsistenz: Die geschätzten Regr.Koeffizienten β̂ sind fast unverändert.

• Auswirkung der Wurzel-N -Konsistenz: Die Standardfehler sollten wie √1N abklingen: seN (β̂) ∼ √1N .

√

√

seN ≈ const / N ⇒ seN1 /seN2 ≈ N2/N1. Mit N2 = N, N1 = N/2 folgt: seN/2/seN ≈ 2.

√

D.h.: Std.fehler sollten bei Übergang N/2 → N etwa um den Faktor 2 ≈ 1.41 abklingen.

Tatsächlich:

0.030

0.0089

0.0066

0.127

male:

= 1.43, school:

= 1.39, exper:

= 1.47, const:

= 1.44.

0.021

0.0062

0.0045

0.088

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Folie 14

‘Subsampling’ in Stata:

WAGES1-Daten, Regression von lnwage = log(wage) auf male, school und exper:

• Regression auf Basis aller N = 3294 Datensätze in WAGES1.DTA:

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

use wages1.dta, clear

gen lnwage=log(wage)

regress lnwage male school exper

estimates store REG2

// letztes Regr.Erg. in REG2 speichern

regress lnwage male school exper if mod(_n,2)==0

estimates store REG1

// letztes Regr.Erg. in REG1 speichern

* Folgender Befehl gibt Regr.Koeff., StdFehler sowie N, R^2, Regr. F-Wert und LogL aus

estimates table REG1 REG2, b(%9.4f) se statistics(N r2 F ll)

Einzelheiten der (aktuellen) Regression, z.B. R2, kann man auch mit scalar myr2 =e(r2)

(liefert das R2 im Skalar myr2 ) speichern. scalar myll = e(ll) liefert die LogLikelihd.

Die gesch. Regr.koeff.en kann man mit matrix beta = e(b) im Vektor beta speichern.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 16

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Maximum-Likelihood-Methode

Folie 18

Log-Likelihood

Aus rechentechnischen Gründen führt man die Maximierung meistens mit dem Logarithmus

der Likelihood, der sog. log-Likelihood logL, durch:

Übersicht:

logL(x1, . . . , xN ; θ) = log

• Das Maximum-Likelihood-Schätzprinzip

i=1

!

∂ logL(x1 ,...,xN ; θ)

:

∂θ

N ∂ log p(xi, θ) 0 =

i=1

∂θ

θ=θ̂

• Generelle Eigenschaften einer Max.Likelihood-Schätzung

– Konsistenz

√

– asymptotische Normalität ( N -Konsistenz)

– asymptotische Effizienz

Auflösung dieser Gleichung nach θ liefert den Maximum-Likelihood-Schätzer θ̂. Er maximiert

die (log)-Likelihood-Funktion, sofern

• Prinzipien für asymptot. Tests im Zshg. mit der ML-Schätzung

N ∂ 2 log p(xi, θ) ∂ 2 logL(x1, . . . xN ; θ̂)

=

i=1

∂θ2

∂θ2

θ=θ̂

– Wald-Tests

– Likelihood-Ratio-Tests

– Lagrange-Multiplikator-Tests

negativ (-definit) ist.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 17

Maximum Likelihood Methode

Für die Parameter (θ) werden diejenigen Werte als Schätzer (θ̂) genommen, für die die

Wahrscheinlichkeit (die Likelihood ) maximal wird, genau die beobachtete Stichprobe

(x1, . . . xN ) zu realisieren.

Likelihood-Funktion im Fall einer Zufallsstichprobe x1, . . . , xN :

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

Folie 19

• Eine Urne enthält rote und schwarze Kugeln;

Zu schätzen ist der Anteil θ der roten Kugeln

auf Basis einer Stichprobe, bei der N Kugeln mit Zurücklegen gezogen werden.

• Beschreibe Stichprobe durch: xi = 1, falls im i-ten Zug rote Kugel gezogen, xi = 0 sonst.

• Dann ist:

p(xi, θ) = θxi (1 − θ)1−xi ← so darstellen, damit man nach θ ableiten kann

⇒

log p(xi, θ) = xi log(θ) + (1 − xi) log(1 − θ)

∂ log p(xi, θ)

xi 1 − xi

=

−

⇒

∂θ

θ

1−θ

Sei p(x, θ) die individuelle Likelihood (Wahrscheinlichkeit, den Wert x in der Stichprobe zu beobachten,

Dann ist die Likelihood-Funktion gegeben durch:

wenn θ der wahre Parameter ist).

N

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Beispiel: ML-Schätzung einer unbekannten Wahrscheinlichkeit

Allgemeines Konzept zum Schätzen der Parameter eines Modells auf Basis einer Stichprobe:

Bedingung 1. Ordnung zur Maximierung von logL:

p(xi, θ).

i=1

0 =

Sie gibt die Wahrscheinlichkeit an, gerade die beobachtete Stichprobe (x1, . . . , xN ) zu

realisieren, wenn der wahre Parameter θ ist. (Wenn xi stetig verteilt ist, verwendet man anstatt

p(x, θ) die Dichte f (x, θ) zur Bildung der Likelihood-Funktion, da sonst L = 0 wäre)

Die Likelihood-Funktion wird als Funktion von θ – bei gegebenem x1, . . . , xN – maximiert.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

i=1

N

p(xi, θ) =

log p(xi, θ)

Bedingung erster Ordnung für ein Maximum von logL, 0 =

• OLS als spezielle Max.Likelihood-Schätzung

L(x1, . . . , xN ; θ) =

N

K.-H. Schild

wobei N1(=

N xi 1 − xi N1 N − N1

−

=

,

−

i=1 θ

1 − θ θ=θ̂

1 − θ̂

θ̂

xi) die Anzahl roter Kugeln in der Stichprobe ist.

Die Auflösung nach θ̂ liefert als ML-Schätzer für θ den Standard-Schätzer θ̂ = N1/N

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 20

OLS als Maximum-Likelihood-Schätzung

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 22

Asymptotische Effizienz der Maximum-Likelihood-Schätzung

• OLS-Schätzung eines linearen Regressionsmodells (unter GM1, ..., GM6) lässt sich als

Maximum-Likelihood-Schätzung interpretieren.

• Der Parameter(vektor) θ umfasst dann nicht nur die Regr.koeffizienten β1, . . . , βK , sondern auch σ 2: θ = (β1, . . . , βK , σ 2). Der Datenbeobachtung xi entspricht hier (yi, x̃i).

• Der individuellen Likelihood p(xi, θ) entspricht hier die Dichte (der Normalverteilung)

1 (y − x̃ β)2 1

i

i

exp −

f (yi, x̃i; β, σ 2) = √

2

σ2

2πσ 2

1

1 (yi − x̃iβ)2

⇒ log f (yi, x̃i; β, σ 2) = − log(2π σ 2) −

2

2

σ2

2

∂ log f (yi, x̃i; β, σ )

yi − x̃iβ

=

−0

+ x̃i

⇒

∂β

σ2

∂ log f (yi, x̃i; β, σ 2)

1

1 (yi − x̃iβ)2

=

− 2

+

2

∂σ

2σ

2

σ4

Unter schwachen Regularitätsbedingungen gilt für jeden Maximum-Likelihood-Schätzer:

• Der Maximum-Likelihood-Schätzer ist konsistent, plimN →∞ θ̂ = θ

• Der Maximum-Likelihood-Schätzer ist asymptotisch normal verteilt (und

sistent):

√

d

N (θ̂ − θ) −→ N (0, V )

wobei V die asymptotische Varianzmatrix ist.

√

N -kon-

• Der Maximum-Likelihood-Schätzer ist asymptotisch effizient (d.h. die asymptotische

Varianzmatrix V der Maximum-Likelihood-Schätzung ist die ‘kleinste’ unter allen konsistenten, asymptotisch normalen Schätzern von θ)

Zeigt: Der ML-Schätzer hat vorteilhafte Eigenschaften gegenüber anderen Schätzern

(insbesondere ist er asymptotisch effizient).

Vor diesem Hintergrund ist das Gauß-Markov-Theorem ( OLS ist BLUE“) nicht mehr so überraschend.

”

Man beachte jedoch: ML braucht Verteilungsnahmen, d.h. wir müssen hier für OLS auch GM6 unterstellen.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 21

OLS als Maximum-Likelihood-Schätzung (Forts.)

1

σ2

Nullsetzen der summierten Ableitungen nach β liefert – abgesehen vom Faktor

–

genau die Normalengleichungen der OLS-Schätzung, d.h. der ML-Schätzer stimmt in

Bezug auf β mit dem OLS-Schätzer überein:

N

−1 N

N

yi − x̃iβ !

=

0

⇒

β̂

=

β̂

=

x̃i

x̃

x̃

x̃i yi

i

M

L

i

i=1

i=1

i=1

σ2

β=β̂

Die Maximum-Likelihood-Schätzung von σ 2 ergibt sich aus

1 N (yi − x̃iβ)2 1 N

N

!

2

= 0 ⇒ σ̂ 2 = σ̂M

=

(yi − x̃iβ̂ )2

− 2+

L

4

i=1

i=1 2σ

2

σ

N

β=β̂, σ 2 =σ̂ 2

=ûi

Sie unterscheidet sich von der (im Kapitel 2 angegebenen, unverzerrten) Schätzung von

σ 2 nur dadurch, dass keine Freiheitsgradkorrektur stattfindet (N statt N − K im Nenner)

Anmerkung: Die gesamte log-Likelihood (in β̂, σ̂ 2) ergibt sich hier als

N

1 N (yi − x̃iβ̂)2

N

|û|2

= − log(2πσ̂ 2) − 2

logL(y, X; β̂, σ̂ 2) = − log(2πσ̂ 2) −

2

i=1

2

2

σ̂

2

2σ̂

Anmerkung: Explizite Lösungsformeln wie hier sind bei ML eher ungewöhnlich! (sondern

Einsatz iterativer numerischer Lösungsverfahren, i.d.R. Newton-Verfahren, erforderlich)

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

K.-H. Schild

Folie 23

Asymptot. effiziente Varianzmatrix V als Inverse der

Informationsmatrix

Der (negative) Erwartungswert der Hesse-Matrix der individuellen Log-Likelihood wird als

Fisher’sche Informationsmatrix I(θ) bezeichnet:

I(θ) := −E

∂ 2 log p(x, θ) ∂θ∂θ N

1 ∂ 2 log p(xi, θ) Schätzer: I(θ) = −

N i=1

∂θ∂θ Die asymptotisch effiziente Varianzmatrix V der ML-Schätzung θ̂ ist (wiederum unter

geeigneten Regularitätsbedingungen) durch die Inverse der Informationsmatrix gegeben:

V = I(θ)−1

Den (asymptot.) Standardfehler der ML-Schätzung kann man also folgendermaßen schätzen:

– Zunächst wird die Informationsmatrix (in θ̂) geschätzt (was sehr einfach ist): I(θ̂)

−1

als geschätzte Varianzmatrix V̂ von θ̂ berechnet.

– und dann wird deren Inverse I(θ̂)

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 24

Untere Cramer-Rao-Schranke

Aussage ML ist asymptotisch normal und asymptotisch effizient“ impliziert:

”

Die Inverse der Informationsmatrix stellt eine untere Schranke für die asymptotische

Varianzmatrix jedes asymptotisch normalen Schätzers dar.

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 26

• Wald-Test: Nur das unrestringierte Modell wird (per ML) geschätzt (→ θ̂ u) und

überprüft, ob der ‘Defekt’ in der Restriktion Rθ̂ u − r sich signifikant von 0 unterscheidet;

als Teststatistik wird

−1 Rθ̂ u − r

W = N Rθ̂ u − r RV̂ R

verwendet, wobei V̂ eine Schätzung der (asymptot.) Varianzmatrix von θ̂ u ist.

Dies wird oft als die untere Cramer-Rao-Schranke bezeichnet.

Asymptotische Effizienz der ML-Schätzung wird daher oft auch folgendermaßen formuliert:

Der ML-Schätzer nimmt die untere Cramer-Rao-Schranke an.

• Likelihood-Ratio Test: Das Modell wird zweimal geschätzt, einmal ohne die Restriktion

(→ θ̂ u) und einmal mit der Restriktion (→ θ̂ r ; es gilt

also Rθ̂ r = r). Dann wird

überprüft, ob logL(θ̂ u) − logL(θ̂ r ) = log L(θ̂ u)/L(θ̂ r ) signifikant größer 0 ist. Dazu

wird folgende Teststatistik verwendet:

LR = 2 (logL(θ̂ u) − logL(θ̂ r ))

• Lagrange-Multiplikator Test: Nur das restringierte Modell wird geschätzt (→ θ̂ r ).

Es wird überprüft, ob die Ableitung der logLikelihood-Funktion nach θ (die sog. scoreFunktion) in θ̂ r einen Wert nahe bei 0 aufweist (wenn die Restriktionen zutreffen, so sollte

die Bedingung 1. Ordnung – Ableitung der logLiklihood = 0 – auch in θ̂ r angenähert

erfüllt sein.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 25

Asymptot. Tests im Zusammenhang mit der ML-Schätzung

Ziel: Verallgemeinerung des OLS-F -Tests (einer oder mehrerer) linearer Restriktionen.

Ganz generell kann man für eine ML-Schätzung Tests von linearen Restriktionen Rθ = r

(als Nullhypothese) entwerfen.

R bezeichne dabei wieder eine J × K-Matrix mit Rang J.

Dabei kann man (sogar) drei verschiedene Prinzipien zur Def. der Teststatistik unterscheiden

Allen drei Teststatistiken ist folgendes gemein:

Die Teststatistik ist (unter H0 : Rθ = r) jeweils asymptotisch χ2-verteilt mit

J Freiheitsgraden.

(Die small-sample Eigenschaften der Teststatistik sind aber viel komplizierter, weswegen in

der Praxis ausschließlich die asymptotische Version verwendet wird, d.h. für die kritischen

Werte werden diejenigen der χ2J -Verteilung eingesetzt).

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild

Mikro-Ökonometrie: Large-Sample Inferenz mit OLS

Folie 27

Lagr.-Mult. Test für Exklusionsrestriktionen bei linearen Regressionsmodellen

Im Fall eines OLS-geschätzten Regressionsmodells lässt sich der Lagrange-Multiplikator-Test

zur Überprüfung von J Exklusionsrestriktionen (Nullhypothese: βJ−K+1 = 0∧. . .∧βK = 0)

folgendermaßen implementieren:

1) Regressiere y auf den restringierten Satz an erklärenden Variablen (x1, . . . , xK−J ) und

speichere die Residuen ûr

2) Regressiere ûr auf den vollen Satz an erklärenden Variablen (x1, . . . , xK );

das R2 dieser Regression sei mit Ru2 bezeichnet (um es vom R2 der Regression von y auf

x1, . . . , xK zu unterscheiden – diese Regression wird beim LM-Test nicht durchgeführt!).

Ein großes Ru2 signalisiert, dass die Variablengruppe Einfluss auf y hat. Warum?

3) Berechne die Lagrange-Multiplikator-Statistik LM = N Ru2

4) Vergleiche LM mit dem kritischen Wert c(α) einer χ2J -Verteilung (α = Signifikanzniveau). Falls LM > c(α) wird die Nullhypothese (die Exklusionsrestriktionen gelten, d.h.

die Variablengruppe hat keinen Einfluss auf y) abgelehnt.

Abt. Statistik, Fb. Wirtschaftswissenschaften, Philipps-Universität Marburg

K.-H. Schild