5.3 Ergebnis- und Ereigniswahrscheinlichkeiten

Werbung

5 Grundbegriffe der Wahrscheinlichkeitstheorie

43

5.3 Ergebnis- und Ereigniswahrscheinlichkeiten

Bisheriger Aufbau

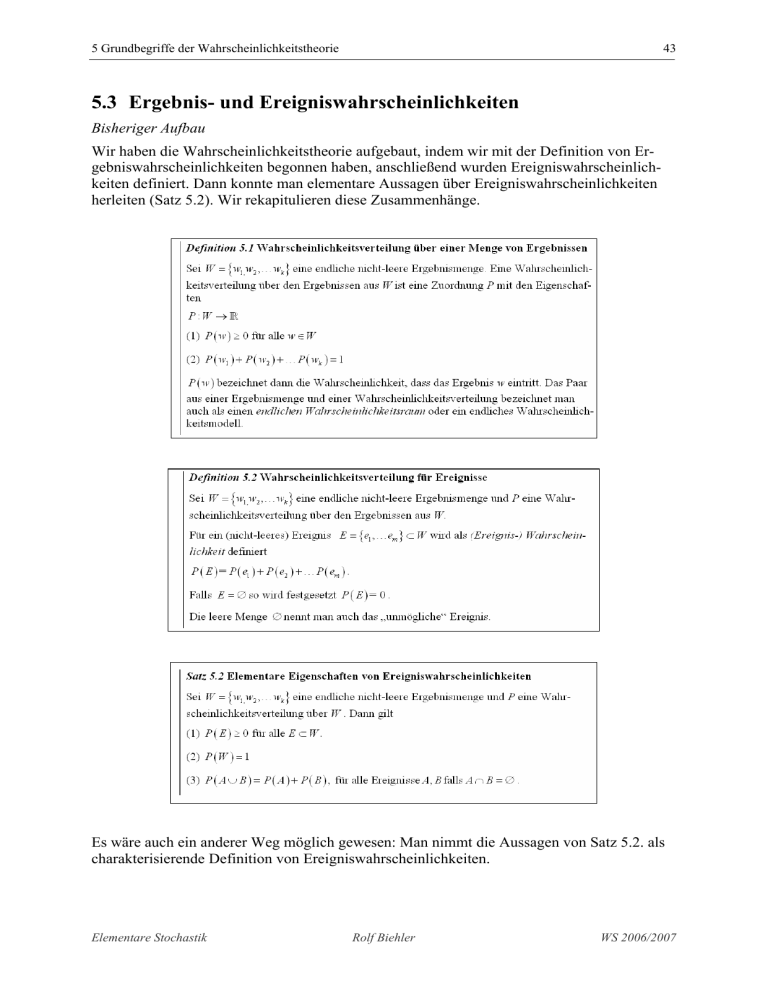

Wir haben die Wahrscheinlichkeitstheorie aufgebaut, indem wir mit der Definition von Ergebniswahrscheinlichkeiten begonnen haben, anschließend wurden Ereigniswahrscheinlichkeiten definiert. Dann konnte man elementare Aussagen über Ereigniswahrscheinlichkeiten

herleiten (Satz 5.2). Wir rekapitulieren diese Zusammenhänge.

Es wäre auch ein anderer Weg möglich gewesen: Man nimmt die Aussagen von Satz 5.2. als

charakterisierende Definition von Ereigniswahrscheinlichkeiten.

Elementare Stochastik

Rolf Biehler

WS 2006/2007

44

Alternativer Aufbau

Definition 5.1’ Wahrscheinlichkeitsverteilung für Ereignisse

Sei W = {w1, w2 ,… wk } eine endliche nicht-leere Ergebnismenge. Eine Zuordnung P,

die jeder Teilmenge E ⊂ W eine Zahl P ( E ) zuordnet heißt Wahrscheinlichkeitsverteilung über (den Ereignissen) der Ergebnismenge W, wenn Sie die folgenden Eigenschaften besitzt:

(1) P ( E ) ≥ 0 für alle E ⊂ W .

(2) P (W ) = 1

(3) P ( A ∪ B ) = P ( A ) + P ( B ) , für alle Ereignisse A, B falls A ∩ B = ∅

heißt.

Bemerkung: Die Wahrscheinlichkeitsverteilung ist dann eine Abbildung P : P (W ) →

, wo-

bei P (W ) die Potenzmenge von W, also die Menge aller Teilmengen von W bezeichnet.

Definition 5.2’ Wahrscheinlichkeitsverteilung für Ergebnisse

Sei W = {w1, w2 ,… wk } eine endliche nicht-leere Ergebnismenge und P eine Wahrscheinlichkeitsverteilung im Sinne von Def. 5.1’. Dann definieren wir für w ∈ W als

Ergebniswahrscheinlichkeit P ( w ) := P ( E ) für E = {w} .

Die Definition ist naheliegend, wir haben nämlich für Elementarereignisse E = {w} als Teilmengen von W bereits eine Wahrscheinlichkeit vorliegen und wir identifizieren wieder Ergebnisse und Elementarereignisse.

Als Satz können wir jetzt beweisen

Satz 5.1’ Darstellung von Ereigniswahrscheinlichkeiten

Sei W = {w1, w2 ,… wk } eine endliche nicht-leere Ergebnismenge und P eine Wahrscheinlichkeitsverteilung über Ereignissen im Sinne von Def. 5.1’, dann gilt für alle

(nicht-leeren) Ereignisse E = {e1 ,… em } ⊂ W :

P ( E ) = P ( e1 ) + P ( e2 ) +… P ( em ) .

Ferner gilt für E = ∅ : P ( E ) = 0

Beweis:

Elementare Stochastik

Rolf Biehler

WS 2006/07

5 Grundbegriffe der Wahrscheinlichkeitstheorie

45

Aus Def. 5.1’ (3) kann man analog zu Satz 5.3 die endliche Additivität ableiten. Wegen

E = {e1} ∪ {e2 } ∪ {e3 } ∪…{em } und da alle diese ein-elementigen Mengen keine gemeinsamen

Elemente haben, gilt wegen deshalb

P ( E ) = P ({e1} ∪ {e2 } ∪ {e3 } ∪ …{em } )

= P ({e1} ) + P {( e2 )} + … P ({em } )

= P ( e1 ) + P ( e2 ) + … P ( em ) gem. Def. 5.2' der Ergebniswahrscheinlichkeit.

Es ist ferner W ∪ ∅ = W , also

P (W ∪ ∅ ) = P (W ) , d.h. wegen Additivität

P (W ) + P ( ∅ ) = P(W )

⇒ P ( ∅ ) = 0.

Fängt man so mit Ereigniswahrscheinlichkeiten an, so nennt man die Werte der Ergebniswahrscheinlichkeiten auch „diskrete Dichte“.

Reflexion über die beiden unterschiedlichen Aufbaumöglichkeiten der Theorie

Nachdem wir Satz 5.1’ bewiesen haben, sind wir also wieder auf dem gleichen Stand wie bei

unserem Aufbau.

Aus elementarer Sicht spricht nichts gegen einen Start mit Ergebniswahrscheinlichkeiten, die

dann zu Ereigniswahrscheinlichkeiten konstruktiv (durch Definition) ausgebaut werden. Im

zweiten Weg geht man abstrakt und hypothetisch davon aus, dass man für alle Ereignisse

Wahrscheinlicheiten hat und zeigt dann, dass man „eigentlich“ nur die Wahrscheinlichkeiten

für die Ergebnisse bzw. die Elementarereignisse benötigt.

Viele Hochschullehrbücher starten mit den Ereigniswahrscheinlichkeiten. Das liegt daran,

dass man diesen Zugang verallegmeinern kann, den Start mit Ergebniswahrschinlichkeiten

aber nicht.

Beispielhaft betrachten wir dazu noch einmal das

Glücksrad von einer etwas anderen Warte. In der

Literatur wird das Folgende unter dem Begriff

der geometrischen Wahrscheinlichkeit diskutiert.

Wir haben uns vorgestellt, dass das Glücksrad an

einer Markierung anhält und dass wir dann sehen, in welchem der m Sektoren es gestoppt hat.

Wir können das Glücksrad aber auch so modellieren, das wir jedem Punkt seiner Peripherie eine Zahl zwischen 0 und 2π zuordnen, nämlich

den Winkel im Winkelmaß bezogen auf z.B. die

Horizontale. Als Ergebnismenge können wir

dann das Intervall [ 0, 2π ) betrachten. 2π nehmen wir nicht mit dazu, weil wir sonst eine Verdopplung der Stelle hätten, der schon der Winkel 0 zugeordnet ist. Wir stellen uns vor, dass

alle diese Ergebnisse „gleichmöglich“ sind. Die Wahrscheinlichkeit, dass man in einem Sektor ( a, b ) ⊂ [ 0, 2π ) landet, entspricht dann offenbar dem Längenanteil, also dem Quotienten

Elementare Stochastik

Rolf Biehler

WS 2006/2007

46

b−a

. Jedem Intervall I der Form ( a, b ) ⊂ [ 0, 2π ) oder endlichen Vereinigungen davon, kann

2π

Länge ( I )

man dann also „Wahrscheinlichkeiten“ folgendermaßen zuordnen: P ( I ) :=

.

2π

Es ist schon anschaulich klar, dass alle der Eigenschaften aus Def. 5.1’ gelten. Die Additivität

folgt einfach aus der Additivität von Längen. Geht man von diesen Voraussetzungen aus,

welche Wahrscheinlichkeit haben dann Ergebnisse w ∈ [ 0, 2π ) ? Wir werden zeigen, dass

hierfür nach unserer Modellierung die Wahrscheinlichkeit 0 ist. Wir können um jedes

1

1⎞

⎛

w ∈ ( 0, 2π ) ein kleines Intervall I n = ⎜ w − , w − ⎟ legen, für alle n größer als einem ben

n⎠

⎝

2

stimmtem n. Es folgt dann aus {w} ⊂ I n , dass P ({w} ) ≤ P ( I n ) = n . Da n beliebig klein ge2π

wählt werden kann, kann also nur P ( w ) = P ({w} ) = 0 sein.

Es entsteht also folgendes Paradoxon: Für jedes einzelne Ergebnis aus w ∈ [ 0, 2π ) ist die

Wahrscheinlichkeit 0 es zu erhalten, während z.B. die Wahrscheinlichkeit irgendein Ergebnis

aus [ 0, 2π ) zu erhalten, 1 ist. Die Aussage P ( I ) = ∑ P ( w ) , die dem Satz 5.1’ entspricht, ist

w∈I

jetzt nicht mehr gültig, ohnehin hätte man zu klären, wie man die überabzählbar unendlich

vielen Summanden für alle w ∈ I „summiert“. Diese Situation hat auch in der Geschichte der

Stochastik Verwirrung gestiftet.

Es hat sich aber herausgestellt, dass man die Definition 5.1’ auch auf überabzählbar unendlich große Ergebnismengen erweitern kann. Im allgemeinen kann man dann aber nicht allen

Teilmengen von W sinnvoll Wahrscheinlichkeiten zuordnen (so wie man auch nicht allen

merkwürdigen Figuren Flächeninhalte zuordnen kann).

Die geometrische Wahrscheinlichkeit mit der intuitiven Vorstellung, dass alle Punkte der

Glücksradperipherie „gleichmöglich“ sind kann mathematisch durch entsprechende Ereigniswahrscheinlichkeiten modelliert werden.

5.4 Simulation von endlichen Wahrscheinlichkeiträumen

Urnen simulieren Glücksräder

Ein Laplace-Modell konnte mit einer Urne simuliert werden, ein allgemeiner endlicher Wahrscheinlichkeitsraum mithilfe eines idealen Glücksrades. Angenommen wir haben eine Ergebnismenge W = {w1, w2 ,… wk } mit P ( w1 ) + P ( w2 ) + … P ( wk ) = 1 .

In dem Fall, dass alle pi := P ( wi ) rational sind, kann man sicher einen Hauptnenner n finden,

so dass pi =

ni

für alle 1 ≤ i ≤ k gilt. Wir legen dann n Kugeln in eine Urne mit folgender Vern

teilung.

Hiermit wird die Urne hinsichtlich der Wahrscheinlichkeiten für die Ergebnisse w1, w2 ,… wk

äquivalent zum Glücksrad.

Elementare Stochastik

Rolf Biehler

WS 2006/07

5 Grundbegriffe der Wahrscheinlichkeitstheorie

47

Typ

Anzahl

w1

n1

w2

n2

wk

nk

Der Fall, das einzelne Wahrscheinlichkeiten bei endlichen Ergebnismengen irrational sind, ist

theoretisch denkbar und kommt auch theoretisch vor. Aber da man irrationale Zahlen beliebig

gut durch rationale approximieren kann, würde man in der praktischen Simulation mit entsprechenden Approximationen arbeiten können.

In Fathom kann man die Urnenziehung über eine Zufallsmaschine Zufallswahl ( ) realisieren, da hier aber nur 10 verschiedene Elemente auflistbar sind, sind diese Möglichkeiten

sehr begrenzt. Allgemeiner ist es, zunächst eine Kollektion als Urne zu füllen und dann daraus

Stichproben zu ziehen.

Einfach ist es, die Werte manuell in eine Spalte

mit n Fällen so häufig einzutragen, wie sie vorkommen sollen. Dies kann man mit dem

Transform-Kommando automatisieren etwa

wie folgt für den Fall k = 4.

Urne

Kugelbeschriftung

=

<n

⎧ ( ? < n1 )

: "w1"

⎪ ( ? < n1 + n2 )

: "w2"

transform ( Index) ⎨

(

?

<

n1

+

n2

+

n3

)

: "w3"

⎪

: "w4"

⎩sonst

Man beachte, dass man in der zweiten Zeile

n1 + n2 nehmen muss, damit genau n2 Fällen die

Ausprägung w2 zugeordnet wird, denn bei

transform wird die Bedingung der zweiten Zeile nur auf diejenigen Fälle angewendet, die

in der ersten Zeile noch nicht behandelt wurden. Es müssen dann n = n1 + n2 + n3 + n4 Fälle zur

Kollektion hinzugefügt werden.

Eine andere Möglichkeit ist die Verwendung des Kommandos Zufallszahl( ), das nun

erklärt werden soll. Dies steht in der meisten Software unter dem Namen random( )zur

Verfügung.

Das Kommando Zufallszahl( )

Eine erste Modellvorstellung ist: Zufallszahl( ) erzeugt zufällig eine Zahl zwischen 0

und 1. Das heißt, für ein Intervall ( a, b ) ⊂ [ 0,1) ist die Wahrscheinlichkeit, dass ein Ergebnis

in ( a, b ) landet gleich P ( a, b ) = b − a ,

Urne

ähnlich wie das bei der geometrischen

Wahrscheinlichkeit beim Glücksrad war.

Die Wahrscheinlichkeit für jede einzelne

Zahl ist dabei gleich 0. Diese Wahrscheinlichkeitsverteilung nennt man auch geometrische Gleichverteilung auf dem Intervall [ 0,1) .

Elementare Stochastik

Kugelbeschriftung

=

Rolf Biehler

<n

⎧ ( ? < p1 )

⎪ ( ? < p1 + p2 )

transform ( Zufallszahl ( ) ) ⎨

⎪ ( ? < p1 + p2 + p3 )

⎩sonst

WS 2006/2007

48

Auf diese Weise kann man nun einen endlichen Wahrscheinlichkeitsraum mit k = 4 direkt mit

einer Zufallsmaschine wie rechts simulieren.

Mit Reglern kann man auch eine Simulationsumgebung mit variablen Wahrscheinlichkeiten

aufbauen. Wir haben 1000 Mal simuliert und ausgewertet.

Mathematischer Hintergrund zu Zufallszahlen

Wählt der Computer nun wirklich zufällig eine reelle Zahl zwischen 0 und 1 aus? Die Zahlen,

die der Computer ausgibt, sind alles endliche Dezimalzahlen, die intern mit einer bestimmten

Genauigkeit erzeugt werden. Angenommen der Computer rechnet mit 20 Stellen. Dann unterscheidet der Rechner im Intervall [ 0,1) insgesamt 1020 verschiedene Zahlen, nämlich die Zahlen 0 ⋅10−20 ,1 ⋅10−20 , 2 ⋅10−20 ,… , (1020 − 1) ⋅10−20 . Dabei ist (1020 − 1) eine Zahl mit 20 9er Zif-

fern. Man kann sich vorstellen, dass der Computer aus einer Urne mit 1020 Kugeln eine herauspickt. Wie viele Zahlen fallen davon ins Intervall ( a, b ) ⊂ [ 0,1) ? Offenbar ziemlich genau,

wenn auch in der Regel nicht perfekt, (b − a) ⋅1020 Zahlen. Damit ist die Wahrscheinlichkeit,

dass ein Ergebnis in ( a, b ) landet, (b − a) , wobei man hier einen maximalen Fehler von etwa

10−20 macht, was praktisch unerheblich ist.

Wir können also den kontinuierlichen Fall, die geometrische Wahrscheinlichkeit, beliebig genau mit enorm großen idealen Urnen sehr genau simulieren. Auch für unsere Modellierung

des Glücksrades hätten wir dies in 1020 kleine Sektoren unterteilt denken können. Das wäre

dann eine Modellierung mit einem endlichen Laplacemodell gewesen. Das reicht zwar für alle

praktischen Zwecke aus. Trotzdem hat es sich für die mathematische Theorie sehr nützlich

erwiesen, auch geometrische Wahrscheinlichkeiten einzubeziehen, ähnlich wie es für die Beschreibende Statistik nützlich war, numerische Merkmale mit Werten in den reellen Zahlen zu

betrachten, auch wenn man in der Praxis mit endlichen vielen Zahlen als Messergebnis auskommt.

Eine andere Frage ist, wie die Zufallszahlen real erzeugt werden, denn der Computer ist im

Kern ein deterministisches Gerät. Nach einem Startwert, der aus bestimmten Angaben, z.B.

der Zeit errechent wird, liegt die vom Computer generierte Zahlenfolge genau fest. Man nennt

die Zahlen deshalb auch Pseudozufallszahlen. Bei einem guten Zufallsgenerator kann man die

Zahlen aber praktisch nicht von realen Zufallsdaten unterscheiden. Um das zu beurteilen sind

spezielle Tests auf Zufälligkeit in Gebrauch.

Elementare Stochastik

Rolf Biehler

WS 2006/07