14. Lernen in Neuronalen und Bayesschen Netzen

Werbung

Einführung in die Künstliche Intelligenz

Seite 126

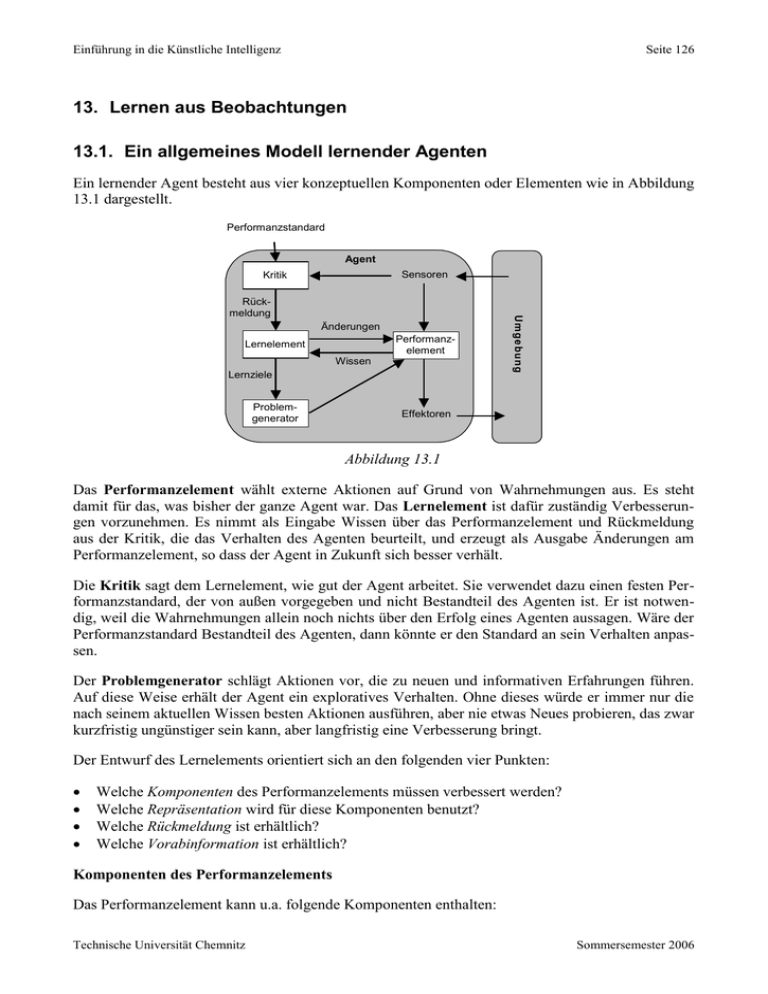

13. Lernen aus Beobachtungen

13.1. Ein allgemeines Modell lernender Agenten

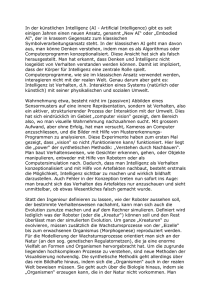

Ein lernender Agent besteht aus vier konzeptuellen Komponenten oder Elementen wie in Abbildung

13.1 dargestellt.

Performanzstandard

Agent

Sensoren

Kritik

Änderungen

Performanzelement

Lernelement

Wissen

Lernziele

Problemgenerator

Umg ebu ng

Rückmeldung

Effektoren

Abbildung 13.1

Das Performanzelement wählt externe Aktionen auf Grund von Wahrnehmungen aus. Es steht

damit für das, was bisher der ganze Agent war. Das Lernelement ist dafür zuständig Verbesserungen vorzunehmen. Es nimmt als Eingabe Wissen über das Performanzelement und Rückmeldung

aus der Kritik, die das Verhalten des Agenten beurteilt, und erzeugt als Ausgabe Änderungen am

Performanzelement, so dass der Agent in Zukunft sich besser verhält.

Die Kritik sagt dem Lernelement, wie gut der Agent arbeitet. Sie verwendet dazu einen festen Performanzstandard, der von außen vorgegeben und nicht Bestandteil des Agenten ist. Er ist notwendig, weil die Wahrnehmungen allein noch nichts über den Erfolg eines Agenten aussagen. Wäre der

Performanzstandard Bestandteil des Agenten, dann könnte er den Standard an sein Verhalten anpassen.

Der Problemgenerator schlägt Aktionen vor, die zu neuen und informativen Erfahrungen führen.

Auf diese Weise erhält der Agent ein exploratives Verhalten. Ohne dieses würde er immer nur die

nach seinem aktuellen Wissen besten Aktionen ausführen, aber nie etwas Neues probieren, das zwar

kurzfristig ungünstiger sein kann, aber langfristig eine Verbesserung bringt.

Der Entwurf des Lernelements orientiert sich an den folgenden vier Punkten:

Welche Komponenten des Performanzelements müssen verbessert werden?

Welche Repräsentation wird für diese Komponenten benutzt?

Welche Rückmeldung ist erhältlich?

Welche Vorabinformation ist erhältlich?

Komponenten des Performanzelements

Das Performanzelement kann u.a. folgende Komponenten enthalten:

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 127

1.

2.

3.

4.

5.

6.

Eine direkte Abbildung von Bedingungen über den aktuellen Zustand auf Aktionen.

Ein Hilfsmittel zur Ableitung relevanter Eigenschaften der Welt aus Wahrnehmungsfolgen.

Informationen über die Art und Weise, wie sich die Welt entwickelt.

Informationen über die Ergebnisse möglicher Aktionen des Agenten.

Nützlichkeitsinformationen, die die Wünschbarkeit von Weltzuständen anzeigen.

Aktion-Wert-Informationen, die die Wünschbarkeit spezieller Aktionen in speziellen Zuständen

anzeigen.

7. Ziele, die Klassen von Zuständen definieren, deren Erreichen den Nutzen des Agenten maximieren.

Jede dieser Komponenten kann gelernt werden, wenn das entsprechende Feedback gegeben ist. Bei

Komponente 4 etwa erhält der Agent den Zustand der Welt als Feedback, der durch seine Aktion

entstanden ist. Er kann daraus eine Beschreibung der Ergebnisse seiner Aktionen ableiten. Wenn

die Kritik bei Komponente 5 mit Hilfe des Performanzstandards aus Wahrnehmungen Nutzenwerte

ableiten kann, dann kann der Agent daraus eine nützliche Repräsentation seiner Nutzenfunktion

lernen.

Der Performanzstandard kann als etwas betrachtet werden, dass eine Menge unterschiedener Wahrnehmungen definiert, die als direktes Feedback auf das Verhalten des Agenten interpretiert werden.

Schmerz und Hunger sind z.B. fest implementierte Performanzstandards in Lebewesen.

Die Komponenten können in unterschiedlicher Weise repräsentiert werden. Die bisher behandelten

Repräsentationsformen z.B. logische Sätze oder probabilistische Formalismen wie Bayessche Netze

kommen alle in Frage. Für alle sind Lernalgorithmen entwickelt worden, die sich im Detail unterscheiden aber in den Grundlagen ähnlich sind.

Bezüglich des Feedbacks, das bei einer Aktion eventuell zu bekommen ist, unterscheidet man

zwischen den Methoden des überwachten Lernens, Reinforcement Learning und nicht überwachten

Lernens. Beim überwachten Lernen kann der Agent das Ergebnis einer Aktion beobachten oder es

wird ihm mitgeteilt (Lernen mit Lehrer). Beim Reinforcement Learning erhält der Agent eine

Reaktion auf seine Aktion als Belohnung oder Bestrafung, aber es wird ihm nicht gesagt, was die

richtige Aktion ist, das muss er selbst herausfinden. Beim nicht überwachten Lernen erhält der

Agent kein Feedback über die Wirkung seiner Aktion, er kann nur Beziehungen zwischen seinen

Wahrnehmungen lernen. Er kann nicht lernen, was er tun soll, außer wenn er eine Nutzenfunktion

hat.

Menschen lernen praktisch immer auf der Basis von Vorwissen. Dies soll sogar für Neugeborene

zutreffen. Der Lerninhalt und der Lernerfolg werden auf jeden Fall vom Vorwissen beeinflusst.

Die sieben Komponenten des Performanzelements können als mathematische Funktionen beschrieben werden, z.B. die dritte als Funktion von Weltzuständen auf Weltzustände oder Ziele als Abbildung von Weltzuständen auf Boolesche Werte. Das bedeutet, dass alles Lernen als Erlernen der

Repräsentation einer Funktion betrachtet werden kann.

13.2. Induktives Lernen

Beim überwachten Lernen bekommt der Lerner eine Menge von Beispielen vorgelegt und soll

daraus eine Funktion erlernen. Die Beispiele haben die Form von Paaren (x, f(x)). x ist die Eingabe

und f(x) die Ausgabe der zu lernenden Funktion. Die reine induktive Inferenz (kurz Induktion)

besteht aus der folgenden Aufgabe: Bestimme auf Grund einer Menge von Beispielen von f eine

Funktion h, genannt Hypothese, die f approximiert.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 128

Im Allgemeinen können viele Hypothesen aus Beispielen generiert werden. Wird einer Hypothese

gegenüber einer anderen der Vorzug gegeben, dann heißt dies ein Bias. Weil es fast immer eine

große Zahl möglicher konsistenter Hypothesen gibt, haben alle Lernalgorithmen einen irgendwie

gearteten Bias.

Die einfachste Form eines lernenden Agenten ist ein reflexiver lernender Agent. Er kann (Wahrnehmung, Aktion)-Paare lernen. Die Grundstruktur eines solchen Agenten besteht aus einem REFLEXPERFORMANCE-ELEMENT und einem REFLEX-LEARNING-ELEMENT.

global Beispiele {}

function REFLEX-PERFORMANCE-ELEMENT(Wahrnehmung) returns eine Aktion

if (Wahrnehmung, Aktion) in Beispiele then return Aktion

else h INDUCE(Beispiele)

return h(Wahrnehmung)

procedure REFLEX-LEARNING-ELEMENT(Wahrnehmung, Aktion)

inputs: Wahrnehmung

Feedback Wahrnehmug

Aktion

Feedback Aktion

Beispiele Beispiele {(Wahrnehmung, Aktion)}

In den folgenden Abschnitten werden Lernalgorithmen behandelt, die sich für unterschiedliche

Formen der Repräsentation der Hypothesen eignen. Für die Repräsentation als logische Sätze

kommen Entscheidungsbaum-Methoden und der Versionsraum-Ansatz in Frage. Für die Repräsentation als nichtlineare numerische Funktionen kommen Neuronale Netze in Frage. Eine weitere

Form sind Lernalgorithmen für Bayessche Netze.

13.3. Lernen von Entscheidungsbäumen

13.3.1. Entscheidungsbäume als Performanzelemente

Ein Entscheidungsbaum nimmt als Eingabe ein Objekt oder eine Situation, beschrieben durch eine

Menge von Eigenschaften, und erzeugt als Ausgabe eine Ja/Nein-Entscheidung. Entscheidungsbäume repräsentieren also Boolesche Funktionen, es können aber auch höherwertige Funktionen

repräsentiert werden. Ein innerer Knoten eines Entscheidungsbaums entspricht einem Test auf den

Wert einer der Eigenschaften und die nach unten von dem Knoten wegführenden Kanten sind mit

den möglichen Werten der Eigenschaft markiert. Ein Blattknoten entspricht einem Booleschen

Wert, der als Ergebnis ausgegeben wird, wenn das Blatt erreicht wird.

Als ein Beispiel wird das Entscheidungsproblem betrachtet, ob man in einem Restaurant auf einen

freien Tisch warten soll, wenn alle Tische besetzt sind. Man möchte also eine Definition für das

Zielprädikat Warten in Form eines Entscheidungsbaums lernen. Zunächst müssen die Eigenschaften oder Attribute festgelegt werden, mit denen die Beispiele beschrieben werden. Die folgenden Attribute werden gewählt:

1.

2.

3.

4.

5.

Alternative: Gibt es in der Nähe ein geeignetes anderes Restaurant?

Bar: Gibt es in dem Restaurant eine komfortable Bar zum Warten?

Fr/Sa: Ist Freitag oder Samstag?

Hungrig: Bin ich hungrig?

Gäste: Wie viele Leute sind im Restaurant (keine, einige oder voll)?

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 129

Preis: In welchem Preissegment liegt das Restaurant (€, €€, €€€)?

Regen: Regnet es draußen?

Reservierung: Habe ich reserviert?

Typ: Um welche Art von Restaurant handelt es sich (Französisch, Italienisch, Chinesisch oder

Burger)?

10. Wartezeit: Welche voraussichtliche Wartezeit wird vom Restaurant geschätzt?

6.

7.

8.

9.

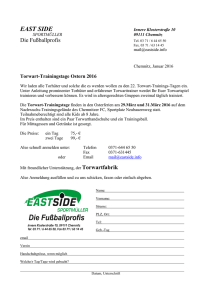

Ein Entscheidungsbaum für das Problem könnte z.B. der in Abbildung 13.2 dargestellte sein. Die

Attribute Preis und Typ sind darin nicht benutzt, weil sie angesichts der Datenlage irrelevant sind.

Der Baum kann in eine Menge von Implikationen (8 insgesamt) umgesetzt werden, die den Pfaden

von der Wurzel zu den mit Ja markierten Blättern entsprechen. Zum Beispiel ergibt der Pfad über

die Knoten Wartezeit und Hungrig die Implikation

r Gäste(r, Voll) Wartezeit(r, 10-30) Hungrig(r, Nein) Warten(r)

Gäste?

Keine

Einige

Nein

Ja

Voll

Wartezeit?

>60

0-10

30-60

Nein

10-30

Alternative?

Nein

Ja

Reservierung?

Nein

Ja

Bar?

Ja

Nein

Ja

Nein

Ja

Hungrig?

Fr/Sa?

Nein

Nein

Ja

Nein

Ja

Ja

Alternative?

Ja

Nein

Ja

Ja

Ja

Regen?

Nein

Nein

Ja

Ja

Abbildung 13.2

13.3.2. Ausdruckskraft von Entscheidungsbäumen

Entscheidungsbäume repräsentieren Mengen von Implikationen, sie können aber nicht beliebige

Mengen von Sätzen der Logik erster Stufe repräsentieren, da sie prinzipiell nur Aussagen über

einzelne Objekte machen können, niemals gleichzeitig über mehrere Objekte. Die Entscheidungsbaum-Sprache ist im Wesentlichen aussagenlogisch.

Die Ausdruckskraft der Entscheidungsbäume entspricht genau der Aussagenlogik, d.h. jede Boolesche Funktion oder jeder aussagenlogische Satz kann als Entscheidungsbaum dargestellt werden.

Man braucht nur von der Wahrheitstabelle der Booleschen Funktion auszugehen und jede Zeile als

Pfad in einem Entscheidungsbaum darzustellen.

Bei manchen Booleschen Funktionen ist aber die Wiedergabe als Entscheidungsbaum sehr aufwändig. Zur Darstellung der Paritätsfunktion zum Beispiel, die eine 1 ausgibt, wenn geradzahlig viele

Eingaben 1 sind, wäre ein exponentiell großer Entscheidungsbaum notwendig. Auch die Repräsentation der Majoritätsfunktion, die eine 1 ausgibt, wenn mehr als die Hälfte ihrer Eingaben 1 ist, ist

schwierig.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 130

13.3.3. Induktion von Entscheidungsbäumen aus Beispielen

Ein Beispiel wird durch die Werte der Attribute und den Wert des Zielprädikats beschrieben. Der

Wert des Zielprädikats heißt Klassifikation des Beispiels. Ist der Wert wahr für ein Beispiel, so

heißt dieses ein positives Beispiel, andernfalls ein negatives Beispiel. Die gesamte Menge der

Beispiele heißt Trainingsmenge. Tabelle 13.1 enthält die Beispiele für das Restaurant-Beispiel.

Beispiele Alternative

X1

Ja

X2

Ja

X3

Nein

X4

Ja

X5

Ja

X6

Nein

X7

Nein

X8

Nein

X9

Nein

X10

Ja

X11

Nein

X12

Ja

Bar

Nein

Nein

Ja

Nein

Nein

Ja

Ja

Nein

Ja

Ja

Nein

Ja

Fr/Sa Hungrig

Nein

Ja

Nein

Ja

Nein Nein

Ja

Ja

Ja

Nein

Nein

Ja

Nein Nein

Nein

Ja

Ja

Nein

Ja

Ja

Nein Nein

Ja

Ja

Attribute

Gäste Preis Regen Reservierung

Einige €€€ Nein

Ja

Voll

€

Nein Nein

Einige

€

Nein Nein

Voll

€

Nein Nein

Voll

€€€ Nein

Ja

Einige €€

Ja

Ja

Keine

€

Ja

Nein

Einige €€

Ja

Ja

Voll

€

Ja

Nein

Voll

€€€ Nein

Ja

Keine

€

Nein Nein

Voll

€

Nein Nein

Typ

Franz

Chin

Burger

Chin

Franz

Ital

Burger

Chin

Burger

Ital

Chin

Burger

Ziel

Warte- Warten

zeit

0-10

Ja

30-60 Nein

0-10

Ja

10-30

Ja

>60

Nein

0-10

Ja

0-10

Nein

0-10

Ja

>60

Nein

10-30 Nein

0-10

Nein

30-60

Ja

Tabelle 13.1

Bei der Erstellung eines Entscheidungsbaums aus Beispielen kommt es darauf an, ein Muster zu

extrahieren, das eine große Zahl von Fällen in knapper Form beschreibt. Der Entscheidungsbaum

muss vor allem eine knappe, aber informationsreiche Repräsentation von Fällen sein und er sollte

alle Trainingsbeispiele erfassen. Dies ist ein Beispiel für ein allgemeines Prinzip des induktiven

Lernens, genannt Ockhams Rasiermesser: Die wahrscheinlichste Hypothese ist die einfachste, die

mit allen Beobachtungen konsistent ist.

Ein Entscheidungsbaum repräsentiert eine einfache Hypothese, wenn er möglichst klein ist. Das

Problem, den kleinsten Entscheidungsbaum zu finden, ist nicht lösbar. Aber man kann versuchen

einen möglichst kleinen zu finden. Zu diesem Zweck geht der DECISION-TREE-LEARNING-Algorithmus so vor, dass er immer das wichtigste Attribut zuerst testet. Damit ist dasjenige Attribut

gemeint, nach dem sich die Beispiele am stärksten unterscheiden. Auf diese Weise wird versucht

eine korrekte Klassifikation mit einer kleinen Menge von Tests zu bekommen, wodurch die Pfade

im Entscheidungsbaum kurz werden und der Baum insgesamt klein wird.

function DECISION-TREE-LEARNING(Beispiele, Attribute, Default) returns einen Baum

inputs: Beispiele

eine Menge von Beispielen

Attribute

eine Menge von Attributen

Default

ein Default-Wert für das Zielprädikat

if Beispiele ist leer then return Default

else if alle Beispiele haben die selbe Klassifikation then return die Klassifikation

else if Attribute ist leer then return MAJORITY-VALUE(Beispiele)

else

best CHOOSE-ATTRIBUTE(Attribute, Beispiele)

Baum ein neuer Entscheidungsbaum mit Wurzeltest best

for each Wert vi von best do

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 131

Beispielei {Elemente von Beispiele mit best = vi}

subtree DECISION-TREE-LEARNING(Beispielei, Attribute - best,

MAJORITY-VALUE(Beispiele))

füge einen Zweig zu Baum hinzu mit Marke vi und Teilbaum subtree

end

return Baum

Nachdem die erste Aufteilung der Testmenge durch das erste Attribut erfolgt ist, entstehen mehrere

neue Entscheidungsbaum-Lernprobleme mit weniger Beispielen und einem Attribut weniger. Die

Konstruktion des Entscheidungsbaums erfolgt also rekursiv. Vier Fälle sind dabei zu unterscheiden:

1. Wenn die Teilmenge einige positive und einige negative Beispiele enthält, dann wähle das beste

Attribut um sie weiter zu unterteilen.

2. Wenn alle Beispiele in der Teilmenge positiv sind (bzw. alle negativ), dann ist der Zweig des

Baums fertig. Man kann mit Ja (bzw. Nein) antworten.

3. Wenn die Teilmenge leer ist bedeutet dies, dass kein Beispiel mit der durch die bisher benutzten

Attribute beschriebenen Eigenschaften vorliegt. Es wird ein Defaultwert zurückgegeben, der auf

Grund der mehrheitlichen Klassifikation am Vorgängerknoten berechnet wird.

4. Wenn keine Attribute übrig sind aber die Teilmenge nicht leer ist und sowohl positive als auch

negative Beispiel enthält, bedeutet dies, dass diese Beispiele zwar verschiedene Klassifikation

haben, aber die gleichen Eigenschaften, zumindest so weit sie auf Grund der definierten Attribute beschreibbar sind. Dieser Fall tritt ein, wenn einige Daten falsch sind, d.h. wenn sie verrauscht sind, oder wenn die Attribute nicht genügend Information enthalten um die vorliegende

Situation zu beschreiben oder wenn die Domäne nicht deterministisch ist. In diesem Fall trift

man eine Mehrheitsentscheidung.

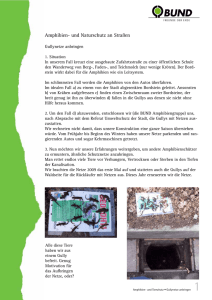

Konstruiert man den Entscheidungsbaum für die Beispiele von Tabelle 13.1 nach dieser Vorschrift,

dann erhält man den Entscheidungsbaum von Abbildung 13.3.

Gäste?

Keine

Einige

Nein

Ja

Voll

Hungrig?

Nein

Ja

Typ?

Nein

Französisch

Italienisch

Ja

Nein

Burger

Chinesisch

Fr/Sa?

Nein

Nein

Ja

Ja

Ja

Abbildung 13.3

Die Diskrepanz zwischen dem Ausgangsbaum und dem Ergebnisbaum ist sicher auch der kleinen

Anzahl von Beispielen zuzuschreiben. Mit mehr Beispielen dürfte der Unterschied geringer ausfallen. Der Baum von Abbildung 13.3 ist auch keine sehr gute Hypothese, denn z.B. kommt der Fall,

dass ein Restaurant voll und die Wartezeit 0 – 10 Minuten beträgt, gar nicht vor. Im Fall von

Hunger sagt der Baum, dass nicht gewartet werden soll, aber wenn die Wartezeit höchstens 10

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 132

Minuten beträgt, wird man in der Regel warten. Diese Beobachtung führt zu der Frage nach der

Korrektheit der Hypothese.

13.3.4. Abschätzung der Performanz des Lernalgorithmus

Die Qualität eines Lernalgorithmus kann danach eingeschätzt werden, wie gut er neue, vorher nicht

betrachtete Beispiele klassifiziert. Dazu muss die Klassifikation dieser Beispiele aber vorab bekannt

sein. Die Menge der Beispiele, die für diesen Zweck verwendet werden, heißt Testmenge. Diese

Menge reserviert man üblicherweise von vornherein für den Test, ansonsten müsste man nach

neuen Beispielen suchen und deren Klassifikation bestimmen. Im Einzelnen geht man in folgenden

Schritten vor:

1. Sammle eine große Menge von Beispielen.

2. Unterteile die Menge in zwei disjunkte Teilmengen, die Trainingsmenge und die Testmenge.

3. Erzeuge mit dem Lernalgorithmus auf der Basis der Trainingsmenge eine Hypothese H.

4. Bestimme den Prozentsatz der Beispiele in der Testmenge, die durch H korrekt klassifiziert

werden.

5. Wiederhole die Schritte 1. bis 4. für verschieden große und zufällig ausgewählte Trainingsmengen.

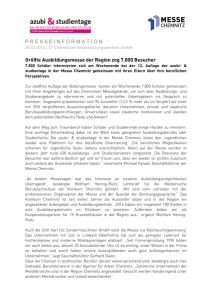

Durch Anwendung dieser Schritte erhält man eine Menge von Daten, auf Grund derer die durchschnittliche Vorhersagequalität als eine Funktion der Größe der Trainingsmenge angegeben werden

kann. Diese Funktion ergibt in grafischer Form dargestellt die so genannte Lernkurve des Algorithmus auf der betrachteten Domäne. Abbildung 13.4 zeigt den ungefähren Verlauf der Lernkurve für

den Algorithmus DECISION-TREE-LEARNING auf der Restaurant-Domäne.

100

90

Korrekt- 80

heit auf

der

70

Testmenge 60

in %

50

40

0

20

40

60

80

100

Größe der Trainingsmenge

Abbildung 13.4

13.3.5. Praktischer Gebrauch des Entscheidungsbaum-Lernens

Gas-Öl-Trenner

BP brachte 1986 ein Expertensystem mit Namen GASOIL zum Einsatz. Sein Zweck war der Entwurf

von Gas-Öl-Trennanlagen für Offshore-Ölplattformen. Die Trennung von Gas und Öl erfordert ein

sehr großes, komplexes und teures Trennsystem, dessen Entwurf eine Anzahl von Attributen

betrifft, u.a. die relativen Anteile von Gas, Öl und Wasser, die Flussrate, den Druck, die Dichte, die

Viskosität und die Temperatur. GASOIL enthielt ungefähr 2500 Regeln. Der Bau eines solchen

Expertensystems von Hand erfordert ungefähr 10 Personen-Jahre. Statt dessen wurde ein Entscheidungsbaum-Lernverfahren auf eine Datenbasis von existierenden Entwürfen angewandt. Damit

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 133

wurde das Expertensystem in 100 Personen-Tagen entwickelt. Es soll besser sein als menschliche

Experten und viele Millionen Dollar eingespart haben.

Fliegen lernen im Flugsimulator

Sammut et al. entwickelten 1992 einen automatischen Piloten für eine Cessna. Die Beispieldaten

wurden durch Beobachtung von drei erfahrenen Piloten im Flugsimulator gewonnen. Jeder der

Piloten führte 30 Minuten lang einen vordefinierten Flugplan aus. Jedes Mal wenn ein Pilot eine

Steueraktion durchführte indem er eine Steuervariable setzte, z.B. Schub oder Flügelklappen, wurde

ein Beispiel erzeugt. Insgesamt wurden 90000 Beispiele erzeugt, jedes durch 20 Zustandsvariable

beschrieben und mit der durchgeführten Aktion markiert. Aus den Beispielen wurde mit Hilfe des

C4.5-Algorithmus ein Entscheidungsbaum erzeugt. Der Baum wurde in ein C-Programm umgesetzt

und dieses in die Steuerschleife des Flugsimulators integriert, so dass das Programm das Flugzeug

selbst fliegen konnte.

Die Ergebnisse waren überraschend. Das Programm konnte nicht nur fliegen, sondern sogar besser

fliegen als die menschlichen Lehrer. Der Grund dafür ist, dass beim Lernen gelegentliche Fehler der

einzelnen Menschen durch Verallgemeinerung ausgeglichen wurden. Das deutet an, dass für

schwierige Aufgaben wie das Fliegen von Hubschraubern, die schwere Lasten bei starkem Wind

tragen, mit den Methoden des Maschinellen Lernens Autopiloten entwickelt werden könnten. Bis

jetzt gibt es solche nicht und es gibt auch nur wenige menschliche Piloten dafür.

13.4. Die Verwendung der Informationstheorie

13.4.1. Das Prinzip des Informationsgewinns

Zur Implementierung der CHOOSE-ATTRIBUTE-Funktion benötigt man ein Maß für gute und unnütze

Attribute. Dieses Maß muss seinen größten Wert für perfekte Attribute und seinen kleinsten Wert

für völlig wertlose Attribute haben. Ein solches Maß ist der erwartete Gehalt an Information, der

von einem Attribut geliefert wird. Der Begriff Information ist dabei im Sinne der Shannonschen

Informationstheorie zu verstehen. Eine Information in diesem Sinn ist eine Antwort auf eine Frage.

Wenn man eine auf die Frage schon relativ gut zutreffende Vermutung hat, dann ist die Antwort

weniger informativ als wenn man überhaupt nichts weiß.

In der Informationstheorie wird der Gehalt einer Information in Bits gemessen. Ein Bit Information

genügt um eine Ja/Nein-Frage zu beantworten, über deren Antwort man keinerlei Vorstellung hat,

wie dem Fall einer Münze. Wenn die möglichen Antworten vi auf die Frage die Wahrscheinlichkeiten P(vi) haben, dann ist der Informationsgehalt I der tatsächlichen Antwort definiert durch

n

I ( P(vi ),..., P(vn )) P(vi ) log 2 P(vi )

i 1

Dies ist der durchschnittliche Informationsgehalt der verschiedenen Antworten (die log 2 P -Ausdrücke), gewichtet mit den Wahrscheinlichkeiten der Antworten.

Beim Entscheidungsbaum-Lernen ist die zu beantwortende Frage: Was ist die korrekte Klassifikation für ein gegebenes Beispiel? Ein korrekter Entscheidungsbaum liefert die Antwort. Eine Schätzung der Wahrscheinlichkeiten der möglichen Antworten vor dem Test der Attribute ist durch das

Verhältnis der positiven und negativen Beispiele in der Trainingsmenge gegeben. Angenommen,

die Trainingsmenge enthalte p positive und n negative Beispiele. Dann wird der Informationsgehalt

einer korrekten Antwort wie folgt abgeschätzt:

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 134

p

n

p

p

n

n

I

,

log 2

log 2

pn

pn pn

pn

pn pn

Der Test eines einzelnen Attributs gibt im Allgemeinen nicht so viel Information, aber immerhin

einen Teil davon. Das Maß an Information, das ein Attribut liefert, wird daran gemessen, wie viel

Information nach dem Attributtest für eine korrekte Antwort noch benötigt wird. Jedes Attribut A

unterteilt die Trainingsmenge E in die Teilmengen E1, ..., Ev, entsprechend ihren Werten für A,

wobei angenommen ist, dass A v verschiedene Werte haben kann. Jede Teilmenge Ei enthält pi

positive und ni negative Beispiele. Wenn man also auf dem i-ten Zweig des Baums fortfährt,

benötigt man zusätzlich I ( pi ( pi ni ) , ni ( pi ni )) Bits an Information um die Frage zu beantworten. Ein zufällig ausgewähltes Beispiel hat mit der Wahrscheinlichkeit ( pi ni ) ( p n) den iten Wert des Attributs, deshalb benötigt man im Durchschnitt nach dem Test des Attributs A

v

Rest ( A)

i 1

pi ni pi

ni

I

,

p n pi ni pi ni

Bits an Information um das Beispiel zu klassifizieren. Der Informationsgewinn aus dem Attributtest ist definiert durch die Differenz zwischen dem ursprünglichen Informationsbedarf und dem

neuen Informationsbedarf:

p

n

Re st ( A)

Gain( A) I

,

pn pn

Die Heuristik, die in der CHOOSE-ATTRIBUTE-Funktion benutzt wird, ist, das Attribut mit dem größten Informationsgewinn zu wählen.

13.4.2. Rauschen und Overfitting

Wenn es bei einem Lernproblem eine große Menge möglicher Hypothesen gibt, besteht die Gefahr,

dass man beim Lernen bedeutungslose Regelmäßigkeiten in den Daten entdeckt. Dieses Problem

heißt Overfitting. Es ist ein sehr allgemeines Phänomen und kann in allen möglichen Lernverfahren vorkommen, nicht nur bei Entscheidungsbäumen.

Eine einfache Technik zur Vermeidung des Overfitting ist das Pruning. Durch das Pruning wird

verhindert, dass Attribute für die Aufteilung einer Menge verwendet werden, die nicht wirklich

relevant sind, selbst wenn die Beispiele an diesem Knoten nicht uniform klassifiziert sind. Die

Frage ist, wie irrelevante Attribute entdeckt werden. Der Informationsgewinn bietet dafür eine

Möglichkeit. Angenommen man teilt eine Menge von Beispielen mit einem irrelevanten Attribut

auf. Die entstehenden Teilmengen haben dann in der Regel etwa dieselbe Verteilung von positiven

und negativen Beispielen wie die ursprüngliche Menge. Dann ist der Informationsgewinn annähernd Null. Damit stellt sich umgekehrt die Frage, ab welchem Informationsgewinn es sich lohnt,

ein Attribut zur Aufteilung der Beispielmenge zu verwenden.

Mit dieser Frage beschäftigen sich statistische Signifikanztests. Ein Signifikanztest beginnt mit der

Annahme, es gebe in den vorliegenden Beispielen kein zugrunde liegendes Muster (so genannte

Nullhypothese). Dann werden die Daten analysiert um festzustellen, wie weit sie vom vollständigen Fehlen eines Musters abweichen. Wenn der Grad der Abweichung statistisch unwahrscheinlich

ist, dann besteht beträchtliche Evidenz für das Vorliegen eines signifikanten Musters in den Daten.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 135

Im Fall der Entscheidungsbäume ist die Nullhypothese, dass das gerade betrachtete Attribut irrelevant ist und damit der Informationsgewinn für eine unendlich große Menge von Beispielen Null.

Nun muss die Wahrscheinlichkeit dafür berechnet werden, dass unter Annahme der Nullhypothese

eine Beispielmenge der Größe v die beobachtete Abweichung von der erwarteten Verteilung der

positiven und negativen Beispiele zeigt. Die Abweichung kann man messen, indem man die tatsächlichen Anzahlen positiver und negativer Beispiele in jeder Teilmenge, also pi und ni, mit den

erwarteten Zahlen p̂ i und n̂i vergleicht, wobei man vollständige Irrelevanz voraussetzt:

pˆ i p

p i ni

pn

nˆ i n

p i ni

pn

Ein Maß für die Gesamtabweichung ist definiert durch

v

D

i 1

( pi pˆ i ) 2 (ni nˆ i ) 2

pˆ i

nˆ i

Unter der Nullhypothese ist der Wert von D entsprechend der 2-Verteilung mit v – 1 Freiheitsgraden verteilt. Mit Hilfe von 2-Tabellen oder statistischer Software kann dann berechnet werden mit

welcher Wahrscheinlichkeit ein Attribut wirklich irrelevant ist.

Pruning hat auch Vorteile, wenn Daten verrauscht sind. Bei stark verrauschten Daten liefern Bäume

mit Pruning bessere Ergebnisse als solche ohne Pruning. Bäume mit Pruning sind meist wesentlich

kompakter und deshalb auch besser zu verstehen.

13.4.3. Erweiterung der Anwendbarkeit von Entscheidungsbäumen

Um den Einsatzbereich des Entscheidungsbaum-Lernens zu erweitern muss man Maßnahmen ergreifen um fehlende Daten zu ergänzen und um Attribute mit besonderen Eigenschaften verwendbar

zu machen.

Fehlende Daten In vielen Anwendungsbereichen sind nicht alle Attributwerte für jedes Beispiel

bekannt. Das kann daran liegen, dass sie nicht erfasst wurden oder dass es zu aufwändig ist sie

zu ermitteln. Hier sind zwei Probleme zu lösen: 1. Wie modifiziert man die Konstruktion des

Entscheidungsbaums, insbesondere die Definition des Informationsgewinns, wenn bei einigen

Beispielen Attributwerte fehlen? 2. Wie klassifiziert man ein neues Beispiel mit einem bestehenden Entscheidungsbaum, wenn eines der Testattribute nicht anwendbar ist?

Attribute mit vielen Werten Ist die Zahl der Werte eines Attributs sehr hoch, dann kann der

Extremfall eintreten, dass das Attribut für jedes Beispiel einen eigenen Wert hat und damit

lauter einelementige Mengen entstehen. Der Informationsgewinn hätte dann für dieses Attribut

den höchsten Wert. Trotzdem wäre das Attribut irrelevant oder nutzlos. Um solche Attribute zu

behandeln kann man den Gain Ratio verwenden.

Attribute mit kontinuierlichen Werten Manche Attribute haben kontinuierliche Wertebereiche, z.B. Attribute wie Größe oder Gewicht. Um sie für das Entscheidungsbaum-Lernen verwendbar zu machen diskretisiert man üblicherweise die Wertebereiche. Das wird meistens von

Hand gemacht. Eine bessere Methode ist, die Attribute im Rahmen des Lernprozesses vorab zu

behandeln um herauszufinden, welche Unterteilung des Wertebereichs die nützlichste Information für die Zwecke der Klassifikation liefert.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 136

13.5. Das Erlernen allgemeiner logischer Beschreibungen

13.5.1. Hypothesen

Ausgangspunkt der Suche nach Hypothesen ist ein einstelliges Zielprädikat, das Q genannt wird.

Nun wird versucht, einen äquivalenten logischen Ausdruck zu finden, mittels dessen Beispiele

korrekt klassifiziert werden können. Jeder Vorschlag für einen solchen Ausdruck wird als Hypothese betrachtet, der Ausdruck selbst heißt ein Kandidat für das Zielprädikat. Ci bezeichne einen

Kandidaten (das muss kein atomarer Satz sein), dann ist eine Hypothese ein Satz der Form

x Q(x) Ci(x)

Der Hypothesenraum ist die Menge aller Hypothesen, die der Lernalgorithmus auf Grund seines

Entwurfs darstellen kann. Der Algorithmus DECISION-TREE-LEARNING z.B. kann jede Hypothese

darstellen, die sich auf der Basis der vorgegebenen Attribute als Entscheidungsbaum darstellen

lässt, sein Hypothesenraum besteht deshalb aus allen diesen Entscheidungsbäumen. Ein Hypothesenraum {H1, ..., Hn} wird allgemein mit dem Symbol H bezeichnet. Der Lernalgorithmus nimmt

an, dass eine der Hypothesen korrekt ist, d.h. er hält den Satz

H1 H2 H3 ... Hn

für wahr. Jede Hypothese setzt voraus, dass eine bestimmte Menge von Beispielen, und zwar die,

die die Definition des Kandidaten erfüllen, Beispiele für das Zielprädikat sind. Diese Beispielmenge

heißt Extension des Prädikats. Zwei Hypothesen mit unterschiedlichen Extensionen sind deshalb

logisch inkonsistent, denn sie unterscheiden sich in mindestens einem Beispiel, das sie voraussetzen. Haben zwei Hypothesen dieselbe Extension, dann sind sie logisch äquivalent.

13.5.2. Beispiele

Ein Beispiel ist ein Objekt, repräsentiert durch einen logischen Ausdruck, auf das das Zielprädikat

anwendbar ist oder nicht. Das i-te Beispiel wird mit Xi bezeichnet, es wird durch den Satz Di(Xi)

bezeichnet, wobei Di irgendein logischer Ausdruck mit einem Argument ist. Das Beispiel wird

durch den Satz Q(Xi) im positiven Fall und durch Q(Xi) im negativen Fall klassifiziert.

Die vollständige Trainingsmenge ist die Konjunktion aller die Beispiele repräsentierenden Sätze.

Eine Hypothese stimmt mit allen Beispielen überein, wenn sie logisch konsistent mit der Trainingsmenge ist. Das bedeutet, dass sie mit jedem Beispiel der Trainingsmenge konsistent sein muss. Um

den Begriff der Konsistenz mit einem Beispiel zu klären wird der umgekehrte Fall der Inkonsistenz

mit einem Beispiel betrachtet. Dieser Fall trifft in folgenden beiden Situationen zu:

Ein Beispiel ist falsch negativ für die Hypothese, wenn es nach der Hypothese negativ sein

müsste, in Wirklichkeit aber positiv ist.

Ein Beispiel ist falsch positiv für die Hypothese, wenn es nach der Hypothese positiv sein

müsste, in Wirklichkeit aber negativ ist.

In beiden Fällen ist das Beispiel inkonsistent mit der Hypothese. Ist das Beispiel eine korrekte

Beobachtung eines Fakts, dann kann die Hypothese als nicht zutreffend fallen gelassen werden.

Damit entspricht das Lernen genau der Resolution-Regel beim Inferieren, wobei die Disjunktion der

Hypothesen eine Klausel darstellt und das Beispiel ein Literal, das gegen ein Literal der Klausel

wegresolviert werden kann. Somit kann ein logisches Inferenzsystem aus einem Beispiel lernen

durch Eliminieren einer oder mehrerer Hypothesen.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 137

13.5.3. Current-best-hypothesis-Suche

Bei der Current-best-hypothesis-Suche wird eine einzelne Hypothese erstellt und sukzessive beim

Betrachten neuer Beispiele aktualisiert. Ist ein neues Beispiel falsch negativ, dann wird die Extension der Hypothese durch Generalisierung erweitert, so dass sie das neue Beispiel umfasst. Ist ein

neues Beispiel falsch positiv, dann wird die Extension der Hypothese durch Spezialisierung eingeschränkt, so dass sie das Beispiel nicht mehr umfasst.

Der folgende Algorithmus CURRENT-BEST-LEARNING realisiert die Current-best-hypothesis-Suche.

Nach jedem Generalisierungs- und Spezialisierungsschritt muss geprüft werden, ob die Hypothese

mit den übrigen Beispielen noch konsistent ist, denn bei der Veränderung der Extension der Hypothese kann es passieren, dass weitere positive Beispiele ausgeschlossen oder negative Beispiele

eingeschlossen werden.

function CURRENT-BEST-LEARNING(Beispiele) returns eine Hypothese

H eine Hypothese, die mit dem ersten Beispiel in Beispiele konsistent ist

for each restliches Beispiel e in Beispiele do

if e ist falsch positiv für H then

H wähle eine Spezialisierung von H, die konsistent ist mit Beispiele

else if e ist falsch negativ für H then

H wähle eine Generalisierung von H, die konsistent ist mit Beispiele

if es kann keine konsistente Spezialisierung/Generalisierung gefunden werden then fail

end

return H

Die Operationen Spezialisierung und Generalisierung müssen noch als logische Relationen zwischen Hypothesen definiert werden, damit sie implementierbar sind. Sei H1 eine Hypothese, definiert durch den Satz C1, und H2 eine Hypothese, definiert durch den Satz C2. Ist H1 eine Generalisierung von H2, dann muss gelten

x C2(x) C1(x)

Um eine Generalisierung von H2 zu konstruieren muss man also nur einen Satz C1 finden, der von

C2 logisch impliziert wird. Dafür gibt es verschiedene Möglichkeiten. Eine besonders einfache ist

das Weglassen eines konjunktiv verknüpften atomaren Satzes. Ist z.B. C2(x) Alternative(x)

Gäste(x, Einige), dann ist eine mögliche Generalisierung C1(x) Gäste(x, Einige). Man nennt diese

Operation auch Weglassen von Bedingungen. Durch sie entsteht eine schwächere Definition, die

demzufolge eine größere Menge positiver Beispiele umfasst. In entsprechender Weise kann man

eine Hypothese spezieller machen, indem man konjunktive Glieder hinzufügt oder disjunktive weg

lässt.

Der CURRENT-BEST-LEARNING-Algorithmus ist indeterministisch definiert, denn es muss immer

wieder eine Auswahl aus mehreren möglichen Spezialisierungen und Generalisierungen getroffen

werden. Diese mehrfache Auswahl führt nicht notwendigerweise zur einfachsten Hypothese, sie

kann sogar zu Situationen führen, in denen keine einfache Modifikation der aktuellen Hypothese

mit allen Beispielen konsistent ist. In diesem Fall muss zu einem früheren Auswahlpunkt zurück

gesetzt werden. Bei einer großen Zahl von Beispielen und einem großen Hypothesenraum entstehen

für den CURRENT-BEST-LEARNING-Algorithmus folgende Probleme:

1. Das Überprüfen aller bisher betrachteten Beispiele nach jeder Modifikation der Hypothese ist

sehr aufwändig.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 138

2. Es ist schwierig gute Heuristiken für das Auswählen zu finden, so dass häufig zurück gesetzt

werden muss.

13.5.4. Least-commitment-Suche

Der ursprüngliche Hypothesenraum kann als disjunktiver Satz der Form

H1 H2 H3 ... Hn

betrachtet werden. Wenn sich einzelne Hypothesen dieses Raums als inkonsistent mit den Beispielen herausstellen, dann werden sie aus der Disjunktion entfernt. Wenn der ursprüngliche Hypothesenraum die richtige Antwort enthält, dann muss der reduzierte Raum auch die richtige Antwort

enthalten, da nur inkonsistente Hypothesen entfernt wurden. Die Menge der übrigbleibenden Hypothesen heißt Versionsraum, und der Algorithmus zur Manipulation des Versionsraums heißt Versionsraum-Lernalgorithmus.

function VERSION-SPACE-LEARNING(Beispiele) returns einen Versionsraum

local variables: V, der Versionsraum: die Menge aller Hypothesen

V die Menge aller Hypothesen

for each Beispiel e in Beispiele do

if V ist nicht leer then V VERSION-SPACE-UPDATE(V, e)

end

return V

function VERSION-SPACE-UPDATE(V, e) returns einen aktualisierten Versionsraum

V {h V | h ist konsistent mit e}

Der Algorithmus hat den Vorteil inkrementell zu sein, d.h. man muss nicht zurücksetzen und bereits

behandelte Beispiele müssen nicht noch einmal betrachtet werden. Er macht auch keine willkürlichen Entscheidungen, sondern schiebt Entscheidungen so lange wie möglich hinaus, d.h. er ist ein

least-commitment-Algorithmus. Das Hauptproblem ist aber, wie die Disjunktion aller Hypothesen

überhaupt dargestellt werden kann, wenn der Hypothesenraum sehr groß ist.

Auf dem Hypothesenraum ist durch die Relation Generalisierung/Spezialisierung eine partielle Ordnung definiert. Die Randpunkte werden durch Mengen von Hypothesen markiert, die Grenzmengen. Der gesamte Hypothesenraum kann durch zwei Grenzmengen beschrieben werden, nämlich

die allgemeinste Grenzmenge (die G-Menge) und die speziellste Grenzmenge (die S-Menge). Alle

Mengen dazwischen sind konsistent mit den Beispielen. Für die Darstellung des Versionsraums mit

Hilfe der G-Menge und S-Menge gilt:

Der aktuelle Versionsraum ist die Menge der Hypothesen, die mit allen bisher betrachteten

Beispielen konsistent sind. Er wird durch die G-Menge und die S-Menge repräsentiert, die beide

Mengen von Hypothesen sind.

Jedes Element der S-Menge ist konsistent mit allen bisher betrachteten Beispielen und es gibt

keine konsistenten Hypothesen, die spezieller sind.

Jedes Element der G-Menge ist konsistent mit allen bisher betrachteten Beispielen und es gibt

keine konsistenten Hypothesen, die allgemeiner sind.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 139

Im initialen Versionsraum müssen alle möglichen Hypothesen repräsentiert werden, bevor ein Beispiel betrachtet wurde. Dazu wird die G-Menge gleich Wahr gesetzt (die Hypothese, die alles

enthält) und die S-Menge gleich Falsch (die Hypothese, deren Extension leer ist).

Die Hypothesen müssen die folgenden beiden Eigenschaften haben, damit die Repräsentation durch

die Grenzmengen hinreichend ist:

1. Jede konsistente Hypothese, die nicht in den Grenzmengen enthalten ist, ist spezieller als

irgendein Element in der G-Menge und ist allgemeiner als irgendein Element der S-Menge.

2. Jede Hypothese, die spezieller als irgendein Element von G und allgemeiner als irgendein

Element von S ist, ist eine konsistente Hypothese.

Es ist noch zu klären, wie S und G aktualisiert werden müssen, wenn ein neues Beispiel betrachtet

wird, d.h. die Funktionsweise der Funktion VERSION-SPACE-UPDATE ist festzulegen. Dazu müssen

die Elemente Si und Gi der S-Menge bzw. G-Menge betrachtet werden. Für jede von ihnen kann das

neue Beispiel falsch positiv oder falsch negativ sein. Diese vier Fälle sind zu untersuchen.

1. Falsch positiv für Si: Das bedeutet, dass Si zu allgemein ist und dass es keine konsistente

Spezialisierung von Si gibt (nach Definition). Also wird Si aus der S-Menge entfernt.

2. Falsch negativ für Si: Das bedeutet, dass Si zu speziell ist, also wird es durch alle seine direkten

Generalisierungen ersetzt.

3. Falsch positiv für Gi: Das bedeutet, dass Gi zu allgemein ist, also wird es durch alle seine

direkten Spezialisierungen ersetzt.

4. Falsch negativ für Gi: Das bedeutet, dass Gi zu speziell ist und dass es keine konsistente

Generalisierung von Gi gibt (nach Definition). Also wird Gi aus der G-Menge entfernt.

Für jedes neue Beispiel wird einer dieser Schritte durchgeführt. Das geschieht so lange, bis eines

der folgenden drei Ereignisse eintritt:

1. Es ist nur noch ein Konzept im Versionsraum vorhanden, dieses wird als die einzige Hypothese

ausgegeben.

2. Der Versionsraum kollabiert, d.h. entweder S oder G wird leer. Das bedeutet, dass es keine

konsistenten Hypothesen für die Trainingsmenge gibt. Dies ist ein Fehlerfall ähnlich dem beim

Entscheidungsbaumverfahren.

3. Es sind keine Beispiele mehr vorhanden aber noch mehrere Hypothesen im Versionsraum übrig.

Der Versionsraum ist dann die Disjunktion dieser Hypothesen. Sie kann als Klassifikator für

neue Beispiele verwendet werden. Passt ein neues Beispiel zu allen Disjunktionsgliedern, dann

wird ihre Bewertung als Klassenzugehörigkeit des Beispiels ausgegeben. Passt es nicht zu allen

Disjunktionsgliedern, dann kann man eine Mehrheitsentscheidung treffen.

Der Versionsraum-Ansatz hat zwei grundsätzliche Nachteile:

Wenn die Domäne verrauscht ist oder für eine Klassifikation unzureichende Attribute besitzt,

dann kollabiert der Versionsraum immer.

Wenn man Disjunktionen unbegrenzter Länge im Hypothesenraum zulässt, dann enthält die SMenge immer eine einzige speziellste Hypothese, nämlich die Disjunktion der Beschreibungen

der positiven Beispiele, die bisher betrachtet wurden. Entsprechend enthält die G-Menge eine

einzige allgemeinste Hypothese, nämlich die Negation der Disjunktion der negativen Beispiele.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 140

Das Problem der verrauschten Daten ist bis heute noch nicht befriedigend gelöst. Das Problem der

Länge der Disjunktionen kann man durch Beschränkungen der Länge lösen oder durch Einführen

einer Generalisierungshierarchie allgemeinerer Prädikate. Die Operationen der Generalisierung und

Spezialisierung lassen sich leicht auf diese Prädikate erweitern.

13.6. Theoretische Begründung des Maschinellen Lernens

Das Prinzip der Theorie des Maschinellen Lernens ist das folgende: Jede Hypothese, die schwerwiegend falsch ist, wird mit hoher Wahrscheinlichkeit nach einer kleinen Anzahl von Beispielen

entdeckt, weil sie eine inkorrekte Vorhersage macht. Umgekehrt heißt das, dass es für eine Hypothese, die mit einer hinreichend großen Zahl von Beispielen konsistent ist, sehr unwahrscheinlich

ist, dass sie schwerwiegend falsch ist, d.h. sie muss wahrscheinlich nahezu korrekt (Probably

Approximately Correct – PAC) sein. Das PAC-Lernen ist eine Theorie des Maschinellen Lernens.

13.6.1. Wie viele Beispiele sind nötig?

In diesem Abschnitt werden folgende Notationen verwendet:

X

D

H

m

die Menge aller positiven Beispiele

die Verteilung, aus der die Beispiele gewählt werden

die Menge möglicher Hypothesen

die Zahl der Beispiele in der Trainingsmenge

Zu Beginn wird angenommen, dass die gesuchte Funktion f in H enthalten ist. Nun kann der Fehler

einer Hypothese h bezüglich der Funktion f bei gegebener Verteilung D als die Wahrscheinlichkeit,

mit der h sich von f unterscheidet, beschrieben werden:

Fehler(h) = P(h(x) f(x) | x aus D ausgewählt)

Eine Hypothese h heißt nahezu korrekt, wenn Fehler(h) für eine kleine Konstante . Es soll

gezeigt werden, dass nach Betrachten von m Beispielen alle konsistenten Hypothesen nahezu

korrekt sind. Die konsistenten Hypothesen kann man sich als in einer -Kugel um die Funktion f

herum liegend vorstellen, während die schwerwiegend falschen Hypothesen außerhalb dieser Kugel

liegen.

Die Wahrscheinlichkeit, dass eine schwerwiegend falsche Hypothese hs Hschlecht mit den ersten m

Beispielen konsistent ist, wird folgendermaßen berechnet. Es gilt Fehler(hs) > . Deshalb ist die

Wahrscheinlichkeit, dass hs mit irgendeinem Beispiel übereinstimmt, kleiner oder gleich 1 . Für

alle m Beispiele ist die Wahrscheinlichkeit

P(hs stimmt mit m Beispielen überein) (1 )m

Die Wahrscheinlichkeit, dass Hschlecht eine konsistente Hypothese enthält, ist durch die Summe der

individuellen Wahrscheinlichkeiten beschränkt:

P(Hschlecht enthält eine konsistente Hypothese) |Hschlecht|(1 )m

|H|(1 )m

Das Ziel eines Lernalgorithmus muss es sein, diesen Wert unter eine kleine Schranke zu drücken,

d.h. es soll gelten

|H|(1 )m

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 141

Dies wird erreicht, wenn man die Zahl der Beispiele folgendermaßen wählt:

m 1 ln 1 ln H

(13.1)

13.6.2. Lernen von Entscheidungslisten

Eine Entscheidungsliste ist ein logischer Ausdruck eingeschränkter Form. Sie besteht aus einer

Reihe von Tests, von denen jeder aus einer Konjunktion von Literalen besteht. Ein Test wird auf die

Beschreibung eines Beispiels angewendet, wenn er erfolgreich ist, gibt die Entscheidungsliste einen

Wert zurück, ist er nicht erfolgreich, wird mit dem nächsten Test fortgefahren. Entscheidungslisten

sind den Entscheidungsbäumen ähnlich, sie haben aber eine einfachere Struktur, dafür sind die

einzelnen Tests komplexer. Abbildung 13.5 zeigt eine Entscheidungsliste, die die Hypothese H4 von

Abschnitt 13.5.3 repräsentiert. Die Hypothese hat die Form

x Warten(x) Gäste(x, Einige) (Gäste(x, Voll) Fr/Sa(x))

Gäste(x, Einige)

N

Gäste(x, Voll) Fr/Sa(x)

J

N

Nein

J

Ja

Ja

Abbildung 13.5

Wird die Länge der Tests nicht beschränkt, dann können Entscheidungslisten jede Boolesche Funktion repräsentieren. Beschränkt man die Länge, etwa auf k Literale, dann kann der Lernalgorithmus

von einer kleinen Beispielmenge verallgemeinern. Die so eingeschränkten Entscheidungslisten

bilden die Sprache k-DL. Das Beispiel von Abbildung 13.5 ist in 2-DL. Eine Teilmenge der Sprache

k-DL ist die Sprache k-DT, die Menge aller Entscheidungsbäume mit maximaler Tiefe k. Je nach Art

und Zahl der Attribute, mit denen die Beispiele beschrieben sind, gibt es verschiedene Ausprägungen der Sprache k-DL. Hat eine k-DL-Sprache n Boolesche Attribute, dann wird sie mit k-DL(n)

bezeichnet.

Um zu zeigen, dass Sprachen vom Typ k-DL lernbar sind, muss zunächst die Anzahl der in der

Sprache möglichen Hypothesen berechnet werden. Die möglichen Tests sind Konjunktionen mit

höchstens k Literalen und n Attributen, die Sprache der Tests wird mit Conj(n, k) bezeichnet. Jeder

Test kann einem Ja- oder einem Nein-Ausgang zugeordnet sein oder er kann fehlen, deshalb gibt es

höchstens 3|Conj(n, k)| verschiedene Mengen von Komponententests. Die Tests in den Mengen können

beliebig angeordnet sein, so dass insgesamt gilt:

k DL (n) 3

Conj ( n , k )

Conj(n, k ) !

Die Mächtigkeit der Menge Conj(n, k) ist

k

2n

Conj (n, k ) O(n k )

i 0 i

Nach Einsetzen und Umrechnen erhält man

k DL (n) 2 O ( n

Technische Universität Chemnitz

k

log2 ( n k )

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 142

Eingesetzt in die Gleichung (13.1) erhält man

m 1 ln 1 O(n k log 2 (n k ))

function DECISION-LIST-LEARNING(Beispiele) returns eine Entscheidungsliste, Nein oder Fehler

if Beispiele ist leer then return Nein

t ein Test, der eine nicht leere Teilmenge Beispielet von Beispiele testet; die Elemente

von Beispielet sind alle positiv oder alle negativ

if es gibt kein solches t then return Fehler

if die Beispiele in Beispielet sind positiv then o Ja

else o Nein

return eine Entscheidungsliste mit erstem Test t und Ergebnis o und den restlichen

Elementen gegeben durch DECISION-LIST-LEARNING(Beispiele Beispielet)

13.7. Zusammenfassung

Lernen wurde in diesem Abschnitt als das Erlernen einer Funktion, die Eingaben zu Ausgaben in

Beziehung setzt, aufgefasst. Speziell wurde das Lernen aus Beispiel-Ein/Ausgabe-Paaren betrachtet.

Die wichtigsten Punkte sind:

Für intelligente Agenten ist das Lernen von großer Bedeutung, damit sie in unbekannten Umgebungen handlungsfähig sind, d.h. Umgebungen, die auch der Entwickler nicht vorhersehen

kann.

Das Lernen ist auch für das Entwickeln von Agenten mit vertretbarem Aufwand von großer

Bedeutung.

Die Grundstruktur lernender Agenten besteht aus einem Performanzelement, das die Aktionen

auswählt, und einem Lernelement, das für die Modifikation des Performanzelements zuständig

ist.

Es gibt vielerlei Formen des Lernens; sie hängen von der Art des Performanzelements, dem

verfügbaren Feedback und dem verfügbaren Wissen ab.

Beim Lernen geht es immer um das Erlernen einer möglichst genauen Repräsentation einer

Funktion.

Das Erlernen einer Funktion aus Ein/Ausgabe-Beispielen heißt induktives Lernen.

Der Schwierigkeitsgrad des Lernens hängt von der gewählten Repräsentation ab. Zu lernende

Funktionen können als logische Sätze, Polynome, Bayessche Netze, Neuronale Netze oder noch

anders repräsentiert werden.

Entscheidungsbäume sind eine effiziente Methode zum Erlernen deterministischer Boolescher

Funktionen.

Nach Ockhams Rasiermesser ist die einfachste Hypothese, die die gegebenen Beispiele matcht,

die günstigste. Die Heuristik des Informationsgewinns ermöglicht es, einen einfachen Entscheidungsbaum zu finden.

Die Performanz induktiver Lernalgorithmen wird durch ihre Lernkurve gemessen, die die Vorhersagegenauigkeit als Funktion der Anzahl der betrachteten Beispiele angibt.

Es wurden zwei Ansätze für das Lernen logischer Theorien behandelt. Der Current-besthypothesis-Ansatz ermittelt eine einzelne Hypothese, der Versionsraum-Ansatz ermittelt alle

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 143

konsistenten Hypothesen. Beide Ansätze sind empfindlich gegen verrauschte Daten in der

Trainingsmenge.

Die Theorie des Maschinellen Lernens untersucht die Beispielkomplexität und die Rechenkomplexität des induktiven Lernens. Es gibt einen Trade-off zwischen der Ausdrucksstärke der

Hypothesensprache und der Einfachheit des Lernens.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 144

14. Lernen in Neuronalen und Bayesschen Netzen

14.1. Gehirn und Computer

14.1.1. Struktur und Arbeitsweise des Gehirns

Das Neuron, auch Nervenzelle genannt, ist die elementare funktionale Einheit von allem Nervengewebe, einschließlich des Gehirns. Es besteht aus einem Zellkörper, genannt Soma, der den Zellkern enthält. Aus dem Zellkörper verzweigen eine Anzahl kurzer Fasern, genannt Dendriten, und

eine einzelne lange Faser, genannt Axon. Die Dendriten verzweigen in ein buschiges Netz von

Endigungen um die Zelle herum, während das Axon sich über eine lange Distanz erstreckt, meist

etwa 1 cm (damit das 100-fache des Durchmessers des Zellkörpers) in extremen Fällen bis zu 1 m.

Das Axon verzweigt sich am Ende ebenfalls in einzelne Fäden, die mit Dendriten oder Zellkörpern

anderer Neuronen verbunden sind. Die Verbindungsstellen zwischen Neuronen heißen Synapsen.

Jedes Neuron bildet Synapsen mit irgendwelchen anderen Neuronen, die Anzahl ist sehr unterschiedlich, sie geht von einem Dutzend bis 100000. Abbildung 14.1 zeigt eine vereinfachte Darstellung eines Neurons.

Axon von einem

anderen Neuron

Synapse

Zellkörper

oder Soma

Synapsen

Dendriten

Axonale

Verzweigung

Zellkern

Axon

Abbildung 14.1

Die Übertragung von Signalen von einem Neuron auf ein anderes erfolgt durch einen komplizierten

elektrochemischen Prozess. Wenn ein elektrischer Impuls am Axonende ankommt, erzeugt die Synapse eine Transmittersubstanz, die in den Dendrit einer anderen Zelle eindringt und dort das elektrische Potential erhöht oder erniedrigt (exzitatorische bzw. inhibitorische Synapsen). Wenn das

Potential einen Schwellenwert erreicht, wird ein Impuls, genannt das Aktionspotenzial, durch das

Axon geschickt. Dieser löst dann wieder die Erzeugung von Transmittersubstanz in den entsprechenden Synapsen aus. Synapsen können unterschiedlich stark sein, d.h. unterschiedliche Leitfähigkeit haben, und diese kann sich ändern. Ebenso können Neuronen neue Verbindungen zu anderen

Neuronen aufbauen und ganze Neuronengruppen können ihren Platz verändern. Durch diese Möglichkeiten der Modifikation ist das Gehirn lernfähig.

14.1.2. Vergleich zwischen Gehirn und Computer

Der Hauptunterschied liegt in der Zykluszeit und im Grad der Parallelität. In der Zykluszeit ist der

Computer weit schneller als das Gehirn und wird noch schneller werden. Dafür ist das Gehirn im

Grad der Parallelität weit überlegen. Das wirkt sich auf die Zahl der geschalteten Elemente pro

Sekunde aus. Dies bewirkt die Leistungsfähigkeit des Gehirns bei besonderen Aufgaben, z.B. der

Bilderkennung. Das Gehirn kann ein Gesicht in weniger als einer Sekunde zuverlässig erkennen,

ein Computer braucht dazu viel länger und ist weniger zuverlässig. Neuronale Netze sind prinzipiell

ebenfalls in starkem Maß parallele Systeme.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 145

Das Gehirn ist fehlertoleranter als ein Computer. Wenn ein Bit wegen eines Hardwarefehlers

kippt, kann das eine ganze Berechnung zerstören. Neuronen fallen laufend aus (und werden nicht

mehr ersetzt), ohne dass dadurch die Funktionsfähigkeit des Gehirns beeinträchtigt wird.

Abgesehen von krankhaften Veränderungen behält ein Gehirn seine Leistungsfähigkeit 70 – 80

Jahre lang oder noch länger bei, ohne dass eine Speicherkarte ersetzt werden muss, die Service Line

angerufen werden muss oder rebootet werden muss. Das Gehirn wird ständig mit neuen Eingaben

konfrontiert und kann diese meist ohne Probleme verarbeiten. Für einen Computer ist dies praktisch

unmöglich. Der Vorzug der Neuronalen Netze ist, ähnlich wie der des Gehirns, die allmähliche

Leistungsminderung gegenüber einem plötzlichen Leistungsabfall.

14.2. Neuronale Netze

14.2.1. Grundbegriffe

Ein Neuronales Netz besteht aus einer Menge von Knoten oder Einheiten, die durch Kanten verbunden sind. Jeder Kante ist ein numerisches Gewicht zugeordnet. Die Gewichte sind veränderlich

und durch ihre Veränderung kann das Netz lernen, während die Struktur im Allgemeinen als fest

betrachtet wird. Durch das Lernen bringt das Netz seine Ausgaben, die es auf Grund bestimmter

Eingaben erzeugt, mit den gewünschten Ausgaben in Übereinstimmung. Einige der Einheiten sind

als Eingabe- bzw. Ausgabeeinheiten ausgezeichnet.

Jede Einheit hat eine Anzahl von Eingabekanten, die von anderen Einheiten kommen, und von Ausgabekanten, die zu anderen Einheiten führen. Sie hat weiterhin ein bestimmtes Aktivierungsniveau

und ein Hilfsmittel zum Berechnen des Aktivierungsniveaus im nächsten Schritt aus den Eingaben

und Gewichten. Im Prinzip führt jede Einheit ihre Berechnung lokal auf Grund der Eingaben von

den Nachbareinheiten aus, eine globale Kontrolle ist nicht erforderlich. In der praktischen Realisierung, meist als Software, werden die Berechnungen aber synchronisiert, damit die Einheiten in einer

festen Reihenfolge arbeiten.

14.2.2. Notationen

Für die Bezeichnung der Bestandteile eines Neuronalen Netzes sind einige formale Notationen

erforderlich. Sie sind in Tabelle 14.2 zusammengestellt.

Notation

ai

ai

g

g‘

Erri

Erre

Ii

I

Ie

ini

N

O

Oi

O

t

T

Bedeutung

Aktivierungswert der Einheit i (gleichzeitig die Ausgabe der Einheit)

Vektor der Aktivierungswerte der Eingaben in Einheit i

Aktivierungsfunktion

Ableitung der Aktivierungsfunktion

Fehler der Einheit i (Differenz zwischen Ausgabe und Ziel)

Fehler für Beispiel e

Aktivierung der Einheit i in der Eingabeschicht

Vektor der Aktivierungen aller Eingabeeinheiten

Vektor der Eingaben für Beispiel e

Gewichtete Summe der Eingaben in Einheit i

Gesamtzahl der Einheiten im Netz

Aktivierung der einzigen Ausgabeeinheit eines Perzeptrons

Aktivierung der Einheit i in der Ausgabeschicht

Vektor der Aktivierungen aller Einheiten der Ausgabeschicht

Schwellenwert für eine Schrittfunktion

Zielausgabe für ein Perzeptron (gewünschte Ausgabe)

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 146

Zielvektor bei mehreren Ausgabeeinheiten

Zielvektor für Beispiel e

Gewicht der Kante von Einheit j zu Einheit i

Gewicht der Kante von Einheit i zur Ausgabeeinheit in einem Perzeptron

Vektor der Gewichte an den zu Einheit i führenden Kanten

Vektor aller Gewichte im Netz

T

Te

Wj,i

Wi

Wi

W

14.2.3. Einfache Rechenelemente

In Abbildung 14.2 ist eine typische Einheit dargestellt. Ihre Grundfunktion ist es aus den über die

Eingabekanten empfangenen Signalen ein neues Aktivierungsniveau zu berechnen und dieses über

die Ausgabekanten an die nächsten Einheiten zu schicken. Die Berechnung erfolgt in zwei

Schritten: Im ersten Schritt wird durch eine lineare Komponente, die Eingabefunktion ini, die

gewichtete Summe der Eingabewerte berechnet. Im zweiten Schritt wird durch eine nichtlineare

Komponente, die Aktivierungsfunktion g, das Aktivierungsniveau ai berechnet. Gewöhnlich

haben alle Einheiten in einem Netz die selbe Aktivierungsfunktion.

ai = g(ini)

aj

W j,i

g

ini

Eingabekanten

ai

Ausgabe

-kanten

Eingabe- Aktivierungs- Ausgabe

funktion

funktion

Abbildung 14.2

ini wird berechnet durch

ini W j ,i a j Wi a i

j

Der neue Wert des Aktivierungsniveaus wird berechnet durch die Funktion g.

ai g (ini ) g W j ,i a j

j

Für die Wahl der Funktion g gibt es eine Fülle von Möglichkeiten. Drei besonders gebräuchliche

Funktionen sind die Schrittfunktion, die Signumsfunktion und die Sigmoidfunktion. Sie sind in

Abbildung 14.3 illustriert.

ai

ai

+1

ai

+1

+1

ini

ini

ini

t

-1

Schrittfunktion

Technische Universität Chemnitz

Signumsfunktion

Sigmoidfunktion

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 147

Abbildung 14.3

Die Definition dieser Funktionen ist wie folgt:

1,

stept ( x)

0,

falls x t

falls x t

1,

sign ( x)

1,

falls x 0

falls x 0

sigmoid ( x)

1

1 ex

Statt Aktivierungsfunktionen mit Schwellenwert zu verwenden, kann man solche ohne Schwellenwert verwenden und statt dessen noch eine zusätzliche Eingabe mit Gewicht vorsehen. Dadurch

wird das Lernen im Netz einfacher, denn man muss nur noch die Gewichte verändern, nicht

Gewichte und Schwellenwerte. Die zusätzliche Eingabe hat die konstante Aktivierung a0 = -1. Das

zusätzliche Gewicht W0,i dient zusammen mit der Aktivierung a0 als Schwellenwert wenn W0,ia0 =

t. Dann kann für alle Einheiten der feste Schwellenwert 0 verwendet werden. Die zusätzliche

Eingabe kann im Netz durch eine spezielle Einheit, genannt Bias, die eine Kante zu jeder anderen

Einheit, aber keine Eingabekante besitzt, realisiert werden.

14.2.4. Netzstrukturen

Es gibt viele verschiedene Netzstrukturen mit unterschiedlichen Berechnungsleistungen. Sie lassen

sich in zwei Hauptgruppen einteilen, die zyklenfreien (feed forward) und die rekurrenten Netze.

In zyklenfreien Netzen sind die Kanten gerichtet und es gibt keine Schleifen, während in rekurrenten Netzen beliebige Strukturen erlaubt sind. Graphentheoretisch ist ein zyklenfreies Netz ein DAG.

Üblicherweise wird die Anordnung der Einheiten im Netz in Schichten vorgenommen. In einem

geschichteten zyklenfreien Netz führen von jeder Einheit aus nur Kanten zu Einheiten in der nächsten Schicht, es gibt keine Kanten zu Einheiten in der selben Schicht oder zu Einheiten in vorangehenden Schichten oder Kanten, die eine Schicht überspringen (Ausnahme: das Bias). In Abbildung

14.4 ist ein zweischichtiges zyklenfreies Netz dargestellt. Die Eingabeeinheiten werden nicht als

eigene Schicht gezählt.

W1,3

I1

H3

W3,5

W1,4

O5

W2,3

I2

H4

W4,5

W2,4

Abbildung 14.4

Zyklenfreie Netze realisieren Funktionen der Eingaben, die nur von den Gewichten abhängen. Sie

haben keine inneren Zustände, da bei der Berechnung der Aktivierungswerte einer Schicht die

Aktivierungswerte der vorhergehenden Schichten keine Rolle spielen. Die Netze können dazu

verwendet werden, adaptive Versionen von Reflexagenten zu realisieren oder einzelne Komponenten komplexerer Agenten.

In rekurrenten Netzen wird die Aktivierung als Eingabe der selben oder vorhergehender Einheiten

verwendet. Deshalb haben diese Netze einen inneren Zustand, der in den Aktivierungsniveaus der

Einheiten gespeichert ist. Die Berechnung in rekurrenten Netzen verläuft weniger geordnet als in

zyklenfreien. Die Netze können instabil werden, oszillieren oder chaotisches Verhalten zeigen. Es

kann lange dauern, bis sie auf eine Eingabe eine stabile Ausgabe erzeugen und der Lernprozess ist

schwieriger. Ihre Repräsentationsfähigkeit ist aber dafür größer als die zyklenfreier Netze. Sie

können komplexe Agenten und Systeme mit inneren Zuständen darstellen.

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 148

In einem zyklenfreien Netz gibt es eine Schicht von Einheiten, die Eingaben aus der Umgebung

aufnehmen, die Eingabeeinheiten (in Abbildung 14.4 I1 und I2). Ihr Aktivierungswert ist durch die

Umgebung bestimmt. Ferner gibt es eine Schicht von Einheiten, die ihre Ausgaben in die Umgebung abgeben, die Ausgabeeinheiten (in Abbildung 14.4 O5). Dazwischen gibt es Schichten von

Einheiten, die keine Verbindung zur Außenwelt haben, sie heißen deshalb verborgene Einheiten

(hidden units) (in Abbildung 14.4 gibt es eine Schicht verborgener Einheiten, H3 und H4). Ein

bestimmter Typ zyklenfreier Netze, die Perzeptrone, haben keine verborgenen Einheiten. Bei

ihnen ist der Lernprozess einfach, dafür ist ihre Repräsentationsfähigkeit stark beschränkt. Netze

mit einer oder mehreren Schichten verborgener Einheiten heißen mehrschichtige Netze. Schon mit

einer genügend großen Schicht verborgener Einheiten ist es möglich, jede kontinuierliche Funktion

der Eingaben zu repräsentieren, mit zwei Schichten können sogar diskontinuierliche Funktionen

repräsentiert werden.

Bei fester Struktur und festen Aktivierungsfunktionen g haben die Funktionen, die durch ein zyklenfreies Netz gelernt (und damit repräsentiert) werden können, eine spezifische parametrisierte

Form. Die Gewichte bestimmen, welche Funktionen tatsächlich repräsentiert werden.

Stellt man sich die Gewichte als Parameter oder Koeffizienten der repräsentierten Funktion vor,

dann ist das Lernen der Prozess, bei dem die Parameter getunt werden, um die Daten der Trainingsmenge möglichst genau zu treffen. In der Statistik heißt dieser Prozess nichtlineare Regression.

14.2.5. Optimale Netzstrukturen

Ein generelles Problem bei der Konstruktion Neuronaler Netze ist die Festlegung der Struktur. Wird

das Netz zu klein angelegt, dann kann es die gewünschte Funktion nicht repräsentieren. Wird es zu

groß angelegt, dann kann es alle Beispiele der Trainingsmenge in der Art einer Tabelle speichern,

aber es hat keine Verallgemeinerungsfähigkeit und kann neue Beispiele nicht richtig klassifizieren.

Dieses Phänomen ist das Overfitting, es ist typisch für statistische Modelle.

Zyklenfreie Netze mit einer verborgenen Schicht können jede kontinuierliche Funktion approximieren, Netze mit zwei verborgenen Schichten können überhaupt jede Funktion approximieren. Aber

die Zahl der Einheiten in jeder Schicht kann exponentiell mit der Zahl der Eingaben anwachsen. Es

gibt noch keine gute Theorie um die mit einer kleinen Zahl von Einheiten approximierbaren Funktionen zu kennzeichnen.

Das Problem eine gute Netzstruktur zu finden kann als ein Suchproblem betrachtet werden. Um

dieses zu lösen wurden verschiedene Verfahren versucht, z.B. genetische Algorithmen. Bei ihnen ist

aber der Rechenaufwand sehr hoch, weil man Populationen von Netzen untersuchen und mit Fitnessfunktionen testen muss. Ein anderes mögliches Verfahren ist Bergsteigen. Dabei wird das Netz

schrittweise modifiziert, und zwar entweder von einem kleinen Netz ausgehend vergrößernd, oder

von einem großen Netz ausgehend verkleinernd.

14.3. Perzeptrone

14.3.1. Struktur von Perzeptronen

Ein Perzeptron ist ein einschichtiges, zyklenfreies Netz. Abbildung 14.5(a) zeigt ein Perzeptron. Die

Ausgabeeinheiten sind unabhängig voneinander, denn jedes Gewicht beeinflusst nur eine Ausgabe.

Deshalb kann man ein Perzeptron als zusammengesetzt aus lauter einfachen Perzeptronen mit

jeweils nur einer Ausgabeeinheit betrachten, vgl. Abbildung 14.5(b), und man kann die Untersuchung auf solche einfachen Perzeptrone beschränken. Die Indizes lassen sich hier vereinfachen, die

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 149

Ausgabeeinheit wird einfach mit O bezeichnet und das Gewicht von der Eingabe j zu O mit Wj. Die

Aktivierung der Eingabeeinheit j ist durch Ij gegeben. Damit ist die Aktivierung der Ausgabe

O step0 W j I j step0 ( W I)

j

Ij

Eingabeeinheiten

Wj,i

Oi

Ij

Ausgabeeinheiten

Eingabeeinheiten

(a) Perzeptron-Netz

Wj

(14.1)

O

Ausgabeeinheit

(b) Einzelnes Perzeptron

Abbildung 14.5

14.3.2. Repräsentationsfähigkeit von Perzeptronen

Es können einige komplexe Boolesche Funktionen repräsentiert werden, z.B. die Majoritätsfunktion, die eine 1 ausgibt, wenn mehr als die Hälfte ihrer n Eingaben 1 ist. Dafür benötigt man ein

Perzeptron, bei dem alle Gewichte Wj = 1 sind und der Schwellenwert t = n/2. Bei einem Entscheidungsbaum würde man für diese Funktion O(2n) Knoten benötigen.

Leider können viele Boolesche Funktionen nicht repräsentiert werden. Der Grund dafür ist, dass

jede Eingabe Ij die Ausgabe nur in einer Richtung beeinflussen kann, unabhängig von den übrigen

Eingabewerten. Man betrachte zur Illustration einen Eingabevektor a. Jede Komponente des Vektors sei aj = 0 und die Ausgabe sei 0. Angenommen, beim Wechsel von aj zum Wert aj = 1 werde

die Ausgabe 1. Dann muss Wj positiv sein. Ferner gibt es dann keinen Vektor b, für den die Ausgabe 1 ist wenn bj = 0, aber andererseits die Ausgabe 0, wenn bj = 1. Diese Eigenschaft schränkt die

Repräsentationsfähigkeit der Perzeptrone erheblich ein.

14.3.3. Erlernen linear separierbarer Funktionen

Der Lernalgorithmus Neural-Network-Learning geht von zufällig aus dem Intervall [-0.5, 0.5] ausgewählten Gewichten in einem Perzeptron aus. Dann werden die Gewichte schrittweise verändert,

und zwar so, dass die Ausgabe bei den vorgelegten Beispielen an die gewünschte Ausgabe angepasst wird. Dieser Anpassungsschritt muss für jedes Beispiel mehrere Male wiederholt werden um

Konvergenz zu erzielen. Der Lernprozess wird dazu meist in Epochen unterteilt. In jeder Epoche

wird für jedes Beispiel eine Anpassung durchgeführt. Der Algorithmus ist wie folgt definiert.

function NEURAL-NETWORK-LEARNING(Beispiele) returns ein Netz

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 150

Netz ein Neuronales Netz mit zufällig ausgewählten Gewichten

repeat

for each e in Beispiele do

O NEURAL-NETWORK-OUTPUT(Netz, e)

T die erwarteten Ausgabewerte für e

aktualisiere die Gewichte in Netz auf der Basis von e, O und T

end

until alle Beispiele werden korrekt vorhergesagt oder das Stopp-Kriterium ist erreicht

return Netz

Die Regel für das Aktualisieren der Gewichte (Lernregel) für das Perzeptron ist einfach. Die

vorhergesagte Ausgabe für ein Beispiel sei O, die korrekte Ausgabe sei T. Dann ist der Fehler

Err = T O

Ist der Fehler positiv, dann muss der Wert von O vergrößert werden, ist er negativ, muss er

verkleinert werden. Jede Eingabeeinheit hat den Anteil WjIj an der Gesamteingabe. Ist Ij positiv,

dann führt eine Vergrößerung von Wj tendenziell zu einer größeren Ausgabe, ist Ij negativ, dann

führt eine Vergrößerung von Wj tendenziell zu einer kleineren Ausgabe. Fasst man beide Einflüsse

zusammen, dann erhält man die folgende Regel:

W j W j I j Err

ist eine Konstante, genannt die Lernrate. Die Regel ist eine leicht geänderte Version der Perzeptron-Lernregel von Rosenblatt (1960). Rosenblatt bewies, dass die Lernregel gegen eine Menge

von Gewichten konvergiert, die die Beispielmenge korrekt repräsentiert, sofern die Beispiele eine

linear separierbare Funktion repräsentieren.

14.4. Mehrschichtige zyklenfreie Netze

14.4.1. Back-Propagation-Lernen

Mit der Methode des Back Propagation können auch mehrschichtige zyklenfreie Netze lernen. Prinzipiell verläuft der Lernprozess wie bei den Perzeptronen: Dem Netz werden Beispiele vorgelegt.

Stimmt der Ausgabevektor mit den erwarteten Werten überein, dann muss nichts gemacht werden.

Liegt aber ein Fehler vor, d.h. eine Differenz zwischen Ausgabe und Ziel, dann müssen die

Gewichte angepasst werden. Die Idee des Back-Propagation-Algorithmus ist es, alle für den Fehler

verantwortlichen Gewichte in die Korrektur einzubeziehen. Für die Ausgabeeinheiten ist dies am

einfachsten und die Regel ist der für Perzeptrone ähnlich. Es gibt zwei Unterschiede: Anstelle eines

Eingabewerts wird die Aktivierung einer verborgenen Einheit benutzt und es wird die erste Ableitung g‘ der Aktivierungsfunktion g verwendet. Ist Erri = Ti – Oi der Fehler an der Ausgabeeinheit i,

dann ist die Aktualisierungsregel für das Gewicht an der Kante von Einheit j zur Ausgabeeinheit i

W j ,i W j ,i a j Erri g ' (ini )

Es ist üblich, einen speziellen Fehlerausdruck i Erri g ' (ini ) zu definieren. Dieser Fehlerwert

wird nämlich zurückpropagiert. Damit wird die Regel verkürzt zu

W j ,i W j ,i a j i

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 151

Der Fehler i an der Ausgabeeinheit i wird nun auf die vorhergehenden verborgenen Einheiten

aufgeteilt und zwar proportional zu den Gewichten der Kanten von den verborgenen Einheiten zu i.

Die Fehler j der verborgenen Einheiten werden durch die Propagierungsregel wie folgt berechnet:

j g ' (in j )W j ,i i

i

Die Aktualisierungsregel für die Gewichte von den Eingabeeinheiten zu den verborgenen Einheiten

ist damit

Wk , j W k , j I k j

Der vollständige Algorithmus wird durch die Funktion BACK-PROP-UPDATE implementiert.

function BACK-PROP-UPDATE(Netz, Beispiele, ) returns ein Netz mit modifizierten Gewichten

inputs: Netz, ein mehrschichtiges zyklenfreies Netz

Beispiele, eine Menge von Eingabe/Ausgabe-Paaren

, die Lernrate

repeat

for each e in Beispiele do

/* Berechnung der Ausgabe für dieses Beispiel */

O RUN-NETWORK(Netz, Ie)

/* Berechnung des Fehlers und von für die Ausgabeeinheiten */

Erre Te O

/* Aktualisierung der Gewichte, die zu der Ausgabeschicht führen */

W j ,i W j ,i a j Errie g ' (ini )

for each nachfolgende Schicht in Netz do

/* Berechnung des Fehlers an jeder Einheit */

j g ' (in j ) i W j ,i i

/* Aktualisierung der Gewichte, die in die Schicht führen */

Wk , j W k , j I k j

end

end

until Netz ist konvergiert

return Netz

Der Algorithmus kann folgendermaßen zusammengefasst werden:

Berechne die -Werte für die Ausgabeeinheiten, ausgehend vom beobachteten Fehler.

Wiederhole die folgenden Schritte für jede Schicht im Netz, beginnend mit der Ausgabeschicht,

bis die erste verborgene Schicht erreicht ist:

-

Propagiere die -Werte zurück zu der vorhergehenden Schicht.

Aktualisiere die Gewichte zwischen den beiden Schichten.

14.4.2. Back Propagation als Suche mit absteigendem Gradienten

Back Propagation kann als Suche im Raum der Gewichte mit absteigendem Gradienten betrachtet

werden. Der Gradient liegt auf der Fehler-Oberfläche. Diese Oberfläche beschreibt den Fehler auf

Technische Universität Chemnitz

Sommersemester 2006

Einführung in die Künstliche Intelligenz

Seite 152

jedem Beispiel als Funktion aller Gewichte im Netz. Abbildung 14.6 zeigt ein Beispiel für eine

Fehler-Oberfläche im zweidimensionalen Fall, d.h. für zwei Gewichte.

Err

a

W1

b

W2

Abbildung 14.6

Die aktuelle Menge der Gewichte definiert einen Punkt auf der Oberfläche. Von einem solchen

Punkt aus betrachtet man die Neigung der Oberfläche entlang den Achsen, die die Gewichte repräsentieren. Diese Neigung stellt die partielle Ableitung auf der Oberfläche bezüglich jedes Gewichts

dar, d.h. sie beschreibt, um wie viel sich der Fehler ändert, wenn man eine kleine Änderung an dem

jeweiligen Gewicht vornimmt. Macht man dies mit jedem Gewicht gleichzeitig, dann bewegt sich

das Netz als Ganzes entlang dem steilsten Abfall auf der Fehler-Oberfläche.

Der Schlüssel zum Verständnis des Back Propagation ist, dass es eine Möglichkeit bietet die

Berechnung des Gradienten auf die Einheiten im Netz aufzuteilen, so dass die Änderung in jedem

Gewicht durch die Einheit berechnet werden kann, der das Gewicht zugeordnet ist, wobei sie nur

lokale Information benutzt.

14.4.3. Eigenschaften des Back-Propagation-Lernens

Das Back-Propagation-Lernen kann nach den selben Eigenschaften beurteilt werden, die man auch

an andere Lernverfahren als Kriterien anlegt.

Ausdruckskraft Neuronale Netze sind eine Attribut-basierte Repräsentation und haben deshalb

nicht die selbe Ausdruckskraft wie allgemeine logische Beschreibungen. Sie sind für kontinuierlichwertige Ein- und Ausgaben geeignet, im Unterschied zu Entscheidungsbäumen. Die Klasse aller

mehrschichtiger Netze als Ganze kann zwar jede Funktion der Eingaben repräsentieren, aber ein

einzelnes Netz kann zu wenige verborgene Einheiten haben.