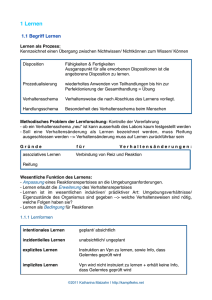

lernen

Werbung

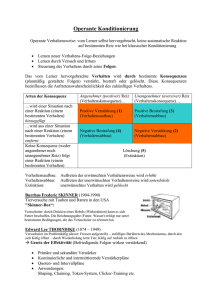

-1LMU München Seminar Allgemeine Psychologie Referat am 18.12.2002-11-27 Klaus Z......., Tina Theobald, Paul Wimmer, Andrea Budimir-Bekan, Nadine Schmidt, Christine Durst, Daniela Reda, Elisabeth Tinhofer LERNEN 1. Geschichte der Forschung In der Lernpsychologie unterscheidet man 2 zentrale Lerntheorien: Klassische Konditionierung Operante Konditionierung Die Erforschung dieser zwei Theorien galt über lange Zeit als Schlüssel zum Verständnis erlernten Verhaltens. Besonders amerikanische Psychologen, die dem Behaviorismus nahe standen, befasten sich mit der Erforschung der Lerngesetze. Annahme: Mensch ist nur von seiner Umwelt abhängig Ziel: - Aufstellen von allgemeingültigen Gesetzen des Lernens auf der Basis streng objektiv beobachtbarer Verhaltensmerkmale - Entwicklung einer Verhaltenstechnologie um psychische Störungen beseitigen zu können Seid den 70ger Jahren jedoch spricht man von der „Kognitiven Wende“ Erforschung von Gedächtnis-, Denk- und Motivationsprozesse im Zusammenhang mit Lernphänomenen bedeutendster Vertreter: Bandura- „sozial- kognitive- Lerntheorie“ 2. Zentrale Lerntheorien 2.1 Klassisches Konditionieren . Definition : Bei der klassischen Konditionierung geht es darum, eine natürliche, angebo rene Reaktion des Organismus auf einen bestimmten und bekannten auslösenden Reiz mit einem anderen (ursprünglich neutralen) zu koppeln Die experimentelle Untersuchung der Klassischen Konditionierung geht auf den russischen Physiologen Iwan Petrowitsch Pawlow (1849-1936) zurück. Die Theorie von PAWLOW wird deswegen als klassisch bezeichnet, weil sie in der Lernpsychologie den ersten und auch für folgende Lernforscher grundlegenden Theorieansatz darstellt. Häufig wird auch der Begriff „Respondentes Lernen“ oder „Reiz-Reaktions-Lernen“ verwendet, da auf einen gegebenen Reiz eine Reaktion (Antwort = response) folgt. -2Ursprünglich beschäftigte sich Pawlow mit Verdauungsprozessen. Er gab den Hunden Futter und maß parallel die Menge des entstehenden Speichels. In diesem Zusammenhang bemerkte er, dass ein zuvor neutraler Reiz (z.B. Schritte des VL), der einige Male zeitgleich oder knapp vor der Futtergabe auftritt, den Speichelfluss bei alleiniger Präsentation auslöst. Aus dieser Beobachtung heraus entstand letztendlich die Gesamtkonzeption des Behaviorismus. Pawlow wandte sich von seiner ursprünglichen Arbeit ab und konzentrierte sich auf eine sorgfältige experimentelle Untersuchung dieser Lernprozesse. Versuchsaufbau: Der Versuchshund wird auf einem Labortisch festgeschnallt. Bekommt der Hund Fleischpulver ins Maul, sondert er Speichel ab. Fleischpulver = unkonditionierter Reiz/ Stimulus (US) Speichelabsonderung = unkonditionierte Reaktion (UR) Nun wird dem Hund zusätzlich zu diesem US einen neutralen Reiz/ Stimulus (NS), z.B. einen Glockenton dargeboten. Tritt dieser NS mehrmals in Verbindung mit dem US auf, so bewirkt bereits der Glockenton alleine eine Speichelabsonderung. Aus dem ursprünglich neutralem Reiz „Glockenton“ ist ein konditionierter Stimulus (CS) geworden, der eine konditionierte Reaktion (CR), den Speichelfluss, auslöst. Zusammenfassung des klassischen Konditionieren Unkonditionierter Stimulus US unkonditionierte Reaktion (UR) (Futter) (Speichelfluss) Neutraler Stimulus (NS) keine gesicherte Reaktion (Glockenton) US + NS nach mehreren Wiederholungen konditionierte Reaktion (CR) Lernen CS (Glockenton) CR (etwas schwächer, als UR) (Speichelabsonderung) Der ursprünglich neutrale Reiz „Glockenton“ hat eine Signalfunktion übernommen. Deshalb spricht man auch von Signallernen. Es handelt sich hierbei um klassisches Konditionieren anhand von Reflexen! Definition: Unter einem Reflex versteht man eine angeborene spezifische Organreaktion auf einen bestimmten Reiz. -3Phasen bei der klassischen Konditionierung: 1. Phase: KONTROLLPHASE: - Überprüfung, ob der US ein zuverlässiger Auslöser der UR ist - NS darf noch nicht die UR auslösen; er ruft allerdings die Orientierungsreaktion (OR) hervor (Hinwendung zur Reizquelle, Steigerung der Aufmerksamkeit Pupillenerweiterung, Herzklopfen) - Einzelne Komponenten der Ur müssen sich deutlich von OR unterscheiden, sonst könnte OR fälschlicherweise als CR interpretiert werden 2. Phase: KONDITIONIERUNGSPHASE: - US löst UR aus - Mehrmalige gemeinsame Darbietung von NS und US wichtig dabei ist die zeitliche Beziehung zwischen den beiden Reizen; man unterscheidet 4 verschiedene Varianten: S.329 Abb.2 - Der zeitliche Abstand zwischen dem Beginn des NS und dem Einsetzen des US wird als Interstimulationsintervall (ISI) bezeichnet. Untersuchungsergebnisse zur Wirksamkeit der verschiedenen Konditionierungsarten: ~ verzögerte Konditionierung führt am schnellsten zum Aufbau einer konditionierten Reaktion (CR) ~ rückwirkende Konditionierung führt nicht zu einem systematischen Lerneffekt 3. Phase: LÖSCHUNGSPHASE: - Darbietung des CS (Glockenton) ohne US (Fleischpulver) bei erfolgreicher Konditionierung tritt die CR anfangs noch deutlich auf, allerdings ist die Stärke kleiner, als bei der UR, daher auch die Umbenennung starker Abfall der physiologischen Reaktion Löschung der CR Die Löschung einer bestimmten Reaktion ist kein Vergessensprozeß Löschung = Lernen, dass der vorher relevante Reiz jetzt unwichtig ist. Reiz verliert seinen Signalcharakter 4. Phase: SPONTANERHOLUNG - Nach längerer Pause erneute Darbietung des CS -4 gelöschte Reaktion tritt wieder auf, die Intensität ist aber bedeutend geringer und verschwindet bei folgenden Durchgängen schnell Verschiedene Formen bei der Klassischen Konditionierung: Reizgeneralisierung Reizdiskriminierung > Definition: Von Reizgeneralisierung spricht man, wenn auch ein dem konditionierten Reiz ähnlicher Reiz die konditionierte Reaktion auslöst. > Beispiel: konditionierter Reiz ist konditionierte Reaktion erfolgt auch auf > Definition: Die konditioniere Reaktion wird nur durch den genau definierten Reiz ausgelöst > Diskriminationstraining: - Darbietung zweier ähnlicher Reize in unregelmäßiger Reihenfolge - zusammen mit dem einen Reiz (z.B. Kreis) wird ein unkonditionierter Reiz dargeboten, mit dem anderen Reiz (Ellipse) nicht nach einigen Durchgängen: Lernprozess, konditionierte Reaktion nur auf Darbietung des Kreises Vorsicht: durch Training verringert sich die Diskriminationsleistung experimentelle Neurosen Bedingte Furcht- / Angstreaktion: Der Erwerb von Furcht-Angstreaktionen gegenüber situativen Bedingungen in der individuellen Lebensgeschichte kann als klassische Konditionierung interpretiert werden. Koppelung emotional –motivationaler Reaktionen (keine Reflexe) an unterschiedliche, zuvor neutrale Reize - Beispiel: „ Der kleine Albert“ (Watson und Rayner (1920)) + Hypothese: Eine Vielzahl emotionaler Reaktionen auf bestimmte situative Bedingungen können über den Prozess einer Klassischen Konditionierung erworben werden + Durchführung/ Ergebnisse: kleiner Albert war zwischen 9 und 13 Monate alt unkonditionierten Reizes (US) = Hämmern an einen Stahlstab unkonditionierte Reaktion (UR) = Schreck-/ Angstreaktion neutraler Reiz(NS) = Ratte, haarige Tiere Interesse und Zutrauen Konditionierungstraining: NS + US UR (Schreck-/ Angstreaktion) CS CR (Furcht-/ Angstreaktion) Generalisierung: alles haarige (z.B. bärtiger Mann) führt zu einer Furcht-/Angstreaktion + Kritik: - Kind ist wehrlos und wird bewusst dazu gebracht, sich zu fürchten -5- es erfolgt keine Aufhebung der gelernten Furcht-/ Angst- Reaktion Interozeptive Konditionierung: Hierbei handelt es sich um eine besondere Form der klassischen Konditionierung. Ziel: Beeinflussung der Organfunktionen; Konditionierung der Aktivitätssteigerung Beispiel: - Vp wurde ein aufblasbarer Gummiballon zur Messung des Drucks in die Harnblase eingesetzt - während der Gummiballon mit Luft (US)gefüllt wurde, mussten die VP die Bewegung eines angeschlossenen Zeigers auf einer Skala (NS, später CS) verfolgen - Blasendruck Harndrang (UR) - NS + US Harndrang, nach mehreren Wiederholungen reichte schon die Zeigerstellung, um den Harndrang auszulösen 2.2 Operantes Konditionieren Diese Art von Lernen wird als „operant“ oder „instrumentell“ bezeichnet, weil hierbei die Reaktion eines Individuums „operativ“ oder „instrumentell“ für das Auftreten einer Verstärkung ist. Das heißt, das Verhalten wirkt derart auf die Umwelt ein, dass es zu einer Verstärkung dieser Verhaltensweise kommt. Es liegt kein reizgebundenes Verhalten vor; die Reaktionen werden spontan vom Individuum produziert. Es interessiert der Zusammenhang zwischen einem spontan gezeigtem Verhalten und der Konsequenz dieses Verhaltens in Form einer Verstärkung für das Individuum. Die Verstärkung als Konsequenz eines Verhaltens Ist die entscheidende Variable beim operanten Lernen: (Hinweis: In der Literatur wird gelegentlich zwischen operanter und instrumenteller Konditionierung unterschieden. Instrumentelle Situation: das Versuchstier ist auf ganz wenige oder nur eine Verhaltensweise beschränkt, wobei eine Verhaltenswiederholung nur mit Hilfe des VL möglich wäre, z.B. Ratte in einem Laufgang, deren Geschwindigkeit vom Start ins Ziel durch Lernen verändert werden soll. Sie muss nach dem Durchlaufen des Ganges erst wieder vom VL an den Start gesetzt werden. Operante Situation: Versuchstier ist frei, das Verhalten oder ein anderes zu zeigen, z.B. Skinner-Box) 2.2.1 Lernen durch Versuch und Irrtum Etwa zeitgleich mit Pawlow begann Edward L. Thorndike (1874-1949) seine Experimente mit Katzen. - Versuchsanordnung: Eine hungrige Katze wird in einen Käfig gesperrt. Schale mit Futter ist gut sichtbar außerhalb des Käfigs aufgestellt. Durch Zug an einer von der Käfigdecke herabhängenden Schlaufe könnte die Türe geöffnet werden. Katze läuft unruhig hin und her und tritt nach einiger Zeit zufällig auf die Schlaufe, Türe öffnet sich. Nach mehreren Wiederholungen des Versuchs ist eine Verringerung der Zeit, die die Katze zum Öffnen der Türe benötigt, zu beobachten. Der Lernfortschritt ist graduell Katze hat nach Versuch und Irrtum gelernt Lernen durch Versuch und Irrtum („trial-and-error“) ist ein Suchprozess, bei dem das zufällig richtige Verhalten durch den Erfolg verstärkt wird und in der Zukunft vermehrt -6auftritt. Lernen am Erfolg! Aus seinen Untersuchungen leitete Thorndike folgendes Gesetz ab: Gesetz des Effekts: „...unter verschiedenen Reaktionen wird diejenige stärker mit der Situation verknüpft, die von einem für das Tier befriedigenden Zustand begleitet oder innerhalb kurzer Zeit gefolgt werden...“ 2.2.2 Lernen durch Verstärkung: Besonders Burrhus F. Skinner beschäftigte sich mit der Frage, welche Wirkung positive oder negative Verstärkung auf ein Verhalten haben kann. Definition: Bei einem Verstärker handelt es sich um einen Reiz, der als Konsequenz eines Verhaltens auftritt und dessen Stärke (Auftretenswahrscheinlichkeit) erhöht. Sowohl negative wie auch positive Verstärkung führen zu einer Erhöhung der Auftretenswahrscheinlichkeit eines Verhaltens. Verstärkerarten: - Positive Verstärker: = Reize, die durch ihre Darbietung die Auftretenswahrscheinlichkeit erhöhen - Negative Verstärker: = Reize, die durch ihre Entfernung dazu führen, dass Verhaltensweisen vermehrt auftreten - kortikale Reizung: Elektrische Reizung wirkt verstärkend in bestimmten Gebieten des Zwischenhirns. (Experimente von Olds & Milner 1954) - Generell unterscheidet man 3 Klassen von Verstärkern: Primäre Verstärker Sekundäre Verstärker Generalisierte Verstärker - befriedigt physiologische Bedürfnisse (Hunger) - wirken ohne vorherigen Lernprozess - Abhängigkeit des primären Verstärkers von den Bedürfnissen des Organismus - durch häufige gemeisame Darbietung eines neutralen Reizes mit einem primären V. wird der neutrale Reiz zum sekundär Verstärker Wenn Verstärker ihre Wirksamkeit aus der in der Lerngeschichte des Individuums erfolgten Verknüpfung mit mehreren primären und sekundären Verstärkern beziehen, dann spricht man von generalisierten Verstärkern Experimentelle Varianten Für die operante Konditionierung typische experimentelle Vorgehensweise ist die Versuchsanordnung von Skinner. Er arbeitete meisten mit Ratten oder Tauben, die in eigens dafür entwickelten Boxen, sie sog. Skinner-Boxen trainiert wurden. Eine Skinner-Box besteht aus einem Käfig, der mit einem Druckhebel, einem Licht, einem Futtermagazin, einem Futterauslieferungsmechanismus und evtl. einem elektrifizierbaren Rost ausgestattet ist. -7a) Lernen durch positive Verstärkung Analog zur klassischen Konditionierung unterscheidet man wieder 4 Phasen: S.333 /Abb.5 - Bestimmung der Basisrate (Grundrate) Registrierung, wie oft das zu konditionierende Verhalten ohne Verstärkung auftritt (z.B. wie oft betätigt die Ratte spontan den Hebel pro Zeiteinheit) - Trainingsphase: Gezielte Verstärkung des Verhaltens (bei jedem Hebeldruck rollt eine Futterkugel herunter in den Futtertrog) Häufigkeit des Hebeldrückens nimmt zu - Extinktion = Löschung: Keine weitere Verstärkung, d.h. die Ratte bekommt kein Futter mehr, Löschung = Abschwächung des Verhaltens, nach ausgedehnter Löschungsphase kann kein Effekt der Konditionierung mehr beobachtet werden - Spontanerholung: Nach Unterbrechung und anschließender Herstellung der experimentellen Situation kommt es zu abgeschwächten Reaktionen Ratte für kurze Zeit aus der Skinner Box(Löschung), dorthin zurückgebracht betätigt sie wieder den Futterhebel, allerdings weniger häufig angenehmer Reiz = Futter = positive Verstärkung b) Lernen durch negative Verstärkung Skinner-Box besteht bei diesem Experiment aus zwei Abteilen, die durch eine verschließbare Öffnung miteinander verbunden sind. Nun wird das Gitter in der einen Hälfte unter Strom gesetzt Ratte lernt nach wenigen Durchgängen, von diesem Abteil isn andere zu flüchten unangenehmer Reiz = elektrischer Strom = negative Verstärkung Verstärkungspläne: Unter Verstärkungsplänen versteht man die Art und Weise, wie Verstärker im Experiment verabreicht werden. Jedes Auftreten des infrageKontinuierliche Verstärkung Jedes Auftreten des infragestehenden Verhaltens wird verstärkt. - Vorteil: führt rascher zum angestrebten Verhalten als intermittierende Verstärkung Intermittierende Verstärkung Nicht jedes Auftreten des infragestehenden Vehaltens wird verstärkt. - Vorteil: hat löschungsresistenteres Verhalten als Konsequenz - Die Unterbrechung kann nach zwei Kriterien eingerichtet sein: - Intervallplan: Verstärkung nach einem bestimmten Zeitintervall - Quotenplan: Verstärkung nach einer bestimmten Anzahl von Reaktionen führen zu einer höheren Reaktionshäufigkeit als Intervallpläne -8 beide Versuchspläne können sowohl fixiert wie auch variabel gestaltet werden, fixiert Intervallplan Gleichbleibende Zeitabstände Quotenplan Genau jede n-te Reaktion wird verstärkt Stark wechselnde Verhaltenshäufigkeiten variabel Zufällig wechselnde Zeitabstände stabiles, einheitliches Verhalten Anzahl der Reaktionen ohne Verstärkung zufällig, Durchschnitt immer gleich über die Zeit sehr gleichmäßiges Verhalten Es gibt viel Kombinationsmöglichkeiten der Verstärkungsvarianten; Generell gilt: Art des Verstärkungsplans = UV, Lerngeschwindigkeit und Löschungswiderstand = AV Wird nicht kontingent verstärkt, d.h. dass Verstärkung unabhängig vom Auftreten eines bestimmten Verhaltens nach einem bestimmten Zeitintervall gegeben wird, so kann es zu einem sog. abergläubischen Verhalten kommen (sehr löschungsresistent) Verstärkungsmenge: Experimentelle Erforschung von Crespi (1942): - Versuchsaufbau: Ratten liefen durch einen 7m langen Gang, am Ende wurde als Verstärkung Futter dargeboten, die Laufzeit vom Anfang bis zum Ende wurde von jeder Ratte gemessen - Ergebnisse: ~ monotoner Zusammenhang zwischen Verstärkermenge und Laufgeschwindigkeit; je größer die Verstärkung, desto schneller war die Geschwindigkeit ~ Änderung der Verstärkermenge: Reduktion langsameres Laufen (negativer Kontrasteffekt) Vermehrung schnelleres Laufen (positiver Kontrasteffekt) in der Trainingsphase wächst die Stärke des konditionierten Verhaltens mit der Verstärkungsmenge Keine Verstärkung: ein wesentlicher Teil des Gelernten wird erst in Performanz (Umset zung in beobachtbares Verhalten) umgesetzt, wenn entsprechende Verstärkung geboten wird. = latentes Lernen: Kompetenz, die sich erst zeigt, wenn Motivierung durch Verstärkung Zeitintervall zwischen Verhalten und Verstärkung: Je größer das Zeitintervall zwischen der Ausübung des Verhaltens und der Darbietung des Verstärkers ist, desto langsamer wird gelernt, und desto geringer ist die Stärke des konditionierten Verhaltens Behauptung von Spence (1947): Bei verzögerter Verstärkung sei ein Lernerfolg nur über sekundäre Verstärkung möglich. Z.B. Geräusch im Futtermagazin .... c) Lernen durch Hinweisreize: Eine Ratte in der Skinner-Box erhält nur Futter, wenn kurz vor dem Hebeldruck ein Lämpchen aufgeleuchtet hat. Die Ratte lernt mit der Zeit, den Hebel nur dann zu drücken, wenn das Lichtsignal gegeben wurde. Man spricht von einem diskriminativen Belohnungstraining -9 das Licht = diskriminativer Hinweisreiz Tiere sind zu erstaunlichen Diskriminationsleistungen fähig. Experiment von Reese(1966): „lesende“ Tauben: Tauben bekamen Wörter gezeigt: turn – Tauben drehten sich im Kreis peck – Tauben begannen zu picken Erklärung: Wörter hatten anfangs stark unterschiedliches Aussehen (Größe und Farbe) leicht zu unterscheiden Es folgte eine schrittweise Reduzierung der Unterschiede zwischen den beiden Hinweisreizen, bis sie schließlich gleich waren = fading (Ausblenden) Die Fähigkeit, die Lösung von Diskriminationsaufgaben zu lernen wurde als Indikator für Intelligenzunterschiede zwischen Tierarten angesehen. Warren (1965) nennt folgende Rangordnung: (1) Rhesusaffen, (2) Totenkopfäffchen, (3) Krallenaffen, (4) Katzen, (5) Ratten, (6) Eichhörnchen d) Verhaltensdifferenzierung/ Verhaltensketten: Definition: Von Verhaltensdifferenzierung spricht man, wenn einzelne Merkmale eines Verhaltens (Geschwindigkeit etc.) in einem Lernprozess verändert werden. Verstärkt wird hier nur, wenn das infragegestellte Merkmal im gewünschten Ausprägungsgrad erscheint Die Ratte in der Skinner-Box soll lernen, den Hebel besonders kräftig zu drücken. In der ersten Phase wird jedes Drücken verstärkt, dann nur noch Drücken mit höherer Intensität und schließlich nur noch bei kräftigem Drücken des Hebels. Durch eine stufenweise Annäherung an das gewünschte Verhalten kommt es zu einer Verhaltensformung (shaping) Mit dieser Methode kann auch ein komplizierteres, nicht im natürlichen Repertoire vorkommende Verhaltensweise erlernt werden (z.B. Tier lernt Fernsehbedienung) Spektakuläre Erfolge in der Tierdressur Tierverhalten in Fernsehfilmen Dabei spielt auch der Aufbau von Verhaltensketten eine wichtige Rolle. Definition: Eine Verhaltenskette stellt eine Abfolge von Reiz-Reaktions-Einheiten dar, wobei jedes einzelne Verhalten entweder als Konsequenz einen weiteres Verhalten auslösenden diskriminativen Hinweisreiz zur Folge hat oder aber selbst als solcher dient. Bezogen auf das vorangegangene Verhalten hat der diskriminative Hinweisreiz die Funktion eines Verstärkers 2.2.3 Bestrafung, Löschung und Ablösung von Verhalten: Um die Ausführungswahrscheinlichkeit eines Verhaltens zu reduzieren, gibt es drei unterschiedliche Möglichkeiten: Bestrafung Entzug der Verstärker, die das Verhalten aufrechtgehalten haben Löschung Aufbau eines konkurrierenden Verhaltens -10- Bestrafung: Verhaltungsunterlassung aufgrund negativer Konsequenzen wird auch als passives Vermeidungslernen bezeichnet. Man unterscheidet zwei Arten der Bestrafung: Bestrafung Typ 1 Hinzufügen eines unangenehmen Reizes Beispiel: Skinner-Box Stromstoß über das Bodengitter nach Betätigung des Hebels Unterdrückung des Verhaltens bei der Ratte Bestrafung Typ 2 Entfernung eines angenehmen Reizes Beispiel: durch Bewegung des Bodengitters geht der Ratte das Futterkügelchen verloren Wirksamkeit von Bestrafung: Die Wirksamkeit der Bestrafung wurde von Estes (1944) experimentell getestet. - Versuchsaufbau: Skinner-Box mit Hebel, Futtermagazin, elektrisches Bodengitter - Ablauf: 16 Ratten – 1. Phase: möglichst häufiges Hebeldrücken wurde operant Konditioniert mit positiver Verstärkung (erst kontinuierlich, dann intermittierend) 1.Löschungsphase: Experimentalgruppe wurde nicht mehr verstärkt und erhielt oft, aber nicht immer einen elektrischen Schock beim Hebeldruck Kontrollgruppe erhielt weder Bestrafung noch Verstärkung 2. und 3.Löschungsphase: Verhalten wurde in beiden Gruppen weder bestraft noch verstärkt - Ergebnisse: S.345 Abb.9 Es handelt sich hierbei um ein typische Bestrafungsexperiment im Rahmen der operanten Konditionierung, da in der ersten Phase ein Verhalten durch positive Verstärkung aufgebaut wurde und in der zweiten Phase(Löschung) sein Auftreten durch aversive Reize (Elektroschock) bestraft wird. Zusammenfassung der Ergebnisse einer Bestrafung: - Je intensiver der Strafreiz, umso stärker und dauerhafter ist die Unterdrückung des Verhaltens - Intermittierende Bestrafung ist wirksamer als kontinuierliche - Strafreiz muss direkt auf das fragliche Verhalten folgen - Wirksamkeit der Bestrafung verringert sich, wenn dem Verhalten gelegentlich eine positive Verstärkung folgt - besonders wirkungsvoll ist es, wenn gleichzeitig zur Unterdrückung eine Alter nativreaktion aufgebaut wird, die positiv verstärkt wird Bestrafung Löschung des Verhaltens!! -11- Bestrafung hat primär Einfluss auf die Performanz - bestrafte Verhalten tritt dann wieder auf, wenn das Individuum keine weiteren Bestrafungen erwartet Rolle der Bestrafung beim Menschen Naturgegebene negative Konsequenzen werden leichter ertragen als eine Bestrafung durch einen Menschen, wenn dem Bestraften klar ist, dass es in der Entscheidung des anderen liegt, ihn zu bestrafen oder nicht. Je deutlicher die informative Funktion einer Bestrafung ( z.B. Kind fasst auf heiße Herdplatte) ist und dazu beiträgt, Schaden von ihm abzuwenden, desto eher wird im allgemeinen eine Bestrafung zu rechtfertigen sein. Conditioned emotional response (konditionierte emotionale Reaktion) Als erste haben sich Skinner und Esters (1941) damit befasst. Es handelt sich hierbei nicht um eine Bestrafung im eigentlichen Sinn; es wird mit aversiven Reizen gearbeitet, die allerdings nicht nach einem bestimmten Verhalten gesetzt werden, sondern verhaltensunabhängig auftereten. Typischer Aufbau eines Experimentes zur konditionierten emotionalen Reaktion: 1. Aufbau eines bestimmten Verhaltens durch positive Verstärkung hohe und stabile Verhaltensrate 2. Klassische Konditionierung: unabhängig vom augenblicklichen Verhalten wird ein aversiver Reiz (US) dargeboten, der durch einen diskriminativen Hinweisreiz (NS, später CS) signalisiert wird Reduktion des operant konditionierten Verhaltens, auch wenn kein NS (CS) mehr auftritt Löschung: Werden die Verstärker herausgefiltert, die ein Verhalten aufrechterhalten und diese aus der Situation entfernt, so spricht man von Löschung des Verhaltens. Beispiel: Kind schreit wenn es ins Bett gelegt wurde Eltern kommen immer wieder herein und versuchen es zu besänftigen Zuwendung = Verstärker lassen die Eltern ihr Kind schreien und gehen nicht mehr zu ihm zurück, so lernt das Kind, dass sein Schreien nichts mehr nütz und die Schreidauer nimmt stetig ab! = Löschung! 3.Verbindung von klassischer und operanter Konditionierung 3.1 Angst und Vermeidung: Vor allem Miller (1948a) hat sich mit diesem Thema auseinandergesetzt. Als Versuchstiere dienten ihm 25 Ratten. -12- 5. Beobachtungslernen und die Wirkung von Vorbildern 5.1 Problembereiche und daraus abgeleitete Fragenstellungen der Vorbildforschung: Imitationskompetenz: Welches sind die basalen Fähigkeiten der Imitation? Ist die Befähigung zur Nachahmung genetisch angelegt oder ist sie erworben? Imitationsbereitschaft: Wie wird eine Bereitschaft zu imitieren erworben; was sind deren Lernbedingungen? Entwicklung der Imitation: Was sind die Prozesse und Bedingungen der Ontogenese der Imitation? Gibt es Entwicklungsfortschritte von Imitationsleistungen? Motivation zur Imitation: Welche situationalen und personalen Einflüsse veranlassen im konkreten Fall zur Nachahmung? Hier geht es nicht mehr um die Frage des Lernens und der Entwicklung, sondern um aktuelle Motivierungsbedingungen der Imitation. Lernen durch Beobachtung: Wie können Personen durch Beobachtung anderer Wissen erwerben; welche Lernprozesse liegen dem zugrunde? Es geht um die kognitiv- funktionalen Bedingungen von Vorbildwirkungen im allgemeinen. Imitation kann, muss aber nicht beteiligt sein. Motivation zur Ausführung: Welche situationalen und personalen Bedingungen lassen Personen durch Beobachtung Gelerntes in Handlung umsetzten; was sind die Veranlassungen zur Handlungausführung? Es geht um die motivationalen Bedingungen von Vorbildwirkungen. Indirekte Vorbildwirkungen. Welche Einflüsse haben Vorbilder auf Handlungen, die mit dem gezeigten Vorbildverhalten nur indirekt zu tun haben? Wie beeinflussen Vorbilder Urteilsbildungen und handlungsleitende Kognitionen von Beobachtern, die deren weitere Handlungen steuern? Diese Teilbereiche lassen sich zu Problemkomplexen gruppieren: Imitation Im engeren Sinne Bedingungen und Möglichkeiten der Nachahmung beobachteten Ontogenetische Sichtweise Verhaltens Allgemeine Effekte von Vorbildbeobachtung vs. Alllgemeinpsychologische Sichtweise Kompetenzfaktoren Permanenzfaktoren Betreffen Fähigkeiten und deren Erwerb, die zur Imitation und zum Beobachtungslernen nötig sind Motivationsfaktoren, die die Ausführung regulieren -13- 5.2 Theorien des Vorbildlernens: In den Theorien werden nur einzelne, manchmal mehrere, aber nie alle der oben genannten Problembereiche behandelt. Besondere Aufmerksamkeit wurde den motivationalen Bedingungen des Lernens von Imitation und des Lernens am Vorbild entgegengebracht. Die kognitiven Prozessen des Wahrnehmens, Speicherns und Umsetzen in Handlung wurden weniger berücksichtigt. Instinkttheorie Um die Jahrhundertwende war der Instinktbegriff ein gebräuchliches Konzept zr Erklärung menschlichen Verhaltens. Die Hauptbegründer einer Instinktpsychologie waren JAMES (1890) und McDOUGALL (1908) Definition: Unter Instinkt verstand man eine genetisch verankerte Verhaltensdisposition, die Lebewesen leitet, oder Einsicht und ohne vorheriger Erfahrungsmöglichkeit der Umwelt angepasste Verhaltensweisen zu zeigen. JAMES ordnete Imitation ausdrücklich den Instinkten zu; McDOUGALL hingegen nicht. o Imitation bei Neugeborenen? MELTZOFF und MOORE (1977) berichteten über Nachahmung ganz bestimmter Bewegungen, vor allem im Mundbereich, bei Neugeborenen. Bereits PREYER (1980) berichtete von solchen Beobachtungen. - Versuchsergebnisse: 18 12-21 Tage alte Babys zeigten eine erhöhte Auftretensrate bestimmter Reaktionsweisen, wenn diese von einem erwachsenen Vorbild vorgemacht wurden. Annahme: erfahrungsunabhängiger aktiver Nachahmungsprozess, der durch ein abstraktes Repräsentationsmedium vermittelt ist. Fähigkeit der Neugeborenen, die sensorische Information optischer und propriozeptiver Reize in der gleichen Modalität zu repräsentieren und zu vergleichen Generell kommt man zu dem Schluss, dass das Phänomen einer allgemeinen Nachahmung bei Neugeborenen nicht nachweisbar ist; für die Verhaltensweise des ZungeHerausstreckens in den ersten beiden Lebensjahren scheint es eine „Nachahmungs“Bereitschaft zu geben (genetisch fixiertes Verhaltensmuster) Lerntheoretische Konzeption: Deutliche Gegenposition zur Instinktheorie. - Imitation als eine erworbene Verhaltensbereitschaft. - Das Lernen von Imitation steht im Mittelpunkt, sprich um die Bedingungen, durch die eine Bereitschaft zu imitieren, erworben wird. - Imitationsfähigkeit und Ausführungskompetenz wird vorausgesetzt. - Erklärung des Nachahmungsverhalten durch allgemeine Lerngesetze (klassische/ operante Konditionierung oder Kombination) o Imitationslernen als Spezialfall des instrumentellen Konditionierens -14 Bekräftigungstheorie von MILLER und DOLLARD (1941) : Ohne Bekräftigung findet kein Lernen und somit kein Imitationslernen statt. Für jeden Lernakt sind, nach MILLER undDOLLARD, 4 Bestimmungsstücke notwendig: (1) Bedürfnis (drive) muss da sein (2) Hinweisreiz (cue) muss gegeben sein (3) Reaktion (response) (4) Bekräftigung (reward = Triebreduktion) MILLER und DOLLARD haben ihre theoretischen Überlegungen durch zehn Experimente mit Ratten und Kindern zu festigen versucht. - Ergebnisse: ~ Nachahmung ist erlerntes Verhalten ~ Unterscheidung von zwei Klassen von Imitationsverhalten: copying = Verhaltensangleichung matched-dependent behavior = reagieren auf das Verhalten des Vorbilds, Nachbildung - Kritikstellen: ~ Zirkularitätsfalle ~ Nachahmung kann ohne Bekräftigung nicht erklärt werden ~ Der Erwerb neuen Verhaltens kann nicht genau erklärt werden, da immer ReizReaktions-Verbindungen gelernt werden ~ Gültigkeit der Experimente: Situationen waren einfache Problemlöseaufgaben o Generalisierte Imitation: Fortführung des Ansatzes von MILLER und DOLLARD. Generalisierte Imitation umschreibt eine Klasse funktionaläquivalenter Verhaltensweisen, die in der individuellen Lebensgeschichte erworben wird. Drei der vier zentralen Bestimmungsstücke werden beibehalten: cue, response, reinforcement; auf das Triebkonzept wird verzichtet. - Erwerb: Bekräftigung erster zufällig auftretender oder durch Aufforderung hervorgerufe ner Imitationsreaktionen. Kontingente Bekräftigung Generalisierung einer Klasse von Verhaltensweisen, die funktionsäquivalent sind Zur Aufrechterhaltung der generalisierten Imitation ist nach den Prinzipien der operanten Konditionierung nur noch intermittierende Bekräftigung notwendig. o Kognitiv-affektive Vermittlung: Einführung von kognitiv-affektiven Vermittlungskonstrukten durch MOWRER und ARONFREED. Bruch mit der behavioristischen Sichtweise Zwei-Faktoren-Theorie von BANDURA: 1.Schritt: Erwerb eines Abbildes (image oder kognitive Schablone) des Vorbildverhaltens 2.Schritt: Verhaltensausführung Lernen findet vor der Verhaltensausführung statt Emotionale Prozesse spielen eine entscheidende Rolle. Affektänderungen, die der Beobachter während der Beobachtung erfährt, werden durch klassisches Konditionieren mit dem Abbild (cognitive template) assoziiert. - Kritik: ~ kognitionspsychologische Sicht: Konstrukt bleibt zu vage, keine präzisen Vor stellungen über seinen Aufbau, seine Speicherung und über Prozessse der Umsetztung in Verhalten -15~ motivationspsychologische Sicht: kritisieren der ausschließlichen Bindung an Emotionsprozesse Sozial-kognitive Theorie: Ein Kernstück der sozial-kognitiven Theorie von BANDURA (1977a) bildet die Annahme, dass der Mensch die Fähigkeit besitzt, durch Beobachtung zu lernen und Einsicht zu gewinnen. BANDURAS Anliegen war von Beginn an die Auseinandersetzung mit dem Lernbegriff der operanten Konditionierung. Drei Kernannahmen der Theorie: (1) stellvertretende, symbolische und selbstregulierende Prozesse spielen für die psychologischen Funktionen wichtige Rolle (2) entscheidende Bedeutung des Selbstregulationsprozesses: Menschen wählen Reize aus, organisieren sie und formen sie um (3) das Denken, Affekte und das Verhalten kann durch das Beobachten anderer beeinflusst werden Beobachtungsparadigmen Präzisierung der Zwei-Faktoren-Theorie: Erwerb durch klassische Konditionierung Kognitive Repräsentationen Ausführung Aufbau in der Erwerbsphase Regulieren Verhaltensausführung kognitive Repräsentationen Ausführung Durch Bekräftigung Es finden im Beobachtungslernen vier Subprozesse statt: (1) Aufmerksamkeitsprozesse in der Beobachtungsphase Bereits beim Aufnahmeprozess findet Selektion statt; Aufmerksamkeit kann durch verschiedene Variablen gefördert oder gestört werden (2) Behaltensprozesse der Speicherung und Verarbeitung Das Material wird entweder sprachlich oder bildlich kodiert, organisiert und gespeichert Sprachliche Kodierung ist der bildlichen überlegen (3) Motorische Reproduktionsprozesse Person steuert sich selbt, Diskrepanz zwischen dem kognitiven Abbild und dem eigenen Verhalten, die in einem Selbstbeobachtungsprozess registriert werden, führen zu korrektiven Anpassungsprozessen (4) Motivationsprozesse zur Verhaltensausführung Motivationsprozesse wirken als Ausführungsregularien, die nur durch Bekräftigung angeregt sind. Man unterscheidet (1) direkte Bekräftigung, (2) stellvertretende Bekräftigung und (3) Selbstbekräftigung o Vorbildeffekte: BANDURA unterschied drei verschiedene Vorbildeffekte: Lernen durch Beobachtung Erwerb neuer Verhaltensmuster oder Zusammensetzung bekannter Teilreaktionen Observational learning Vorhandene Verhaltensmuster werden effect unter neue Situationskontrolle gebracht Hemmung oder Enthemmung Inhibitory/ dishibitory effect Unterdrückung von potenziell verfügbaren, aber sozial sanktionierten Verhaltensweisen oder Befreiung dieser Verhaltensweisen von Hemmung (Phobien) Reaktionserleichterung Response facilitation effect Ein Verhalten, das weder neu noch sozial sanktioniert ist, wird durch gleiches Verhalten anderer ausgelöst -16 Diese Einteilung dient zur Systematisierung, hat aber kaum praktische Forschungsrelevanz Ansätze zu einer Motivationstheorie der Vorbildwirkung o Nachahmung als Selbstregulation Als Rahmenmodell für Motivation und Selbstregulation diente das einfache Modell des Regelkreises bzw. der TOTE-Einheit (Test-Operate-Test-Exit): ein bestehender Zustand wird mit einem Referenzkriterium verglichen (Test); bei Abweichungen (Ist-SollDiskrepanz) wird korrigiert (Operate) und erneut verglichen (test). Dieser Zyklus wird solange durchlaufen, bis eine genügende Ist-Soll- Anpassung erreicht ist (Exit). POWERS (1973) postuliert zwei Parameter, durch die das System in Gang gesetzt und in Gang gehalten wird: (1) Ziel (purpose): verhindert Abweichungen von einem Standard (2) Standard: Eine Hierarchie mehrerer ineinander verschachtelter Regelkreise und somit eine hierarchische Ordnung von Standards wird postuliert Der Standard für jeden Regelkreis wird durch den output des nächst Höhergeordneten Regelkreises gebildet Der Informationseinstrom wird auf verschiedenen Kontrollniveaus analysiert und mit dem auf dem jeweiligen Nivea gültigen Standard verglichen. Man unterscheidet 9 Kontrollniveaus: * EBENE 1 - Unterste Ebene: Kontrolle von Reizintensitäten bzw. deren Empfindungen * EBENE 2-6: Kontrolle motorischer Ausführungen, raum-zeitliche Koordination von zusammengehörigen Bewegungsmustern * EBENE 7 - Niveau der Programmkontrolle: Entscheidung über Handlungen und Strategien; Voraussetzung ist Kenntnis der Wenn-Dann-Beziehungen * EBENE 8 – Prinzipienkontrolle: Orientierung an logischen und moralischen Prinzipien * EBENE 9 – System-Kompetenzkontrolle: beinhaltet generalisierte Orientierungsleitlinie der Lebensgestaltung Es werden nicht bei jeder Handlung alle Kontrollebenen durchlaufen!! Alltagshandlungen bleiben auf der Programmebene stehen Mit diesem Modell lassen sich gut Nachahmungshandlungen und die Wirkung von Vorbildern beschreiben: Die Person reguliert ihr Verhalten gemäß einem Referenzstandard, der durch das, was vorher am Vorbild beobachtet wurde, mitbestimmt wird. Durch dieses Modell kann auch das Phänomen der Kontraimitation erklärt werden: Kontraimitation = aktive Distanzierung vom Vorbild; Widerstand gegen einen von außen nahegelegten Standard Interpretation als Reaktanzeffekt, der durch die Orientierung an einem übergeordneten Prinzip motiviert ist Erhaltung der persönlichen Freiheit, Erhaltung des Selbstwertes, Erhöhung der eigenen Fähigkeitseinschätzung - Schwachpunkt des kontrolltheoretischen Selbstregulationsansatzes: wenig Auskunft über motivationale Bedingungen -17- o Reaktionsunsicherheit: Reaktionsunsicherheit (response uncertainty) bezeichnet einen Zustand, in dem die Person nicht über schnell Abrufbare Handlungspläne verfügt und sich unsicher über situationsangemessenes Verhalten ist. Dieser Zustand betrifft sowohl Verhaltens-, Kognitions-, als auch Emotionsaspekte. Dieses Konzept wurde von THIELEN, DOLLINGER und KIRKLAND (1979) aufgestellt. Thesen: (1) Bereitschaft zur Nachahmung sinkt mit zunehmender Strukturiertheit der Situation und mit zunehmender Vorkenntnis bezüglich der Aufgabe (Situationstrukturiertheit und Vorkenntnisse versorgen Person mit konkreten Handlungsanleitungen und reduzieren Unsicherheiten) (2)Bereitschaft steigt mit vorheriger Misserfolgserfahrung o Vorbildwirkungen bei Leistungshandeln: Besonderes Interesse wurde in der Vorbildforschung dem Thema Vorbildwirkungen auf Standards, die Kinder an ihr eigenes Leistungshandeln anlegen, entgegengebracht. Dieses Thema wurde mit Hilfe zweier Untersuchungen nachgegangen. - Ablauf der Untersuchung: es wurde Kindern eine Leistungsaufgabe gegeben, die Vorerfahrung der Kinder mit der Aufgabe wurde variiert, das Leistungsmotiv der Kinder wurde erhoben Die Kinder beobachteten ein Vorbild, das die gleichen Leistungsergebnisse erzielt wie sie, sich selbst aber in einer Bedingung hohe, in der anderen niedrige Leistungsstandards setzt AV = auf Seiten der Kinder wurde Standardsetzungen, Selbstbewertungen, Schwierigkeits- und Tüchtigkeitseinschätzungen, Kausalattribuierungen erhoben - Ergebnisse: ~ ohne Aufgabenerfahrung hohe Reaktionsunsicherheit Orientierung des Standards am Vorbild (nicht exakt), Übernahme von Prinzipien nach längerer Beschäftigung mit der Aufgabe passen die Kinder ihren Standard dem eigenen Leistungsniveau an, werden unabhängiger ~ mit Aufgabenerfahrung Vergleich mit Vorbild, Vorbildeinfluss geringer klarer Motiveffekt: Misserfolgmotivierte: richten nach Vorbild Erfolgsmotivierte: unbeeinflussbar oder kontraimitativ, d.h sie setzen den eigenen Standard nach niedrigem Vorbildstandard etwas über dem eigenen Tüchtigkeitsniveau an bleiben längerer Zeit stabil!! -18Diese Motivatonsanalyse zeigt, auf welche Weise Vorbilder direkte und indirekte Wirkungen haben und wie unterschiedlich die Informationen, die ein Vorbild vorgibt, verarbeitet werden und das Handeln anderer beeinflusst. 5.3 Bedingungen der Vorbildwirkung: Merkmale des Vorbilds: Bestimmte Vorbilder werden eher nachgeahmt; Kriterien sind u.a. Geschlecht, Alter, Rasse, Kompetenz Beobachter nutzt diese Merkmale als Information über zu erwartende Handlungskonsequenzen kein durchschlagender Effekt eines einzelnen Kriteriums Interaktion Vorbildsituationen: ~ Situative Rahmenbedingungen haben größere Bedeutung als überdauernde Vorbildmerkmale ~ Bekräftigung des Vorbildverhaltens hat, nach THELEN und RENNIE, nur dann einen förderlichen Effekt auf die Nachahmung, wenn der Beobachter sie als relevant für das eigene Handeln erkennt. Man unterscheidet: Fremdbekräftigung und Selbstbekräftigung ~ es spielt eine Rolle, ob in der Vorbilddarbietung Widersprüchlichkeiten enthalten sind. Konflikt durch unklare Handlungsanweisungen es wird das Verhalten gewählt, das für die Personen weniger Bedürfnisverzicht bedeutet Beziehungen zwischen Vorbild und Beobachter: Einfluss von Wärme und Zuwendung, die das Vorbild gegenüber dem beobachtenden Kind zeigt. Es wird angenommen, dass der Einfluss von Wärme entwicklungsabhängig mit dem Alter sinkt. Motivationspsychologische Erklärungen: ~ bei Verhaltensweisen, die einen Bedürfnisverzicht verlangen, z.B. Selbstkritik und Selbstkontrolle, altruistisches Handeln oder aggressives Handeln, mindert warme Zuwendung die Nachahmung; durch die Zuwendung sinken die Sanktionsbefürchtungen ~ bei der Nachahmung neutraler Verhaltensweisen wirkt Wärme nachahmungsfördernt Merkmale des Beobachters: Defizite in der Aufmerksamkeits-, Speicherungs- und Ausführungsfähigkeit beeinträchtigen die Nachahmungsleistung Beobachtungssituationen: ~ Modus der Vorbilddarbietung: symbolisch, d.h. durch Film oder Video Zu berücksichtigen ist auch die direkte oder indirekte Lenkung der Aufmerksamkeit, die die Beobachtung und Speicherung beeinflussen Performanzsituationen: Wichtig sind alle Anreizbedingungen, die den Beobachter direkt oder indirekt auffordern, das gelernte Verhalten auszuführen, oder die ihm Anlass zur Vermutung geben, dass die Ausführung positive Handlungsfolgen herbeiführt oder negative verhindert. 5.4 Ausblick: Fragen des Imitations- und Beobachtungslernen finden immer weniger Interesse -19Eine integrative Vorbildtheorie wird nicht angestrebt; man schenkt eher einzelnen Teilgebieten mehr Aufmerksamkeit, z.B. evolutionstheoretische Perspektive, entwicklungspsychologischer Ansatz, Motivationstheorien, kognitionspsychologische sicht, Einfluss der modernen Medien Ansteckungseffekt