Kleines Lehrbuch der Astronomie und Astrophysik

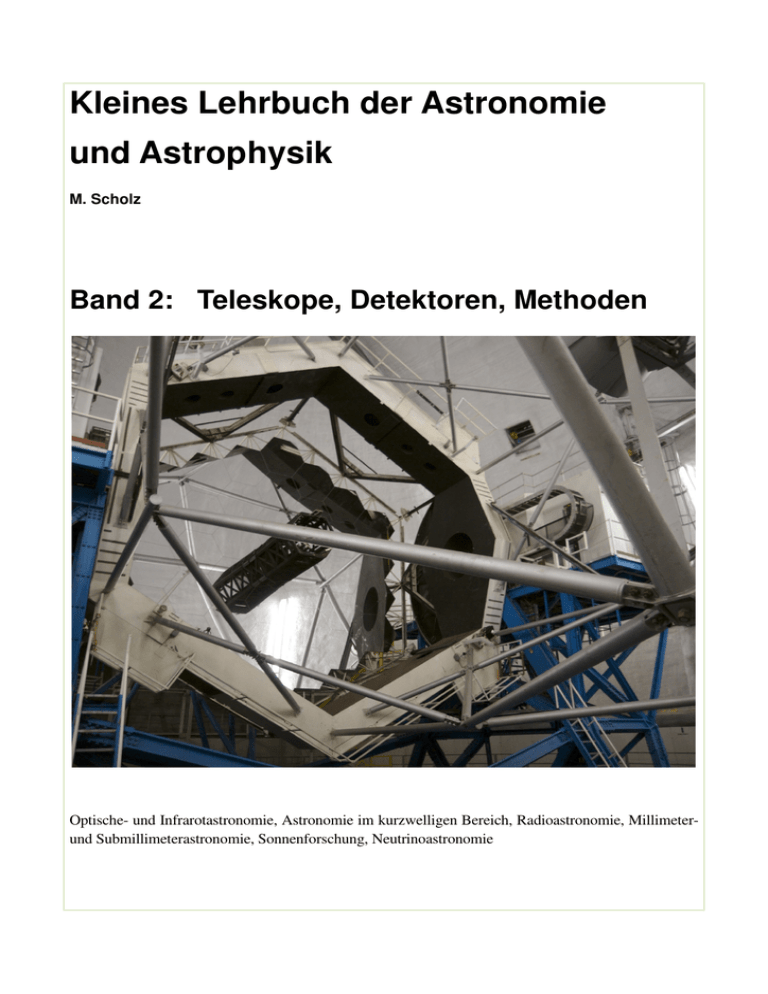

Werbung