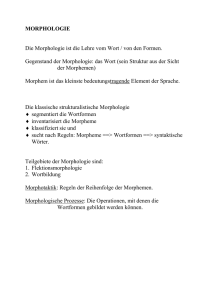

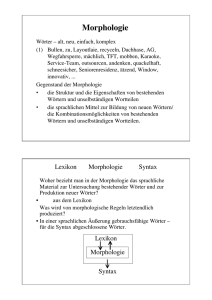

Morphologie und Lexikographie

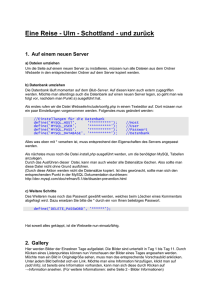

Werbung