Dokument 1

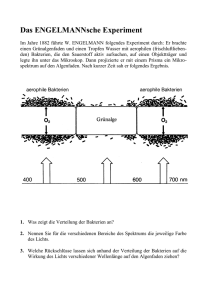

Werbung