2 –Test Anwendungen Der 2 –Test ist eine Klasse von Verfahren für

Werbung

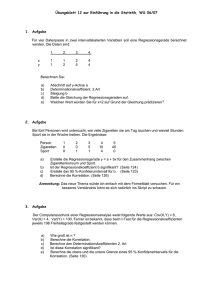

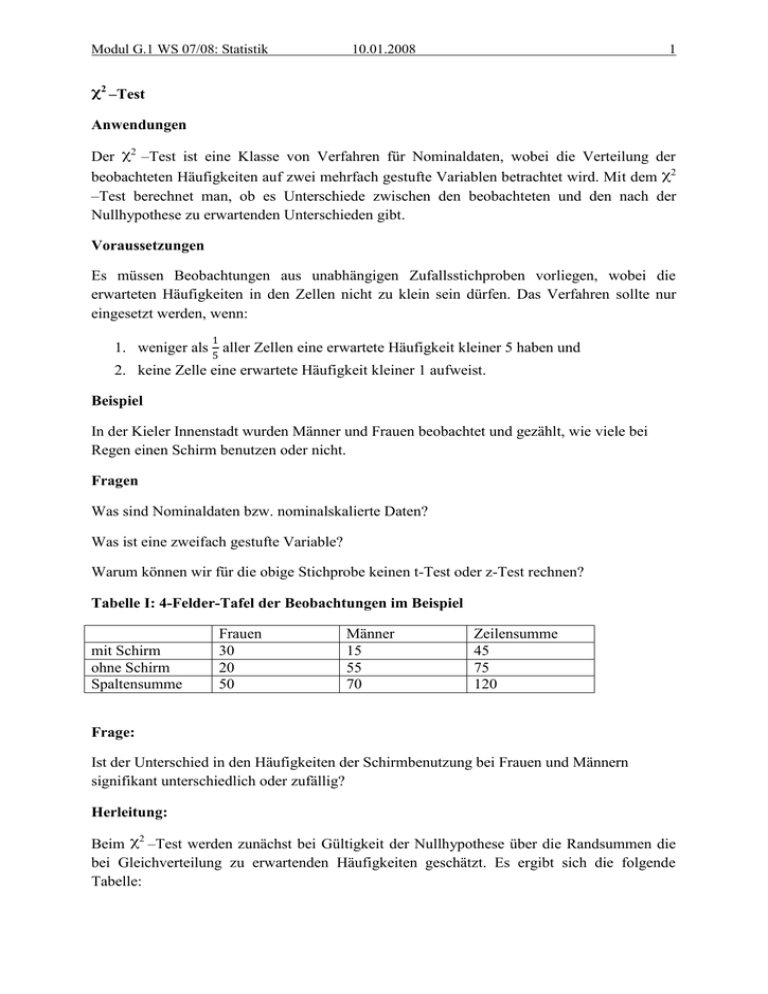

Modul G.1 WS 07/08: Statistik 10.01.2008 1 2 –Test Anwendungen Der 2 –Test ist eine Klasse von Verfahren für Nominaldaten, wobei die Verteilung der beobachteten Häufigkeiten auf zwei mehrfach gestufte Variablen betrachtet wird. Mit dem 2 –Test berechnet man, ob es Unterschiede zwischen den beobachteten und den nach der Nullhypothese zu erwartenden Unterschieden gibt. Voraussetzungen Es müssen Beobachtungen aus unabhängigen Zufallsstichproben vorliegen, wobei die erwarteten Häufigkeiten in den Zellen nicht zu klein sein dürfen. Das Verfahren sollte nur eingesetzt werden, wenn: 1 1. weniger als 5 aller Zellen eine erwartete Häufigkeit kleiner 5 haben und 2. keine Zelle eine erwartete Häufigkeit kleiner 1 aufweist. Beispiel In der Kieler Innenstadt wurden Männer und Frauen beobachtet und gezählt, wie viele bei Regen einen Schirm benutzen oder nicht. Fragen Was sind Nominaldaten bzw. nominalskalierte Daten? Was ist eine zweifach gestufte Variable? Warum können wir für die obige Stichprobe keinen t-Test oder z-Test rechnen? Tabelle I: 4-Felder-Tafel der Beobachtungen im Beispiel mit Schirm ohne Schirm Spaltensumme Frauen 30 20 50 Männer 15 55 70 Zeilensumme 45 75 120 Frage: Ist der Unterschied in den Häufigkeiten der Schirmbenutzung bei Frauen und Männern signifikant unterschiedlich oder zufällig? Herleitung: Beim 2 –Test werden zunächst bei Gültigkeit der Nullhypothese über die Randsummen die bei Gleichverteilung zu erwartenden Häufigkeiten geschätzt. Es ergibt sich die folgende Tabelle: Modul G.1 WS 07/08: Statistik 10.01.2008 2 Tabelle II: Darstellung der Randsummen mit Schirm ohne Schirm Spaltensumme Frauen Männer 50 70 Zeilensumme 45 75 120 Die nach der Nullhypothese zu erwartenden Häufigkeiten für die einzelnen Zeilen sind über die folgende Gleichung zu berechnen: fe(j,k) = f(erwartetes j,k) = = 𝐴𝑛𝑧𝑎 ℎ𝑙 𝐴𝑗 𝑁 * 𝑍𝑒𝑖𝑙𝑒𝑛𝑠𝑢𝑚𝑚𝑒 𝐴𝑛𝑧𝑎 ℎ𝑙 𝐵𝑘 𝑁 *N 𝑗 ∗𝑆𝑝𝑎𝑙𝑡𝑒𝑛𝑠𝑢𝑚𝑚𝑒 (𝑘) 𝑁 Die Anzahl Aj beschreibt die absolute erwartete Häufigkeit für die j-te Kategorie des ersten Merkmals und ist somit die absolute erwartete Häufigkeit für das Tragen eines Schirms mit 45 Beobachtungen. Analog dazu beschreibt die Abzahl Bk die Häufigkeiten für das Geschlecht. So ergeben sich pro Zelle die folgenden Erwartungswerte: mit Schirm ohne Schirm Spaltensumme Frauen 45∗50 = 18,75 120 75∗50 120 50 = 31,25 Männer 45∗70 = 26,25 120 75∗70 120 70 = 43,75 Zeilensumme 45 75 120 Vergleicht man die Häufigkeiten fe(j,k) mit den beobachteten Werten fb(j,k), so zeigt sich Zellenweise eine Differenz. Mit Hilfe des 2 –Tests kann nun bestimmt werden, ob diese Unterschiede signifikant sind. Anmerkung Der hier vorgestellte Vierfelder-2 –Test ist auf beliebig viele Felder erweiterbar. So könnte auch untersucht werden, ob sich Psychologie-, Jura- und Germanistikstudierende in der relativen Häufigkeit des Schirmtragens unterscheiden. Modul G.1 WS 07/08: Statistik 10.01.2008 3 Die Freiheitsgrade lassen sich über die Anzahl der Zellen mit frei variierbaren Häufigkeiten veranschaulichen. Da innerhalb einer Spalte die Summe der Zeilen immer der Randsumme entsprechen muss, sind p – 1 Zeilensummen frei variierbar. Analog dazu sind q – 1 Spaltensummen frei wählbar, da auch hier pro Zeile die Summe der Spalten die jeweilige Randsumme ergeben muss. Damit sind (p – 1) * (q - 1) Zellenhäufigkeiten frei. Im Beispiel ergibt sich folgender 2 –Wert: 2 = (30−18,75)2 18,75 + (15−25,25)2 26,25 + (20−31,25)2 31,25 + (55−43,75)2 43,75 = 6,75 + 4,82 + 4,05 + 2,30 = 17,92 Bei einem Freiheitsgrad von (2-1) * (2-1) = 1 ist den 2 entsprechenden Tabellen (z.B. B.16 und B.17 (Leonhart 2004)) bei einem α-Niveau von 5% ein kritischer Wert von 3,84146 zu entnehmen. Da der berechnete 2 –Wert größer als der kritische Wert in der Tabelle ausfällt, ist in diesem Beispiel auf signifikante Unterschiede in der Schirmbenutzung zwischen Männern und Frauen zu schließen. Anmerkung Da beim 2 –Test ausschließlich bei einem Freiheitsgrad von 1 gerichtete Hypothesen möglich sind, werden die meisten Tabellen für kritische Werte für ungerichtete Hypothesen erstellt. Soll bei einem Freiheitsgrad von 1 eine gerichtete Hypothese getestet werden, so ist bei einem α-Niveau von 5% der kritische 2 –Wert der Fläche von 0,90 zugrundezulegen. Fragen Formuliere sämtliche Hypothesen für obiges Beispiel. Warum gehen nur ungerichtete Hypothesen bei mehr als vier Feldern? Wie können wir gerichtete Hypothesen testen, wenn wir mehr als vier Felder haben? Phonetisches Beispiel mit mehr als vier Feldern? Modul G.1 WS 07/08: Statistik 10.01.2008 4 Korrelation und Regression Zusammenhang zwischen mehreren kontinuierlichen Variablen. Z.B: Haben überdurchschnittlich gute Psychologiestudenten auch eine überdurchschnittliche soziale Kompetenz ? Wenn ja: positiver Zusammenhang. Falls das Gegenteil der Fall ist (da die besonders guten Studenten ihre ganze Zeit mit Lernen verbracht haben) gibt es einen negativen Zusammenhang. Frage 65 55 60 RMS [dB] 70 75 Interpretiere folgende Abbildung 300 350 400 450 F1 [Hz] Frage: Weitere Beispiele für Zusammenhänge zwischen Variablen? Andere Beispiele: 1. Körpergröße – Körpergewicht, 2. Zungenhöhe und Gaumenkontakt, 3. Frequenzwerte von F1 und f0 Modul G.1 WS 07/08: Statistik 10.01.2008 5 Kovarianz = Maß für den linearen Zusammenhang zwischen zwei Variablen X und Y (covariance). Zähler: Summe der Abweichungen vom Mittelwert für Variable X multipliziert mit den Abweichungen für Y. Fall 1: Beide Messwerte weichen stark positiv oder stark negativ von ihren Mittelwerten ab Produkt positiv Fall 2: Ein Messwert weicht negativ und der andere positiv von den Mittelwerten ab Produkt ist negativ Verhalten sich nun alle Differenzen einheitlich, d.h. sind sie für einen vorgegebenen Zusammenhang alle positiv oder negativ, so wird der Betrag der Summe größer als bei ständig wechselnden Vorzeichen. Nenner: Division durch die Anzahl der Messwerte ist notwendig, da die Summe automatisch größer wird, je mehr Messwerte in die Berechnung eingehen. Für Stichproben wird durch (n – 1) geteilt. Die Kovarianz kann theoretisch unendlich große positive oder negative Werte annehmen und ist damit schwierig zu interpretieren. Ein positiver Zusammenhang ist vorhanden, wenn mit höherer Ausprägung in der Variablen X auch eine höhere Ausprägung in der Variablen Y gegeben ist. Beispiel Zusammenhang zwischen Alter und benutzter Wortmenge bei Kleinkindern. Mit höherem Alter verwenden Kinder mehr Wörter. Für eine untersuchte Stichprobe gilt: Überdurchschnittlich alte Kinder verwenden mehr Wörter als durchschnittlich alte Kinder. Umkehrschluss: Kinder die weniger Wörter als der Durchschnitt verwenden sind vermutlich auch unter dem Altersdurchschnitt. Fragen Beispiel für negativen Zusammenhang? Beispiel für keinen Zusammenhang? Achtung Kovarianzen erlauben nur Aussagen über stochastische Zusammenhänge zwischen Variablen. Es können aus Kovarianzen keine Kausalaussagen abgeleitet werden. Unzulässige Kausalaussage: Je höher die Ausprägung im Merkmal A, desto höher muss auch die Ausprägung im Merkmal B sein. Modul G.1 WS 07/08: Statistik 10.01.2008 6 Problem Die Kovarianz ist stark vom ‘‘Maßstab‘‘ der Daten abhängig (z.B. bei Gewichtsangaben in Gramm vs. Kilo vs. Tonnen). Dieser Maßstab beeinflusst neben der Varianz auch die Kovarianz. Lösung Standardisierung der Kovarianz syx an der Standardabweichung der beiden Variablen. Daraus folgt der Korrelationskoeffizient. Ähnlich: z-Transformation. Hier entsteht durch Normierung eine z-Verteilung mit dem Mittelwert 0 und der Streuung 1. Berechnung der z-Scores: zi=(xi- 𝑥 )/sx. So entsteht Vergleichbarkeit zwischen Datensätzen, die sich in Mittelwert und Standardabweichung unterscheiden. Korrelation Die Korrelation ist ein standardisiertes Maß für den linearen Zusammenhangzwischen zwei Variablen. Die Kovarianz ist stark vom Maßstab der Daten abhängig. Die Korrelation hingegen nimmt stets Werte zwischen 1 und -1 an. Damit sind Korrelationskoeffizienten rxy (auch ρ (gesprochen roh)) normierte Kennwerte, die besser zu vergleichen sind als Kovarianzen und außerdem besser interpretierbar sind. Produkt-Moment Korrelation Interaktive Beispiele zur Punkt-Moment-Korrelation: http://psychologie.fernuni-hagen.de/methoden/ils/kurs/kap14/kap14_2.html a. Graphische Darstellung der Produkt-Moment-Korrelation b. Unsinnige Zusammenhänge Modul G.1 WS 07/08: Statistik 10.01.2008 7 Voraussetzungen für Produkt-Moment Korrelation: 1. 2. 3. 4. Beide Variablen müssen intervallskaliert sein. Beide Variablen müssen normalverteilt sein. Der Zusammenhang zwischen beiden Variablen sollte linear sein. Homoskedastizität: für alle Individuen i, die ein gleiches xi haben, müssen die entsprechenden yi normalverteilt sein. Andere Korrelationskoeffizienten (vgl. Tabelle 11.1 in Leonhart): 1) Spearmans Rangkorrelation: Alle Beobachtungen werden durch ihren Rang ersetzt. Verwendung: wenn keine Normalverteilung vorliegt, bei kleinem N, Voraussetzung: die Daten müssen mindestens ordinalskaliert sein. Nachteil: sehr anfällig für Ausreißer. 2) Kendalls τ: die übereinstimmenden und nicht-übereinstimmenden Paare werden gezählt. Übereinstimmendes Paar = Differenz der x Koordinate hat gleiches Vorzeichen wie die Differenz der y Koordinate. Verwendung: bei ordinalskalierten Daten mit vielen Ausreißern Nachteil: Da dabei alle Ränge miteinander verglichen werden, ist der Rechenaufwand sehr hoch. Interpretation r = -1 negative Winkelhalbierende, perfekter Zusammenhang, kommt in der Sozialwissenschaft nicht vor. Wenn r = -1 zu beobachten ist, ist eine Berechnung der Korrelation normalerweisen nicht sinnvoll (Bsp.: Zusammenhang von Körpergröße und Abstand zu einer 2,50 hohen Zimmerdecke) -1 < r < 0 negative Korrelation negativ gerichtete Punktwolke, „je größer x umso kleiner y“ z.B. Intelligenzquotient und Lösungszeit für eine Aufgabe, f0 und F1 bei Vokalen r=0 ca. kreisförmige Punktwolke es existiert kein Zusammenhang zwischen den Variablen 0<r<1 positive Korrelation positiv gerichtete Punktwolke, „je größer y umso größer x“ z.B. Körpergröße und Körpergewicht, Körpergröße und f0 r=1 positive Winkelhalbierende, siehe r = -1. JE NÄHER DER KORRELATIONSKOEFFIZIENT BEI 1 ODER -1 LIEGT UND JE SCHMALER DIE PUNKTWOLKE, DESTO DEUTLICHER ODER AUSGEPRÄGTER IST DER ZUSAMMENHANG ZWISCHEN ZWEI VARIABLEN Modul G.1 WS 07/08: Statistik 10.01.2008 Vorsicht vor Fehlinterpretationen: Auch aus einer hohen Korrelation darf kein kausaler Zusammenhang geschlossen werden!!! Signifikanzprüfung Nullhypothese: Der Stichprobenkorrelationskoeffizient unterscheidet sich nicht signifikant von 0 (=Populationskorrelationskoeffizient). Alternativhypothese: r ≠ 0 Zur Überprüfung wird wiederum ein t-Test verwendet. Vorsicht: Bei großen Stichproben werden auch niedrige Korrelationskoeffizienten leicht signifikant 8