Document

Werbung

II. Sachversicherungsmathematik

Im Gegensatz zur Personenversicherungsmathematik, die im wesentlichen auf Sterbe- und anderen

Ausscheidewahrscheinlichkeiten beruht, die aufgrund großer Datenbestände regelmäßig in repräsentativem Umfang erhoben und gepflegt werden können, sind die wahrscheinlichkeitstheoretischen Grundlagen der Sachversicherung erheblich weniger gut gesichert. Deshalb kommt hier der

mathematischen Statistik und Modellierung als Hilfsmittel zur Erfassung und Beschreibung der

potenziellen Risiken eine große Bedeutung zu. Zwei wesentlichen Komponenten begegnet man hier

aber in jedem Fall immer wieder: zum einen der Schadenfrequenz, d.h. der Häufigkeit, mit der Versicherungsschäden oder Schäden auslösende Ereignisse innerhalb einer Police in einem befristeten

Zeitraum – in der Regel ein Jahr – auftreten (etwa die Anzahl der Sturmschäden in der Gebäudeversicherung, oder die Anzahl der Verkehrsunfälle in der Kraftfahrzeug-Haftpflichtversicherung),

zum anderen die Einzelschadenhöhe, d.h. der geldwerte Schaden, der durch das jeweilige Schadenereignis ausgelöst wird (z.B. die Reparaturkosten für verlorene Dachpfannen bei einem Sturm oder

beschädigte Fahrzeuge bei einem Verkehrsunfall). Diese beiden Komponenten sind wesentliche

Bestandteile des sogenannten kollektiven Modells der Risikotheorie, das nun als erstes im Detail

vorgestellt wird.

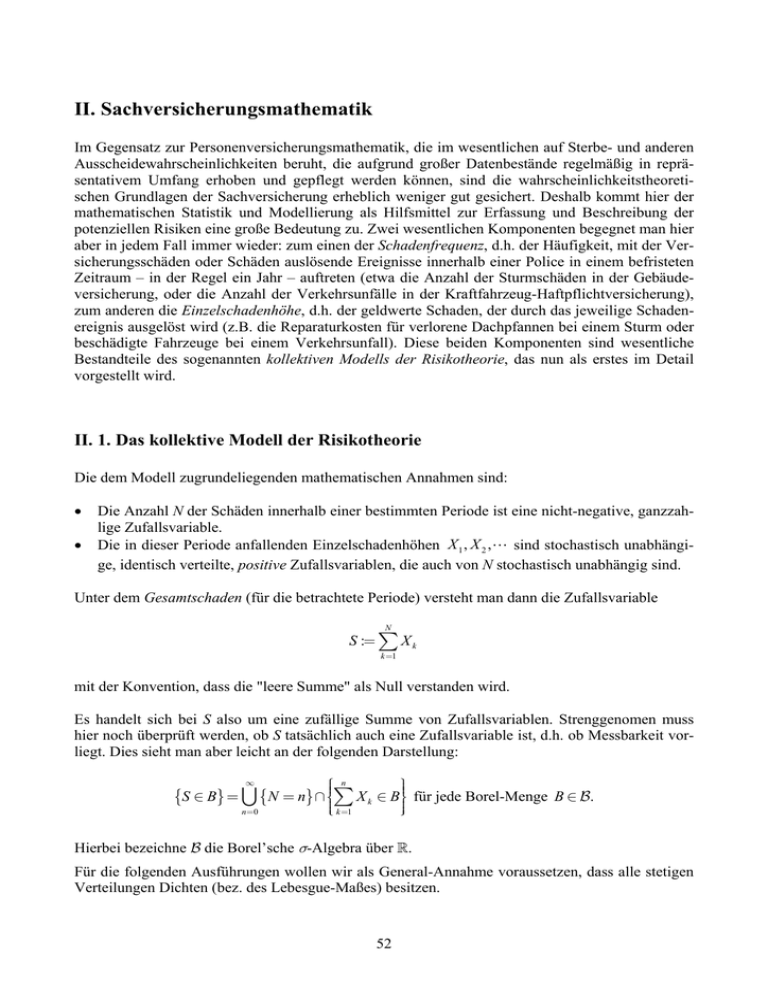

II. 1. Das kollektive Modell der Risikotheorie

Die dem Modell zugrundeliegenden mathematischen Annahmen sind:

•

•

Die Anzahl N der Schäden innerhalb einer bestimmten Periode ist eine nicht-negative, ganzzahlige Zufallsvariable.

Die in dieser Periode anfallenden Einzelschadenhöhen X 1 , X 2 , sind stochastisch unabhängige, identisch verteilte, positive Zufallsvariablen, die auch von N stochastisch unabhängig sind.

Unter dem Gesamtschaden (für die betrachtete Periode) versteht man dann die Zufallsvariable

N

S := ∑ X k

k =1

mit der Konvention, dass die "leere Summe" als Null verstanden wird.

Es handelt sich bei S also um eine zufällige Summe von Zufallsvariablen. Strenggenomen muss

hier noch überprüft werden, ob S tatsächlich auch eine Zufallsvariable ist, d.h. ob Messbarkeit vorliegt. Dies sieht man aber leicht an der folgenden Darstellung:

∞

⎧ n

⎪

⎪

⎪ k =1

⎩

⎪⎫

⎪⎭⎪

{S ∈ B} = ∪ { N = n} ∩ ⎪⎨∑ X k ∈ B⎪⎬ für jede Borel-Menge B ∈ B.

n=0

Hierbei bezeichne B die Borel’sche σ-Algebra über R.

Für die folgenden Ausführungen wollen wir als General-Annahme voraussetzen, dass alle stetigen

Verteilungen Dichten (bez. des Lebesgue-Maßes) besitzen.

52

Von zentralem Interesse für die Sachversicherungsmathematik ist die Verteilung des Gesamtschadens. Hierbei spielt der Begriff der Faltung von Verteilungen eine große Rolle.

Definition 2 (Faltung). Es seien X und Y reellwertige, stochastisch unabhängige Zufallsvariablen.

Dann heißt die Verteilung der Summe X + Y die Faltung der Verteilungen von X und Y, in Zeichen:

P X +Y = P X ∗ PY .

Die Faltung von Verteilungen kann auf verschiedene Weise dargestellt werden:

Lemma 8. Es seien X und Y stochastisch unabhängige, reellwertige Zufallsvariablen. Ihre Verteilungsfunktionen seien mit FX und FY bezeichnet, bei stetigen Verteilungen ferner ihre Dichten

entsprechend mit f X und fY . Die Verteilungsfunktion der Faltung P X ∗ PY sei mit FX ∗ FY bezeichnet, entsprechend die Dichte mit f X ∗ fY . Dann gilt:

∞

FX ∗ FY ( z ) = FY ∗ FX ( z ) = ∫ FX ( z − v) fY (v) dv

−∞

∞

f X ∗ fY ( z ) = fY ∗ f X ( z ) = ∫ f X ( z − v) fY (v) dv, z ∈ .

−∞

Beweis: Es ist

∞

∞

FX ∗ FY ( z ) = P ( X + Y ≤ z ) = ∫ P ( X + Y ≤ z | Y = y ) PY (dy ) = ∫ P ( X + y ≤ z ) PY (dy )

−∞

−∞

∞

∞

= ∫ FX ( z − y ) PY (dy ) = ∫ FX ( z − y ) fY ( y ) dy,

−∞

−∞

woraus durch Differentiation folgt

∞

f X ∗ fY ( z ) =

∞

d

d

FX ∗ FY ( z ) =

∫ FX ( z − y) fY ( y) dy = ∫ f X ( z − v) fY (v) dv.

dz

dz −∞

−∞

Die Verteilung des Gesamtschadens lässt sich damit auf folgende Weise ausdrücken:

Lemma 9. Für die Verteilungsfunktion FS des Gesamtschadens gilt:

∞

⎧⎪

⎪⎪ p0 + ∑ pn F n∗ ( z ), falls z ≥ 0

P ( S ≤ z ) = FS ( z ) = ⎨

n=1

⎪⎪

falls z < 0.

⎪⎪⎩0,

53

Dabei bezeichne pn := P( N = n) für n = 0,1,

die Elementarwahrscheinlichkeiten von N und

F n∗ die n-fache Faltung von F, der Verteilungsfunktion der Einzelschadenhöhen.

Ferner gilt für die bedingte Verteilung unter S > 0 :

⎧

⎪ 1

FS ( z ) − FS (0) ⎪

⎪

P ( S ≤ z | S > 0) =

= ⎨1− p0

⎪

1− FS (0)

⎪

⎪

⎪

⎩0,

∞

∑p

n

F n∗ ( z ), falls z ≥ 0

n=1

falls z < 0.

Sind die Einzelschadenhöhen stetig verteilt, so auch der Gesamtschaden S unter S > 0 mit

f S ( z | S > 0) =

1

1− p0

∞

∑p

n

f n∗ ( z ) für z ≥ 0.

n=1

Hierbei bezeichnet analog f n∗ die n-fache Faltung von f, der Dichte der Einzelschadenhöhenverteilung.

Beweis: Es ist nach obigem

∞

⎛∞

⎧ n

⎫⎞

⎛ n

⎞

⎪

⎪

P ( S ≤ z ) = FS ( z ) = P ⎜⎜⎜ ∪ { N = n} ∩ ⎨⎪∑ X k ≤ z⎬⎪⎟⎟⎟ = p0 + ∑ pn P ⎜⎜∑ X k ≤ z ⎟⎟⎟

⎜⎝ k =1

⎪

⎪

⎠

⎝ n=0

n=1

⎪ k =1

⎪⎠⎟

⎩

⎭

∞

= p0 + ∑ pn F n∗ ( z ), z ∈ .

n=1

Die angegebene Fallunterscheidung resultiert daraus, dass nach Voraussetzung der Positivität der

Einzelschadenhöhen F ( z ) = 0 ist für z < 0.

Die zweite Beziehung ergibt sich sofort hieraus wegen P ( S > 0) = 1− FS (0) = 1− p0 .

Man beachte, dass bei Stetigkeit der Einzelschadenhöhen in der Regel die Verteilung von S nicht

mehr stetig ist, sondern – falls p0 > 0 gilt – ein Atom im Nullpunkt besitzt. Allerdings bleibt in

diesem Fall die bedingte Verteilung von S unter S > 0 stetig mit

f S ( z | S > 0) =

d ⎡⎢ 1

dz ⎢⎣1− p0

⎤

n∗

⎥= 1

p

F

z

(

)

∑

n

⎥ 1− p0

n=1

⎦

∞

∞

∑p

n

f n∗ ( z ), z ≥ 0.

n=1

In speziellen Fällen lässt sich die Gesamtschadenverteilung explizit angeben:

Lemma 10. Die Verteilung von N sei geometrisch mit

pn = pq n , n = 0,1,

mit einem Parameter p = 1− q ∈ (0,1) ,

die Verteilung der Einzelschadenhöhen sei exponentiell E (λ ) mit einem Parameter λ > 0. Dann

gilt:

54

⎧⎪ p + (1− p )(1− e−λ pz ) , falls z ≥ 0

P ( S ≤ z ) = FS ( z ) = ⎪⎨

⎪⎪0,

falls z < 0.

⎩

Ferner ist der Gesamtschaden S unter der Bedingung S > 0 wieder exponentialverteilt, und zwar

nach E (λ p ).

Beweis: Die Verteilung einer Summe unabhängiger, exponentialverteilter Zufallsvariablen ist vom

Erlang-Typ (spezieller Gamma-Typ), d.h. es gilt hier für n ∈ :

f n∗ ( z ) =

λ n z n−1 −λ z

e , z ≥ 0.

(n −1)!

Es ergibt sich zunächst

f S ( z | S > 0) =

n n−1

∞

∞

1 ∞

(λqz ) n−1

n

n∗

n−1 λ z

−λ z

−λ z

pq

f

(

z

)

pq

e

λ

p

e

=

=

= λ p e−λ pz , z ≥ 0,

∑

∑

∑

q n=1

(n −1)!

n=1

n=1 ( n −1)!

=exp(λqz )

d.h. es ist S unter der Bedingung S > 0 nach E (λ p ) -verteilt. Hieraus folgt:

FS ( z ) = P ( S ≤ z ) = P( S ≤ z | S = 0) ⋅ P( S = 0) + P( S ≤ z | S > 0) ⋅ P( S > 0)

⎧

⎛z

⎞⎟

⎪⎪ p + (1− p )(1− e−λ pz ) , falls z ≥ 0

⎜

⎟

= 1⋅ P( N = 0) + ⎜⎜ ∫ f S (u | S > 0) du ⎟⋅ P( N > 0) = ⎨

⎪⎪0,

⎜⎝ 0

falls z < 0.

⎠⎟

⎩

Die Verteilung von S kann also aufgefasst werden als eine Mischung zweier Verteilungen, und

zwar einer Einpunktverteilung ε0 im Nullpunkt mit Gewicht p und einer Exponentialverteilung

E (λ p ) mit Gewicht 1− p.

Für die Darstellung der Gesamtschadenverteilung sind manchmal gewisse Transformationen von

Wahrscheinlichkeitsverteilungen nützlich.

Definition 3 (erzeugende Funktionen). Es sei X eine reellwertige Zufallsvariable derart, dass für

eine Teilmenge I ⊆ der Ausdruck

ψX (t ) := E (etX ) , t ∈ I

für alle t ∈ I endlich ist. Dann heißt die auf I definierte Abbildung ψX die momenterzeugende

Funktion zu X bzw. zu der Verteilung P X .

Die durch

ϕ X ( s ) := ψX (ln s) = E ( s X ) , s ∈ e I := {et | t ∈ I }

55

definierte Funktion heißt die wahrscheinlichkeitserzeugende Funktion zu X bzw. zu der Verteilung

PX .

Die momenterzeugende Funktion ψX charakterisiert die Verteilung P X eindeutig, wenn die Menge

I ein Intervall [−δ , δ ] mit δ > 0 enthält. Der zugehörige Beweis wird üblicherweise mit Hilfsmitteln der Fourier-Analyse geführt; wir verweisen deshalb hier auf die einschlägige Literatur zur

Wahrscheinlichkeitstheorie (z.B. BILLINGSLEY (1986), Theorem 30.1).

Satz 1. Es sei X eine reellwertige Zufallsvariable derart, dass für eine Teilmenge I ⊆

menterzeugende Funktion ψX existiert. Dann gilt:

die mo-

a) Es ist stets ψX (0) = ϕ X (1) = 1. Existiert ferner ψX (t ) für ein t = t ∗ > 0 bzw. t = t∗ < 0, so

auch für alle t ∈ ⎡⎢⎣0, t ∗ ⎤⎥⎦ bzw. t ∈ [t∗ , 0]. Bezeichnet speziell

t + := sup {t ∈

| ψX (t ) < ∞} , t − := inf {t ∈

| ψX (t ) < ∞} ,

(

so existiert ψX (t ) für alle t ∈ (t − , t + ) , und ϕ X ( s) existiert für alle s ∈ et , et

−

+

) (mit der Kon-

vention e−∞ = 0, e∞ = ∞). Gilt insbesondere X ≥ 0 bzw. X ≤ 0 (mit Wahrscheinlichkeit 1),

so ist t − = −∞ bzw. t + = +∞.

( ), k ∈

b) Es sei 0 < δ < min {t + , −t − } . Dann existieren sämtliche Momente E X

Nullpunkt beliebig oft differenzierbar , und es gilt

ψX ( k ) (0) = E ( X k ) , k ∈

∞

E(X k )

k =0

k!

ψX (t ) = ∑

und

t k , t ≤ δ.

Insbesondere ist

E ( X ) = ψX' (0), Var ( X ) = ψX'' (0) − {ψX' (0)} .

2

Ferner ist ϕ X ( s) für s = 1 differenzierbar, und es gilt

⎛ k −1

⎞

ϕ (Xk ) (1) = E ⎜⎜∏ ( X − i )⎟⎟⎟ , k ∈

⎜⎝ i=0

⎠

und

⎛ k −1

⎞

⎜⎜∏ ( X − i )⎟⎟

E

∞

⎜⎝

⎠⎟

( s −1) k , s −1 ≤ 1− e−δ .

ϕ X ( s ) = ∑ i =0

k

!

k =0

Insbesondere ist

56

k

, ψX ist im

E ( X ) = ϕ 'X (1), Var ( X ) = ϕ ''X (1) + ϕ 'X (1) {1− ϕ 'X (1)}.

c) Gilt P ( X ∈

+

) =1

mit

+

:= {0,1, 2, } , so lässt sich ϕ X fortsetzen, d.h. es existiert

ϕ X ( s ) = E ( s X ) auch für alle s ≤ 1, und es gilt

ϕ (Xk ) (0)

= P( X = k ), k ∈

k!

und

∞

ϕ X ( s ) = ∑ P( X = k ) s k , s ≤ 1.

k =0

d) Sind X und Y stochastisch unabhängige, reellwertige Zufallsvariablen mit momenterzeugenden

Funktionen ψX und ψY , die beide in derselben Menge I ⊆ existieren, so besitzt dort auch

die Zufallsvariable Z = X + Y eine momenterzeugende Funktion, und es gilt

ψX +Y (t ) = ψX (t ) ⋅ ψY (t ), t ∈ I

bzw. auch

ϕ X +Y ( s ) = ϕ X ( s ) ⋅ ϕY ( s ), s ∈ e I .

Beweis:

a) Die erste Aussage ist wegen e0 = 1 trivial. Mit der Hölder-Ungleichung7 erhält man ferner für

0 ≤ t ≤ t∗

t / t∗

{ ( )}

ψX (t ) = E (etX ) ≤ E et

∗

X

t / t∗

= {ψX (t ∗ )}

t

und Y ≡ 1), wenn man dort X durch e X ersetzt. Mit analoger Argument∗

tation folgt für t∗ ≤ t ≤ 0

(mit der Wahl p =

{

}

ψX (t ) = E (etX ) = E (e(−t )(− X ) ) ≤ E (e(−t∗ )(− X ) )

t / t∗

= {ψX (t∗ )}

t / t∗

(

.

)

Somit existiert ψX (t ) für alle t ∈ (t − , t + ) , also auch ϕ X ( s) für alle s ∈ et , et . Für X ≥ 0

−

+

(mit Wahrscheinlichkeit 1) ist stets e ≤ 1 für t ≤ 0 (mit Wahrscheinlichkeit 1), d.h. es folgt

t − = −∞. Analog folgt t + = +∞, falls X ≤ 0 (mit Wahrscheinlichkeit 1).

tX

b) Für t ≤ δ seien die Abbildungen Gn (t , i ) definiert durch

7

p

Für Zufallsvariablen X, Y, für die X und Y

q

integrierbar sind mit

1

+

p

{ (

absolut integrierbar, und es gilt (Hölder-Ungleichung) E ( X ⋅ Y ) ≤ E X

57

1

= 1, p, q > 0, ist das Produkt X ⋅ Y

q

p

)} {E ( Y )}

1/ p

q

1/ q

.

n

Gn (t ; x) := ∑

k =0

Für n ∈

xk k

t , x∈ , n∈ .

k!

und t ≤ δ ist dann

Gn (t ; X ) ≤ e

≤ eδ X + e−δ X =: Z ,

tX

d.h. Z ist integrierbar mit E ( Z ) = ψX (δ ) + ψX (−δ ). Ferner ist

n

X ≤

n!

n!

Gn (δ; X ) ≤ n Z für alle n ∈ ,

n

δ

δ

d.h. es existieren sämtliche Momente von X. Wegen

etX = lim Gn (t ; X ) für t ≤ δ

n→∞

sind die Voraussetzungen des Satzes von der majorisierten Konvergenz8 erfüllt, also gilt

⎛ n X k k ⎞⎟

t ⎟

ψX (t ) = E (etX ) = lim E (Gn (t ; X )) = lim E ⎜⎜∑

n→∞

n→∞

⎜⎝ k =0 k ! ⎠⎟⎟

n

= lim ∑

n→∞

E(X k )

k!

k =0

∞

E(X k )

k =0

k!

t =∑

k

t k , t ≤ δ,

wie behauptet. Die Differenzierbarkeit von ψX im Nullpunkt ergibt sich sofort durch gliedweise

Differentiation dieser Reihe, mit ψX ( k ) (0) = E ( X k ) , k ∈ .

Die letzte Behauptung ergibt sich analog unter Beachtung der Reihenentwicklung (verallgemeinerte binomische Formel)

k −1

∞

∏ ( x − i)

k =0

k!

s = (1 + ( s −1)) = ∑

x

x

i =0

( s −1) k , s −1 < 1. 9

c) Unter der angegebenen Bedingung lässt sich ϕ X darstellen als

∞

∞

ϕ X( k ) (0) k

ϕ X ( s ) = E ( s ) = ∑ s P ( X = k ) =∑

s ,

k!

k =0

k =0

X

8

k

Ist Y eine integrierbare Zufallsvariable und gilt X n ≤ Y für alle n ∈ , so folgt aus X n → X (mit Wahrscheinlich-

keit 1): E ( X n − X ) → 0 und damit auch E ( X n ) = E ( X ) für n → ∞.

k −1

9

Für ganzzahlige x ist die Reihe endlich, da

∏ ( x − i) = 0 ist für k > x.

i=0

58

∞

wobei die Reihe wegen

∑ P( X = k ) = 1 in jedem Fall für

s ≤ 1 (absolut) konvergiert. Hier-

k =0

aus folgt die Behauptung.

d) Mit X und Y sind auch die Zufallsvariablen etX und etY für alle t ∈

woraus sofort

stochastisch unabhängig,

ψX +Y (t ) = E (et ( X +Y ) ) = E (etX ⋅ etY ) = E (etX ) E (etY ) = ψX (t )ψY (t ), t ∈ I

folgt. Die andere Aussage ergibt sich völlig analog.

Die folgenden Tabellen geben einen Überblick über die erzeugenden Funktionen einiger für die

Versicherungsmathematik wichtigen Verteilungen.

P

Name

X

Zähldichte f ( k ) = P ( X = k )

ϕX ( s)

E( X )

Var ( X )

1

s s −1

⋅

n s −1

n +1

n −1

2

12

n

, k = 1,

Ln

Gleichverteilung

B ( n, p )

Binomialverteilung

⎛n⎞⎟ k

⎜⎜ ⎟ p (1 − p ) n−k , k = 0, , n

⎜⎝k ⎠⎟

(1 − p + ps )

NB (β , p )

negative

Binomialverteilung

⎛β + k − 1⎞⎟ β

k

⎜⎜

p (1 − p ) , k = 0,1, 2,

⎜⎝ k ⎠⎟⎟

⎛

⎞⎟

p

⎜⎜

⎜⎝1 − (1 − p ) s ⎠⎟⎟

Poisson-Verteilung

e

,n

n

P (λ )

−λ

λ

np (1 − p )

np

n

β

β

2

1− p

β

p

1− p

p

2

k

, k = 0,1, 2,

e

k!

λ

λ ( s −1)

λ

Man beachte, dass die negative Binomialverteilung NB (β , p ) auch für nicht-ganzzahlige Parameter β > 0 definiert ist; es gilt dann

⎛β + k − 1⎞⎟ (β + k −1)(β + k − 2)

⎜⎜

=

⎜⎝ k ⎠⎟⎟

k!

β

, k = 0,1, 2,

.

Als Spezialfall für β = 1 ergibt sich hieraus die geometrische Verteilung G ( p).

P

Name

X

R[ a , b ]

Gleichverteilung

E (λ )

Exponentialverteilung

Γ (α , λ )

Gamma-Verteilung

2

N ( µ, σ )

Normalverteilung

ψ X (t )

Dichte f ( x )

b−a

, a≤ x≤b

λ e −λ x , x ≥ 0

λ

α

e −e

bt

1

x

1

2πσ

2

e

2

12

1

λ −t

λ

λ

α

α

λ

λ

2

⎛ σ 2t 2

⎞

+ µt ⎟⎟ µ

⎜⎝ 2

⎠⎟

σ

2

⎛ ( x − µ) 2 ⎞⎟

⎟

2

⎜⎝

2σ ⎠⎟

exp ⎜⎜

59

(b − a )

1

, x>0

exp ⎜⎜−

a +b

λ

α

−λ x

Var ( X )

t (b − a )

⎛ λ ⎞⎟

⎜⎜

⎜⎝ λ − t ⎠⎟⎟

α −1

Γ (α )

at

E( X )

2

2

Die Exponentialverteilung ist ein Spezialfall der Gamma-Verteilung für α = 1.

Einige der genannten Verteilungen besitzen spezielle Faltungseigenschaften; so gilt etwa

B (n, p ) ∗ B (m, p ) = B (n + m, p )

NB (β , p ) ∗ NB (γ , p ) = NB (β + γ , p )

P (λ ) ∗ P (µ) = P (λ + µ)

Γ(α, λ ) ∗ Γ(δ , λ ) = Γ(α + δ , λ )

[n, m ∈ , 0 < p < 1]

[β , γ > 0, 0 < p < 1]

[λ, µ > 0]

[α, δ , λ > 0]

N (µ, σ 2 ) ∗ N (ν , τ 2 ) = N (µ + ν , σ 2 + τ 2 )

[µ, ν ∈ , σ 2 , τ 2 > 0].

Satz 2. Im kollektiven Modell der Risikotheorie gilt: existiert die wahrscheinlichkeitserzeugende

Funktion ϕN ( s) für 0 ≤ s < η mit η > 1 und die momenterzeugende Funktion ψX (t ) der die Einzelschadenhöhen repräsentierenden Zufallsvariablen X für 0 ≤ t < δ mit δ > 0, so gilt

ψS (t ) = ϕN (ψX (t )) , t ∈ I ,

wobei I ein geeignetes, die Null enthaltendes Intervall bezeichnet mit der Eigenschaft, dass

ψX ( I ) ⊆ [0, η ) ist. Ist X diskret mit Werten in , so gilt auch

ϕS (t ) = ϕN (ϕ X (t )) , t ∈ e I ∪ [0,1].

Insbesondere existieren alle Momente des Gesamtschadens S, und speziell gilt

E ( S ) = E ( N ) ⋅ E ( X ), Var ( S ) = E ( N ) ⋅Var ( X ) + Var ( N ) ⋅ {E ( X )} .

2

Beweis: Wir wählen τ > 0 so klein, dass 0 ≤ ψX (τ ) < η ausfällt; das ist wegen lim ψX (t ) = 1 nach

t →0

dem Satz von der majorisierten Konvergenz möglich. Mit der Wahl I ⊆ (−∞, τ ) ist ein geeignetes

Intervall I gefunden, da nach Voraussetzung über die Einzelschadenhöhen X > 0 gewählt werden

kann. Für t ∈ I folgt nun aufgrund der gemachten Unabhängigkeitsvoraussetzungen:

∞

⎛

⎛ N

⎞⎞

⎛N

⎞

⎛ n

⎞

ψS (t ) = E ⎜⎜⎜exp ⎜⎜t ∑ X k ⎟⎟⎟⎟⎟ = E ⎜⎜∏ etX k ⎟⎟ = P( N = 0) + ∑ P( N = n) ⋅ E ⎜⎜∏ etX k ⎟⎟

⎝⎜ k =1

⎠⎟

⎝⎜ k =1

⎠⎟

⎝⎜ k =1 ⎠⎟⎠⎟

⎝⎜

n=1

∞

n

∞

n=1

k =1

n=1

= P( N = 0) + ∑ P( N = n) ⋅ ∏ E (etX k ) = P( N = 0) + ∑ P( N = n) ⋅ {ψX (t )}

∞

= ∑ P( N = n) ⋅ {ψX (t )} = ϕN (ψX (t )).

n

n= 0

Bei diskretem X ergibt sich entsprechend nach Satz 1

ϕS (t ) = ψS (ln t ) = ϕN (ψX (ln t )) = ϕN (ϕ X (t )) , t ∈ e I .

60

n

Für 0 ≤ t ≤ 1 ist ferner auch 0 ≤ ϕ X (t ) = E (t X ) ≤ 1, so dass ϕS (t ) auch für t ∈ [0,1] existiert.

Die Existenz der Momente ist nach Satz 1 unter den gemachten Annahmen gesichert; speziell ist

E ( S ) = ψS' (0) = ϕN' (ψX (0))⋅ ψX' (0) = ϕN' (1)⋅ ψX' (0) = E ( N ) ⋅ E ( X ),

Var ( S ) = ψS'' (0) − {ψS' (0)} = ϕN'' (ψX (0))⋅ {ψX' (0)} + ϕN' (ψX (0))⋅ ψX'' (0) − {E ( S )}

2

2

2

= ϕN'' (1)⋅ {E ( X )} + ϕN' (1)⋅ ψX'' (0) − {E ( S )}

2

2

= E ( N ( N −1))⋅ {E ( X )} + E ( N ) ⋅ E ( X 2 ) − {E ( N ) E ( X )}

2

= ⎡⎢ E ( N 2 ) − {E ( N )}

⎣

2

2

⎤ ⋅ {E ( X )}2 + E ( N ) ⋅ ⎡ E ( X 2 ) − {E ( X )}2 ⎤

⎥⎦

⎢⎣

⎥⎦

= Var ( N ) ⋅ {E ( X )} + E ( N ) ⋅Var ( X ),

2

wie behauptet.

Ohne die (einschränkenden) Voraussetzungen an die Existenz der erzeugenden Funktionen lässt

sich mit anderen Mitteln noch zeigen, dass diese letzte Beziehung auch dann gültig bleibt, wenn

lediglich die Existenz der Varianzen (also der ersten beiden Momente) von N und X gesichert ist.

Für die Gesamtschadenverteilung aus Lemma 10 ergibt sich so etwa

E (S ) = E ( N ) ⋅ E ( X ) =

1− p

,

λp

Var ( S ) = E ( N ) ⋅Var ( X ) + Var ( N ) ⋅ {E ( X )} =

2

1− p 2

.

λ 2 p2

Mit Hilfe von Satz 2 lässt sich Lemma 10 auch insgesamt alternativ beweisen. Für die momenterzeugende Funktion des Gesamtschadens erhalten wir dort nämlich

ψS (t ) = ϕN (ψX (t )) =

= p+q

p

p

λ −t

λ − qλ − t + qλ

=

=p

=p

λ − qλ − t

λ − qλ − t

1− q ⋅ ψX (t ) 1− q ⋅ λ

λ −t

pλ

= p + q ⋅ ψY (t ), t < λ,

pλ − t

d.h. mit 0 ∈ I = (−∞, λ ) ergibt sich eindeutig die momenterzeugende Funktion einer Mischverteilung aus ε0 (mit Gewicht p) und einer Exponentialverteilung E (λ p ) (mit Gewicht q = 1− p).

Satz 1 erlaubt eine aus numerischer Sicht interessante Anwendung auf die Berechnung der Gesamtschadenverteilung, wenn man die (als stetig verteilt angenommenen) Einzelschadenhöhen geeignet

diskretisiert, z.B. durch Aufrundung auf Vielfache von 1000 € o.ä. Bezeichnet man diese "Schrittweite" mit ∆ > 0, so wird aus der zugrundeliegenden Zufallsvariablen X für die Einzelschadenhöhen die diskretisierte Zufallsvariable

61

X ∆ := min {k ∈

| k ∆ ≥ X }.

Der hieraus entstehende "Gesamtschaden" S∆ besitzt nun die wahrscheinlichkeitserzeugende Funktion

ϕS∆ ( s) = ϕN (ϕ X ∆ ( s)) , s ≤ 1.

Durch Entwicklung dieser Funktion in eine Taylorreihe um den Nullpunkt erhält man die Wahrüber die Koeffizienten von s k zurück. Damit

scheinlichkeiten P ( S∆ = k ) für alle k = 0,1, 2,

lässt sich die Gesamtschadenverteilung – zumindest näherungsweise – auch in solchen Fällen numerisch berechnen, in denen ein geschlossener Ausdruck nicht zur Verfügung steht.

Beispiel 13. Wir nehmen an, dass die Schadenzahl N Poisson-verteilt ist mit Parameter λ = 3 und

die diskretisierten Einzelschadenhöhen einer NB (β , p ) -Verteilung mit den Parametern β = 10

und p = 0,3 genügen mit ∆ = 10000. Die zugehörige wahrscheinlichkeitserzeugende Funktion

lautet dann

β

⎛

⎞

⎞⎟

⎜⎜ ⎜⎜⎛⎛⎜

⎟⎞⎟⎟⎟

p

⎟ −1⎟⎟⎟⎟

ϕS∆ ( s ) = ϕN (ϕ X ∆ ( s )) = exp λ (ϕ X ∆ ( s ) −1) = exp ⎜λ ⎜⎜

⎜⎜ ⎜⎜⎜⎝1− (1− p) s ⎠⎟⎟

⎠⎟⎠⎟⎟

⎝ ⎝

(

)

10

⎛ ⎛⎛

⎞

⎜⎜ ⎜⎜⎜ 0,3 ⎞⎟

⎟⎞⎟

⎟⎟ −1⎟⎟⎟⎟⎟⎟ , s ≤ 1

= exp ⎜3⎜⎜

⎜⎜ ⎜⎜⎜⎝1− 0, 7 s ⎠⎟

⎠⎟⎠⎟⎟

⎝ ⎝

2

mit E ( S∆ ) = 70, Var ( S∆ ) = 1866 , was eine zugehörige Standardabweichung von 43,20 ergibt.

3

Der erwartete Gesamtschaden E ( S ) liegt also in der Größenordnung von 700000 €.

Mit Hilfe eine Computer-Algebra-Systems (z.B. MAPLE) erhält man dann folgende Reihenentwicklung bis zum 100. Term:

62

Aufgrund der hohen Standardabweichung werden also relativ viele Terme benötigt, um die Gesamtschadenverteilung einigermaßen realistisch abzubilden. In diesem Beispiel ist es sicher empfehlenswert, Terme bis zur Ordnung 200 oder mehr zu verwenden. Mit demselben MAPLEWorksheet ergibt sich etwa

ϕS∆ ( s) = … + 0, 00028787 s 200 + … + 0, 00000281 s 300 + …

Weitere numerische Verfahren zur Berechnung der Gesamtschadenverteilung werden im nachfolgenden Abschnitt vorgestellt.

Ähnlich wie in der Personenversicherungsmathematik lassen sich auch in der Sachversicherungsmathematik (Netto-)Prämien als Erwartungswert E ( S ) des (Jahres-)Gesamtschadens berechnen.

Die Sätze 1 und 2 zeigen, wie dies konkret in einem kollektiven Modell der Risikotheorie geschehen kann.

Wir wollen zum Ende dieses Abschnitts noch auf eine wichtige Anwendung von Satz 2 in der Naturkatastrophenmodellierung eingehen (vgl. DONG (2001)). Ein beträchtlicher Teil der weltweit

verursachten Sachschäden geht auf Naturgefahren wie Stürme, Überschwemmungen oder Erdbeben

zurück. Dies ist ein Grund dafür, dass sowohl große Rückversicherer als auch unabhängige Consulting-Firmen mit geophysikalischen Modellen versuchen, die möglichen Risiken "in vitro", also auf

dem Computer zu simulieren, um damit die Gefährdungspotenziale konkreter Portfolios der Erstversicherer bestimmen zu können. Datengrundlage bilden zunächst die historischen Ereignisse mit

ihren bekannten Parametern wie Windgeschwindigkeiten und -richtungen, Wasserständen oder

Magnituden bei Erdbeben (sog. Event Set). Durch zufällige Perturbationen dieser Parameter wird

die Datenbasis geeignet vergrößert, so dass sich bis zu 20000 und mehr "Ereignisse" ergeben (sog.

Stochastic Event Set). Die folgende Graphik zeigt das prinzipielle Vorgehen bei solchen geophysikalischen Modellierungen.

63

Die folgende Graphik zeigt eine entsprechende Vorausberechnung der Sturmbahn des Hurricanes

Isabel vor der Ostküste der USA10.

10

Quelle: reinsurance, November 2003, S. 53

64

Als Ergebnis von solchen Portfolio-Analysen stellen die kommerziellen Produkte eine sog. Event

Loss Table (Ereignisschaden-Tabelle) bereit, die etwa folgendermaßen aussieht (exemplarisch sind

hier nur 7 Zeilen der Tabelle wiedergegeben):

Die unter "Scenario" angegebenen Nummern beziehen sich auf diejenigen Ereignisse im Stochastic

Event Set, die Auswirkungen auf das zugrundeliegende Portfolio haben (können). (Die vorige Graphik zeigt, dass z.B. Gebäude in Florida von dem Sturm-Ereignis nicht betroffen sind, während

Gebäude an der Atlantikküste der Staaten Virginia und North Carolina mit hoher Wahrscheinlichkeit betroffen sind.) "Exposed S(um) I(nsured)" bezeichnet hierbei die dem Ereignis mit der betreffenden Szenarien-Nummer ausgesetzte Versicherungssumme (das ist im Sinne der vorigen Bemerkung nicht immer das gesamte Portfolio). Mit "Modelled Loss" wird der erwartete Verlust bezeichnet, mit "Standard Deviation" die zugehörige Standardabweichung. In der Regel werden – je nach

Anbieter unterschiedliche – Verteilungstypen für den Verlust angegeben, z.B. Lognormal- oder

Betaverteilungen, auf die sich diese Parameter beziehen. In den meisten Fällen wird für die Anzahl

der (Sturm-)Ereignisse je Jahr eine Poisson-Verteilung angenommen, manchmal auch eine negative

Binomialverteilung. Mit "Rate" ist der Erwartungswert der Anzahl der Ereignisse im PoissonModell gemeint, was in diesem Fall mit dem Parameter der Verteilung identisch ist.

Wenn n die Anzahl der relevanten Szenarien ( = Anzahl der Zeilen in der Tabelle) bezeichnet und

wir mit N1 , N 2 , , N n die (als voneinander unabhängig angenommenen) Ereignisfrequenzen sowie

mit X ij , 1 ≤ i ≤ n, j ∈ die (ebenfalls als unabhängig angenommenen) positiven Einzelschadenhöhen bezeichnen, wobei alle X i i dieselbe Verteilung Qi besitzen mögen, so erhalten wir folgende

Summenschäden:

Ni

Si := ∑ X ij , i = 1,

, n (Ereignis-Gesamtschaden, Scenario Loss )

j =1

n

n

Ni

S := ∑ Si =∑∑ X ij

i =1

(Jahres-Gesamtschaden, Aggregate Loss ).

i =1 j =1

Aus Sicht der Rückversicherung, die wir später noch ausführlicher besprechen werden, sind beide

Schadensummen von Interesse. Für den Ereignis-Gesamtschaden erhalten wir also gerade für jedes

i ein kollektives Modell, so dass diese Gesamtschadenverteilung mit Lemma 9 oder mit Hilfe von

Satz 2 berechnet werden kann über die erzeugenden Funktionen. Die Jahres-Gesamtschadenverteilung ist demnach die Faltung der Ereignis-Gesamtschadenverteilungen. Für das in der Praxis

meist verwendete Poisson-Modell lässt sich dies aber geschickt vereinfachen, so dass sich auch für

den Jahres-Gesamtschaden ein (äquivalentes) kollektives Modell ergibt. Dieser Ansatz wird in der

Praxis auch tatsächlich verwendet (vgl. DONG (2001), Part I).

65

Zur Vorbereitung benötigen wir noch zwei Hilfsresultate.

Lemma 11. Es seien Z1 , , Z n (nicht notwendig stochastisch unabhängige) Zufallsvariablen mit

Verteilungen Q1 , , Qn . Ferner sei J eine von den Zi stochastisch unabhängige Zufallsvariable mit

Werten in der Menge {1,

, n}. Dann ist auch Z J eine Zufallsvariable, deren Verteilung durch die

folgende Mischung der Verteilungen Q1 ,

, Qn gegeben ist:

n

P Z J = ∑ P( J = i ) Qi .

i =1

Beweis: Zunächst gilt

n

{Z J ∈ B} = ∪ { J = i} ∩ {Zi ∈ B} für jede Borel-Menge B ∈ B.

i =1

Dies zeigt, dass Z J eine Zufallsvariable (d.h. messbar) ist. Für die Verteilung folgt entsprechend:

n

n

⎛n

⎞

P ( Z J ∈ B ) = P ⎜⎜∪ { J = i} ∩ {Z i ∈ B}⎟⎟⎟ = ∑ P ({ J = i} ∩ {Z i ∈ B}) = ∑ P( J = i ) P ( Z i ∈ B )

⎜⎝ i=1

⎠ j=1

i =1

für jede Borel-Menge B ∈ B , woraus die Behauptung folgt.

Bemerkung: Die Aussage von Lemma 11 bleibt auch für eine Folge von Zufallsvariablen richtig;

an.

J nimmt dann entsprechend Werte in

Eine Mischung von Verteilungen Q1 , , Qn kann also offensichtlich dadurch erzeugt werden, dass

zunächst ein Index i zufällig durch die Zufallsvariable J ausgewählt und anschließend die entsprechende Zufallsvariable Zi realisiert wird.

Für die zugehörigen Verteilungsfunktionen F1 ,

f1 ,

, Fn bzw. im Fall der Existenz der Dichten

, f n gilt analog:

n

FZ J ( x) = ∑ P( J = i ) Fi ( x)

i =1

n

f Z J ( x) = ∑ P( J = i ) fi ( x), x ∈ .

i =1

Lemma 12. In der Situation von Lemma 11 gilt: Falls die Zi momenterzeugende Funktionen auf

einem gemeinsamen Intervall I besitzen, existiert dort auch die momenterzeugende Funktion von

Z J , und es gilt

n

ψZ J (t ) = ∑ P( J = i) ψZi (t ), t ∈ I .

i =1

66

Beweis: Es ist aufgrund der Unabhängigkeitsannahme

n

n

ψZ J (t ) = E (et Z J ) = ∑ P( J = i ) E (et Z J | J = i) = ∑ P( J = i ) ψZi (t ), t ∈ I .

i =1

(

)

= E exp{t Zi }

i =1

Wir kommen jetzt zu dem angekündigten Satz.

Satz 3. Es seien N1 , N 2 , , N n stochastisch unabhängige, Poisson-verteilte Zufallsvariablen mit

Parametern λ1 , λ2 , , λn > 0. Ferner seien X ij , 1 ≤ i ≤ n, j ∈ untereinander und auch von den

Ni stochastisch unabhängige, positive Zufallsvariablen (Schäden), so dass alle X i i dieselbe Verteilung Qi besitzen. Dann kann die Verteilung des Gesamtschadens

Ni

n

S := ∑∑ X ij

i =1 j =1

alternativ auch über ein kollektives Modell dargestellt werden, d.h. S und die Summe

N

S := ∑ X k

k =1

besitzen dieselbe Verteilung, wobei N eine Poisson-verteilte Zufallsvariable ist mit Parameter

n

λ = ∑ λi

i =1

und die X i (auch von N ) unabhängige positive Zufallsvariablen sind mit der Verteilung Q, die

eine Mischung der Qi darstellt mit

n

Q=∑

i =1

λi

Qi .

λ

67

Beweis: Wir verwenden hier erzeugende Funktionen; die Aussage ist aber auch allgemeiner gültig.

Es ist nach Satz 2 und Lemma 12

{

}

ψSi (t ) = ϕNi (ψX i i (t )) = exp λi (ψX i i (t ) −1) und

n

⎧

⎧

⎫

⎤⎫

⎪ ⎡ n λ

⎪

⎪ n

⎪

ψS (t ) = ∏ ψSi (t ) = exp ⎪

⎨∑ λi (ψX i i (t ) −1)⎪⎬ = exp ⎪⎨λ ⎢⎢ ∑ i (ψX i i (t ) −1)⎥⎥ ⎪⎬

⎪

⎪

⎪⎩

i=1

⎪ i=1

⎪

⎩

⎭

⎦ ⎪⎭

⎪ ⎣ i=1 λ

⎪

n

⎧ ⎡ λ

⎫

⎤⎪

⎪

= exp ⎨⎪λ ⎢ ∑ i ψX i i (t ) −1⎥⎬⎪ = exp {λ (ψX (t ) −1)} = ϕN (ψX (t ))

⎥⎦⎪

⎪

⎪ ⎢⎣ i=1 λ

⎪

⎩

⎭

λi

als Wahrscheinlichkeiten

λ

P( J = i ) für eine diskrete Zufallsvariable J wie in Lemmata 11 und 12 gefordert aufgefasst werden können.

für t ∈ I geeignet. Hierzu ist nur zu beachten, dass die Zahlen

Neben dem jeweiligen Ereignis-Gesamtschaden ist manchmal auch der Ereignis-Maximalschaden

M i := max { X ij |1 ≤ j ≤ Ni } von Interesse (bei DONG (2001) irreführender Weise mit Occurence

Loss bezeichnet). Auch seine Verteilung kann in einem Poisson-Modell recht einfach berechnet

werden.

Lemma 13. Im kollektiven Modell der Risikotheorie sei mit

M := max { X i |1 ≤ i ≤ N }

der Maximalschaden bezeichnet. Dann gilt:

⎧⎪ ∞

⎪⎪∑ p F n ( z ), falls z ≥ 0

P ( M ≤ z ) = FM ( z ) = ⎨ n=0 n

⎪⎪

falls z < 0.

⎪⎪⎩0,

Beweis: Es ist ähnlich dem Beweis von Lemma 9 (vgl. Lemma 7)

∞

⎛∞

⎞

⎛n

⎞

P ( M ≤ z ) = FM ( z ) = P ⎜⎜ ∪ { N = n} ∩ {max { X k |1 ≤ k ≤ n} ≤ z}⎟⎟⎟ = p0 + ∑ pn P ⎜⎜∩ { X k ≤ z }⎟⎟⎟

⎝⎜n=0

⎠

⎝⎜ k =1

⎠

n=1

∞

∞

n=1

n=0

= p0 + ∑ pn F n ( z ) = ∑ pn F n ( z ), z ∈ .

Der Unterschied zwischen der Verteilung des Gesamt- und des Maximalschadens ist also lediglich

der, dass im ersten Fall Faltungspotenzen, im zweiten Fall gewöhnliche Potenzen der Verteilungsfunktionen auftreten.

68

Bemerkung: Für das Poisson-Modell, d.h. P N = P (λ ) mit λ > 0 bedeutet dies gerade:

∞

∞

λn n

F ( z ) = e−λ exp {λ F ( z )} = e−λ{1−F ( z )} = eλ{F ( z )−1}

n=0 n !

P ( M ≤ z ) = FM ( z ) = ∑ pn F n ( z ) = e−λ ∑

n=0

für z ≥ 0, das an die entsprechende Formel für die momenterzeugende Funktion des Gesamtschadens erinnert.

Für die Event Loss Table bedeutet dies, dass der maximale Ereignisschaden M i die folgende Verteilungsfunktion besitzt:

−λi {1− Fi ( z )}

P ( M i ≤ z ) = FM i ( z ) = e

, z ≥ 0.

Hiermit lässt sich analog zu Lemma 7 sofort auch die Verteilungsfunktion des JahresMaximalschadens M = max {M i |1 ≤ i ≤ n} (wegen der angenommenen Unabhängigkeit aller Einzelschäden) angeben:

n

n

⎛n

⎞

⎧⎪ n

⎫⎪

−λ 1−F ( z )

P ( M ≤ z ) = P ⎜⎜∩ {M i ≤ z }⎟⎟⎟ = ∏ P ( M i ≤ z ) = ∏ e i { i } = exp ⎨⎪−∑ ⎣⎡λi {1− Fi ( z )}⎦⎤⎬⎪

⎜⎝ i=1

⎪⎩⎪ i=1

⎪⎭⎪

⎠ i=1

i =1

{

}

= exp −λ ⎡⎢⎣1− F ( z )⎤⎥⎦ , z ≥ 0,

wobei

n

F ( z) = ∑

i =1

λi

Fi ( z ), z ∈

λ

die Verteilungsfunktion zur Mischverteilung Q bezeichnet.

Wenn man davon ausgeht, dass ein Schaden nicht wesentlich höher ausfallen kann als die Versicherungssumme des versicherten Objekts, dann besitzen die Verteilungen Qi bzw. die Verteilungsfunktionen Fi explizit bekannte endliche rechte Endpunkte (vgl. Abschnitt I. 2)

ϖi = sup {t ∈

Fi (t ) < 1} , i = 1,

, n.

Für die nachfolgenden Überlegungen wollen wir jetzt o.B.d.A. annehmen, dass diese strikt der Größe nach geordnet sind, d.h. dass gilt

ϖ1 < ϖ2 < < ϖn .

Es ist dann Fi (ϖk ) = 1 für 1 ≤ i ≤ k , so dass hieraus

n

P ( X ≤ ϖk ) = F (ϖk ) = ∑

i =1

k

n

k

λi

λ

λ

λ

Fi (ϖk ) = ∑ i + ∑ i Fi (ϖk ) ≥ ∑ i , k = 1,

λ

i =1 λ

i = k +1 λ

i =1 λ

folgt. Für die Verteilung des Jahres-Maximalschadens M bedeutet dies:

69

,n

⎪⎧ n

⎪⎫

P ( M > ϖk ) = 1− exp −λ ⎡⎢⎣1− F (ϖk )⎤⎥⎦ ≥ 1− exp ⎪⎨− ∑ λi ⎪⎬ , k = 1,

⎪⎩⎪ i=k +1 ⎪⎭⎪

{

}

, n.

Nimmt man zur Vereinfachung und in einer ersten Näherung an die „Wirklichkeit“ an, dass die

Einzelschäden einer Einpunktverteilung in ϖi genügen, so gilt sogar noch Fi (ϖk ) = 0 für i > k ,

so dass dann

k

λ

P ( X ≤ ϖk ) = F (ϖk ) = ∑ i , k = 1, , n

i =1 λ

folgt mit

⎪⎧ n

⎪⎫

P ( M > ϖk ) = 1− exp −λ ⎢⎣⎡1− F (ϖk )⎥⎦⎤ = 1− exp ⎨⎪− ∑ λi ⎬⎪ , k = 1,

⎪⎩⎪ i=k +1 ⎪⎭⎪

{

}

, n.

Die sich so ergebende Funktion wird in der geophysikalischen Modellierungswelt auch als OEP

curve (Occurence Loss Exceeding Probability) bezeichnet, obwohl dies nach den Bemerkungen vor

Lemma 13 missverständlich ist (vgl. DONG (2001), S. 15). Die dahinter stehende Abschätzung der

möglichen Schäden durch deterministische Einzelschäden wird in der dortigen Literatur auch als

ignorance of secondary uncertainties bezeichnet.

Der Vorteil dieser Form der OEP curve besteht in ihrer Einfachheit, allerdings müssen dazu vorher

in der Event Loss Table die entsprechenden ϖi der Größe nach geordnet werden.

Für den Jahres-Gesamtschaden S liefern Lemma 9 und Satz 3 für das geophysikalische PoissonModell entsprechend

n

P ( S ≤ z ) = FS ( z ) = e−λ + e−λ ∑

k =1

λ k k∗

F ( z ), z ≥ 0.

k!

Die sich hieraus ergebende Abbildung P( S > ϖk ) = 1− FS (ϖk ) für k = 1, , n heißt analog AEP

curve (Aggregate Loss Exceeding Probability) (vgl. DONG (2001), S. 16). Bei geeigneter Diskretisierung im Sinne von Beispiel 13 kann eine Berechnung der zugehörigen Wahrscheinlichkeiten wieder über die wahrscheinlichkeitserzeugende Funktion ϕS (etwa mit der dort beschriebenen Reihenentwicklung) erfolgen. Aufgrund der in der Praxis recht umfangreichen Event Loss Tables sind aber

die im nachfolgenden Abschnitt besprochenen numerischen Verfahren in der Regel effizienter. Alternativ ist eine statistische Bestimmung der AEP curve mittels Monte-Carlo-Simulation möglich,

indem eine große Zahl von zufälligen Beobachtungen aus dem Modell gezogen und die zugehörige

empirische Verteilung bestimmt wird. Allerdings sind hier je nach Parameter-Situation bis zu einigen 100000 Stichproben notwendig.

Die obigen Formeln zeigen, dass der Einbezug von secondary uncertainties, also der Berücksichtigung von tatsächlich zufälligen Einzelschäden, ausgedrückt durch die X i i bzw. durch X , nichts

Wesentliches an der Darstellung ändert. Wir fassen diese allgemeineren Darstellungen hier noch

einmal abschließend zusammen (vgl. DONG (2001), S. 46ff):

70

{

}

P ( M > z ) = 1− exp −λ ⎡⎢⎣1− F ( z )⎥⎦⎤ , z ≥ 0 :

OEP curve (Occurence Loss Exceeding Probability)

n

⎧

⎪

⎪

λk k∗ ⎫

P ( S > z ) = 1− e−λ ⎪⎨1 + ∑

F ( z )⎪⎬ , z ≥ 0 : AEP curve (Aggregate Loss Exceeding Probability).

⎪

⎪

k =1 k !

⎪

⎪

⎩

⎭

Hierbei ist wie oben

n

n

i =1

i =1

λ = ∑ λi und F ( z ) = ∑

λi

Fi ( z ), z ∈ .

λ

Tabellen mit den notwendigen erweiterten Angaben (wie Erwartungswerte und StandardAbweichungen für die Einzelschäden) heißen entsprechend Extended Event Loss Tables.

II. 2. Die Panjer-Rekursion

In den beiden folgenden Abschnitten wollen wir weiterhin das kollektive Modell unterstellen und

dabei annehmen, dass die Einzelschadenhöhenverteilung wieder mit einer "Schrittweite" ∆ > 0

diskretisiert ist. Für umfangreichere Probleme – etwa wie im Fall der geophysikalischen Modellierung im vorigen Abschnitt – ist dann aber die Reihenentwicklung der wahrscheinlichkeitserzeugenden Funktion ϕS∆ ( s ) = ϕN (ϕ X ∆ ( s )) , s ≤ 1 um den Nullpunkt nicht effizient. Gehört die Verteilung von N jedoch zur Familie der Poisson-, Binomial- oder negativen Binomialverteilungen, so

lässt sich die zu S∆ gehörige Verteilung auf elegante und effiziente Weise rekursiv berechnen. Wir

verwenden für diesen Fall die folgende Darstellung der wahrscheinlichkeitserzeugenden Funktion:

B

⎧⎪

A

⎪⎛

⎞

1

A

−

⎪⎪⎜

⎟

⎟

ϕN ( s ) = ⎨⎜⎜⎝1− As ⎠⎟

⎪⎪

⎪⎪e B ( s−1)

⎩

für A, B ≠ 0

für A = 0, B ≠ 0

mit geeigneten reellen Zahlen A, B ∈ . Durch Vergleich mit der Tabelle auf S. 59 ergibt sich:

ϕ N ( s ) = eλ ( s−1)

ϕN ( s ) = ((1− p) + ps )

n

für A = 0, B = λ > 0

A

für A < 0, p :=

, B := −nA

A −1

β

⎛

⎞⎟

p

⎟

ϕN ( s ) = ⎜⎜

⎜⎝1− (1− p) s ⎠⎟⎟

für 0 < A < 1, p := 1− A, B := β A = β (1− p)

für s ≤ 1. Damit bilden die wahrscheinlichkeitserzeugenden Funktionen der Poisson-, Binomialund negativen Binomialverteilungen Spezialfälle dieser Klasse, die wir Panjer-Klasse nennen wollen.

Durch Differenzieren dieser Funktionen und Zusammenfassen der Terme erhält man sofort

71

d

B

ϕN ( s) =

ϕN ( s ), s < 1.

1− As

ds

Mit Hilfe dieses Ergebnisses lässt sich jetzt folgendes fundamentale Resultat formulieren.

Satz 4 (Panjer-Rekursion). Gehört die wahrscheinlichkeitserzeugende Funktion ϕN der Schadenzahl zur Panjer-Klasse und bezeichnet man mit

f k := P ( X ∆ = k ) , g k := P ( S∆ = k ) , k = 0,1, 2,

,

die Elementarwahrscheinlichkeiten der (diskretisierten) positiven Einzelschadenhöhen bzw. des

(diskretisierten) Gesamtschadens, so gilt:

g 0 = ϕ N ( 0)

g k +1 =

1 k

∑ g k− j f j+1 [ A(k − j ) + B( j +1)], k = 0,1, 2,

k + 1 j =0

.

Beweis: Es ist für s < 1

{

}

d

d

B

ϕ S∆ ( s ) =

ϕN (ϕ X ∆ ( s )) = ϕ N' (ϕ X ∆ ( s ))⋅ ϕ X' ∆ ( s ) =

ϕ N (ϕ X ∆ ( s ))⋅ ϕ X' ∆ ( s )

1− A ϕ X ∆ ( s )

ds

ds

=

B

ϕN (ϕ X ∆ ( s ))⋅ ϕ X' ∆ ( s ), also

1− A ϕ X ∆ ( s )

ϕS' ∆ ( s) (1− A ϕ X ∆ ( s )) = B ⋅ ϕS∆ ( s) ⋅ ϕ X' ∆ ( s)

bzw. ϕS' ∆ ( s ) = A⋅ ϕS' ∆ ( s ) ⋅ ϕ X ∆ ( s) + B ⋅ ϕS∆ ( s) ⋅ ϕ X' ∆ ( s).

Aus der Reihendarstellung der wahrscheinlichkeitserzeugenden Funktionen folgt also:

⎛∞

⎞

ϕS' ∆ ( s ) = ⎜⎜∑ (k +1) g k +1 s k ⎟⎟⎟

⎝⎜ k =0

⎠

sowie

∞ ⎛ k

⎛∞

⎞⎛∞

⎞

B ⋅ ϕS∆ ( s ) ⋅ ϕ X' ∆ ( s ) = B ⋅ ⎜⎜∑ g k s k ⎟⎟⎟⋅ ⎜⎜∑ (k + 1) f k +1 s k ⎟⎟ = B ⋅ ∑ ⎜⎜⎜∑ ( j + 1) f j +1 g k − j

⎜⎝ k =0

⎜ j =0

⎠ ⎝⎜ k =0

⎠⎟

k =0 ⎝

⎞⎟ k

⎟⎟ s

⎠⎟

und wegen f 0 = 0 nach Voraussetzung:

∞ ⎛ k

⎛∞

⎞⎛∞

⎞

A⋅ ϕS' ∆ ( s ) ⋅ ϕ X ∆ ( s ) = A ⋅ ⎜⎜∑ (k + 1) g k +1 s k ⎟⎟⎟⋅ ⎜⎜∑ f k s k ⎟⎟⎟ = A ⋅ ∑ ⎜⎜⎜∑ (k + 1− j ) f j g k +1− j

⎝⎜ k =0

⎠ ⎝⎜ k =0

⎠

⎝ j=1

k =0 ⎜

∞ ⎛ k −1

= A ⋅ ∑ ⎜⎜⎜∑ (k − j ) f j +1 g k − j

⎝ j =0

k =0 ⎜

Hieraus folgt

72

⎞⎟ k

⎟⎟ s .

⎠⎟

⎞⎟ k

⎟⎟ s

⎠⎟

⎛∞

⎞

k

'

'

'

⎜⎜⎜∑ (k + 1) g k +1 s ⎟⎟⎟ = ϕS∆ ( s ) = A⋅ ϕS∆ ( s ) ⋅ ϕ X ∆ ( s ) + B ⋅ ϕS∆ ( s ) ⋅ ϕ X ∆ ( s )

⎝ k =0

⎠

∞ ⎛ k −1

= A ⋅ ∑ ⎜⎜⎜∑ (k − j ) f j +1 g k − j

⎜ j =0

k =0 ⎝

∞ ⎛ k −1

= ∑ ⎜⎜⎜ A∑ (k − j ) f j +1 g k − j

⎝ j =0

k =0 ⎜

∞ ⎛ k

⎞⎟ k

⎞

⎟⎟ s + B ⋅ ∑ ⎜⎜∑ ( j + 1) f j +1 g k − j ⎟⎟⎟ s k

⎜⎜

⎠⎟

⎠⎟

k =0 ⎝

j =0

k

⎞

+ B ∑ ( j + 1) f j +1 g k − j ⎟⎟⎟ s k , s < 1.

⎟⎠

j =0

Da beide Reihen im Bereich s < 1 übereinstimmen, müssen ihre Koeffizienten identisch sein:

k −1

k

k

j =0

j =0

j =0

(k + 1) g k +1 = A∑ (k − j ) f j +1 g k − j + B∑ ( j + 1) f j +1 g k − j = ∑ g k − j f j +1 [ A(k − j ) + B( j +1)]

für k = 0,1, 2,

. Hieraus folgt die Rekursionsformel und wegen

g 0 = P ( S∆ = 0) = P ( N = 0) = ϕN (0)

insgesamt die Behauptung.

Bemerkung.

a) Für einige Anwendungen etwa im Zusammenhang mit Rückversicherung ist es vorteilhaft, die

die "Schäden" beschreibenden Zufallsvariablen bzw. die Zufallsvariable X ∆ als lediglich nichtnegativ anzunehmen, d.h. den Wert Null zu zulassen. In diesem Fall ergibt sich nach analoger

Rechnung folgende modifizierte Panjer-Rekursion:

g 0 = ϕN ( f 0 )

k

1

g k +1 =

∑ gk− j f j+1 [ A(k − j ) + B( j +1)], k = 0,1, 2,

(k + 1) (1− Af 0 ) j=0

.

b) Besitzt die Verteilung der Zufallsvariablen X ∆ einen rechten Endpunkt ϖ∆ ∈ , so ist die Anzahl der Summanden in der Rekursion nach oben beschränkt, und es gilt wegen f j = 0 für

j > ϖ∆ :

g0 = ϕN ( f 0 )

1

g k +1 =

(k + 1) (1− Af 0 )

min {k , ϖ∆ −1}

∑

g k − j f j +1 [ A(k − j ) + B( j + 1)], k = 0,1, 2,

j =0

entsprechend in der obigen Rekursion in Satz 4.

73

,

Die Panjer-Rekursion kann leicht in beliebigen Sprachen programmiert werden. Wir geben hier

beispielhaft ein MAPLE-Worksheet wieder, das als universelle Vorlage für solche Rechnungen

dienen kann.

Beispiel 14. Die Schadenzahl sei negativ-binomialverteilt nach NB (β , p ) mit β = 2 und

p = 0, 25. Die Verteilung der (diskretisierten) Einzelschadenhöhen sei gegeben durch

k

0

1

2

3

4

5

6

fk

0

0,1

0,15

0,2

0,25

0,2

0,1

Mit MAPLE kann man die zugehörige Panjer-Rekursion z.B. wie folgt programmieren (mit den

Parametern A = 1− p = 0, 75, B = β A = 1,5, Berechnung der ersten 16 Terme):

74

Man beachte, dass das Feldelement für die Wahrscheinlichkeiten f k für k = 0 nicht definiert werden muss, da Listenindizes in MAPLE standardmäßig bei 1 beginnen. (Die Funktion nops( f ) zählt

die Länge der Liste, also hier 6, das ist zugleich ϖ∆ ).

II. 3. Die diskrete Fourier-Transformation

Die Panjer-Rekursion ist aufgrund ihrer einschränkenden Voraussetzungen an die Form der Verteilung für die Schadenzahl N nicht in allen relevanten Fällen verwendbar. Das in diesem Abschnitt

vorgestellte Verfahren vermeidet diese Schwierigkeiten. Dazu wollen wir zunächst einige theoretische Grundlagen erarbeiten.

Die zentrale Idee der diskreten Fourier-Transformation besteht wie im vorigen Abschnitt in einer

effizienten Auswertung der Funktion ϕS∆ ( s ) = ϕN (ϕ X ∆ ( s )). Allerdings betrachten wir jetzt nicht

reelle Argumente s, sondern komplexe Argumente in der Form s = e−it mit t ∈ . Dabei bezeichnet

i wie in der Analysis üblich die imaginäre Einheit i = −1. Formal erhält man die Verteilung von

S∆ dann über die "Inversion" der Fourier-Transformierten über das Integral

2π

1

ϕS (e−it ) eikt dt = P ( S∆ = k ) , k = 0,1, 2,

2π ∫0 ∆

.

Die Fourier-Transformation lässt sich allgemein für Folgen f reeller Zahlen definieren. Dabei wol∞

len wir die Notation f = { f (k )}k =0 verwenden. Die Menge aller solcher Folgen soll mit F bezeichnet werden.

Definition 4. Es bezeichne

∞

f := ∑ f (k ) für f ∈ F

k =0

und

1

Für f ∈

f,g ∈

1

1

heißt

f

={ f ∈F

f < ∞} .

auch die ( 1 -)Norm von f. Ferner ist die Faltung f ∗ g zweier Folgen

definiert durch

k

k

j =0

j =0

( f ∗ g )(k ) := ∑ f ( j ) g (k − j ) =∑ f (k − j ) g ( j ), k = 0,1, 2,

.

Die Menge 1 bildet im Sinne der Funktionalanalysis einen Banachraum, d.h. einen

vollständigen11, normierten Vektorraum (hier: von Folgen reeller Zahlen als Elemente). Dabei ist

die Vektorraumstruktur gegeben durch die Verknüpfungen

11

Vollständigkeit bedeutet, dass jede Cauchy-Folge

{ f n } von Elementen des Raumes in der Norm konvergiert.

75

( f + g )(k ) := f (k ) + g (k )

(α f )(k ) := α f (k ),

1

Lemma 14. Der Raum

f , g ∈ 1, α ∈ .

ist abgeschlossen gegenüber der Faltungsbildung, d.h. es gilt

f ∗g∈

1

für alle f , g ∈

1

mit

f ∗ g ≤ f ⋅ g , f , g ∈ 1.

Beweis: Es ist für k = 0,1, 2,

( f ∗ g )(k ) :=

k

∑

j =0

k

f ( j ) g (k − j ) ≤ ∑ f ( j ) ⋅ g (k − j )

j =0

und somit

∞

∞

k

∑ ( f ∗ g )(k ) ≤ ∑∑

k =0

k = 0 j =0

∞

= ∑ f ( j)

j =0

∞

∞

f ( j ) ⋅ g (k − j ) = ∑∑ f ( j ) ⋅ g (k − j ) = ∑∑ f ( j ) ⋅ g (k − j )

0≤ j ≤k

∞

∞

k= j

j =0

∑ g (k − j ) = ∑

j =0 k = j

f ( j) ⋅ g = g

∞

∑

f ( j) = f ⋅ g

j =0

für alle f , g ∈ 1.

Definition 5 (diskrete Fourier-Transformation). Die durch

∞

fˆ (t ) := ∑ f (k ) e−ikt , t ∈ ; f ∈

1

k =0

definierte Funktion auf

heißt (diskrete) Fourier-Transformierte der Folge f ∈ 1.

Lemma 15. Für die Fourier-Transformierte fˆ einer Folge f ∈

1

gilt folgende Abschätzung:

fˆ (t ) ≤ f , t ∈ .

Beweis: Es gilt

∞

fˆ (t ) ≤ ∑ f (k ) ⋅ e−ikt = f , t ∈ .

k =0

=1

76

Bemerkung: Ist Z eine Zufallsvariable mit Werten in

+

= {0,1, 2, } und bezeichnet man mit f Z

die Folge der zugehörigen Elementarwahrscheinlichkeiten, d.h. es ist f Z (k ) = P ( Z = k ), k ∈

gilt gerade

+

, so

∞

fˆZ (t ) = ∑ e−ikt P( Z = k ) = E (e−itZ ) = ψZ (−it ) = ϕZ (e−it ), t ∈ .

k =0

Entsprechend gilt: bezeichnet man mit

∞

∞

f := { P ( X ∆ = k )}k =0 , g := { P ( S∆ = k )}k =0

die Folgen der Elementarwahrscheinlichkeiten für die (diskretisierten) Einzelschadenhöhen bzw.

den (diskretisierten) Gesamtschaden, so ist

(

)

gˆ (t ) = ϕN fˆ (t ) , t ∈ .

Dies folgt völlig analog wie im Beweis zu Satz 2.

Satz 5 (Fourier-Inversionstheorem I). Die Fourier-Transformierte fˆ einer Folge f ∈

1

ist integ-

rierbar über dem Intervall [0, 2π ], und es gilt folgende Umkehrformel:

2π

1

fˆ (t ) eikt dt = f (k ) für alle k = 0,1, 2,

∫

2π 0

.

Beweis: Die Integrierbarkeit folgt aus Lemma 15. Zur Vereinfachung des Beweisgangs nehmen wir

zunächst an, dass die Folge f endlich ist, d.h. es existiert ein M ∈ mit der Eigenschaft

f (k ) = 0 für k > M .

Dann gilt

2π

∫

0

2π

2π

2π M

M

⎧∞

⎫

⎧

⎫

⎪

⎪

⎪

−ijt ⎪ ikt

−ijt ⎪ ikt

⎪

⎪

ˆf (t ) eikt dt = ⎪

f ( j ) e ⎬ e dt = ∫ ⎨∑ f ( j ) e ⎬ e dt = ∫ ∑ f ( j ) ei ( k − j ) t dt

∫ ⎨⎪⎪∑

⎪

⎪ j =0

⎪

⎪

⎪

0 ⎩ j =0

0 ⎪

0 j =0

⎭

⎩

⎭

M

2π

j =0

0

= ∑ f ( j ) ∫ ei ( k − j )t dt = 2π f (k ), k ∈

+

wegen

2π

∫

0

2π

2π

⎪⎧2π, falls j = k

ei ( k − j ) t dt = ∫ cos ((k − j )t ) dt + i ∫ sin (( k − j )t ) dt = ⎨⎪

⎪⎪⎩0,

falls j ≠ k

0

0

77

(man beachte, dass sich deshalb für k > M in dem vorletzten Ausdruck der oberen Gleichung immer der Wert Null ergibt). Die Vertauschung von Integral und Summe ist dabei aufgrund der Integrierbarkeit von f und der Endlichkeit der Summe gerechtfertigt.

Sei nun f eine beliebige Folge aus 1. Wir definieren für jedes M ∈ die Folge f M durch

⎪⎧ f (k ), k ≤ M

f M (k ) := ⎪⎨

⎪⎪⎩0,

k > M.

Dann sind auch f M und g M := f − f M Elemente von

M

f M = ∑ f (k ) ≤ f

1

wegen

und g M = f − f M =

k =0

Wegen f ∈

1

∞

∑

f (k ) =: cM ≤ f .

k = M +1

strebt die Folge {cM }M ∈ für M → ∞ gegen Null, und es ist

2π

∫ gˆ

2π

2π

(t ) e dt ≤ ∫ gˆ M (t ) e dt ≤ ∫ gˆ M (t ) dt ≤ 2π g M = 2πcM .

ikt

M

ikt

0

0

0

Es folgt

2π

∫

2π

2π

2π

fˆ (t ) eikt dt = ∫ fˆM (t ) eikt dt + ∫ gˆ M (t ) eikt dt = 2π f M (k ) + ∫ gˆ M (t ) eikt dt

0

0

0

0

mit

2π

∫ gˆ

M

(t ) eikt dt ≤ 2πcM → 0 für M → ∞.

0

Hieraus folgt die Behauptung wegen f M → f für M → ∞.

Satz 6 (Fourier-Inversionstheorem II). Es sei f ∈

M ∈ mit der Eigenschaft

1

eine endliche Folge, d.h. es existiert ein

f (k ) = 0 für k ≥ M .

Dann gilt exakt:

2π

1

1

fˆ (t ) eikt dt =

∫

M

2π 0

M −1

⎛ 2π j ⎞⎟ 2 πijk / M

für alle k = 0,1, 2,

⎟e

⎠⎟

∑ fˆ ⎜⎜⎜⎝ M

j =0

Beweis: Es ist für k = 0,1, 2,

78

.

M −1

∑

j =0

M −1

M −1 ⎛

⎞

⎞

⎛ 2π j ⎞⎟ 2 πijk / M M −1 ⎛⎜ M −1

−2 πimj / M ⎟ 2 πijk / M

⎜⎜exp ⎧⎨⎪ 2πi (k − m) ⎫⎬⎪⎟⎟

=

=

fˆ ⎜⎜

e

f

(

m

)

e

e

f

(

m

)

⎟

⎟

⎜

∑

∑

∑

∑

⎟

⎟

⎜

⎜

⎪⎩⎪

⎪⎭⎪⎠⎟

⎝⎜ M ⎠

M

⎠

j = 0 ⎝ m= 0

m= 0

j =0 ⎝

j

⎛

⎞

⎜⎜exp ⎪⎧⎨ 2πi (k − m) ⎪⎫⎬⎟⎟ −1

⎪⎩⎪

⎪⎭⎪⎠⎟

M

⎝⎜

f ( m)

⎛

⎧⎪ 2πi (k − m) ⎫⎪⎞⎟

⎬⎟⎟ −1

⎜⎜⎜exp ⎨

⎪⎩⎪

⎪⎭⎪⎠

M

⎝

M

M −1

= f (k ) ⋅ M + ∑

m= 0

m≠ k

M −1

= f ( k ) ⋅ M + ∑ f ( m)

m= 0

m≠ k

exp {2πi (k − m)} −1

= f (k ) ⋅ M ,

⎛

⎞

⎜⎜exp ⎪⎧⎨ 2πi (k − m) ⎪⎫⎬⎟⎟ −1

⎪⎩⎪

⎪⎭⎪⎠⎟

M

⎝⎜

woraus mit Satz 5 die Behauptung folgt.

Bemerkung: Die einschränkende Annahme in Satz 6 ist wesentlich, da für unendliche Folgen f

i. Allg. nur gilt:

2π

1

1

1

fˆ (t ) eikt dt = ∫ fˆ (2π s ) e 2 πiks ds ≈

∫

M

2π 0

0

M −1

⎛ 2π j ⎞⎟ 2 πijk / M

für alle k = 0,1, 2,

⎟e

⎠⎟

∑ fˆ ⎜⎜⎝⎜ M

j =0

. 12

Diese Approximationsformel entspricht gerade der Rechteckregel der numerischen Integration.

Eine Fehlerabschätzung ist möglich über die Zerlegung f = f M −1 + g M −1 mit den im Beweis von

Satz 5 definierten Hilfsfunktionen. Es ergibt sich dann:

1

2π

∫

2π

0

1

fˆ (t ) eikt dt −

M

M −1

∑

j =0

≤

1

2π

⎛ 2π j ⎞⎟ 2 πijk / M

1

1

=

fˆ ⎜⎜

fˆM −1 (t ) + gˆ M −1 (t )) eikt dt −

(

∫

⎜⎝ M ⎠⎟⎟ e

2π 0

M

2π

∫ gˆ

2π

M −1

(t ) eikt dt ≤

0

≤

1

2π

∫

2π

1

2π

∫

2π

gˆ M −1 (t ) eikt dt ≤

0

1

2π

M −1

∑ fˆ

M −1

j =0

⎛ 2π j ⎞⎟ 2 πijk / M

⎜

⎟e

⎝⎜⎜ M ⎠⎟

2π

∫

gˆ M −1 (t ) dt

0

∞

g M −1 dt = ∑ f ( k ) .

k =M

0

Eine wesentliche Konsequenz der Sätze 5 und 6 besteht darin, dass unter den Voraussetzungen von

Satz 6 die Hin- und Rücktransformation mit Hilfe von Vektoren und Matrizen beschrieben werden

kann. Es gilt nämlich:

⎧ 2πi ⎪

⎫

⎧ 2πi ⎫

1

⎪

⎪

⎪

Lemma 16. Es bezeichne vrs := exp ⎨−

rs⎬ , wrs =

= exp ⎨

rs⎬ für 0 ≤ r , s ≤ M −1 und

⎪

⎪

vrs

⎪ M ⎪

⎪

⎪M ⎪

⎪

⎩

⎭

⎩

⎭

M ×M

M ∈ sowie V := [vrs ] ∈

. Ferner bezeichne

f M −1 := [ f (0), f (1),

, f ( M −1) ] ∈

tr

M

⎡

, fˆM −1 := ⎢ fˆ (0),

⎢⎣

12

⎛ 2π ⎞

fˆ ⎜⎜ ⎟⎟⎟ ,

⎜⎝ M ⎠

⎛ 4π ⎞

fˆ ⎜⎜ ⎟⎟⎟ ,

⎝⎜ M ⎠

⎛ 2π ( M −1) ⎞⎟⎤

, fˆ ⎜⎜

⎟⎥ ∈

⎝⎜

⎠⎟⎥⎦

M

tr

M

.

Der hierbei entstehende Fehler wird in der Informationstechnik auch als Aliasing bezeichnet; er tritt u.a. auf bei der

Konvertierung von analogen zu digitalen Bild- und Tonsignalen und umgekehrt.

79

Dann gilt: V −1 =W :=

1

[ wrs ] und unter den Voraussetzungen von Satz 6:

M

fˆM −1 = V ⋅ f M −1 sowie f M −1 = W ⋅ fˆM −1.

Beweis: Es ist für 0 ≤ r , t ≤ M −1

⎪⎧⎪ exp {2πi (t − r )} −1

= 0, r ≠ t

M −1

M −1

⎧⎪ 2πi

⎫⎪

⎧

⎫⎪ ⎪⎪⎪

⎪ 2πi

(t − r )⎬ −1

vrs wst = ∑ exp ⎨

s (t − r )⎬ = ⎨ exp ⎨

∑

⎪

⎪⎭⎪ ⎪⎪

⎩⎪⎪ M

⎭⎪⎪

⎪M

s =0

s =0

⎩

⎪⎪

r = t,

⎪⎩M ,

1

[ wrs ]. Die

M

folgt nun unmittelbar aus der Definition der Fourier-

d.h. es gilt V ⋅W = E (Einheitsmatrix). Ebenso folgt W ⋅V = E , d.h. es ist V −1 =W =

vektorielle Darstellung von fˆM −1 und f M −1

Transformierten sowie den Sätzen 5 und 6.

Bemerkung: Es ist möglich, die erforderlichen Rechenschritte für die Matrixmultiplikation aufgrund der besonderen Struktur der Matrizen V und W technisch erheblich zu beschleunigen. Das

dem zugrunde liegende Verfahren heißt die schnelle Fourier-Transformation (Fast Fourier Transform, FFT) und ist z.B. in MAPLE über eigene Befehle implementiert.

Lemma 16 erlaubt nun auf elegante Weise die angekündigte Variante der numerischen Berechnung

der Gesamtschadenverteilung im diskretisierten kollektiven Modell der Risikotheorie. Dazu wollen

wir wieder mit

∞

∞

f := { P ( X ∆ = k )}k =0 , g := { P ( S∆ = k )}k =0

die Folgen der Elementarwahrscheinlichkeiten für die (diskretisierten) Einzelschadenhöhen bzw.

den (diskretisierten) Gesamtschaden bezeichnen. Das Verfahren beinhaltet die folgenden drei

Schritte:

1. Fourier-Transformation: wähle M ∈

geeignet und

berechne fˆM −1 = V ⋅ f M −1 ∈

M

.

2. Transformiere das Ergebnis koordinatenweise mit der wahrscheinlichkeitserzeugenden

Funktion ϕN der Schadenzahl:

(

)

M

(

)

berechne ϕN fˆM −1 ∈

.

3. Rücktransformation:

berechne g M −1 = W ⋅ ϕN fˆM −1 ∈

80

M

.

Der Vektor g M −1 enthält dann näherungsweise die ersten M Komponenten von g. Falls die Verteilung des Gesamtschadens einen endlichen rechten Endpunkt ϖ ≤ M −1 besitzt, ist dieses Ergebnis

sogar exakt, anderenfalls entsteht ein Aliasing-Fehler, der mit der Markoff-Ungleichung durch den

Ausdruck

∞

∞

k =M

k =M

∑ g (k ) = ∑ P ( S

S∆

≥ tM )≤

∆ = k ) = P ( S∆ > M −1) = P (t

ϕS∆ (t )

tM

=

ϕN (ϕ X ∆ (t ))

tM

für jedes t > 0 abgeschätzt werden kann.

Für das bei der Panjer-Rekursion besprochene Beispiel 14 ergibt sich mit MAPLE für die FourierTransformation nach obigem Muster:

Der Aliasing-Fehler beträgt hier maximal 0,07869 (berechnet z.B. durch Summation der ersten 50

Terme der Panjer-Rekursion oder Reihenentwicklung von ϕS∆ ).

81