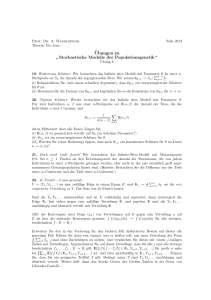

S. FX(x) fX(x) E[X] Var[X] diskret 26 Pr[X ≤ x] Pr[X = x] ∑ xfX(x) E[(X

Werbung

![S. FX(x) fX(x) E[X] Var[X] diskret 26 Pr[X ≤ x] Pr[X = x] ∑ xfX(x) E[(X](http://s1.studylibde.com/store/data/009308841_1-a646025deab6d8ab299a07364077e1f4-768x994.png)

S.

26

diskret

FX (x)

Pr[X ≤ x]

fX (x)

Pr[X = x]

XE[X]

xfX (x)

Var[X]

E[(X − E[X])2 ] = E[X 2 ] − E[X]2

x∈WX

Z

kontinuierlich

91

x

Pr[X ≤ x] = Pr[X < x] =

0

FX

(x)

fX (t)dt

−∞

Bernoulli

Binomial

(p)

(

1 − p für x = 0

1

für x = 1

47

Bin(n, p)

x

X

48

fX (k)

k=0

Geometrisch

Geo(p)

x

X

50

Poisson

54

Po(λ)

(

1−p

p

für x = 0

für x = 1

n x n−x

b(x; n, p) =

p q

x

(a, b)

104

Normal

N (µ, σ 2 )

105

Exp(λ)

Markov (S. 60)

E[X]

Pr[X ≥ t] ≤

t

109

Pr[|X − E[X]| ≥ t] ≤

Var[X]

t2

pq = p(1 − p)

np

npq

1

p

q

p2

fX (k)

e−λ λx

x!

x ∈ N0

λ

λ

a+b

2

(a − b)2

12

µ

σ2

1

λ

1

λ2

für x < a

x−a

für a ≤ x ≤ b

b−a

1

für x > b

Z x

Φ(x; µ, σ) =

ϕ(t)dt

Chebyshev (S. 61)

p

x ∈ N+

−∞

Exponential

E[(X − E[X])2 ] = E[X 2 ] − E[X]2

pq x−1

0

(

1 − e−λx

0

xfX (x)dx

fX (k)

k=0

Gleich

+∞

−∞

k=1

x

X

Z

falls x ≥ 0

sonst

(

1

b−a

für a ≤ x ≤ b

0

sonst

1

(x − µ)2

ϕ(x; µ, σ) = √

· exp −

2σ 2

2πσ

(

λ · e−λx falls x ≥ 0

0

sonst

P

Chernoff (S. 66, 69) für Bin oder Bernoulli

eδ

Pr[X ≥ (1 + δ)µ] ≤

δ > −1

(1 + δ)1+δ

1

Zufallsvariablen

Bestimmte Verteilungen

Unabhängigkeit (23, 40):

Normalverteilung und Normierung (S. 107):

Pr[A ∩ B] = Pr[A] · Pr[B]

Pr[X1 = x1 , X2 = x2 , . . . Xn = xn ] = Pr[X1 = x1 ] · Pr[X2 = x2 ] · · · Pr[Xn = xn ]

X ∼ N (µ, σ 2 ) =⇒ (aX + b) ∼ N (aµ + b, a2 σ 2 )

Bedingte Wahrscheinlichkeit (S. 14):

Pr[A ∩ B]

Pr[A|B] =

Pr[B]

X ∼ N (µ, σ 2 ) =⇒

Pr[A ∩ B] = Pr[B|A] · Pr[A] = Pr[A|B] · Pr[B]

Multiplikationssatz (S. 17):

Pr[a < X ≤ b] = Φ

Pr[A1 ∩ A2 ∩ · · · ∩ An ] = Pr[A1 ] · Pr[A2 |A1 ] · · · Pr[An |A1 ∩ · · · ∩ An−1 ]

Satz der totalen Wahrscheinlichkeit (S. 19):

X −µ

σ

b−µ

σ

∼ N (0, 1)

−Φ

a−µ

σ

Gedächtnislosigkeit (S. 111): genau bei Geo und Exp

Pr[B] = Pr[B|A] · Pr[A] + Pr[B|Ā] · Pr[Ā]

Pr[B] =

n

X

Pr[B|Ai ] · Pr[Ai ]

i=1

B⊆

[

˙ n

i=1

Pr[X > x + y|X > y] = Pr[X > x]

Ai

Faltung (S. 42):

Approximation durch Normalverteilung

Z := X + Y

fZ (z) =

X

fX (x) · fY (z − x)

x∈WX

Zentraler Grenzwertsatz (S. 123, Satz 2.40):

Pn Xi unabhängig, identisch verteilt mit Erwartungswert µ und Varianz σ 2 . Yn := i=1 Xi . Konfidenzintervall!

Linearität des Erwartungswertes (S. 43):

Z := X1 + X2 + · · · + Xn

E[Z] = E[X1 ] + E[X2 ] + · · · + E[Xn ]

Zn :=

Yn − nµ

√

σ n

im Grenzfall n → ∞ : Zn ∼ N (0, 1)

Linearität der Varianz bei unabhängigen Zufallsvariablen (S. 46):

Z := X1 + X2 + · · · + Xn

Für n Bernoulliexperimente bzw. eine einzige Binomialverteilte Hn : Grenzwertsatz von

DeMoivre (S. 125, Satz 2.42):

Var[Z] = Var[X1 ] + Var[X2 ] + · · · + Var[Xn ]

Multiplikativität des Erwartungswertes bei unabhängigen Zufallsvariablen (S. 44):

Z := X1 · X2 · · · Xn

Hn − np

Hn∗ := p

np(1 − p)

E[Z] = E[X1 ] · E[X2 ] · · · E[Xn ]

2

im Grenzfall n → ∞ : Hn∗ ∼ N (0, 1)

Schätzer und Konfidenz

t-Test: Eine Zufallsvariable, σ unbekannt, µ zu testen. (S. 157)

Zwei-Stichproben-t-Test: Zwei Zufallsvariablen, µ zu vergleichen. (S. 159)

U erwartungstreuer Schätzer für ϑ wenn E[U ] = ϑ (S. 137 Definition 3.1)

X 2 -Anpassungstest: Eine endliche, diskrete Zufallsvariable, Verteilung insgesamt zu

P

1

2

MSE: Mean Squared Error n (U −ϑ) , bei erwartungstreuem Schätzer MSE= Var[U ]

testen. (S. 161)

MSE klein ⇔ Schätzer effizient. vlg. Aufg. 7.3.

Markovkette in diskreter Zeit: S. 172 ff.:

Stichprobenmittel und Stichprobenvarianz (erwartungstreue Schätzer):

n

X̄ :=

1X

Xi

n i=1

n

S 2 :=

1 X

(Xi − X̄)2

n − 1 i=1

Likelihood L(~x; ϑ) :=

n

Y

Exponentieren von Matrix P :

Eigenwerte: P − λi · I = 0; Eigenvektoren: P · νi = λi · νi

D: Eigenwerte auf Diagonale; B: Eigenvektoren als Spaltenvektoren

P k = B · Dk · B −1 , einfach Diagonaleinträge potenzieren.

f (xi ; ϑ)

Tij = min{n ≥ 1|Xn = j, wennX0 = i} Übergangszeit von i nach j.

hij erwartete Übergangszeit, fij Ankunftswahrscheinlichkeit.

X

E[Tij ] = hij = 1 +

pik hkj

i=1

ML-Schätzwert ϑ̂ als Parameter, bei dem L(x; ϑ) minimal wird, durch Ableitung.

Konfidenzintervall [U1 , U2 ] zum Konfidenzniveau 1 − α: Pr[U1 ≤ ϑ ≤ U2 ] ≥ 1 − α

k6=j

2

Für n Stichproben von X ∼ N (µσ ) (S. 144, 3.4):

z(1− α ) σ

z(1− α ) σ 2

Pr X̄ − √

≤ µ ≤ X̄ + √ 2

=1−α

n

n

Pr[Tij < ∞] = fij = pij +

X

pik fkj

k6=j

Stationäre Verteilung: π = P π (S. 178, 4.9)

Kochrezept Konfidenzintervall:

(n)

1. Zentraler Grenzwertsatz ergibt standardnormalverteiltes Z

irreduzibel: Irreduzibel: pij > 0, im endlichen Fall äquivalent stark Verbunden.

Dann gibt es eine stationäre Verteilung.

2. Pr[−z(1− α ) ≤ Z ≤ z(1− α ) ] ≥ 1 − α

Periode: maximales ξ so dass {n ∈ N0 |pii > 0} ⊆ {i · ξ|i ∈ N0 }

2

3. Z 2 ≤ z(1−

α nach ϑ auflösen

)

aperiodisch: ξ = 1 bzw. ∃k : pij > 0

2

(n)

2

(k)

∧

(k+1)

pij

>0

2

ergodisch: irreduzibel und aperiodisch, konvergiert immer zu stationärer Verteilung.

Fahrplan Testverfahren:

Eine Doppelstochastische Übergangsmatrix (Zeilen- und Spaltensummen 1) führt zu

Gleichverteilung. (S. 188, 4.23)

Gauß-Test: Eine Zufallsvariable, σ bekannt, µ zu testen. (S. 156)

3

Markovkette in kontinuierlicher Zeit: S. 189 ff.:

λ Zufluss- und µ Abflussrate. Aufenthaltsdauer ∼ Exp(µ).

νij Übergangsrate von i zu j.

λi =

X

νji

µi =

X

νij

j6=i

j6=i

Verteilungsentwichlung S. 193; kontinuierliche Verteilung:

X

X

X

0=

πj νji − πi

νij

mit

πi = 1

j6=i

j6=i

i

Warteschlangen: S. 196 ff.

Ankunftsrate λ, Bearbeitungsrate µ

N Anzahl der Jobs im System (wartend und in Bearbeitung)

Verkehrsdichte ρ = µλ < 1, sonst Divergenz.

E[N ] =

X

k · πk =

k≥0

ρ

1−ρ

Var[N ] =

ρ

(1 − ρ)2

Ri Antwortzeit (Gesamtverweildauer) für Job i, E[N ] = λ · E[R]

Birt-and-Death S. 200 ff.

M/M/k-Schlangen s. Aufgabe 10.4.

4