2.5 Gauß-Jordan

Werbung

2.5

Gauß-Jordan-Verfahren

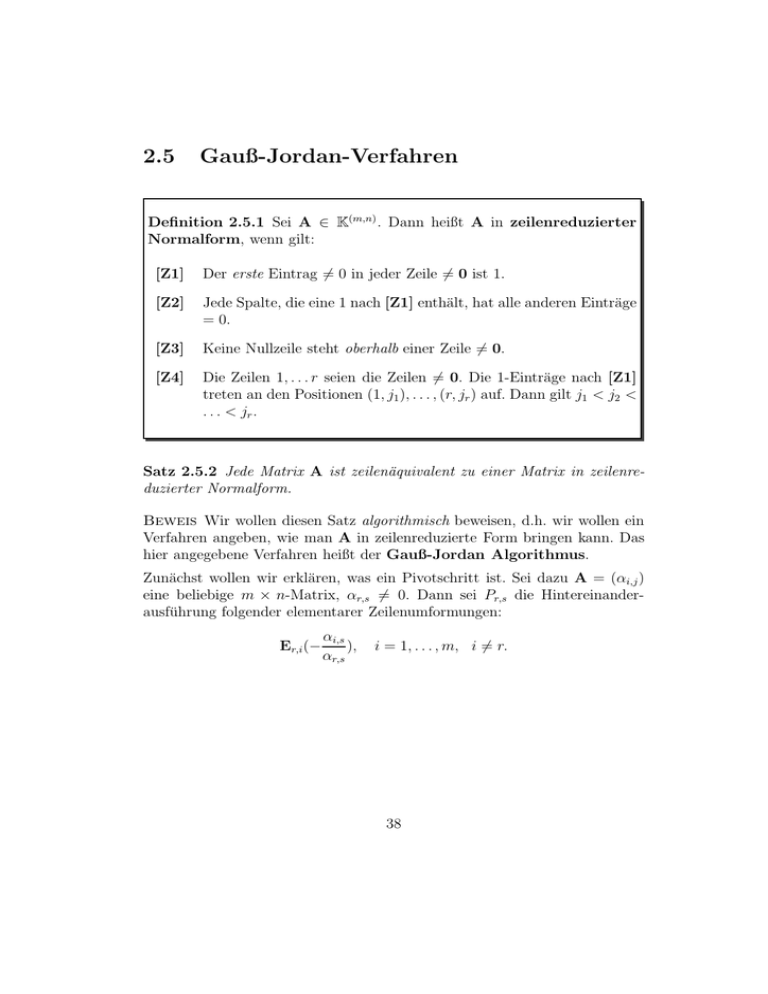

Definition 2.5.1 Sei A ∈ K(m,n) . Dann heißt A in zeilenreduzierter

Normalform, wenn gilt:

[Z1]

Der erste Eintrag 6= 0 in jeder Zeile 6= 0 ist 1.

[Z2]

Jede Spalte, die eine 1 nach [Z1] enthält, hat alle anderen Einträge

= 0.

[Z3]

Keine Nullzeile steht oberhalb einer Zeile 6= 0.

[Z4]

Die Zeilen 1, . . . r seien die Zeilen 6= 0. Die 1-Einträge nach [Z1]

treten an den Positionen (1, j1 ), . . . , (r, jr ) auf. Dann gilt j1 < j2 <

. . . < jr .

Satz 2.5.2 Jede Matrix A ist zeilenäquivalent zu einer Matrix in zeilenreduzierter Normalform.

Beweis Wir wollen diesen Satz algorithmisch beweisen, d.h. wir wollen ein

Verfahren angeben, wie man A in zeilenreduzierte Form bringen kann. Das

hier angegebene Verfahren heißt der Gauß-Jordan Algorithmus.

Zunächst wollen wir erklären, was ein Pivotschritt ist. Sei dazu A = (αi,j )

eine beliebige m × n-Matrix, αr,s 6= 0. Dann sei Pr,s die Hintereinanderausführung folgender elementarer Zeilenumformungen:

Er,i (−

αi,s

),

αr,s

i = 1, . . . , m, i 6= r.

38

1

sowie abschließend Er ( αr,s

). Dadurch wird aus der s-ten Spalte von B

0

0

.

.

.

0

1

0

.

..

0

wobei der Eintrag 1 an der r-ten Position steht.

Nun zum Verfahren: Wir setzen r = 1 und verfahren mit der Matrix A wie

folgt:

Suche die erste Spalte jr

α1,jr

..

.

αm,jr

so, dass nicht alle αr,jr , . . . , αm,jr gleich 0 sind. Sonst STOP, der

Algorithmus terminiert. Durch Zeilenvertauschungen erreicht man

αr,jr 6= 0. Dann pivotisiere Pr,jr .

Die so erhaltene Matrix nennen wir jetzt A und setzen r auf r + 1. Nun

wiederholen wir den oben beschriebenen Schritt.

Das Verfahren terminiert, weil jr < jr+1 gilt.

Die Anzahl Zeilen 6= 0 in einer Matrix, die zeilenreduziert ist, nennt man den

Rang r der Matrix. Es ist zunächst nicht klar, ob der Rang eine Invariante

unter Zeilenäquivalenz ist (das ist zwar der Fall, erfordert aber einigen Aufwand, es zu beweisen; wir können den Beweis erst führen, wenn wir einiges

über Vektorräume wissen).

Wenn A in zeilenreduzierter Normalform mit r Zeilen 6= 0 ist, dann können

die n − r Variablen xi , die zu den Spalten i 6= j1 , . . . jr gehören, frei gewählt

werden. Wir sagen auch, das System hat n − r Freiheitsgrade!

39

2.6

Gauß-Verfahren

Zum Lösen von linearen Gleichungssystemen genügt es, die Matrix in zeilenreduzierte Form zu bringen. Dazu ist es nicht nötig, dass die Einträge über

den Pivots an den Stellen (i, jr ) alle 0 sind, und der (i, jr )-Eintrag muss auch

nicht auf 1 normiert werden.

Definition 2.6.1 Eine Matrix A ∈ K(m,n) heißt zeilenreduziert, wenn

gilt:

[ZR1]

Keine Nullzeile steht oberhalb einer Zeile 6= 0, d.h. die ersten r

Zeilen seien die Zeilen 6= 0.

[ZR1]

Wenn der erste Eintrag 6= 0 in Zeile i in der Spalte ji auftritt, so

gilt j1 < j2 . . . < jr .

Man kann eine Matrix offenbar mit weniger Aufwand in zeilenreduzierte Form

als in zeilenreduzierte Normalform bringen. Wir verwenden dazu ein ähnliches Verfahren wie zuvor, wobei wir den Schritt Pr,s durch die Hintereinanderausführung von

αi,s

Er,i (−

), i = r + 1, . . . , m,

αr,s

ersetzen. Wir nennen dieses Verfahren das Gauß-Verfahren

Bemerkung 2.6.2 (1.) Man kommt beim Gauß-Verfahren ohne die Umformungen [E1] aus.

(2.) Wir werden später sehen, dass jede Matrix zu genau einer Matrix in

zeilenreduzierter Normalform zeilenäquivalent ist. Das ist der Grund, warum

man von einer Normalform spricht. Es gibt verschiedene zeilenreduzierte Matrizen, die zeilenäquivalent sind.

(3.) Das (einfachere) Gauß-Verfahren ist ausreichend, wenn man lineare Gleichungssysteme lösen möchte.

(4.) Es sei noch einmal darauf hingewiesen, dass das Gauß- und das GaußJordan-Verfahren über allen Körpern funktioniert. Es funktioniert i.a. nicht,

wenn man Gleichungen über Ringen lösen möchte.

40

2.7

Lösungsmengen linearer Gleichungssysteme

Wir wollen hier einige einfache Folgerungen notieren, die aus der Tatsache

folgen, dass jede Matrix in zeilenreduzierte Form gebracht werden kann. Die

Sätze sind aber noch etwas unbefriedigend, weil wir nicht zeigen können, dass

der Rang einer Matrix (vgl. Abschnitt 2.5) vernünftig definiert ist.

Satz 2.7.1 Sei A ∈ K(m,n) mit m < n. Dann hat das lineare Gleichungssystem Ax = 0 mindestens eine Lösung x 6= 0.

Beweis Nach Umformung von A in zeilenreduzierte Form gibt es mindestens einen Freiheitsgrad, weil r < n gilt. Dabei ist r die Anzahl der Zeilen

6= 0.

Satz 2.7.2 Sei A ∈ K(n,n) . Dann gilt:

Ax = 0 hat nur die triviale Lösung

⇔

A ist zeilenäquivalent zu I.

Beweis “⇐”: klar.

“⇒”: Angenommen, A ist zu einer Matrix in zeilenreduzierter Form äquivalent, die r < n Zeilen 6= 0 hat. Dann hat A aber eine Lösung x 6= 0,

Widerspruch zur Annahme.

Inhomogene Systeme Ax = b lassen sich im Prinzip genauso lösen wie homogene Systeme: Die Umformungen, die auf die Zeilen von A ∈ K(m,n) angewendet werden, wendet man auch auf b an. Genauer:

Satz 2.7.3 Das lineare Gleichungssystem Ax = b hat dieselbe Lösungsmenge wie A′ x = b′ , wenn die erweiterte Matrix (A′ b′ ) durch elementare Zeilenumformungen aus (A b) hervorgeht.

Wenn man die Matrix (A b) in zeilenreduzierte Form (A′ b′ ) gebracht hat,

kann man also schnell erkennen, ob das System überhaupt eine Lösung hat:

Es hat genau dann eine Lösung, wenn die Matrix A′ genauso viele Zeilen

6= 0 hat wie die Matrix (A′ b′ ). Wenn diese Zahl r ist, so hat das inhomogene

System, ähnlich wie im homogenen Fall, genau n − r Freiheitsgrade.

41

2.8

Matrixmultiplikation

Wir wollen jetzt ein etwas vertieftes Verständnis von elementaren Zeilenumformungen sowie von Satz 2.7.2 bekommen. Dazu müssen wir eine Multiplikation auf der Menge der Matrizen einführen, die zunächst sehr künstlich

wirkt:

Definition 2.8.1 (Matrizenmultiplikation) Sei A ∈ K(m,n) , B ∈

K(n,p) , A = (αi,j ) und B = (βi,j ). Dann ist C := A · B eine m × p-Matrix

(γi,j ) mit

n

X

γi,j :=

αi,k βk,j .

k=1

Achtung: Man kann nicht alle Matrizen miteinander multiplizieren. Die Größen

der Matrizen müssen zueinander passen!

Jetzt wird klar, dass die Notation Ax = b sinnvoll ist. Es handelt sich hier

um eine Matrixgleichung

β1

x1

α1,1 . . . α1,n

..

.. · .. = .. .

.

. . .

xn

αm,1 . . . αm,n

βm

Die Matrizenmultiplikation ist eine binäre Verknüpfung. Diese Verknüpfung

ist sicherlich nicht kommutativ, weil ja evtl. das Produkt AB definiert ist,

nicht aber BA. Aber selbst, wenn sowohl AB als auch BA erklärt sind (wenn

also sowohl A als auch B in K(n,n) liegen), kann AB 6= BA gelten:

0 1

0 1

1 0

=

0 0

0 0

0 0

aber

0 1

1 0

0 0

=

0 0

0 0

0 0

Das Beispiel zeigt auch, dass das Produkt von zwei Matrizen 0 sein kann.

Man kann zeigen, dass das Produkt von Matrizen assoziativ ist. Wir können

auch noch eine (komponentenweise) Addition von Matrizen einführen:

42

Definition 2.8.2 (Matrizenaddition) Sei A ∈ K(m,n) , B ∈ K(m,n) , A =

(αi,j ) und B = (βi,j ). Dann ist C := A + B eine m × n-Matrix (γi,j ) mit

γi,j := αi,j + βi,j .

Man kann nun zeigen:

Satz 2.8.3 Die Matrizen (K(n,n) , +, ·, 0, I) bilden einen im allgemeinen nichtkommutativen Ring mit neutralem Element I.

Beweis (Skizze) Nicht trivial ist nur die Assoziativität der Multipliklation,

die man aber nachrechnen kann.

Wir wollen nun zeigen, dass elementare Zeilenumformungen von A nichts

anderes bedeuten als die Multiplikation der Matrix A von links mit einer

sogenannten Elementarmatrix.

Definition 2.8.4 Elementarmatrizen sind diejenigen quadratischen Matrizen, die aus I durch eine elementare Zeilenumformung hervorgehen.

Es gibt drei Typen von Elementarmatrizen (γi,j ):

Er (γ) = (γi,j ) mit

γi,j

0

= 1

γ

Es,r (γ) = (γi,j ) mit r 6= s und

γ

γi,j = 1

0

wenn i 6= j

wenn i = j, i 6= r

wenn i = j = r

wenn i = r, j = s

wenn i = j

sonst

43

Es,r = (γi,j ) mit r 6= s und

1 wenn i = j, i 6= r, s

γi,j = 1 wenn (i, j) = (r, s) oder (s, r)

0 sonst

Überlegen wir uns das für Es,r (γ) = (γi,j ). Wir betrachten den (i, j)-Eintrag

′

= (Es,r · A)i,j

αi,j

von Es,r · A. Es gilt

′

αi,j

=

n

X

γi,k αk,j

k=1

′

′

Für i 6= r gilt offenbar αi,j

= αi,j . Für i = r erhalten wir αr,j

= γαs,j + αr,j .

Lemma 2.8.5 (1.) Er (γ) · Er (γ −1 ) = Er (γ −1 ) · Er (γ) = I

(2.) Es,r (γ) · Es,r (−γ) = Es,r (−γ) · Es,r (γ) = I

(3.) Er,s · Er,s = I

d.h. zu jeder Elementarmatrix E gibt es eine Elementarmatrix E′ mit EE′ =

E′ E = I. Aus naheliegenden Gründen wird E′ mit E−1 bezeichnet.

Satz 2.8.6 Seien A, B ∈ K(m,n) . Dann ist B zeilenäquivalent zu A genau

dann wenn es ein Produkt P von Elementarmatrizen gibt mit A = PB,

P ∈ K(n,n) .

Wir haben für quadratische Matrizen gesehen, dass A zu I zeilenäquivalent

sein kann, d.h. I = PA, wobei z.B. P = E1 . . . Er , wobei die Ei Elementarmatrizen sind. Dann gilt

I = P·A

I = E1 · · · Er · A

E−1

= E2 · · · Er · A

1

... = ...

−1 −1

Er Er−1 . . . E−1

= A

1

−1 −1

−1

Er Er−1 . . . E2 = AE1

... = ...

I = AP

44

−1

−1

−1

Wir bezeichnen E−1

r Er−1 . . . E1 als P . Dann gilt für zeilenäquivalente Ma−1

trizen PB = A und B = P A.

Definition 2.8.7 Wir nennen A ∈ K(n,n) invertierbar wenn es eine Matrix B gibt mit AB = I.

Satz 2.8.8

A ∈ K(n,n) invertierbar

⇔

A zeilenäquivalent zu I.

Beweis “⇐”: klar

“⇒”: Angenommen, A ist nicht zu I zeilenäquivalent, aber invertierbar,

z.B. AB = I. Dann hat eine zeilenreduzierte Normalform von A eine Nullzeile, ist also nicht invertierbar. Es gibt also ein Produkt P von Elementarmatrizen so, dass PA nicht invertierbar ist, aber P und A sind invertierbar.

Dann ist aber

(PA)(BP−1) = I,

also ist PA doch invertierbar.

Korollar 2.8.9 A ist invertierbar ⇔

trizen.

A ist Produkt von Elementarma-

Wenn AB = I, dann ist auch BA = I. Ferner gibt es nur eine Matrix B

mit AB = I.

Beweis Das A genau dann invertierbar ist wenn es ein Produkt von Elementarmatrizen ist, folgt aus Satz 2.8.6 und 2.8.8. Wenn AB = I und A das

Produkt von Elementarmatrizen ist, dann gilt nach den Bemerkungen vor

Satz 2.8.8 auch BA = I. Beachten Sie bitte, dass diese Vertauschbarkeit nur

gilt, weil A Produkt von Elementarmatrizen ist.

Nun zur Eindeutigkeit: AB = BA = I und AB′ = I. Dann gilt B =

B(AB′) = (BA)B′ = B′ .

Wir können dieses Korollar direkt in einen Algorithmus zur Bestimmung der

Inversen von A umsetzen (siehe Vorlesung).

Der folgende Satz fasst noch einmal zusammen, was für lineare Gleichungssysteme Ax = b und die Invertierbarkeit von A gilt.

45

Satz 2.8.10 Sei A ∈ K(n,n) . Dann sind die folgenden Aussagen äquivalent:

(1.) A ist invertierbar.

(2.) Ax = 0 hat genau eine Lösung.

(3.) Ax = b hat für ein b genau eine Lösung.

(4.) Ax = b hat für jedes b genau eine Lösung.

(5.) A ist zeilenäquivalent zu I.

Beweis Die Äquivalenz von (1.), (2.), und (5.) folgt aus Satz 2.8.8. Wenn wir

die inhomogenen Systeme in (3.) und (4.) umformen, erhalten wir A′ x = b′

für eine zeilenreduzierte Normalform A′ . Wenn diese Matrix eine Nullzeile

hat, dann hat das System A′ x = b′ mehr als eine Lösung (weil nämlich

eine Variable frei gewählt werden kann), oder aber keine Lösung (wenn die

Nullzeile zu einer Gleichung 0x1 + 0x2 + . . . + 0xn = β 6= 0 gehört). Das heißt

aber, dass A′x = b′ nur dann eindeutig lösbar ist, wenn A′ = I. Das liefert

(1.) ⇔ (3.) sowie (1.) ⇔ (4.)

2.9

Zusammenfassung

• Sie haben gelernt, wie man lineare Gleichungssysteme löst. Das ist eines

der wesentlichen Ziele der Vorlesung!

• Sie sollen lineare Gleichungssysteme über beliebigen Körpern lösen

können.

• Die theoretische Behandlung von linearen Gleichungssystemen ist noch

etwas unbefriedigend, weil der Rang noch nicht eindeutig definiert werden konnte. Unbefriedigend ist auch noch, dass wir nicht wissen, ob jede

Matrix zu genau einer Matrix in zeilenreduzierter Normalform äquivalent ist.

• Neben R und Q sollten Sie nun auch in den endlichen Körper Fp sowie

den komplexen Zahlen C rechnen können.

• Machen Sie sich mit der modularen Arithmetik vertraut.

46

• Sie können Matrizen invertieren.

• Sie können Matrizen miteinander multiplizieren und haben verstanden,

das elementare Zeilenumformungen Matrizenmultiplikation von links

mit Elementarmatrizen sind.

47

Kapitel 3

Vektorräume

3.1

Definition und Beispiele

Definition 3.1.1 Sei (V, ⊕, 0) eine Menge, auf der eine Verknüpfung ⊕

definiert ist, die ein Element 0 enthält und die folgende Eigenschaften hat:

[G1]

u ⊕ (v ⊕ w) = (u ⊕ v) ⊕ w

∀u, v, w ∈ V.

[G2]

u⊕v = v⊕u

[G3]

Es gibt ein Element 0 ∈ V mit der Eigenschaft v ⊕ 0 = v

V (neutrales Element).

[G4]

Zu jedem v ∈ V gibt es ein Element w ∈ V mit v ⊕ w = 0.

Bezeichnung für dieses Element w = −v (inverses Element).

∀u, v ∈ V.

∀v ∈

Sei (K, +, ·, 0, 1) ein Körper, und sei ⊙ eine Abbildung V ×K → V (Skalarmultiplikation). Das Element ⊙(v, λ) schreiben wir naheliegenderweise

als v ⊙ λ (v ∈ V, λ ∈ K). Es gelte

[S1]

v⊙1 =v

∀v ∈ V .

[S2]

v ⊙ (λ1 · λ2 ) = (v ⊙ λ1 ) ⊙ λ2

[S3]

(v1 ⊕ v2 ) ⊙ λ = (v1 ⊙ λ) ⊕ (v2 ⊙ λ) ∀v1 , v2 ∈ V, λ ∈ K.

48

∀v ∈ V, λ1 , λ2 ∈ K.

[S4]

v ⊙ (λ1 ⊕ +λ2 ) = (v ⊙ λ1 ) + (v ⊙ λ2 ) ∀v ∈ V, λ1 , λ2 ∈ K.

Dann heißt V ein K-Vektorraum.

Die Elemente aus V heißen Vektoren, die Elemente aus K Skalare. Wir

werden Skalare meistens mit griechischen Buchstaben bezeichnen, Vektoren

mit lateinischen Buchstaben. Beachten Sie, dass wir die Skalare von rechts

an die Vektoren multiplizieren.

Beispiel 3.1.2 (1.) Der in dieser Vorlesung wohl wichtigste Vektorraum

ist

x1

x2

Kn := { .. : x1 , . . . , xn ∈ K}

.

xn

die Menge aller n-Tupel von Elementen aus K. Nun ist das zunächst nur

eine Menge, auf der keine Verknüpfung definiert ist. Das kann aber leicht

nachgeholt werden:

x1

y1

x1 + y1

x2 y2

x2 + y2

.. ⊕ .. := ..

. .

.

xn

yn

xn + yn

sowie

x1 · λ

x1

x2 · λ

x2

.. ⊙ λ := ..

.

.

xn · λ

xn

Man muss jetzt nachrechnen, dass die Menge Kn mit diesen Verknüpfungen

wirklich zu einem Vektorraum wird. Das ist sehr einfach!

(2.) Die Menge K(m,n) der m × n-Matrizen ist ebenfalls ein K-Vektorraum:

Die Addition von Matrizen wurde bereits erklärt, die Skalarmultiplikation ist

α1,1 · · · α1,n

α1,1 · λ · · · α1,n · λ

..

.. ⊙ λ = ..

..

.

.

.

.

αm,1 · · · αm,n

αm,1 · λ · · · αm,n · λ

49

Als Vektorraum betrachtet sind Kmn und K(m,n) fast identisch. Das werden

wir später präzisieren.

(3.) Wir bezeichnen mit

K[x] := {

m

X

ci xi : ci ∈ K, m ∈ N}

i=0

die Menge aller Polynome

Pm i über K. Beachten Sie, dass m hier nicht fest

gewählt ist. Ist f = i ci x , so heißt

max{i : ci 6= 0}

der Grad des Polynoms f . Das Nullpolynom (alle ci = 0) hat demnach

keinen Grad; manchmal

sagt man,

Pn das iNullpolynom habe den Grad −∞.

P

i

c

x

und

Zwei Polynome m

i=0 di x heißen gleich, wenn sie denselben

i=0 i

Grad gr haben und ci = di für alle i ≤ gr gilt.

Wir können K[x] zu einem K-Vektorraum machen:

m

X

i

ci x ⊕

i=0

sowie

n

X

i=0

m

X

i=0

i

m

X

di x =

(ci + di )xi

i

i=0

ci x ⊗ λ =

m

X

(ci · λ)xi .

i=0

Pm

Pn

i

i

Bemerkung zur Addition: Wenn wir

i=0 ci x und

i=0 di x mit n < m

addieren wollen, so setzen wir einfach ci = 0 für m ≥ i > n.

Als K-Vektorraum können wir K[x] auch wie folgt erklären: Dieser Vektorraum besteht aus allen Tupeln

(c0 , c1 , c2 , . . .)

wobei ci 6= 0 für nur endlich viele i gilt (alle abbrechenden Folgen). Wir

haben also keine “echten” Folgen mit unendlich vielen Einträgen 6= 0. Sie

können aber auch den Vektorraum aller nicht abbrechenden Folgen

(c0 , c1 , c2 , . . .)

50

definieren. Dieser Vektorraum wird mit K[[x]] bezeichnet, eine intuitive Notation dafür wäre etwa

K[[x]] = {

∞

X

ci xi : ci ∈ K}

i=0

Hier

man aber aufpassen: Wir haben nur eine formale Summe f =

P∞ muss

i

i=0 ci x und wir setzen für x nichts ein, d.h. wir werten f nicht an irgendeiner Stelle x aus. Das können wir ja auch nicht, denn unendliche Summen

gibt es bei uns in der linearen Algebra nicht! Das geht nur in der Analysis, wo

man Begriffe wie Konvergenz kennt. Wenn wir uns aber auf Polynome, d.h.

K[x] beschränken, so können wir sehr wohl für x etwas einsetzen, nämlich

z.B. irgendwelche Elemente aus K. So können wir aus jedem Polynom auch

eine Abbildung K → K machen. Polynome sind aber nicht dieselben Objekte

wie solche Polynomabbildungen, weil zu verschiedenen Polynomen dieselben

Abbildungen gehören können:

Beispiel 3.1.3 Das Polynom f = x2 + x ∈ F2 [x] liefert bei Einsetzung der

Elemente aus F2 stets den Wert 0, aber f ist nicht das Nullpolynom.

4. Sei S eine beliebige Menge. Die Menge

Abb(S; K) = {f : f ist Abbildung S → K}

ist ein K-Vektorraum. Die Addition auf Abb(S; K) ist

f ⊕g : S →

K

s 7→ f (s) + g(s)

und die Skalarmultiplikation

f ⊗λ : S →

K

s 7→ f (s) · λ

Lemma 3.1.4 In einem K-Vektorraum gilt für alle v ∈ V :

1. v · 0 = 0

2. v · 1 = v

51

3. v · λ = 0

⇔

v = 0 oder λ = 0

4. v · (−1) = −v

Wir wollen in diesem Kapitel abschließend noch den Begriff der Linearkombination definieren:

Definition 3.1.5 Sei V ein K-Vektorraum, und sei S ⊆ V . Dann heißt

ein Vektor v eine Linearkombination von Vektoren aus S, wenn es

v1 , . . . , vn ∈ S und Skalare λ1 , . . . λn gibt mit

v=

n

X

vi · λi .

i=1

52