Flexible Analysetechniken für kürzeren "time to mar

Werbung

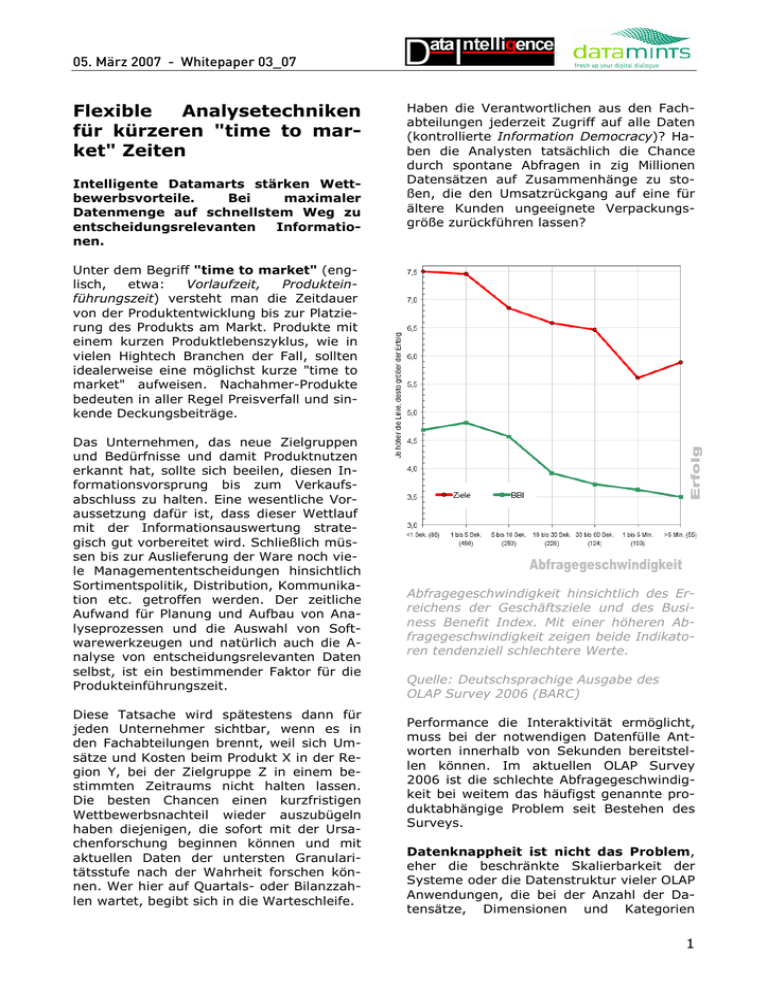

05. März 2007 - Whitepaper 03_07 Flexible Analysetechniken für kürzeren "time to market" Zeiten Intelligente Datamarts stärken Wettbewerbsvorteile. Bei maximaler Datenmenge auf schnellstem Weg zu entscheidungsrelevanten Informationen. Haben die Verantwortlichen aus den Fachabteilungen jederzeit Zugriff auf alle Daten (kontrollierte Information Democracy)? Haben die Analysten tatsächlich die Chance durch spontane Abfragen in zig Millionen Datensätzen auf Zusammenhänge zu stoßen, die den Umsatzrückgang auf eine für ältere Kunden ungeeignete Verpackungsgröße zurückführen lassen? Unter dem Begriff "time to market" (englisch, etwa: Vorlaufzeit, Produkteinführungszeit) versteht man die Zeitdauer von der Produktentwicklung bis zur Platzierung des Produkts am Markt. Produkte mit einem kurzen Produktlebenszyklus, wie in vielen Hightech Branchen der Fall, sollten idealerweise eine möglichst kurze "time to market" aufweisen. Nachahmer-Produkte bedeuten in aller Regel Preisverfall und sinkende Deckungsbeiträge. Das Unternehmen, das neue Zielgruppen und Bedürfnisse und damit Produktnutzen erkannt hat, sollte sich beeilen, diesen Informationsvorsprung bis zum Verkaufsabschluss zu halten. Eine wesentliche Voraussetzung dafür ist, dass dieser Wettlauf mit der Informationsauswertung strategisch gut vorbereitet wird. Schließlich müssen bis zur Auslieferung der Ware noch viele Managemententscheidungen hinsichtlich Sortimentspolitik, Distribution, Kommunikation etc. getroffen werden. Der zeitliche Aufwand für Planung und Aufbau von Analyseprozessen und die Auswahl von Softwarewerkzeugen und natürlich auch die Analyse von entscheidungsrelevanten Daten selbst, ist ein bestimmender Faktor für die Produkteinführungszeit. Diese Tatsache wird spätestens dann für jeden Unternehmer sichtbar, wenn es in den Fachabteilungen brennt, weil sich Umsätze und Kosten beim Produkt X in der Region Y, bei der Zielgruppe Z in einem bestimmten Zeitraums nicht halten lassen. Die besten Chancen einen kurzfristigen Wettbewerbsnachteil wieder auszubügeln haben diejenigen, die sofort mit der Ursachenforschung beginnen können und mit aktuellen Daten der untersten Granularitätsstufe nach der Wahrheit forschen können. Wer hier auf Quartals- oder Bilanzzahlen wartet, begibt sich in die Warteschleife. Abfragegeschwindigkeit hinsichtlich des Erreichens der Geschäftsziele und des Business Benefit Index. Mit einer höheren Abfragegeschwindigkeit zeigen beide Indikatoren tendenziell schlechtere Werte. Quelle: Deutschsprachige Ausgabe des OLAP Survey 2006 (BARC) Performance die Interaktivität ermöglicht, muss bei der notwendigen Datenfülle Antworten innerhalb von Sekunden bereitstellen können. Im aktuellen OLAP Survey 2006 ist die schlechte Abfragegeschwindigkeit bei weitem das häufigst genannte produktabhängige Problem seit Bestehen des Surveys. Datenknappheit ist nicht das Problem, eher die beschränkte Skalierbarkeit der Systeme oder die Datenstruktur vieler OLAP Anwendungen, die bei der Anzahl der Datensätze, Dimensionen und Kategorien 1 05. März 2007 - Whitepaper 03_07 schlichtweg Grenzen setzt. Neue Fragestellungen mit neuen oder neu strukturierten Dimensionen ziehen die Generierung immer neuer OLAP Würfel nach sich. Ein Aufwand den IT Abteilungen aus Zeitgründen und aus Sorge um Systemressourcen scheuen. Analysten werden schließlich dazu verdonnert mit Standard-Reports und grob granulären Daten zu arbeiten. Das Risiko eines verspäteten Erkenntnisgewinns steigt – schlechte Voraussetzungen für kurze Vorlaufzeiten im Marketing. Eine solide Informationsgrundlage liefert in der Regel ein Datawarehouse. Es enthält Daten hoher Qualität, die gepflegt und in sich stimmig sind. Eine schnelle Anpassung an geänderte Aufgabenstellungen gestaltet sich jedoch gerade aus diesem Grund recht aufwändig. Die Komplexität eines Datawarehouse steigt mit dem Umfang exponentiell an. Das Hinzufügen und Neuordnen von Daten wird zum zeitintensiven Faktor. Noch kritischer stellt sich die Lage für Mittelständler dar, die hier nicht in dem Maße in die Informationsgewinnung investieren können oder wollen, als dies für kürzere "time to market" Zeiten notwendig wäre. Der klassische Ansatz AnforderungenKonzeption-Realisierung nimmt hier zu viel Zeit in Anspruch und wir den gestellten Ansprüchen nicht gerecht. Ein praktischer Lösungsansatz für dieses Problem ist die Reduktion der Komplexität durch Beschränkung auf das Notwendigste. Dieser Ansatz bedeutet jedenfalls, dass mit Standardwerkzeugen wie Excel und Access schnell Ergebnisse erzielt werden können – nicht selten auf Kosten der Ergebnissicherheit und Flexibilität. Ab einer gewissen Datenmenge ist ein solches Vorgehen nicht mehr praktikabel. Die Einfachheit von Excel als Frontend in Verbindung mit hoch performanten Datenquellen mehrdimensionaler Rechenergebnisse wird in der Praxis mit Middlewarelösungen erreicht, die als Datamart zwischen operativen Datenquellen oder einem DataWarehouse und Frontends wie Excel, Access u.a. eingebunden werden. Einer der wenigen Vertreter dieser Analyse-Beschleuniger ist QueryObject vom italienischen BI Entwickler CrossZ Solutions und dem deutschen Systemhaus datamints Penzberg. GmbH aus dem bayerischen Warum sind solche Analysebeschleuniger wie QueryObject für die Industrie und Verwaltung so wichtig? Weil politische Entscheidungen beispielsweise, die auf Basis mehrdimensionaler Analysen mit 100 und mehr Millionen Datensätzen getroffen werden sollen, der IT keine Zeit geben. Hier zwei Beispiele für derartige, vornehmlich aus ROLAP Systemen stammenden Anforderungen: Fragen zur inneren Sicherheit Terrorismusbekämpfung und QueryObject Datamarts im Einsatz bei der italienischen Einwanderungsbehörde: Personendaten von Nicht-EU Bürgern können mit der QueryObject Analysetechnologie in wenigen Sekunden abgefragt und mit Daten aus weiteren Quellen verknüpft werden. Als Web-Anwendung (PHP/JSP) können Behörden landesweit auf diese Daten zugreifen, ohne dass bei jeder ad hoc Abfrage auf die zentrale "Immigration Database" zugegriffen werden muss. QueryObject Datamarts sind so konzipiert, dass Millionen Datensätze als wenige Megabyte kleine Datei abgelegt werden. Ein Security Layer garantiert die Sicherheit der read-only Dateien, die sehr einfach via EMail oder CD/DVD verteilt werden. Für die Analyse selbst ist kein OLAP Server notwendig. Diese kann jederzeit auch Offline auf dem Laptop des Analysten passieren. Die QueryObject Dateien verhalten sich gegenüber jedem Frontend mit ODBC Schnittstelle als relationale Tabelle. Selbst sehr komplexe mehrdimensionale Abfragen benötigen ausschließlich einfache SQL Befehle (keine MDX notwendig!). Die hohe Abfrageperformance erklärt sich daraus, dass jede theoretisch mögliche Berechnung mit den ins Datamart geladenen Daten bereits automatisch durchgeführt wurde. Ein sorgsames Haushalten mit Dimensionen und Ebenen und der Datenmenge wie bei OLAP Würfeln gewöhnlich der Fall, ist bei den QueryObject Datamarts nicht notwendig. Hier können die Analysten sehr großzügig vorgehen und sich somit viel 2 05. März 2007 - Whitepaper 03_07 Unabhängigkeit von Administratoren verschaffen. Wettbewerbsvorteile in der Telekommunikation Telefongesellschaften wie TIM, Wind, Telekom Italia, MCI Worldcom u.a. setzen die QueryObject Middleware nicht nur zur Analyse von Netzwerkperformance, TrafficDaten oder zur Aufdeckung offener Posten (Billing Reconciliation) ein. Analysen hinsichtlich Kundenabwanderung und Kaufverhalten sind die wichtigsten Maßnahmen, um möglichst schnell wieder zu einem bedürfnisgerechteren Tarifmodell zu kommen. Antwortzeiten bei Abfragen von zig Millionen Call Detail Records über einen Zeitraum von über einem Jahr stehen im Kundenservice von MCI im Vordergrund, die dem Anrufer damit Antworten schon nach wenigen Sekunden am Telefon liefern können. Eine kurze "time to market" setzt voraus, dass so genannte Decision Support Systeme, also OLAP-Systeme (Online Analytical Processing), den Entscheidungsträgern ein intuitives, schnelles und flexibles Manipulieren von Daten mittels vertrauter Geschäftsbegriffe ermöglichen. Dazu braucht es nicht nur schnelle, flexible Lieferanten von Rechenergebnissen sondern auch eine ebenso flexible Anwendung die den Rahmen setzt. In der Praxis erweisen sich Prozessmanagementsysteme, die als Framework aufgebaut sind, als sehr vorteilhaft. Neue Anforderungen lassen sich damit schnell zu einer betriebsfertigen Anwendung konfigurieren. Ein Beispiel eines solchen Frameworks stellt das Softwareprodukt "Der Analyzer" von der Firma DataIntelligence GmbH aus Bad Homburg dar. Der Analyzer bietet Datenanbietern (Datenbrokern) und deren Kunden aus Marketing- und Vertriebsabteilungen eine analytische Plattform auf der Daten beispielsweise aus dem Gesundheitswesen, schnell und unkompliziert für mehrdimensionale Abfragen zur Verfügung gestellt werden. Die Anwender führen diese Analysen in eigener Regie aus und werden nicht durch vorgefertigte Reports eingeschränkt. Die Browser ähnliche Oberfläche erlaubt Gelegenheitsnutzern einen schnellen Ein- stieg in die Bedienung und verlangt für tiefergehende Analysen keine Datenbankkenntnisse. Ein definiertes Datenmodell und die Verwendung von Metadaten ermöglichen es die Konfiguration des Analyzers so zu ändern, dass ohne zeitaufwändige Programmierung in kurzer Zeit eine völlig neue Anwendung entsteht. Als Beispiel dienen hier OutsourcingUnternehmen, die für regionale Energieversorger das komplette Datenmanagement übernehmen. Sie haben mit dieser Framework-Technologie die Möglichkeit auf veränderte Informationsbedürfnisse ihrer Kunden wesentlich flexibler zu reagieren. Die Kunden selbst (z.B. Stadtwerke) erhalten in kürzester Zeit einen Einblick in veränderte Verbrauchergewohnheiten ohne dazu eine eigene Business Intelligence Abteilung aufbauen zu müssen. Die Steuerung durch Metadaten bildet den Kern des Analyzer Frameworks. Metadaten sorgen dafür, dass die Struktur der Nutzdaten und die notwendigen Verarbeitungsschritte der Applikation bekannt gemacht und dem Nutzer angeboten werden. Um eine neue Applikation mit dem Analyzer zu realisieren, müssen zunächst die gewünschten Nutzdaten in eine entsprechende einladbare Form gebracht werden. Als Basis dient hier ein Sterndatenmodell, welches die einfache Auswertung von Dimensionen und Fakten nach allen möglichen Gesichtspunkten gestattet. Als nächstes werden die Meta-Daten eingerichtet, um diese Datenstruktur für die Verarbeitung je nach gewünschter Abfrage zugänglich zu machen. Das Ergebnis ist eine in wenigen Tagen erstellte Informationsanwendung für spezielle Bedürfnisse mit eigener Datenbank. Diese Datenbank lässt sich durch Zeitreihen weiter fortschreiben und wird dem Nutzer aktualisiert weitergegeben. Der Anwender stellt sich auf der Oberfläche die gewünschten Abfragen zusammen. Nach der Ausführung erhält er das Ergebnis in Form einer flexiblen Pivot-Darstellung, die dann weiter geändert oder exportiert werden kann. Um seinen individuellen Bedürfnissen nachzukommen, kann er sich die Nutzdaten durch Gruppierungen und Kom- 3 05. März 2007 - Whitepaper 03_07 binationen von Elementen selber strukturieren. Die Abfragen lassen sich abspeichern und können so an andere Anwender weitergegeben werden. Gleiches gilt auch für die Ergebnisse. Beim Analyzer handelt es sich technologisch um einen Datamart, der auf Hyperion Intelligence als Frontend und Sybase iAnywhere als relationale Datenbank für Nutz- und Metadaten basiert. Bei großen Datenmengen wird QueryObject als Basis für die vorberechneten Fakten eingesetzt. Die Kombination konfigurierbarer Einzelwerkzeuge ("best of breed") dürfte bei der Analyse von Business-Daten angesichts des hierzulande häufig kritisierten Wettbewerbnachteils langer Produkteinführungszeiten weiter an Bedeutung gewinnen. Die Autoren: Stefan Maier, Geschäftsführer der datamints GmbH, Systemhaus für Database Marketing www.datamints.com [email protected] Tel. 08856 – 80 20 435 Michael Beth, Geschäftsführer der DataIntelligence GmbH - Entwicklung von Business Intelligence Anwendungen www.dataintelligence.de [email protected] Tel. 06172 – 68118 35 Quellen: Abb. S.1 aus kostenfreie Leseprobe des OLAP Survey 6 (BARC, dt. Ausgabe) http://www.barc.de/fileadmin/barc/study/OLAP_Survey_06_Leseprobe.pdf 4