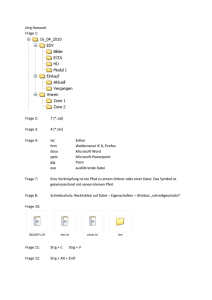

EDV für Korpuslinguisten - hatas

Werbung