Compilerbau - Technische Universität Braunschweig

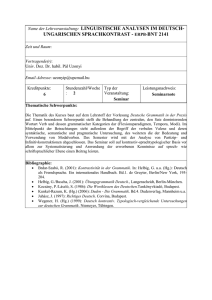

Werbung

TECHNISCHE UNIVERSITÄT CAROLO-WILHELMINA ZU BRAUNSCHWEIG

Vorlesungsskript

Compilerbau

Prof. Dr. Ursula Goltz

Dr. Thomas Gehrke

Dipl.-Inform. Malte Lochau

11. Mai 2010

Institut für Programmierung und Reaktive Systeme

Vorwort

Das vorliegende Skript ist als Ausarbeitung der Compilerbau-Vorlesung entstanden,

die ich seit dem Sommersemester 1992, zunächst an der Universität Hildesheim, seit

1998 an der Technischen Universität Braunschweig halte. Die erste Version der Vorlesung war stark durch die Compilerbau-Vorlesung Prof. Dr. Klaus Indermark, die

ich in den 80’er Jahren an der RWTH Aachen als Mitarbeiterin betreuen durfte,

beeinflusst. Sie basiert außerdem zu großen Teilen auf dem klassischen Drachen”

buch“ [Aho08] von Aho et. al. Sehr hilfreich bei der Weiterentwicklung der Vorlesung

war das zwischenzeitlich erschienene Buch von Reinhard Wilhelm und Dieter Maurer

[WM96].

Darüber hinaus haben im Laufe der Jahre viele Beteiligte zur Ausarbeitung und Weiterentwicklung dieses Skripts beigetragen, denen ich an dieser Stelle danken möchte.

Zunächst danke ich Dr. Michaela Huhn und Dr. Peter Niebert, die mich bei der Konzeption der Vorlesung in Hildesheim hervorragend unterstützt haben. Besonderer

Dank gebührt meinen Mitautoren Dr. Thomas Gehrke und Malte Lochau, die dieses

Skript mit hoher Selbstständigkeit bearbeitet haben. Dr. Werner Struckmann und

Tilo Mücke haben durch Ergänzungen und hilfreiche Hinweise beigetragen. Jochen

Kamischke hat uns als studentische Hilfskraft sehr gut unterstützt. Die Studierenden,

die diese Vorlesung in den vergangenen Jahren gehört haben, haben durch ihre aktive Teilnahme ebenfalls zur Weiterentwicklung des Skripts beigetragen; auch Ihnen

gebührt mein herzlicher Dank.

Braunschweig, den 5. März 2009

Ursula Goltz

i

Inhaltsverzeichnis

Verzeichnis der Abbildungen

v

Verzeichnis der Tabellen

vii

Listings

viii

1 Einführung

1.1 Inhalte und Gliederung . . . . . . . . . . . .

1.2 Höhere Programmiersprachen . . . . . . . .

1.3 Implementierung von Programmiersprachen

1.3.1 Interpreter . . . . . . . . . . . . . . .

1.3.2 Compiler . . . . . . . . . . . . . . . .

1.3.3 Virtuelle Maschinen als Zielplattform

1.4 Umgebung eines Compilers . . . . . . . . . .

1.5 Aufbau eines Compilers . . . . . . . . . . .

1.5.1 Analyse . . . . . . . . . . . . . . . .

1.5.2 Synthese . . . . . . . . . . . . . . . .

1.5.3 Front-End, Back-End . . . . . . . . .

1.5.4 Läufe . . . . . . . . . . . . . . . . . .

2 Lexikalische Analyse

2.1 Terminologie . . . . . . . . . . . . . . . . . .

2.2 Reguläre Sprachen und endliche Automaten

2.2.1 Reguläre Sprachen . . . . . . . . . .

2.2.2 Reguläre Ausdrücke . . . . . . . . . .

2.2.3 Endliche Automaten . . . . . . . . .

2.2.4 Reguläre Definitionen . . . . . . . . .

2.3 Sieber . . . . . . . . . . . . . . . . . . . . .

2.4 Fehlerbehandlung . . . . . . . . . . . . . . .

3 Syntaktische Analyse

3.1 Kontextfreie Grammatiken . . . .

3.1.1 Kontextfreie Grammatiken

3.1.2 Ableitungen . . . . . . . .

3.1.3 Strukturbäume . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

2

3

3

3

4

5

7

7

11

12

12

.

.

.

.

.

.

.

.

14

14

15

16

16

18

27

30

32

.

.

.

.

35

35

36

38

40

iii

Inhaltsverzeichnis

3.2

3.3

3.4

3.5

3.1.4 Mehrdeutige Grammatiken . . . . . . . . . . .

Konstruktion von Parsern . . . . . . . . . . . . . . .

3.2.1 Kellerautomat . . . . . . . . . . . . . . . . . .

Top-Down-Syntaxanalyse . . . . . . . . . . . . . . . .

3.3.1 LL(k)-Grammatiken . . . . . . . . . . . . . .

3.3.2 Transformierung von Grammatiken . . . . . .

3.3.3 Erweiterte kontextfreie Grammatiken . . . . .

3.3.4 Fehlerbehandlung bei der Top-Down-Analyse .

Bottom-Up-Syntaxanalyse . . . . . . . . . . . . . . .

3.4.1 LR(k)-Grammatiken . . . . . . . . . . . . . .

3.4.2 Fehlerbehandlung bei der Bottom-Up-Analyse

Parser Generatoren . . . . . . . . . . . . . . . . . . .

4 Semantische Analyse

4.1 Attributierte Grammatiken . . . . . .

4.2 Typüberprüfung . . . . . . . . . . . .

4.2.1 Typsysteme . . . . . . . . . .

4.2.2 Gleichheit von Typausdrücken

4.2.3 Typumwandlungen . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. 42

. 46

. 46

. 49

. 51

. 59

. 67

. 75

. 80

. 84

. 113

. 117

.

.

.

.

.

118

119

128

129

135

137

.

.

.

.

.

5 Zwischencode-Erzeugung

5.1 Abstrakte Keller-Maschinen . . . . . . . . . . . . . . . . . . . . . . .

5.1.1 Syntaxbäume . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.1.2 Zwischencode für die Keller-Maschine . . . . . . . . . . . . . .

5.1.3 Befehle zur Steuerung des Kontrollflusses . . . . . . . . . . . .

5.2 Drei-Adreß-Code . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2.1 Übersetzung von Syntaxbäumen in Drei-Adreß-Code . . . . .

5.2.2 Übersetzung in Drei-Adreß-Code unter Verwendung von attributierten Grammatiken . . . . . . . . . . . . . . . . . . . . . .

5.3 Vergleich der beiden Arten von Zwischencode . . . . . . . . . . . . .

141

142

143

147

147

151

153

Literaturverzeichnis

158

iv

155

157

Verzeichnis der Abbildungen

1.1

1.2

1.3

1.4

Umgebung eines Compilers. .

Phasen eines Compilers. . . .

Übersetzung einer Zuweisung.

Parse-Baum der Zuweisung. .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

7

9

10

2.1

2.2

2.3

2.4

2.5

2.6

2.7

2.8

2.9

Interaktion zwischen Scanner und Parser. . . . . . . . .

Beispiel eines Übergangsgraphen. . . . . . . . . . . . .

Konstruktion eines NEA zu einem regulärem Ausdruck.

Beispiel einer NEA-Konstruktion. . . . . . . . . . . . .

Beispiel zur Potenzmengenkonstruktion. . . . . . . . .

DEA mit minimaler Zustandsmenge. . . . . . . . . . .

Beispiel zur Minimalisierung. . . . . . . . . . . . . . . .

Übergangsgraphen für die Symbole des Beispiels. . . .

Analyse eines Programmausschnitts. . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

14

20

21

21

24

26

26

31

33

3.1

3.2

3.3

3.4

3.5

3.6

3.7

3.8

3.9

3.10

3.11

3.12

3.13

3.14

3.15

3.16

3.17

3.18

3.19

Interaktion zwischen Scanner, Parser und restlichem Front-End. . .

Beispiel eines Strukturbaums. . . . . . . . . . . . . . . . . . . . . .

Konstruktion eines Strukturbaums. . . . . . . . . . . . . . . . . . .

Verschiedene Strukturbäume zu einem Satz. . . . . . . . . . . . . .

Mögliche Strukturbäume des “dangling else”-Problems. . . . . . . .

Lösung des “dangling else”-Problems. . . . . . . . . . . . . . . . . .

Schema eines Kellerautomaten. . . . . . . . . . . . . . . . . . . . .

Konstruktion des Strukturbaums anhand der Ausgabe des Parsers. .

Fehlerhafte Konstruktion eines Strukturbaums für die Eingabe a. .

Transformation in rechtsrekursive Grammatik. . . . . . . . . . . . .

Beispiel einer regulären Ableitung. . . . . . . . . . . . . . . . . . .

Übergangsgraphen für arithmetische Ausdrücke. . . . . . . . . . . .

Übergangsgraphen für Pascal-Typen. . . . . . . . . . . . . . . . . .

Beispiel eines recursive descent-Parsers. . . . . . . . . . . . . . . . .

Aufrufgraph einer recursive descent-Syntaxanalyse. . . . . . . . . .

Erzeugung eines Strukturbaums für einen arithmetischen Ausdruck.

Beispiel eines charakteristischen endlichen Automaten . . . . . . . .

Beispiel eines LR-DEA. . . . . . . . . . . . . . . . . . . . . . . . . .

Struktur einer LR(1)-Parse-Tabelle. . . . . . . . . . . . . . . . . . .

. 35

. 41

. 42

. 43

. 44

. 45

. 47

. 52

. 56

. 61

. 69

. 71

. 73

. 74

. 75

. 82

. 90

. 94

. 104

v

Verzeichnis der Abbildungen

3.20 Zustandsmenge des LR-DEA der Grammatik zur Beschreibung der

C-Zuweisung aus Beispiel 43. . . . . . . . . . . . . . . . . . . . . . . 106

3.21 Zustandsmenge des charakteristischen endlichen Automaten mit LR(1)Items zur Grammatik aus Beispiel 43. . . . . . . . . . . . . . . . . . . 107

3.22 Charakteristischer endlicher LR(1)-Automat zur Grammatik aus Beispiel 43. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 108

3.23 Zustandsmenge des charakteristischen endlichen Automaten mit SLR(1)Items für die Grammatik aus Beispiel 43. . . . . . . . . . . . . . . . . 110

3.24 Zustandsmenge des charakteristischen endlichen Automaten mit LALR(1)Items für die Grammatik aus Beispiel 43. . . . . . . . . . . . . . . . . 111

3.25 Charakteristischer endlicher LR(1)-Automat zur Grammatik aus Beispiel 43. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

4.1

4.2

4.3

4.4

4.5

4.15

Beispiel eines attributierten Strukturbaums. . . . . . . . . . . . . . . 119

Synthetische und inherite Attribute. . . . . . . . . . . . . . . . . . . . 120

Berechnung von Typinformationen im Strukturbaum. . . . . . . . . . 121

Attributierter Strukturbaum zur Analyse einer Binärzahl. . . . . . . . 123

Attributierter Strukturbaum zur Analyse einer Binärzahl mit inheritem Attribut. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124

Darstellung der direkten Abhängigkeiten zwischen Attributvorkommen.126

Beispiel eines Abhängigkeitsgraphen. . . . . . . . . . . . . . . . . . . 127

“Verklebter” Abhängigkeitsgraph. . . . . . . . . . . . . . . . . . . . . 127

Semantische Regeln für Beispielsprache. . . . . . . . . . . . . . . . . . 133

Attributierter Strukturbaum für ein Beispielprogramm. . . . . . . . . 133

Attributierter Strukturbaum für ein fehlerhaftes Beispielprogramm. . 134

Funktion zur Überprüfung, ob zwei Typausdrücke identisch sind. . . . 135

Attributierter Strukturbaum einer Zuweisung. . . . . . . . . . . . . . 139

Attributierter Strukturbaum einer Zuweisung mit Attributabhängigkeiten. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 139

Attributierter Strukturbaum einer Zuweisung mit Typfehler. . . . . . 140

5.1

5.2

5.3

5.4

5.5

5.6

5.7

5.8

Einordnung der Zwischencode-Erzeugung. . . . . . . . . . . . . . . .

Syntaxbaum . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Konstruktion eines Syntaxbaums aus Postfix-Notation. . . . . . . . .

Auswertung eines Postfix-Ausdrucks mit Hilfe eines Stacks. . . . . . .

Attributierter Strukturbaum mit Zwischencode. . . . . . . . . . . . .

Attributierter Strukturbaum einer verschachtelten if-Anweisung. . . .

Syntaxbaum mit temporären Namen. . . . . . . . . . . . . . . . . . .

Syntaxbaum mit Attributen für die Erzeugung von Drei-Adreß-Code.

4.6

4.7

4.8

4.9

4.10

4.11

4.12

4.13

4.14

vi

141

144

145

146

148

152

154

156

Verzeichnis der Tabellen

2.1

2.2

2.3

Beispiele für Symbole, Muster und Lexeme. . . . . . . . . . . . . . . 15

Übergangsrelation ∆ in Tabellenform. . . . . . . . . . . . . . . . . . . 20

Reguläre Ausdrücke und die dazugehörigen Symbole und Attributwerte. 29

3.1

3.2

3.3

3.4

3.5

3.6

Beispielableitung eines Top-Down-Parsers. . . . .

Beispiel einer Parse-Tabelle. . . . . . . . . . . . .

Parse-Tabelle für dangling-else-Grammatik. . . . .

Für Fehlerbehandlung modifizierte Parse-Tabelle.

Beispiel einer Ableitung mit Fehlerbehandlung. .

Beispielableitung eines Bottom-Up-Parsers. . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

50

64

67

77

78

83

vii

Listings

NEA nach DEA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

DEA Minimalisierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

23

25

Berechnung von FIRST 1–Mengen . . . . . . . . . . . . . . . . . . . . . .

Berechnung von FOLLOW 1–Mengen . . . . . . . . . . . . . . . . . . . . .

Transformation einer linksrekursiven in eine rechtsrekursive Grammatik . .

Linksfaktorisierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Konstruktion der Parse–Tabelle zu einer Grammatik . . . . . . . . . . . .

Deterministische Top–Down–Analyse mit Parse–Tabelle . . . . . . . . . . .

Konstruktion der FIRST–und FOLLOW–Mengen einer ELL(1)–Grammatik

Beispiel eines recursive descent–Parsers . . . . . . . . . . . . . . . . . . . .

LR–DEA–Konstruktion . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Algorithmus LR(1)–GEN . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Konstruktion der LR(1)–action–Tabelle . . . . . . . . . . . . . . . . . . . .

LR(1)–Parse–Algorithmus . . . . . . . . . . . . . . . . . . . . . . . . . . .

Konstruktion der SLR(1)–action–Tabelle . . . . . . . . . . . . . . . . . . .

57

58

60

62

63

65

69

74

92

100

104

105

109

Ueberpruefung ob zwei Typausdruecke identisch sind . . . . . . . . . . . . 135

viii

1 Einführung

1.1 Inhalte und Gliederung

Die Techniken zur Konstruktion von Übersetzern (Compiler) als der altehrwürdigen Disziplin der Informatik sind unverändert allgegenwärtig. Wie kaum ein anderes

Gebiet der Informatik werden beim Compilerbau Themen aus Theorie und Praxis

miteinander verbunden. Auf der einen Seite bilden Automatentheorie und formale

Sprachen das theoretische Fundament bei der Implementierung von Programmiersprachen. Zugleich gehören aber auch praktische Fragestellungen beim Entwurf und

der Entwicklung von Programmiersprachen für konkrete Aufgabenstellungen zu diesem Beschäftigungsfeld. Schließlich muss sich der Compilerbauer auch mit den Ressourcen, Befehlssätzen etc. unterschiedlichster Rechnerarchitekturen möglicher Zielplattformen auseinander setzen.

Auch bei aktuellen Themen und Problemstellungen der Informatik kommt man an

Techniken des Compilerbaus nicht vorbei. Dazu zählen Themen wie virtuelle Maschinen, Parallelisierung, Speicherlokalität und Programmanalyse und -optimierung.

Das vorliegende Skript ist in zwei Teile gegliedert. Der erste Teil befasst sich mit den

Teilen des Compilers, die als Front-End bezeichnet werden. Dazu zählen alle Phasen

des Übersetzungsvorgangs einer Eingabesprache, die unabhängig von der Zielsprache

und Ausführungsplattform für übersetzte Programme erfolgen. Dazu zählen insbesondere die Analysephasen zur Überprüfung der Korrektheit des Eingabeprogrammes

sowie die im Rahmen der einzelnen Übersetzungsschritte erzeugten Zwischendarstellungen des Eingabeprogrammes.

Nach dem einführenden Kapitel, das die Grundbegriffe des Übersetzerbaus einführt,

folgen aufeinander aufbauend die ausführliche Einführung der Konzepte der lexikalischen, syntaktischen und (statischen) semantischen Analyse. Die Vorgehensweise

in den einzelnen Phasen wird jeweils durch Beispiele veranschaulicht, so zum Beispiel die Typüberprüfung im Rahmen der semantischen Analyse. Eine systematische

Einführung in die theoretischen Grundlagen von Typsystemen erfolgt dann im zweiten Teil des Skripts. Als Abschluss des ersten Teils werden verschiedene Techniken

der Zwischencode-Erzeugung beschrieben, die den vorbereitenden Schritt für die anschließende Code-Generierung durch das Back-End darstellen.

Der zweite Teil des Skripts ist dem Back-End des Compilers gewidmet, also den

Zielplattform-spezifischen Phasen, in denen die Synthese des Zielprogrammes aus

dem Quellprogramm erfolgt. Der Schwerpunkt wird in diesem Teil auf der Überset-

1 Einführung

zung objektorientierter Programmiersprachen liegen, deren statische und dynamische

Eigenschaften im Detail untersucht werden. Als exemplarische Zielplattform werden

abstrakte bzw. virtuelle Maschine betrachtet. Die theoretischen Grundlagen werden dann ausführlich an einer konkreten Programmiersprache, der objektorientierten

Sprache Java, verdeutlicht. Den Abschluss bilden Optimierungstechniken für Übersetzer, wobei sowohl allgemeine Ansätze, als auch speziell objektorientierte Ansätze

beschrieben werden.

1.2 Höhere Programmiersprachen

In der Anfangszeit der Informatik wurde die Programmierung von Rechnern in der

jeweiligen Maschinensprache des entsprechenden Rechners vorgenommen. Aufgrund

der Rechnerorientierung dieser Sprachen war der Entwurf sowie die nachfolgende

Anpassung und Änderung des Programmcodes äußerst aufwendig und mit hohen

Kosten verbunden. Speicherzellen mußten direkt über ihre jeweiligen Adressen angesprochen werden. Wurden nachträglich Änderungen am Programm vorgenommen,

mußten diese Adressen “von Hand” angepaßt werden.

Eine erste Verbesserung wurde durch die Einführung der Assemblersprachen erzielt. Den Befehlen der Maschinensprache wurden kurze Buchstabenfolgen, sogenannte Mnemonics1 , zugeordnet, die die Lesbarkeit von Programmtexten erhöhen. Das

Programm zur Generierung des zu einem Assemblertext gehörenden Maschinenprogramms, ebenfalls Assembler genannt, erlaubte eine rudimentäre Überprüfung des

Programmtextes auf Fehler. Außerdem wurde durch die Möglichkeit zur Vergabe

symbolischer Adressen (labels) die Pflege von Programmen erleichtert.

Trotz der Überlegenheit der Assemblersprachen gegenüber den Maschinensprachen

besitzt die Programmerstellung mittels Assembler eine Reihe bedeutender Nachteile.

Durch die direkte Zuordnung von Mnemonics zu Maschinenbefehlen ist der Abstraktionsgrad von Programmen gering, so daß sich die Programmierung immer noch an

der Maschine und nicht am konkreten Problem orientieren muß. Assemblerprogramme sind aufgrund ihres Mangels an Strukturelementen nur schwer verständlich, was

eine erschwerte Wartbarkeit von Programmen zur Folge hat. Durch den Mangel an

Datenstrukturen ist die Handhabung der Daten eines Programms aufwendig. Außerdem sind Assemblerprogramme nur auf einem Maschinentyp einsetzbar, so daß

Portierungen von Programmen auf andere Maschinentypen mit anderer Maschinensprache i. allg. nicht möglich sind.

Um die Nachteile der Assemblersprachen zu vermeiden und um eine problembezogene Programmierung zu unterstützen, wurden die höheren Programmiersprachen eingeführt. Diese Sprachen abstrahieren von den Eigenschaften der verwendeten Rechner. Kontrollstrukturen wie z.B. Schleifen und Rekursion erlauben eine Steuerung

1

2

Mnemonik ist die Kunst, das Gedächtnis durch Hilfsmittel zu unterstützen.

1.3 Implementierung von Programmiersprachen

des Programmflusses ohne die Verwendung von Sprungbefehlen. Das Konzept der

Variablen und der Datentypen entlastet den Programmierer von der aufwendigen

Speicherverwaltung. Durch den Abstraktionsgrad wird zudem die Portierung von

Programmen auf andere Rechnerarchitekturen erleichtert.

1.3 Implementierung von Programmiersprachen

Um Programme einer höheren Programmiersprache auf einem Rechner ausführen zu

können, muß diese Sprache auf diesem Rechner verfügbar gemacht (implementiert)

werden. Die dazu existierenden Konzepte werden in zwei Klassen eingeteilt.

1.3.1 Interpreter

Ein Interpreter IL zur einer Programmiersprache L ist ein Programm, das als Eingabe

ein Programm pL der Sprache L und eine Eingabefolge e erhält und eine Ausgabefolge

a errechnet. Da bei der Interpretation von pL auch Fehler auftreten können, läßt sich

die Funktionalität des Interpreters darstellen als

IL : L × D∗ → D∗ ∪ {error},

wenn sowohl Eingabe- wie auch Ausgabedaten aus einem gemeinsamen Bereich D

stammen. Die Ausführung des Programms pL mit Eingabefolge e und Ausgabefolge

a ist durch die Gleichung

IL (pL , e) = a

beschrieben.

Die Arbeitsweise eines Interpreters ist gekennzeichnet durch eine gleichzeitige Bearbeitung des Programms pL und der Eingabe e. Dies führt dazu, daß der Interpreter

bei jeder, also auch bei wiederholter, Ausführung eines Programmkonstrukts zuvor

das Konstrukt analysieren muß. Daher kann der Interpreter auch keine globalen Informationen, etwa zur Optimierung der Speicherverwaltung, über pL verwenden.

1.3.2 Compiler

Um die aus der lokalen Sicht eines Interpreters auf das auszuführende Programm resultierenden Ineffizienzen zu vermeiden, werden beim Compiler die Verarbeitung des

Programms und der Eingabe nacheinander durchgeführt. Zuerst wird das Programm

pL ohne die Berücksichtigung von Eingabedaten analysiert und in eine andere Form

überführt. Diese erlaubt die effizientere Ausführung des Programms mit beliebigen

Eingabefolgen, ohne daß die Analyse und die Überführung des Programms wiederholt

werden müssen.

3

1 Einführung

Wir nennen unsere zu übersetzende Sprache L im folgenden Quellsprache. Die Übersetzung besteht in der Überführung eines Programms pL der Quellsprache in ein

Programm pM , wobei M die Maschinen- oder die Assemblersprache eines konkreten oder abstrakten Rechners ist. Wir nennen pM Zielprogramm und folglich M die

Zielsprache des Übersetzers.

Nach der Übersetzung wird das erzeugte Programm pM zur Laufzeit mit der Eingabefolge e ausgeführt. Dabei gehen wir davon aus, daß pM mit der Eingabe e die

Ausgabe a erzeugt, wenn ein Interpreter für L mit IL (pL , e) = a dieselbe Ausgabe

erzeugt. Wenn wir die Maschine, deren Maschinensprache unsere Zielsprache M ist,

als Interpreter IM für M auffassen, so muß gelten:

wenn IL (pL , e) = a, dann IM (pM , e) = a.

Neben der Generierung des Zielprogramms wird während der Übersetzung eines Programms eine umfassende Überprüfung auf Fehler des zu analysierenden Programmtextes vorgenommen. Durch diese globale Analyse können manche Fehler bereits vor

der Ausführung des Programms gefunden werden, während dies beim Interpreter aufgrund seiner lokalen Sicht auf den Programmtext erst zur Laufzeit geschehen kann.

Der Compiler erkennt nur Fehler eines Programmes, die von der konkreten Eingabe

während eines Programmlaufs unabhängig sind. Hierzu gehören neben syntaktischen

Fehlern auch semantische Fehler, z.B. Zugriffe auf nichtdeklarierte Variablen. Fehler,

die aus der Eingabe e resultieren, können auch beim Compiler erst zur Laufzeit des

Zielprogramms pM entdeckt werden.

1.3.3 Virtuelle Maschinen als Zielplattform

Bei der klassischen Implementierung einer Programmiersprache auf einer Zielplattform sind wir bisher sowohl bei der Verwendung eines Interpreters als auch eines

Compilers von der Maschinensprache des realen Rechners als Zielsprache ausgegangen.

Dieser Ansatz hat mehrere Nachteile:

• Der Compiler-Entwickler muss für eine Vielzahl unterschiedlicher Instruktionssätze von Prozessoren entsprechende Back-Ends (siehe unten) zur Verfügung

stellen.

• Der Compiler-Entwickler möchte für eine effiziente Code-Erzeugung auf Befehle zurückgreifen, die eventuell nicht im Instruktionssatz enthalten sind. Das

gilt insbesondere für die Umsetzung spezieller Konstrukte der Quellsprache,

beispielsweise zur Behandlung von Ausnahmen.

• Insbesondere möchte der Entwickler für die Übersetzung von Programmen entwickelte Ansätze trotz sich ändernder Instruktionssätze und Rechnerarchitekturen gleich bleibende Rahmenbedingungen vorfinden.

4

1.4 Umgebung eines Compilers

Aus diesen Gründen wird bei der Implementierung neuerer Programmiersprachen

zunehmend dazu übergegangen, den Instruktionssatz einer idealisierten abstrakten

oder virtuellen Maschine (VM) als Zielsprache des Compilers einzuführen. Die so

definierte zusätzliche Abstraktionsschicht auf der Zielplattform hat mehrere Vorteile:

• Die Implementierung der virtuellen Maschine für eine spezifische Plattform

kann unabhängig von der Entwicklung des Compilers vorgenommen werden,

solange beides mit Hinblick auf einen festen Instruktionssatz der VM erfolgt.

• Für die VM erzeugte Code ist auf jedem System lauffähig, auf dem die VM

implementiert ist (Portierbarkeit).

• Der Befehlssatz der VM kann passend zu Paradigmen und Konstrukten der

Quellsprache gewählt werden und erlaubt so eine effiziente Übersetzung der

Quellprogramme. Beispiel: Der Java Bytecode (JBC) als Instruktionssatz der

Java Virtual Machine (JVM) beinhaltet spezielle Befehle zum Umgang mit

Objekten, da die Quellsprache Java objektorientiert ist.

• Der durch den Compiler erzeugte Code wird nicht direkt auf dem Zielsystem

ausgeführt, sondern auf einer Zwischenschicht, wodurch eine sicherere Ausführung

gewährleistet werden kann (Sand-Boxing).

Somit kann der Einsatz einer virtuellen Maschine für die Implementierung einer Programmiersprache als Kombination beider zuvor vorgestellten Ansätze gesehen werden:

1. Die Übersetzung des Quellprogramms in ein Programm für die virtuelle Maschine erfolgt durch einen Compiler.

2. Die virtuelle Maschine ist ein Interpreter für das durch den Compiler erzeugte

Zielprogramm.

In zweiten Teil der Vorlesung werden wir uns ausführlich mit den Konzepten virtueller

Maschinen beschäftigen.

1.4 Umgebung eines Compilers

Zur Umgebung eines Compilers gehören i. allg. weitere Programme, die für die Übersetzung und die Ablauffähigkeit eines Programms benötigt werden (Abbildung 1.1

[ASU99]).

Am Beginn des Übersetzungsprozesses steht ein “rohes” Quellprogramm. Dieses

Quellprogramm enthält neben dem eigentlichen Programm zusätzliche Meta-Anweisungen, die beschreiben, wie das Quellprogramm vor der Übersetzung mit dem Compiler modifiziert werden soll. Dabei kann es sich z.B. um die Definition von Makros

(z.B. #def ine in C [KR90]), um die Generierung zusätzlicher Befehle zur Fehlersuche

oder um das Einfügen weiterer Quelltexte (z.B. \include in LATEX [Kop02]) handeln.

Diese Modifikationen des Quelltextes werden von einem sogenannten Präprozessor

5

1 Einführung

"rohes" Quellprogramm

Präprozessor

Quellprogramm

Compiler

Assemblerprogramm

Assembler

relokatibler Maschinencode

Lader / Binder

ausführbarer Maschinencode

Abbildung 1.1: Umgebung eines Compilers.

vorgenommen.

Nach der Behandlung des Quelltextes durch den Präprozessor kann der Compiler das

Zielprogramm erzeugen. Wie zuvor erwähnt, handelt es sich bei dem Zielprogramm

entweder um ein Maschinenspracheprogramm bzw. einen Assemblertext. Im zweiten

Fall muß der Assemblertext nun in einem zusätzlichen Schritt durch den Assembler

in Maschinencode übersetzt werden. Oft wird heutzutage vom Compiler statt des

Assemblertextes ein C-Programm erzeugt, welches vom C-Compiler weiterverarbeitet

wird.

Der vom Compiler erzeugte Maschinencode ist i. allg. noch nicht ausführbar, da es

sich um sogenannten relokatiblen Code handelt. In diesem Code sind die Sprungadressen noch nicht festgelegt, so daß der Code im Speicher frei verschiebbar ist.

Außerdem müssen die Bibliotheken des jeweiligen Übersetzers noch zum erzeugten

Maschinencode hinzugefügt werden. Diese Bibliotheken enthalten z.B. die Ein- und

Ausgaberoutinen der Programme (z.B. das Modul InOut in Modula-2 [Wir97]) sowie

weitere Routinen, die zur Laufzeit eines Programmes benötigt werden. Es gibt zwei

Verfahren zur Einbindung der Bibliotheken in ein Programm. Der Binder faßt den relokatiblen Maschinencode und den Code der Bibliotheken zu einem neuen Programm

zusammen und ersetzt dabei die abstrakten Programmadressen des relokatiblen Codes durch die statischen Adressen der Unterprogramme der Bibliotheken. Dieses erzeugte Programm ist ohne die Unterstützung weiterer Programme ausführbar. Der

6

1.5 Aufbau eines Compilers

Quellprogramm

lexikalische

Analyse

Analyse

syntaktische

Analyse

semantische

Analyse

Symboltabellenverwaltung

Fehlerbehandlung

Zwischencodeerzeugung

Codeoptimierung

Synthese

Codeerzeugung

Zielprogramm

Abbildung 1.2: Phasen eines Compilers.

Lader lädt hingegen den relokatiblen Code und den Code der benötigten Bibliotheken in den Hauptspeicher und ersetzt die abstrakten Adressen dort dynamisch. Aus

diesem Grund muß der Lader bei jedem Aufruf des Zielprogramms verwendet werden.

1.5 Aufbau eines Compilers

Die Aufgabe eines Compilers läßt sich zunächst in zwei grundlegende Teilaufgaben

zerlegen (Abbildung 1.2): die Analyse des Quellprogramms und die Synthese des

Zielprogramms. Beide Aufgaben werden in einer Reihe von Phasen bearbeitet.

1.5.1 Analyse

In den Analysephasen wird das Quellprogramm in seine Bestandteile zerlegt. Dabei

wird eine Überprüfung auf statische (also von der konkreten Eingabe eines Programmablaufs unabhängige) Korrektheit des zu analysierenden Programmtextes vorgenommen. Enthält das Programm erkennbare Fehler, werden entsprechende Fehler-

7

1 Einführung

meldungen an den Benutzer ausgegeben. Weiterhin wird eine Zwischendarstellung

des Programms erzeugt, die nur noch die für die Synthesephasen benötigten Informationen des Programmtextes enthält.

Im folgenden erläutern wir die Analysephasen aus Abbildung 1.2 [ASU99] an der

Übersetzung der Zuweisung

position := initial + rate ∗ 60.

Dabei nehmen wir an, daß die Variablen position, initial und rate als FließkommaVariablen deklariert sind.

Lexikalische Analyse (scanning): Die lexikalische Analyse dient der Zerlegung des

Zeichenstroms der Eingabe in Symbole. Die Zuweisung wird dabei in folgende Symbole zerlegt:

1. Bezeichner (position)

2. Zuweisungssymbol

3. Bezeichner (initial)

4. Additionssymbol

5. Bezeichner (rate)

6. Multiplikationssymbol

7. Konstante (60)

Wird als Symbol ein Bezeichner erkannt, wird dieser Bezeichner in die Symboltabelle des Compilers eingetragen. Jedem Bezeichner wird eine eindeutige Nummer

zugewiesen, in unserem Beispiel der Einfachheit halber gemäß der Reihenfolge des

Auftretens im Quellprogramm. An die nachfolgenden Phasen wird nicht mehr der

Bezeichner selbst, sondern die ihm zugeordnete Nummer weitergegeben (in Abbildung 1.3 [ASU99] ist während der lexikalischen Analyse position durch id1 ersetzt

worden, initial durch id2 und rate durch id3 ).

Das Teilprogramm, das die lexikalische Analyse des Quelltextes durchführt, wird

Scanner genannt.

Syntaktische Analyse (parsing): In der syntaktischen Analyse werden Gruppen

von Symbolen mit hierarchischer Struktur erkannt. Die Quellsprache wird durch die

Regeln einer kontextfreien Grammatik definiert. Anhand der Produktionen dieser

Grammatik wird die von der lexikalischen Analyse gelieferte Symbolfolge auf Korrektheit überprüft. Dabei wird ein sogenannter Strukturbaum (parse-tree) erzeugt,

der die Analyse des Programmtextes gemäß den Regeln der Grammatik darstellt.

Für die Analyse der Zuweisung nehmen wir die folgende kontextfreie Grammatik an

(kursiv gedruckte Wörter sind Nichtterminalsymbole):

8

1.5 Aufbau eines Compilers

position := initial + rate * 60

lexikalische Analyse

id1 := id2 + id3 ∗ 60

syntaktische Analyse

id1

:= a

aa

+

PPPP

id2

!* XXX

!!

60

id3

semantische Analyse

id1

:=

id2

XXX

+

XXXX

* aa

aa

id3

inttoreal

60

Zwischencode-Erzeugung

temp1 := inttoreal(60)

temp2 := id3 * temp1

temp3 := id2 + temp2

id1

1

2

3

Symboltabelle

position

...

initial

...

rate

...

:= temp3

Code-Optimierung

temp1 := id3 * 60.0

id1

:= id2 + temp1

Code-Generierung

MOVF id3, R2

MULF #60.0, R2

MOVF id2, R1

ADDF R2, R1

MOVF R1, id1

Abbildung 1.3: Übersetzung einer Zuweisung.

9

1 Einführung

Zuweisung

``

""L ``````

"

``

"

L

Bezeichner

Ausdruck

:=

``

T `````

`

T

position

Ausdruck

Ausdruck

+

XXXX

XX

AA

Bezeichner

initial

Ausdruck

Bezeichner

*

Ausdruck

Zahl

rate

60

Abbildung 1.4: Parse-Baum der Zuweisung.

Zuweisung →

Ausdruck →

Bezeichner := Ausdruck

Bezeichner | Zahl |

Ausdruck + Ausdruck |

Ausdruck * Ausdruck

Der Strukturbaum der Zuweisungsanweisung gemäß dieser Grammatik ist in Abbildung 1.4 dargestellt.

Der Strukturbaum enthält neben den Terminalsymbolen der Eingabe auch die Nichtterminalsymbole der Grammatik, die bei der Ableitung der Eingabe verwendet wurden. Diese Nichtterminalsymbole werden in den weiteren Phasen des Compilers nicht

mehr benötigt. Daher wird als Endprodukt der syntaktischen Analyse ein Syntaxbaum

erzeugt, wie er in Abbildung 1.3 dargestellt ist2 .

Das Teilprogramm zur syntaktischen Analyse heißt Parser.

Semantische Analyse: Nach der Überprüfung auf syntaktische Korrektheit des

Programms wird in der semantischen Analyse die “statische” Semantik des Quellprogramms analysiert. “Statisch” bedeutet in diesem Zusammenhang, daß die semantischen Merkmale untersucht werden, die nicht von den Eingabedaten abhängig

und daher für alle dynamischen Ausführungen gleich sind. Zur semantischen Analyse

gehören die Überprüfung auf korrekte Typisierung, die Einhaltung von Gültigkeitsbereichen und eventuelle Typanpassungen. Während der semantischen Analyse werden

die Bezeichner in der Symboltabelle mit Attributen versehen. Hierzu gehören z.B. der

Variablentyp und der Gültigkeitsbereich der Variablen.

Im Beispiel in Abbildung 1.3 hatten wir angenommen, daß die drei Bezeichner Varia2

Im Gegensatz zu unserer Terminologie werden die Begriffe Syntaxbaum und Strukturbaum in

[WM96] synonym verwendet.

10

1.5 Aufbau eines Compilers

blen vom Typ REAL darstellen. Bei der Typüberprüfung des Programms wird in der

semantischen Analyse festgestellt, daß die ganze Zahl 60 mit dem Inhalt einer REALVariablen multipliziert werden soll. Daher wird in den Syntaxbaum die Information

eingefügt, daß vor der Multiplikation eine Typumwandlung der Zahl vorgenommen

werden muß.

1.5.2 Synthese

In den Synthesephasen wird das zum Quellprogramm gehörende Zielprogramm erzeugt. Dabei werden die Informationen, die in den Analysephasen über den Programmtext gesammelt wurden, verwendet.

Zwischencode-Erzeugung: Vor der Erzeugung des eigentlichen Zielprogramms wird

oft eine Zwischendarstellung des Programms generiert, die einerseits bereits maschinennah, andererseits noch an keiner konkreten Zielmaschine orientiert ist. Diese Zwischensprache wird Zwischencode genannt.

In Abbildung 1.3 wird als Zwischencode ein Drei-Adreß-Code erzeugt. Jeder Befehl

dieses Codes darf maximal drei Adressen verwenden. Zwei Adressen geben an, wo

sich die Operanden des Befehls befinden. Die dritte Adresse bezeichnet den Speicherplatz, an dem das Ergebnis des Befehls abgelegt werden soll. Die Speicherzellen an

den Adressen id1, id2 und id3 enthalten die Werte der zugehörigen Variablen. Die

Adressen temp1, temp2 und temp3 bezeichnen temporäre Speicherplätze für Zwischenergebnisse.

Code-Optimierung: Die Verwendung eines maschinenunabhängigen Zwischencodes

bietet den Vorteil, daß auf dem erzeugten Zwischencode eine ebenfalls maschinenunabhängige Code-Optimierung vorgenommen werden kann. Bei dieser Optimierung

wird der Zwischencode auf Redundanzen hin untersucht und in bezug auf Laufzeit

und Speicherplatzverbrauch verbessert.

Im Beispiel wird in der Code-Optimierung erkannt, daß statt der Umwandlung einer

ganzen Zahl in eine REAL-Zahl gleich die entsprechende Fließkommakonstante im

Code verwendet werden kann. Hierdurch entfallen ein temporärer Speicherplatz und

eine Konvertierungs-Operation. Außerdem kann das Ergebnis des Additionsbefehls

direkt in id1 gespeichert werden, so daß die letzte Zuweisung entfällt.

Code-Generierung: In dieser letzten Compilerphase wird das Zielprogramm für

die Zielmaschine erzeugt. Dabei wird jeder Befehl des optimierten Zwischencodes in

eine kurze Sequenz von Maschinenbefehlen übersetzt. Nach Möglichkeit werden die

Speicherplätze des Zwischencodes durch Register der konkreten Maschine ersetzt, um

zeitaufwendige Zugriffe auf den Hauptspeicher zu vermeiden.

11

1 Einführung

Eventuell schließt sich an die Phase der Code-Generierung noch eine maschinenabhängige Code-Optimierung an, die Ineffizienzen im erzeugten Maschinencode beseitigt (z.B. überflüssige Kopierbefehle entfernt oder einzelne Maschinenbefehle durch

effizientere Befehle mit derselben Wirkung ersetzt).

1.5.3 Front-End, Back-End

Bei der Einteilung des Compilers in Phasen werden häufig die Begriffe Front-End

und Back-End verwendet. Das Front-End eines Compilers umfaßt alle zielsprachenunabhängigen Compilerphasen, das Back-End entsprechend alle quellsprachenunabhängigen Phasen des Compilers.

Für die Portierung eines Compilers auf eine andere Zielsprache kann i. allg. das FrontEnd unverändert weiterverwendet werden, so daß nur das entsprechende Back-End

neu implementiert werden muß. Im umgekehrten Fall kann die Verbindung mehrerer

Front-Ends mit einem gemeinsamen Back-End sinnvoll sein, um innerhalb eines Programms Teilprogramme in einer jeweils für das Teilproblem optimalen Programmiersprache zu schreiben und aus diesen Teilprogrammen ein gemeinsames Zielprogramm

zu erzeugen.

1.5.4 Läufe

Es ist üblich, mehrere Übersetzungsphasen in einem einzelnen Lauf (pass) zu implementieren. Ein Lauf steht dabei für einen Durchlauf durch eine Darstellung des

Programms. Dabei kann es sich sowohl um den Quelltext als auch um eine interne Darstellung des Programms wie z.B. den Syntaxbaum handeln. Dabei bietet es

sich an, Phasen, deren Arbeitsschritte eng miteinander verzahnt sind, in einem Lauf

zusammenzufassen. Eine Möglichkeit wäre zum Beispiel die Integration von lexikalischer und syntaktischer Analyse in einem Lauf sowie der semantischen Analyse und

der Codegenerierung in einem zweiten Lauf.

Einen Extremfall stellt der Ein-Pass-Compiler dar, der die Analyse des Quellprogramms und die Synthese des Zielprogramms während eines einzigen Durchlaufs

durch den Programmtext durchführt. In diesem Fall muß gewährleistet sein, daß

jeder Bezeichner vor seiner Verwendung deklariert wurde, da nachträgliche Änderungen am Zielprogramm nicht mehr möglich sind. Aus diesem Grund ist in vielen

Compilern für die Sprache Pascal [JW91] die Vordeklaration von Bezeichnern mit

der forward-Anweisung vorgesehen.

Andere Programmiersprachen wie z.B. Algol-68 [OT97] erlauben die Verwendung von

Bezeichnern vor ihrer Deklaration, so daß für diese Sprachen die Implementierung

mittels eines Ein-Pass-Compilers nicht möglich ist.

Bei der Implementierung einer Sprache mittels einer virtuellen Maschine gilt: Der

12

1.5 Aufbau eines Compilers

vom Compiler erzeugte Code ähnelt dem idealisierten Zwischencode, der durch die

virtuelle Maschine interpretiert wird, also auf Instruktionen der realen Hardware

zum Zeit der Ausführung abgebildet wird. Somit kann die virtuelle Maschine auch

als Middle-End bezeichnet werden. Das bedeutet in der Regel aber nicht, dass bei

dieser Variante die Phase der Zwischencode-Erzeugung entfällt. Vielmehr existiert im

Allgemeinen eine weitere Zwischendarstellung des Programms zwischen semantischer

Analyse und dem Code für die virtuelle Maschine, auf deren Grundlage Optimierungen unabhängig von der VM durchgeführt werden können.

13

2 Lexikalische Analyse

Die lexikalische Analyse arbeitet als erste Phase des Compilers direkt mit dem zu

übersetzenden Programmtext (siehe Abbildung 2.1).

Der Programmteil zur Durchführung der lexikalischen Analyse wird Scanner genannt. Der Scanner erfüllt die folgenden Aufgaben:

• Das Quellprogramm wird zeichenweise gelesen und dabei in Symbole zerlegt.

Bei dieser Zerlegung werden Leerzeichen, Kommentare, Zeilenenden etc. entfernt, so daß sie in den weiteren Compilerphasen nicht mehr beachtet werden

müssen.

• Die Bezeichner des Programms werden in der Reihenfolge ihres Auftretens im

Quelltext mit erläuternden Informationen in die Symboltabelle eingefügt.

• Für die eventuelle Ausgabe von Fehlermeldungen werden Informationen gesammelt (z.B. Zeilennummern).

Ein wichtiger Gesichtspunkt bei der Realisierung eines Scanners ist Effizienz, da die

nachfolgenden Phasen des Compilers direkt vom Scanner abhängig sind und deren

Laufzeit daher durch einen langsamen Scanner negativ beeinflußt wird. Meist wird

der Scanner als Unterprogramm des Parsers realisiert (eventuell als Coroutine). Der

Scanner liefert jeweils nach Aufforderung durch den Parser ein Symbol.

2.1 Terminologie

In diesem Abschnitt führen wir die Begriffe Symbol, Muster und Lexem ein.

Symbol

Quellprogramm

Scanner

Parser

nächstes Symbol

anfordern

Symboltabelle

Abbildung 2.1: Interaktion zwischen Scanner und Parser.

2.2 Reguläre Sprachen und endliche Automaten

Symbole sind die vom Scanner an den Parser zu liefernden Grundeinheiten der Programmiersprache. Mengen von gleichartigen Symbolen nennen wir Symbolklassen.

Typische Symbolklassen sind die Menge der Integer-Konstanten und die Menge der

Zeichenketten.

Muster beschreiben die möglichen Auftreten eines Symbols im Quellprogramm. Die

Zeichenfolgen im Programmtext, die Symbolen entsprechen, nennen wir Lexeme.

Beispiele für Symbole und die zugehörigen Muster und Lexeme sind in Tabelle 2.1

angeführt.

Symbol

if

id

Musterbeschreibung

if

Buchstabe, gefolgt von

Buchstaben oder Ziffern

mögliche Lexeme

if

pi, D2

Tabelle 2.1: Beispiele für Symbole, Muster und Lexeme.

2.2 Reguläre Sprachen und endliche Automaten

Grundlage für die lexikalische Analyse ist die Theorie der regulären Sprachen.

Wir wiederholen zunächst einige wichtige Grundbegriffe der formalen Sprachen.

Ein Alphabet Σ ist eine endliche Menge von Zeichen; z.B. {0, 1},

{0, ..., 9, A, ..., Z} oder der ASCII-Zeichensatz.

Ein Wort über einem Alphabet Σ ist eine endliche Folge von Zeichen aus dem Alphabet; z.B. 01001, A195, [email protected]. Das leere Wort bezeichnen wir mit

ε. Die Menge aller Wörter über einem Alphabet Σ bezeichnen wir mit Σ∗ .

Eine Sprache über einem Alphabet ist eine Menge von Wörtern über dem Alphabet,

z.B. ∅, {ε}, {A, B, C, AB, AC, ABC} sowie die Menge aller syntaktisch wohlgeformten Modula 2-Programme.

Seien v und w Wörter über dem Alphabet Σ. Die Konkatenation von v und w,

geschrieben vw, ist dasjenige Wort, das durch das Anhängen von w an v ensteht. Für

v = compiler und w = bau ergibt sich als Konkatenation vw das Wort compilerbau.

Es gilt εw = wε = w für beliebige Wörter w.

Die Exponentiation von Wörtern ist wie folgt definiert:

• w0 = ε

• wi = wi−1 w für i > 0. Es gilt w1 = w.

Operationen auf Sprachen: Seien L, M Sprachen. Dann sind die folgenden Operationen definiert:

15

2 Lexikalische Analyse

Vereinigung:

Konkatenation:

Exponentiation:

Kleene-Abschluß:

Positiver Abschluß:

L∪M

LM

L0

Li

L∗

L+

:=

:=

:=

:=

:=

:=

{w | w ∈ L ∨ w ∈ M }

{vw | v ∈ L ∧ w ∈ M }

{ε},

Li−1 L für i > 0

S

∞

i

i=0 L

S∞

i

i=1 L

Beispiel 1

Seien L = {A, B, ..., Z, a, b, ..., z} und D = {0, 1, ..., 9} Sprachen mit Wörtern der

Länge 1. Dann ist

L∪D

die Sprache der Buchstaben und Ziffern,

LD

die Sprache, die lauter Wörter der Form Buchstabe Ziffer

enthält,

4

L

die Sprache aller Wörter mit genau vier Buchstaben über L,

L∗

die Sprache aller beliebig langen Wörter aus Buchstaben

(inkl. ε),

L((L ∪ D)∗ ) die Sprache aller Wörter aus Buchstaben und Ziffern,

die mit einem Buchstaben beginnen,

+

D

die Sprache aller nicht-leeren Wörter aus Ziffern.

2.2.1 Reguläre Sprachen

Sei Σ Alphabet.

Definition 1

Die regulären Sprachen über Σ sind induktiv definiert durch

• ∅ ist reguläre Sprache,

• für alle a ∈ Σ ist {a} reguläre Sprache,

• falls L1 , L2 reguläre Sprachen, so sind auch L1 ∪ L2 , L1 L2 und L∗1 reguläre

Sprachen.

Nichts sonst ist eine reguläre Sprache über Σ.

Bemerkung: {ε} wird durch den ∗ -Operator aus ∅ gewonnen. Also ist {ε} regulär.

2.2.2 Reguläre Ausdrücke

Reguläre Ausdrücke sind spezielle Formeln, mit denen reguläre Sprachen definiert

werden.

Definition 2

Die Menge der regulären Ausdrücke über Σ, reg(Σ), ist induktiv definiert durch

16

2.2 Reguläre Sprachen und endliche Automaten

•

•

•

•

∅ ∈ reg(Σ),

ε ∈ reg(Σ),

für jedes a ∈ Σ ist a ∈ reg(Σ),

falls r1 , r2 ∈ reg(Σ), dann (r1 |r2 ) ∈ reg(Σ), (r1 r2 ) ∈ reg(Σ) und (r1 )∗ ∈

reg(Σ).

Bemerkung: Die Zeichen (, ), |,∗ in regulären Ausdrücken sind Metazeichen. Sie sind

keine Elemente des Alphabets Σ, sondern dienen als Operatoren zur Bildung der

regulären Ausdrücke. Die Metazeichen müssen von den Zeichen des Alphabets zu

unterscheiden sein, damit die von dem regulären Ausdruck beschriebene Sprache

eindeutig zu bestimmen ist. Sind die Metazeichen im Alphabet Σ enthalten, wird

die hieraus resultierende Doppeldeutigkeit durch eine spezielle Kennzeichnung der

Metazeichen vermieden (siehe Beispiel 2).

Die Sprache, die von einem regulären Ausdruck definiert wird, wird in der folgenden

Definition eingeführt.

Definition 3

Sei r regulärer Ausdruck. Die Sprache L(r) ist induktiv definiert durch

• L(∅) = ∅

• L(ε) = {ε}

• L(a) = {a}

• L(( r1 | r2 )) = L(r1 ) ∪ L(r2 ),

L((r1 r2 )) = L(r1 )L(r2 ),

L((r1 )∗ ) = (L(r1 ))∗

Bemerkung: Es gilt: r ∈ reg(Σ) ⇔ L(r) ist reguläre Sprache.

Wir verdeutlichen die regulären Ausdrücke anhand von Beispielen.

Beispiel 2

• a | b beschreibt {a} ∪ {b} = {a, b}

• (a b)∗ beschreibt ({a}{b})∗ = {ab}∗ = {ε, ab, abab, ...}

• (A|...|Z|a|...|z) beschreibt {A, ..., Z, a, ..., z}

• Sei Σ = {(, )}. Die Zeichen des Alphabets sind in den Metazeichen regulärer

Ausdrücke enthalten. Daher kennzeichen wir die Metazeichen durch Unterstreichung. Damit beschreibt ( ( )∗ ) die Sprache, deren Wörter mit beliebig vielen

öffnenden Klammern beginnen und mit einer schließenden Klammer enden:

{), (), ((), (((), ...}

17

2 Lexikalische Analyse

Konventionen: Um bei der Angabe regulärer Ausdrücke Klammern zu sparen und

Mehrdeutigkeiten zu vermeiden, ordnen wir den Operatoren dieser Ausdrücke Prioritäten zu.

• • hat die höchste Priorität, so daß a|b∗ und (a|b)∗ unterschiedliche Sprachen

beschreiben. Zudem ist der ∗-Operator linksassoziativ, d.h. a∗∗ = (a∗ )∗ .

• Die Konkatenation besitzt die zweithöchste Priorität und ist ebenfalls linksassoziativ.

• | hat die niedrigste Priorität ( (a|b)∗ c vs. a|b∗ c ) und ist ebenfalls linksassoziativ.

Bemerkung: Unterschiedliche reguläre Ausdrücke können dieselbe Sprache beschreiben. So ist L((a|b)(a|b)) = {aa, ab, ba, bb} = L(aa|ab|ba|bb).

Algebraische Eigenschaften: Für die Operatoren | und Konkatenation gelten die

folgenden algebraischen Eigenschaften, wobei wir reguläre Ausdrücke genau dann

gleichsetzen, wenn sie dieselbe Sprache beschreiben (r = s bedeutet L(r) = L(s)):

• r|s = s|r

(Kommutativität von |)

• r|(s|t) = (r|s)|t (Assoziativität von |)

• r(st) = (rs)t

(Assoziativität der Konkatenation)

2.2.3 Endliche Automaten

Nach der Einführung der regulären Sprachen und der regulären Ausdrücke in den

vorigen Abschnitten geben wir nun einen Mechanismus zur Erkennung von Wörtern

regulärer Sprachen an. Hierzu verwenden wir die endlichen Automaten.

Definition 4

Ein nichtdeterministischer endlicher Automat (NEA) ist ein Tupel M = (Σ, Q, ∆, q0 , F ),

wobei

• Σ endliches Alphabet (das Eingabealphabet),

• Q endliche Menge (von Zuständen),

• q0 ∈ Q (der Anfangszustand),

• F ⊆ Q (die Menge der Endzustände) und

• ∆ ⊆ Q × (Σ ∪ {ε}) × Q (die Übergangsrelation) ist.

Definition 5

Sei M = (Σ, Q, ∆, q0 , F ) ein NEA.

Ein Paar (q, w), q ∈ Q, w ∈ Σ∗ heißt Konfiguration von M , (q0 , w) heißt Anfangskonfiguration, (qf , ε) mit qf ∈ F Endkonfiguration.

Die Schritt-Relation ist eine binäre Relation ⊢M ⊆ (Q × Σ∗ ) × (Q × Σ∗ ), definiert

durch

18

2.2 Reguläre Sprachen und endliche Automaten

(q, aw) ⊢M (q ′ , w) :⇔ (q, a, q ′ ) ∈ ∆ für q, q ′ ∈ Q und a ∈ Σ oder a = ε.

⊢∗M sei die reflexive transitive Hülle von ⊢M .

Die von M akzeptierte Sprache ist L(M ) = {w ∈ Σ∗ | (q0 , w) ⊢∗M (qf , ε),

qf ∈ F }.

Ein endlicher Automat soll ein Eingabewort daraufhin überprüfen, ob es zu einer

bestimmten Sprache gehört. Dabei wird die Eingabe von links nach rechts zeichenweise gelesen. Zu Beginn befindet sich der Automat im Anfangszustand q0 und der

Eingabezeiger zeigt auf das erste Zeichen des Eingabewortes. Nach dem Lesen eines

Zeichens wird das entsprechende Zeichen aus der Eingabe entfernt und der Automat

geht in Abhängigkeit vom gelesenen Zeichen mittels der Übergangsrelation in einen

neuen Zustand über. Weiterhin ist der Übergang in einen anderen Zustand ohne das

Lesen eines Eingabezeichens möglich (ε-Übergang). Ein Übergang eines Automaten

in einen anderen Zustand wird Schritt genannt. Ist die Eingabe vollständig gelesen und der Automat befindet sich in einem Endzustand, wird das gelesene Wort

akzeptiert. Befindet sich der Automat nach dem vollständigen Lesen der Eingabe

nicht in einem Endzustand oder ist in einem Zustand kein Übergang für das nächste

Eingabezeichen möglich, wird das Eingabewort verworfen.

Das Verhalten eines NEA wird also in jedem Schritt durch den aktuellen Zustand

des Automaten und die restliche Eingabe bestimmt. Diese beiden Faktoren bilden

zusammen die aktuelle Konfiguration des endlichen Automaten. Die Übergänge

zwischen Konfigurationen werden durch die Schritt-Relation beschrieben.

Der Automat erkennt die Worte, für die er durch eine Folge von Schritten aus der Anfangskonfiguration eine Endkonfiguration erreichen kann. Die Menge der von einem

NEA erkannten Worte bildet die von ihm akzeptierte Sprache.

Graphische Darstellung: Zur Verbesserung der Übersichtlichkeit werden NEAs

durch Übergangsgraphen dargestellt. Die Knoten des Graphen repräsentieren die

Zustände des Automaten. Die Kanten stellen die Zustandsübergänge des Automaten

dar und sind mit dem Zeichen beschriftet, das während des Übergangs gelesen wurde

(bzw. mit ε, falls kein Zeichen gelesen wurde).

Beispiel 3

Der Übergangsgraph in Abbildung 2.2 stellt einen NEA dar, der die Sprache L((a|b)∗ abb) =

{abb, aabb, babb, aaabb, ababb, ...} akzeptiert.

Ein NEA akzeptiert ein Eingabewort w genau dann, wenn es im Übergangsgraphen

einen Pfad vom Startzustand in einen Endzustand gibt, so daß die gelesenen Eingabesymbole die Kanten des Pfades beschriften.

Die Übergangsrelation ∆ eines NEA kann in Form einer Tabelle dargestellt werden.

Die Tabelle 2.2 enthält die Übergangsrelation des in Abbildung 2.2 dargestellten

Automaten.

19

2 Lexikalische Analyse

a

0

a

1

b

2

b

3

b

Abbildung 2.2: Beispiel eines Übergangsgraphen.

Zustand / Eingabe

0

1

2

3

a

{0, 1}

-

b

{0}

{2}

{3}

-

ε

-

Tabelle 2.2: Übergangsrelation ∆ in Tabellenform.

Satz 1

Zu jedem regulären Ausdruck r gibt es einen nichtdeterministischen endlichen Automaten, der die von r beschriebene reguläre Sprache akzeptiert.

Beweis

Wir führen den Beweis konstruktiv durch, indem wir für jeden regulären Ausdruck

eine Überführung in entsprechende “Automaten” angeben, wobei Kanten zunächst

mit regulären Ausdrücken beschriftet sein dürfen. Handelt es sich bei dem Ausdruck r

um ∅, der die leere Sprache beschreibt, besteht der Automat aus nur einem Zustand,

der zugleich Endzustand ist, und enthält keine Übergänge. Andernfalls beginnen wir

mit einem Graphen für den regulären Ausdruck r, wie er in in Abbildung 2.3 oben

angegeben ist. Die Überführungsschritte für die einzelnen Operatoren sind in Abbildung 2.3 aufgeführt. r, r1 , r2 sind reguläre Ausdrücke. (A) beschreibt die Behandlung

der Alternative, (K) der Konkatenation, (S) des Stern-Operators und (KL) die Behandlung von Klammern.

Beispiel 4

In Abbildung 2.4 wird schrittweise der Automat für den regulären Ausdruck a(a|0)∗

konstruiert. Neben den einzelnen Konstruktionsschritten ist die Regel aus Abbildung

2.3 angegeben, die in diesem Schritt verwendet wurde.

20

2.2 Reguläre Sprachen und endliche Automaten

q

n

pn

r

r1 |r2

qn

r1

n

p

qn

n

p

(A)

r2

r1 r2

n

q

n

p

n r1

q

n r2

q1

n

p

(K)

ε

n r

q

n

p

∗

nε

q

n

q1

nε

q2

pn

(S)

r

ε

n

q

(r)

n

p

r

qn

pn

(KL)

Abbildung 2.3: Konstruktion eines NEA zu einem regulärem Ausdruck.

a(a|0)∗

0m

1m

0m

a

2m

0m

a

ε

2m

(a|0)∗

1m

(a|0)

m

3

mε

4

ε

(K)

1m

(S)

ε

a

0m

a

ε

2m

m0

3

ε

mε

4

1m

(KL),(A)

ε

Abbildung 2.4: Beispiel einer NEA-Konstruktion.

21

2 Lexikalische Analyse

Da es sich bei dem mit dem Verfahren erzeugten Automaten um einen nichtdeterministischen endlichen Automaten handelt, ist eine direkte Umsetzung des Automaten

in ein Programm aufgrund des Nichtdeterminismus nicht ohne weiteres möglich.

Aus der Theorie der formalen Sprachen ist bekannt, daß es zu jedem NEA einen

deterministischen endlichen Automaten (DEA) gibt, der dieselbe Sprache erkennt.

Definition 6

Sei M = (Q, Σ, ∆, q0 , F ) ein NEA. M heißt deterministischer endlicher Automat

(DEA), wenn ∆ eine Funktion σ : Q × Σ → Q ist.

In einem DEA treten keine ε-Übergänge auf. Weiterhin gibt es für jeden Zustand

unter jeder Eingabe höchstens einen Folgezustand.

Satz 2

Wird eine Sprache L von einem NEA akzeptiert, so gibt es einen DEA, der L akzeptiert.

Beweis

Der Beweis wird konstruktiv geführt, indem wir ein Verfahren angeben, das zu einem NEA einen DEA generiert, der dieselbe Sprache erkennt. Dieses Verfahren wird

Potenzmengenkonstruktion genannt.

Die Potenzmengenkonstruktion verwendet die beiden folgenden Definitionen:

Definition 7

Sei M = (Q, Σ, ∆, q0 , F ) ein NEA und sei q ∈ Q. Die Menge der ε-Folgezustände

von q ist

ε − F Z(q) = {p | (q, ε) ⊢∗M (p, ε)},

also die Menge aller Zustände p, inklusive q, für die es einen ε-Weg im Übergangsgraphen zu M von q nach p gibt. Wir erweitern ε − F Z auf Mengen von Zuständen

S ⊆ Q:

[

ε − F Z(S) =

ε − F Z(q).

q∈S

Definition 8

Sei M = (Q, Σ, ∆, q0 , F ) ein NEA.

Der zu M gehörende DEA M ′ = (Q′ , Σ, δ, q0′ , F ′ ) ist definiert durch:

Q′ = P(Q), die Potenzmenge von Q,

q0′ = ε − F Z(q0 ),

F ′ = {S ∈ Q′ | S ∩ F 6= ∅} und

δ(S, a) = ε − F Z({p | (q, a, p) ∈ ∆ für q ∈ S}) für a ∈ Σ, S ∈ Q′ .

22

2.2 Reguläre Sprachen und endliche Automaten

Der folgende Algorithmus konstruiert zu einem NEA M den zu M gehörenden DEA

M ′ , wobei nicht erreichbare Zustände weggelassen werden.

Algorithmus NEA nach DEA

Eingabe: NEA M = (Q, Σ, ∆, q0 , F )

Ausgabe: DEA M ′ = (Q′ , Σ, δ, q0′ , F ′ )

1

2

3

4

5

6

7

8

9

10

11

12

13

q0′ := ε − F Z(q0 ); Q′ := {q0′ };\\

marked(q0′ ) := f alse; δ := ∅;\\

while e x i s t i e r t S ǫ Q′ and marked(S) = f alse do

marked(S) := true;

foreach a ǫ Σ do

T := ε − F Z({p ǫ Q | (q, a, p) ǫ ∆ und q ǫ S})

if T ∈

/ Q′ then

Q′ := Q′ ∪ {T } ; (∗ n eu er Zustand ∗)

marked(T ) := f alse

f i ;\\

δ := δ ∪ {(S, a) 7→ T } (∗ n eu er ” Ubergang ∗)

od

od

Die Zustände von M ′ sind Mengen von Zuständen von M (daher der Name Potenzmengenkonstruktion). Zwei Zustände p und q von M fallen in dieselbe Zustandsmenge

S (also in denselben Zustand von M ′ ), wenn es ein Wort w gibt, welches den NEA M

sowohl nach p als auch nach q bringt. Nach Definition 8 erhält man den Folgezustand

eines Zustands S in M ′ unter einem Zeichen a, indem man die Nachfolgezustände

aller Zustände q ∈ S unter a zusammenfaßt und deren ε-Folgezustände hinzufügt.

Wir verdeutlichen die Arbeitsweise der Potenzmengenkonstruktion, indem wir für den

in Abbildung 2.4 erzeugten NEA einen DEA generieren, der ebenfalls die durch den

regulären Ausdruck a(a|0)∗ beschriebene Sprache erkennt. In Abbildung 2.5 [WM96]

sind die einzelnen Schritte des Verfahrens dargestellt. Die Zustände des zu konstruierenden DEA sind mit 0′ , 1′ , 2′ und ⊘ benannt, wobei 0′ der Anfangszustand ist. ⊘ ist

ein “Fehlerzustand”, der als Folgezustand eines Zustands q unter a verwendet wird,

wenn es keinen Übergang im NEA unter a aus q heraus gibt. Sind für einen Zustand

des DEA für alle möglichen Zeichen aus Σ die entsprechenden Nachfolgezustände des

DEA berechnet, wird der Zustand markiert (in Abbildung 2.5 durch Unterstreichung

dargestellt) und braucht nicht weiter behandelt zu werden. Endzustände des DEA

sind die Zustände, in deren Menge von Zuständen des NEA ein Endzustand auftritt

(1′ und 2′ sind Endzustände, da sie den NEA-Endzustand 1 beinhalten).

23

2 Lexikalische Analyse

0′ = {0}; Q′ = {0′ }

ausgewählter Zustand neues Q′

0′

{0′ , 1′ , ⊘} mit

1′ = {1, 2, 3}

neuer (Teil-) DEA

a

1′

0′ H

HH 0 H⊘

a

1′

{0′ , 1′ , 2′ , ⊘} mit 0′

c

2′ = {1, 3, 4}

c

0

c

0

c

1′

0′

@

@

0

0 @

@

a

1′

⊘

a

a

2′

{0′ , 1′ , 2′ , ⊘}

a

⊘

{0′ , 1′ , 2′ , ⊘}

⊘

a

′

1

′

0

@

0

@

0 @

@

⊘

a

′

2

a

′

2

0

a

′

2

0

0

Abbildung 2.5: Beispiel zur Potenzmengenkonstruktion.

24

2.2 Reguläre Sprachen und endliche Automaten

Da der durch das Verfahren erzeugte DEA i. allg. nicht der “kleinstmögliche” Automat ist, wird im Anschluß an die Potenzmengenkonstruktion ein weiteres Verfahren,

genannt Minimalisierung, durchgeführt, das zu dem erzeugten DEA einen weiteren

DEA konstruiert, der dieselbe Sprache akzeptiert und über eine minimale Zustandsmenge verfügt. In dem durch die Potenzmengenkonstruktion erzeugten DEA kann

es noch Zustände mit gleichem “Akzeptanzverhalten” geben. Zwei Zustände p und q

besitzen das gleiche Akzeptanzverhalten, wenn der Automat aus p und q unter allen

Eingabewörtern entweder immer oder nie in einen Endzustand geht. Die Minimalisierung beruht auf dem Zusammenfassen dieser Zustände zu einem gemeinsamen

Zustand.

Der folgende Algorithmus beschreibt das Verfahren der Minimalisierung.

Algorithmus Minimalisierung.

Eingabe: DEA M = (Q, Σ, δ, q0 , F ).

Ausgabe: DEA Mmin = (Qmin , Σ, δmin , q0,min , Fmin ) mit Qmin minimal.

Methode: Die Zustandsmenge von M wird in eine Partition aufgeteilt, die schrittweise verfeinert wird. Für Zustände in verschiedenen Klassen einer Partition

ist schon bekannt, daß sie verschiedenes Akzeptanzverhalten zeigen, d.h. daß es

mindestens ein Wort w gibt, unter welchem aus einem der Zustände ein Endzustand erreicht wird und unter dem anderen nicht. Deshalb beginnt man mit der

Partition Π = {F, Q − F }. In jedem Iterationsschritt des Verfahrens wird eine

Klasse K aus der Partition entfernt und durch eine Menge von Verfeinerungen

Ki ersetzt. Dabei gilt, daß für alle Zustände q in einer Verfeinerung Ki der

Nachfolgezustand δ(q, a) unter einem Zeichen a in einer gemeinsamen Klasse

Ki′ liegt. Wird eine solche Verfeinerung gefunden, wird die Variable changed auf

true gesetzt. Der Algorithmus hält, wenn in einem Schritt die Partition nicht

mehr verfeinert wurde. Da in jedem Iterationsschritt nur Klassen der aktuellen

Partition evtl. in Vereinigungen neuer Klassen zerlegt werden, Q und damit

auch P(Q) aber endlich sind, terminiert das Verfahren. Die Klassen der dann

gefundenen Partition sind die Zustände von Mmin . Es gibt einen Übergang zwischen zwei neuen Zuständen P und R unter einem Zeichen a ∈ Σ, wenn es einen

Übergang δ(p, a) = r mit p ∈ P und r ∈ R in M gab.

1

2

3

4

5

6

7

Π = {F, Q − F } ;

do changed := f a l s e ;

Π′ := Π ;

foreach K ∈ Π do

Π′ :=S(Π′ − {K}) ∪ {{Ki }1≤i≤n } , und d i e Ki s i n d maximal mit

K = 1≤i≤n Ki , und ∀a ∈ Σ : ∃Ki′ ∈ Π : ∀q ∈ Ki : δ(q, a) ∈ Ki′

i f n > 1 then changed := true f i (∗ K wurde

a u f g e s p a l t e n ∗)

25

2 Lexikalische Analyse

a

′

{0

}

′

′

a

{1 , 2 } 0

Abbildung 2.6: DEA mit minimaler Zustandsmenge.

Partition

{{0′ , ⊘}, {1′ , 2′ }}

{{0′ }, {⊘}, {1′ , 2′ }}

{1′ , 2′ }

{⊘}

Klasse

Aufspaltung

{0′ , ⊘}

{1′ , 2′ }

{0′ }, {⊘}

nein

keine weitere Aufspaltung

bilden zusammen einen neuen Zustand

ist ein toter Zustand, da er nicht Endzustand ist und alle

Übergänge aus ihm hinaus wieder in ihn hineingehen.

Abbildung 2.7: Beispiel zur Minimalisierung.

od ;

Π := Π′

u n t i l not changed ;

Qmin = Π− ( Tot ∪ U n e r r e i c h b a r ) ;

8

9

10

11

q0,min

Fmin

δmin (K, a) = K ′

die Klasse in Π, in der q0 ist.

die Klassen, die ein Element aus F enthalten.

wenn δ(q, a) = p mit q ∈ K und p ∈ K ′

für ein und damit für alle a ∈ K.

K ∈ Tot

wenn K kein Endzustand ist und nur Übergänge

in sich selbst enthält.

K ∈ Unerreichbar wenn es keinen Weg vom Anfangszustand nach K gibt.

Die Anwendung des Verfahrens der Minimalisierung auf den in Abbildung 2.5 konstruierten DEA liefert den in Abbildung 2.6 angegebenen DEA mit minimaler Zustandsmenge. In Abbildung 2.7 sind die dabei aufgetretenen Iterationsschritte angegeben.

Mit Hilfe dieser drei Verfahren ist die Implementierung eines Scanners möglich:

1. Zuerst wird die zu erkennende Sprache, also die Menge der möglichen Lexeme

für Symbole, durch reguläre Ausdrücke beschrieben.

2. Im nächsten Schritt wird gemäß Satz 1 ein NEA konstruiert, der die von den

regulären Ausdrücken beschriebene Sprache akzeptiert.

26

2.2 Reguläre Sprachen und endliche Automaten

3. Anschließend wird mit dem Verfahren der Potenzmengenkonstruktion ein DEA

erzeugt, der dieselbe Sprache wie der NEA erkennt.

4. Mit Hilfe des Verfahrens der Minimalisierung wird ein weiterer DEA konstruiert, der dieselbe Sprache wie der erste DEA erkennt, aber über eine minimale

Zustandsmenge verfügt.

5. Dieser minimale DEA kann nun als Grundlage für die Implementierung des

Scanners verwendet werden.

2.2.4 Reguläre Definitionen

Der Übersichtlichkeit halber ist es wünschenswert, regulären Ausdrücken Namen geben zu können, damit diese Namen in anderen regulären Ausdrücken verwendet

werden können. Diese Namen können wie Zeichen aus dem Alphabet in regulären

Ausdrücken auftreten.

Definition 9

Sei Σ Alphabet. Dann ist eine reguläre Definition eine Folge

d 1 → r1

d 2 → r2

...

d n → rn ,

wobei di jeweils ein eindeutiger Name, ri ∈ reg(Σ ∪ {d1 , ..., di−1 }) ist.

Die Einschränkung ri ∈ reg(Σ ∪ {d1 , ..., di−1 }) gewährleistet, daß kein Name eines

regulären Ausdrucks in einem anderen Ausdruck verwendet wird, bevor der Name

deklariert wurde. Insbesondere sind hierdurch keine rekursiven Definitionen möglich.

Beispiel 5

letter → A | B | ... | Z | a | b | ... | z

digit → 0 | 1 | ... | 9

id

→ letter ( letter | digit )∗

Diese reguläre Definition beschreibt (etwas vereinfacht) die Bezeichner, wie sie in

Programmiersprachen auftreten. Bezeichner beginnen hier mit einem Buchstaben,

dem eine beliebig lange Sequenz von Buchstaben und Zeichen folgen kann.

Zur Verbesserung der Lesbarkeit werden folgende Abkürzungen vereinbart:

Ein- oder mehrmaliges Auftreten: Sei r regulärer Ausdruck. Dann stehe r+ für rr∗ ,

d.h. L(r+ ) = L(r)+ . Priorität und Assoziativität gelten wie für den ∗ -Operator.

27

2 Lexikalische Analyse

Null- oder einmaliges Auftreten: Sei r regulärer Ausdruck. Dann stehe r? für r | ε,

d.h. L(r?) = L(r) ∪ {ε}.

Beispiel 6

Der reguläre Ausdruck a+ beschreibt die Menge aller nicht-leeren Wörter, die nur

aus a’s bestehen.

a?b∗ beschreibt die Menge aller Wörter, die entweder nur b’s oder genau ein a und

dann nur b’s enthalten.

Beispiel 7

Betrachten wir die Regeln einer kontextfreien Grammatik für einen Ausschnitt einer

Programmiersprache:

stmt → if expr then stmt

|

if expr then stmt else stmt

|

ε

expr → term relop term

|

term

term → id | num

In der durch diese Regeln beschriebenen Programmiersprache treten folgende Symbole auf: if, then, else, relop, id, num. Der Scanner muß diese Symbole im Eingabestrom erkennen und herausfiltern. Die Symbole werden in Form einer regulären

Definition spezifiziert:

if

→ if

then → t h e n

else

→ else

relop → = | < | <= | <> | > | >=

id

→ letter (letter | digit)∗

num → digit+ (. digit+ )? (E (+ | -)? digit+ )?

Dabei seien letter und digit wie in Beispiel 5 definiert. num ist entweder einfache

Integer-Zahl oder eine Fließkommazahl, wobei Nachkommastellen und ein positiver

bzw. negativer Exponent angegeben werden können.

Schlüsselwörter sollen hier nicht als Bezeichner verwendet werden dürfen. Daher wissen wir, daß bei Erkennen der Zeichenkette t h e n das Symbol then und nicht id

an den Parser weitergereicht werden muß.

Lexeme sind durch Leerräume getrennt, dabei sind Leerräume nicht-leere Folgen von

Leerzeichen und Zeilenwechseln:

delim → blank | newline

sep

→ delim+

blank und newline müssen dann in Abhängigkeit von der Implementierung interpretiert werden.

28

2.2 Reguläre Sprachen und endliche Automaten

Regulärer Ausdruck

sep

if

then

else

id

num

<

<=

=

<>

>

>=

Symbol

–

if

then

else

id

num

relop

relop

relop

relop

relop

relop

Attributwert

–

–

–

–

Verweis auf Eintrag in der Symboltabelle

Wert der Zahl

LT

LE

EQ

NE

GT

GE

Tabelle 2.3: Reguläre Ausdrücke und die dazugehörigen Symbole und Attributwerte.

Unser Ziel ist nun die Erstellung eines Scanners, der im Eingabestrom ein Lexem für

das nächste Symbol identifiziert und als Ausgabe ein Paar aus Symbol und Attribut

gemäß Tabelle 2.3 liefert.

Bei der Erkennung der Lexeme tritt folgendes Problem auf: um die Lexeme eindeutig

identifizieren zu können, muß der Scanner im Eingabestrom “vorausschauen” können.

Zum Beispiel liefern

then das Symbol then,

thens das Symbol id,

85 das Symbol num und

85a einen lexikalischen Fehler ( steht für ein Leerzeichen).

Das Vorausschauen im Eingabestrom wird lookahead genannt. Im allgemeinen genügt

ein lookahead von 1 nicht. Daher sollte die Eingabe in einen Eingabepuffer kopiert

werden, in dem über einen Zeiger auf das jeweils aktuelle Zeichen zugegriffen werden kann. Hierdurch wird ein Zurückschreiben von Zeichen aus dem lookahead durch

Zurücksetzen des Zeigers ermöglicht.

Ein weiteres Problem tritt bei der Erkennung der Schlüsselwörter der zu übersetzenden Sprache auf. Die Codierung der Erkennung von Schlüsselwörtern in Automaten resultiert in einer sehr großen Anzahl von Zuständen. Deshalb werden i. allg.

Schlüsselwörter zunächst wie Bezeichner behandelt. Erst später wird zwischen Bezeichnern und Schlüsselwörtern differenziert, so daß die jeweils entsprechende Information an den Parser geliefert wird.

Ein mögliches Verfahren besteht darin, die Schlüsselwörter vorab mit entsprechenden

Informationen in die Symboltabelle einzutragen, um eine Unterscheidung von den

Einträgen für Bezeichner zu ermöglichen. Eine weitere Möglichkeit besteht in der

29

2 Lexikalische Analyse

Kombination des Scanners mit einem Sieber (siehe Abschnitt 2.3).

Beispiel 8 (Fortführung von Beispiel 7)

Wir geben nun für die Symbole Übergangsgraphen an, die beschreiben, wie der Scanner

arbeitet, wenn er vom Parser mit der Ermittlung des nächsten Symbols beauftragt

wurde. Dabei gehen wir davon aus, daß der benötigte Teil der Eingabe in einem

Puffer steht, der über einen Zeiger den Zugriff auf das aktuelle Zeichen erlaubt. Am