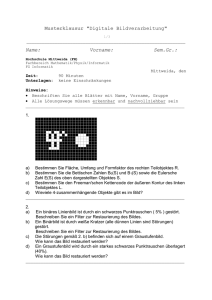

Lexikon Industr Bildverarb

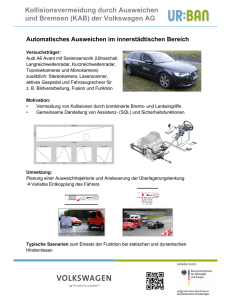

Werbung