Zeitreihen unter strikter Exogenität - Philipps

Werbung

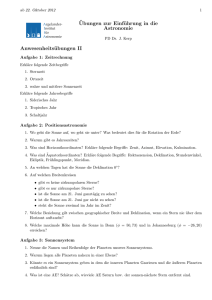

KAP 6: Zeitreihen unter strikter Exogenität

I

K.H. Schild

24. Mai 2017

Jahr

1948

1949

1950

1951

..

.

1998

1999

2000

2001

2002

2003

1 / 38

In diesem Kapitel ...

I

I. Grundlegendes zur Ökonometrie von Zeitreihen

I

I

Inflationsrate

8.1

-1.2

1.3

7.9

..

.

1.6

2.2

3.4

2.8

1.6

2.3

Arbeitslosenquote

3.8

5.9

5.3

3.3

..

.

4.5

4.2

4.0

4.7

5.8

6.0

3 / 38

Zeitreihen als Pfade von stochastischen Prozessen

I

I

Was sind Zeitreihen?

Zeitreihen(daten) entstehen,

indem man gewisse Variablen,

sagen wir Y , X1 , . . . ,XK

über einen gewissen Zeitraum in konstantem zeitlichen Abstand erfasst.

Zeitlicher Abstand“ kann z.B. sein: 1 Jahr, 1 Quartal, 1 Monat, 1 Tag, 1 Stunde

”

I Indizieren wie die Zeitpunkte durch t = 1, 2, . . . , T , ...

... bekommen wir die Zeitreihen

yt , xt,1 , . . . xt,K .

I Wir bekommen ein Sample“ wie bei Querschnittsdaten, nur ist der Index für die

”

Beobachtungseinheit jetzt ein Zeitpunkt t, nicht das Individuum i

Beispiel: Jahresdaten, yt = Inflationsrate INFLR, xt = Arbeitslosenquote UNEMPLR

Bei Zeitreihen ist der datengenerierende Prozess ein stochastischer Prozess.

Ein stochastischer Prozess ist eine Folge von Zufallsvektoren

(Z t )t=1,...,T ,

Was sind Zeitreihen(daten)?

Was ist ein Regressionsmodell für Zeitreihendaten?

Was ist anders bei Zeitreihen als bei Querschnittsdaten?

Welche Möglichkeiten bieten Zeitreihen gegenüber Querschnittsdaten?

(Lags von erklärenden Variablen, autoregressive Modelle, Differenzen,

Deterministische Fkt.nen der Zeit)

I

I

II. Übertragung der OLS-Small-Sample-Theorie auf Zeitreihen

(Wann kann man Zeitreihen- wie Querschnittsdaten behandeln?)

I

1. OLS-Unverzerrtheit bei Zeitreihen nur unter strikter Exogenität sichergestellt

2. Effizienz (OLS ist der BLUE) unter Homoskedastie“ und keine Fehler-Autokor.“

”

”

3. Exakte Tests benötigen darüber hinaus auch noch normalverteilte Fehler

III. Deterministische Trends (Einiges zu Trend- und Saison-Bereinigung)

IV. Hodrick-Prescott-Filter

z.B. Z t = (Yt , Xt , Ut )

Die Zeitreihen yt , xt , ut sind Realisierungen (Pfade) des stochastischen Prozesses

Der entscheidende Punkt bei Zeitreihen ist:

– Es kann nicht nur Yt mit Xt korrelieren

(intratemporale Korrelation)

– sondern es kann auch Xt mit Xt−1 oder mit Xt−4 korrelieren

– oder es kann Xt mit Ut−1 korrelieren

(intertemporale Korrelation)

Denn wir können nicht annehmen, dass Z t unabhängig ist von Z s für s 6= t

Beschreibung des Prozesses umfasst die gemeinsame Verteilung der Variablen (Z 1 , . . . , Z T )

I

Also: Was ist das Besondere bei Zeitreihen-Regressionen?

1. Wir haben i.d.R. intertemporale Korrelation

innerhalb jeder einzelnen Variable (Autokorrelation, z.B. Xt korreliert mit Xt−1 )

und auch zwischen verschiedenen Variablen (z.B.: Xt korreliert mit Ut−1 )

(Dagegen Querschnittsdaten: Nur Korrelation zwischen Variablen der gleichen Beob.Einheit)

2. Wir beobachten i.d.R. genau eine Realisierung des stochastischen Prozesses

(Wir können die Zeit nicht zurückdrehen, und den Prozess nochmal ablaufen lassen)

2 / 38

4 / 38

Zeitreihenregressionen

I

Zwei Typen von Zeitreihenmodellen

Wenn wir Daten der betreffenden Zeitreihen haben, ...

... können wir – rein technisch – ein lineares Regressionsmodell

Grobunterteilung der Zeitreihenmodelle in:

I

Yt = β0 + β1 Xt,1 + . . . + βK Xt,K + Ut

Statische Modelle:

Die zu erklärende Variable yt wird nur durch kontemporäre Variablen

xt,1 , . . . , xt,K erklärt.

I

mit OLS schätzen ...

... als ob wir Querschnittsdaten hätten.

I

Allerdings ignorieren wir dabei vollständig, wie die Daten entstanden sind.

(Wir tun dabei so, als ob die Zeitreihendaten einer Zufallsziehung aus einer

Population entstammen, was sicher nicht der Fall ist)

I

Mindestens sollte uns klar sein, ...

unter welchen Voraussetzungen sichergestellt ist, ...

dass OLS eine gute (z.B. unverzerrte) Schätzung liefert.

I

I

I

Außerdem: Wenn wir den Zeitreihencharakter außer Acht lassen, ignorieren wir,

dass Zeitreihen viele neue Möglichkeiten für Regress.modelle bieten:

Beispiel (1): infrtet = β0 + β1 unempt + ut (Klassische Philipps-Kurve)

infrte = Jährliche Inflationsrate, unemp = Arbeitslosenquote. Modell fragt nach

dem (kontemporären) Einfluss der Arbeitslosenq. auf die Inflat.rate.

Beispiel (2): mrdrtet = β0 + β1 convrtet + β2 unempt + ut

mrdrte = Zahl der Morde pro 10 000 Einwohner (in einer bestimmten Großstadt)

convrte = Aufklärungsquote (conviction rate) von Morden

unemp = (lokale) Arbeitslosenquote

Modell fragt nach dem dem Einfluss der Aufklärungsquote auf die Mordquote.

Dynamische Modelle:

Die zu erklärende Variable yt wird auch durch vergangene (‘lagged’) Variablen

erklärt, z.B. xt,1 = zt und xt,2 = zt−1 .

5 / 38

7 / 38

Möglichkeiten, die (nur) Zeitreihenregressionen bieten

I

I

I

I

I

Verzögerte ( lagged“) erklärte Variablen

”

z.B: INFLRTEt auf UNEMPLRt und UNEMPLRt−1

Verzögerte erklärte Variable als erklärende Variable: Autoregression

z.B: INFLRt auf INFLRt−1 , UNEMPLRt und UNEMPLRt−1

Wir können das Modell in Differenzen betrachten

z.B: ∆INFLRt auf ∆UNEMPLRt

[∆yt := yt − yt−1 ]

Wir können beides mischen

z.B.: ∆INFLRt auf ∆INFLRt−1 , ∆UNEMPLRt , und ∆UNEMPLRt−1

Wir können Funktionen der Zeit t einfügen, z.B.

Linearer Trend: t selbst als erklärende Variable

Quadratischer Trend: t und t2 als erklärende Variable

Saison-Dummies als erklärende Variable (z.B. je ein Dummy für 1., 2., 3. Quartal)

Stetige Saison-Funktionen: sin(2πωt), cos(2πωt) als erklärende Variablen

0, wenn t < tEVENT

Event-Dummies: xt =

als erklärende Variablen

1, wenn t ≥ tEVENT

⇒ Unzahl an Möglichkeiten der Modellspezifikation bei Zeitreihen-Regressionen

6 / 38

Dynamische Modelle

I

In vielen Fällen:

Verzögerte Wirkung einer erklärenden Variable (jetzt z genannt) auf y,

Mögliche Gründe: technisch, biologisch, ökonomisch (Dauer von Entscheidungsund Anpassungsprozessen) usw.

I

Bei einem dynamischen Modell (oder finite-distributed-lag Modell oder

FDL-Modell oder auch FDL(q)-Modell) handelt es sich um ein Modell der Form

yt = α0 + δ0 zt + δ1 zt−1 + . . . + δq zt−q + ut

wobei q für die größte berücksichtigte Verzögerung (engl: Lag) steht.

I

Natürlich auch möglich: Weitere erklärende Variablen (kontemporär oder

ebenfalls verzögert).

I

Auch denkbar: Verzögertes y als erklärende Variable (autoregressives Modell)

Schließen wir hier aber noch aus – das würde die strikte Exogenitätsannahme

verletzen.

8 / 38

Beispiel:

Geburtenrate (gfr) erklärt durch das Kindergeld (pe)

Einflussmessung: Kurz- und langfristiger Multiplikator

I

Gegeben dynamisches Modell

yt = α0 + δ0 zt + δ1 zt−1 + . . . + δq zt−q + ut ,

gfrt = α0 + δ0 pet + δ1 pet−1 + δ2 pet−2 + β1 pillt + ut

I

I

wobei:

gfr = Allgemeine Fertilitätsrate

(Zahl der Neugeborenen pro 1000 Frauen im Alter 18-45)

pe = Realer Wert der ‘personal tax exemption’ (’Kinderfreibetrag’, Kindergeld)

pill = 0 falls t < 1963, 1 falls t ≥ 1964

Wie kann man den Einfluss von z auf y messen?

I

δ0 heißt kurzfristiger Multiplikator (short run multiplier od. impact multiplier )

(gibt den Effekt an, den eine Änderung von zt um ∆zt = 1 auf yt in der gleichen

Periode t hat, wenn vorher z unverändert war)

I

Die Summe aller δ’s,

LRP =

Modell adressiert die Frage, welchen Einfluss das Kindergeld auf die Geburtenrate

hat.

Xq

j=0

δj

wird als langfristiger Multiplikator bezeichnet

(long run multiplier oder long run propensity = LRP) bezeichnet.

Schon aus biologischen Gründen ist es sinnvoll, pe verzögert einzubeziehen.

I

I

Die LRP gibt an, wie eine permanente Erhöhung von z auf y wirkt.

Theoretisch müsste man dazu q = ∞ wählen. Aber: Schätzung des LRP ändert

sich oft nicht sehr, wenn ein (genügend) großes q weiter vergrößert wird.

9 / 38

11 / 38

Einschub: Schätzung von dynam. Modellen in EViews

Verwendung von lagged-Variablen in EViews:

Um also das Modell:

Beispiel: Geburtenrate (gfr) erklärt durch das

Kindergeld (pe)

x(-1) für xt−1 usw.

gfrt = α0 + δ0 pet + δ1 pet−1 + δ2 pet−2 + β1 pillt + ut

I

in EViews zu schätzen, die Gleichung wie folgt eingeben:

c

gfr

t

gfr c pe pe(-1) pe(-2) pill

Die Schätzung mit US-amerik. Daten 1913-1984 ergibt (beachte Datenreduktion!):

Dependent Variable: GFR

Method: Least Squares

Date: 04/07/10 Time: 21:36

Sample (adjusted): 1915 1984

Included observations: 70 after adjustments

C

PE

PE(-1)

PE(-2)

PILL

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

F-statistic

Prob(F-statistic)

I

Coefficient

Std. Error

t-Statistic

Prob.

96.37813

-0.079600

-0.029238

0.189525

-30.20776

3.353547

0.104015

0.159081

0.103682

4.043297

28.73916

-0.765276

-0.183791

1.827941

-7.471071

0.0000

0.4469

0.8547

0.0721

0.0000

0.465296

0.432392

14.62256

13898.25

-284.5115

14.14067

0.000000

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

Hannan-Quinn criter.

Durbin-Watson stat

94.77429

19.40881

8.271757

8.432364

8.335552

0.135670

OLS-Schätzung mit den Daten von 1913-1984 (USA) lieferte:

I

=

96.3

− 0.08 pet

(3.35)

(0.10)

T = 70, R2 = 0.47

− 0.03 pet−1

(0.16)

+ 0.19 pet−2

(0.10)

− 30.2 pillt

(4.04)

[ ≈ 0.19 − 0.03 − 0.08 = 0.08.

Die geschätzte long run propensity beträgt LRP

Das heißt: Bei einer dauerhaften Erhöhung der personal tax exemption lässt jeder

zusätzliche Dollar pe eine Erhöhung der Geburtenrate um 0.08 erwarten.

(Die pe schwankt um einen Mittelwert von 100$, die Geburtenrate gfr hat einen

Mittelwert von ca. 95 und schwankt zwischen min. 65 und max. 125. Das recht hohe R2

entsteht nur aufgrund der Berücksichtigung des Time-Dummies pill. )

10 / 38

12 / 38

Abschnitt II. Übertragung der

OLS-Small-Sample-Theorie auf Zeitreihen

I

Zunächst: Formulierung von GM-Annahmen

I

Dann: Welche GM-Annahme wird für welches Qualitätsmerkmal“ der

”

OLS-Schätzung benötigt?

Annahme TS3: Strikte Exogenität der Regressoren

Unter strikter Exogenität verstehen wir inhaltlich folgendes:

Der Störterm hat zu jedem Zeitpunkt t einen erwarteten Wert von 0

und keinen systematischen Zusammenhang mit einer der erklärenden

Variablen zu irgendeinem Zeitpunkt s (weder dem gleichen noch

einem vergangenen oder zukünftigen)

Lässt sich mathematisch wieder mit drei Konstrukten fassen:

Gauß-Markov-Annahme TS3.1: Strikte Exogenität

Der Störterm ut hat einen erwarteten Wert von 0 und ist stochastisch unabhängig von

allen Zufallsvariablen xs,1 , . . . , xs,K zu allen Zeitpunkten s:

E[u] = 0 und u ist stochastisch unabhängig von X

← “Zufallsmatrix“

wobei X die Gesamtheit der Zufallsvariablen (xs,1 , . . . , xs,K )s=1,...,T bezeichnet.

bzw.

15 / 38

13 / 38

Annahmen TS1 (Lineares Modell),

TS2 (Keine perfekte Kollinearität)

Annahme TS3: Strikte Exogenität der Regressoren

(Forts)

Analog zu den Gauß-Markov-Annahmen formulieren wir Standard-Annahmen im

Kontext von Zeitreihen-Regressionen:

Gauß-Markov-Annahme TS1: Lineares Modell

Der stochastische Prozess (xt,1 , . . . , xt,K , yt )t=1,...,T folgt dem Modell

Gauß-Markov-Annahme TS3.2: Strikte Exogenität

Der Störterm ut hat einen erwarteten Wert von 0 und ist unkorreliert mit allen Zufallsvariablen xs,1 , . . . , xs,K zu allen Zeitpunkten s:

E[ut ] = 0 und cov(ut , xs,j ) = 0 für j = 1, . . . , K, s = 1, . . . , T

yt = β0 + β1 x1,t + . . . + βK xK,t + ut ,

wobei ut für t = 1, . . . , T die Folge der Fehler- oder Störterme bezeichnet (die man

im Zeitreihenkontext auch Schocks oder Innovationen nennt).

Anmerkung: Analog zu GM1

Annahme TS2: Keine perfekte Kollinearität

Gauß-Markov-Annahme TS2: keine perfekte Kollinearität

Weder in der Zeitreihe noch im stochastischen Prozess ist eine der unabhängigen

Variablen eine Linearkombination der anderen.

bzw.

Gauß-Markov-Annahme TS3.3: Strikte Exogenität

Der Störterm ut hat – bei zu allen Zeitpunkten s gegebener Ausprägung der erklärenden Variablen xs,1 , . . . , xs,K – einen erwarteten Wert von 0:

E[ut | X] = 0

wobei X die Gesamtheit der Zufallsvariablen (xs,1 , . . . , xs,K )s=1,...,T bezeichnet.

Implikationskette: TS3.1 ⇒ TS3.3 ⇒ TS3.2

Anmerkung: Analog zu GM2

14 / 38

16 / 38

Bedeutung der strikten Exogenitätsannahme

I

Annahme TS4: Homoskedastie

Betrachte (zur Verdeutlichung) die einfachste Situation:

Statisches Modell mit einer einzigen erklärenden Variable:

Gauß-Markov Annahme TS4: Homoskedastie

Zu jedem Zeitpunkt t hat der Störterm ut – bei zu allen Zeitpunkten s gegebener

Ausprägung der erklärenden Variablen xs,1 , . . . , xs,K – die gleiche Varianz σ 2 :

yt = β1 + β2 zt + ut

I

Damit ein solches Modell die strikte Exogenitätsannahme erfüllt, müssen drei

Bedingungen mehr oder weniger notwendigerweise erfüllt sein:

(1) zt darf nicht mit ut korreliert sein. D.h. zt muss kontemporär exogen sein

(analog zu Querschnittsdaten – Zufallsstichprobe).

(2) Keine Wirkung von vergangenem z auf aktuelles y.

Wenn z einen verzögerten Effekt auf yt hat, dann enthält yt Anteile des

vergangenen z. Damit enthält auch ut solche Anteile (jedenfalls solange yt nicht

komplett durch zt erklärt wird), und die strikte Exogenitätsannahme ist verletzt.

(3) Keine Wirkung von vergangenem y auf aktuelles z.

Wenn y einen verzögerten Effekt auf zt hat, dann korreliert auch das vergangenene

u mit dem aktuellen zt (da das vergangene y mit dem vergangenen u korreliert,

jedenfalls solange y nicht komplett durch z erklärt wird); dies widerspricht der

strikten Exogenitätsannahme.

Var(ut | X) = σ 2 ,

wobei X die Gesamtheit der Zufallsvariablen (xs,1 , . . . , xs,K )s=1,...,T bezeichnet.

Homoskedastie im Zeitreihenkontext: Die Störtermvarianz ist

(i) unabhängig von (der jeweiligen Ausprägung der) x-Variablen

und

(ii) konstant im Zeitverlauf

19 / 38

17 / 38

Beispiel

I

Annahme TS5: Keine Autokorrelation der Störterme

Autokorrelation der Störterme ist bei Zeitreihen-Regressionen ein wichtiges Thema.

Im Querschnittsdaten-Szenario wurde die Autokorrelation der Störterme durch die

Annahme einer Zufallstichprobe implizit ausgeschlossen, hier müssen wir das fordern:

Ein Beispiel, wo der dritte Punkt (vergangenes y wirkt auf aktuelles z)

vermutlich zur Verletzung der strengen Exogenitätsannahme führt, ist:

mrdrtet = β0 + β1 convrtet + ut

Nimmt man zur Vereinfachung an, dass die aktuelle Auklärungsquote convrtet mit

den Aufwendungen für die Kripo im Zeitraum (t − 1, t] identifiziert werden kann

und dass die Politik diese Aufwendungen an die vergangene Verbrechensquote

mrdrtet−1 anpasst, so hat man eine Wirkung von yt−1 = mrdrtet−1 auf

zt = convrtet . Das führt zu einer Verletzung der Annahme strikter Exogenität.

18 / 38

Gauß-Markov Annahme TS5: Keine Autokorrelation der Störterme

Für jeweils zwei (verschiedene) Zeitpunkte t und t0 gilt: Die Störterme ut und ut0

sind – bei zu allen Zeitpunkten s gegebener Ausprägung der erklärenden Variablen

xs,1 , . . . , xs,K – unkorreliert:

cov(ut , ut0 | X) = 0 für t 6= t0

wobei X die Gesamtheit der Zufallsvariablen (xs,1 , . . . , xs,K )s=1,...,T bezeichnet.

20 / 38

Annahme TS6: Normalverteilte Störterme

Anmerkungen zur Erwartungstreue/Unverzerrtheit

Gauß-Markov Annahme TS6: Normalverteilte Störterme

Zu jedem Zeitpunkt t ist der Störterm ut – – bei zu allen Zeitpunkten s gegebener

Ausprägung der erklärenden Variablen xs,1 , . . . , xs,K – normalverteilt,

I

Benötigt werden dazu nur

TS.1 (lin. Mod.),

TS.2 (keine Kollinearität),

TS.3 (strikte Exogenität)

I

Nicht benötigt werden:

TS.4 (Homoskedastie von u),

TS.5 (keine Autokorrelation von u),

TS.6 (Normalverteilung von u)

I

Aber: Um die Standardfehler (auf einfach Weise konsistent und/oder erwartungstreu)

schätzen zu können, benötigen wir TS4 und TS5.

I

Für exakte Tests benötigen wir dann auch noch TS6.

2

ut |X ∼ N (0, σ ),

wobei X die Gesamtheit der Zufallsvariablen (xs,1 , . . . , xs,K )s=1,...,T bezeichnet.

21 / 38

Erwartungstreue der OLS-Schätzung

(unter TS1,TS2,TS3)

Varianz der OLS Schätzung

Satz 1: Unter den Annahmen TS1 (lineares Modell), TS2 (keine Kollinearität) und

TS3 (strikte Exogenität) ist die OLS-Schätzung erwartungstreu.

E[β̂|X] = β

23 / 38

(und daher auch: E[β̂] = β)

Analog zum Ergebnis bei Querschnittsdaten haben wir (der Trick ist jedesmal, auf die

gesamte Beobachtungsmatrix X zu konditionieren)

Satz 2: Unter den Annahmen TS1 bis TS5 gilt für die Varianzmatrix des OLS-Schätzer

β̂ bei Vorliegen der exogenen Daten X:

Var(β̂ | X) = σ 2 (X 0 X)−1

Beweis:

E[β̂|X]

=

=

=

E[(X 0 X)−1 X 0 y | X]

0

−1

E[(X X)

0

0

−1

X Xβ | X] + E[(X X)

E[β|X]

| {z }

=β

0

−1

+ (X X)

X

0

| ersetze y = Xβ + u

0

X u | X]

E[u|X]

| {z }

= β

Satz 3: Unter den Annahmen TS1 bis TS5 ist

=0 (wg. TS3)

0

−1

0

Der entscheidende Schritt dabei ist das Herausziehen von (X X) X ;

das geht, da auf ganz X konditioniert wurde und folgende allgemeine Regel für

bedingte Erwartungswerte gilt:

E[g(X) · Y | X] = g(X) · E[Y | X]

Um den Standardfehler von β̂ schätzen zu können, muss lediglich σ 2 geschätzt

werden. Der auf den OLS-Residuen ût basierende Standard-Schätzer ist

erwartungstreu, wenn eine Freiheitsgradkorrektur vorgenommen wird:

T

1 X 2

σ̂ =

û

T − K t=1 t

2

(K = Gesamtzahl der Regressoren)

ein erwartungstreuer (d.h. unververrter, unbiased) Schätzer von σ 2 .

22 / 38

24 / 38

Gauß-Markov-Theorem

(unter TS1,. . .,TS5)

Schließlich gilt unter TS1 bis TS5 das Gauß-Markov-Theorem:

Satz 4: Unter den Annahmen TS1 bis TS5 ist OLS der best linear unbiased estimator (BLUE).

Das heißt: Unter allen linearen Schätzern β̂ = W (X) y mit einer von X abhängigen

Matrix W = W (X) hat β̂ OLS = (X 0 X)−1 X 0 y die kleinste Varianzmatrix im folgenden Sinne:

Var(β̂ OLS ) − Var(β̂) ist positiv semidefinit für jeden linearen Schätzer β̂

25 / 38

27 / 38

Exakte Hypothesentests (unter TS1,. . .,TS6)

Wenn wir die Normalverteilungsannahme bzgl. der Störterme aus TS6 hinzufügen,

dann übertragen sich die Ergebnisse der Small-Sample-Theorie der Querschnittsdaten

auf die Regression in Zeitreihenmodellen (unter strikter Exogenität):

Satz 5: Unter den Annahmen TS1 bis TS6 ist die OLS-Schätzung normalverteilt

(konditional auf X):

β̂ OLS ∼ N (β, σ 2 X 0 X)

Außerdem gilt unter diesen Annahmen: Die t-Statistiken haben die exakten tVerteilungen und die F -Statistiken die exakte F -Verteilung.

26 / 38

28 / 38

Abschnitt III.1: Deterministische Trends

I

Ökonomische Zeitreihen sind haben oft einen offensichtlichen Trend

(vor allem dann, wenn es sich um ‘Level-Größen’ handelt)

I

I

I

I

I

I

I

I

I

Trends in Regressionsbeziehungen; Spurious

Regression

I

Einkommen (in industrialisierten Ländern),

Konsum (in industrialisierten Ländern),

BIP

Produktivität

Aktienkurs

DAX, Dow-Jones, ....

Natürlich kann man auch in allgemeinen (statischen oder dynamischen)

Regressionsmodellen Trendterme als zusätzliche erklärende Variablen einbeziehen:

Anstatt

betrachte

oder sogar

In Regressionsmodellen kann ein Trend (in der erklärten und wenigstens

einer der erklärenden Variablen) wie eine omitted variable“ wirken.

”

Gemeinsame Trends in erklärter wie erklärenden Variable können also zu

(starken) Verzerrungen in den geschätzten Regressionskoeffizienten führen

(ohne Trend)

0

(linearer Trend)

yt = β x̃t + γ t + ut

0

yt = β x̃t + γ1 t + γ2 t

2

+ ut

(quadr. Trend)

I

Die Berücksichtigung eines solchen (deterministischen) Trends ist oft sehr wichtig

– zur Vermeidung des Problems der

I

Spurious regression: Wenn es Faktoren (in ut ) gibt, die mit der Zeit wachsen

und sowohl mit xt als auch yt positiv korrelieren, zeigt die Regression von yt auf

xt (ohne Trendterm) einen signifikanten Einfluss von xt (und ein großes R2 ) an,

ohne dass dies irgendetwas über den ‘wahren Mechanismus’ aussagt.

I

Standard-Beispiel: yt = Geburtenrate, xt = Zahl der Störche

Man spricht dann von einer spurious regression (Geister-Regression)

(Grob gesagt sieht man im Regr.Koeffizienten primär den Effekt des gemeinsamen

Trends, nicht den eigentlichen Effekt der Variable.)

yt = β 0 x̃t + ut

29 / 38

Trendbereinigung (Bestimmung von Wachstumsraten)

I

Hat man eine einzelne Zeitreihe yt , kann man die mittlere Zunahme pro

Zeiteinheit β̂1 durch OLS-Schätzung von

yt = β0 + β1 t + ut

bestimmen. (E-Views-Funktion zur Ermittlung von t: @trend(["base date"]))

Bei diesem Vorgehen verwendet man xt,1 = 1 und xt,2 = t als Regressoren.

I

Zur Trendbereinigung wird der geschätzte Trend abgezogen, d.h. zu den

Residuen

ÿt = yt − β̂0 − β̂1 t,

übergegangen.

I

Liegt exponentielles Wachstum vor, sollte log(yt ) statt yt regressiert werden:

log(yt ) = β0 + β1 t + ut

Das geschätzte β̂1 gibt in diesem Fall die mittlere Wachstumsrate an

30 / 38

31 / 38

Interpretation einer Regression mit Trend als

trendbereinigte Regression

Man kann zeigen:

Einschluss eines linearen Trends γt in das Regres.Modell yt = β 0 x̃t + ut

liefert die gleiche OLS-Schätzung β̂ wie folgendes zweistufige Vorgehen:

(1) Sowohl yt also auch sämtliche Regressoren xt = (xt,1 , . . . , xt,K ) werden

(einzeln) linear-trendbereinigt, mit dem Ergebnis ÿt , ẍt = (ẍt,1 , . . . , ẍt,K )

(2) Es wird ÿt regressiert auf ẍt .

Also:

Man kann den Einschluss eines lin. Trends auch so interpretieren, dass man

implizit alles (die erklärte wie die erklärenden Var.) linear-trendbereinigt.

Allerdings:

Der Einschluss eines lin. Trends in die Regres. bereinigt alles von linearen Trends,

und z.B. nicht von quadrat. Trends (man müsste dann einen solchen ansetzen).

Es gibt Formen von Trends (sog. stochastische Trends), die sich nicht durch

deterministische Funktionen der Zeit erfassen lassen.

Solche Trends können nicht durch Einbeziehung deterministischer Trends

kontrolliert werden. → Dies wird ein Thema der nä. Kapitel sein.

32 / 38

III.2 Saisonale Effekte

I

I

I

Time-Dummies

Einfache Möglichkeit zur Behandlung saisonaler Effekte: Verwendung von

Saison-Dummies (binäre Variablen, die angeben, ob man sich in der

betreffenden Saison befindet).

Der Regressionskoeffizient eines Saison-Dummies misst den ‘Einfluss der Saison’:

Um wieviel höher ist yt im Schnitt in der betreffenden Saison?

Beispiel: Die Daten liegen monatlich vor und man hat eine regelmäßige

Veränderung von yt im Juli, d.h. für t = 7, 19, 31, . . .. Dann kann/sollte man eine

Dummy-Variable (1 im Monat Juli, 0 sonst) in die Regression einbeziehen;

in EViews lässt sich eine solche Variable als series (Zeitreihe) wie folgt

definieren:

series month7 = (@mod(@trend,12) = 7)

(setzt voraus, dass die erste Beobachtung im Januar des Jahres 0 liegt; @trend

liefert den Index t zurück; @mod(t,x) ist der Rest der Ganzzahldivision von t

durch x).

33 / 38

I

Fragestellung: Einfluss einer Intervention (z.B. Regulierungsmaßnahme) auf eine

interessierende Größe (das Outcome, häufig: Kapitalmarktrenditen) schätzen,

wobei der Beginn der Intervention in den Beobachtungszeitraum fällt (so dass es

ein ‘Vorher’ und ‘Nachher’ gibt).

I

Einfachstes Modell: Dauerhafte Veränderung der Outcome-Größe y um einen

konstanten Wert, sobald die Intervention stattgefunden hat.

I

Standard-Vorgehen: Periodenspezifische binäre erklärende Variable(n)

verwenden

D.h. Eine Dummy-Variable hinzufügen, die den Wert 0 vor und 1 nach der

Intervention annimmt. E-Views Funktion:

series isEvent = (@trend >= t0)

I

Signifikanz des Koeffizienten der Dummy-Variablen signalisiert Einfluss der

Intervention.

35 / 38

Saisonbereinigung

I

Analog zur Trendbereinigung:

Saisonbereinigung wird erreicht, indem die ursprüngliche Variable ersetzt wird

durch die Residuen einer einf. Regression von ihr auf (eine Konstante u.) die

Saison-Dummies.

I

Ebenfalls wie bei der Trendbereinigung:

Einschluss eines Saison-Dummies im Regressionsmodell ist äquivalent dazu,

für jede der Variablen (erklärte wie erklärenden) zunächst eine saisonale

Bereinigung durchzuführen und dann die saisonbereinigten Variablen

aufeinander zu regressieren (ohne Saison-Dummy).

I

Manchmal sind Zeitreihendaten schon saisonbereinigt, so dass man keine

Anpassung benötigt.

I

Es gibt mehr oder weniger standardisierte Verfahren zur Saisonbereinigung

(z.B. Census X12).

34 / 38

36 / 38

Abschnitt IV: Hodrick-Prescott-Filter

I

Ziel: Zerlege eine (univariate) Zeitreihe (xt )t=1,...,T in eine Trendkomponente gt

und eine zyklische Komponente ct :

xt = gt + ct ,

I

I

Beispiel zum HP-Filter

gt = Trend-Komponente,

ct = zyklische Komponente

um – z.B. in einem Regressionsmodell – anstatt xt nur den Trend (oder auch: nur

die zyklische Komponente) zu verwenden.

Der Hodrick-Prescott-Filter betrachtet die Trendkomponente als eine ‘glatte’

Komponente, die sich dadurch auszeichnet, dass

gt − gt−1 gt+1 − 2gt + gt−1

1 gt+1 − gt

−

=

2

∆t

∆t

∆t

(∆t)

zu jedem Zeitpunkt t klein sein sollte.

Der HP-Filter sucht einen Kompromiss zwischen der Größe des Abstands von gt

zu xt und der Größe dieser Differenzenquotienten, indem er (gt )t=1,...,T so wählt,

dass

XT

XT −1

(xt − gt )2 + λ

(gt+1 − 2gt + gt−1 )2 → min

(∗)

t=1

t=2

{gt }

minimal wird, wobei λ = λ(∆t) ein fester (Anwender-definierter) Parameter ist.

37 / 38

Wir betrachten aggregierte Quartalsdaten des US-amerikanischen Arbeitsmarkts im Zeitraum

von 1948 bis 2011. Die Zeitreihe EMPLRATE = employment rate enthält die

Beschäftigungsquote (1 - Arbeitslosenquote), die Zeitreihe RULC = real units labour costs

die reale Lohnquote ( Quotient aus ‘Lohn pro Stunde’ und ’Output pro Stunde’). Nach einem

Modell von R. Goodwin sollten diese beiden Größen in einer Räuber-Beute-Beziehung stehen,

was dazu führt, dass sich beide Größen periodisch verhalten (mit gleicher Periodendauer, aber

zeitlich versetzt, so dass ein Maximum der Lohnquote einem Minimum der

Beschäftigungsquote vorausgeht und umgekehrt). Ein solches periodisches Verhalten lässt

sich, wenn überhaupt, nur nach einer adäquaten Trendbereinigung identifizieren.

In den beiden linken Diagrammen der folgenden Folie wurde für den Glättungsparameter der vorgesehene Wert λ = 1600 gewählt. Dadurch kommt es zu komplizierten

Trendkomponenten, aber in den zyklischen Komponenten ist ein periodisches

Verhalten zumindest zu erahnen.

In den beiden Diagrammen rechts wurde λ sehr groß gewählt, so dass Krümmungen in

der Trendkomponente stark bestraft werden. Der HP-Filter versucht hier,

Krümmungen im Trend möglichst zu vermeiden, mit dem Ergebnis annähernd linearer

Trends. Ein periodisches Verhalten in den zyklischen Komponenten ist dann aber

kaum noch ersichtlich.

39 / 38

Hodrick-Prescott-Filter (II)

Beispiel zum HP-Filter (II)

Hodrick-Prescott Filter (lambda=1600)

I

I

I

I

Hodrick-Prescott Filter (lambda=16000000)

Man kann zeigen: Das Problem (*) hat für jedes λ > 0 eine eindeutige Lösung,

die sich durch Lösen eines lin. Gl.Systems der Form (I + λD0 D)g = x ergibt.

1.5

1.5

1.4

1.4

1.3

1.3

1.2

Für λ → 0 konvergiert gt → xt und ct → 0, d.h. der Filter reproduziert xt als gt .

Je größer λ, je glatter wird die Trend-Komponente gt .

Für λ → ∞ wird versucht, einen linearen Trend gt = γ t durch xt zu legen (da

die 2. Ableitung von gt Null wird).

Hodrick/Prescott empfehlen, λ = λ(∆t) gemäß der Formel

λ = 1600(∆t/Quartal)−2 zu wählen, was auf folgende Werte hinausläuft:

für ∆t = 1 Jahr

100

λ = 1600 für ∆t = 1 Quartal

14400 für ∆t = 1 Monat

2

Da in die Zielfunktion (∗) ( ∆t)2 = (∆t)4 eingeht, erscheint es sinnvoller, λ

mit der 4. Potenz von 1/∆t ansteigen zu lassen, z.B. λ = 1600(∆t/Quartal)−4

In EViews: Betreffende series öffnen, dann proc – Hodrick-Prescott-Filter

.04

1.0

.04

1.2

1.1

1.0

0.9

.02

.00

.00

-.04

-.02

-.08

-.04

0.9

-.12

50

55

60

65

70

75

RULC

80

85

90

Trend

95

00

05

10

50

55

60

65

Cycle

70

75

RULC

Hodrick-Prescott Filter (lambda=1600)

80

85

90

Trend

95

00

05

10

Cycle

Hodrick-Prescott Filter (lambda=160000000)

.98

.98

.96

.94

.02

.92

.01

.90

.96

.04

.94

.02

.92

.00

.00

.90

.88

-.02

.88

-.01

-.04

-.02

-.03

38 / 38

1.1

.08

-.06

50

55

60

65

70

75

EMPLRATE

80

85

90

Trend

95

00

Cycle

05

10

50

55

60

65

70

75

EMPLRATE

80

85

90

Trend

95

00

Cycle

05

10

40 / 38