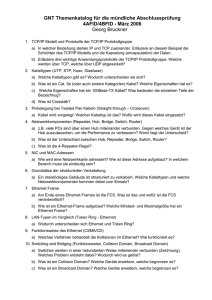

Zusammenfassung Communication Networks SS 2006 D

Werbung