Franke: Grundbegriffe der Statistik

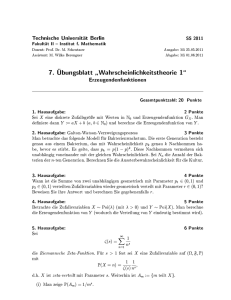

Werbung

Contents

1 Numerische und graphische Zusammenfassung quantitativer Daten

1.1

1.2

1.3

1.4

1.5

1.6

1.7

Lageparameter . . . . . . . . . . . . . . . . . . . .

Variabilitatskenngroen oder Streuungsparameter .

Der Box-Plot . . . . . . . . . . . . . . . . . . . . .

Das Histogramm . . . . . . . . . . . . . . . . . . .

Balkendiagramme und Paretodiagramme . . . . . .

Streudiagramme oder Scatter Plots . . . . . . . . .

Kovarianz und Korrelation als Abhangigkeitsmae

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Wahrscheinlichkeitstheoretische Grundlagen

2.1

2.2

2.3

2.4

2.5

2.6

2.7

2.8

2.9

2.10

Zufallsgroen, Ereignisse, Wahrscheinlichkeiten . . . . . . . .

Binomial- und hypergeometrisch verteilte Zufallsgroen . . .

Laplace-verteilte Zufallsgroen und rein zufallige Auswahlen .

Allgemeine diskrete Verteilungen . . . . . . . . . . . . . . . .

Verteilungen mit Dichten . . . . . . . . . . . . . . . . . . . .

Vier wichtige Klassen von Wahrscheinlichkeitsdichten . . . . .

Verteilungsfunktion und Quantile . . . . . . . . . . . . . . . .

Erwartungswert und Varianz von Zufallsgroen . . . . . . . .

Naherungsformeln fur Wahrscheinlichkeiten . . . . . . . . . .

Unabhangigkeit und Korrelation . . . . . . . . . . . . . . . .

3 Schatzer fur Verteilungsparameter

3.1

3.2

3.3

3.4

Punktschatzer . . . . . . . . . . . . . . . .

Vergleich verschiedener Schatzverfahren .

Intervallschatzer oder Kondenzintervalle

Kovarianz- und Korrelationsschatzer . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

2

3

5

6

9

10

11

13

13

17

22

23

27

30

35

38

44

45

50

50

54

57

62

4 Lineare Regression

63

5 Statistische Entscheidungsverfahren

67

5.1

5.2

5.3

5.4

5.5

5.6

5.7

5.8

Entscheidung zwischen zwei moglichen Mittelwerten (Signaldetektion)

Tests fur den Mittelwert einer normalverteilten Stichprobe . . . . . . .

Vergleich der Mittelwerte zweier normalverteilter Stichproben . . . . .

Tests fur die Varianzen normalverteilter Daten . . . . . . . . . . . . .

Test auf Unabhangigkeit zweier normalverteilter Stichproben . . . . .

Der Chi-Quadrat-Anpassungstest . . . . . . . . . . . . . . . . . . . . .

Kontingenztafeln und der Chi-Quadrat-Unabhangigkeitstest . . . . . .

Binomial- und Vorzeichentests . . . . . . . . . . . . . . . . . . . . . . .

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

67

70

74

75

80

81

88

90

1 Numerische und graphische Zusammenfassung quantitativer Daten

Seit die elektronische Datenverarbeitung sich durchgesetzt hat, werden uberall groe Datenmengen gesammelt

und { manchmal { auch analysiert. Die meisten realistischen Datensatze sind so gro, da das direkte Anschauen der Zahlenkolonnen keine nennenswerte Information bringt: Man sieht den Wald, d.h. die eigentliche

interessierende Struktur, vor lauter Baumen, d.h. vor lauter Einzelbeobachtungen, nicht mehr. Es ist daher

notig, die Masse an Informationen so weit wie moglich zu reduzieren { auf wenige numerische Strukturparameter

oder auf uberschaubare graphische Darstellungen.

Die Reduktion der Daten auf wenige Kenngroen darf allerdings nicht zu weit getrieben werden, da sonst

wichtige Feinheiten der Datenstruktur verschleiert werden. Um entscheiden zu konnen, wieviele und welche

Strukturparameter oder -kenngroen einen Datensatz in ausreichender Weise charakterisieren, braucht

man ein mathematisches Modell fur den Mechanismus, der die Daten erzeugt. Solche Modelle werden in den

folgenden Kapiteln vorgestellt. Mit ihrer Hilfe lat sich z.B. beurteilen, was in einem Experiment zufallige

Variabilitat und was interessanter Eekt ist. Mathematische Modelle fur die Erzeugung von Daten werden auch

spatestens dann benotigt, wenn man es mit mehrdimensionalen Beobachtungen zu tun hat, wo keine einfachen

graphischen Darstellungsmoglichkeiten mehr existieren.

In diesem Kapitel verzichten wir aber erst noch auf die Modellierung, sondern betrachten numerische und

graphische Zusammenfassungen eindimensionaler quantitativer Daten. Darunter verstehen wir numerische

Beobachtungen, d.h. auf naturliche Weise als Zahlen gegebene Meergebnisse. Als Gegensatz hierzu lassen

sich qualitativen Daten wie Antworten auf eine Frage nach dem Familienstand oder nach der Parteipraferenz

nur willkurlich Zahlen zuordnen. Hierzu gehoren auch Daten, die wie Zeugnisnoten geordnet und mit Zahlen

versehen sind, die aber nur fur Werturteile und nicht fur numerische Messungen stehen.

1.1 Lageparameter

Im folgenden betrachten wir einen Datensatz (oder eine Stichprobe) x1; : : : ; xN von reellen Zahlen. Die

Anzahl N der Daten heit Stichprobenumfang. Ein Lageparameter des Datensatzes gibt an, wo auf der

reellen Achse die Zahlenwerte x1; : : : ; xN liegen. Verschiebt man den ganzen Datensatz um einen konstanten

Wert c, d.h. geht man zu dem neuen Datensatz x1 + c; : : : ; xN + c uber, so andert sich ein Lageparameter

entsprechend durch Addition von c :

Ist ` ein Lageparameter des Datensatzes x1 ; : : : ; xN ; so ist `+c der entsprechende Lageparameter des Datensatzes

x1 + c; : : : ; xN + c:

Die beiden am haugsten benutzten Lageparameter sind das Stichprobenmittel (oder Mittelwert) xN sowie

der Stichprobenmedian (oder Zentralwert) x_ N : Das Stichprobenmittel ist das arithmetische Mittel der Daten:

Stichprobenmittel

N

X

xN = N1

xi = N1 (x1 + : : : + xN )

i=1

Der Stichprobenmedian ist der mittelste Datenwert, wenn N ungerade ist, bzw. die Mitte zwischen den beiden

mittelsten Datenwerten, wenn N gerade ist. Links bzw. rechts des Stichprobenmedians liegt jeweils etwa die

Halfte der Daten. Um ihn formal denieren zu konnen, mussen wir zuerst die Daten x1 ; : : : ; xN der Groe nach

ordnen. Wir erhalten dann die sogenannten Ordnungsstatistiken x(1) x(2) : : : x(N ) :

Die Ordnungsstatistiken x(1); : : : ; x(N ) sind die der Groe nach geordneten Daten x1; : : : ; xN ; wobei x(1)

der kleinste und x(N ) der grote Datenwert ist.

Stichprobenmedian

x_ N = x(m+1)

; falls N = 2m + 1 ungerade

x_ N = 21 fx(m) + x(m+1) g ; falls N = 2m

2

gerade

Das Stichprobenmittel ist einfach und schnell zu berechnen, lat sich direkt auf hoherdimensionale, d.h. vektorwertige Daten x1; : : : ; xN verallgemeinern und hat in bestimmten, oft benutzten mathematischen Modellen

gewisse Optimalitatseigenschaften (vgl. Kapitel 3.1). Der Stichprobenmedian ist dagegen unempndlich gegenuber wenigen, stark von der Mehrheit der Daten abweichenden Mewerten, sogenannten Ausreiern. In

Datensatzen, die vereinzelte grobe Me- oder Datenubertragungsfehler enthalten oder in denen es aus internen

Grunden seltene extreme Beobachtungen gibt, vermittelt der Stichprobenmedian einen besseren Eindruck, wo

sich die Mehrheit der Zahlenwerte x1; : : : ; xN bendet.

In der Praxis schadet es nichts, beide Lageparameter xN und x_ N zu berechnen. Stimmen sie in etwa uberein, so spielt es keine Rolle,

welchen der beiden Werte wir als Kenngroe fur die Lage des Datensatzes verwenden. Unterscheiden sie sich deutlich (relativ zur generellen

Groenordnung der Daten), so deutet dies auf die Anwesenheit von Ausreiern oder auf die Schiefe des Datensatzes hin (vgl. Kapitel 1.4).

10.4 10.9

11.1

11.5

11.6

Studienzeiten

11.7

11.9 13.1

13.18 = N

11 9 = _ N

13.1

13.3

14.7

16.8

21.3

x

:

8.06 9.13 9.25

9.40

9.53

9.57

x

Bauteillangen

9.57

9.73 10.08 10.25 10.38 10.52 10.98 11.24 12.91

10.04 = N

9 73 = _ N

x

:

8.06 9.13 9.40

x

Bauteillangen mit Ausreier ("Komma verschoben")

9.53

9.57

9.57

9.73

10.08 10.25 10.38 10.52 10.98 11.24 12.91 92.50

15 59 = N

10 08 = _ N

:

x

:

x

Ausfallzeitpunkte der Bauteile

0.43 9.44 22.25 26.09 26.83 29.54 32.68 34.46 37.66 38.02 38.77 38.91 39.20 41.37 42.58

30 55 = N

34 46 = _ N

:

x

:

x

1.2 Variabilitatskenngroen oder Streuungsparameter

Ein Streuungsparameter eines Datensatzes ist ein Ma fur die Groe des Bereichs, uber den die Zahlenwerte

x1; : : : ; xN verteilt sind. Er quantiziert also die Variabilitat der Daten. Verschiebt man den ganzen Datensatz

um einen konstanten Wert, so andert sich an der Variabilitat nichts:

Ist s ein Streuungsparameter des Datensatzes x1; : : : ; xN ; so ist s auch der entsprechende Streuungsparameter

des Datensatzes x1 + c; : : : ; xN + c:

Wir betrachten drei Streuungsparameter: die Stichprobenstandardabweichung sN ; die Spannweite dN

sowie die Viertelweite (oder Quartilenweite) dvN : Die Stichprobenstandardabweichung ist die Wurzel aus der

Stichprobenvarianz s2N , und diese ist wiederum in etwa die mittlere quadratische Abweichung der Zahlenwerte

x1; : : : ; xN von ihrem Mittelwert xN :

Stichprobenvarianz

N

X

s2N = N 1; 1 (xi ; xN )2

i=1

Man konnte auch die Summe der quadratischen Abweichungen (x1 ; xN )2 ; : : : ; (xN ; xN )2 durch N statt durch N ; 1 teilen, was in

manchen Buchern und Software-Paketen auch gemacht wird. Fur groe N ist der Unterschied vernachlassigbar. Unsere Denition hat den

Vorteil, da so die Formel fur die t-Statistik (vgl. Kapitel 5.2) einfacher wird.

Es liegt nahe, auch den Mittelwert der absoluten Abweichungen jx1 ; xN j; : : : ; jxN ; xN j zu betrachten, der auch ein Streuungsparameter

ware. sN hat aber mathematisch wesentlich angenehmere Eigenschaften, so da wir diesem Streuungsparameter den Vorzug geben.

3

min

Die Spannweite ist die Dierenz der groten Beobachtung xmax

N und der kleinsten Beobachtung xN ; d.h. die

Dierenz x(N ) ; x(1) der groten und kleinsten Ordnungsstatistik:

Spannweite

min

dN = xmax

N ; xN = x(N ) ; x(1)

Die Spannweite ist ein Ma fur die Gesamtgroe des Bereichs, uber den sich die Daten x1; : : : ; xN verteilen. Sie

hangt aber allein von den beiden extremen Beobachtungen ab und vermittelt kein Bild von der Variabilitat der

Mehrheit der Daten. Abbildung 1.2a zeigt z.B. zwei sehr verschiedene Datensatze mit derselben Spannweite.

Abbildung 1.2a

Auch sN hangt { wie das Stichprobenmittel xN { vergleichsweise stark von den extrem groen und kleinen Beobachtungen ab, ist also empndlich gegen Ausreier. Ein Streuungsparameter, der eine dem Stichprobenmedian

vergleichbare Unempndlichkeit gegenuber wenigen extremen Datenwerten aufweist, ist die Viertelweite. Sie

ist der Abstand zwischen dem oberen und dem unteren Viertelwert (oder Quartil) vNo bzw. vNu ; d.h. zwei

Werten uber bzw. unter denen etwa ein Viertel der Zahlenwerte x1; : : : ; xN liegen. Es gilt also

vNu x_ N vNo ;

und die beiden Viertelwerte und der Stichprobenmedian teilen den Datensatz in vier etwa gleich groe Teile:

alle Werte unterhalb von vNu ; zwischen vNu und x_ N ; zwischen x_ N und vNo sowie oberhalb von vNo :

Ist N + 1 durch 4 teilbar, d.h. N + 1 = 4m; so ist vNu der m-grote Datenwert x(m) und vNo der (3m)grote Datenwert x(3m): Andernfalls wird, ahnlich wie bei der Denition des Stichprobenmedians fur gerade N;

zwischen zwei Datenwerten interpoliert { wie, das hangt von dem Rest r ab, der beim Teilen von N + 1 durch

4 ubrig bleibt.

Viertelwerte

r = 0; N + 1 = 4m

: vNu = x(m)

vNo = x(3m)

r = 1; N + 1 = 4m + 1 : vNu =

vNo =

3x + 1x

4 (m) 4 (m+1)

r = 2; N + 1 = 4m + 2 : vNu =

vNo =

1 fx + x

(m+1) g

2 (m)

r = 3; N + 1 = 4m + 3 : vNu =

vNo =

1x + 3x

4 (m) 4 (m+1)

Viertelweite

dvN = vNo ; vNu

4

1x

3

4 (3m) + 4 x(3m+1)

1 fx

2 (3m) + x(3m+1) g

3x

1

4 (3m) + 4 x(3m+1)

1.47 2.68 3.41 3.48 3.86 4.41 5.86 6.09 6.14

1.91 = sN

6:33 = dN

3:27 = dvN

6.41

6.54

6.75

7.00

7.30 7.80

0.40 1.27 3.22 4.17 4.35 6.26 6.81 15.40 16.66 23.91 34.54 44.89

14.29 = sN

44:49 = dN

18:64 = dvN

Die absolute Groe der Variabilitat eines Datensatzes hangt entscheidend von der Skala ab, in der die Daten

gemessen werden. Eine Skalenanderung entspricht der Multiplikation aller Datenwerte mit einer Konstanten

c > 0 (z.B. c=100 beim U bergang von m zu cm; c = 0; 001 beim U bergang von msec zu sec), und mit

dieser Konstante werden sowohl Lage- wie auch Streuungsparameter multipliziert. Entsprechend erhalt man

aus einem Datensatz mit Streuungsparameter 1 durch eine Skalenanderung, d.h. durch Multiplikation mit der

Konstanten s > 0; einen Datensatz mit Streuungsparameter s: Daher nennt man Streuungsparameter auch

Skalenparameter.

Sind ` und s ein Lage- bzw. Streuungsparameter des Datensatzes x1; : : : ; xN ; so sind (fur c > 0) c` und cs die

entsprechenden Parameter des Datensatzes cx1; : : : ; cxN :

Streuungsparameter nehmen nur positive Werte (bzw. im Extremfall x1 = : : : = xN den Wert 0) an. Ihre

Einheit ist dieselbe wie die Einheit der Daten. s2N ist daher als quadratische Groe (Einheit z.B. kg2 fur

Messungen in der Einheit kg) selbst kein Streuungs- oder Skalenparameter.

1.3 Der Box-Plot

Der Box-Plot ist eine einfache und eingangige Methode, die numerische Information uber den Datensatz, die

in Stichprobenmedian, Viertelweite und Spannweite steckt, zu veranschaulichen. Besonders nutzlich ist dieses

Verfahren fur den Vergleich verschiedener Stichproben.

Wir unterscheiden beim Box-Plot Datensatze ohne Ausreier und Datensatze mit Ausreiern. Als Ausreier

betrachten wir hier einzelne Datenwerte, die um mehr als 1; 5 dvN oberhalb des oberen Viertelwerts vNo bzw.

unterhalb des unteren Viertelwerts vNu liegen.

Der Begri "Ausreier" wird in anderen Zusammenhangen auch anders prazisiert. Warum Beobachtungen, die um mehr als 1; 5 dvN von der

mittleren Halfte der Datenwerte entfernt liegen, als extrem angesehen werden, werden wir im Zusammenhang mit "normalen" Stichproben

untersuchen (vgl. Kapitel 2.8), sobald wir passende Modelle zur Verfugung haben.

Das Zentrum des Box-Plots besteht aus einem Rechteck, das den unteren mit dem oberen Viertelwert verbindet

und in das zusatzlich eine Trennlinie in Hohe des Medians eingezeichnet ist.

XNmin

vNu

vNo

X_ N

Box-Plot ohne Ausreier

XNmax

Sind keine Ausreier vorhanden, so schlieen sich links und rechts zwei Balken an, die bei der kleinsten Beobachtung XNmin = X(1) bzw. bei der groten Beobachtung XNmax = X(N ) mit einem Strich enden.

Sind Ausreier vorhanden, so enden die Balken auf der Seite der Ausreier bei vNu ; 1; 5 dvN bzw. vNo + 1; 5 dvN :

Die wenigen, daruber hinausgehenden Ausreier werden einzeln eingetragen (als Punkte, Sterne, Kreuze,...) und

5

bei Bedarf so markiert, da man sie identizieren kann, d.h. da man wei, welche speziellen Beobachtungen

extreme Werte angenommen haben.

XNmin

vNu

vNo

X_ N

vNo + 1; 5 dvN

extreme Werte

Durchschnittliches Pro-Kopf-Einkommen in den Vereinigten Staaten

Alaska

6315

Georgia

4091

Louisiana

3545

Montana

4347

North Dakota

5087

Tennessee

3821

Wyoming

4566

Arizona

4530

Hawaii

4963

Maine

3694

Nebraska

4508

Ohio

4561

Texas

4188

Arkansas

3378

Idaho

4119

Maryland

5299

Nevada

5149

Oklahoma

3983

Utah

4022

California

5114

Illinois

5107

Massachusetts

4755

New Hampshire

4281

Oregon

4660

Vermont

3907

Colorado

4884

Indiana

4458

Michigan

4751

New Jersey

5237

Pennsylvania

4449

Virginia

4701

Connecticut

5348

Iowa

4628

Minnesota

4675

New Mexico

3601

Rhode Island

4558

Washington

4864

Delaware

4809

Kansas

4669

Mississippi

3098

New York

4903

South Carolina

3635

West Virginia

3617

3000

3500

4000

4500

5000

5500

6000

Alabama

3624

Florida

4815

Kentucky

3712

Missouri

4254

North Carolina

3875

South Dakota

4167

Wisconsin

4468

Abbildung 1.3

1.4 Das Histogramm

Lage- und Streuungsparameter und die daraus abgeleiteten Box-Plots zeigen nicht alle eventuell interessanten

Eigenschaften eines Datensatzes. Beobachtet man die Lebensdauer mehrerer identischer technischer Bauteile,

so ist der resultierende Datensatz typischerweise rechtsschief, d.h. die meisten Beobachtungen konzentrieren

sich um den Stichprobenmedian herum, aber ein nennenswerter Anteil an Datenwerten ist groer, d.h. liegt

weiter rechts. Wir reden hier nicht von Ausreiern, sondern von typischen Daten; die Abweichungen von

Stichprobenmedian sind nur nach rechts hin systematisch groer als nach links. Tritt der umgekehrte Fall

ein, nennt man einen Datensatz linksschief. Solche Eigenschaften eines Datensatzes werden sichtbar, wenn

man sich ein Histogramm anschaut. Hierzu wird die reelle Achse in Intervalle unterteilt, und uber jedem

Intervall wird ein Rechteck gezeichnet, dessen Flache proportional zur Anzahl der Datenwerte xi ist, die in

dem betreenden Intervall liegen. Sind die Intervalle alle gleich lang (und nur diesen Fall betrachten wir im

6

folgenden), so wahlt man als Hohe des Rechtecks die Anzahl der xi im entsprechenden Intervall oder alternativ

die relative Haugkeit (= N1 Anzahl) der xi im Datensatz x1 ; : : : ; xN , die in das Intervall fallen. Man kann

das Histogramm auch als Funktion auassen, die auf den einzelnen Intervallen konstant ist:

Histogramm

Wahle Startpunkt a und Intervallbreite b > 0:

Unterteile (;1; 1) in Intervalle In = (a + (n ; 1)b; a + nb]; ;1 < n < 1; der Breite b:

Zahle, wieviele der Datenpunkte aus dem Datensatz x1; : : : ; xN in die einzelnen Intervalle

fallen:

Zn = Anzahl der i = 1; : : : ; N mit a + (n ; 1)b < xi a + nb

Histogramm der Anzahlen:

HN (x) = Zn fur x 2 In ; ;1 < n < 1:

Histogramm der relativen Haugkeiten:

hN (x) = N1 HN (x) = N1 Zn fur x 2 In ; ;1 < n < 1:

Da wir nur N Daten haben, sind nur endlich viele der Anzahlen Zn von 0 verschieden, und es gilt:

1

X

Zn = N :

0.0

6

0.05

8

10

0.10

12

0.15

14

16

0.20

n=;1

4

6

8

10

12

14

16

Abbildung 1.4a

2

20

0

0

4

40

6

60

Naturlich gibt es aufgrund der zufalligen Variationen in einem Datensatz nur selten ein perfekt symmetrisches

Histogramm (vgl. Abb. 1.4a). Man spricht daher nur von einem rechts- oder linksschiefen Datensatz, wenn das

Histogramm sehr deutlich asymmetrisch ist.

0

Abbildung 1.4b

7

2

4

6

8

Rechts- und Linksschiefe erkennt man auch am Box-Plot, wenn auch eventuell nicht so deutlich (s. Abb. 1.4b).

Ein weiteres Kennzeichen schiefer Datensatze ist es, da Stichprobenmittel und Stichprobenmedian sich stark

voneinander unterscheiden. Wir schreiben hier (lies: "sehr viel groer als") fur einen im Vergleich zur

Variabilitat der Daten nennenswerten Unterschied. Wo man die Grenze zwischen einem noch symmetrischen

und einem schiefen Datensatz zieht, ist aber subjektiv, solange wir kein Modell fur den datenerzeugenden

Mechanismus formuliert haben.

0

0

20

20

40

40

60

60

80

80

Ist xN x_ N ; so ist der Datensatz rechtsschief. Ist x_ N xN ; so ist der Datensatz linksschief.

1

2

3

4

5

1

Eruptionslaenge in min

Anfangspunkt x0 = 0; 75

2

3

4

5

Eruptionslaenge in min

Abbildung 1.4c

Anfangspunkt x0 = 0; 5

Der optische Eindruck, den ein Histogramm vermittelt, hangt bekanntlich deutlich von der Wahl der Intervalloder Zellenbreite b ab und kann auch { was weniger bekannt ist { wesentlich von der Wahl des Anfangspunktes

abhangen (s. Abb. 1.4c). Im Zweifelsfall kann man sich verschiedene Histogramme mit unterschiedlichen Wahlen

von a und b anschauen.

Faustregel: Wahle a so, da der Stichprobenmedian ungefahr in der Mitte eines Intervalls liegt.

max

Wahle b so, da das groe Intervall [xmin

N ; xN ], in dem uberhaupt Daten liegen, von

wenigstens 5 und hochstens 20 Teilintervallen der Lange b uberdeckt wird { je groer

N ist, desto groer sollte die Zahl der Teilintervalle sein. Dabei sollte die Anzahl der

Datenwerte N wenigstens das Funache der Anzahl der genannten Teilintervalle sein.

Unter Berucksichtigung dieser Gesichtspunkte wahlt man a und b der Einfachheit halber

als glatte Zahlen. Vermittelt das so gefundene Histogramm keinen zufriedenstellenden

Eindruck von den Daten, so variiert man b und eventuell auch a:

Eine andere interessante Eigenschaft eines Datensatzes, die sich eventuell am Histogramm erkennen lat, ist die

Zwei- oder Mehrgipigkeit (Bi- oder Multimodalitat), d.h. das Histogramm hat zwei oder mehrere deutliche

Maxima. Ein klassisches Beispiel ist die britische Einkommensverteilung, die in den funfziger und sechziger

Jahren eingipig (oder unimodal) war, wobei das Maximum dem "Mittelstandsbauch" entsprach, seither sich

aber zu einer deutlich zweigipigen Verteilung entwickelt hat mit zwei Maxima im niederen (Arbeitslose, Billigjobs,...) und im mittleren Bereich (Mittelstand). Zwei- oder Mehrgipigkeit des Histogramms deutet eventuell

darauf hin, da die Daten aus zwei unterschiedlichen Populationen erhoben worden sind.

Wie schon bei der Schiefe bleibt es ohne statistisches Modell und daraus abgeleiteten Verfahren dem subjektiven Urteilsvermogen des

Datenauswerters uberlassen, ob er lokale Nebenmaxima im Histogramm als zufalliges Phanomen oder als ernsthaften Hinweis auf die

Mehrgipigkeit des Datensatzes interpretiert. Im Beispiel steht die Zweigipigkeit auer Frage, aber in vielen Grenzfallen braucht man

entweder viel Erfahrung mit ahnlichen Datensatzen oder ein objektives statistisches Entscheidungsverfahren wie z.B. die in Kap. 5.6

beschriebenen Anpassungstests.

Die Willkur hinsichtlich der Wahl des Anfangspunktes a umgeht das sogenannte WARP-Verfahren (vgl. Hardle, Smoothing Techniques with

Implementation in S, Springer Verlag, 1991). Hierbei wird das Histogramm fur viele, jeweils leicht verschobene Anfangspunkte a1 ; : : : ; am

(m)

und stets dasselbe b berechnet (mit ak+1 ; ak = ; m = b); und die so entstehenden Histogramme h(1)

N ; : : : ; hN werden gemittelt. Die

resultierende Funktion

m

X

w (x) = 1 h(i) (x)

N

m i=1 N

8

ist unempndlich gegen den Einu des Anfangspunktes und hat geringere Sprunghohen, wirkt insgesamt also glatter (vgl. Abb. 1.4d,

rechts unten).

Abbildung 1.4d

1.5 Balkendiagramme und Paretodiagramme

%

0

10

20

30

40

Fur qualitative Daten u1; : : : ; uN ; die keine numerischen Werte annehmen, wird das Histogramm durch das

Balkendiagramm ersetzt. Hier wird in mehr oder weniger willkurlicher Anordnung zu jedem Wert, der in

u1; : : : ; uN vorkommt, ein Balken aufgetragen, dessen Hohe (bei jeweils derselben Breite) proportional zur

Anzahl der ui ; i = 1; : : : ; N, ist, die den betreenden Wert angenommen haben.

SPD

CDU

B90/Gr ne

andere

keine Angabe

Abbildung 1.5a: Umfrage zur Landtagswahl

Ein Paretodiagramm ist ein spezielles Balkendiagramm, das im Zusammenhang mit der Qualitatssicherung

betrachtet wird. Beobachtet werden die Ursachen fur das Versagen oder die unbefriedigende Leistung eines

9

Systems. Die Haugkeit der einzelnen Ursachen wird dann mit einem Balkendiagramm veranschaulicht. Dabei

zeigt sich oft die Gultigkeit von Paretos Regel (kein Naturgesetz und kein mathematischer Satz, sondern eine

Erfahrungstatsache, die in der Praxis oft, aber nicht immer bestatigt wird): Von vielen moglichen Ursachen fur

ein Ereignis leisten einige wenige den Hauptbeitrag.

Beispiel: Eine von einem Rechner kontrollierte Drehbank liefert zu oft unbefriedigende Ergebnisse. Die Bedienungsmannschaft registrierte

die folgenden Ursachen und ihre Haugkeiten: Fehler bei der Bedienung (14), Stromschwankungen (5), Instabilitat des Kontrollrechners

(24), zu spater Austausch eines abgenutzten Schneidkopfes (2), andere Grunde (6). Das Paretodiagramm zeigt deutlich, da zur Steigerung

der Qualitat in erster Linie die Fehleranfalligkeit des Rechners verringert und in zweiter Linie die Leistung der Bedienungsmannschaft

verbessert werden mu, wobei andere Fehlerquellen vernachlassigbar sind.

Abbildung 1.5b

1.6 Streudiagramme oder Scatter Plots

15

Bisher haben wir nur eindimensionale Daten betrachtet. Oft werden aber an ein und demselben Objekt zwei oder

mehr Messungen vorgenommen, fur deren wechselseitige Abhangigkeit man sich interessiert. Wir betrachten

einen zweidimensionalen Datensatz

x x 1

N

y1 ; : : : ; yN ; xi ; yi reellwertig:

Tragt man die Punkte mit Koordinaten xi ; yi in einem zweidimensionalen Koordinatensystem auf, so nennt

man dies ein Streudiagramm oder einen Scatter Plot. Hangen xi und yi nicht voneinander ab, so hat die

resultierende Punktwolke ungefahr die Form einer Ellipse mit zu den Koordinatenachsen parallelen Hauptachsen

(Abb. 1.6a). Die Ellipse wird zum Kreis, wenn die Variabilitaten der eindimensionalen Datensatze x1; : : : ; xN

bzw. y1 ; : : : ; yn in etwa gleich sind. Zeigt die Punktwolke eine steigende (Abb. 1.6b) bzw. fallende (Abb. 1.6c)

Tendenz, so hangen xi und yi (in erster Naherung linear) voneinander ab: je groer der Wert xi; desto groer

bzw. kleiner ist meist auch der Wert yi : Gelegentlich erkennt man am Scatterplot auch speziellere Formen der

Abhangigkeit zwischen xi und yi : Abb. 1.6d zeigt z.B. eine Situation, wo Vergroerung von xi bis zu einem

gewissen Sattigungswert auch yi vergroert, noch weitere Vergroerung von xi aber keinen Einu mehr auf yi

hat.

o

o

o

o

o

8

o

o

o o

o

o

6

oo

o

o

o

Y

o

o

5

o

o

o

o

0

o

o

o

o

o

o oo

oo

o o

o

oo

oo

o

oo

o ooo

o

o o

o

oo

o o o

o

o

o

oo

o

o oo

o

oo

o o

o o

oo

o

o oo

o

o

oo

o oo o

o

oo

o

o o oo

o

o

oo o oo

o

o

o

oo

o

oo

oo o

o o

oo

oo o

o

oo o o

o

oo

o o

o o o oo oo

o

o

o o

o

o

o

o

o

o

o

o

o

oo

o

o

o

o

-2

o

o

oo

o

o

o

o

4

o

o

o

o

o

oo o o

o

o oo

o

o o o

oo

o

o oo

o

o

o

o

o

oo

o

o

o o o

o

o

o o

oo

o

o o o

o

oo

o

o

o o

oo

o

o oo

oo o

o

o

oo o o

o

oo

o

o o

o

o o

o

o

o

o

o o

o

o

o

o

o

o

o o

o

o

o

o

o

oo

o

oo

o

o

o

o

o o o

oo

o

o

o

o

o

o

o

o

Y

o

2

o

ooo

o o

o

0

10

o

o

o

o

o

o

-2

0

2

4

6

8

0

2

4

6

X

X

Abbildung 1.6a

Abbildung 1.6b

10

8

o

o

o

o

o

o

o

oo

o

o

o

4

o

2

Y

-4

-2

o

oo o o

oo

oo

o o

o o o

o

o o o

o o o ooo

o o

o oo o oo

o

o o oo

o

ooo

o

o

ooo oo

o o o o

oo

o

o

o o

o

o

o

o

oo o oo

o

o

o o

o

o o o

o

o

-6

o

o

o

oo

oo

o

o oo o

o

o

o

oo o o

o

oo

o

o

o

o oo

o oo

o o

o

o o oo

o

o

o

-8

o

o

o

o

6

o

o

o

o

o

o

o

oo

o

o

8

o

o o

o

o

-2

o

o

o

4

o

o oo

o o oo o

oo

o

o o o o ooo o

o o

o oo

o

o

o

ooo o o

oo o o o o o ooo

o

o

o

oo

o

oooo

o

ooo

o

o

o

oooo

oo o oo

oo o o

o o o o oo

o

o

o

o

o ooo

o

o

o

o

o

o

o

o oo

o

o

o oo

oo oo o o o o

o o

o oo

o

o

o

o o o

o

oo

oo

ooo oo o

o

o

o

o o

oo o

o

o

oo

oo o

o oo o

o

o

o oo

oo

o

o

o o o oo o oo ooo o

o

o

o

o

o oo o o o o

o

o

oo

o

o

o

o

oo

oo

o

o

o

o

oo

o o

o

o

o

o

o

o

o

o

o

o

o

o o

o

2

o

o

o

o

0

o

o

6

o

o o

o

o

o

o

o

o

Y

o

o

0

0

o

10

0

2

X

4

6

8

X

Abbildung 1.6c

Abbildung 1.6d

1.7 Kovarianz und Korrelation als Abhangigkeitsmae

Die im Streudiagramm erkennbare Abhangigkeit zwischen xi und yi lat sich mit Hilfe der Stichprobenkovarianz c^N , dem Mittelwert der Produkte der durch Abziehen des jeweiligen Stichprobenmittels um 0 zentrierten

xi und yi , quantizieren:

Stichprobenkovarianz

N

X

c^N = N 1; 1 (xi ; xN )(yi ; y N )

i=1

Oft wird auch durch N statt durch N ; 1 dividiert. Wir ziehen diese Denition vor, da wir dann bei der folgenden Denition der

Stichprobenkorrelation direkt die Stichprobenstreuungen einsetzen konnen.

Wie die Stichprobenstreuung ist die Stichprobenkovarianz nicht invariant gegenuber A nderung der Skalen, in

denen die xi bzw. yi gemessen werden. Daher ziehen wir als Abhangigkeitsma die skalen- und verschiebungsinvariante Stichprobenkorrelation ^N vor:

Stichprobenkorrelation

P

s2N;x = N 1;1 Ni=1 (xi ; xN )2

P

s2N;y = N 1;1 Ni=1 (yi ; y N )2

^N

= sN;xc^NsN;y

Es gilt immer: ;1 ^N 1:

Man erhalt die Stichprobenkorrelation also aus der Stichprobenkovarianz, indem man durch die Stichprobenstandardabweichungen der x1 ; : : : ; xN und der y1 ; : : : ; yN dividiert. Unabhangig von den Skalen der xi und

yi nimmt ^N immer Werte zwischen ;1 und +1 an. Dies folgt sofort aus der Cauchy-Schwarz-Ungleichung

in RN ; wenn man benutzt, da bis auf den sich herauskurzenden Faktor N 1;1 die Stichprobenkovarianz das

Skalarprodukt und sN;x ; sN;Y die Normen der beiden Vektoren mit Koordinaten x1 ; xN ; : : : ; xN ; xN bzw.

y1 ; y N ; : : : ; yN ; y N sind.

Ist ^N die Stichprobenkorrelation zwischen x1; : : : ; xN und y1 ; : : : ; yN ; so ist ^N auch die Stichprobenkorrelation

zwischen

i ) x1 + cx ; : : : ; xN + cx und y1 + cy ; : : : ; yN + cy (Verschiebungsinvarianz)

ii) cx x1; : : : ; cxxN und cy y1 ; : : : ; cy yN fur cx ; cy > 0 (Skaleninvarianz)

11

73

o

o

o

o

o oo

o

72

o

o

o

o

o

o

o

o

o

o

71

o

o

o

o

o

o

o

o o

o

o

o

oo

o

o

o o

70

Lebenserwartung

o

o

o o

o

o

o

o

69

o

o

o

68

o

o

o

3000

3500

4000

4500

5000

5500

6000

Einkommen

Abbildung 1.7: Zusammenhang zwischen Pro-Kopf-Einkommen und Lebenserwartung in den USA (X : Einkommen, Y : Lebensdauer):

X N = 4435; 8 Y N = 70:88

c^N = 280:66

sN;X = 614:47 SN;Y = 1:34

^N = 0:34

12

2 Wahrscheinlichkeitstheoretische Grundlagen

Die datenanalytischen Verfahren des ersten Kapitels haben den Nachteil, da Schlusse subjektiv gezogen werden

und oft viel Erfahrung erfordern. Fragen wie "Ist ein Histogramm zweigipig, so da die Population, aus der

Daten stammen, in zwei Teile zerfallt, oder erweckt es nur zufallig den Eindruck der Zweigipigkeit?" oder

"Ist j^N j gro genug, um auf Abhangigkeit zwischen xi und yi schlieen zu konnen?" lassen sich aber auch mit

objektiven statistischen Entscheidungsverfahren in einer Weise beantworten, die jederzeit reproduzierbar ist.

Grundlage dieser Verfahren sind Modelle fur den datenerzeugenden Mechanismus. In diesem Kapitel entwickeln

wir solche Modelle und interpretieren die Modellparameter fur einen Datensatz aus unabhangigen, auf identische

Weise gewonnenen Daten (Zahlenwerte und qualitative Merkmale).

Zur Sprachregelung: Stochastik ist ein Sammelbegri fur Wahrscheinlichkeitstheorie und mathematische Statistik, beschreibt also die mathematische Disziplin, die sich mit der Modellierung und dem Studium des Zufalls beschaftigt. Stochastische Modelle sind dementsprechend mathematische Modelle, die den Zufall benutzen, um fur deterministische Betrachtungen zu komplexe Phanomene zu beschreiben. Paradebeispiel ist

der Wurfelwurf, dessen Ergebnis sich auf der Basis der klassischen Mechanik im Prinzip aus Handhaltung,

Luftwiderstand, Reibung, Rollverhalten, ... exakt vorausberechnen lat. Das physikalische System ist aber viel

zu kompliziert, um diese deterministischen Rechnungen durchfuhren zu konnen. Stattdessen kann man fur viele

Zwecke ein einfaches stochastisches Modell benutzen: Das Ergebnis des Wurfelwurfes ist eine Zufallsgroe mit

Werten in der Menge f1; 2; 3; 4; 5; 6g; wobei jede Zahl 1; : : : ; 6 dieselbe Wahrscheinlichkeit 61 hat, als Wert der

Zufallsgroe aufzutreten.

2.1 Zufallsgroen, Ereignisse, Wahrscheinlichkeiten

Wir betrachten eine Messung oder eine andere Art von Feststellung eines numerischen oder qualitativen Merkmals,

deren Ergebnis in einem Werteraum X liegt. Wiederholte Messungen derselben Art fuhren zu unterschiedlichen Ergebnissen. Wir modellieren den einzelnen Mevorgang, indem wir von einem Zufallsmechanismus

ausgehen, dessen einmalige Betatigung eine Zufallsgroe X mit Werten in X liefert. Betatigen wir den Zufallsmechanismus wiederholt, so produziert er verschiedene Realisationen der Zufallsgroe X.

X heit in diesem Zusammenhang eine quantitative Zufallsgroe, wenn der Werteraum X auf naturliche Weise

als Teilmenge der reellen Zahlen oder allgemeiner des Rd fur ein d 1 aufgefat werden kann. Quantitative

Zufallsgroen haben also Zahlen oder Vektoren als Werte.

Beispiele: i)

ii)

iii)

iv)

R

Korpergroe eines Menschen: X = (0; 1) Anzahl der defekten Gerate in einer Tagesproduktion von 100 Geraten: X = f0; 1; : : : ; 100g Lange, Breite, Hohe eines Quaders X = (0; 1) (0; 1) (0; 1) 3

Alter und Gewicht eines Menschen X = f0; 1; 2; : : : g (0; 1) 2

RR

R

X heit andernfalls eine qualitative Zufallsgroe. In diesem Fall lassen sich den moglichen Werte aus X gar

nicht oder nur willkurlich Zahlen zuordnen.

Beispiele: i)

ii)

iii)

iv)

v)

Familienstand eines Menschen: X = f ledig, verheiratet, verwitwet, geschieden, keine Angabe g

Meinungsauerung auf Frage nach Tempo 100 auf der Autobahn: X = fdagegen, dafur, egal, keine Angabeg

Farbe eines bestellten Neuwagens: X = f rot, grun, blau, wei, schwarz, ... g

Zeugnisnote in einem Schulfach: X = f1; 2; 3; 4; 5; 6g

Ergebnis eines Wurfelwurfs: X = f1; 2; 3; 4; 5; 6g

Eine besonders einfache Klasse von Zufallsmechanismen, die sowohl qualitative wie quantitative Zufallsgroen

(hier: Anzahlen) liefern konnen, sind die Laplace-Mechanismen. Sie treten bei der rein zufalligen Auswahl

eines Individuums aus einer endlichen Menge auf und bilden so die Grundlage von Stichprobenverfahren in z.B.

Marktforschung oder Qualitatskontrolle.

Denition 1: A sei eine endliche Menge.

1. Ein geordnetes n-tupel von Elementen aus A, d.h. eine Anordnung (evtl. mit Wiederholungen) von

Elementen aus A, heit Stichprobe vom Umfang n.

2. Ein Mechanismus, der wiederholt aus A ein Element auswahlen kann, so da fur alle n 1 bei n-maliger

Betatigung jede Stichprobe vom Umfang n dieselbe Chance hat, als Ergebnis aufzutreten, heit LaplaceMechanismus. Die einzelnen Wahlen heien unabhangige Realisierungen des Mechanismus.

13

3. Die einmalige Betatigung des Mechanismus liefert eine Laplace-verteilte Zufallsgroe mit Werten in

X = A:

Beispiele:

i) A = f1; : : : ; 6g: (1; 3; 4; 1; 3) und (1; 2; 4; 6; 5) sind zwei Stichproben vom Umfang n = 5: Ein zu A passender

Laplace-Mechanismus ware das wiederholte Werfen eines idealen,

d.h. vollig regelmaigen Wurfels. Jede

der beiden genannten Stichproben hatte dieselbe Chance (= ( 61 )5 ); das Ergebnis funfmaligen Wurfelns zu

sein.

ii) Gegeben sei eine Urne mit gleich vielen roten (r), schwarzen (s) und blauen (b) Kugeln und A = fr; s; bg: 8tupel wie (r; s; s; s; b; r; b; b) oder (s; r; b; b; r; r; s; s) haben beim wiederholten Ziehen mit Zurucklegen jeweils

dieselbe Chance (= ( 13 )8 ); als Ergebnis des sukzessiven Ziehens realisiert zu werden.

Um andere Typen von Zufallsmechanismen und Zufallsgroen charakterisieren zu konnen, brauchen wir die

Begrie Ereignis, Wahrscheinlichkeit und Verteilung.

Sprechweisen: X sei eine Zufallsgroe mit Werten in der Menge X :

1. Beobachtbare Ereignisse sind von der Form fX 2 B g, wobei B eine beliebige, nicht pathologische

Teilmenge von X ist. Nach Betatigen des Zufallsmechanismus, der X erzeugt, steht fest, ob ein solches

Ereignis eingetreten ist oder nicht.

2. Jedem Ereignis fX 2 B g wird eine Wahrscheinlichkeit Ws(X 2 B) zugedacht, d.h. eine Zahl zwischen

0 und 1, die die Chance, da fX 2 B g eintrit, mit. Diese Zuordnung erfullt:

Ist Ws(X 2 B) = 0, so ist fX 2 B g ein unmogliches Ereignis, das zwar hypothetisch vorstellbar, in

der Praxis aber nicht realisierbar ist. Ist Ws(X 2 B) = 1; so ist fX 2 B g ein sicheres Ereignis.

3. Die Abbildung P; die jeder (nicht pathologischen) Teilmenge B von X die Wahrscheinlichkeit Ws(X 2 B)

des zugehorigen Ereignisses zuordnet, heit die Verteilung von X:

P : f nicht pathologische Teilmenge von Xg ;! [0; 1]

P (B) := Ws(X 2 B)

Wegen 2) gilt insbesondere:

P (;) = Ws(X 2 ;) = 0

P (X ) = Ws(X 2 X ) = 1

R

Beispiel: X sei die Lebensdauer (in Tagen) einer Gluhbirne, die ununterbrochen brennt. Ein passender Werteraum ist

X = [0; 1) :

Beobachtbare

und interessierende Ereignisse sind z.B. fX 5:5g = fX 2 [0; 5:5]g, d.h. die Gluhbirne brennt

hochstens 5 12 Tage lang, oder f7 < X 28g = fX 2 (7; 28]g; d.h. die Gluhbirne brennt in der 2.-4. Woche durch.

Ein grobes Modell fur die Lebensdauer von Gluhbirnen geht davon aus, da es ein geeignetes > 0 gibt mit

Ws(X 5:5) P ([0; 5:5]) = 1 ; e;5:5

Ws(7 < X 28) P ((7; 28]) = e;7 ; e;28

Allgemein gilt fur diese Verteilung P , die sogenannte Exponentialverteilung:

P ([a; b]) Ws(a X b) = e;a ; e;b fur alle 0 a b < 1

Bevor wir einige einfache, praktisch wichtige Verteilungen kennenlernen, ist es nutzlich, ein paar Rechenregeln

fur Wahrscheinlichkeiten anzuschauen. An ihnen erkennt man, da zur Angabe einer Verteilung nur die Wahrscheinlichkeiten einfacher Ereignisse vorgegeben werden mussen. Daraus lassen sich dann mit den folgenden

Regeln Wahrscheinlichkeiten beliebiger Ereignisse berechnen.

Vorher ist ein kurzer Ruckblick auf einige Begrie der Mengenlehre notig: A; B seien Teilmengen des Werteraums

X.

Kann

nur endlich oder abzahlbar viele verschiedene Werte aus X annehmen, so ist f 2 g fur jede Teilmenge X ein

beobachtbares Ereignis. Hat einen kontinuierlichen Wertebereich, z.B. alle positiven reellen Zahlen bei einer Langenmessung, so

mussen gewisse pathologische Teilmengen von X aus den Betrachtungen ausgeschlossen werden. Solche Teilmengen sind aber sehr

kompliziert und lassen sich nur mit erheblichem mathematischen Aufwand beschreiben. In einfachen praktischen Situationen, wie

wir sie in diesem Skript durchweg betrachten, treten solche pathologischen Situationen nicht auf.

X

X

X

14

B

B

i) Die Vereinigung A [ B von A und B ist die Menge aller Werte in X , die zu A oder zu B gehoren.

ii) Der Durchschnitt A \ B von A und B ist die Menge aller Werte in X , die zu A und zu B gehoren.

iii) A und B heien disjunkt, wenn sie keine gemeinsamen Elemente haben, d.h. wenn A \ B die leere Menge

; ist.

iv) Das Komplement Ac von A ist die Menge aller Werte in X , die nicht zu A gehoren.

Diese mengentheoretischen Begrie lassen sich leicht in der Sprache der Ereignisse, deren Eintreten oder

Nichteintreten uns interessiert, interpretieren:

i) fX 2 A [ B g tritt ein, wenn wenigstens eines der Ereignisse fX 2 Ag oder fX 2 B g eintritt.

ii) fX 2 A \ B g tritt ein, wenn beide Ereignisse fX 2 Ag und fX 2 B g eintreten.

iii) Wenn A; B disjunkt sind, so schlieen die Ereignisse fX 2 Ag und fX 2 B g einander aus, d.h. es kann

hochstens eines der beiden eintreten.

iv) fX 2 Ac g = fX 2= Ag tritt ein, wenn fX 2 Ag nicht eintritt.

Beispiel: Wir betrachten in erster Linie endliche oder abzahlbare Mengen oder Teilintervalle der reellen Zahlen.

i) X = fa; b; c; : : : ; zg seien die Buchstaben des Alphabets.

Fur A = fa; b; c; d; e; f g; B = fa; d; g; j; mg ist A [ B = fa; b; c; d; e; f; g; j; mg; A \ B = fa; dg:

Die Mengen A = fa; b; cg; B = fh; k;w; zg sind disjunkt.

Die Menge A

=

fa; e; i; o:ug der Vokale hat als Komplement Ac

fb; c; d; f; g; h; j; : : : ; n; p; : : : ; t; v; : : : ; zg; die Menge der Konsonanten.

ii) [0; 2] [ [1; 5] = [0; 5] [0; 2] \ [1; 5] = [1; 2]

(;1; 0] und c(0; 1] sind cdisjunkt.

fx; jxj 1cg = [;1; 1]c = (;1; ;1) [ (1; 1) = fx; jxj > 1g

fx; x cg = (;1; c] = (c; 1) = fx; x > cg

15

=

Die ersten drei Rechenregeln fur Wahrscheinlichkeiten wurden von Kolmogorow als Postulate gefordert, d.h.

nur solche Zuordnungen von Zahlenwerten zu Ereignissen wurden als Wahrscheinlichkeiten betrachtet, die diese

Kolmogorowschen Axiome erfullen:

Fur alle (nicht pathologischen) B; B1 ; B2 ; : : : X gilt:

W1) 0 Ws(X 2 B) 1

W2) Ws(X 2 X ) = 1

W3) Sind B1 ; B2 ; : : : paarweise disjunkt, d.h. Bi \ Bj = ; fur i 6= j; so gilt:

Ws(X 2 Bj fur ein j = 1; 2; : : :) Ws(X 2

1

[

j =1

Bj ) =

1

X

j =1

Ws(X 2 Bj ):

W1 und W2 besagen, da Wahrscheinlichkeiten immer Zahlen zwischen 0 und 1 sind und da das sichere

Ereignis fX 2 Xg den maximal moglichen Wahrscheinlichkeitswert zugeordnet bekommt. Entscheidend ist W3,

die sogenannte abzahlbare Additivitat: wenn die Ereignisse fX 2 Bj g einander ausschlieen, dann ist die

Wahrscheinlichkeit, da uberhaupt eines von ihnen eintritt (es kann ja hochstens eines eintreten), die Summe

der Wahrscheinlichkeiten, da die einzelnen Ereignisse eintreten.

Beispiel:

R

i) X sei eine reellwertige Zufallsgroe, d.h. X = : Die halboenen Intervalle (0; 1]; (1; 2]; (2; 3]; : : : sind paarweise

disjunkt, und

1

[

(j ; 1; j ] = (0; 1] [ (1; 2] [ (2; 3] [ : : : = (0; 1)

Mit W3 folgt so:

j=1

Ws(X > 0) = Ws(X 2 (0; 1)) =

1

X

j=1

Ws(X 2 (j ; 1; j ]) =

1

X

j=1

Ws(j ; 1 < X j )

ii) A = fa1 ; : : : ; am g X sei eine endliche Menge. Ist Ws(X = aj ); j = 1; : : : ; m; bekannt, so lat sich

Ws(X 2 B) fur alle Teilmengen B A berechnen, z.B. fur B = fa1 ; a3 ; a6 g = fa1 g [ fa3 g [ fa6 g :

Ws(X 2 B) = Ws(X = a1 ) + Ws(X = a3 ) + Ws(X = a6 )

oder allgemeiner, da B = Si;ai 2B fai g d.h. B ist Vereinigung seiner Elemente:

Ws(X 2 B) =

X

i;ai 2B

Ws(X = ai )

Als Spezialfalle von W3 ergeben sich drei einfache Regeln, die wir im folgenden oft benutzen:

Fur alle (nicht pathologischen) B; C X gilt:

W3a) Sind B; C disjunkt, d.h. fX 2 B g; fX 2 C g schlieen einander aus, so gilt:

Ws(X 2 B oder X 2 C) Ws(X 2 B [ C) = Ws(X 2 B) + Ws(X 2 C)

W3b) Ws(X 2= B) = 1 ; Ws(X 2 B)

W3c) Ist B C; d.h. aus fX 2 B g folgt fX 2 C g; so gilt:

Ws(X 2 B) Ws(X 2 C)

W3a folgt aus W3, wenn man dort B1 = B; B2 = C und Bj = ; fur alle j 3 wahlt. W3b folgt aus W3a fur C = Bc und aus der

Tatsache, da fX 2 Bg oder fX 2= Bg auf jeden Fall eintritt, als sicheres Ereignis also die Wahrscheinlichkeit 1 hat:

Ws(X 2 B) + Ws(X 2= B) = Ws(X 2 B oder X 2= B) = 1 :

16

Fur W3c sei B0 der Teil von C; der nicht zu B gehort. B; B0 sind dann disjunkt, und B [ B0 = C , so da wegen W3a:

Ws(X 2 B) = Ws(X 2 C ) ; Ws(X 2 B0 ) Ws(X 2 C ):

i) B = f0g; C = f1g: Wegen W3a: Ws(X = 0 oder X = 1) = Ws(X = 0) + Ws(X = 1)

ii) B = (0; 1): Wegen W3b: Ws(X 0) = 1 ; Ws(X > 0)

iii) B = (0; 1); C = [0; 1) = f0g [ B: Wegen W3c: Ws(X > 0) Ws(X 0)

Die Begrie Zufallsgroe, Zufallsmechanismus und damit der daraus abgeleitete Begri Ereignis haben in diesem Abschnitt im Mittelpunkt

des Interesses gestanden, sind aber nicht in einem mathematisch exakten Sinn deniert worden. Das ist im Rahmen dieses auf Anwendungen

zielenden Skriptes auch nicht notwendig. Es reicht aus, sich einen Zufallsmechanismus als die idealisierte Form einer Apparatur vorzustellen,

die bei wiederholter Betatigung verschiedene Ergebnisse liefert. Das Gedankenkonstrukt Zufallsmechanismus dient dann als idealisiertes

Modell fur reale, datenproduzierende Vorgange.

Beispiel:

Der Begri Wahrscheinlichkeit lat sich dagegen uber die Kolmogorowschen Axiome als eine Abbildung von (einem Teilsystem der)

Teilmengen von X in das Intervall [0; 1] auassen, die gewisse Rechenregeln erfullt. Diese Denition ist mathematisch exakt genug, um im

folgenden damit arbeiten zu konnen. Der Kern eines stochastischen Modells fur einen datenerzeugenden Mechanismus ist daher immer die

Angabe des Werteraums X und der zugehorigen Wahrscheinlichkeiten Ws(X 2 B); B X (B nicht pathologisch), d.h. die Angabe der

Verteilung.

Ein stochastisches Modell benutzt man in Situationen, wo eine Messung kein deterministisches, d.h. kein

sicher vorhersagbares, Ergebnis hat. Das Ergebnis der Messung liege aber auf jeden Fall in der Menge X . Als

Modell fur eine solche Messung dient dann die Realisation einer Zufallsgroe X mit Werteraum X , und es wird

speziziert durch Angabe der Wahrscheinlichkeiten Ws(X 2 B); B X (nicht pathologisch).

2.2 Binomial- und hypergeometrisch verteilte Zufallsgroen

Die Verteilungen dieses Abschnitts spielen eine wichtige Rolle in der Stichprobentheorie und damit bei Umfragen

und in der Qualitatssicherung.

Fur n 1 und 0 < p < 1 nennen wir eine Zufallsgroe X mit Werten in X = f0; : : : ; ng binomialverteilt

zum Parameter (n; p); wenn

n

Ws(X = k) = k pk (1 ; p)n;k ; k = 0; : : : ; n :

Als Kurzschreibweise benutzen wir dafur: 00 X ist B(n; p)-verteilt".

; Zur Erinnerung: Die Binomialkoezienten nk { lies: n uber k { sind deniert durch

n!

n(n ; 1) : : : (n ; k + 1)

k = k!(n ; k)! = 1 2 : : : (k ; 1) k ; k = 0; : : : ; n;

n

wobei k! = 1;n2 : :;:n(k ; 1) k { lies: k-Fakultat { fur k 2 und 0! = 1! = 1 :

Speziell gilt 0 = n = 1 :

Der binomische Lehrsatz zeigt, da die Rechenregel W2: Ws(X 2 X ) = 1 erfullt ist:

Ws(X 2 X ) =

n

X

k=0

Ws(X = k) =

n n

X

k=0 k

pk (1 ; p)n;k = (p + 1 ; p)n = 1 :

Modellbildung: Binomialverteilte Zufallsgroen treten im Zusammenhang mit folgender Situation auf: Es

werden n unabhangige, gleichartige Versuche durchgefuhrt, die nur zwei mogliche Ergebnisse haben konnen.

Wir nennen diese beiden Ergebnisse stets Erfolg und Mierfolg, wobei wir an n technische oder wissenschaft-

liche Experimente denken. Bei Meinungsumfragen tritt eine solche Situation auf, wenn n Personen eine Frage

gestellt wird, die sie nur mit "Ja" oder "Nein" beantworten konnen. Angenommen, ein Einzelversuch fuhrt mit

Wahrscheinlichkeit p zum Erfolg { und damit wegen W3b mit Wahrscheinlichkeit 1 ; p zum Mierfolg:

Ws(Erfolg) = p ; Ws(Mierfolg) = 1 ; p :

Dann ist die Zufallsgroe

X = Anzahl der Erfolge in n Versuchen

B(n; p)-verteilt.

17

Spezialfall (Stichprobenziehen mit Zurucklegen): Gegeben seien N Objekte (oder Personen), von denen

genau M ein bestimmtes Merkmal haben. Wir wahlen nacheinander n dieser Objekte aus, wobei bei jedem

Ziehungsvorgang alle Objekte { also auch die bereits gezogenen { in Frage kommen. Als Endergebnis erhalten

wir eine Stichprobe vom Umfang n aus der Menge der N Objekte. Dann kann man mit Hilfe der Kombinatorik

zeigen:

X = Anzahl der gezogenen Objekte, die das Merkmal besitzen

ist B(n; p)-verteilt mit p = MN : Wenn man bei den gezogenen Objekten nur darauf achtet, ob sie das Merkmal

besitzen oder nicht, so ist jede Einzelziehung ein Versuch mit nur zwei moglichen Ausgangen, so da das Ziehen

einer Stichprobe mit Zurucklegen in diesem Sinn ein Spezialfall der obigen Modellbildung ist. "Erfolg" entspricht

dabei dem Ziehen eines Objektes mit dem Merkmal.

Binomialverteilte Zufallsgroen treten als Anzahlen von Erfolgen in n Versuchen auf. Sie lassen sich daher

als Summe sogenannter 0-1-Zufallsgroen (oder auch Bernoulli-verteilter Zufallsgroen) schreiben. Eine

solche 0-1-verteilte Zufallsgroe Y kann nur die beiden Werte 0 oder 1 annehmen, und ihre Verteilung ist durch

die Wahrscheinlichkeit p, da Y = 1 ist, gegeben:

Ws(Y = 1) = p; Ws(Y = 0) = 1 ; p fur ein 0 < p < 1 :

Durch Vergleich mit der Denition einer binomialverteilten Zufallsgroe im Spezialfall n = 1 sieht man, da

eine 0-1-verteilte Zufallsgroe nichts anderes als eine B(1; p)-verteilte Zufallsgroe ist.

Wir stellen uns nun eine Versuchsreihe von n unabhangigen, identischen Versuchen vor, die als Ergebnis jeweils

nur "Erfolg" oder "Mierfolg" haben konnen, und wir setzen fur j = 1; : : : ; n :

Yj = 1 , falls Erfolg im j-ten Versuch

Yj = 0 , falls Mierfolg im j-ten Versuch.

Y1 ; : : : ; Yn sind dann n unabhangige 0-1-Zufallsgroen mit demselben Parameter p:

p = Ws(Erfolg) = Ws(Yj = 1) ; j = 1; : : : ; n ;

und die Anzahl der Erfolge in den n Versuchen ist

X=

n

X

j =1

Yj = Anzahl der Erfolge in n Versuchen.

X ist, wie oben bereits behauptet, B(n; p)-verteilt.

Diese Aussage lat sich beweisen, wenn das vorerst noch heuristische Konzept der "Unabhangigkeit" von Versuchen oder { allgemeiner {

von Zufallsgroen prazisiert wird (vgl. Kap. 2.10). Wir verzichten aber im Rahmen dieses Skripts auf den Beweis.

Binomialverteilung

Werteraum X ;= f0; : : : ; ng; Parameter n 1; 0 < p < 1

Ws(X = k) = nk pk (1 ; p)n;k ; k = 0; : : : ; n

Schreibweise: X ist B(n; p)-verteilt

Spezialfall fur n = 1 : 0-1-Zufallsgroe Y

Werteraum X = f0; 1g; Parameter 0 < p < 1

Ws(Y = 1) = p; Ws(Y = 0) = 1 ; p

Schreibweise: Y ist B(1; p)-verteilt

18

0.8

0.6

0.15

0.4

0.10

0.0

0.2

0.05

0.0

0

1

2

3

4

5

6

7

8

9 10 11 12 13 14 15 16 17 18 19 20

0

Ws(X = k) fur n = 20 und p = 0; 5

1

2

3

4

5

6

7

8

9 10 11 12 13 14 15 16 17 18 19 20

Ws(X = k) fur n = 20 und p = 0; 1

Abbildung 2.2a

Beispiel:

i) n Personen mit Kopfschmerzen erhalten ein neues Medikament und geben an, ob der Schmerz nachlat (Erfolg) oder nicht (Mierfolg).

Wir setzen

Yj = 1, wenn das Medikament beim j -ten Patienten gewirkt hat

Yj = 0, andernfalls.

Ist p = Ws(Yj = 1) die Wahrscheinlichkeit, da das Medikament bei einem rein zufallig ausgewahlten Kopfschmerzpatienten wirkt,

so ist

n

X

X = Yj = Anzahl der Erfolge in den n Versuchen

j=1

binomialverteilt zum Parameter (n; p):

ii) Bei n jungen Kraftfahrern wird registriert, ob sie das

erste Jahr nach Erwerb des Fuhrerscheins unfallfrei uberstehen (Erfolg, Yj = 1)

oder nicht (Mierfolg, Yj = 0). Die Anzahl X = Pnj=1 Yj der Fahrer ohne Unfall ist dann B(n; p)-verteilt mit p = Ws(Yj = 1) =

Ws("unfallfrei").

iii) Umfragen unter Unternehmern uber ihre Einschatzung der zukunftigen Geschaftsentwicklung dienen zur Einschatzung der wirtschaftlichen Lage. Um die Verlalichkeit solcher Prognosen zu uberprufen, wird bei den n befragten Personen nach einem Jahr nachgefragt,

ob die ursprungliche Einschatzung sich bewahrheitet hat (Erfolg, Yj = 1) oder nicht (Mierfolg, Yj = 0). Die Zahl der Unternehmer,

die die Entwicklung ihrer Firma richtig eingeschatzt haben, ist dann X = Pnj=1 Yj und somit binomialverteilt.

Fur n; M N nennen wir eine Zufallsgroe X mit Werten X = f0; : : : ; min(n; M)g hypergeometrisch verteilt

zum Parameter (n; M; N) ; wenn

;M ;N ;M Ws(X = k) = k ;Nn;k ; k = 0; : : : ; min(n; M)

n

Als Kurzschreibweise benutzen wir dafur: 00 X ist H(n; M; N);verteilt".

Modellbildung (Stichprobenziehen ohne Zurucklegen): Gegeben seien wie oben N Objekte (oder Personen), von denen genau M ein bestimmtes Merkmal haben. Wir wahlen nacheinander n Objekte aus, wobei

einmal gewahlte Objekte nicht wieder gewahlt werden konnen. Das Ergebnis ist eine Stichprobe vom Umfang

n ohne Wiederholungen, d.h. jedes Objekt erscheint hochstens einmal in der Stichprobe. Dann folgt mit

Hilfe der Kombinatorik:

X = Anzahl der gezogenen Objekte, die das Merkmal besitzen

ist H(n; M; N)-verteilt. Es spielt in diesem Zusammenhang ubrigens keine Rolle, ob die Objekte nacheinander

gezogen werden oder ob simultan n Stuck aus der Gesamtheit von N Objekten gewahlt werden. Wichtig ist

allein, da alle Objekte dieselbe Chance haben, in der Stichprobe enthalten zu sein, und da jedes Objekt

hochstens einmal in der Stichprobe auftreten kann.

19

Hypergeometrische Verteilung

Werteraum X = f0; : : : ; min(n; M)g; Parameter n; M N

;M ;N ;M Ws(X = k) = k ;Nn;k ; k = 0; : : : ; min(n; M)

n

0.0

0.05

0.10

0.15

Schreibweise: X ist H(n; M; N)-verteilt

0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23

Abbildung 2.2b: Ws(X = k) fur N = 300; M = 100; n = 30

Anwendungsfeld Qualitatskontrolle:

Um die Qualitat von Produkten zu uberprufen, werden (wenn die Tests kostenintensiv oder destruktiv sind)

nur Stichproben aus der Produktion genau untersucht. In der Form der Endkontrolle fuhrt der Produzent

diese Tests selbst durch: aus einer Tagesproduktion von N Geraten wird eine Stichprobe von n Stuck gezogen

und genau untersucht. Bei der Abnahmekontrolle fuhrt der Kaufer der Gerate oder eine fur die Einhaltung

gesetzlich festgelegter Mindestanforderungen verantwortliche Behorde die entsprechenden Tests durch: aus einer

Lieferung oder einem sogenannten Los von N Geraten wird eine Stichprobe von n Stuck gezogen und untersucht.

Mathematisch unterscheiden sich diese beiden Falle vorerst nicht; die unterschiedlichen Interessen von Produzent

und Abnehmer mussen aber spater bei der Entwicklung statistischer Entscheidungsverfahren berucksichtigt

werden. M ist jeweils die { unbekannte { Gesamtzahl defekter Gerate in der Tagesproduktion bzw. in der

Lieferung. Das "Merkmal", das manche Objekte haben, ist also die Eigenschaft, den Qualitatsanspruchen nicht

zu genugen.

X = Anzahl der defekten Gerate in der Stichprobe vom Umfang n

ist also eine hypergeometrisch verteilte Zufallsgroe. X wird in der Qualitatskontrolle dazu benutzt, Ruckschlusse

auf das unbekannte M zu ziehen und eine Entscheidung zu treen, ob z.B. eine Maschine gewartet werden mu

oder ob eine Lieferung vom Kunden abgelehnt wird.

Bei der Qualitatskontrolle ist es in der Praxis wichtig, da die Stichprobe rein zufallig aus der Gesamtheit von N Objekten gezogen

wird. Jedes Gerat mu dieselbe Chance haben, getestet zu werden. Man erreicht dies z.B., indem man die Gerate numeriert und einen

Zufallszahlengenerator n Nummern auswahlen lat. Andernfalls kann es zu schwerwiegenden Fehlschlussen kommen: Untersucht man

bei der Endkontrolle nur vormittags produzierte Gerate, so wird eine nachmittags durch Ermudungserscheinungen des Personals deutlich

nachlassende Qualitat nicht entdeckt. Untersucht man bei einer Abnahmekontrolle nur solche Gerate, die im Container vorne stehen, so

konnten diese z.B. aus einer fehlertrachtigeren Montagsproduktion stammen und so zur falschlichen Ablehnung der in Wahrheit aus allen

Wochentagen gemischten und qualitatsmaig befriedigenden Lieferung fuhren.

Wenn M und N ; M beide sehr viel groer als n sind, d.h. wenn die Stichprobe klein gegenuber der Zahl der

Objekte mit und ohne Merkmal ist, dann lat sich eine hypergeometrisch verteilte Zufallsgroe mit Parameter

(n; M; N) durch eine binomialverteilte Zufallsgroe mit Parameter (n; p) und p = MN approximieren:

20

X sei H(n; M; N)-verteilt

kmit M;Nn;;k M n

;

Ws(X = k) nk MN

1 ; MN

d.h. H(n; M; N) B(n; MN ) fur M; N ; M n

o

o

0.25

o

0.15

o

o

0.20

o

o

0.15

0.10

o

o

o

o

0.05

0.05

0.10

o

o

o

o

o

o

0

2

4

6

8

o

0.0

0.0

o

o

o

o

10

o

0

: hyp (N = 50; M = 20; n = 10)

: B(n = 10; p = 0; 4)

o

o

o

5

10

o

15

o

o

o

o

o

20

: hyp (N = 400; M = 160; n = 20)

: B(n = 20; p = 0; 4)

Abbildung 2.2c

Dies kann mit Methoden der Analysis gezeigt werden, ist aber auch intuitiv einleuchtend: die hypergeometrische

Verteilung tritt beim Stichprobenziehen ohne Zurucklegen auf, die Binomialverteilung beim Stichprobenziehen

mit Zurucklegen. Ist nun die Zahl der Objekte sehr gro gegenuber der Stichprobe, so ist auch beim Ziehen

mit Zurucklegen die Chance, da ein Objekt zwei- oder mehrfach in der Stichprobe auftaucht, vernachlassigbar

klein. In solchen Fallen kann man als Modell fur die Anzahl der gezogenen Objekte mit Merkmal statt einer

hypergeometrischen auch eine binomialverteilte Zufallsgroe nehmen, auch wenn die Stichprobe eigentlich ohne

Wiederholungen gezogen wird. Der Fehler ist vernachlassigbar, und die Rechnungen sind fur die Binomialverteilung wesentlich einfacher.

Bei der Qualitatskontrolle kann die hypergeometrische Verteilung im Normalfall nicht durch die Binomialverteilung ersetzt werden, da die Anzahl M der defekten Objekte (hoentlich!) klein und daher die Annahme

M n verletzt ist. Bei Meinungsumfragen kann man dagegen in der Regel das Binomialmodell benutzen,

obwohl die Stichproben auch hier ohne Wiederholungen aus der Gesamtpopulation gezogen werden.

Anwendungsfeld Meinungsumfragen:

Um die Meinung einer Population (Bevolkerung der Bundesrepublik, Kunden des ABC-Baumarktes, Anhanger

des 1.FCK, Studierende der Universitat bis zum 4. Semester, ...) zu erkunden, wird eine Stichprobe vom

Umfang n ausgewahlt und befragt. Die Frage kann nur auf zwei Weisen beantwortet werden (z.B. "Ja" oder

"Nein"). Im Normalfall wird jede Einzelperson hochstens einmal befragt, so da die Zahl der Ja-Antworten

eigentlich hypergeometrisch verteilt ist. Wir nehmen aber an, da die Groe N der Gesamtpopulation sowie die

Anzahlen M und N ; M der Personen in der Gesamtpopulation, die die eine oder die andere Antwort geben

wurden, sehr viel groer als n sind (N mu nicht bekannt sein). In diesem Fall ist

X = Anzahl der Personen in der Stichprobe, die mit "Ja" antworten

in genugend guter Naherung eine binomialverteilte Zufallsgroe mit Parameter n und p = MN : p ist der

(unbekannte) Bruchteil der Gesamtpopulation, der mit "Ja" antworten wurde, und den man mit Hilfe der

Beobachtung X schatzen kann.

Auf die meisten Fragen bei Meinungsumfragen gibt es mehr als zwei mogliche Antworten, z.B. m verschiedene

einander ausschlieende Antworten A1; : : : ; Am : Sei in einer Stichprobe von Umfang n fur i = 1; : : : ; n:

Xi = Anzahl der Personen, die mit Ai antworten

21

Dann sind X1 ; : : : ; Xm alle binomialverteilt:

Xi ist B(n; pi)-verteilt ; i = 1; : : : ; m ;

wobei p1 + : : : + pm = 1 :

pi ist hier der Anteil der Personen in der Gesamtpopulation, der die Antwort Ai geben wurde. Da jeder Befragte

in der Stichprobe genau eine der Antworten Ai gibt, gilt

X1 + : : : + Xm = n :

Die Zufallsgroen X1 ; : : : ; Xm hangen also voneinander ab. Wenn der Stichprobenumfang n klein gegen die Gesamtpopulation ist, liefert die Annahme, da der Vektor (X1 ; : : : ; Xm ) multinomial verteilt ist ein brauchbares

Modell (vgl. Kapitel 2.4).

Beispiel:

i) Ein Kaufhaus interessiert sich dafur, welcher Anteil p der Kunden mit dem Wagen zum Einkaufen kommt, also auf Parkplatze

angewiesen ist. Die Untersuchung wird fur die einzelnen Wochentage getrennt durchgefuhrt. Am Montag werden n Kunden befragt,

von denen X angeben, da sie mit dem Wagen in die Stadt gefahren sind. X ist B(n; p)-verteilt, und aus X lat sich die interessierende

Groe p schatzen.

ii) Bei einer Umfrage werden n Personen (typisch hier: n = 1000 oder 2000) befragt, welcher Partei sie ihre Stimme geben wurden,

wenn am kommenden Wochenende gewahlt wurde. Von diesen n Personen bekennen sich X1 zur SPD, X2 zur CDU, X3 zur FDP,...

Jede dieser Anzahlen Xi ist binomialverteilt zum Parameter (n; pi ), wobei pi der Anteil an Stimmen ist, den die Partei Nr. i bei

der hypothetischen Wahl bekame.

2.3 Laplace-verteilte Zufallsgroen und rein zufallige Auswahlen

In Kapitel 2.2 wurde jeweils angenommen, da die Objekte oder Personen in einer Stichprobe rein zufallig aus

der Gesamtpopulation ausgewahlt wurden, d.h. da jedes Element der Ausgangsmenge dieselbe Chance hat,

in die Stichprobe aufgenommen zu werden. Eine solche rein zufallige Auswahl liefert das einmalige Betatigen

eines Laplace-Mechanismus, und das Ergebnis nennen wir eine Laplace- verteilte Zufallsgroe:

Sei A = fa1; : : : ; am g eine endliche Menge. Eine Zufallsgroe X mit Werten in X = A heit Laplace-verteilt

in A, wenn

Ws(X = aj ) = m1 ; j = 1; : : : ; m:

Beispiel: Ein fairer Wurfel wird zwei Mal geworfen. Die moglichen Ergebnisse sind die Paare (j; k); j; k = 1; : : : ; 6; und

jedes dieser Ergebnisse hat dieselbe Chance, erwurfelt zu werden. Sei A = f(j; k); j; k = 1; : : : ; 6g; X das

Wurfelergebnis. Dann ist X Laplace-verteilt in A mit

1 ; j; k = 1; : : : ; 6 ;

Ws(X = (j; k)) = 36

da A m = 36 Elemente hat.

Ist X Laplace-verteilt, so lassen sich die Wahrscheinlichkeiten von Ereignissen fX 2 B g fur B X = A

besonders einfach berechnen. Sei A = fa1; : : : ; am g; B = fai1 : : : ; ail g A:

Aus der Rechenregel W3 folgt:

Ws(X 2 B) = Ws(X = aij fur ein j = 1; : : : ; l)

l

X

Xl

=

Ws(X = aij ) = m1 = ml

j =1

j =1

Laplace-Wahrscheinlichkeit

X sei Laplace-verteilt in A; und sei B A:

der Elemente von B

Ws(X 2 B) = Anzahl

Anzahl der Elemente von A

22

Diese Identitat wird oft an den Anfang der Wahrscheinlichkeitstheorie gestellt. Mit ihr und mit kombinatorischen Hilfsmitteln kann

man z.B. die hypergeometrische bzw. die Binomialverteilung

beim Stichprobenziehen ohne bzw. mit Zurucklegen herleiten, solange der

Binomialparameter p rational, d.h. von der Form M

N ; ist. Schon fur irrationales p scheitert dieser elementare Ansatz, und kontinuierliche

Zufallsgroen lassen sich bestenfalls auf sehr kunstliche Weise mit Grenzubergangen auf einen Laplace-Mechanismus zuruckfuhren. Wir

haben daher auf diesen Zugang verzichtet und stattdessen gleich die Kolmogorowschen Axiome W1-W3 als Grundlage fur das Rechnen mit

Wahrscheinlichkeiten gewahlt.

Beispiel (Fortsetzung): X stehe wieder fur den zweifachen Wurfelwurf mit Werten in A = f(j; k); j; k = 1; : : : ; 6g: Wir schreiben

X = (X1 ; X2 ); wobei X1 das Ergebnis des ersten, X2 des zweiten Wurfs ist.

Sei B = f(j; k) 2 A; j + k = 6g = f(1; 5); (2; 4); (3; 3); (4; 2); (5; 1)g . Also heit X 2 B; da die Augensumme X1 + X2 = 6 ist, und:

der Elemente von B 5

Ws(X1 + X2 = 6) = Ws(X 2 B) = Anzahl

Anzahl der Elemente von A = 36

2.4 Allgemeine diskrete Verteilungen

Bereits in Kapitel 2.1 haben wir gesehen, da die Verteilung einer Zufallsgroe X, die nur endlich viele

verschiedene Werte a1 ; : : : ; am nehmen kann, vollstandig durch die Wahrscheinlichkeiten Ws(X = ai); i =

1; : : : ; m; bestimmt wird. Die entsprechenden U berlegungen lassen sich auch auf Zufallsgroen ubertragen, die

abzahlbar unendlich viele verschiedene Werte annehmen konnen.

Wir betrachten eine Zufallsgroe X mit Werteraum X , die nur die Werte x1; x2; : : : 2 X annehmen kann.

Um die Verteilung von X festzulegen, geben wir Wahrscheinlichkeitsgewichte p(x1); p(x2); : : : vor mit den

Eigenschaften:

p(xj ) 0 ; j = 1; 2; : : : ;

1

X

j =1

p(xj ) = 1 :

Die Gewichte sind also nichtnegativ und summieren sich zu 1 auf. Dann denieren wir

Ws(X = xj ) = p(xj ) ; j = 1; 2; : : : ;

Ws(X 2 B) =

X

j ; xj 2B

p(xj ) fur alle B X :

Die so denierte diskrete Verteilung genugt den Rechenregeln W1-W3. Fur beliebige Wahrscheinlichkeitsgewichte erhalt man also passende Wahrscheinlichkeiten fur alle Ereignisse der Form fX 2 B g; die die

Kolmogorowschen Axiome erfullen.

Nimmt X nur endlich viele Werte x1 ; : : : ; xm an, so mussen nur fur diese Werte Wahrscheinlichkeitsgewichte p(x1 ); : : : ; p(xm ) 0 mit

p(x1 )+ : : : + p(xm ) = 1 vorgegeben werden. Der einzige Unterschied zum

1 abzahlbar unendlichen Fall mbesteht darin, da die Folge x1 ; x2 ; : : :

nach der m-ten Stelle xm abbricht und da die unendliche Summe P durch die endliche Summe P ersetzt wird. Wir betrachten daher

j=1

j=1

in der Folge den endlichen Fall nicht getrennt, sondern fassen ihn als Spezialfall des abzahlbaren Falls auf.

Diskrete Verteilung

Gegeben:

mogliche Werte x1; x2; : : : von X

Wahrscheinlichkeitsgewichte p(x1); p(x2); : : : 0

mit p(x1) + p(x2 ) + : : : = 1

Dann gilt: Ws(X = xj ) = p(x

Pj ) p(x ) =

Ws(X 2 B) =

j

j ;xj 2B

23

P Ws(X = x ) fur alle B X

j

j ;xj 2B

Beispiel:

i) Zu n 1; 0 < p < 1 und moglichen Werten 0; : : : ; n denieren wir Wahrscheinlichkeitsgewichte

p(k) = nk pk (1 ; p)n;k ; k = 0; : : : ; n :

Die Zufallsgroe X mit diesen Gewichten, d.h. mit

Ws(X = k) = p(k) ; k = 0; : : : ; n ;

ist { wie wir aus Kapitel 2.2 wissen { B(n;p)-verteilt.

Mit der obigen Identitat fur Ws(X 2 B) folgt z.B.

Ws(X 3)

=

Ws(X gerade )

=

Ws(X > 3)

=

3

3

P

p(k) = P ;nkpk (1 ; p)n;k fur B = f0; 1; 2; 3g

k=0

k=0

n

n

;n k

P

P

n;k fur B = f0 k n; k gerade g

p(k) =

k p (1 ; p)

k=0; k gerade

k=0; k gerade

n

P

p(k) = 1 ; Ws(x 3)

k=4

Bei der letzten Gleichung haben wir W3b benutzt, da Ws(X 3) fur groere n wesentlich leichter auszurechnen ist als Ws(X > 3):

Hinweis: Fur kleine Werte von n und l lat sich Ws(X l) in der beschriebenen Weise leicht ausrechnen. Fur mittlere Werte

von n und verschiedene p sind diese Wahrscheinlichkeiten im Anhang tabelliert. Fur groe Werte von n gibt es brauchbare

Naherungsformeln (vgl. Kapitel 2.9).

ii) Beim Entwurf einer neuen Verpackung stellt sich die Frage, welcher dominierende Farbton die Kunden am meisten anspricht. Um

eine objektive Entscheidung treen zu konnen, werden Musterverpackungen in den Farbtonen rot, blau, grun, gelb, wei und schwarz

angefertigt. Zufallig an einer Verkaufsstelle vorbeikommende Kunden werden gefragt, welche Verpackung ihnen am besten gefallt.

Die Antwort Y eines einzelnen Kunden ist dann eine Zufallsgroe mit Werten in X = fr; b; gr; ge; w; sg; deren Verteilung durch die

Wahrscheinlichkeitsgewichte

p(r); p(b); p(gr); p(ge); p(w); p(s) 0

gegeben sind. Damit lat sich z.B. die Wahrscheinlichkeit, da der Kunde eine bunte Verpackung vorzieht, berechnen:

Ws(Y 2 fr; b; gr; geg) = p(r) + p(b) + p(gr) + p(ge) :

Die Wahrscheinlichkeitsgewichte sind naturlich unbekannt und sollen mit der Befragung geschatzt werden. Werden n Kunden

unabhangig voneinander gefragt, so registriert man

Xf = Anzahl der Kunden, die sich fur Farbe f entscheiden

fur f = r; b; gr; ge; w; s : Jedes einzelne Xf ist binomialverteilt, wahrend der Vektor aus den 6 Anzahlen (Xr ; Xb ; : : : ; Xs ) multinomialverteilt ist. (Xr ; Xb ; : : : ; Xs ) ist eine Zufallsgroe mit Werten in f0; : : : ; ng6 = f(i1 ; i2 ; : : : ; i6 ); 0 i1 ; i2 ; : : : ; i6 ng

Abnahmekontrolle bei Lieferung: Es werden N Gerate geliefert, von denen eine Stichprobe des Umfangs

n einer genauen Untersuchung unterzogen wird. X sei die zufallige Anzahl von Geraten, die dabei als defekt

identiziert werden. Aus Kapitel 2.2 wissen wir, da X hypergeometrisch verteilt ist. Die Zahl aller Gerate

N und die Zahl der getesteten Gerate n sind bekannt. Die Anzahl M der defekten Gerate in der gesamten

Lieferung ist unbekannt, und damit hangen auch die Wahrscheinlichkeitsgewichte

;M ;N ;M pM (k) = WsM (X = k) = k ;Nn;k ; k = 0; : : : ; min(n; M)

n