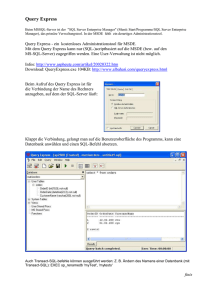

Grundlagen von Datenbanken

Werbung