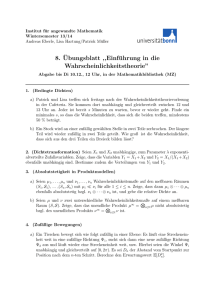

4 Unabhängige Zufallsvariablen. Gemeinsame Verteilung

Werbung

4 Unabhängige Zufallsvariablen. Gemeinsame Verteilung

Häufig werden mehrere Zufallsvariablen gleichzeitig betrachtet , z.B.

Beispiel 4.1. Ein Computersystem bestehe aus n Teilsystemen. Xi sei der Ausfallzeitpunkt des i -ten Systems (i = 1, . . . , n) . Man beschreibe den Ausfallzeitpunkt X

des Gesamtsystems bei

a) Parallelschaltung ( Ausfall“ ⇐⇒

”

b) Serienschaltung ( Ausfall“ ⇐⇒

”

Lösung : a) X = max(X1 , . . . , Xn ) ;

b) X = min(X1 , . . . , Xn ) .

Ausfall“ in allen Teilsystemen ) ;

”

Ausfall“ in einem Teilsystem ) .

”

Modelle für die gemeinsame Beschreibung von ZV. sind besonders einfach bei

Unabhängigkeit “ :

”

Definition 4.1. Seien (Ω, A, P ) ein W-Raum und Xi : (Ω, A) − (Xi , Bi )- ZV. für

i = 1, 2, . . . . Dann heißen X1 , X2 , . . . (stochastisch ) unabhängig (bzgl. P ) , wenn

gilt :

(∗)

P (Xi1 ∈ Bi1 , . . . , Xik ∈ Bik ) = P (Xi1 ∈ Bi1 ) · · · P (Xik ∈ Bik )

für jede endliche Auswahl {i1 , . . . , ik } ⊂ N , Biν ∈ Biν (ν = 1, . . . , k) .

Bemerkung 4.1. a) Nach Definition 4.1 genügt die Betrachtung von jeweils endlich

vielen ZV., etwa X1 , . . . , Xn .

b) Sind alle Xi diskret verteilt , d.h. existieren abzählbare Wertebereiche Xi mit

P (Xi ∈ Xi ) = 1 ∀ i = 1, . . . , n , so gilt :

X1 , . . . , Xn unabhängig

⇐⇒

P (X1 = x1 , . . . , Xn = xn ) =

n

P (Xi = xi )

i=1

∀ xi ∈ Xi , i = 1, . . . , n .

c) Setzt man die ZV. X1 , . . . , Xn zu X = (X1 , . . . , Xn ) zusammen, so ist X ein

(Ω, A) − (X , B)–Zufallsvektor ( vgl. Wahrscheinlichkeitstheorie“ ) , wobei

”

X = X1 × · · · × Xn , B := B1 ⊗ · · · ⊗ Bn := kleinste σ-Algebra, die alle

Ereignisse B1 × · · · × Bn , Bi ∈ Bi , umfasst .

37

Definition 4.2. a) Die Verteilung PX auf B (im Sinne von Definition 2.2) von

X = (X1 , . . . , Xn ) heißt gemeinsame Verteilung der ZV. X1 , . . . , Xn .

b) Die Verteilung PXi (auf Bi ) der ZV. Xi heißt i-te Rand-(Marginal-)Verteilung

von PX . Es gilt :

PXi (Bi ) = P (X1 , . . . , Xn ) ∈ X1 × · · · × Xi−1 × Bi × Xi+1 × · · · × Xn

= PX (X1 × · · · × Xi−1 × Bi × Xi+1 × · · · × Xn ),

Bi ∈ Bi ,

d.h. die gemeinsame Verteilung PX = PX1 ,...,Xn bestimmt die Randverteilungen PXi

(i = 1, . . . , n) .

Beispiel 4.2. n-maliges Ziehen mit Zurücklegen aus einer Urne mit N Kugeln . Sei

Xi = Ergebnis der i-ten Ziehung“ (i = 1, . . . , n) .

”

Ω = ω = (ω1 , . . . , ωn ) | ωi ∈ {1, . . . , N} = {1, . . . , N}n , A = P(Ω) ,

Modell :

P ({ω}) = N1n ;

Hier :

Xi (ω) = ωi (i = 1, . . . , n) ,

(X1 , . . . , Xn )(ω) = (X1 (ω), . . . , Xn (ω)) = (ω1 , . . . , ωn ) = ω ;

Bildraum : X = Ω , B = A = P(Ω) ,

PX = P = diskrete Gleichverteilung auf P(Ω) ;

n−1

i-te Randverteilung : PXi ({xi }) = P (Xi = xi ) = NN n = N1 ,

diskrete Gleichverteilung auf P {1, . . . , N} .

Sind die ZV. X1 , . . . , Xn unabhängig ? Ja, denn

n

1

P (Xi = xi ) ∀ xi ∈ {1, . . . , N} , i = 1, . . . , n .

P (X1 = x1 , . . . , Xn = xn ) = n =

N

i=1

Beim Ziehen ohne Zurücklegen sind die ZV. X1 , . . . , Xn nicht unabhängig !

H

Wie lässt sich das gemeinsame Zufallsgeschehen (die gemeinsame Verteilung) von endlich

vielen ZV. beschreiben ? Wir beschränken uns auf die beiden folgenden Möglichkeiten :

a) Der Bildraum X von X = (X1 , . . . , Xn ) ist abzählbar und B = P(X ) : Dann

ist die gemeinsame Verteilung PX = PX1 ,...,Xn festgelegt durch die (diskrete) W-Dichte

p(x1 , . . . , xn ) = P (X1 = x1 , . . . , Xn = xn ) ,

38

(x1 , . . . , xn ) ∈ X ;

b) Bildraum X = Rn und B = Bn = Borel-σ-Algebra in Rn = kleinste σ-Algebra, die

alle n-dimensionalen Intervalle (a, b) = (a1 , b1 ) × · · · × (an , bn ) umfasst : Dann ist PX

festgelegt durch Angabe der Wahrscheinlichkeiten

P X ∈ (a, b) = P X1 ∈ (a1 , b1 ), . . . , Xn ∈ (an , bn ) , ai < bi (i = 1, . . . , n) .

Gilt sogar : P X ∈ (a, b) = PX (a, b) =

b1

bn

...

a1

an

f (x1 , . . . , xn ) dx1 . . . dxn ,

wobei

Rn → R1 eine nicht-negative, Riemann-integrierbare Funktion ist mit

∞ f : ∞

...

f (x1 , . . . , xn ) dx1 . . . dxn = 1 , so heißt X = (X1 , . . . , Xn ) absolut-stetig

−∞

−∞

verteilt mit (gemeinsamer) Dichte f .

Beispiel 4.3. a) (Exponentialverteilung im R3 )

λ1 λ2 λ3 e−(λ1 x1 +λ2 x2 +λ3 x3 ) , x1 , x2 , x3 > 0 ,

f (x1 , x2 , x3 ) =

0,

sonst .

b) (Rechteckverteilung im R2 )

f (x1 , x2 ) =

1

(b1 −a1 )(b2 −a2 )

0,

, a1 < x1 < b1 , a2 < x2 < b2 ,

sonst .

Bemerkung 4.2. Die Randverteilungen ergeben sich wie folgt :

a) X = (X1 , . . . , Xn ) diskret verteilt mit Dichte p(x1 , . . . , xn ) :

pi (xi ) = P (Xi = xi ) =

p(x1 , . . . , xi−1 , xi , xi+1 , . . . , xn ) ;

xν (ν=i)

xi fest

b) X = (X1 , . . . , Xn ) absolut-stetig verteilt mit Dichte f (x1 , . . . , xn ) :

∞

∞

...

f (x1 , . . . , xn ) dx1 . . . dxi−1 dxi+1 . . . dxn

fi (xi ) =

−∞

−∞

(xi fest)

ist Dichte der Randverteilung PXi (absolut-stetig ) .

Beispiele 4.3 (Fortsetzung) Die Randverteilungen besitzen Dichten :

a) fi (xi ) = λi e−λi xi I(0,∞) (xi )

b) fi (xi ) =

1

I(a ,b ) (xi )

bi − ai i i

(i = 1, 2, 3) ;

(i = 1, 2) .

39

Bemerkung 4.3. Die Unabhängigkeit der X1 , . . . , Xn ergibt sich aus der Produktform

der gemeinsamen Dichte , d.h.

a) falls X = (X1 , . . . , Xn ) diskret verteilt ist mit Dichte

p(x1 , . . . , xn ) =

n

pi (xi ) ,

pi i-te Randdichte ,

i=1

bzw.

b) falls X = (X1 , . . . , Xn ) absolut-stetig verteilt ist mit Dichte

f (x1 , . . . , xn ) =

n

fi (xi ) ,

fi i-te Randdichte ,

i=1

so sind die ZV. X1 , . . . , Xn unabhängig .

Definition 4.3. Seien (Ω, A, P ) ein W-Raum und X = (X1 , . . . , Xn ) : Ω → Rn

eine n-dimensionale ZV. Die durch

F (x1 , . . . , xn ) := P (X1 ≤ x1 , . . . , Xn ≤ xn ) ,

definierte Abbildung

X1 , . . . , Xn .

F :

Rn → [0, 1]

heißt

(x1 , . . . , xn ) ∈ Rn ,

(gemeinsame ) VF.

der

ZV.

Analog zu den Sätzen 2.2/2.3 besitzt die gemeinsame VF. folgende Eigenschaften :

Satz 4.1. Sei F (gemeinsame ) VF. der n-dimensionalen ZV. (X1 , . . . , Xn )

auf (Ω, A, P ) . Dann gilt :

a) F ist monoton wachsend in jeder Komponente xi (i = 1, . . . , n) ;

b) F ist rechtsstetig in jeder Komponente xi (i = 1, . . . , n) ;

c)

lim

xi →−∞ (∃ i)

F (x1 , . . . , xn ) = 0 ,

lim

xi →+∞ (∀ i)

F (x1 , . . . , xn ) = 1 ;

d) Ist X = (X1 , . . . , Xn ) absolut-stetig verteilt mit Dichte f (x1 , . . . , xn ) , so gilt

in jedem Stetigkeitspunkt x von f :

f (x) = f (x1 , . . . , xn ) =

∂n

F (x1 , . . . , xn ) ;

∂x1 . . . ∂xn

e) PX ist durch F eindeutig festgelegt.

40

Bemerkung 4.3 (Fortsetzung) Die Unabhängigkeit der X1 , . . . , Xn ergibt sich ebenfalls

aus der Produktform von F , d.h. aus

F (x1 , . . . , xn ) =

n

Fi (xi ) ∀ (x1 , . . . , xn ) ∈ Rn ,

Fi i-te Rand-VF.

i=1

Beispiel 4.1 (Fortsetzung) Die Ausfallzeitpunkte der n Teilsysteme seien unabhängig ,

identisch Exp(λ)-verteilt . Dann besitzt der Ausfallzeitpunkt X des Gesamtsystems

die folgende Dichte :

a) Parallelschaltung , d.h. X = max (X1 , . . . , Xn ) :

F (x) = P (X ≤ x) = P (X1 ≤ x, . . . , Xn ≤ x)

n

(1 − e−λx )n , x > 0 ,

=

P (Xi ≤ x) =

0,

sonst .

i=1

Ableitung : F (x) =

nλ e−λx (1 − e−λx )n−1 , x > 0 ,

0,

x < 0,

d.h. X ist absolut-stetig verteilt mit Dichte f der Form :

f (x) = nλ e−λx (1 − e−λx )n−1 I(0,∞) (x) ;

Erwarteter Ausfallzeitpunkt (über partielle Integration ) :

EX =

∞

−λx

x nλ e

0

−λx n−1

(1 − e

)

11

dx =

;

λ k=1 k

n

b) Serienschaltung , d.h. X = min (X1 , . . . , Xn ) :

n

n

F (x) = P ∪ {Xi ≤ x} = 1 − P ∩ {Xi > x}

i=1

i=1

1 − (e−λx )n = 1 − e−nλx , x > 0 ,

=

0,

sonst .

Also ist X = min (X1 , . . . , Xn ) Exp(nλ)-verteilt mit Dichte

f (x) = nλ e−nλx I(0,∞) (x) .

Erwarteter Ausfallzeitpunkt :

EX =

1

.

nλ

41

Bemerkung 4.4. Das obige Beispiel zeigt, dass das Minimum von n unabhängig ,

identisch verteilten (i.i.d.) ZV. mit einer Exp(λ)-Verteilung eine Exp(nλ)-Verteilung

besitzt . Es gilt sogar allgemeiner :

Xi unabhängig, Exp(λi )-verteilt (i = 1, 2, . . . , n)

=⇒

X = min (X1 , . . . , Xn ) ist Exp(λ1 + · · · + λn )-verteilt .

Eine weitere, sogar charakteristische, Eigenschaft der Exp(λ)-Verteilung ist deren

Gedächtnislosigkeit “ (bzw. Nichtalterungseigenschaft “). Ein diskretes Analogon zur

”

”

Exponentialverteilung bildet hierbei noch die geometrische Verteilung.

Satz 4.2. a) X sei absolut-stetig verteilt auf (Ω, A, P ) mit P (X > 0) = 1 und

Dichte f (x) = λe−λx I(0,∞) (x) (λ > 0, fest ) .

=⇒

P (X ≥ x + y | X ≥ x) = P (X ≥ y)

∀ x, y ≥ 0 ;

b) X sei diskret verteilt auf (Ω, A, P ) mit P (X ∈ N0 ) = 1 und Dichte p(i) = pq i ,

i ∈ N0 (0 < p < 1, q = 1 − p, fest )

=⇒

P (X = i + j | X ≥ i) = P (X = j)

∀ i, j ∈ N0 .

Bemerkung 4.5. a) Falls X absolut-stetig verteilt ist mit P (X > 0) = 1 , so gilt auch

die Umkehrung in Satz 4.2 a) : Charakterisierung der Exponentialverteilung ;

b) Falls X diskret verteilt ist mit P (X ∈ N0 ) = 1 und P (X = 0) =: p < 1 , so gilt

auch die Umkehrung in Satz 4.2 b): Charakterisierung der geometrischen Verteilung .

Die Unabhängigkeit von Zufallsvariablen bleibt unter ( messbaren“) Transformationen

”

erhalten :

Satz 4.3. Seien X1 , . . . , Xn unabhängige, reelle ZV. auf (Ω, A, P ) und h1 , . . . , hn

1

∀ B ∈ B1 , i = 1, . . . , n . Dann

messbare “ reelle Funktionen , d.h. h−1

i (B) ∈ B

”

gilt :

Y1 := h1 (X1 ), . . . , Yn := hn (Xn ) sind unabhängige, reelle ZV.

Beispiel 4.4. (X1 , . . . , Xn ) unabhängige, reelle ZV.

=⇒

a)

X1k , . . . , Xnk

unabhängige, reelle ZV.

(k ∈ N, fest) ;

b)

s X1 , . . . , s Xn

unabhängige, reelle ZV.

(s > 0, fest) ;

c)

etX1 , . . . , etXn

unabhängige, reelle ZV.

(t ∈ R, fest) .

42

Das Zufallsgeschehen eines (n-dimensionalen) Zufallsvektors unter einer n-dimensionalen

Transformation verändert sich wie folgt : Seien

X = (X1 , . . . , Xn ) eine n-dimensionale ZV. auf (Ω, A, P ) und h : Rn → Rn

messbar“, d.h. h−1 (B) ∈ Bn ∀ B ∈ Bn , wobei Bn = kleinste σ-Algebra in Rn ,

”

die alle n-dimensionalen Intervalle umfasst .

Frage : Wie sieht die (gemeinsame) Verteilung aus von

Y = h(X) = h1 (X1 , . . . , Xn ), . . . , hn (X1 , . . . , Xn ) ?

Antwort : a) Seien X1 , . . . , Xn diskret verteilt ∀ i = 1, . . . , n

=⇒

X = (X1 , . . . , Xn ) ist diskret verteilt und es genügt, die Wahrscheinlichkeitsdichte zu

bestimmen :

P (Y1 = y1 . . . , Yn = yn ) = P (h1 (X) = y1 , . . . , hn (X) = yn ) = P

y = (y1 , . . . , yn ) ∈ h(X ) , X

”

n

∩ {X ∈ h−1

i ({yi })} ,

i=1

Träger “ von PX , d.h. PX (X ) = P (X ∈ X ) = 1 .

Beispiel 4.5. a) X = (X1 , X2 ) besitze folgende gemeinsame Verteilung :

pX (0, 1) =

1

1

1

, pX (0, 3) = , pX (1, 2) = .

3

6

2

Was ist die gemeinsame Verteilung von Y1 = X1 + X2 , Y2 = X1 − X2 ?

Lösung :

(0, 1) → (1, −1) , (0, 3) → (3, −3) , (1, 2) → (3, −1)

pY (1, −1) =

=⇒

1

1

1

, pY (3, −3) = , pY (1, 2) = .

3

6

2

b) Sei (X1 , . . . , Xn ) absolut-stetig verteilt mit (gemeinsamer) Dichte f = f (x1 , . . . , xn ) .

Dann gilt der folgende Transformationssatz :

43

Satz 4.4. X = (X1 , . . . , Xn ) sei absolut-stetig verteilt auf (Ω, A, P ) mit Dichte

f = f (x1 , . . . , xn ) , x = (x1 , . . . , xn ) ∈ Rn . Ferner gelte :

(i) h : Rn → Rn ist injektiv mit Umkehrabbildung

u : W → Rn , wobei W := h(Rn ) offen ;

(ii) h ist ein Diffeomorphismus , d.h. h und u besitzen stetige partielle Ableitungen.

Bezeichne J = J(y) die Jacobi-Matrix der Umkehrabbilung u , also

⎛

⎞

∂u1

∂u1

·

·

·

∂yn

⎜ ∂y. 1

.. ⎟

⎜

.

J(y) = ⎝ .

. ⎟

⎠, y ∈ W .

∂un

∂un

· · · ∂yn

∂y1

Dann ist Y = (Y1 , . . . , Yn ) = h(X) absolut-stetig verteilt mit (gemeinsamer ) Dichte

|detJ(y)| f (u1(y), . . . , un (y)) , y ∈ W ,

g(y) = g(y1, . . . , yn ) =

0,

sonst .

Beispiel 4.6. X = (X1 , X2 ) sei absolut-stetig verteilt mit gemeinsamer Dichte f =

f (x1 , x2 ) und Randdichten f1 = f1 (x1 ) , f2 = f2 (x2 ) . Man bestimme die gemeinsame

Verteilung von Y1 = X1 + X2 , Y2 = X2 :

Umkehrabbildung :

X1 = Y1 − Y2 , X2 = Y2 , also

u1 (y) = y1 − y2 , u2 (y) = y2 , y = (y1 , y2 ) ∈ R2 ;

h, u bijektiv , stetig partiell differenzierbar ;

1

−1

| det J(Y )| = det

= 1 , y ∈ R2

0

1 =⇒

Dichte :

g(y1, y2 ) = f (y1 − y2 , y2 ) ,

(y1 , y2) ∈ R2 .

Als Dichte der Randverteilung von Y1 = X1 + X2 erhält man sofort :

∞

g1 (y1 ) =

f (y1 − y2 , y2 ) dy2 , y1 ∈ R1 .

−∞

Sind X1 , X2 sogar unabhängig , etwa f (x1 , x2 ) = f1 (x1 )f2 (x2 ) , (x1 , x2 ) ∈ R2 , so

ergibt sich speziell :

∞

g1 (y1 ) =

f1 (y1 − y2 )f2 (y2 ) dy2 .

−∞

44

Z.B. : X1 , X2 i.i.d. , Exp(λ)- verteilt

Dichte von X1 − X2 : g̃1 (y1 ) =

λ

2

=⇒

e−λ | y1 | , y1 ∈ R1

(Laplace-Verteilung ; Bezeichnung : D(λ)-Verteilung ) .

Definition 4.4. X1 , . . . , Xn seien unabhängige, reelle ZV. auf (Ω, A, P ) . Die

Verteilung PX1 +···+Xn der Summe X1 + · · · + Xn heißt Faltung von PX1 , . . . , PXn ,

geschrieben PX1 ∗ · · · ∗ PXn .

Bemerkung 4.6. Die Herleitung in Beispiel 4.6 zeigt , dass die Faltung zweier unabhängiger, absolut-stetig verteilter ZV. X und Y mit Dichten f = f (x) und g = g(y)

die folgende Dichte besitzt (Dichte von Z = X + Y ) :

∞

∞

f (z − y)g(y) dy =

g(z − x)f (x) dx , z ∈ R1 .

h(z) =

−∞

−∞

Beispiel 4.7. ( n -dimensionale Normalverteilung ) Die Funktion f : Rn → R1 mit

f (x1 , . . . , xn ) :=

1

2

2

e−(x1 +···+xn )/2

n/2

(2π)

ist W-Dichte einer n-dimensionalen ZV. X = (X1 , . . . , Xn ) , denn f1 : R1 → R1 mit

1

2

e−x1 /2 ,

f1 (x1 ) = √

2π

x1 ∈ R1 ,

ist Dichte der N(0, 1)-Verteilung (vgl. Beispiel 2.5), d.h.

f (x1 , . . . , xn ) =

n

(x1 , . . . , xn ) ∈ Rn ,

f1 (xi ) ,

i=1

ist (gemeinsame ) Dichte von n i.i.d., N(0, 1)-verteilten ZV. X1 , . . . , Xn .

Frage :

Wie sieht die Dichte von Y = BX + a aus (a ∈ Rn , B ∈ Rn×n regulär) ?

Antwort :

y = h(x) = Bx + a ist injektiv , da B regulär , W = h(Rn ) = Rn offen ;

x = u(y) = B −1 (y − a) , y ∈ Rn ;

| det J| = | det B −1 | = 1/| det B| ;

Setzt man Σ := BB , so gilt :

x21 + · · · + x2n = x x = (y − a) (B −1 ) B −1 (y − a) = (y − a) Σ−1 (y − a) ,

| det B| = | det Σ|1/2 , also

Dichte von Y : g(y) =

1

(2π)n/2 | det Σ|1/2

1

Σ−1 (y−a)

e− 2 (y−a)

45

,

y ∈ Rn .

Definition 4.5. Ein Zufallsvektor Y mit obiger Dichte g heißt (n -dimensional )

normalverteilt mit Parametern “ a, Σ ; Schreibweise : PY = N(a, Σ) .

”

Erwartungswerte (von reellen Transformationen mehrerer ZV.)

X = (X1 , . . . , Xn ) sei eine n-dimensionale ZV. auf (Ω, A, P ) und h : Rn → R1 sei

messbar“, d.h. h−1 (B) ∈ Bn ∀ B ∈ B1 .

”

Satz 4.5. Sei X diskret verteilt mit Dichte p(x1 , . . . , xn ) oder absolut-stetig

verteilt mit Dichte f (x1 , . . . , xn ) . Dann gilt :

⎧ ⎪

...

h(x1 , . . . , xn ) p(x1 , . . . , xn ) ,

X diskret ,

⎪

⎨

x

x

n ∞

1∞

Eh(X) =

⎪

⎪

...

h(x1 , . . . , xn ) f (x1 , . . . , xn ) dx1 . . . dxn , X absolut-stetig ,

⎩

−∞

−∞

falls die n-fache Summe bzw. das n-dimensionale Integral absolut konvergieren .

Erwartungswerte (von Produkten unabhängiger ZV.)

Satz 4.6. X, Y seien unabhängige, reelle ZV. auf (Ω, A, P ) mit existierenden

EW. EX, EY . Dann gilt :

E(XY ) existiert

und

E(XY ) = EX · EY .

Varianzen, Kovarianzen

Seien X, Y reelle ZV. auf (Ω, A, P ) mit E(X 2 ) < ∞ , E(Y 2 ) < ∞ .

Dann gilt : V ar(X + Y ) existiert und

V ar(X + Y ) = V ar(X) + V ar(Y ) + 2 E(X − EX)(Y − EY ) .

Definition 4.6. Seien X, Y reelle ZV. auf (Ω, A, P ) mit existierenden zweiten

Momenten . Dann heißt

Cov(X, Y ) := E(X − EX)(Y − EY )

die Kovarianz von X und Y .

Falls Cov(X, Y ) = 0 , so heißen X und Y unkorreliert .

Bemerkung 4.7. a) V ar(X + Y ) = V ar(X) + V ar(Y ) + 2 Cov(X, Y ) ;

46

Allgemein :

V ar

n

Xi =

n

i=1

V ar(Xi ) + 2

i=1

Cov(Xi , Xj ) ,

i<j

falls alle zweiten Momente existieren .

b)

X, Y unabhängig mit existierenden zweiten Momenten

=⇒ Cov(X, Y ) = 0 , also X, Y unkorreliert ;

Allgemein : X1 , . . . , Xn unabhängig mit existierenden zweiten Momenten

n

n

=⇒ V ar

Xi =

V ar(Xi ) ;

i=1

c)

i=1

Rechenregeln : X, Y, Z reelle ZV. mit existierenden zweiten Momenten ; a, b, c ∈ R1

=⇒

1) Cov(X, Y ) = Cov(Y, X) , Cov(X, X) = V ar(X) ;

2) Cov(aX, bY ) = ab Cov(X, Y ) ;

3) Cov(X, Y + Z) = Cov(X, Y ) + Cov(X, Z) ,

speziell : Cov(X, Y + c) = Cov(X, Y ) ;

4) Cov(X, Y ) = E(XY ) − (EX)(EY )

Beispiel 4.8.

”

Verschiebungssatz “.

n aus N = R + S Kugeln gezogen :

X = Anzahl gezogener roter Kugeln“ ; V ar(X) = ?

”

a) Ziehen mit Zurücklegen :

1 , im i-ten Zug rot“ ,

”

Seien Xi =

0 , sonst ;

=⇒

X1 , . . . , X n

i.i.d., B(1, p)-verteilt (p =

=⇒

V ar(X) = V ar

n

R

)

N

Xi = n V ar(X1 ) = np(1 − p) .

i=1

b) Ziehen ohne Zurücklegen : Xi wie in a), aber abhängig ;

V ar(X) = V ar

n

i=1

Xi =

n

V ar(Xi ) +

i=1

Cov(Xi , Xj ) .

i=j

Hier : EXi = p , V ar(Xi ) = p(1 − p) (wie in a)), aber

i=j

EXi Xj = 1 · P (Xi = 1) + 0 =

R(R−1)

N (N −1)

47

=⇒

Cov(Xi , Xj )

V ar(X)

i=j

=

=

=

R(R−1)

N (N −1)

−

R 2

N

−R)

= − NR(N

2 (N −1)

und

−R)

R N −R

nN

− n(n − 1) NR(N

2 (N −1)

N

R

R

1− N

1 − Nn−1

. . . = nN

,

−1

d.h. kleinere Varianz beim Ziehen ohne Zurücklegen .

Für Abschätzungen von Momenten ist die Cauchy-Schwarz’sche Ungleichung von großer

Bedeutung :

Satz 4.7. Seien X, Y reelle ZV. auf (Ω, A, P ) mit existierenden zweiten

Momenten . Dann gilt :

a) {E(XY )}2

b)

≤ E(X 2 ) E(Y 2 ) ;

= “ gilt genau dann , wenn a, b ∈ R existieren mit a2 + b2 > 0 und

”

P (aX + bY = 0) = 1 , d.h. , wenn X und Y mit Wahrscheinlichkeit 1

linear abhängig sind .

1

(i = 1, . . . , n)

Beispiel 4.9. Sei P (X = xi , Y = yi ) =

n

n

n

n

1 2

1 2

1 2

2

2

2

=⇒ {E(XY )} =

xi yi , EX =

x , EY =

y

n i=1

n i=1 i

n i=1 i

n

n

n

2 2

=⇒

xi yi ≤

xi

yi2 (vgl. Lineare Algebra ) .

i=1

i=1

i=1

Bemerkung 4.8. a) Mit zentrierten ZV. X = X − EX, Y = Y − EY :

|Cov(X, Y )| ≤

V ar(X) V ar(Y ) ;

X − EX

Y − EY

b) Für standardisierte ZV. X ∗ = , Y∗ = :

V ar(X)

V ar(Y )

|Cov(X ∗, Y ∗ )| ≤ 1 .

Definition 4.7. Seien X, Y reelle ZV. auf (Ω, A, P ) mit existierenden , positiven

Varianzen . Dann heißt

Korr(X, Y ) := ρ(X, Y ) := Cov(X, Y )

V ar(X) V ar(Y )

der Korrelationskoeffizient von X und Y .

48

= Cov(X ∗, Y ∗ )

Bemerkung 4.9. ρ(X, Y ) ist ein Maß für die lineare Abhängigkeit “ zwischen X

”

und Y . Nach Satz 4.7 und Bemerkung 4.8 gilt |ρ(X, Y )| ≤ 1 und =“ genau

”

dann , wenn X und Y mit Wahrscheinlichkeit 1 linear abhängig sind .

Bedingte Verteilungen und bedingter Erwartungswert unter {Y = y} ,

falls Y absolut-stetig verteilt ist

Man beachte : P (Y = y) = 0 , also eine Definition wie in Definition 3.2 ist nicht

möglich !

Ansatz : Sei (X, Y ) absolut-stetig verteilt mit gemeinsamer Dichte f = f (x, y) und

Randdichten f1 = f1 (x) , f2 = f2 (y) . Dann gilt :

P (X ∈ [x, x + Δx] | Y ∈ [y, y + Δy]) =

Δx,Δy klein

≈

P (X ∈ [x, x + Δx], Y ∈ [y, y + Δy]

P (Y ∈ [y, y + Δy])

f (x, y)

f (x, y) ΔxΔy

=

Δx =: fX | Y =y (x) Δx .

f2 (y) Δy

f2 (y)

Ferner : fX | Y =y (x) definiert bei festem y mit f2 (y) > 0 eine W-Dichte , denn es gilt :

fX | Y =y (x) ≥ 0 ∀ x und

∞

∞

1

fX | Y =y (x) dx =

f (x, y) dx = 1 .

f2 (y) −∞

−∞

Definition 4.8. Sei (X, Y ) absolut-stetig verteilte ZV. auf (Ω, A, P ) mit

gemeinsamer Dichte fX,Y = fX,Y (x, y) und Randdichten fX = fX (x) , fY = fY (y) .

a) Dann heißt

⎧

⎨ fX,Y (x, y) , falls f (y) > 0 ,

Y

fY (y)

fX | Y =y (x) :=

⎩

0,

sonst ,

bedingte Dichte von X unter Y = y .

b) Existiert der EW. Eh(X, Y ) einer reellwertigen ZV. h(X, Y ) , so heißt

∞

E[h(X, Y ) | Y = y] :=

h(x, y) fX | Y =y (x) dx

−∞

bedingter EW. von h(X, Y ) unter Y = y .

49

Wie im diskreten Fall , d.h., wenn P (Y = y) > 0 , so gilt auch hier der Satz vom

iterierten Erwartungswert :

Satz 4.8. Sei (X, Y ) absolut-stetig verteilte ZV. auf (Ω, A, P ) mit Dichte

f = f (x, y) und Randdichten fX = fX (x) , fY = fY (y) . Existiert der EW.

E h(X, Y ) einer reellwertigen ZV. h(X, Y ) , so folgt :

∞

E h(X, Y ) =

E[h(X, Y ) | Y = y] fY (y) dy .

−∞

Unter Unabhängigkeit der ZV. X und Y ergibt sich speziell :

Satz 4.9. Unter den Voraussetzungen von Satz 4.8 gelte zusätzlich , dass X und

Y unabhängig sind , d.h. (o.E. ) , dass f (x, y) = fX (x)fY (y) ∀ x, y . Dann folgt :

a) fX | Y =y (x) = fX (x)

∀ y;

b) E[h(X, Y ) | Y = y] = E[h(X, y)]

Beispiel 4.10.

∀ y.

Laplace-Verteilung D(λ)

a) X besitze eine Exp(λ)-Verteilung, U eine R(0, 1)-Verteilung und X, Y

unabhängig. Setzt man

X , falls 0 < U ≤ 12 ,

Z=

−X , falls 12 < U < 1 ,

seien

so hat Z die Dichte

f (z) =

λ −λ | z |

e

, z ∈ R;

2

b) X, Y seien i.i.d. Exp(λ) -verteilt

=⇒

Z := X − Y ist D(λ)-verteilt .

Bemerkung 4.10. Als Spezialfall von Satz 4.8 ergibt sich die Formel von der totalen

Wahrscheinlichkeit :

P (X ∈ B) = P (X ∈ B | Y = y) fY (y) dy .

50