Einführung in die Stochastik Universität Zürich Wintersemester 2003

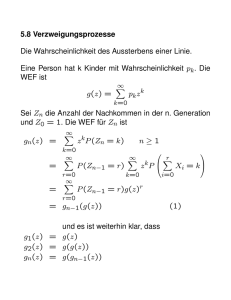

Werbung