Formelübersicht - Statistik

Werbung

Formelübersicht - Statistik I + II

Inhaltsverzeichnis

1 Elementare Wahrscheinlichkeitsrechnung

1.1 Kombinatorik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Wahrscheinlichkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.3 PIE - Prinzip von Inklusion und Exklusion . . . . . . . . . . . . . . . . . .

1

1

1

2

2 Wahrscheinlichkeitsverteilungen

2.1 Binomialverteilung . . . . . . . . . . . . . .

2.2 Poisson-Verteilung . . . . . . . . . . . . . .

2.3 Exponentialverteilung . . . . . . . . . . . . .

2.4 Dichtefunktionen und Verteilungsfunktionen

2.4.1 Dichtefunktionen . . . . . . . . . . .

2.4.2 Verteilungsfunktionen . . . . . . . .

.

.

.

.

.

.

3

3

3

4

4

4

5

3 Grundlegende Parameter

3.1 Erwartungswert/Mittelwert/Durchschnitt .

3.1.1 Eigenschaften des Erwartungwerts .

3.2 Varianz und Streuung . . . . . . . . . . .

3.2.1 Eigenschaften der Varianz . . . . .

3.3 Kovarianz . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

6

6

6

7

7

4 Untersuchung linearer Zusammenhänge

4.1 Lineare Regression . . . . . . . . . . . . . . . . . . .

4.2 Robuste Regression nach Theil . . . . . . . . . . . . .

4.3 Lineare Regression nach Gauß-Markov . . . . . . . .

4.3.1 Regressionsmodell und Koeffizientenschätzung

4.3.2 Schätzung der Varianz . . . . . . . . . . . . .

4.4 Korrelationskoeffizient nach Pearson . . . . . . . . .

4.5 Rangkorrelationskoeffizient nach Spearman . . . . . .

4.6 Anpassungsgüte . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

8

8

8

8

8

9

10

10

10

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5 Visualisierungsmethoden

5.1 Stängel-Blatt-Diagramm . . . . .

5.2 Boxplot und benötigte Parameter

5.3 Histogramm . . . . . . . . . . . .

5.4 Lorenzkurve und Gini-Koeffizient

5.5 Verteilungstabellen . . . . . . . .

5.6 Empirische Verteilungsfunktion .

6 Stochastische Graphen

6.1 Allgemeine Markov-Ketten . . .

6.2 Mittelwertsregeln . . . . . . . .

6.3 Stationäre Verteilung . . . . . .

6.4 Gewinnwahrscheinlichkeiten . .

6.5 Mittlere Spielzeiten/Wartezeiten

6.6 Mittleres Kapital . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7 Ökonomische Modelle

7.1 Bedienungstheorie . . . . . . . . . .

7.2 Zinsen und Kredite . . . . . . . . .

7.3 Preisindizes . . . . . . . . . . . . .

7.4 Zeitreihen . . . . . . . . . . . . . .

7.5 Shapley-Index . . . . . . . . . . . .

7.6 Clusteranalyse . . . . . . . . . . . .

7.6.1 Complete-Linkage Verfahren

7.6.2 Single-Linkage Verfahren . .

7.6.3 Average-Linkage Verfahren .

7.7 Akzelerator-Multiplikator-Modell .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

11

11

12

12

13

14

.

.

.

.

.

.

15

15

15

15

16

16

16

.

.

.

.

.

.

.

.

.

.

17

17

17

18

18

18

19

19

20

20

20

8 Schätzer

8.1 Einfache Punktschätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2 Konfidenzintervalle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2.1 Mittelwerte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2.2 Wahrscheinlichkeiten . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2.3 Quantile der Standardnormalverteilung . . . . . . . . . . . . . . . .

8.3 Eigenschaften von Schätzern . . . . . . . . . . . . . . . . . . . . . . . . . .

8.3.1 Erwartungstreue . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.3.2 Wirksamkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.3.3 Die Ungleichung vom arithmetischen und geometrischen Mittel (vereinfachte Form) . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.4 Maximum-Likelihood-Schätzung . . . . . . . . . . . . . . . . . . . . . . . .

8.4.1 Schätzverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.4.2 Logarithmen-Gesetze . . . . . . . . . . . . . . . . . . . . . . . . . .

21

21

22

22

22

22

23

23

23

23

23

23

24

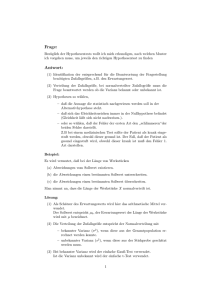

9 Tests

9.1 Testtheorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.2 Der t-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.2.1 Eine Stichprobe . . . . . . . . . . . . . . . . . . . . . . . .

9.2.2 Zwei unabhängige Stichproben . . . . . . . . . . . . . . . .

9.2.3 Zwei abhängige Stichproben . . . . . . . . . . . . . . . . .

9.3 Chi2 -Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.3.1 Allgemeines Testverfahren . . . . . . . . . . . . . . . . . .

9.3.2 Vereinfachte Formel für Vierfeldertafeln . . . . . . . . . . .

9.4 Fisher-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.5 Einfacher Rangsummentest . . . . . . . . . . . . . . . . . . . . . .

9.6 Odds Ratio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.6.1 Bedeutung und Berechnung . . . . . . . . . . . . . . . . .

d. . . . . . . . . . . . . . . . . .

9.6.2 Konfidenzintervalle für OR

9.7 Normalverteilungstest zum Vergleich zweier Wahrscheinlichkeiten

9.8 α und β bei Hypothesentests mit Normalverteilung . . . . . . . .

9.9 F-Test für lineare Regressionsmodelle . . . . . . . . . . . . . . . .

9.10 Varianzanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.10.1 Allgemeine Varianzanalyse (ANOVA) . . . . . . . . . . . .

9.10.2 Rangvarianzanalyse . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

25

25

25

26

26

26

27

27

27

28

29

29

29

30

30

30

31

31

31

32

10 Elementare Prinzipien

10.1 Markov-Ungleichung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10.2 Tschebyscheff-Ungleichung . . . . . . . . . . . . . . . . . . . . . . . . . . .

10.3 Benford-Gesetz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

34

34

34

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1.1

Elementare Wahrscheinlichkeitsrechnung

Kombinatorik

Anzahl möglicher Anordnungen von n Elementen:

n! = n · (n − 1) · (n − 2) · . . . · 2 · 1

Binomialkoeffizient:

n

n!

n

=

=

k

(n − k)! · k!

n−k

Anzahl verschiedener Möglichkeiten der Auswahl von k Elementen aus n:

mit Beachtung der Reihenfolge

mit Wiederholung

k

n

n+k−1

k

ohne Beachtung der Reihenfolge

ohne Wiederholung

n

k ·k!

n

k

Lottoformel: Wahrscheinlichkeit für k Richtige bei einer Ziehung von l Zahlen aus n

n−l

l

·

p(k) = pk = k nl−k

l

1.2

Wahrscheinlichkeit

Definition der Wahrscheinlichkeit nach Laplace:

Ω = Menge aller möglichen Ereignisse

E = Menge aller günstigen Ereignisse, E ⊆ Ω

P (E) =

|E|

Anzahl günstiger Ereignisse

=

|Ω|

Anzahl möglicher Ereignisse

Allgemein:

P (∅) = 0

P (Ω) = 1

A ⊆ Ω ⇒ P (A) ∈ [0, 1]

A ⊆ B ⇒ P (A) ≤ P (B)

Komplementäre Wahrscheinlichkeit:

P (Ac ) = 1 − P (A)

1

Bedingte Wahrscheinlichkeit / Satz von Bayes:

P (A|B) =

P (A ∩ B)

P (B)

P (A ∩ B) = P (A|B) · P (B)

Totale Wahrscheinlichkeit:

P (A) =

n

X

P (A|Bi ) · P (Bi )

i=1

A und B sind stochastisch unabhängig, wenn:

P (A|B) = P (A)

oder äquivalent:

P (A ∩ B) = P (A) · P (B)

1.3

PIE - Prinzip von Inklusion und Exklusion

PIE ist eine Technik zur Bestimmung der Mächtigkeit einer (zusammengesetzten) Menge

mithilfe ihrer Teilmengen. Für je zwei endliche Mengen A und B gilt: |A ∪ B| = |A| +

|B| − |A ∩ B|. Angewendet auf Mengen in einem Wahrscheinlichkeitsraum resultiert die

Siebformel bzw. der Additionssatz für Wahrscheinlichkeiten.

Zwei Teilmengen A und B:

P (A ∪ B) = P (A) + (B) − P (A ∩ B)

Drei Teilmengen A, B und C:

P (A ∪ B ∪ C) = P (A) + (B) + P (C) − P (A ∩ B) − P (A ∩ C) − P (B ∩ C) + P (A ∩ B ∩ C)

Allgemein: Abwechselnde Inklusionen und Exklusionen, d.h. einzelne Teilmengen addieren

(Inklusion), Kombinationen von 2 Teilmengen abziehen (Exklusion), Kobminationen von 3

Teilmengen addieren (Inklusion), Kombinationen von 4 Teilmengen abziehen (Exklusion),

Kombinationen von 5 Teilmengen addieren (Inklusion), ...

2

2

2.1

Wahrscheinlichkeitsverteilungen

Binomialverteilung

Die Binomialverteilung beschreibt die Anzahl der Erfolge in einer Serie von Versuchen. Sei

p die Erfolgswahrscheinlichkeit für einen einzelnen Versuch und n die Anzahl der durchgeführten Versuche, dann ist P (X = k) die Wahrscheinlichkeit, dass die binomial verteilte

Zufallsgröße X den Wert k annimmt, d.h. dass genau k Erfolge erzielt werden. Die Misserfolgswahrscheinlichkeit 1 − p wird dabei meist duch q dargestellt.

n k n−k

P (X = k) =

p ·q

für k = 0, 1, . . . , n

k

k X

n i n−i

P (X ≤ k) =

p ·q

= 1 − P (X ≥ k + 1)

i

i=0

n X

n i n−i

P (X ≥ k) =

p ·q

= 1 − P (X ≤ k − 1)

i

i=k

Erwartungswert:

E(X) = µ = n · p

Varianz:

V (X) = σ 2 = n · p · q

2.2

Poisson-Verteilung

Die Poisson-Verteilung ist eine diskrete Wahrscheinlichkeitsverteilung und gilt als Spezialfall der Binomialverteilung. Sie modelliert die Verteilung seltener Ereignisse (sehr

kleine Erfolgswahrscheinlichkeit). Die Poisson-Verteilung besitzt einen Parameter λ, dieser

bezeichnet die erwartete Ereignishäufigkeit im Beobachtungsintervall. Beispielsweise kann

λ = 2 für 2 gesichtete Sternschnuppen pro Jahr gewählt werden. P2 (X = k) wäre dann

die Wahrscheinlichkeit, dass in einem Jahr k Sternschnuppen gesichtet werden, wobei

durchschnittlich 2 Sichtungen erwartet würden.

Wahrscheinlichkeitsfunktion:

Pλ (k) =

Erwartungswert:

λk −λ

e

k!

∞

X

λk

E(X) =

k e−λ = λ

k!

k=0

Varianz:

V (X) = E(X 2 ) − E(X)2 = λ2 + λ − λ2 = λ

3

2.3

Exponentialverteilung

Dichtefunktion:

(

λe−λx

fλ (x) =

0

x≥0

x<0

Verteilungsfunktion:

Zx

F (x) =

(

1 − e−λx

fλ (t) dt =

0

x ≥ 0,

x < 0.

−∞

Erwartungswert:

Z∞

E(X) =

λxe−λx dx =

1

λ

0

Varianz:

2

Z∞ 1

1

V (X) =

x−

λe−λx dx = 2

λ

λ

0

In der Übung hergeleitet:

1

P (X > k · E(X)) = P (X > k · ) = e−k

λ

2.4

2.4.1

Dichtefunktionen und Verteilungsfunktionen

Dichtefunktionen

Die Dichtefunktion, auch Dichte oder Wahrscheinlichkeitsdichte genannt, dient zur

Beschreibung einer stetigen Wahrscheinlichkeitsverteilung. Die Integration der Dichtefunktion über ein Intervall [a, b] liefert die Wahrscheinlichkeit dafür, dass die zugehörige

Zufallsgröße einen Wert zwischen a und b annimmt. Die Werte einer Dichtefunktion sind

immer ≥ 0 und die Fläche unter ihr ist stets 1.

Vorsicht Verwechslungsgefahr: Die Dichtefunktion an der Stelle a gibt nicht die Wahrscheinlichkeit für das Eintreten von a wieder.

Ist X eine stetige Zufallsvariable, dann benennen wir die Dichte dieser Zufallsgröße mit

f(x) und es gilt:

f (x) ≥ 0

Z ∞

f (x)dx = 1

−∞

Z

b

f (x)dx = P (a ≤ x ≤ b)

a

4

Mithilfe der Dichtefunktion kann man den Erwartungswert und die Varianz stetiger Zufallsvariablen bestimmen:

Z ∞

xf (x)dx

E(X) =

−∞

Z

∞

V (X) =

(x − E(X))2 f (x)dx

−∞

2.4.2

Verteilungsfunktionen

Die kumulative Verteilungsfunktion F (x) einer Zufallsgröße X ist das Integral der Dichtefunktion von −∞ bis x. Umgekehrt ist die Dichtefunktion die Ableitung der Verteilungsfunktion.

Z x

f (t)dt

F (x) =

−∞

dF (x)

dx

Der Wert der Verteilungsfunktion an der Stelle a gibt die Wahrscheinlichkeit an, mit der

die Zufallsgröße X einen Wert ≤ a annimmt:

Z a

P (x ≤ a) = F (a) =

f (x)dx

f (x) = F 0 (x) =

−∞

Z

∞

P (x > a) = 1 − F (a) =

f (x)dx

a

Z

P (a ≤ x ≤ b) = F (b) − F (a) =

b

f (x)dx

a

Die Verteilungsfunktion einer Zufallsgröße nimmt nur Werte von 0 bis 1 an und ist monoton

steigend.

5

3

Grundlegende Parameter

Alle Berechnungsformeln dieses Kapitels sind auf zugrunde liegende Stichproben ausgerichtet. Natürlich können mit ihnen auch die theoretischen Parameter ausgerechnet werden,

wenn die theoretische Verteilung der Zufallsgröße bekannt ist.

3.1

Erwartungswert/Mittelwert/Durchschnitt

Der Erwartungswert d.h. der theoretische Mittelwert einer Größe X wird mit E(X) oder

µ bezeichnet. Meist liegt aber nur eine Stichprobe vor, auf deren Basis dieser theoretische

Mittelwert geschätzt werden muss. Den genutzten Schätzer nennt man meist Durchschnitt,

Stichprobenmittelwert oder empirischen Mittelwert. Er wird mit x̄ oder auch µ̂ bezeichnet.

x̄ = Mittelwert/Durchschnitt (n = Gesamtanzahl, xi = Ausprägungen)

Pn

1

n · Pi=1 xi , wenn n Werte x1 . . . xn gegeben

x̄ = n1 · m

i=1 xi · H(xi ), wenn absolute Häufigkeiten H(xi ) für m Klassen x1 . . . xm gegeben

P m

i=1 xi · h(xi ), wenn relative Häufigkeiten h(xi ) für m Klassen x1 . . . xm gegeben

3.1.1

Eigenschaften des Erwartungwerts

X und Y seinen Zufallsgrößen, a sei eine Konstante.

E(a · X) = a · E(X)

E(X + Y ) = E(X) + E(Y )

E(X + a) = E(X) + a

3.2

Varianz und Streuung

Die Varianz V (X) oder σ 2 beschreibt die mittlere quadratische Abweichung vom Mittelwert. Ihre positive Wurzel σ wird Streuung oder Standardabweichung genannt. Ähnlich

wie beim Erwartungswert muss die wahre Varianz meist basierend auf einer Stichprobe

geschätzt werden. Ihr Schätzer wird empirische Varianz oder Stichprobenvarianz genannt

und mit s2 bezeichnet.

s2 = s2x =Varianz

√

s = sx = s2 = Streuung

Allgemeine Formel:

n

1 X

s = ·

(xi − x̄)2

n i=1

2

6

Äquivalente Momentenformel:

s2 = x2 − x̄2

Häufig wird die Varianz mit den obigen Formeln zu gering eingeschätzt, weshalb zur Bestimmung der Stichprobenvarianz meist eine korrigierte Formel Verwendung findet, bei der

man nicht durch n, sondern durch n − 1 teilt:

s2 =

3.2.1

n

X

1

·

(xi − x̄)2

n − 1 i=1

Eigenschaften der Varianz

X sei eine Zufallsgröße und a eine Konstante.

V (X) = E(X 2 ) − E(X)2

V (a · X) = a2 · V (X)

V (X + a) = V (X)

V (−X) = V (X)

3.3

Kovarianz

sxy =Kovarianz von x und y

Allgemeine Formel:

sxy =

n

1 X

·

(xi − x̄) · (yi − ȳ)

n i=1

Äquivalente Momentenformel:

sxy = xy − x̄ · ȳ

Hinweis: Die Kovarianz einer Zufallsgröße mit sich selbst liefert ihre Varianz.

7

4

Untersuchung linearer Zusammenhänge

4.1

Lineare Regression

Wertepaare/Punkte (xi , yi ) sind gegeben. Es wird eine Gerade berechnet, sodass die

Summe aller quadrierten Abstände zwischen den Punkten und dieser Gerade minimal ist.

Regressionsgerade:

y = ȳ +

4.2

sxy

xy − x̄ · ȳ

· (x − x̄) = ȳ +

· (x − x̄)

2

sx

x2 − x̄2

Robuste Regression nach Theil

bestimmt.

In der obigen Variante wird die Steigung der Regressionsgerade durch xy−x̄·ȳ

x2 −x̄2

Bei der robusten Regression nach Theil wird sie stattdessen als Median der Steigungen

einzelner Punkt-Paare berechnet, um den Einfluss von Ausreißern zu verringern.

Berechnung:

1. Ordne alle xi aufsteigend an und teile diese Reihe dann in zwei Hälften (bei einer

ungeraden Anzahl von Werten wird der Mittlere weggelassen).

2. Für jedes xi aus der unteren Hälfte wird dann die Steigung zu jedem xj aus der

y −y

oberen Hälfte berechnet: mij = xjj −xii

3. Bestimme den Median aller berechneten Anstiege und verwende diesen als robuste

Steigung anstelle von xy−x̄·ȳ

in der allgemeinen Formel für die Regressionsgrade.

x2 −x̄2

4.3

Lineare Regression nach Gauß-Markov

Bei der einfachen linearen Regression wird eine Regressionsgerade bestimmt, welche die

Veränderung der Zielgröße in Abhängigkeit von der Einflussgröße beschreibt. Meist wirken sich aber mehrere Einflussgrößen auf eine Zielgröße aus. Den Grundsatz für die Modellierung solcher komplexer wirtschaftlicher Zusammenhänge bietet das Gauß-MarkovTheorem. Seine Anwendung wird auch als GM-Schätzung bezeichnet.

4.3.1

Regressionsmodell und Koeffizientenschätzung

Y : Zielgröße (Response)

X1 , . . . , Xk : Einflussgrößen (Regressoren)

k : Anzahl der Einflussgrößen

n : Anzahl der Messungen

β1 , . . . , βk : Regressionskoeffizienten (Anstiege von Y ) für die Einflussgrößen

8

Für jede Messung gibt es einen Wert von Y und einen für jedes X1 , . . . , Xk . Mithilfe der

Regressionskoeffizienten kann man dann pro Messung eine Gleichung aufstellen, welche die

Effekte von X1 , . . . , Xk auf Y beschreibt:

y1 = β1 x11 + β2 x12 + β3 x13 + · · · + βk x1k + 1

y2 = β1 x21 + β2 x22 + β3 x23 + · · · + βk x2k + 2

y3 = β1 x31 + β2 x32 + β3 x33 + · · · + βk x3k + 3

..

.

yn = β1 xn1 + β2 xn2 + β3 xn3 + · · · + βk xnk + n

Fasst man alle gemessenen y1 . . . yn in einem Vektor y zusammen, sowie alle β1 . . . βk in

einem weiteren Vektor β, dann kann man auch alle x11 . . . xnk in einer n × k−Matrix X

zusammen fassen. Die Gleichungen von oben vereinfachen sich dann zu:

y =β·X +

Für das Regressionsmodell ist nun der Koeffizientenvektor β zu schätzen. Ein erwartungstreuer Schätzer hierfür ist nach dem Gauß-Markov-Theorem:

β̂ = (X T X)−1 X T y

Vorgehensweise zum Berechnen von β̂:

1. Aufstellen der Matrix X und des Vektors y aus den gegebenen Daten

2. Matrix X zu X T transformieren

3. X T X berechnen und Inverse davon bilden

4. Alles in die obige Formel einsetzen und so β̂ berechnen

Bei Bedarf kann als 5. Schritt das komplette Modell aufgestellt werden, indem β̂ in die

Modellgleichung y = β · X + eingesetzt wird.

4.3.2

Schätzung der Varianz

Wurde β̂ berechnet, so kann auch die Gauß-Markov-Varianz (GM-Varianz) geschätzt werden durch:

1

(y − X β̂)T (y − X β̂)

σ̂ 2 =

n−k

9

4.4

Korrelationskoeffizient nach Pearson

Der Korrelationskoeffizient r ist ein Maß für den linearen Zusammenhang von 2 Merkmalen.

r=

sxy

xy − x̄ · ȳ

q

=p

sx · sy

2

2

x − x̄ · y 2 − ȳ 2

Es gilt −1 ≤ r ≤ 1.

Falls r ≈ 0 ⇒ x und y sind unkorreliert.

Falls r > 0 ⇒ x und y sind positiv korreliert.

Falls r < 0 ⇒ x und y sind negativ korreliert.

Unabhängige Variablen sind stets unkorreliert, aber die Umkehrung gilt nicht: Unkorrelierte

Variablen können durchaus abhängig voneinander sein!

4.5

Rangkorrelationskoeffizient nach Spearman

Den Datenreihen x1 ...xn und y1 ...yn werden Rangzahlen Ri bzw. Si zugeordnet. Jedes

Wertepaar (xi , yi ) hat dann ein Rangpaar (Ri , Si ) mit der Rangdifferenz di = Ri − Si .

P

6 · ni=1 d2i

, wobei − 1 ≤ rspearman ≤ 1

rspearman = 1 −

n · (n2 − 1)

4.6

Anpassungsgüte

P

Totale Variabilität: SQtotal = ni=1 (yi − ȳ)2

P

(yi − ŷi )2

Residuenanteil der totalen Variabilität: SQresidual = ni=1P

Regressionsanteil der totalen Variabilität: SQregression = ni=1 (ŷi − ȳ)2

Es gilt: SQtotal = SQresidual + SQregression

Anpassungsgüte:

SQresidual

R2 = 1 −

, wobei 0 ≤ R2 ≤ 1

SQtotal

2

Bei linearer Regression gilt: R2 = rpearson

10

5

5.1

Visualisierungsmethoden

Stängel-Blatt-Diagramm

Dieses Diagramm dient zur Visualisierung von Häufigkeitsverteilungen, wobei jede Einzelbeobachtung erhalten bleibt (nur für geringe Datenmengen geeignet).

Es besteht aus zwei Spalten. Die linke Spalte enthält die Äquivalenzklassen (Stängel), in

welche die auf der rechten Seite dargestellten Merkmale (Blätter) eingeteilt werden.

5.2

Boxplot und benötigte Parameter

min = Minimum, kleinster Wert

max = Maximum, größter Wert

Modus/Modalwert = häufigster Wert

Quantile für Gesamtanzahl n und Anteil p:

(

1

(xn·p + xn·p+1 ), wenn n · p ganzzahlig

x̃p = 2

xdn·pe , wenn n · p nicht ganzzahlig

x̃0,25 = unteres Quartil

x̃0,5 = Median

x̃0,75 = oberes Quartil

x̃0,75 − x̃0,25 = IQR (Interquartilsabstand)

xi ist ein Ausreißer, falls xi ≤ x̃0,25 − 1, 5 · IQR oder xi ≥ x̃0,75 + 1, 5 · IQR

Box-Plot:

11

5.3

Histogramm

Das Histogramm ist eine Möglichkeit zur Darstellung der Häufigkeitsverteilung metrischer

Variablen. Dazu ist eine Einteilung der Daten in Klassen gleicher oder unterschiedlicher

Breite nötig.

Es wird ein Balken pro Klasse gezeichnet, der direkt an die Balken der Nachbarklassen

anschließt und dessen Fläche proportional zur relativen Häufigkeit der Klasse ist. (Höhe

des Balkens = Klassenhäufigkeit/Klassenbreite)

5.4

Lorenzkurve und Gini-Koeffizient

Die Lorenzkurve ist eine Funktion im Einheitsquadrat und dient zur Veranschaulichung

der Disparität/Ungleichheit einer Verteilung.

Die X-Achse wird entsprechend der Klassen von Merkmalsträgern in gleich oder

verschieden große Abschnitte eingeteilt. Für jede Klasse wird ihr Anteil an der Merkmalssumme berechnet. Die Lorenz-Kurve ist dann abschnittsweise linear durch die Punkte

(0|0), (u1 |v1 ) , (u2 |v2 ) , . . . , (un |vn ) = (1|1) definiert.

xj = Abschnittslängen für die Klassen der Merkmalsträger

yj = Anteile an der Merkmalssumme

i

P

ui =

xj

vi =

j=1

i

P

yj

j=1

Die Lorenz-Kurve ist konvex und liegt daher immer unter der Diagonale. Je gleichmäßiger

die Verteilung ist, umso mehr nähert sie sich der Diagonalen an.

12

Der Gini-Koeffizient G ∈ [0, 1] beschreibt die zweifache Abweichung der Lorenzkurve von

der Diagonalen. Je ungleichmäßiger die Verteilung, desto größer G.

G=1−

5.5

1

· (2 · (v0 + v1 + · · · + vn−1 ) + 1)

n

Verteilungstabellen

1-dimensional:

Die Zufallsvariable X habe die Ausprägungen x1 , x2 und x3 . Bei n Beobachtungen treten

diese mit den Häufigkeiten H(x1 ), H(x2 ) und H(x3 ) auf. Die relativen Häufigkeiten der

1)

....

einzelnen Ausprägungen sind somit P (X = x1 ) = H(x

n

P

xi

x1

x2

x3

absolute Häufigkeiten:

H(xi ) H(x1 ) H(x2 ) H(x3 ) n

P

xi

x1

x2

x3

relative Häufigkeiten:

P (X = xi ) P (x1 ) P (x2 ) P (x3 ) 1

2-dimensional:

Analog zum 1-dimensionalen Fall, aber es wird zusätzlich eine zweite Zufallsariable Y mit

den Ausprägungen y1 und y2 betrachtet.

P

x1

x2

x3

y

H(x1 ∩ y1 ) H(x2 ∩ y1 ) H(x3 ∩ y1 ) H(y1 )

absolute Häufigkeiten: 1

y2 H(x1 ∩ y2 ) H(x2 ∩ y2 ) H(x3 ∩ y2 ) H(y2 )

P

H(x1 )

H(x2 )

H(x3 )

n

P

x1

x2

x3

y1 P (x1 ∩ y1 ) P (x2 ∩ y1 ) P (x3 ∩ y1 ) P (y1 )

relative Häufigkeiten:

y2 P (x1 ∩ y2 ) P (x2 ∩ y2 ) P (x3 ∩ y2 ) P (y2 )

P

P (x1 )

P (x2 )

P (x3 )

1

13

5.6

Empirische Verteilungsfunktion

absolute Häufigkeit: H(aj ), Anzahl des Auftretens von aj

H(a )

relative Häufigkeit: h(aj ) = n j , wobei n =Gesamtanzahl

empirische Verteilungsfunktion:

X

F (x) =

h(aj )

aj ≤x

Die Funktion wächst monoton von 0 bis 1 und verläuft konstant zwischen aj und aj+1 ∀j.

Ihre Erscheinung ähnelt dadurch einer Treppe.

14

6

6.1

Stochastische Graphen

Allgemeine Markov-Ketten

n verschiedene Zustände, n ≥ 2

zufälliger Übergang von Zustand i nach

Übergangsmatrix:

p00

p10

M = p20

..

.

pn0

Zustand j mit der Wahrscheinlichkeit pij

p01 p02

p11 p12

p21 p22

..

..

.

.

pn1 pn2

. . . p0n

. . . p1n

. . . p2n

. . . ..

.

. . . pnn

pii < 1 → i ist ein innerer Zustand

pii = 1 → i ist ein absorbierender Zustand/Randzustand

R = Randmenge, Menge aller absorbierenden Zustände

6.2

Mittelwertsregeln

1. Mittelwertsregel

Die Wahrscheinlichkeit eines inneren Zustands ist das gewichtete Mittel der Wahrscheinlichkeiten seiner Nachbarn.

2. Mittelwertsregel

Der Erwartungswert eines inneren Zustands ist 1 + das gewichtete Mittel der Erwartungswerte seiner Nachbarn.

Alle folgenden Berechnungsformeln für stochastische Graphen beruhen im Wesentlichen

auf diesen beiden Mittelwertsregeln.

6.3

Stationäre Verteilung

vt = (v (0) , v (1) , v (2) , . . . v (n) ): Verteilungsvektor zum Zeitpunkt t

v (i) entspricht der Wahrscheinlichkeit, zum Zeitpunkt t in Zustand i zu sein.

Die Summe der v (i) ist für jeden Zeitpunkt gleich 1.

Es gilt:

vt+1 = vt · M ⇒ vt+1 = vo · M t ∀t

Existiert eine stationäre Verteilung v, so gilt für diese:

v =v·M

Mithilfe dieser Eigenschaft kann ein Gleichungssystem aufgestellt werden.

v (0) + v (1) + v (2) + · · · + v (n) = 1 wird als weitere Gleichung aufgenommen.

Damit ist die Bestimmung aller v (i) durch Lösen des Systems möglich.

15

6.4

Gewinnwahrscheinlichkeiten

Die Randzustände werden in Gewinn- und Verlustzustände eingeteilt.

gi = Gewinnwahrscheinlichkeit von Zustand i

0, falls i Verlustzustand

gi = 1, falls i Gewinnzustand

P

j pij · gj , sonst

Ermittlung der gi durch Lösen des resultierenden Gleichungssystems.

6.5

Mittlere Spielzeiten/Wartezeiten

wi = mittlere Spielzeit beim Start in Zustand i

(mittlere Anzahl der Übergänge bis zum Erreichen eines Zustands aus R)

(

0, falls i ∈ R

wi =

P

1 + j pij · wj , sonst

Ermittlung der wi durch Lösen des resultierenden Gleichungssystems.

6.6

Mittleres Kapital

Beim Übergang von Zustand i nach Zustand j mit der Wahrscheinlichkeit pij erhält bzw.

zahlt der Spieler einen zuvor festgelegten Betrag bij . Dieser Betrag kann konstant sein,

oder für jedes i bzw. j verschieden.

ki = mittleres Kapital, das beim Start in Zustand i erspielt wird (oder gezahlt werden

muss falls ki < 0)

(

0, falls i ∈ R

ki = P

j pij · (kj + bij ), sonst

Ermittlung der ki durch Lösen des resultierenden Gleichungssystems.

16

7

7.1

Ökonomische Modelle

Bedienungstheorie

λ: eintreffende Kunden pro Zeiteinheit

µ: bearbeitete Kunden pro Zeiteinheit

ρ = µλ : Auslastungskoeffizient/Verkehrsrate

Formeln für das Modell: 1 Bedienelement und ∞ viele Warteplätze

Gültigkeit der Formeln nur bei ρ < 1

Stationäre Verteilung:

p0 = 1 − ρ

pn = ρ n · p0

Mittlere Anzahl der Kunden im System:

L=

λ

µ−λ

Mittlere Anzahl der Kunden in der Warteschlange:

LS =

7.2

λ2

µ · (µ − λ)

Zinsen und Kredite

i = Zinssatz

r = 1 + i = Aufzinsungsfaktor

v = 1r = Abzinsungs-/Diskontierungsfaktor

Kt = K(t) = Kapital zur Zeit t

n = Laufzeit in Jahren

m = Anzahl der Zahlungsperioden pro Jahr

1

im = m · (r m − 1) = Zinssatz für die Periode

1

m

(rm und vm analog)

Verzinsung über mehrere Jahre:

Kn = K0 · r n

Annuitätentilgung zur Kreditrückzahlung:

A=K·

i

1 − vn

Am = K ·

bzw.

17

im

n)

m · (1 − vm

7.3

Preisindizes

p0 (i) = Preis der Ware i zum Zeitpunkt 0

pt (i) = Preis der Ware i zum Zeitpunkt t

q0 (i) = Menge der Ware i zum Zeitpunkt 0

qt (i) = Menge der Ware i zum Zeitpunkt t

Preisindex nach Laspeyres:

pLaspeyres

0t

Pn

pt (i) · q0 (i)

= Pni=1

i=1 p0 (i) · q0 (i)

pP0taasche

Pn

pt (i) · qt (i)

= Pni=1

i=1 p0 (i) · qt (i)

Preisindex nach Paasche:

7.4

Zeitreihen

Eine Zeitreihe x1 , x2 , x3 , x4 , . . . , xT = {xt }Tt=1 ist eine Folge von Datenpunkten. Um kleine,

zufällige Schwankungen zu eliminieren, oder Saisoneffekte zu reduzieren, können Zeitreihen

geglättet werden. Eine einfache Methode dafür sind gleitende Durchschnitte:

yt =

k

X

xt+i · ai

wobei ai Gewichte und

X

ai = 1

i

i=−k

Saisonbereinigung

1. Glättung mit gleitendem Durchschnitt, die Länge entspricht jener der vermuteten

Periode der Saison

2. Differenzenbildung zwischen Ursprungsreihe und geglätteter Reihe

3. Berechnung der Saisonfigur durch Mittelung der Differenzen gleicher Zeitpunkte innerhalb der Periode

4. Standardisierung der Saisonfigur auf den Mittelwert 0 (von jedem Wert den Durchschnitt abziehen)

5. Bestimmung der bereinigten Zeitreihe, durch Abziehen der standardisierten Saisonfigur von der Ursprungsreihe

7.5

Shapley-Index

1.) Bildung aller möglichen Permutationen der Elemente

2.) Bestimmung des mehrheitslieferden Elements für jede Permutation

mit xi als Mehrheitsbringer

3.) Shapley-Index von Element xi = Permutationen

alle Permutationen

18

7.6

Clusteranalyse

Die Clusteranalyse dient zur Entdeckung von Ähnlichkeitsstrukturen in Datenbeständen.

Einzelne Objekte werden mit ähnlichen Elementen schrittweise in Gruppen, den sogenannten Clustern, zusammengefasst. Am Ende befinden sich alle Objekte in einem

einzigen großen Cluster, aber das wichtige Ergebnis der Clusteranalyse sind die Cluster

der einzelnen Zwischenschritte. Man erhält so Cluster mit ähnlichen Elementen, mithilfe

derer man die Objekte in n, n − 1, . . . 3, 2, 1 Klassen einteilen kann.

Es gibt verschiedene Methoden der Clusteranalyse. Diese unterscheiden sich hinsichtlich

der Berechnung der Abstände zwischen den einzelnen Clustern.

7.6.1

Complete-Linkage Verfahren

Bei dieser Methode der Cluster-Analyse wird der Abstand zwischen zwei Clustern als

maximaler Abstand aller Elementpaare aus den beiden Clustern bestimmt. Ein Cluster

hat dabei zu sich selbst immer den Abstand 0.

D(C1 , C2 ) := Abstand der Cluster C1 und C2

d(i, j) := Abstand der Objekte i und j

D(C1 , C2 ) =

max d(i, j) und D(C, C) = 0

i∈C1 ,j∈C2

Ablauf der Clusteranalyse

Zu Beginn ist eine Matrix mit den Abständen d(i, j) aller Objekte untereinader gegeben.

Es werden dann die folgenden 4 Schritte solange wiederholt, bis nur noch 2 Cluster übrig

sind:

1. Suche aus der Matrix den geringsten Abstand, der nicht null ist.

2. Fasse die beiden Elemente mit diesem minimalen Abstand zu einem Cluster zusammen. Alle weiteren Cluster bleiben bestehen und werden nur entsprechend umbenannt.

3. Bestimme die Distanzen des neu gebildeten Clusters zu den anderen. Die Abstände

zwischen unveränderten Clustern bleiben gleich, man muss aber die Umbenennungen

beachten.

4. Stelle eine aktualisierte Distanzmatrix auf und beginne von vorn. Es gibt jetzt insgesamt ein Cluster weniger als vorher.

Wenn nur noch zwei Cluster übrig sind, dann werden diese in einem letzten Schritt zu

einem einzigen zusammengefasst. Rechenschritte sind dafür nicht mehr nötig.

19

7.6.2

Single-Linkage Verfahren

Hier wird der Abstand zwischen zwei Clustern als minimaler Abstand aller Elementpaare

aus den beiden Clustern bestimmt. Ein Cluster hat dabei zu sich selbst immer den

Abstand 0.

D(C1 , C2 ) =

7.6.3

min

i∈C1 ,j∈C2

d(i, j) und D(C, C) = 0

Average-Linkage Verfahren

Hier wird der Abstand zwischen zwei Clustern als durchschnittlicher Abstand aller

Elementpaare aus den beiden Clustern bestimmt. Ein Cluster hat dabei zu sich selbst

immer den Abstand 0.

D(C1 , C2 ) =

X

1

d(i, j) und D(C, C) = 0

|C1 | · |C2 | i∈C ,j∈C

1

7.7

2

Akzelerator-Multiplikator-Modell

Dieses Modell dient zur Beschreibung des Zusammenhangs von Einkommen, Investitionen und Konsum. α (Sparen) und β (Ausgeben) sind konstante Koeffizienten, xt (Weißes

Rauschen) beschreibt das zufällige Einkommen zur Zeit t.

Ct = α · Yt−1

It = β · (Ct − Ct−1 ) + xt

Yt = Ct + It

Einsetzen liefert den Einkommensprozess:

Yt = α · (1 + β) · Yt−1 − α · β · Yt−2 + xt

20

8

Schätzer

Schätzer werden verwendet, um unbekannte statistische Größen anzunähern. Geschätzt

werden meist Mittelwerte, Streuungen oder Wahrscheinlichkeiten, es sind aber auch zahlreiche andere Parameter möglich. Für die Schätzung existiert dabei oft mehr als ein Schätzer,

genutzt werden aber hauptsächlich die einfachen, intuitiven Schätzfunktionen. Es wird unter anderem zwischen Punkt-Schätzern und Bereichs- bzw. Intervallschätzern differenziert.

Punkt-Schätzer, wie beispielsweise der Stichprobenmittelwert, liefern einen einzelnen Wert

für den zu schätzenden Parameter. Intervallschätzer (Konfidenzintervalle) hingegen liefern

einen Bereich, in welchem der geschätzte Parameter mit einer gewissen Sicherheit liegt.

8.1

Einfache Punktschätzer

geschätzter Parameter

Schätzer

Mittelwert/Erwartungswert

E(X) bzw. µ

Durchschnitt/Stichprobenmittelwert

x̄ bzw. µ̂

Streuung/

Standardabweichung

σ

Stichprobenstreuung/empirische Streuung/

empirische Standardabweichung

s

Varianz

V (X) bzw. σ 2

empirische Varianz

s2

relative Ereignishäufigkeit/

Wahrscheinlichkeit

π bzw. p

geschätzte relative Häufigkeit/

geschätzte Wahrscheinlichkeit

p̂

Odds Ratio

OR

geschätzter Odds Ratio

d

OR

Beispiele für einfache intuitive Schätzformeln bei einer Stichprobe der Größe n mit

Beobachtungen xi und k- fachem Auftreten eines bestimmten Ereignisses:

p̂ =

x̄ = µ̂ =

v

u

u

s=t

k

n

n

1 X

·

xi

n i=1

n

X

1

·

(xi − x̄)2

n − 1 i=1

21

8.2

Konfidenzintervalle

Ein Konfidenzintervall gibt Informationen über die Präzision der Schätzung eines Parameters. Würde man denselben Versuch beliebig oft durchführen, so enthielte das Konfidenzintervall mit einer gewissen Häufigkeit (Konfidenzniveau) den wahren Wert des Parameters. Als Konfidenzniveau wird meist 95% verwendet. Im folgenden Abschnitt gilt

c = Φ−1 (1 − α2 ), dies beschreibt das (1 − α2 )-Quantil der Standardnormalverteilung.

8.2.1

Mittelwerte

KI für µ bei bekannter Streuung σ:

h

σ

σi

x̄ − c · ; x̄ + c ·

n

n

KI für µ bei geschätzter Streuung s:

v

u

n

i

h

X

u 1

s

s

t

mit s =

·

(xi − x̄)2

x̄ − c · ; x̄ + c ·

n

n

n − 1 i=1

oder äquivalent:

x̄ − c ·

8.2.2

s

s

; x̄ + c ·

n−1

n−1

v

u

n

u1 X

t

·

(xi − x̄)2

mit s =

n i=1

Wahrscheinlichkeiten

KI für p, mithilfe des Schätzers p̂:

"

#

r

r

p̂ · (1 − p̂)

p̂ · (1 − p̂)

p̂ − c ·

; p̂ + c ·

n

n

8.2.3

Quantile der Standardnormalverteilung

Konfidenzniveau 1 − α

90%

95%

99%

99,7%

99,9%

c = Φ−1 (1 − α2 )

1, 64

1, 96

2, 58

3

3, 2

In der Regel wird für 95% vereinfacht c = 2 und oft auch für 99,9% c = 3 genutzt.

22

8.3

8.3.1

Eigenschaften von Schätzern

Erwartungstreue

Ein Schätzer heißt erwartungstreu, wenn sein Erwartungswert dem wahren Wert des

zu schätzenden Parameters entspricht. Anderenfalls spricht man von einem verzerrten

Schätzer. Die Abweichung des Erwartungswerts von der zu schätzenden Größe wird dann

Verzerrung oder Bias genannt.

Beispiel:

P

Sei X eine Zufallsgröße mit dem Erwartungswert µ und x̄ := n1 · ni=1 xi der Schätzer für

µ basierend auf der Stichprobe S = x1 , x2 , ...xn . Dann ist x̄ ein erwartungstreuer Schätzer

wenn gilt: E(x̄) = µ

8.3.2

Wirksamkeit

Gibt es mehrere erwartungstreue Schätzer für einen Parameter, so besitzt der wirksamste

Schätzer die geringste durchschnittliche Abweichung vom wahren Wert. Ein wirksamster

Schätzer ist also immer jener mit der minimalsten Varianz.

8.3.3

Die Ungleichung vom arithmetischen und geometrischen Mittel (vereinfachte Form)

Es gilt:

Pn

i=1

n

8.4

8.4.1

ai

2

Pn

≤

i=1

a2i

n

Maximum-Likelihood-Schätzung

Schätzverfahren

Bei der Schätzung von Parametern nach dem Maximum-Likelihood-Prinzip wird jener

Schätzer bestimmt, welcher basierend auf der beobachteten Stichprobe, die größte bzw.

maximale Wahrscheinlichkeit hat. Es werden dabei immer folgende 3 Schritte durchgeführt:

1. Aufstellen der Likelihood-Funktion L(λ), wobei λ der zu schätzende Parameter ist.

Diese Funktion drückt vereinfacht die Wahrscheinlichkeit des Eintretens der beobachteten Stichprobe in Abhängigkeit von λ aus. Sie wird meist durch Multiplikation

aller Einzelereignisse aufgestellt.

2. Logarithmieren der Likelihood-Funktion L(λ) zu L (λ)

3. Ableiten der logarithmierten Funktion L (λ) und Bestimmen des Maximums. (übliche

Extremwertbestimmung)

23

Bei mehreren Parametern λ1 , λ2 , . . . wird L (λ) für jeden Parameter einzeln abgeleitet und

das jeweilige Maximum bestimmt. Dies ist dann der Maximum-Likelihood-Schätzer für den

Parameter, nach dem abgeleitet/differenziert wurde.

8.4.2

Logarithmen-Gesetze

log(a · b) = log(a) + log(b)

log(ab ) = b · log(a)

log(a)0 =

24

1

a

9

9.1

Tests

Testtheorie

H0 : Nullhypothese

H1 : Alternativhypothese

T : Testgröße

Die Testgröße T wird basierend auf dem gewählten Test bestimmt. Meist gibt es eine Grenze

(einseitiger Test) oder zwei Grenzpunkte (zweiseitiger Test), wodurch der Wertebereich

der Testgröße in den Normal- und den Extrembereich eingeteilt wird. Liegt T innerhalb

des Normalbereichs, so ist das Ergebnis nicht signifikant und H0 bleibt bestehen. Liegt T

dagegen im Extrembereich, so ist das Ergebnis signifikant; in diesem Fall wird H0 verworfen

bzw. abgelehnt und H1 angenommen.

Realität

H0 gilt

H1 gilt

H0 gilt

richtige Entscheidung

(Spezifität, 1- α)

β (Fehler 2. Art)

H1 gilt

α (Fehler 1. Art)

richtige Entscheidung

(Power, Sensitivität, 1- β)

Test

Wird H0 abgelehnt, obwohl korrekt, nennt man dies α oder den Fehler 1. Art. α wird

oftmals zu Beginn der Analysen als angestrebte Irrtumswahrscheinlichkeit des Tests

festgelegt, um die Grenze zur Annahme oder Ablehnung von H0 zu bestimmen. In der

Regel gilt dabei α = 5%. Kommt es aufgrund des Tests nicht zur Ablehnung von H0 ,

obwohl H1 zutrifft, wird dies β oder Fehler 2. Art genannt.

Es gilt:

Je größer α desto kleiner β und umgekehrt.

Je größer n desto kleiner α und β bei gleicher Grenze.

9.2

Der t-Test

Ein parametrisches Testverfahren zum Vergleich eines Mittelwertes mit einem festen Wert oder zum Vergleich der Mittelwerte zweier Stichproben. Der Test basiert auf

der t-Verteilung; zum Ablesen der Grenzwerte wird eine Tabelle dieser Verteilung benötigt.

Der errechnete Wert für T wird bei jeder Form des t-Tests mit dem Grenzwert aus der

Tabelle für das festgelegte α und die Freiheitsgrade f verglichen. Ist T positiv, dann ist

der Test signifikant, falls T > Grenzwert. Ist T negativ, dann ist der Test signifikant, falls

T < −Grenzwert.

25

9.2.1

Eine Stichprobe

X : normalverteilte Zufallsgröße mit Beobachtungen xi

H0 : µ = µ0

H1 : Alternativhypothese, µ 6= µ0 (zweiseitig) oder µ < µ0 bzw. µ > µ0 (einseitig)

f = n − 1 : Anzahl der Freiheitsgrade

T : Testgröße

v

u

n

X

u 1

x̄ − µ0 √

t

· n mit s =

·

T =

(xi − x̄)2

s

n − 1 i=1

äquivalent ist:

T =

9.2.2

x̄ − µ0 √

· n−1

s

mit

v

u

n

u1 X

t

s=

·

(xi − x̄)2

n i=1

Zwei unabhängige Stichproben

X : normalverteilte Zufallsgröße mit n1 Beobachtungen xi , Mittelwert x̄, Varianz s2x

Y : normalverteilte Zufallsgröße mit n2 Beobachtungen yi , Mittelwert ȳ, Varianz s2y

H0 : µx = µy

H1 : µx 6= µy (zweiseitig) oder µx < µy bzw. µx > µy (einseitig)

f = n1 + n2 − 2 : Anzahl der Freiheitsgrade

T : Testgröße

s

(n1 − 1) · s2x + (n2 − 1) · s2y

1

x̄ − ȳ

1

T =

mit s =

·

+

s

n1 + n2 − 2

n1 n2

9.2.3

Zwei abhängige Stichproben

X : Erste Messung der Zufallsgröße mit Beobachtungen xi

Y : Zweite Messung der Zufallsgröße mit Beobachtungen yi

di = xi − yi : Differenzen z.B. pro Individuum

H0 : µx = µy , also δ = µx − µy = 0 oder ein δ ∈ R

H1 : µx 6= µy , also δ 6= 0 bzw. ungleich dem Wert aus H0 (zweiseitig, einseitig analog)

f = n − 1 : Anzahl der Freiheitsgrade

T : Testgröße

v

u

n

n

X

¯

u1 X

d−δ √

1

t

¯

¯2

T =

· n − 1 mit d = ·

di und sd =

·

(di − d)

sd

n i=1

n i=1

26

äquivalent ist:

d¯ − δ √

T =

· n

sd

9.3

9.3.1

n

1 X

¯

d= ·

di

n i=1

mit

und

v

u

u

sd = t

n

X

1

¯2

·

(di − d)

n − 1 i=1

Chi2 -Test

Allgemeines Testverfahren

Der Chi2 -/χ2 -/Chi-Quadrat-Test prüft die stochastische Abhängigkeit von zwei Merkmalen basierend auf einer Häufigkeitstabelle. Die Tabelle muss dabei keine Vierfeldertafel

sein, sondern kann beliebig viele Zeilen und Spalten besitzen. Jedoch ist es Voraussetzung

für den Chi2 -Test, dass die Einträge in jedem Feld mindestens 5 betragen. Ist dies nicht der

Fall, dann können Zeilen oder Spalten zusammengeführt werden, um die Voraussetzung

zu erfüllen. Der Wert für die Testgröße χ2 wird mit dem abgelesenen Grenzwert aus der

Chi2 -Tabelle verglichen. Der Test ist dann signifikant, falls χ2 > Grenzwert.

H0 : Unabhängigkeit

H1 : Abhängigkeit

m, n : Anzahl der Zeilen bzw. der Spalten der Tabelle

f : (m − 1) · (n − 1), also (Zeilenzahl − 1) · (Spaltenzahl − 1)

beobachtete Häufigkeiten: Einträge der Tabelle

erwartete Häufigkeiten:

Zeilensumme · Spaltensumme

Gesamtsumme

Testgröße:

( beobachtete H. − erwartete H. )2

χ =

erwartete H.

alleF elder

2

X

Hinweis: Sind die beobachteten und erwarteten Häufigkeiten nicht für alle Felder bekannt,

so kann χ2 zumindest für die bekannten Felder bestimmt werden. Ist dieses ”partielle”χ2

bereits größer als der Grenzwert, dann ist der Test signifikant. Ist es aber kleiner als der

Grenzwert, so kann keine Aussage über die Signifikanz getroffen werden.

9.3.2

Vereinfachte Formel für Vierfeldertafeln

Soll der Chi2 -Test für eine Vierfeldertafel durchgeführt werden, dann kann auch die folgende äquivalente Formel genutzt werden:

χ2 =

n(ad − bc)2

(a + b)(a + c)(b + d)(c + d)

27

9.4

Fisher-Test

Der Fisher-Test ist ein Abhängigkeitstest mit Hilfe der Vierfeldertafel. Er ist ein exaktes

Testverfahren, das auch bei geringen Werten zuverlässig ist, allerdings basiert es auf der

Berechnung von Binomialkoeffizienten, die extrem schnell größer werden. Deshalb können

wir bei wirklich großen Stichproben keinen Fisher-Test mehr anwenden.

H0 : Unabhängigkeit (des Zeilenmerkmals vom Spaltenmerkmal)

H1 : Abhängigkeit

B

B̄

Summe

A

a

c

a+c

Ā

b

d

b+d

Summe

a+b

c+d

n=a+b+c+d

Getestet wird, mit welcher Wahrscheinlichkeit das beobachtete Ereignis oder ein extremeres eintritt. Die Testentscheidung richtet sich danach, wie sich P(Beobachtung oder

extremeres Ereignis) und α zueinander verhalten. Ist der Testwert kleiner als α, besteht

ein signifikanter Unterschied und H0 wird abgelehnt. Ist der Testwert hingegen größer als

α, dann besteht kein signifikanter Unterschied und die Nullhypothese wird beibehalten.

Berechnung:

Es gibt insgesamt 8 verschiedene Möglichkeiten zur Berechnung der Wahrscheinlichkeit

der Beobachtung. Es wird immer eines der 4 Felder als Orientierungspunkt ausgewählt

und dann die Zeilen-“ oder Spaltenmethode“ verwendet. Meistens benutzt man als

”

”

Orientierungspunkt das Feld mit dem kleinsten Wert. Für die folgenden Formeln wird

beispielshalber a genutzt.

Zeilenmethode:

P (Beobachtung) =

a+b

a

c+d

c

b+d

b

·

n

a+c

Spaltenmethode:

P (Beobachtung) =

a+c

a

·

n

a+b

Der Orientierungswert wird dann schrittweise extremer gestaltet, soweit es die Randsummen zulassen. Für jeden Schritt wird dann erneut die Wahrscheinlichkeit berechnet und zu

P(Beobachtung) hinzu addiert. So wird am Ende P(Beobachtung oder extremeres Ereignis)

erhalten.

28

9.5

Einfacher Rangsummentest

Dieser Test ist ein nichtparametrisches Verfahren zur Überprüfung der signifikanten

Abweichung einer Stichprobe vom Mittelwert. Andere Bezeichnungen für die Anwendung

des zugrundeliegenden Testprinzips sind Wilcoxon-/Mann-Whitney- oder U-Test.

Sei X eine ordinale Zufallsgröße und S die beobachtete Stichprobe, dann wird die Wahrscheinlichkeit für eine ähnliche oder extremere Beobachtung berechnet (gleiches Testprinzip

wie beim Fisher-Test). Die Bestimmung der Wahrscheinlichkeit erfolgt nach dem Prinzip

von Laplace, d.h. die Anzahl der günstigen Möglichkeiten (alle Stichproben mit gleicher

oder extremerer Rangsumme) wird durch die Anzahl aller denkbaren Möglichkeiten geteilt.

Ist die Wahrscheinlichkeit kleiner als α, so liegt ein signifikantes Ergebnis, d.h. eine signifikante Abweichung vom allgemeinen Mittelwert, vor.

9.6

9.6.1

Odds Ratio

Bedeutung und Berechnung

Odds Ratios sind statistische Maßzahlen zur Beurteilung der Stärke des Zusammenhangs

von zwei Merkmalen. Andere Bezeichnungen für Odds Ratio sind unter anderem Chancenverhältnis und Quotenverhältnis. Als Grundlage zur Berechnung wird eine Vierfeldertafel

genutzt.

B

B̄

Summe

A

a

c

a+c

Ā

b

d

b+d

Summe

a+b

c+d

n=a+b+c+d

Odds Ratio:

d = a·d

OR

b·c

Odds Ratios finden bevorzugt in der medizinischen Datenauswertung Verwendung. Meist,

um zu untersuchen, wie stark ein potentieller Risikofaktor mit einer bestimmten Erkrankung zusammenhängt. Wäre in der obigen Tabelle beispielsweise A der Risikofaktor und

d an, um wie viel größer die Chance zu erkranken in der

B die Erkrankung, dann gibt OR

Gruppe mit Risikofaktor ist, verglichen mit der Gruppe ohne Risikofaktor. Odds Ratios

liegen immer zwischen 0 und ∞.

d < 1 : Die Chance, dass B eintritt, ist bei A geringer als bei Ā

OR

d = 1 : Die Chance, dass B eintritt, ist unabhängig von A

OR

d > 1 : Die Chance, dass B eintritt, ist bei A höher als bei Ā

OR

29

9.6.2

d

Konfidenzintervalle für OR

Konfidenzintervalle basieren auf der Annahme der Normalverteilung, allerdings sind

Odds Ratios selbst nicht normalverteilt, logarithmierte Odds Ratios hingegen schon. Aus

diesem Grund werden stets erst Konfidenzintervalle für die logarithmierten Odds Ratios

bestimmt, deren Grenzen dann mithilfe der Exponentialfunktion zurück transformiert

werden.

d :

KI für ln(OR)

r

h

i

d − c · se ; ln(OR)

d + c · se mit se = 1 + 1 + 1 + 1

ln(OR)

a b c d

d:

Transformation zum KI für OR

h

i h

i

d

d

d

d

eln(OR)−c·se ; eln(OR)+c·se = elinke Grenze von ln(OR) ; erechte Grenze von ln(OR)

Für c werden basierend auf der Normalverteiung die üblichen Werte genutzt, also c = 1, 96

bzw. c = 2 für das 95%-Konfidenzintervall und c = 3 für das 99,9%-Konfidenzintervall.

9.7

Normalverteilungstest zum Vergleich zweier Wahrscheinlichkeiten

p1 , p2 : Wahrscheinlichkeiten, basierend auf zwei Stichproben

n1 , n2 : Stichprobenumfänge

D : Differenz der Wahrscheinlichkeiten

H0 : p1 − p2 = 0, d.h. D = 0

H1 : D 6= 0

p̂ : Schätzer für p in der Gesamtpopulation

p̂ =

T =q

p1 · n1 + p2 · n2

n1 + n2

D

p̂(1 − p̂) · ( n11 +

1

)

n2

Als Ablesetabelle für kritische Werte dient jene der Standardnormalverteilung.

9.8

α und β bei Hypothesentests mit Normalverteilung

X : Zufallsgröße

H0 : Nullhypothese (mit µ0 und σ0 )

H1 : Alternativhypothese (mit µ1 und σ1 )

G : fixierte Grenze

Φ : Verteilungsfunktion der Standardnormalverteilung (Tabelle)

30

Z(X) =

X−µ

σ

: Standardisierung von X (für G analog)

Falls H1 rechts von H0 liegt, also µ0 < µ1 gilt:

α = PH0 (X > G) = PH0 (Z(X) > Z(G)) = 1 − Φ(Z(G))

β = PH1 (X ≤ G) = PH1 (Z(X) ≤ Z(G)) = Φ(Z(G))

Falls H1 links von H0 liegt, also µ0 > µ1 gilt:

α = PH0 (X < G) = PH0 (Z(X) < Z(G)) = Φ(Z(G))

β = PH1 (X ≥ G) = PH1 (Z(X) ≥ Z(G)) = 1 − Φ(Z(G))

9.9

F-Test für lineare Regressionsmodelle

Mit diesem Verfahren kann getestet werden, ob ein Regressionskoeffizient, d.h. im einfachsten Fall die Steigung einer Regressionsgerade, signifikant verschieden von 0 ist. Hier

betrachten wir nur diesen einfachen Fall, wir haben dann eine Regressionsgerade der Form:

ŷ = β0 + β1 x

Getestet wird also, ob sich β1 signifikant von 0 unterscheidet, denn nur dann kann davon

ausgegangen werden, dass x wirklich Einfluss auf ŷ ausübt.

H0 : β1 = 0, d.h. die Steigung ist 0

H1 : β1 6= 0, d.h. die Steigung ist nicht 0

n : Stichprobenumfang

R : linearer Korrelationskoeffizient nach Pearson

f : Freiheitsgrade; f = (1, n − 2)

R2

· (n − 2)

1 − R2

Mithilfe von α und f wird aus der Tabelle der F-Verteilung der korrespondierende Grenzwert abgelesen und mit der Testgröße T verglichen. Ist T größer als der Grenzwert, so liegt

Signifikanz vor und x ist wirklich ein Regressor für ŷ mit dem Faktor β1 .

T =

9.10

Varianzanalyse

9.10.1

Allgemeine Varianzanalyse (ANOVA)

Die Varianzanalyse untersucht, ob mehrere Gruppen oder Messreihen hinsichtlich einer

meist ordinalskalierten Variable einer gemeinsamen Population entstammen. Häufig wird

31

der Begriff ”Varianzanalyse”mit ANOVA (engl. analysis of variance) abgekürzt. In der

Regel wird zunächst die gesamte Varianz aller beobachteten Werte bestimmt. Diese

Varianz wird dann in jenen Teil, der durch das untersuchte Merkmal erklärt werden

kann, sowie die Restvarianz aufgeteilt. Die eigentliche Testgröße ist dann das Verhältnis

dieser beiden Anteile zueinander. Sie wird mit einem aus der Tabelle der F-Verteilung

abgelesenen Grenzwert verglichen.

H0 : Es besteht kein Unterschied zwischen den Gruppen d.h. µ1 = µ2 = · · · = µm

H1 : Mindestens 2 der getesteten Stichproben unterscheiden sich d.h. es gibt mindestens 2

lllllk Stichproben i und j mit µi 6= µj

m : Anzahl der Stichproben

n : Anzahl der gesamten Stichprobenelemente

ni : Größe der einzelnen Stichproben

f : m − 1 und n − m (2 Freiheitsgrade wegen der F-Verteilung)

SQtotal : gesamte Varianz, es gilt: SQtotal = SQF aktor + SQresidual

SQF aktor : Anteil der Varianz, der durch das untersuchte Gruppierungsmerkmal (Faktor)

mmmlllllk erklärt wird

SQresidual : Restvarianz, die nicht durch das untersuchte Merkmal erklärt wird

SQtotal =

ni

m X

X

(xik − x̄)2

i=1 k=1

SQF aktor =

m

X

ni (x̄i − x̄)2

i=1

SQresidual =

ni

m X

X

(xik − x̄i )2

i=1 k=1

T =

9.10.2

1

· SQF aktor

m−1

1

· SQresidual

n−m

Rangvarianzanalyse

Die Rangvarianzanalyse ist ein parameterfreies Testverfahren. Sie untersucht, ob mehrere

Gruppen oder Messreihen hinsichtlich einer ordinalskalierten Variablen einer gemeinsamen

Population entstammen. Die Rangvarianzanalyse wird auch Kruskal-Wallis-Test genannt

und ist dem Wilcoxon-/Mann-Whitney-/U-Test sehr ähnlich. Der Unterschied besteht

darin, dass bei der Rangvarianzanalyse mehr als 2 Gruppen gleichzeitig getestet werden

können. Als Ablesetabelle wird die Tabelle der Chi-Quadrat-Verteilung genutzt. Es gibt

2 Varianten der Rangvarianzanalyse: für abhängige oder unabhängige Stichproben. Die

folgende Formel bezieht sich auf den unabhängigen Fall:

32

H0 : Es besteht kein Unterschied zwischen den Gruppen (gleiche Grundgesamtheit)

H1 : Mindestens 2 der getesteten Stichproben unterschieden sich

m : Anzahl der Stichproben

n : Anzahl der gesamten Stichprobenelemente

ni : Größe der einzelnen Stichproben

Ri : Rangsummen

f : m − 1 d.h. Anzahl der Stichproben-1

m

X R2

12

i

T = −3(n + 1) +

n(n + 1) i=1 ni

33

10

10.1

Elementare Prinzipien

Markov-Ungleichung

Die Markow-Ungleichung gibt eine obere Schranke für die Wahrscheinlichkeit an, dass

eine Zufallsvariable eine positive Konstante oder das c-fache ihres Erwartungswertes

überschreitet.

E(|X|)

P [|X| ≥ a] ≤

a

bzw.

1

P [|X| ≥ c · E(|X|)] ≤

c

10.2

Tschebyscheff-Ungleichung

Diese Tschebyscheff-Ungleichung gibt eine obere Grenze für die Wahrscheinlichkeit an, dass

eine Zufallsvariable mit endlicher Varianz Werte außerhalb eines symmetrisch um den Erwartungswert gelegenen Intervalls annimmt. Sei X eine Zufallsvariable mit Erwartungswert

µ und Varianz σ 2 . Dann gilt für alle reellen Zahlen k > 0:

P [|X − µ| ≥ k] ≤

10.3

σ2

k2

Benford-Gesetz

Mithilfe des Benford-Gesetztes können Gesetzmäßigkeiten der Verteilung von Ziffernstrukturen in empirischen Datensätzen beschrieben werden. Anwendung findet das Gesetz z.B.

bei der Analyse von Einwohnerzahlen oder Geldbeträgen. Möchte man die Häufigkeiten

verschiedener Ziffern als erste Ziffer einer Zahl untersuchen, dann verwendet man:

hi = Wahrscheinlichkeit des Auftretens der Ziffer i als erste Zahl z.B. i = 1, . . . , 9

h0 = 0

1

hi = log10 (1 + )

i

Als Basis im Logarithmus nutzt man dabei immer die Gesamtanzahl der möglichen Ziffern.

Im Dezimalsystem sind dies die Ziffern 0, . . . , 9 , also ist die Basis 10. Für die Ziffern

1, . . . , 9 als erste Ziffer von Zahlen im Dezimalsystem ergeben sich so folgende Häufigkeiten:

Ziffer

rel. Häufigkeit

1

30, 1%

2

17, 6%

3

12, 5%

4

9, 7%

34

5

7, 9%

6

6, 7%

7

5, 8%

8

5, 1%

9

4, 6%