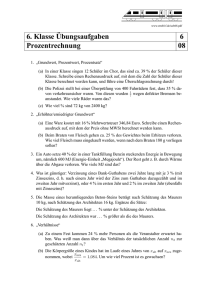

Vorlesungsnummer 2563

Werbung