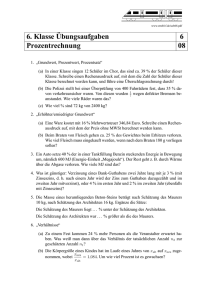

Skript

Werbung