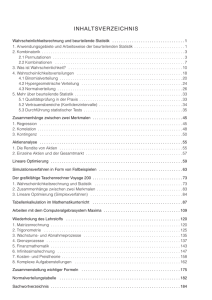

Zusammenfassung der Vorlesungen Statistik I und II von Konrad

Werbung