Stochastik für die Naturwissenschaften

Werbung

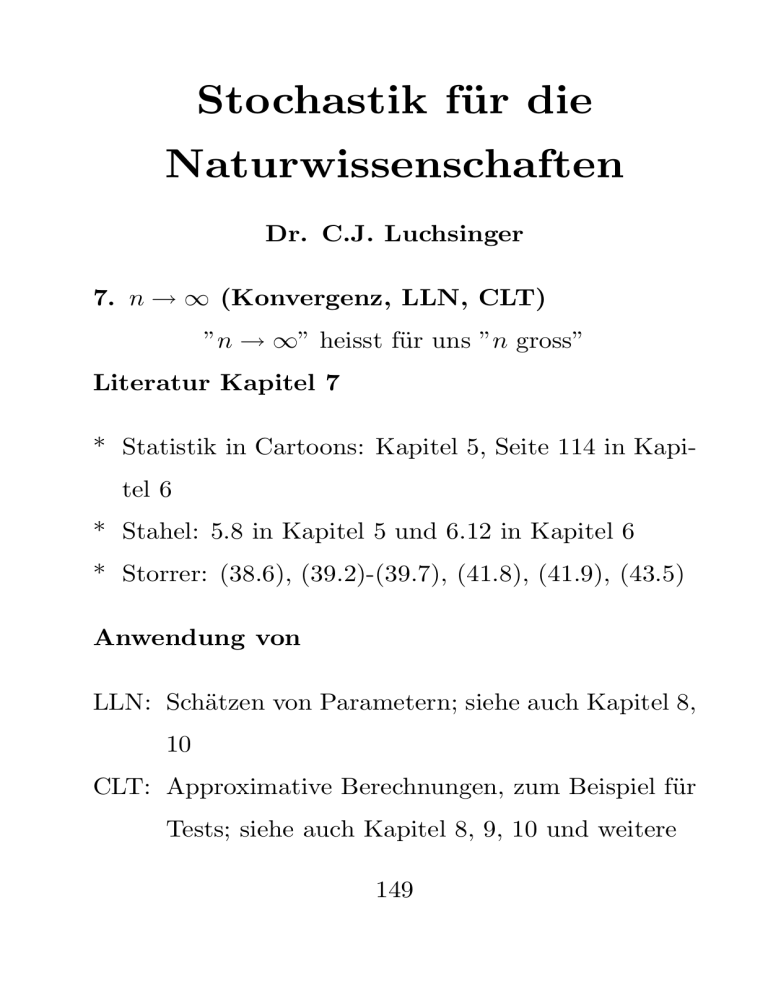

Stochastik für die Naturwissenschaften Dr. C.J. Luchsinger 7. n → ∞ (Konvergenz, LLN, CLT) ”n → ∞” heisst für uns ”n gross” Literatur Kapitel 7 * Statistik in Cartoons: Kapitel 5, Seite 114 in Kapitel 6 * Stahel: 5.8 in Kapitel 5 und 6.12 in Kapitel 6 * Storrer: (38.6), (39.2)-(39.7), (41.8), (41.9), (43.5) Anwendung von LLN: Schätzen von Parametern; siehe auch Kapitel 8, 10 CLT: Approximative Berechnungen, zum Beispiel für Tests; siehe auch Kapitel 8, 9, 10 und weitere 149 7.1 LLN (Law of Large Numbers; Gesetz der grossen Zahlen) Fragestellung: Was geschieht mit 1 n Pn k=1 Xk falls n → ∞ und welche Voraussetzungen werden wir sinnvollerweise machen? Wir haben in Kapitel 2 und in Teil 5.3 über Stichproben immer wieder das arithmetische Mittel von Realisationen (oder Daten) n 1X x := xi n i=1 (7.1) untersucht. Der Ausdruck n 1X Xi n i=1 (7.2) ist offenbar das Pendant auf der Ebene der Zufallsgrössen, vor der Realisation. In (7.1) haben wir reelle Zahlen, da ist kein Zufall mehr drin. Wenn wir aber erneut eine (unabhängige) Stichprobe nehmen, wird 150 (7.1) bei stetigen Zufallsgrössen sicher anders aussehen (bei diskreten Zufallsgrössen kann es je nach konkreter Situation (n und konkrete Parameter) zufällig auch den gleichen Wert geben). Indem wir (7.2) unter- suchen, lernen wir auch viel über (7.1), z.B. über die Schwankungsbreite (Varianz) oder um welchen Wert (7.1) etwa zu liegen kommt (Erwartungswert). (7.1) konvergiert gegen den Erwartungswert von (7.2); mehr gleich nachfolgend. Indem wir Erwartungswert und Varianz von (7.2) berechnen, können wir abschätzen, was mit (7.1) passieren muss, wenn n → ∞. Von Kapitel 5, die Xi ’s seien iid mit E[Xi ] = µ und V [Xi ] = σ 2 : 1 Pn 1 Pn E n i=1 Xi = µ und V n i=1 Xi = n1 σ 2 . Das heisst, (7.1) wird um µ herum schwanken, mit immer kleinerer Schwankung, Bild: 151 Wir wollen eine Aussage der Art machen: n 1X Xi n i=1 konvergiert gegen den Erwartungswert von X1 . Theorem 7.1 [Satz von Kolmogoroff (LLN)] Sei X1 , X2 , . . . eine Folge von unabhängigen, identisch verteilten Zufallsgrössen mit Erwartungswert µ und E[|X1 |] < ∞. Dann genügt diese Folge dem Gesetz der grossen Zahlen, das heisst, es gilt für jedes > 0: X 1 n Xi − µ> = 0. lim P n→∞ n i=1 Diesen Ausdruck liest man am besten von innen nach aussen! 152 2 wichtige Anwendungen des LLN 1. Arithmetisches Mittel 2. Relative Häufigkeiten 153 7.2 CLT (Central Limit Theorem; Zentraler Grenzwertsatz) Fragestellung: Was geschieht mit dem Ausdruck Pn Xk − nµ √ , nσ k=1 (7.3) einfacherer Fall (µ = 0, σ = 1) n 1 X √ Xk , n k=1 falls n → ∞ und welche Voraussetzungen werden wir sinnvollerweise machen? Erinnert Sie der Ausdruck Pn Xk − nµ √ nσ k=1 an etwas, was wir gerade durchgenommen haben? 154 Mit n X Xk − nµ k=1 haben wir in einem ersten Schritt offenbar einfach zentriert (den Erwartungswert abgezogen - er ist jetzt 0), √ dann in einem zweiten Schritt mit nσ normiert und dabei Pn Xk − nµ √ nσ k=1 erhalten. Die Varianz ist jetzt 1. Zusammen nennt man diese beiden Schritte standardisieren. And then a miracle occurs..., denn das Ding hat am Schluss (bei n = ∞) eine Normalverteilung N (0, 1). Das Überraschende am CLT ist, dass mit wenigen Voraussetzungen (v.a. keine über die Verteilung der Xk ’s) immer eine Normalverteilung als Limesverteilung resultiert. 155 Das ”−nµ” verstehen wir relativ einfach; warum ge√ rade ” nσ” im Nenner? Dazu folgende Rechnung: Gesucht ist eine Funktion g(n), sodass die Varianz nicht von n abhängt. n n 1 X X 1 V Xi = V Xi 2 g(n) i=1 g(n) i=1 n 1 X = V [Xi ] g(n)2 i=1 1 2 = n ∗ σ ; g(n)2 wenn wir g(n) := √ n wählen, haben wir eine konstante Varianz. Dies ist notwendig, damit (7.3) überhaupt konvergieren kann! Wir betrachten jetzt die beiden Ausdrücke CLT1 und CLT2; sie illustrieren alle 3 Aspekte: man muss zentrieren, normieren und erhält eine Normalverteilung im Limes. Die Binomialverteilung Bin(n,p) ist eine Summe von iid Be(p) - die Voraussetzungen des nachfolgenden CLT sind also erfüllt: 156 Theorem 7.2 [Zentraler Grenzwertsatz] Sei Xk , k ≥ 1, eine Folge von iid Zufallsgrössen mit E[X1 ] =: µ und 0 < V [X1 ] =: σ 2 < ∞. Dann gilt für a ∈ R beliebig: Pn k=1 Xk − nµ √ P ≤ a −→ P [N (0, 1) ≤ a] nσ wenn n → ∞. Mit ”P [N (0, 1) ≤ a]” meinen wir die Wahrscheinlichkeit, dass eine Standard-Normal-verteilte Zufallsgrösse Werte kleiner oder gleich a annimmt. Die Verteilungsfunktion der zentrierten und normierten Summe (7.3) konvergiert also in jedem Punkt gegen die Verteilungsfunktion der Standard-Normal-Verteilung. Bemerkung zu Theorem 7.2: Ab welchem n ”darf” man die Normalverteilung brauchen? Nichttriviale, allgemeine Fehler-Abschätzungen, welche nur von n 157 abhängen und für alle Verteilungen gelten, existieren nicht. Wenn die Xk ’s aber Be(p)-Zufallsgrössen sind, so sagt eine Praktikerregel, dass np(1 − p) ≥ 9 gelten sollte, damit man mit gutem Gewissen die Normalverteilung benutzen darf (vgl CLT1, CLT2). Wir lösen dazu gleich eine Aufgabe: Sie werden von Räubern im Wald zu einem Münzwurfspiel eingeladen. Wenn in 100 Würfen mehr ”Kopf” als ”Zahl” kommt, dürfen Sie von den Räubern ausgeraubt werden (Merke: Transparenz ist sehr wichtig für das Funktionieren von Märkten). Das Resultat ist nach 100 Würfen 65 zu Ihren Ungunsten. Sie fragen sich jetzt (bisschen spät), ob die Münze fair war oder nicht. Dazu überlegen Sie sich, wie gross bei einer fairen Münze wohl die Wahrscheinlichkeit ist, 65 mal (oder mehr) 158 ”Kopf” zu werfen. Leider haben Sie keine Bin(100, 0.5)-Verteilungstabelle dabei. Rettung naht: Sie erinnern sich nämlich Gott sei Dank an den CLT: Beachten Sie bitte: 1. Wir machen diese Rechnungen unter der Annahme p = 0.5. 2. Wir berechnen die Wahrscheinlichkeit, 65 mal oder mehr ”Kopf” zu werfen. Diese Denkweise wird in Kapitel 9 und weiteren kultiviert werden. Grund für häufigen Einsatz der Normalverteilung? 159 7.3 Zusammenhänge bei Verteilungen II: Limesverteilungen In ”6.3 Zusammenhänge bei Verteilungen I”, haben wir uns gefragt, wie Summen von unabhängigen Zufallsgrössen verteilt sind. Jetzt geben wir eine Verteilung an (Binomial), welche zu einer anderen Verteilung wird (Poisson), wenn wir gezielt einen Parameter gegen ∞ gehen lassen. Wenn man die Wahrscheinlichkeitsfunktion (die Werte von P [X = k], k ≥ 0) einer Binomial- und einer Poissonverteilung mit gleichem Erwartungswert vergleicht, so sieht man, dass der Unterschied immer kleiner wird, je grösser n in der Binomial-Verteilung ist (Storrer (39.3), (39.5)). Im folgenden Satz ist λ konstant. p ist klein und wird immer kleiner; deshalb indexieren wir es mit einem n: pn . Weil der Erwartungswert einer Po(λ)-Zufallsgrösse gleich λ ist und der Erwartungs160 wert einer Bin(n, p) gleich np, fordern wird (damit sicher mal die Erwartungswerte übereinstimmen): np = λ - oder eben npn = λ. Damit muss natürlich gelten: pn := λ/n. Dies ist für die Formulierung des Satzes wichtig, nicht aber für die Anwendungen. Satz 7.3 [Konvergenz der Binomial- gegen die Poisson-Verteilung] Sei Xn eine Folge von Bin(n, pn )-Zufallsgrössen. Es gelte für alle n genügend gross: npn = λ > 0 (Erwartungswerte jeweils gleich). λ ist konstant! Dann gilt für r ∈ N0 fest: −λ λ P [Xn = r] −→ e r r! für n → ∞. Damit haben wir im Limes eine PoissonVerteilung mit Parameter λ. 161 Vorteil: einfachere Formel bei Poisson als bei Binomial (Binomialkoeffizient!) Wie wird das ganze in der Praxis eingesetzt? Storrer (39.5). 162 7.4 Nachtrag: Motivation der Poisson-Verteilung Wegen 7.3 ist es offenbar so, dass die Poisson-Verteilung dort sinnvoll ist, wo eine grosse Zahl von unabhängigen Versuchen mit je kleiner Erfolgswahrscheinlichkeit vorhanden sind. ”Versuch” und ”Erfolg” sind dabei nicht allzu eng zu verstehen - ein Beispiel aus der Versicherungsmathematik soll dies illustrieren: Es gibt ein paar Millionen Gebäude in der Schweiz. Versuch ist, ob es in einem Jahr zum Brand kommt (=Erfolg) oder nicht. n ist sicher sehr gross und (Gott sei Dank) das p sehr klein. Solche Schadenzahlen (nicht die versicherte Summe!) werden mit Poisson-Zufallsgrössen modelliert. Flugzeugabstürze einer Airline werden auch so modelliert, mit unterschiedlichem λ von Airline zu Airline. Sie finden weitere Beispiele im Storrer, Kapitel 39. 163 7.5 Mind-Mapping Verteilungen Damit haben wir den Stoff von Storrer Kapitel 3741 (und bisschen mehr) vollständig behandelt und ich empfehle Ihnen, diese Kapitel noch vollständig durchzulesen. 164