Skript zur Vorlesung Graphenalgorithmen

Werbung

Skript zur Vorlesung

Graphenalgorithmen

Version 1.0.12

Juniorprofessor Dr. rer. nat. Robert Elsässer,

überarbeitet von Dr. rer. nat. Henning Meyerhenke

Universität Paderborn

Fakultät für Elektrotechnik, Informatik und Mathematik

Institut für Informatik

D-33102 Paderborn

Skript (Version 1.0) verfasst von Florentin Neumann

Inhaltsverzeichnis

Vorwort

3

1 Einleitung und Motivation

4

2 Kürzeste Pfade, All Pairs Shortest Paths (APSP)

6

2.1

Der Floyd-Warshall-Algorithmus . . . . . . . . . . . . . . . . . .

8

2.2

Matrix-Multiplikation . . . . . . . . . . . . . . . . . . . . . . . .

9

2.2.1

Voraussetzungen

9

2.2.2

Distanz- und Wegeberechnungen mit dem Algorithmus

. . . . . . . . . . . . . . . . . . . . . .

von Seidel . . . . . . . . . . . . . . . . . . . . . . . . . .

3 Matchings in bipartiten Graphen

11

24

3.1

Grundlagen und Strukturaussagen . . . . . . . . . . . . . . . . .

24

3.2

Berechnung von gröÿtmöglichen Matchings . . . . . . . . . . . .

29

3.3

Matchings mit maximalem Gewicht . . . . . . . . . . . . . . . .

31

3.3.1

31

Korrektheit

. . . . . . . . . . . . . . . . . . . . . . . . .

4 Matchings in allgemeinen Graphen

35

4.1

Der Algorithmus von Edmonds

. . . . . . . . . . . . . . . . . .

4.2

Approximationsalgorithmen für MWM

. . . . . . . . . . . . . .

35

4.3

Die Theoreme von Tutte und Petersen

. . . . . . . . . . . . . .

37

5 Netzwerkalgorithmen

5.1

Der Hypercube

5.2

5.3

41

. . . . . . . . . . . . . . . . . . . . . . . . . . .

42

Gitter und Torus

. . . . . . . . . . . . . . . . . . . . . . . . . .

46

Lastbalancierung

. . . . . . . . . . . . . . . . . . . . . . . . . .

47

6 Bisektionsweite und Partitionierung

6.1

6.2

35

52

Untere Schranken für die Bisektionsweite . . . . . . . . . . . . .

53

6.1.1

Verfahren von Leighton . . . . . . . . . . . . . . . . . . .

53

6.1.2

Spektrale untere Schranke

56

. . . . . . . . . . . . . . . . .

Obere Schranken für die Bisektionsweite

1

. . . . . . . . . . . . .

57

6.3

Maximale Schnitte in Graphen . . . . . . . . . . . . . . . . . . .

Literaturverzeichnis

69

70

2

Vorwort

Dieses Skript basiert auf der Vorlesung Graphenalgorithmen, die ich im WS

2009/10 an der Universität Paderborn für Master-Studierende gelesen habe.

Die ursprüngliche Version wurde ein Jahr zuvor von Florentin Neumann anhand der Vorlesung von Robert Elsässer erstellt. Das Kapitel über Bisektionsweite und Partitionierung stammt überwiegend aus dem Skript zur Vorlesung

Algorithmen für synchrone Rechnernetze von Burkhard Monien.

Inhaltlich habe ich die Vorlesung gegenüber dem Vorjahr leicht verändert,

was auch zu Löschungen und Hinzufügungen im Skript geführt hat. Leider

konnte ich noch nicht alle Lücken füllen, habe aber an solchen Stellen weitestgehend Literaturverweise eingefügt. Des weiteren sind sicherlich noch nicht

alle enthaltenen Fehler korrigiert, ich bin daher im Namen aller am Skript

Beteiligten um entsprechende Hinweise dankbar.

Bitte bedenken Sie bei der Prüfungsvorbereitung, dass die gesamte Veranstaltung geprüft wird, dazu gehören zum Beispiel auch die Übungszettel. Ein

Studium des Skripts kann den Besuch der Vorlesung und der Übung nicht ersetzen!

Paderborn, 8. März 2010

Henning Meyerhenke

3

Kapitel 1

Einleitung und Motivation

In dieser Vorlesung werden Sie eine Reihe von Algorithmen kennenlernen, die

auf Graphen operieren. Ein Graph modelliert allgemein gesprochen eine Menge von Entitäten (dargestellt als Knoten) und die Beziehungen der Entitäten

(dargestellt durch Kanten).

Denition 1.

Ein Algorithmus ist eine eindeutige Beschreibung eines Verfah-

rens zur Lösung einer bestimmten Klasse von Problemen.

Genauer gesagt ist ein Algorithmus eine Menge von Regeln für ein Verfahren, um aus gewissen Eingabegröÿen bestimmte Ausgabegröÿen herzuleiten.

Dabei muss dass Verfahren in einem endlichen Text beschreibbar sein. Jeder

Schritt dieses Verfahrens muss auch tatsächlich ausführbar sein und darüber

hinaus muss der Ablauf des Verfahrens zu jedem Zeitpunkt eindeutig deniert

sein.

Hier einige typische Beispielprobleme, in denen Graphenalgorithmen eine

wichtige Rolle spielen:

•

Wie ndet ein Navigationssystem gute Verbindungen zwischen zwei Orten?

•

Wie werden im Internet Informationen geroutet?

•

Wie berechnet ein Unternehmen eine möglichst gute Aufteilung seiner

Ressourcen, um seinen Gewinn zu maximieren?

•

Wie werden etwa in Google Informationen schnell gefunden?

Um über die Qualität eines Algorithmus urteilen zu können, bedarf es bestimmter Kriterien, um entsprechende Urteile treen zu können. (i) Algorithmen müssen korrekt sein. D.h. zu jedem Algorithmus gehört ein Korrektheitsbeweis, der in allgemeiner Form die Korrektheit der Berechnung der Ausgabegröÿe zu einer gegebenen Eingabegröÿe zeigt. (ii) Algorithmen sollen zeit-

4

und speicherezient sein. Hierzu bedarf es Analysemethoden für den Zeit- und

Speicherbedarf eines Algorithmus. Diese Analyse basiert in der klassischen Algorithmik nicht auf empirischen Untersuchungen, sondern auf mathematischen

Analysen. Wir nutzen hierfür Pseudocode und Basisoperationen.

Zum Entwurf eines Algorithmus gehören grundsätzlich drei Dinge: 1. Die

Beschreibung des Algorithmus selbst in Pseudocode. 2. Ein vollständiger Korrektheitsbeweis. 3. Die Analyse des Zeit- und Speicherbedarfs des Algorithmus.

5

Kapitel 2

Kürzeste Pfade, All Pairs Shortest

Paths (APSP)

Zu Beginn dieses Kapitels betrachten wir das Problem kürzester Wege in gerichteten Graphen mit Kantengewichten. In einem unidirektionalen, zusammenhängenden Graphen

G = (V, E)

mit

V = {1, . . . , n}

und

|E| = m

als

u, v ∈ V

die

Eingabegröÿen soll als Ausgabegröÿe für jedes Paar von Knoten

Distanz von

Graphen

G

u nach v

sowie ein kürzester Weg zwischen den beiden Knoten im

berechnet werden.

Denition 2.

Sei ein gerichteter und gewichteter Graph

der Gewichtsfunktion

hv0 , v1 , . . . , vk i

w : E → R

G = (V, E)

gegeben. Das Gewicht eines Weges

mit

P =

ist die Summe der Gewichte seiner Kanten:

w(P ) =

k

X

w(vi−1 , vi ).

i=1

Denition 3.

Das Gewicht eines kürzesten Weges

gewichteten Graphen

als:

δ(u, v) =

G = (V, E)

in einem gerichteten und

zwischen den Knoten

min{w(P ) : v

ist von

∞, falls v

u

Ein kürzester Weg zwischen

P

von

u, v ∈ V

u

über

P

u, v ∈ V

ist deniert

erreichbar},

nicht erreichbar ist.

ist dann ein Weg

6

P

mit

w(P ) = δ(u, v).

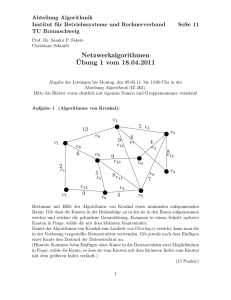

Abbildung 2.1: Unidirektionaler, gewichteter Graph

Die Eingabe wird als Gewichtsmatrix

phen repräsentiert. Die Matrix-Einträge

wij =

0

Gewicht der ger. Kante

W = (wij )

wij

(i, j)

∞

wij ,

dargestellt, die den Gra-

sind wie folgt deniert:

, wenn

i=j

, wenn

i 6= j

und

(i, j) ∈ E

, wenn

i 6= j

und

(i, j) ∈

/E

Aus dieser Denition folgt für den Graphen

wichtsmatrix

G = (V, E)

G

aus Abbildung 2.1 die Ge-

abgebildet in Tabelle 2.1:

a

W zum Graphen G

b

c

d

e f

a

0

2

∞

5

∞ ∞

b

∞

0

4

∞

∞ ∞

c

∞

∞

0

1

∞

7

d

∞

-4

6

0

5

∞

e

∞

∞

8

∞

0

-1

f

∞

∞ ∞ ∞

∞

0

Tabelle 2.1: Gewichtsmatrix

7

aus Abbildung 2.1

2.1

Der Floyd-Warshall-Algorithmus

Algorithm 1 Floyd-Warshall - APSP

1: procedure Floyd-Warshall(G = (V, E))

2:

D(0) ← W

3:

5:

for k ← 1 to n do

for i ← 1 to n do

for j ← 1 to n do

6:

dij ← min(dij

4:

7:

8:

9:

10:

11:

(k)

(k−1)

(k−1)

, dik

(k−1)

+ dkj

)

end for

end for

end for

return Dn

end procedure

Der Floyd-Warshall-Algorithmus basiert auf der Idee, das Problem schritt-

weise zu vergröÿern. In Iteration

Knoten aus der Menge

{1, . . . , k}

k

werden alle Wege berücksichtigt, die über

verlaufen (direkte Kanten des Graphen ein-

geschlossen). Nach Ende der äuÿersten Schleife hat

k den Wert n überschritten,

so dass alle möglichen Wege berücksichtigt worden sind.

Lemma 4.

Sei

G

ein Graph ohne negative Zyklen und sei

reichbar. Dann gibt es einen kürzesten

i − j -Weg,

j

von

i

aus er-

der keinen Knoten doppelt

benutzt.

Satz 5.

Sei

G = (V, E)

ein Graph mit nicht-negativen Zyklen. Dann berechnet

der Algorithmus von Floyd-Warshall die Entfernung zwischen jedem Knotenpaar in

O(|V |3 )

Schritten.

Die Beweise von Lemma 4 und Satz 5 werdem dem Leser anhand der obigen

Erläuterungen als Übung empfohlen.

Bemerkung 6.

Das als Algorithmus 1 angegebene Verfahren löst eigentlich

nur das Problem All-Pairs-Distances (APD), d. h. es werden nur die paarweisen Distanzen und nicht auch die zugehörigen kürzesten Wege berechnet.

Eine entsprechende Erweiterung des Algorithmus für APSP wird dem Leser

als Übungsaufgabe empfohlen.

8

Abbildung 2.2: Ungerichteter Graph

matrix

2.2

G = (V, E) und die zugehörige Adjazenz-

A

Matrix-Multiplikation

2.2.1

Voraussetzungen

Wir betrachten ungerichtete Graphen

V = {1, ..., n}.

trix

A.

Ein Graph

G = (V, E)

G = (V, E)

mit der Knotenmenge

ist gegeben durch seine Adjazenzma-

Betrachte hierzu den Graphen aus Abbildung 2.2 und die zugehörige

Adjazenzmatrix.

Denition 7.

d.h.

wij

Es sei

G = (V, E)

ein Graph,

ist das Gewicht der Kante von

i

bzgl. des Gewichts kürzesten Weges von

Bemerkung 8.

G.

Es sei

G = (V, E)

W = (wij )

eine Gewichtsmatrix,

(k)

nach j . Deniere δij als Gewicht des

i

nach

j

mit höchstens

ein Graph und

W

k

Kanten.

eine Gewichtsmatrix für

Dann gilt:

(0)

δij =

0

,i = j

und

∞ , i 6= j

Auÿerdem ist

(n−1)

δ(i, j) = δij

(m)

δij

(m−1)

= min {δik

1≤k≤n

+ wkj }

für

m ≥ 1.

.

Im Folgenden betrachten wir das Problem der Matrixmultiplikation. Es

seien

D, W ∈ Rn×n

(i, j)

des Produkts von

der

j -ten

Spalte von

quadratische Matrizen. Dann berechnet sich der Eintrag

D

und

W

als Skalarprodukt der i-ten Zeile von

D

und

W:

(D · W )ij =

n

X

Dik · Wkj

(2.1)

k=1

Wir wollen uns nun zu Nutzen machen, dass die Berechnungsvorschrift zur

Matrixmultiplikation sehr ähnlich zu der rekursiven Formel in Bemerkung 8

9

ist. Denn ersetzt man im rechten Teil der Formel (2.1)

Σ

gegebene

+

durch

min,

gilt für

· durch + und das durch

D, W ∈ (R ∪ {∞})n×n :

(D ∗ W )ij = min {Dik + Wkj }

1≤k≤n

Diese Beobachtung setzen wir nun ein, um mit Hilfe eines modizierten Algorithmus zur Matrixmultiplikation die Distanzen aller paarweise kürzesten Wege

zu berechnen. Die wichtige Idee dabei ist,

(n−1)

D(n−1) = (δij

)

durch fortgesetzte

Matrixmultiplikation zu berechnen:

D(1) = W, D(2) = W 2 = W ∗ W, D(4) = W 4 = W 2 ∗ W 2 , ...

D(2dlog n−1e) = D2dlog n−1e = D2dlog n−1e−1 ∗ D2dlog n−1e−1

Algorithmus 3 namens mmAPD zeigt nun, wie man durch fortgesetzte Aufrufe

an eine Subroutine zur modizierten Matrixmultiplikation die Distanzen der

paarweise kürzesten Wege berechnen kann. Momentan liegt die beste bekannte

Algorithm 2 MatrixMultiply

1: procedure MatrixMultiply(weight matrix A, B )

2:

for i = 1; i ≤ n; i + + do

3:

for j = 1; j ≤ n; j + + do

4:

Cij = ∞

5:

for k = 1; k ≤ n; k + + do

6:

7:

8:

9:

10:

11:

Cij = min{Cij , Aik + Bkj }

end for

end for

end for

return C

end procedure

Laufzeit eines Algorithmus für Matrixmultiplikation bei

re untere Schranke als

Ω(n2 )

O(n2.376 ).

Eine besse-

ist nicht bekannt, so dass hier eine noch nicht

geschlossene Lücke zwischen unterer und oberer Laufzeitschranke klat.

Die obere Laufzeitschranke kann auf die Multiplikation von Boolschen Matrizen angewandt werden, wie wir in Kürze sehen werden. Bedauerlicherweise

folgt aus dieser Beobachtung aber auch eine Laufzeit für das APD Problem,

die gröÿer als

O(n2 )

ist (jedenfalls solange man über keinen Algorithmus mit

quadratischer Zeitkomplexität zur Matrixmultiplikation verfügt).

Die Laufzeit des Algorithmus mmAPD ist

die Zeit ist, um zwei

n × n

O(mm(n) · log n),

wobei mm(n)

Matrizen miteinander zu multiplizieren. Es

gibt allerdings einen Nachteil, denn es gibt keine implizite Darstellung der

10

Algorithm 3 mmAPD

1: procedure mmAPD(weight matrix W )

2:

D(1) = W

3:

m=1

4:

while m < n − 1 do

5:

D(2m) = MatrixMultiply(D(m) , D(m) )

6:

m = 2m

end while

8:

return D(m)

9: end procedure

7:

kürzesten Wege, denn dazu wären alle Matrizen

O(mm(n) · n)

die Laufzeit würde auf

2.2.2

D1 , . . . , D m

notwendig und

ansteigen.

Distanz- und Wegeberechnungen mit dem Algorithmus von Seidel

Wir betrachten nun die Probleme Distanz- und Wegeberechnungen in ungerichteten und ungewichteten Graphen.

•

Problem APD :

Gegeben: Ungerichteter, ungewichteter Graph

Gesucht: Matrix

•

D = (δij ),

wobei

δij

G = (V, E).

die Distanz von

i

nach

j

in

G

ist.

Problem APSP :

Gegeben: Ungerichteter, ungewichteter Graph

Gesucht: Matrix

D = (δij )

G = (V, E).

wie bei APD und eine implizite Darstellung

der kürzesten Wege.

Wir werden für beide Probleme Lösungen erarbeiten und sehen, dass das

APD -Problem in Zeit

O(mm(n)·log n) für ungewichtete, ungerichtete Graphen

lösbar ist und das APSP -Problem in erwarteter Zeit

O(mm(n) · log2 n)

für

dieselbe Graphklasse durch einen randomisierten Algorithmus lösbar ist.

Lemma 9.

zenzmatrix

A.

Ist

der Länge 2 von

Länge

2

G(V, E)

Es sei

von

i

i

Z = A

nach

nach

j

j

2

ein ungerichteter, ungewichteter Graph mit Adja-

, so ist

gibt.

Zij

Zij > 0

genau dann, wenn es einen Weg

gibt die Anzahl der verschiedenen Wege der

an.

11

Proof. ⇒

P = hi, k0 , ji

Sei

{i, k0 }, {k0 , j} ∈ E ,

ein

Weg

Ai,k0 = Ak0 ,j = 1.

also

i

von

j

nach

G.

Pn

in

Zij =

Es folgt

k=1

Dann

ist

Ai,k Ak,j ≥

Ai,k0 Ak0 ,j = 1.

⇐ Sei

Zij > 0.

{i, k0 }, {k0 , j} ∈ E

und

Um zu zeigen, dass

i

nach

j

k0 ∈ {1, ..., n}

Dann existiert

P = hi, k0 , ji

Zij

Weg von

i

mit

n

X

j

nach

in

Dann ist

G.

die Anzahl der verschiedenen Wege der Länge

angibt, betrachten wir die Berechnung von

Zij =

Ai,k0 Ak0 ,j = 1.

X

Aik · Akj =

k=1

2 von

Zij :

1 = |Γ(i) ∩ Γ(j)|.

k∈Γ(i)∩Γ(j)

Damit können wir durch eine einfache Matrixmultiplikation eine Matrix

berechnen, die es erlaubt, schnell einen Graphen

Knoten

G

i

j

und

0

G

Z

zu berechnen, in dem zwei

δ(i, j) ≤ 2

genau dann miteinander verbunden sind, wenn

in

ist:

2

Z = A

1,

0

Aij =

0,

0

G =

Lemma 10.

jazenzmatrix

(Aij = 1

Graphen

Es sei

A.

G,

G(V, E)

A

0

i 6= j

und

(Aij = 1

oder

Zij > 0)

sonst

der durch

0

A

induzierte Graph

ein ungerichteter, ungewichteter Graph mit Ad-

derart, dass

Zij > 0),

oder

0

Ist

falls

und ist

D

0

0

Aij = 1

genau dann gilt, wenn

A

die Distanzmatrix des durch

0

i 6= j

und

gegebenen

so gilt:

0

•

a)

Dij = 2Dij ,

•

b)

Dij = 2Dij − 1,

wenn

0

Dij

wenn

gerade ist und

Dij

ungerade ist.

Proof.

•

Fall a)

⇒∃

Dij = 2k

ist gerade.

kürzester Weg

P = hi = i0 , i1 , ..., i2k−1 , i2k = ji

0

⇒ P = hi = i0 , i2 , ..., i2k−2 , i2k = ji

ist Weg von

i

von

nach

j

i

nach

in

j

in

G.

0

G.

0

⇒ Dij ≤ k

Wäre

≤ 2l

Also

0

Dij = l < k ,

so existierte ein Weg

(Widerspruch, da

Dij = 2k ).

0

Dij = 2k = 2Dij .

12

Q

von

Daraus folgt

i

nach

0

j

Dij = k .

in

G

der Länge

•

Fall b)

⇒∃

Dij = 2k + 1

ungerade.

P = hi = i0 , i1 , ..., i2k , i2k+1 = ji

kürzester Weg

0

⇒ P = hi = i0 , i2 , ..., i2k , i2k+1 = ji

ist Weg von

i

i

von

j

nach

nach

j

in

G.

0

G.

in

0

⇒ Dij ≤ k + 1

0

Dij = l ≤ k ,

Wäre

≤ 2k

so existierte ein Weg

(Widerspruch, da

Dij = 2k + 1).

Q

von

i

j

nach

Daraus folgt

in

G

der Länge

0

Dij = k + 1.

0

Dij = 2k + 1 = 2Dij − 1.

Also

Die Idee für einen Algorithmus beläuft sich auf drei hauptsächliche Schritte:

1. Berechne die Distanzen

D

0

für

0

G

(rekursiv).

2. Berechne die Parität der Distanzen in

G.

3. Dann liefert Lemma 10 eine Berechnungsvorschrift für die Distanzen

D

G.

in

Lemma 11.

Graphen

Betrachte ein beliebiges Paar disjunkter Knoten

i, j ∈ V

des

G.

•

a) Für alle Nachbarn

•

b) Es existiert ein Nachbar

Proof. Sei

k ∈ Γ(i)

gilt

Dij − 1 ≤ Dkj ≤ Dij + 1.

k ∈ Γ(i)

P = hi = i1 , i2 , ..., ip+1 = ji

mit

Dkj = Dij − 1.

kürzester Weg von

i

nach

j

in

G,

also

Dij = p.

•

a) Sei

1.

k ∈ Γ(i),

d. h.

{i, k} ∈ E .

k = i2 ⇒ P1 = hk = i2 , ..., ip+1 = ji

ist Weg von

k

j

nach

⇒ Dkj ≤ p + 1

2.

k 6= i2 ⇒ P2 = hk = i0 , i1 , ..., ip+1 = ji

ist Weg von

k

nach

j

⇒ Dkj ≤ p + 1

In jedem Fall:

3. Annahme:

Dkj ≤ p + 1 = Dij + 1

Dkj = q < Dij − 1.

Dann existiert

P3 = hk = k1 , k2 , ..., kq+1 = ji

P4 = hi = k0 , k1 , k2 , ..., kq+1 = ji

von

•

i

nach

j

13

k

ist ein Weg der Länge

(Widerspruch zur Denition von

b) Folgt aus a), 1.) und 3.).

von

Dij ).

nach

j ⇒

q + 1 < Dij

Lemma 12.

i, j ∈ V

Betrachte ein beliebiges Paar disjunkter Knoten

des

G.

Graphen

a) Ist

Dij

gerade, so ist

•

b) Ist

Dij

ungerade, so ist

k ∈ Γ(i)

dem existiert ein

0

0

Dkj ≥ Dij

•

k ∈ Γ(i).

für alle Nachbarn

0

0

Dkj ≤ Dij

für alle Nachbarn

0

k ∈ Γ(i).

Auÿer-

0

Dkj < Dij .

derart, dass

Proof.

•

Fall a)

Dij = 2l

⇒ ∀

|{z}

k ∈ Γ(i): Dkj ≥ 2l − 1

Nachbarn

Lemma 11

Dann ist

ist gerade.

0

Dij = l

nach Lemma 10 a).

Weiter folgt aus Lemma 10 a,b), dass

0

Dkj

•

ist ganzzahlig

0

⇒ ∀

|{z}

0

Dij = l

0

ist ungerade.

k ∈ Γ(i): Dkj ≤ 2l

Nachbarn

Lemma 11

Dann ist

nach Lemma 10 b).

Weiter folgt aus Lemma 10 a,b), dass

0

Dkj

ist ganzzahlig

0

1

2

0

k ∈ Γ(i)

0

0

Dkj = l − 1 < l = Dij

Lemma 13.

0

Dkj ≤ (Dkj + 1)/2 ≤ l +

⇒ Dkj ≤ l = Dij

Weiter gilt, dass ein

gilt

1

2

⇒ Dkj ≥ l = Dij

Dij = 2l − 1

Fall b)

0

Dkj ≥ Dkj /2 ≥ l −

mit

Dkj = Dij − 1 = 2l − 2

existiert, also

nach Lemma 10 a).

Betrachte ein beliebiges Paar disjunkter Knoten

Graphen

G.

•

a)

Dij

ist gerade genau dann, wenn

•

b)

Dij

ist ungerade genau dann, wenn

P

0

k∈Γ(i)

P

i, j ∈ V

des

0

Dkj ≥ Dij · deg (i).

0

k∈Γ(i)

0

Dkj < Dij · deg (i).

Proof.

•

Fall a)

⇒

|{z}

Dij ist

P

gerade

0

k∈Γ(i)

Dkj ≥

P

0

k∈Γ(i)

0

Dij = deg(i)Dij .

Lemma 12 a)

•

Fall b)

⇒

|{z}

Dij ist

P

ungerade

k∈Γ(i)

0

Dkj ≤

P

0

k∈Γ(i)

0

Dij − 1 = deg(i)Dij − 1.

Lemma 12 b)

Die jeweilige Rückrichtung ergibt sich durch die Betrachtung der beiden komplementären Fälle.

14

Eine alternative Herleitung, wie man die Parität der

Dij

bestimmen kann,

ist in den zusätzlichen Materialien zur Vorlesung enthalten.

Dij

Wir betrachten nun den Algorithmus APD, der die Distanzen

Knotenpaare

(i, j)

G

für einen gegebenen ungerichteten Graphen

A

Der Graph wird durch seine Adjazenzmatrix

für alle

berechnet.

repräsentiert.

Algorithm 4 APD

1: procedure APD(Adjazenzmatrix A)

2:

Z = A2

3:

berechne

0

A

0

4:

Aij = 1

mit

gdw.

0

. Aij = 1 ⇔

i 6= j

und

7:

if Aij = 1 ∀i 6= j then

0

return D = 2A − A

end if

8:

D = APD(A )

(Aij = 1

oder

6:

0

9:

return D

.

j

mit

Rekursionsabbruch

. Rekursion

P

0

. Sij = k∈Γ(i) Dkj

0

2D0 ,

ij

Dij =

2D0 − 1,

ij

end procedure

Satz 14.

0

falls

Sij ≥ Dij Zii

falls

Sij < Dij Zii

. Zii = deg(i)

0

Der Algorithmus APD berechnet die Distanzmatrix

Knoten Graphen

G

O(mm(n) · log n)

in Zeit

Proof. Sei

T (n, δ)

δ

O(n ).

S

δ = 1,

Dann hat

durch

n

vollständig. Ist

2

(n) = Ω(n )

mm

O(mm(n) log n).

2

G

so ist

δ < n,

Wegen

Laufzeit

G.

die Zeit, die APD auf Graphen mit

benötigt. Ist

2

der Durchmesser von

Wegen

Dij < n

D

eines

n-

mit Hilfe der ganzzahligen Ma-

trixmultiplikation, wobei die Einträge der Matrix nicht gröÿer als

von

nach

Zij > 0)

0

S =A·D

10:

Sei

i

0

5:

11:

es ex. Weg der Länge 1 od. 2 v.

0

G

n

Durchmesser

O(n2 )

sind.

0

δ = dδ/2e.

Knoten und Durchmesser

δ = 2,

so ist

T (n, δ) =

und Rekursionstiefe

und somit

0

Dij < n

log n

δ

(n) +

mm

folgt die

sind die Einträge

nach oben beschränkt.

Das Zeugenproblem für Boolsche Matrizen

Wir erweitern den Algorithmus APD nun so, dass nicht nur die Distanzen

sondern auch für jedes Knotenpaar

(i, j)

Dij ,

ein kürzester Weg berechnet wird.

Dabei soll die Laufzeit des neuen Algorithmus subkubisch sein. Das Problem

ist dabei, dass es Graphen

tenpaare Distanz

Ω(n)

G = (V, E)

von der Gestalt gibt, dass

Ω(n2 )

Kno-

haben.

Beispiel 15. G = (V, E)

ist eine Linie:

15

V = {1, ..., n}, E = {(i, i + 1)|1 ≤

i < n}.

Setze

n

2

δ=

= Ω(n),

n−δ

X

k=

k=1

dann haben

n2

(n − δ + 1)(n − δ)

>

= Ω(n2 )

2

8

Knotenpaare mindestens den Abstand

δ

kürzesten Wege würde daher Platzbedarf

zueinander. Explizites Speichern der

Ω(n3 ),

Ω(n3 ),

also auch Zeitaufwand

bedeuten. Daher werden die kürzesten Wege nur implizit gespeichert, indem

zu jedem Knotenpaar

nach

j

(i, j)

Sij

der Nachfolger

von

i

auf einem kürzesten Weg

gespeichert wird.

S = (Sij )

O(n2 )

hat

Einträge und ein kürzester Weg von

i

nach

j

kann in

Zeit proportional zu seiner Länge bestimmt werden:

SPN(

S , i, j )

x0 = i; k = 0;

repeat

xk+1 = Sxk ,j ; k + +;

until (xk = j);

return hx0 , ...xk i

Notation 16.

•

Wir bezeichnen im Folgenden:

1

die boolsche

Matrixmultiplikation mit

∧

als Multiplikation und

∨

als

Addition durch ∗ und

•

die ganzzahlige Matrixmultiplikation mit ·.

Denition 17.

{0, 1}

n×n

Es seien

A, B ∈ {0, 1}n×n

das boolsche Produkt von

k ∈ {1, ..., n}

derart, dass

A

boolsche Matrizen,

B.

und

Ein Zeuge für

P = A∗B ∈

Pij

ist ein Index

Aik = 1 = Bkj .

Bemerkung 18.

a)

Pij = 1 ⇔

es gibt einen Zeugen

b) Ist

C = A · B,

c) Ist

A

so ist

Cij

für

Pij = 1

Cij

Pij .

die Anzahl der Zeugen für

Adjazenzmatrix eines Graphen

existiert.

d) Für

so ist

k

Pij .

G(V, E), P = A ∗ A

und

C = AA,

genau dann, wenn ein Weg der Länge 2 zwischen

i

und

j

ist die Anzahl dieser Wege (vgl. Lemma 9).

P = A∗A

ist ein Zeuge

Weg der Länge 2 von

i

nach

k

für

Pij = 1

Zwischenknoten auf einem

j.

1 Da

diese Bezeichnung auf George Boole (1815-1864) zurückgeht, ndet man auch häug

die Schreibweise boolesche Matrixmultiplikation.

16

Pij

e) Für jedes

bzgl.

P =A∗B

kann es bis zu

n

Zeugen geben.

Zeugen sind interessant, wenn man den APD -Algorithmus so erweitern will,

dass er kürzeste Wege berechnet. Da Zeugen Zwischenknoten auf Wegen der

2

Länge

darstellen, helfen sie bei der Konstruktion einer Nachfolgermatrix.

Wie genau dies funktioniert, wird nachfolgend erläutert.

Denition 19.

A, B ∈ {0, 1}n×n

Es seien

boolsche Matrizen,

P = A∗B ∈

{0, 1}n×n . Eine Zeugenmatrix ( Bpwm = Boolean Product Witness Matrix) für

P

ist eine Matrix

W ∈ {0, ..., n}n×n mit

0, wenn P = 0

ij

Wij =

k, k ist Zeuge für P = 1

ij

Problem Bpwm:

• gegeben:

• gesucht:

boolsche Matrizen

A

und

eine Zeugenmatrix

W

für

B.

P = A ∗ B.

Ein trivialer Algorithmus für Bpwm, der für alle

{1, ..., n}

testet, hat Zeitaufwand

O(n3 ).

(i, j) ∈ {1, ..., n}2

alle

k ∈

Da wir einen niedrigeren Aufwand

anstreben, vereinfachen wir zunächst das Problem Bpwm:

Problem UniqueBpwm:

• gegeben: boolsche Matrizen A und B , so dass jeder Eintrag in P = A∗B

einen eindeutigen Zeugen hat.

• gesucht:

Lemma 20.

und

W

a)

die Zeugenmatrix

Es seien

gegeben durch

Wij

W

für

A, B ∈ {0, 1}n×n

Âik = kAik

ist Zeuge für

Pij ,

b) Hat jeder Eintrag von

und

wenn

Pij

Pij

P = A ∗ B.

boolsche Matrizen und die Matrizen

W = ÂB .

Â

Dann gilt:

einen eindeutigen Zeugen hat.

einen eindeutigen Zeugen, so ist

W

die Lösung

von UniqueBpwm.

Proof.

Es ist

Wij =

n

X

k=1

Âik Bkj =

n

X

k · Aik Bkj

k=1

k,

=

0,

> k,

falls genau ein

Aik Bkj = 1

falls

Aik Bkj = 0 ∀k

falls

Aik Bkj = 1

17

und

Ail Blj = 1

für ein

l 6= k.

Beispiel 21.

1 1 0

1 0 0

1 1 0

A = 1 0 0 , B = 1 1 0 , P = 1 0 0 .

0 0 0

0 0 0

0 0 0

1 2 0

= 1 0 0

0 0 0

und

Die grünen und blauen Einträge von

W

3 2 0

W = 1 0 0 .

0 0 0

sind schon korrekte Einträge für eine

Zeugenmatrix, der rote jedoch nicht.

Folgerung 22.

Das Problem UniqueBpwm kann durch eine ganzzahlige Ma-

trixmultiplikation, also in Zeit

O(mm(n)),

gelöst werden.

Problematisch ist nun, dass wir eine Zeugenmatrix

einer Adjazenzmatrix

W

für

P = A∗A

mit

A berechnen wollen. Dabei ist natürlich nicht garantiert,

dass die Zeugen immer eindeutig sind. Die Idee zur Lösung des Problems lässt

sich so beschreiben:

•

Randomisierung liefert den gleichen Eekt wie eindeutige Zeugen für genügend viele Einträge

Pij ,

denn bei einer zufälligen Auswahl von Kandi-

datenmengen trit man wahrscheinlich auf eine Menge mit genau einem

Zeugen.

•

Die wenigen verbleibenden Einträge werden dann mit dem trivialen Algorithmus berechnet.

Nicht eindeutige Zeugen

Wir betrachten boolsche Matrizen

einen festen Eintrag

(OE

w ≥ 2,

Pij

von

P.

Es sei

Ziel ist es, eine Menge

k

für

Lemma 23.

enthalte

r

w = Cij

und

die Anzahl der Zeugen für

Pij

denn nach den Vorbetrachtungen ist es einfach, einen eindeutigen

Zeugen zu nden). Auÿerdem sei

Zeugen

A, B ∈ {0, 1}n×n , P = A ∗ B , C = AB

Pij

r∈N

mit

n

2

≤ wr ≤ n.

R ⊂ {1, ..., n} mit |R| zu nden, die den eindeutigen

enthält.

Es sei

n ∈ N, w ∈ {1, ..., n}, r ∈ N

n Bälle, von denen w

weiÿ und

n−w

n

mit 2

≤ wr ≤ n.

Eine Urne

schwarz sind. Zieht man zufällig

Bälle aus der Urne, ohne diese zwischendurch zurückzulegen, so ist:

Pr[genau

ein weiÿer Ball wurde gezogen]

18

≥

1

2e

Proof. Durch elementare Rechenoperationen kann die gesuchte Wahrscheinlichkeit wie folgt beschränkt werden:

w

1

n−w

r−1

n

r

r! (n − w)!

(n − r)!

(r − 1)!

n!

(n − w − r + 1)!

! w−2

!

w−1

Y 1

Y

wr

(n − r − j)

n

−

i

i=0

j=0

!

w−2

wr Y n − r − j

n j=0 n − 1 − j

!

w−2

wr Y n − r − j − (w − j − 1)

n j=0 n − 1 − j − (w − j − 1)

!

w−2

wr Y n − w − (r − 1)

n j=0

n−w

w−1

r−1

wr

1−

n

n−w

w−1

1

1

1−

siehe **

2

w

= w

=

=

≥

=

=

≥

* Gilt faktorweise:

siehe *

a = n − r − j , b = n − 1 − j , c = w − j − 1.

Dann ist

a(b − c) ≥ b(a − c) ⇔ ac ≤ bc ⇔ a ≤ b.

**

r−1

n−w

≤

1

w

⇔ (r − 1)w ≤ n − w ⇔ rw ≤ n.

Die letzte Ungleichung folgt von den Beobachtungen, dass

(r − 1)/(n − w) ≤ 1/w,

was aus der Annahme, dass

Beispiel 24. n = 8, w = 3, n − w = 5.

n

2

≤ wr ≤ n

ist

wr/n ≥ 1/2

n/2 ≤ wr ≤ n,

und

folgt.

Einzig mögliche Wahl für

r

mit

r = 2:

•

3 Möglichkeiten, genau 2 weiÿe Bälle zu ziehen

•

10 Möglichkeiten, genau 2 schwarze Bälle zu ziehen

•

15 Möglichkeiten, genau 1 weiÿen und 1 schwarzen Ball zu ziehen

•

28 Möglichkeiten insgesamt

Damit ist

Pr[genau

ein weiÿer Ball wurde gezogen]

Sei jetzt

enthält.

R

dann, wenn

R ⊂ {1, ..., n}

derart, dass

=

28−13

28

R

einen eindeutigen Zeugen für

sei gegeben durch einen Vektor

k ∈ R.

Deniere:

19

=

15

28

>

n

R ∈ {0, 1}

1

2

>

1

2e

mit

≈ 0.184.

Rk = 1

Pij

genau

•

eine Matrix

AR ∈ Nn×n

0

durch

AR

ik = kRk Aik

•

eine Matrix

B R ∈ Nn×n

0

durch

R

= Rk Bkj

Bkj

Weiterhin sind die Matrizen

Â

wie bereits weiter oben verwendet.

jede Spalte von

Â,

mit

die zu einem Element

k∈

/R

k

W =A ·B

Proof.

k∈R

k∈

/R

und

W = Â · B

so

mit

k

gehört, durch eine Nullspalte

multipliziert wird.

B,

entsteht, indem jede Zeile von

Es seien

R

Zeuge für

P

B

BR

ist die

die zu einem Element

gehört, durch eine Nullzeile ersetzt wird.

Lemma 25.

oben,

B

sowie

AR ist die Matrix, die aus  entsteht, indem

ersetzt wird und jede andere Spalte

Matrix, die aus

Âik = kAik

und

R

A, B ∈ {0, 1}n×n

Pij

. Wenn

boolsche Matrizen,

einen eindeutigen Zeugen in

AR

R

BR

wie

hat, so ist

Wij

und

Pij .

Wij = (AR · B R )ij =

k · Aik · Bkj .

Zeugeneigenschaft:

Wenn

R

Pn

k=1

R

AR

ik Bkj =

Pn

k=1

k · Rk · Aik · Rk Bkj =

nur einen einzigen Zeugen enthält, folgt aus der

Wij = k·Aik ·Bkj = k , wobei k der eindeutige Zeuge ist.

Die weiteren Ideen, die zum fertigen Algorithmus führen, lassen sich so

umschreiben:

• W = AR B R

liefert Zeugen für alle Einträge in

eindeutigen Zeugen in

•

Eintrag von

1

n

, wenn

2e

2

haben.

Wir wählen

P

R

der Gröÿe

mit

w

|R| = r

einen eindeutigen Zeugen für einen

Zeugen enthält, gröÿer oder gleich der Konstanten

≤ wr ≤ n

ist.

O(log n) Mengen R zufällig aus. Damit wird es sehr unwahr-

scheinlich, dass für einen Eintrag von

•

die einen

Nach Lemma 23 ist die Wahrscheinlichkeit dafür, dass eine zufällig gewählte Menge

•

R

P = A ∗ B,

P

kein Zeuge identiziert wird.

Zeugen für die Einträge, für die kein Zeuge identiziert wird, werden mit

dem trivialen Algorithmus berechnet.

•

Da nicht alle Einträge von

Mengen

die gleiche Anzahl Zeugen haben, müssen

R mit verschiedenen Kardinalitäten r

jedoch, für

r

die Zweierpotenzen zwischen

die Bedingung

Satz 26.

P

n

2

≤ wr ≤ n

1

benutzt werden. Es reicht

und

n

zu benutzen, da nur

erfüllt sein muss.

Algorithmus Bpwm ist ein Las-Vegas-Algorithmus für Problem Bp-

wm mit erwarteter Laufzeit

O(mm(n) log2 n).

20

Algorithm 5 Bpwm

1: procedure Bpwm(Boolsche Matrizen A, B ∈ {0, 1}n×n )

2:

W = −AB

3:

for t = 0, ..., blog nc do . teste alle Zweierpot. r = 2t zwischen 1 und n

. Wij < 0 ⇔

Zeuge für

4:

r = 2t

5:

Repeat d3.77 log ne times

6:

Wähle

R ⊆ {1, ..., n}

mit

Pij

muss noch gefunden werden

.

für

O(log n)

|R| = r

7:

berechne

8:

Z = AR B R

9:

for all (i, j) do . teste, ob neuer Zeuge für Pij

if Wij < 0 und Zij ist Zeuge für Pij then

10:

11:

12:

13:

A

R

und

B

Runden

R

.

vgl. Lemma 23

gefunden wurde

Wij = Zij

end if

end for

14:

15:

16:

17:

18:

end for

for all (i, j) do

if Wij < 0 then

berechne

Wij

.

kein Zeuge für

mit dem trivialen Algorithmus

end if

20:

end for

21: end procedure

19:

21

Pij

gefunden

O(mm(n))

Proof. Die Initialisierung benötigt

läuft die innere Schleife

und führt jedes Mal eine ganzzahlige

n×n

Matrizen durch. Die anderen Operationen in

O(log n)-mal

Matrixmultiplikation von

Zeit. Der Algorithmus durch-

2

O(mm(n) log2 n)

der Schleife sind weniger zeitaufwändig. Die Laufzeit

folgt,

wenn nicht zu oft der triviale Algorithmus aufgerufen werden muss.

• Beh.:

Ist

Pij = 1,

so wird im randomisierten Teil des Algorithmus ein

≥1−

Zeuge mit Wahrscheinlichkeit

• Bew.:

w

Sei

1

gefunden.

n

die Anzahl der Zeugen für

mindestens einmal mit einem Wert

r

Pij .

n

mit

2

Die äuÿere Schleife wird

≤ wr ≤ n

diesem Durchlauf ist die Wahrscheinlichkeit, dass

Pij

Zeugen für

enthält, höchstens

(1 −

≤

keinen eindeutigen

1

nach Lemma 23. Damit ist die

2e

1−

Wahrscheinlichkeit, dass kein Zeuge für

1 3.77 log n

)

2e

R

durchlaufen. In

Pij

identiziert wird höchstens

1

.

n

Damit ist die erwartete Anzahl der nicht gefundenen Zeugen begrenzt durch

n

anstelle der ursprünglichen

Algorithmus zusammen Zeit

n2 .

Somit benötigen alle Aufrufe des trivialen

O(n2 ).

Randomisierter Algorithmus

Wir schlieÿen das Thema in diesem Abschnitt mit der Beschreibung des randomisierten Algorithmus ab, der anhand einer Zeugenmatrix eine Nachfolgermatrix berechnet. Zuvor muss noch festgelegt werden, wie genau diese Nachfolgermatrix berechnet wird.

Denition 27.

trix

S

von

i

für

G

ist eine

G(V, E)

ein Graph mit

n × n-Matrix,

möglich, wenn

dann, wenn

i

nach

j

i 6= j Sij

ein Nachfolger

liegt. Weiter ist

beliebig mit

Sii = 0.

Dij = d. Sij = k ist genau dann

Dik = 1 und Dkj = d − 1. Sei B d ∈ {0, 1}n×n

Dkj = d − 1 (B d

Lemma 28.

Dij = d

Knoten. Eine Nachfolgerma-

A die Adjazenzmatrix eines Graphen G(V, E), D die Distanzmatrix

G. Seien i, j ∈ {1, ..., n}, i 6= j

{0, 1}n×n

n

so dass für alle

ist, der auf einem kürzesten Weg von

Sei nun

von

Es sei

Es sei

A

kann aus

D

in Zeit

O(n2 )

Einträge

Sij

einer Nachfolgermatrix

S

für

d

)

d

Bkj

= 1 genau

berechnet werden).

Adjazenzmatrix eines Graphen

wie oben deniert. Der Aufruf Bpwm(A, B

mit

G(V, E)

und

liefert für alle

Bd ∈

i, j

mit

G.

Der Beweis von Lemma 28 ist dem Leser zur Übung empfohlen.

Das Problem ist, dass es

n

mögliche Werte für

Laufzeit eines Algorithmus mindestens

Ω(nmm(n))

d

gibt. Damit wäre die

und somit superkubisch.

Aber es reichen drei Berechnungen von Zeugenmatrizen aus, denn:

22

•

Für alle

•

Jeder Nachfolger

i, j

und alle Nachfolger

k

von

i

mit

k

von

i

Dij − 1 ≤ Dkj ≤ Dij + 1.

gilt

Dkj = Dij − 1

ist ein möglicher Eintrag für

Sij .

•

•

Also: Jedes

k

Eintrag für

Sij .

Für

mit

Aik = 1

Dkj ≡ Dij − 1 (mod 3)

und

ist ein möglicher

(s)

s = 0, 1, 2 deniere D(s) durch Dkj = 1 genau dann, wenn Dkj +1 ≡ s

(mod 3).

•

Eine Nachfolgermatrix

A∗D

(s)

,

s = 0, 1, 2

S

von

A

kann dann aus den Zeugenmatrizen für

berechnet werden.

Algorithm 6 Apsp

1: procedure Apsp(Adjazenzmatrix A für G(V, E))

2:

berechne

3:

for s = 0, 1, 2 do

4:

D = Apd(A)

berechne

.D

D(s) ∈ {0, 1}n×n

derart, dass

(s)

Dkj = 1

ist Distanzmatrix

gdw.

Dkj + 1 ≡ s

(mod 3)

5:

berechne eine Zeugenmatrix

6:

end for

7:

berechne Nachfolgematrix

8:

S

W (s) = Bpwm(A, D(s) )

mit

(Dij (mod 3))

Sij = Wij

end procedure

Satz 29.

phen

G

Der Algorithmus Apsp berechnet eine Nachfolgermatrix eines Gra-

mit

n

Knoten in erwarteter Zeit

23

O(mm(n) log2 n).

Kapitel 3

Matchings in bipartiten Graphen

3.1

Grundlagen und Strukturaussagen

Ein häuges Problem in der Informatik ist es, eine Menge

an eine höchstens gleich groÿe Menge

V1

V2

von Bewerbern

von Jobs zuzuweisen. Die Struktur

und Lösungsverfahren dieses Problems, das leicht abgewandelt in vielen Anwendungen auftritt, werden in diesem Kapitel behandelt.

Denition 30.

•

Ein Graph

G

heiÿt bipartit genau dann, wenn seine Knotenmenge in

zwei disjunkte Teilmengen zerlegt werden kann, in denen keine internen

G = (V1 ∪ V2 , E)

Kanten existieren:

bipartit

⇔ V1 ∩ V2 = ∅

und

E ⊆

V1 × V2 .

•

Ein Matching

M

ist eine Kantenmenge in

G,

bei der keine zwei Kanten

einen Knoten gemeinsam haben.

•

Ein Matching

M

heiÿt nicht erweiterbar (engl.: maximal matching) ge-

nau dann, wenn jede Kante zu mindestens einer Kante aus

ist:

•

∀(u, v) ∈ E ∃w ∈ V

Ein Matching

M

derart, dass

Ein Knoten

v

u heiÿt

gibt, so dass

• M

oder

inzident

(v, w) ∈ M .

heiÿt gröÿtmöglich oder maximal (engl.: maximum

matching) genau dann, wenn

•

(u, w) ∈ M

M

|M |

saturiert (von

maximal unter allen Matchings in

M ) genau dann, wenn es einen Knoten

(u, v) ∈ M .

ist perfektes Matching:

M

G.

saturiert alle Knoten in

24

G.

Abbildung 3.1: Von links nach rechts: Leeres Matching, nicht erweiterbares

Matching sowie ein Matching, das gröÿtmöglich und perfekt ist.

Abbildung 3.2:

Zwei Beispiele von nicht erweiterbaren, aber nicht gröÿtmög-

lichen Matchings.

Abbildung 3.1 illustriert die verschiedenen Arten von Matchings. Nicht erweiterbare Matchings müssen nicht zwangsläug gröÿtmöglich sein, wie Abbildung 3.2 zeigt. Umgekehrt ist ein gröÿtmögliches Matching natürlich nicht

erweiterbar.

Bemerkung 31.

Das Ersetzen der Matching-Kanten in Abbildung 3.2 (rechts)

durch Kanten, die nicht zum Matching gehören, (und umgekehrt natürlich)

erzeugt ein gröÿeres Matching. Diese Beobachtung kann als mögliche Strategie

zur Vergröÿerung von Matchings dienen.

In der Folge versuchen wir, die oben formulierte Strategie zu formalisieren.

Denition 32.

Sei

M

ein Matching in

alternierender Pfad ist ein Pfad

(u1 , v1 , u2 , v2 , ..., uk , vk , uk+1 )

für alle

i.

Ein

mit

M -alternierender

G = (V1 ∪ V2 , E).

P = (u1 , v1 , u2 , v2 , ..., uk , vk )

(ui , vi ) ∈ M

für alle

i

oder

Ein

oder

M-

P =

(vi , ui+1 ) ∈ M

Pfad mit unsaturierten Endknoten heiÿt

M-

erweiternder Pfad.

Der

Name

alternierend

rührt

natürlich

daher,

dass

in

einem

M-

alternierenden Pfad beim Ablaufen der Kanten sich solche abwechseln, die

zu

M

gehören und solche, die nicht zu

M

gehören. Dies ergibt sich direkt aus

den obigen Denitionen.

Bemerkung 33.

Kanten aus

Hat man einen

P ∩M

M -erweiternden

durch die Kanten aus

25

P \M

Pfad

P,

ersetzt man die

und erhält ein Matching mit

einer Kante mehr. Daraus folgt sofort, dass kein

M

tieren kann, wenn

M -erweiternder

Pfad exisi-

nicht erweiterbar ist.

Um die Folgerung in Bemerkung 33 auch für die zweite logische Richtung

beweisen zu können, denieren wir zunächst die symmetrische Dierenz zweier

Graphen bzw. Mengen.

Denition 34.

Seien

V.

selben Knotenmenge

V

der Knotenmenge

Satz 35.

Seien

M

G = (V, EG )

und

H = (V, EH )

Die symmetrische Dierenz

und der Kantenmenge

0

M

und

menhangskomponente von

M ∆M

G∆H

E = {e|e ∈ EG

zwei Matchings in

0

zwei Graphen mit derist ein Graph mit

e ∈ E H }.

XOR

G = (V1 ∪ V2 , E).

Jede Zusam-

ist entweder ein Pfad oder ein Kreis gerader

Länge.

Proof. Seien

M

0

M

und

Matchings und sei

F = M ∆M

0

. Da

M

und

chings sind, hat jeder Knoten höchstens eine inzidente Kante aus

M

0

F

. Daraus folgt, dass

∆(F ) ≤ 2

F

Zusammenhangskomponente von

F

zwischen den Kanten von

M

und von

M

M

0

G

keinen

dann und nur dann, wenn

besitzt. Wir haben bereits gesehen, dass ein

M

werden kann, ein gröÿeres Matching als

einen

M −M

0

ist ein gröÿtmögliches Matching in einem Graphen

genau dann, wenn

Umgekehrt sei

ist jede

.

M -erweiternden

Proof. Wir zeigen die Kontraposition aller Richtungen.

M

F ),

0

Ein Matching

Matching als

bzw.

M − M . Somit hat jeder Kreis gerade Länge, mit gleicher

und den Kanten von

G = (V1 ∪ V2 , E)

M

Mat-

entweder ein Pfad oder ein Kreis. Auÿer-

dem alterniert jeder Pfad bzw. Kreis in

Satz 36.

0

höchstens zwei Kanten an jedem Knoten hat. Da

gilt (∆(F ) bezeichnet den maximalen Knotengrad von

Anzahl Kanten von

M

M

0

M -erweiternden

G

hat ein gröÿeres

M -erweiternden

Pfad

M -erweiternder Pfad dazu benutzt

zu produzieren.

ein gröÿeres Matching als

Pfad. Sei

einen

G

Pfad enthält.

F = M ∆M

0

M

in

G.

Wir konstruieren

, nach Lemma 35 besteht

F

aus

Pfaden und geraden Kreisen. Diese Kreise haben die gleiche Anzahl Kanten

von

M

und

M

0

. Da

mehr Kanten aus

0

|M | > |M |, muss F

M

0

als aus

M

haben. Solch eine Komponente kann nur ein

Pfad sein, der mit einer Kante aus

aber ein

M -erweiternden

Satz 37.

N (S)

(Halls Theorem) Sei

M

0

beginnt und endet, somit ist dieser Pfad

G.

G = (V1 ∪V2 , E) ein bipartiter Graph. Bezeichne

die Menge von Knoten, die einen Nachbarn in

Matching

|S|

Pfad in

eine Zusammenhangskomponente mit

M,

für alle

das jeden Knoten von

V1

S

haben. In

G

gibt es ein

saturiert, genau dann, wenn

S ⊆ V1 .

26

|N (S)| ≥

Proof. Notwendigkeit (⇒): Die

in

N (S)

|S| Knoten, die zu S

liegen.

(⇐):

Hinlänglichkeit

V1 , |N (S)| ≥ |S|

Um

zu

∀S

⊆

M

ein

saturiert nicht die Knotenmenge

V1 ,

zeigen,

dass

G

ist und

M

dann erhalten wir eine Menge

S ⊆ V1 ,

so dass

u ∈ V1

M

ein Knoten, der in

Bedingung

|N (S)| < S :

nicht saturiert ist. Unter allen Knoten,

die von

u

aus durch

bestehe

S

aus derartigen Knoten der Menge

V2

Halls

hinreichend ist, zeigen wir die Kontrapsoition. Wenn

gröÿtmögliches Matching in

Sei

gematcht wurden, müssen

M -alternierende

Pfade des Graphen

V1

(siehe hierzu Abbildung 3.3). Beachte, dass

und

T

u ∈ S.

G

erreichbar sind,

aus solchen der Menge

Wir behaupten, dass

M

Abbildung 3.3: Beispiel zu Halls Theorem, Satz 37.

die Knoten aus

erreicht

V2

M

M

von einem Knoten in

y∈T

erreicht, über

ergeben diese Kanten aus

dass

|T | = |S − {u}|

M

Die Kante

T = N (S).

S

ist zu

T

Hinzufügen der Kante

einen

y∈

/T

T

M

Pfad

V1

über

sind und kehrt zurück zu

T

S − {u} über eine

erreicht. Da es keinen

saturiert. Somit wird ein

zu einem Knoten aus

eine Bijektion von

T

und

S − {u}

Angenommen

(v, y) kann nicht in M

der Menge

M -alternierende

T

nach

S

M -erweiternden

M -alternierender

erweitert. Insofern

S −{u} und wir wissen,

gilt.

Das Matching zwischen

sächlich gilt

M

matcht. Der

liegen. Also wird jeder Knoten der Menge

Pfad gibt, ist jeder Knoten aus

Pfad, der

S − {u}

mit denen aus

über Kanten, die nicht in

Kanten, die in

Kante aus

T

ergibt auÿerdem

y ∈ V2 − T

liegen, da

hat einen Nachbarn

zu einem

Tat-

v ∈ S.

u unsaturiert ist und und der Rest

zugehörig über das Matching

(v, y)

T ⊆ N (S).

M.

M -alternierenden

Deshalb ergibt das

Pfad, der

v

erreicht,

M -alternierenden Pfad nach y . Dies widerspricht aber der Annahme, dass

und somit kann eine Kante

haben wir gezeigt, dass

(v, y)

auch nicht existieren. Mit

|N (S)| = |T | = |S| − 1 < |S|

T = N (s)

für diese Wahl von

S.

Dies schlieÿt den Beweis der Kontraposition ab.

Bemerkung 38.

hat, das

V1

Falls ein bipartiter Graph

G = (V 1 ∪ V 2, E)

kein Matching

saturiert, lässt sich dies mit Halls Theorem leicht nachweisen.

27

Dazu zeigt man einfach die Existenz einer Teilmenge von

Nachbarn in

V1

mit zu wenigen

V2 .

|X|

Ein klassisches Anwendungsbeispiel ist die Besetzung von

Bewerber aus einer Menge

Y.

Falls

|Y | > |X|,

Jobs durch

erhält natürlich nicht jeder

Bewerber einen Job. Es kann aber eben auch passieren, dass nicht jeder Job

besetzt werden kann, weil

Satz 39.

Für

k > 0

X

nicht saturierbar ist.

k -reguläre

hat jeder

bipartite Graph ein perfektes Mat-

ching.

Proof. Sei

G = (V1 ∪ V2 , E)

k -regulärer,

ein

Kanten nach Endpunkten in

V1

bipartiter Graph. Zählt man die

V2 ,

und nach Endpunkten in

sieht man, dass

k|V1 | = k|V2 |, also |V1 | = |V2 |. Somit reicht es aus, Halls Bedingung zu überprüfen. Ein Matching, das

V1

V2

saturiert, wird auch

saturieren und wird zudem

auch ein perfektes Matching sein.

S ⊆ V1 .

Sei

G

k -regulärer

ein

N (S)

Sei weiterhin

die Anzahl der Kanten von

Graph ist, gilt

und somit ist

sich, dass

m

m = k|S|.

m ≤ k|N (S)|.

|N (S)| ≥ |S|,

wenn

Diese

Daher gilt

k > 0.

m

S

nach

N (S).

Da

Kanten sind inzident zu

k|S| ≤ k|N (S)|.

Daraus ergibt

Mit der beliebigen Wahl von

S ⊆ X

haben wir die Gültigkeit von Halls Bedingung erfolgreich nachgewiesen.

Denition 40.

Menge

Q ⊆ V

Knoten aus

Q

Eine Knotenüberdeckung eines Graphen

derart, dass jede Kante aus

E

G = (V, E)

ist eine

inzident zu mindestens einem

ist. Eine minimale Knotenüberdeckung von

G

ist eine Knoten-

überdeckung mit minimaler Anzahl von Knoten unter allen Knotenüberdeckungen von

G.

Satz 41.

(Satz von König und Egerváry) Sei

G = (V1 ∪ V2 , E)

ter Graph. Ferner sei

M

ein gröÿtmögliches Matching und

Knotenüberdeckung in

G.

Dann gilt:

Q

ein biparti-

eine minimale

|Q| = |M |.

Proof. Sei

immer

Q

M

G = (V1 ∪ V2 , E) ein bipartiter Graph. Es ist leicht einzusehen, dass

|Q| ≥ |M |

gelten muss. Andernfalls gäbe es eine Kante in

nicht überdeckt wäre, weil ein Knoten in

Q

M,

die von

nur höchstens eine Kante aus

überdecken kann.

Gegeben sei daher nun eine minimale Knotenüberdeckung

können wir ein Matching der Gröÿe

|Q|

und

T = Q∩V2 . Seien H

und

H

die Teilgraphen von

28

von

G.

Dann

konstruieren, um zu zeigen, dass die

Gleichheit immer erreicht werden kann. Wir partitionieren

0

Q

Q durch R = Q∩V1

G, die durch R ∪(V2 −T )

und

T ∪(V1 −R) induziert werden. Wir wenden Halls Theorem an, um zu zeigen,

H

dass

ein Matching hat, das

hat, das

T

saturiert. Weil

H

R

V2 − T

in

H

und

0

und

R∪T

|Q|

in

ein Matching

G.

eine Knotenüberdeckung ist, hat

G

keine Kante zwischen

V2 − T

V1 − R (andernfalls wären diese Kanten nicht überdeckt). Für jedes S ⊆ R

betrachten wir

NH (S),

dann könnten wir

S

welches in

durch

deckung zu erhalten, da

und die nicht von

T

ein Matching, das

V2 − T

|NH (S)| < |S|,

enthalten ist. Gälte

NH (S) in Q ersetzen, um eine kleinere Knotenüber-

NH (S)

S

alle Kanten überdeckt, die zu

inzident sind

überdeckt werden.

Die Minimalität von

H

0

disjunkt sind, bilden die beiden Matchings

zusammen ein Matching der Gröÿe

Da

H

saturiert und dass

R

Q

ergibt somit Halls Bedingung für

H

und daher hat

saturiert. Wendet man dasselbe Argument auf

ergibt sich das Matching, das

T

H

0

an,

saturiert. Betrachte hierzu auch Abbildung

3.4.

Abbildung 3.4: Beispiel zu Satz 41

3.2

Berechnung von gröÿtmöglichen Matchings

Satz 42.

G.

Sei

G = (V1 ∪ V2 , E)

Falls es einen

|M |

ein bipartiter Graph und sei

M -erweiternden

M

Pfad gibt, der ein Matching

erzeugt, und es einen Knoten

Pfades gibt, dann gibt es auch einen

v

als Endknoten eines

M1

erweiternden Pfad bezüglich

Sei

P = hv = u1 , u2 , ..., un i

nehmen zusätzlich an, dass wir

erweiternden Pfades

mit

|M1 | >

M -erweiternden Pfad mit v als Endknoten.

enthält, der

M

M1

M1 -erweiternden

Proof. Zum Zwecke des Widerspruchs nehmen wir an, dass

ternden Pfad bezüglich

ein Matching in

hat, der

G

v

als Endknoten hat, aber

v

als Endknoten enthält.

ein erweiternder Pfad bezüglich

M1

durch das Erweitern von

Q = hv1 , v2 , ..., vk i

bezüglich

M

M

G

M1

keinen

und wir

entlang des

P

auf-

M . Somit enthält P

eine

erhalten. Dann ist

grund der Annahme kein erweiternder Pfad bezüglich

29

einen erwei-

M1

Kante, die zu

Wert derart, dass

(u2i , u2i+1 ) ∈ M1 − M .

auf

P

als auch auf

von

Q

entstanden ist. Der Knoten

Q

denn andernfalls wäre

M,

der

und

u2i

v

u2i

i

(u2i , u2i+1 )

M1

durch die Erweiterung

ist ein saturierter Knoten bezüglich

Q,

e

aus

0

Q = hv1 , v2 , ..., vj−1 , vj i

Q,

die zu

muss

M

(u2i , u2i+1 ) ∈ E(Q) − M

M1 ),

Matching hinzugefügt (bezüglich

folgt aus der Konstruktion, dass

bezüglich

M

0

Q

und

u2i = vj

gehört. Sei

e = (vj−1 , vj )

mit

gelten.

ist ein alternierender Pfad bezüglich

die noch nicht im Matching bezüglich

haben. Allerdings ist

M,

P = hv = u1 , u2 , ..., u2i i ein erweiternder Pfad bezüglich

der genau einen unsaturierten Knoten enthält, nämlich

0

liegt sowohl

0

(u2i , u2i+1 ) ∈ E(Q) − M ,

Da

der kleinste ganzzahlige

Die Kante

(siehe Abbildung 3.5), weil

inzident mit der Kante

Der Pfad

aus

Sei nun

als Endknoten hat. Aus diesen Gründen ist

1 < j < k.

M,

M.

gehört, aber nicht zu

M

wenn wir

P

0

v1 .

Die Kanten

enthalten sind, werden dem

M

entlang

nur den Knoten

Q

erweitern. Es

vj = u2i gemeinsam

hv = u1 , u2 , ..., u2i , vj−1 , vj−2 , ..., v1 i ein erweiternder Pfad

(betrachte hierzu auch Abbildung 3.5). Aber dies widerspricht

der Annahme.

Abbildung 3.5: Ein erweiternder Pfad, der im Satz 42 konstruiert wurde

Folgerung 43.

sei

Sei

M

M = M1 , M2 , ..., Mk

ein Matching in einem bipartiten Graphen

eine Sequenz von Matchings, wobei

30

Mi+1

G.

aus

Ferner

Mi

durch

einen

Mi -erweiternden

einen Knoten

v

kein

Mi -erweiternden

Pfad erzeugt wird, für alle

i = 1, ..., k − 1.

Sollte für

M -erweiternder Pfad existieren, dann gibt es auch keinen

Pfad mit

v

als Endknoten (i

= 1, ..., k − 1).

Wir betrachten nun den Algorithmus MaximumMatching, der ein gröÿt-

M

mögliches Matching

p = |V1 | ≤ |V2 | = q ,

für einen bipartiten Graphen

G = (V1 ∪ V2 , E),

mit

berechnet. Die Algorithmus-Idee kann wie folgt zusam-

mengefasst werden:

•

Sei

M

initiales Matching. Falls

gibt es eine Sequenz

Mk

wird aus

M = M1 , ..., Mk ,

Mi

so dass

mit Hilfe eines

Wir wählen einen Knoten

ob es einen

•

kein gröÿtmögliches Matching ist, dann

gröÿtmögliches Matching

Mi+1

•

M

Mi -erweiternden

v , der bzgl. M

M -erweiternden

Pfades erzeugt

unsaturiert ist, und bestimmen,

Pfad gibt, in dem

Falls ein solcher Pfad gefunden wird, wird

M

V

zu

der Endknoten ist

M0

erweitert; wir erhal-

ten dadurch ein gröÿeres Matching

•

Falls

hat

v

v

kein Endpunkt von irgendeinem

M -erweiternden

in einem gröÿtmöglichen Matching

Matchings

M

Mk ,

Pfad ist, dann

das durch Erweitern des

entsteht, gemäÿ Folgerung 43 keinen Matchingpartner

Weitere Erklärungen und Hinweise nden Sie in den Vorlesungsfolien bzw.

im Buch [2].

3.3

Matchings mit maximalem Gewicht

In diesem Abschnitt werden wir den sogenannten ungarischen Algorithmus

kennenlernen, der in vollständigen gewichteten bipartiten Graphen ein Matching maximalen Gewichts ndet.

Details bisher nur auf den Folien oder in den Büchern [1] und [2].

3.3.1

Satz 44.

Korrektheit

Sei

G = (V1 ∪ V2 , E)

ein vollständiger gewichteter bipartiter Graph.

Dann ndet der Algorithmus MaximumWeightMatching (auch Algorithmus von Kuhn und Munkres oder ungarischer Algorithmus genannt) ein Mat-

ching mit maximalem Gewicht in

G.

31

Algorithm 7 MaximumMatching

1: procedure MaximumMatching(Bipartiter Graph G = (V1 ∪ V2 , E), Initiales Matching

M1 )

2:

i = 1, M = M1

3:

if i ≥ p then return M

. M gröÿtmögliches Matching

end if

if vi ∈ M then goto line 3

else{v = vi , Q = {v}}

forall v ∈ V1 ∪ V2 , v 6= vi {T REE(vj ) = F ALSE}; T REE(vi ) =

4:

5:

6:

7:

T RU E;

if Q = ∅ then {i = i + 1, goto line 3}

else extract a vertex x from Q

8:

9:

10:

Let

N (x) = {y1 , ..., yj }.

Set

j=1

if j ≤ k then y = yj

else goto line 8

end if

end if

if T REE(y) = T RU E then {j = j + 1, goto line 11}

end if

if (y, z) ∈ M then {T REE(y) = T RU E, T REE(z) =

11:

12:

13:

14:

15:

16:

17:

T RU E, P AREN T (y) = P AREN T (z) = y, Q = Q ∪ {z}, j = j + 1,

goto line 11}

18:

end if

19:

Use

P AREN T

to determine

20:

end if

21:

Augment

22:

M = M , i = i + 1, goto

23:

M

0

along

P

M -augmenting

to obtain new matching

line 3

end procedure

32

path

M

0

P

from

v

to

y

Algorithm 8 MaximumWeightMatching

1: procedure MaximumWeightMatching(Vollst.

(V1 ∪ V2 , E),

Gewichtsfkt.

3:

4:

Sei

5:

M = MaximumMatching(Hl , ∅);

6:

if M

else

7:

Hl

der von

l

denierte Graph mit Kantenmenge

saturiert jeden Knoten von

Sei

9:

Konstruiere einen alternierenden Baum

10:

11:

12:

13:

El ;

V1 then return M ;

8:

x

G=

w)

forall v ∈ V1 sei l(v) = maxu∈V2 w(v, u);

forall u ∈ V2 sei l(u) = 0;

2:

bipartiter Graph

der erste unsaturierte Knoten in

V1 ;

T

mit Wurzel

x

bzgl.

M;

if ∃ M -erweiternder Pfad P then

Erweitere

M;

goto line 6;

else

14:

ml = min{l(v) + l(u) − w(u, v) | v ∈ V1 ∩ T, u ∈ V2 \ T };

15:

l(v) = l(v) − ml

16:

Konstruiere

für

v ∈ V1 ∩ T , l(u) = l(u) + ml

Hl ;

goto line 9;

18:

end if

19:

end if

20: end procedure

17:

33

für

u ∈ V2 ∩ T ;

Proof. Der Algorithmus beginnt mit einer zulässigen Knotenmarkierung. Er

kann nur terminieren, wenn der Spanngraph

Hl

ein perfektes Matching hat.

Diese Eigenschaft garantiert uns, dass die Knotenmarkierung und das Matching das gleiche Gewicht haben. Nehmen wir an,

l

Knotenmarkierung und der zugehörige Spanngraph

l0

tes Matching. Sei

sei die aktuelle zulässige

Hl

enthalte kein perfek-

die daraufhin erstellte neue Knotenmarkierung. Da

ml

das Minimum einer nicht-leeren endlichen Menge von positiven Zahlen ist, gilt

ml > 0.

Wir weisen zunächst nach, dass

l0

eine zulässige Knotenmarkierung ist.

V1 ∩ V (T )

und

V1 ∩ V (T )

und

v ∈ V1 ∩ V (T )

und

Die Veränderung der Markierungen auf Knoten der Mengen

V2 ∩ V (T )

ergibt

V2 ∩ V (T ).

0

0

l (v) + l (u) = l(v) + l(u)

Daher bleiben die Kanten in

u ∈ V2 \V (T ),

gilt

0

0

für Kanten zwischen

Hl0

erhalten. Falls

l (v) + l (u) = l(v) + l(u) − ml ,

mindestens so groÿ ist wie

was wegen der Wahl von

ml

wu,v .

Der Algorithmus terminiert nur, wenn der Spanngraph

Hl

ein perfektes

Matching enthält, so dass es genügt zu zeigen, dass die Terminierung tatsächlich eintritt. Nehmen wir an, die Kantengewichte

wu,v

seien rational. Wenn

wir die Gewichte mit ihrem Hauptnenner multiplizieren, erhalten wir ein äquivalentes Problem mit ganzzahligen Gewichten. Wir können daher nun auch

annehmen, dass die Markierungen in

schusswert

ml

l

ganzzahlig sind. Daher ist jeder Über-

auch ganzzahlig und in jeder Iteration reduzieren wir die Kosten

der Knotenmarkierung um einen positiven ganzzahligen Betrag. Da wir bei einem endlichen Wert starten und die Kosten nach unten beschränkt sind (nämlich durch die Kosten eines perfekten Matchings), terminiert der Algorithmus

nach endlichen vielen Iterationen.

Bemerkung 45.

Der Beweis von Satz 44 kann so modiziert werden, dass

auch reellwertige Kantengewichte zugelassen werden können.

34

Kapitel 4

Matchings in allgemeinen Graphen

Wir haben bis jetzt Matchings in bipartiten Graphen betrachtet. Es folgt nun

ein Abschnitt, in dem wir uns mit allgemeinen Graphen befassen werden.

4.1

Der Algorithmus von Edmonds

Der Algorithmus von Edmonds berechnet ein gröÿtmögliches Matching in allgemeinen Graphen. Bisher ist seine Darstellung nur im Foliensatz verfügbar.

4.2

Approximationsalgorithmen für MWM

In diesem Abschnitt werden zwei Approximationsalgorithmen für das Problem

MaximumWeightedMatching in allgemeinen Graphen behandelt. Beide

Algorithmen haben die Approximationsgüte

2,

wie wir in den folgenden Re-

sultaten beweisen werden. Die Darstellung der Algorithmen ndet sich im Foliensatz.

Satz 46.

sei

M

∗

Sei

G = (V, E)

ein Graph mit nicht-negativen Kantengewichten und

ein Matching mit maximalem Gewicht in

berechnet ein Matching

Proof. Sei

M

mit

∗

w(M ) ≤ 2w(M )

G.

GreedyApproxMWM

in Zeit

O(m log m).

x das Gewicht der ersten Kante e = {u, v}, die durch den Algorith-

mus GreedyApproxMWM ausgewählt wird. Oensichtlich ist

mit maximalem Gewicht in

G.

Wenn

e

e

eine Kante

und alle inzidenten Kanten gelöscht

werden, werden dabei höchstens zwei Kanten des optimalen Matchings

M∗

entfernt. Die Summe der Gewichte dieser beiden Kanten beträgt höchstens

2x.

Bei der Wahl der nächsten Kante

keine Kante mehr in

e

0

gilt entweder

M ∗ , die schwerer als e0

e ∈ M

∗

oder es gibt

ist. Daher gilt jedes Mal, wenn ein

oder zwei Kanten des optimalen Matchings aus

35

0

E

gelöscht werden, die nicht

in

M

M

aufgenommen worden sind, dass die gewählte Kante in

halb so schwer ist wie die beiden gelöschten Kanten aus

M∗

mindestens

zusammen. Dieses

Argument lässt sich für alle weiteren Iterationen von GreedyApproxMWM

wiederholen. Da alle Kantengewichte nicht negativ sind, folgt die Behauptung

zur Approximationsgüte.

Die Laufzeit ergibt sich durch die initiale Sortierung der Kanten nach ihrem

Gewicht, weil die Schleife jede Kante genau einmal betrachtet und daher nur

lineare Laufzeit in

|E|

hat.

Die folgenden Ergebnisse beruhen auf einer Arbeit von D. E. Drake und S.

Hougardy [6].

Satz 47.

Der Algorithmus

PathGrowingMWM

hat eine Laufzeit von

O(|E|).

Proof. Jeder Knoten des Graphen wird höchstens einmal in der while-Schleife

in den Zeilen 4-10 bearbeitet, denn nach seiner Bearbeitung wird er in Zeile

8 aus

G

entfernt. Die schwerste Kante, die zu einem Knoten

zu nden und

x

aus

G

x

inzident ist,

zu entfernen, lässt sich problemlos mit einem Aufwand

durchführen, der proportional zum Grad von

x

ist. Indem man Pfade immer

nur von Endknoten einer Kante startet, stellt man sicher, dass keine Knoten

mit Grad 0 bearbeitet werden. Die Zahl der Knoten mit Grad mindestens

1

in

G

ist

O(|E|).

Daher ist die Gesamtlaufzeit des Algorithmus PathGro-

wingMWM beschränkt durch die Summe der Knotengrade der Knoten in

was

O(|E|)

Satz 48.

güte von

V,

ergibt.

Der Algorithmus PathGrowingMWM hat eine Approximations-

2, d. h. das von ihm gefundene Matching ist mindestens halb so schwer

wie ein Matching mit maximalem Gewicht.

Proof. Für die Analyse der Güte weisen wir jede Kante des Graphen

einen Knoten von

G

folgendermaÿen zu. Immer wenn ein Knoten

x

des Algorithmus entfernt wird, werden alle Kanten, die noch zu

sind, zu

x

zugewiesen. Auf diese Weise wird jede Kante von

Knoten von

G

G

G

an

in Zeile 8

x

inzident

genau einem

zugewiesen. Andererseits muss nicht jeder Knoten von

G

ihm

zugewiesene Kanten haben.

Wir betrachten nun ein MWM

M

von

G.

Da

M

keine zwei zueinander

inzidente Kanten haben kann, werden alle Kanten von

Knoten von

G

M

an verschiedene

zugewiesen. In jedem Schritt des Algorithmus wird die aktuell

schwerste Kante, die zu

x

inzident ist, in Zeile

hinzugefügt. Daher ist das Gewicht von

36

5

gewählt und zu

M1 ∪ M2

M1

oder

M2

mindestens so groÿ wie das

Gewicht von

M.

Da

1

1

max{w(M1 ), w(M2 )} ≥ w(M1 ∪ M2 ) ≥ w(M ),

2

2

liefert der Algorithmus PathGrowingMWM ein Matching, das mindestens

halb so schwer ist wie das Optimum.

4.3

Die Theoreme von Tutte und Petersen

Denition 49.

F

und

Ein Faktor

F

eines Graphen

G ist ein Spanngraph von G, d. h.

G haben dieselbe Knotenmenge und E(F ) ⊆ E(G). Ein k -Faktor ist ein

k -regulärer

Spanngraph. Eine ungerade Komponente ( odd component) eines

Graphen ist eine (Zusammenhangs)Komponente mit einer ungeraden Anzahl

von Knoten. Die Anzahl ungerader Komponenten von

Bemerkung 50.

Ein

1-Faktor

wird mit

o(H) notiert.

und ein perfektes Matching sind fast dasselbe.

Die genaue Unterscheidung ist, dass ein

von

H

1-Faktor

ein

1-regulärer

Spanngraph

G ist, während ein perfektes Matching die Menge von Kanten in einem sol-

chen Spanngraph ist. Ein

3-regulärer

Graph, für den es ein perfektes Matching

gibt, kann in zwei Teilgraphen zerlegt werden, von denen einer ein

und einer ein

2-Faktor

1-Faktor

ist.

Tutte hat eine notwendige und hinreichende Bedingung dafür gefunden,

1-Faktor

wann Graphen einen

trachten die Teilmenge

G−S

S ⊆ V (G),

G

einen

1-Faktor

hat und wir be-

dann hat jede ungerade Komponente von

einen Knoten, der einen Matching-Partner auÿerhalb dieser Komponente

hat und daher nur zu

sen,

haben. Wenn

o(G − S) ≤ |S|.

S

gehören kann, da die Knoten von

disjunkt sein müs-

Betrachte hierzu auch Abbildung 4.1. Tuttes Bedingung:

Abbildung 4.1:

Für alle

S

S ⊆ V (G), o(G − S) ≤ |S|.

Tuttes Bedingung

Tutte hat bewiesen, dass diese Bedingung

nicht nur notwendig ist, sondern auch hinreichend. Es gibt viele Beweise, die

37

dies zeigen. Wir betrachten hier den Beweis von Lovász und benutzen Ideen

der symmetrischen Dierenz.

Satz 51.

S) ≤ |S|

Ein Graph

G

1-Faktor

hat einen

für jede Teilmenge

o(G −

dann und nur dann, wenn

S ⊆ V (G).

Proof. Notwendigkeit (⇒): Die ungeraden Komponenten von

Knoten haben, die zu disjunkten Knoten von

S

G−S

müssen

gematcht sind.

Hinlänglichkeit (⇐): Wenn wir eine Kante hinzufügen, die zwei Komponenten aus

G−S

verbindet, steigt die Anzahl der ungeraden Komponenten

nicht (eine gerade und eine ungerade Komponete werden zu einer ungeraden

Komponente, zwei Komponenten derselben Parität bilden eine gerade Komponente). Somit bleibt Tuttes Bedingung erhalten, wenn Kanten hinzugefügt

werden: wenn

0

0

G = G + {e} und S ⊆ V (G), dann o(G − S) ≤ o(G − S) ≤ |S|.

Auÿerdem hat

G

keinen

1-Faktor,

wenn

0

G = G + {e}

keinen

1-Faktor

Somit gilt der Satz von Tutte, falls es keinen simplen Graphen

dass

G

Tuttes Bedingung erfüllt,

einer fehlenden Kante zu

G

G

G

keinen

1-Faktor

ergeben würde. Sei

ein solcher Graph. Wir führen den Beweis nun per Widerspruch, indem wir

zeigen, dass

Sei

U

G

einen

1-Faktor

besitzt.

die Menge von Knoten in

1. Fall: G − U

G,

die Grad

n(G) − 1

haben.

besteht aus vollständigen disjunkten Graphen.

In diesem Fall können die Knoten in jeder Komponente von

o(G − U ) ≤ |U |

Paaren zusammengefasst werden. Da

U

G derart gibt,

hat und das Hinzufügen

1-Faktor

einen Graphen mit

hat.

zu jedem Knoten aus

Knoten mit Knoten aus

G−U

U

G−U

zu beliebigen

und jeder Knoten aus

adjazent ist, können wir die übrig gebliebenen

matchen.

Wenn wir Tuttes Bedingung auf

S = ∅ anwenden, ergibt sich, dass n(G) ge-

rade sein muss, denn ein Graph ungerader Gröÿe enthielte eine ungerade Komponente und würde Tuttes Bedingung verletzen. Weiterhin liegen die Knoten,

die übrig bleiben, in

U

und bilden eine Clique. Um den

1-Faktor

zu erhalten,

müssen wir nur noch zeigen, dass eine gerade Menge von Knoten in

U

übrig

geblieben ist. Tatsächlich haben wir eine gerade Anzahl Knoten gemtached

und da

n(G)

gerade ist, bleibt eine gerade Anzahl von Knoten in

U

übrig.

Siehe auch Abbildung 4.2.

2. Fall: G − U

In diesem Fall hat

jazente Knoten

G−U

G−U

x, z

zwei Knoten mit der Distanz

mit einem gemeinsamen Nachbarn

einen anderen Knoten

Konstruktion von

Seien

ist keine disjunkte Vereinigung von Cliquen.

M1

und

G

w,

der nicht adjazent zu