Ludger Rüschendorf

Werbung

Ludger Rüschendorf

Mathematische

Statistik

Mathematische Statistik

Ludger Rüschendorf

Mathematische Statistik

Prof. Dr. Ludger Rüschendorf

Albert-Ludwigs-Universität Freiburg

Freiburg, Deutschland

ISSN 1234-5678

ISBN 978-3-642-41996-6

DOI 10.1007/978-3-642-41997-3

ISBN 978-3-642-41997-3 (eBook)

Mathematics Subject Classification (2010): 62-01,62-C05,62-B05,62-N05

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.de abrufbar.

Springer Spektrum

© Springer-Verlag Berlin Heidelberg 2014

Das Werk einschließlich aller seiner Teile ist urheberrechtlich geschützt. Jede Verwertung, die nicht ausdrücklich vom Urheberrechtsgesetz zugelassen ist, bedarf der vorherigen Zustimmung des Verlags. Das gilt

insbesondere für Vervielfältigungen, Bearbeitungen, Übersetzungen, Mikroverfilmungen und die Einspeicherung und Verarbeitung in elektronischen Systemen.

Die Wiedergabe von Gebrauchsnamen, Handelsnamen, Warenbezeichnungen usw. in diesem Werk berechtigt auch ohne besondere Kennzeichnung nicht zu der Annahme, dass solche Namen im Sinne der

Warenzeichen- und Markenschutz-Gesetzgebung als frei zu betrachten wären und daher von jedermann

benutzt werden dürften.

Gedruckt auf säurefreiem und chlorfrei gebleichtem Papier.

Springer Spektrum ist eine Marke von Springer DE. Springer DE ist Teil der Fachverlagsgruppe Springer

Science+Business Media

www.springer-spektrum.de

Vorwort

Das vorliegende Textbuch gibt eine Einführung in Fragestellungen und Methoden

der mathematischen Statistik. Es basiert auf Vorlesungen, die der Autor seit 1980

regelmäßig in mathematischen Studiengängen in Aachen, Essen, Münster und Freiburg gehalten hat. Ziel dieses Kurses ist es, ausgehend von der Datenanalyse und

deren Motivation darzustellen, dass mit der Verwendung stochastischer Modelle

ermöglicht wird, statistische und datenanalytische Verfahren zu bewerten und zu

begründen. Die Statistik wird auf diese Weise in die Entscheidungstheorie und

Spieltheorie eingeordnet und damit in besonderer Weise Gegenstand der mathematischen Behandlung. Diese Eingliederung erlaubt es, die klassischen statistischen

Fragestellungen wie Test- und Schätzprobleme und Konfidenzbereiche einheitlich

darzustellen und statistische Auswahlkriterien wie Bayes-, Minimax- und weitere

spezifische Optimalitätskriterien systematisch zu entwickeln. Durch eine Reihe von

motivierenden Beispielen, z.B. zum Problem der optimalen Auswahl zur Erkennung von gefälschten Folgen und Daten, zur Identifikation und Rekonstruktion von

verrauschten Bildern soll der breite Horizont statistischer Fragestellungen skizziert

und die Bedeutung der Statistik als praxisrelevante und weitreichende Theorie der

Entscheidungen beschreiben werden.

Klassische und auch moderne Konstruktionsprinzipien für statistische Verfahren werden behandelt und begründet. Hierzu werden zunächst eine Reihe von

grundlegenden statistischen Methoden und Begriffen eingeführt. Ein zentraler Begriff ist die Suffizienz, die den Informationsgehalt einer Statistik oder σ-Algebra

beschreibt. Weitere wichtige Prinzipien sind die Reduktion durch Invarianz oder

Äquivarianz, durch Unverfälschtheit oder Erwartungstreue und die Reduktion auf

geeignete Schätz- und Testklassen. ‘Highlights‘ sind dann jeweils die entscheidungstheoretische Begründung für diverse statistische Verfahren wie z.B. die Zulässigkeit

des arithmetischen Mittels in Normalverteilungsmodellen, die Optimalität von tTest, F -Test, dem Pitman-Permutationstest und dem exakten Test von Fisher oder

die Optimalität von Pitman-Schätzern und von U -Statistiken.

Das Textbuch versucht neben den klassischen Themengebieten auch bis zu einem gewissen Grad in Anwendungen einzuführen, die nicht unbedingt in Standardtexten zur mathematischen Statistik zu finden sind. Gegeben wird eine Einführung

in grundlegende Prinzipien der asymptotischen Statistik. Es wird in den Kapiteln zur Schätz- und Testtheorie oder zu den Konfidenzbereichen in den ganzen

vi

Vorwort

Text eingebunden gezeigt, dass die Grenzwertsätze der Wahrscheinlichkeitstheorie

es ermöglichen, unter sehr allgemeinen Bedingungen approximative Tests und Konfidenzbereiche zu konstruieren und Eigenschaften von Schätzverfahren zu beschreiben. So wird z.B. die asymptotische Verteilung von Maximum-Likelihood-Schätzern

oder von Martingalschätzern bestimmt und der Begriff der asymptotischen Effizienz von Schätzverfahren eingeführt. Detailliert wird beispielhaft für eine Reihe

nichtparametrischer Schätzverfahren die Dichteschätzung behandelt. Gegeben wird

auch eine Einführung in robuste und sequentielle Tests sowie in die Statistik von

Zählprozessen wie z.B. die Methode der Martingalschätzer sowie die Martingalmethode für Anpassungstests. Themen der asymptotischen Entscheidungstheorie

überschreiten jedoch den Rahmen dieser Einführung.

Diese Darstellung dient insbesondere dem Ziel, in die Vielfachheit und Breite

statistischer Fragestellungen einzuführen, wie etwa in das Problem der sequentiellen Statistik, mit einer möglichst geringen Anzahl von Beobachtungen effiziente

Entscheidungen zu treffen oder in das Problem der robusten Statistik trotz nur approximativ zutreffender Modelle zuverlässige Entscheidungen zu konstruieren. Die

Statistik von Zählprozessen ist eine methodisch wichtige Erweiterung der Statistik,

mit bedeutsamen Anwendungen z.B. in der Survival-Analyse oder allgemeiner für

die Statistik von zeitabhängigen Ereignissen.

Behandelt werden im Text parametrische und nichtparametrische Modelle.

Es werden auch einige neuere Anwendungen der Statistik angesprochen, wie z.B.

auf Bildverarbeitung und Bildrekonstruktion oder auf das Quantile hedging in der

Finanzmathematik.

Ein zentrales Ziel dieses Textbuches ist es zu zeigen, dass die Mathematische

Statistik ein Gebiet mit vielen besonders schönen Ideen und Methoden und überraschenden Resultaten ist. Es ist reizvoll zu sehen, wie die Auswahl statistischer

Verfahren schon viel über das zugrunde liegende Modell verrät. Dieses knüpft an

die Begründung des Normalverteilungsmodells mit der Optimalität des arithmetischen Mittels durch Gauß und Laplace an. Die Charakterisierung von Modellen

durch Eigenschaften statistischer Verfahren ist zentrales Thema des anspruchsvollen Buches von Kagan, Linnik und Rao (1973). Überraschend ist z.B. die von Stein

entdeckte Nichtzulässigkeit des arithmetischen Mittels im Normalverteilungsmodell

in Dimension d ≥ 3. Verbesserungen lassen sich mit Hilfe von superharmonischen

Funktionen konstruieren.

Ziel ist es auch besonders, der zunehmenden Spezialisierung in der Statistik entgegenzuwirken und eine breite Orientierung über unterschiedliche Gebiete

und Themenkreise der Statistik zu geben. Wie zuverlässig sind datenanalytische

Methoden, wann können die Daten für sich sprechen, was ist die Bedeutung von

p-Werten, wie lassen sich Abweichungen vom Modell in die statistische Analyse

einbeziehen? Auch mit diesen und ähnlichen für die Anwendungen bedeutsamen

Fragen soll sich dieser Text befassen.

Der vorliegende Kurs baut auf grundlegenden Kenntnissen der Maß- und

Wahrscheinlichkeitstheorie auf. Verwendete Methoden und Resultate der Funktionalanalysis, der Spieltheorie, über analytische Funktionen und lokal kompakte

Vorwort

vii

Gruppen werden im Text vorgestellt. Etwa ab dem 5.ten Studiensemester können

diese Themen sowohl in Bachelor- und Master- als auch in Staatsexamensstudiengängen mit Gewinn vermittelt werden. An den Kurs lassen sich sehr gut Spezialvorlesungen z.B. über asymptotische Statistik, Regressionsanalyse, Statistik von

Prozessen, Bayessche Statistik oder Survival-Analyse anschließen.

Das Buch enthält mehr Stoff, als in einer vierstündigen Vorlesung behandelt

werden kann. Neben den klassischen Themen einer Statistik-Vorlesung enthält es

eine Reihe von weiterführenden Darstellungen und Entwicklungen. Insbesondere

sind die Themengebiete aus den Kapiteln 9–13 nicht Standardthemen. Die zentralen Begriffe und Methoden aus den Kapiteln 1–5 sowie 7.1 und 8.1 lassen sich jedoch

einfach für eine Vorlesung herausfiltern und werden im Eingang der Kapitel herausgestellt. Die weiterführenden Themen und Beispielklassen können dann Anlass

für abschließende Anmerkungen oder Anregungen zum Selbststudium sein. Einige

exemplarische Beispielklassen werden recht ausführlich behandelt und können in

einem Vorlesungskurs stark gekürzt oder ausgelassen werden. Beispiele hierfür sind

etwa die Behandlung von Gibbs-Maßen und Bildrekonstruktion in Kapitel 3.3, die

detaillierte Darstellung verschiedener Schätzklassen in den Kapiteln 5.2–5.5 ebenso

wie in 6.5 und 8.4. Aus den weiterführenden Kapiteln 9–13 lassen sich je nach der

Vorgeschichte des Kurses vielleicht ein oder zwei Themen auswählen.

Von besonderer Bedeutung für den Autor dieses Bandes waren die klassischen Darstellungen von Ferguson (1967) zur statistischen Entscheidungstheorie,

von Lehmann (1959, 1983) zur Testtheorie und Schätztheorie, von Zacks (1971)

zu Entscheidungstheorie und zu Bayes-Verfahren und von Witting (1966) zur optimierungstheoretischen Behandlung von Testproblemen. Dieses frühe Werk sowie

die stark erweiterte Fassung von 1985 sind das wohl einflussreichste statistische

Lehrbuch im deutschsprachigen Raum. Hermann Witting verdankt der Autor dieses Bandes seine Einführung in die Mathematische Statistik sowie sein Interesse an

diesem Gebiet. Bedeutsam für den Autor waren auch die mathematische Theorie

der Experimente von Heyer (1973) sowie die mathematisch besonders interessante

Behandlung von Charakterisierungsproblemen in Kagan, Linnik und Rao (1973).

Von besonderem Interesse waren auch die weiterführenden und orientierenden Darstellungen der (asymptotischen) statistischen Entscheidungstheorie in Pfanzagl und

Wefelmeyer (1982) und Strasser (1985) sowie die Darstellung der asymptotischen

Statistik in Witting und Müller-Funk (1995) und Liese und Miescke (2008). Die

letztgenannten Werke gehen jedoch weit über den Rahmen dieses Buches hinaus.

Die Darstellung der asymptotischen Statistik in Rüschendorf (1988) schließt thematisch eng an diesen Text an.

Eine erste Ausarbeitung von Teilen dieses Vorlesungstextes wurde 1998 und

2004 von Christian Lauer erstellt. Ihm sei hiermit herzlich gedankt. Besonderen

Dank schulde ich auch Monika Hattenbach für ihre vorzügliche Arbeit am Erstellen

und Gestalten des nahezu kompletten Textes. Danken möchte ich auch Janine

Kühn, Viktor Wolf und Swen Kiesel für das Korrekturlesen einiger Buchkapitel

sowie Hans Rudolf Lerche für eine Reihe wertvoller Hinweise, insbesondere zum

Kapitel über sequentielle Tests.

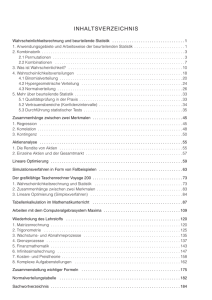

Inhaltsverzeichnis

1

Einführung: Datenanalyse und mathematische Statistik

1.1 Regressionsanalyse . . . . . . . . . . . . . . . . . . . . . . .

1.1.1 Lineare Regression . . . . . . . . . . . . . . . . . . .

1.1.2 Nichtlineare Abhängigkeit . . . . . . . . . . . . . . .

1.1.3 Lineare Modelle . . . . . . . . . . . . . . . . . . . . .

1.1.4 Nichtparametrische Regression . . . . . . . . . . . .

1.2 Mathematische Statistik – Entscheidung unter Unsicherheit

1.2.1 Ein Auswahlproblem . . . . . . . . . . . . . . . . . .

1.2.2 Zufällige Folgen . . . . . . . . . . . . . . . . . . . . .

1.2.3 Bildverarbeitung und Bilderkennung . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

. 2

. 2

. 5

. 6

. 7

. 8

. 8

. 10

. 13

2

Statistische Entscheidungstheorie

17

2.1 Statistisches Entscheidungsproblem . . . . . . . . . . . . . . . . . . 17

2.2 Entscheidungskriterien, Bayes- und Minimax-Verfahren . . . . . . 29

2.3 Anwendungen auf Schätzer, Tests und Konfidenzbereiche . . . . . 40

3

Verteilungsklassen – statistische Modelle

57

3.1 Dominierte Verteilungsklassen . . . . . . . . . . . . . . . . . . . . . 57

3.2 Exponentialfamilien . . . . . . . . . . . . . . . . . . . . . . . . . . 67

3.3 Gibbs-Maße, Bildrekonstruktion und Simulated Annealing . . . . . 72

4

Suffizienz, Vollständigkeit und Verteilungsfreiheit

81

4.1 Suffiziente σ-Algebren und Statistiken . . . . . . . . . . . . . . . . 81

4.2 Minimalsuffizienz, Vollständigkeit und Verteilungsfreiheit . . . . . 101

4.3 Anwendungen in der nichtparametrischen Statistik . . . . . . . . . 114

5

Schätztheorie

123

5.1 Erwartungstreue Schätzer . . . . . . . . . . . . . . . . . . . . . . . 124

5.2 Struktur gleichmäßig minimaler Schätzer . . . . . . . . . . . . . . 141

x

Inhaltsverzeichnis

5.3

5.4

5.5

6

Unverfälschte Schätzer und konvexe Verlustfunktionen . . . . . .

5.3.1 Erwartungstreue Schätzer bei konvexer Verlustfunktion .

5.3.2 Unverfälschte Schätzer . . . . . . . . . . . . . . . . . . . .

Fisher-Information, Cramér-Rao-Schranken und Maximum-Likelihood-Schätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Momentenmethode und Methode der kleinsten Quadrate . . . . .

5.5.1 Die Momentenmethode . . . . . . . . . . . . . . . . . . .

5.5.2 Methode der kleinsten Quadrate . . . . . . . . . . . . . .

Testtheorie

6.1 Existenz optimaler Tests . . . . . . . . . . . . . . . . . . .

6.2 Konstruktion optimaler Tests (Neyman-Pearson-Theorie)

6.3 Zusammengesetzte Hypothesen . . . . . . . . . . . . . . .

6.4 Unverfälschte, ähnliche und bedingte Tests . . . . . . . .

6.5 Unverfälschte Tests in Linearen Modellen . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. 148

. 148

. 151

.

.

.

.

156

170

171

173

181

. 182

. 189

. 197

. 214

. 224

7

Konfidenzbereiche

229

7.1 (Approximative) Konfidenzbereiche und Pivotstatistiken . . . . . . 230

7.2 Konfidenzbereiche und Tests . . . . . . . . . . . . . . . . . . . . . 240

8

Invarianz und Äquivarianz

8.1 Äquivariante Schätzer in Lokations- und

8.2 Invariante Testprobleme . . . . . . . . .

8.3 Der Satz von Hunt und Stein . . . . . .

8.4 Invariante Tests in Linearen Modellen .

9

Skalenfamilien

. . . . . . . . .

. . . . . . . . .

. . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Robuste Tests

9.1 Ungünstigste Paare und Kapazitäten . . . . . . . . . . . . . . . .

9.2 Umgebungsmodelle und robuste Tests . . . . . . . . . . . . . . .

9.3 Robuste Tests gegen Abhängigkeit . . . . . . . . . . . . . . . . .

10 Sequentielle Tests

.

.

.

.

249

250

267

276

283

297

. 298

. 308

. 314

317

11 Einführung in die asymptotische Statistik

337

11.1 Auswahl statistischer Verfahren . . . . . . . . . . . . . . . . . . . . 338

11.2 Dichteschätzung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 345

12 Statistik für Zählprozesse und Martingalmethode

357

12.1 Zählprozesse auf R+ . . . . . . . . . . . . . . . . . . . . . . . . . . 358

12.2 Martingalschätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . 361

Inhaltsverzeichnis

xi

12.3 Konsistenz und asymptotische Normalität von Martingalschätzern 369

12.4 Verteilungsfreie Teststatistiken für Anpassungstests . . . . . . . . . 375

13 Quantile hedging

A

383

Anhang

391

A.1 Bedingte Erwartungswerte und bedingte Verteilungen . . . . . . . 391

A.2 Ergodensätze . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 397

A.3 Spieltheoretische Grundlagen . . . . . . . . . . . . . . . . . . . . . 398

Literaturverzeichnis

410

Sachverzeichnis

417

Kapitel 1

Einführung: Datenanalyse

und mathematische Statistik

Die explorative Datenanalyse (EDA) ist ein Teilgebiet der Statistik. Sie verfolgt die Aufgabe, in vorhandenen Daten Strukturen zu erkennen, Hypothesen über

Ursache und Grund der Daten zu bilden und Grundlagen für eingehendere statistische Modellbildung zu liefern. John W. Tukey hatte in den 1970er Jahren diese

Bedeutung der EDA als Kritik und Ergänzung zur (mathematischen) Statistik,

in der ein zu großes Gewicht auf das Auswerten und Testen von gegebenen Hypothesen gelegt wird, hervorgehoben. So ist neben den traditionellen statistischen

Analysen ein kreativer Impuls gesetzt worden, der mit dem Schlagwort Let the data

speak for themselves einen Anspruch auf eine bedeutsame und bisher vernachlässigte Aufgabe der Statistik erhob.

Mit der Entwicklung von geeigneten Softwarepaketen ist dieser Teil der

Statistik in vielen Anwendungsbereichen in den Vordergrund gerückt. Datenanalytische Verfahren wie z.B. Boxplots, Histogramme, QQ-Plots, Scatterplots und

Projection Pursuit sind zum Standard bei Anwendungen geworden und gehören

auch zum Repertoire des verwandten Data-Mining. Dessen Hauptaufgabenstellung und Ziel ist es, unter Verwendung von Verfahren der multivariaten Statistik neue Muster in großen Datenmengen zu entdecken. Der Fokus des machine

learning ist dagegen eher auf dem Entdecken bekannter Muster in vorhandenen

Datenmengen, z.B. dem Auffinden von Personenbildern im Internet.

Typische Aufgabenstellungen sind die Erkennung von Ausreißern in Datenmengen, die Gruppierung von Objekten nach Ähnlichkeiten (Clusteranalyse), die

Einteilung oder Einordnung in Klassen (Klassifikation), die Identifikation von

Zusammenhängen in Daten (Assoziationsanalyse) und spezifischer die Beschreibung von funktionalen Zusammenhängen in Datenmengen (Regressionsanalyse).

Allgemeines Ziel dieser Verfahren ist es, eine Reduktion der Datenmenge auf eine

kompaktere Beschreibung ohne wesentlichen Informationsverlust vorzunehmen. Die

oben genannten Verfahren können sowohl einen diagnostischen Charakter als auch

einen prognostischen Charakter tragen.

L. Rüschendorf, Mathematische Statistik, Springer-Lehrbuch Masterclass,

DOI 10.1007/978-3-642-41997-3_1, © Springer-Verlag Berlin Heidelberg 2014

2

1 Einführung: Datenanalyse und mathematische Statistik

Die mathematische Statistik basiert dagegen wesentlich auf der Modellierung eines Experimentes, einer Datenmenge durch ein statistisches Modell

(X, A, {Pϑ ; ϑ ∈ Θ}). Kernaufgaben sind die Modellwahl und Modellevaluation und

die begründete Konstruktion und Bewertung von statistischen Verfahren für Hypothesen über das Experiment. Standardaufgaben sind Test- und Schätzprobleme

sowie Konfidenzintervalle und Klassifikationsverfahren. Die besondere Qualität der

mathematischen Statistik besteht in der quantitativen Evaluation der angewendeten statistischen Verfahren. Diese ist nur möglich auf Grund des statistischen

Modells, das die Daten beschreibt. Sie ist auch nur so präzise möglich, wie es die

Modellbeschreibung des Experiments ist. Für viele grundlegende Aufgaben, z.B.

Medikamententests sind präzise Modellbeschreibungen vorhanden und ermöglichen

daher abgesicherte statistische Analysen. In komplexen Datensituationen, z.B. bei

Finanzdaten oder räumlichen Datenmustern, können auch intrinsische Verfahren

zur Abschätzung der Qualität einer Prognose oder eines Verfahrens der statistischen

Datenanalyse wie z.B. Bootstrapsimulationen verwendet werden. Eine zuverlässige

Einschätzung dieser Verfahren ist jedoch nur basierend auf Modellen möglich.

In allgemeiner Form besteht die Aufgabe der mathematischen Statistik darin, begründete Entscheidungen in Situationen unter Unsicherheit zu treffen. Dieser

Aspekt spiegelt sich in dem engen Zusammenhang der mathematischen Statistik

mit der statistischen Entscheidungstheorie und insbesondere mit der Spieltheorie. Für ein grundlegendes Verständnis statistischer Fragestellungen sind diese

Verbindungen fruchtbringend und machen auch einen Teil des Reizes der mathematischen Statistik aus.

1.1

Regressionsanalyse

Als Beispiel für ein datenanalytisches Verfahren behandeln wir in diesem Abschnitt

verschiedene Varianten von Regressionsverfahren.

1.1.1

Lineare Regression

Seien (x1 , y1 ), . . . , (xn , yn ) zweidimensionale Daten. Eine Regressionsgerade y =

bx + a beschreibt eine lineare Abhängigkeit der Messvariable y von der Einflussvariablen x, z.B. eine zeitliche Abhängigkeit.

Die Methode der kleinsten Quadrate bestimmt die Regressionsgerade

als Lösung des Minimierungsproblems:

S(a, b) :=

(yi − a − bxi )2 = min!

(1.1)

i=1

Mit der notwendigen Bedingung

n

∂S

= −2

(yi − a − bxi ) = 0

∂a

i=1

1.1 Regressionsanalyse

3

y = bx + a

y

a

x

Abbildung 1.1 Regressionsgerade

ergibt sich a = y n − bxn mit xn =

1

n

n

i=1

xi , yn =

1

n

n

i=1

yi . Weiter folgt aus

∂S

= −2

(yi − a − bxi )xi = 0

∂b

i=1

n

b

n

x2i =

i=1

n

xi yi − a

i=1

n

xi .

i=1

Einsetzen von a ergibt dann die Regressionsgerade:

n

i=1 xi yi − nxn y n

, a = y n − bxn .

y=

a + bx mit b = n

2

2

i=1 xi − nxn

Der Regressionskoeffizient b hat die alternative Darstellung

b = sx,y

s2x

(1.2)

(1.3)

mit der Stichprobenkovarianz

1 (xi − xn )(yi − y n )

n − 1 i=1

n

sx,y =

und der Stichprobenvarianz

1 (xi − xn )2 .

n − 1 i=1

n

s2x = sxx =

s

Die normierte Größe rx,y := sxx,y

sy heißt empirischer Korrelationskoeffizient.

Nach der Cauchy-Schwarz-Ungleichung gilt

−1 ≤ rx,y ≤ 1.

(1.4)

Ist rx,y ≈ 0 so sind die Daten annähernd linear unabhängig. Ist rx,y > 0 so ist

s

die Steigung b = rx,y sxy der Regressionsgeraden y = a + bx positiv, d.h. die Daten sind positiv linear abhängig; ist rx,y < 0, dann negativ linear abhängig. Für

4

1 Einführung: Datenanalyse und mathematische Statistik

rx,y ≈ 1 oder −1 konzentrieren sich die Daten stark in der Nähe der Regressionsgeraden. Die Regressionsgerade liefert dann eine recht präzise Beschreibung der

Datenmengen.

Ein Problem der Methode der kleinsten Quadrate zeigt die folgende Abbildung 1.2. Die Regressionsgerade ist nicht stabil. Ein einziger Ausreißerpunkt kann

die Lage der Regressionsgerade stark verändern.

Abbildung 1.2 Regressionsgerade − − − mit Zusatzpunkt ∗ im Vergleich zur

Regressionsgerade ohne Zusatzpunkt

Eine gegen Ausreißer stabile Version der Regressionsgerade wurde von Tukey

eingeführt. Dazu werden die x-Werte gleichmäßig in drei Gruppe (kleine, mittlere,

große) eingeteilt.

n

3l

3l + 1

3l + 2

kleine

l

l

l+1

mittlere

l

l+1

l

große

l

l

l+1

Bilde nun die Mediane x

L , x

M , x

R der x-Werte dieser Gruppen und yL ,

−

yL

yM , yR der y-Werte dieser Gruppen. Sei bT = xyR

xL der Anstieg der Geraden

R −

durch (

xL , yL ), (

xR , yR ) mit Achsenabschnitt aL = aR . Sei schließlich aM der

Achsenabschnitt der hierzu parallelen Gerade durch (

xM , yM ). Mit aT := 13 (aL +

aM + aR ) heißt dann

y = aT + b T x

(1.5)

Tukey-Gerade der Daten (x1 , y1 ), . . . , (xn , yn ). Für das Beispiel aus Abbildung

1.2 mit Ausreißerpunkt ∗ bleibt die Tukey-Gerade stabil (vgl. Abbildungen 1.3 und

1.4).

Die Abweichungen

ri = yi − a − bxi

(1.6)

1.1 Regressionsanalyse

5

Abbildung 1.3 Tukey-Gerade − − − im

Vergleich zur Regressionsgeraden

ohne Zusatzpunkt

Abbildung 1.4 Tukey-Gerade − − − mit

Zusatzpunkt ∗ im Vergleich zur

Tukey-Geraden ohne Zusatzpunkt

der Variable yi von den Werten der Regressionsgeraden heißen Residuen. Ist die

Datenmenge gut durch eine lineare Regression darstellbar, dann sollten die Residuen unsystematisch um Null variieren. Das folgende Bild der Residuen würde

deutlich gegen eine lineare Regression sprechen:

Residuen

Abbildung 1.5 Residuen

1.1.2

Nichtlineare Abhängigkeit

Sei y = f (a, b, c, x) eine nichtlineare Funktion einer Einflussvariablen x mit drei

Parametern a, b, c. Bei quadratischer Abhängigkeit ist z.B. y = a + bx + cx2 .

Die Regressionsfunktion f wird wieder nach der Methode der kleinsten Quadrate angepasst.

F (a, b, c) :=

n

(yi − f (a, b, c, xi ))2 = min!

a,b,c

i=1

(1.7)

Die zugehörigen kleinste Quadrategleichungen lauten dann

∂F

= 0,

∂a

∂F

= 0,

∂b

∂F

=0

∂c

(1.8)

6

1 Einführung: Datenanalyse und mathematische Statistik

und liefern Kandidaten a, b, c für die Lösung von (1.7) wie im Fall der linearen

Regression.

y = f (

a, b, c, x) heißt dann (nichtlineare) Regressionsfunktion für die

Daten (x1 , y1 , ), . . . , (xn , yn ).

y

x

Abbildung 1.6 quadratische Regression

1.1.3

Lineare Modelle

Liegen multivariate Einflussgrößen x = (x1 , . . . , xm ) ∈ Rm und multivariate Beobachtungsgrößen y = (y1 , . . . , yk ) ∈ Rk vor, dann heißt

y = b + Ax

(1.9)

ein lineares Modell mit der Designmatrix A = (aij ) ∈ Rk×m und b = (b1 , . . . , bk )

∈ Rk , d.h. es gilt

m

yi =

aij xj + bi , 1 ≤ i ≤ k.

(1.10)

j=1

Bei gegebenen Daten (y i , xi ), 1 ≤ i ≤ n lautet die Methode kleinster

Quadrate

n

F (A, b) :=

y i − (Axi + b)2 = min!

(1.11)

i=1

A,b

b dieser Gleichungen lassen sich explizit angeben (vgl. AbDie Lösungen A,

schnitt 8.4 über Gauß-Markov-Schätzer) und bestimmen die multivariate Regressionsgerade

+ b.

y = Ax

(1.12)

Einige Klassen nichtlinearer

Regressionsgeraden wie in Abschnitt 1.1.2 z.B.

Regressionen der Form y =

ai fi (x) + b lassen sich als Spezialfall des linearen

Modells (1.9) einordnen, indem als neue Einflussvariable zi = fi (x) gewählt werden.

1.1 Regressionsanalyse

1.1.4

7

Nichtparametrische Regression

Gesucht wird ein funktionaler Zusammenhang y = f (x) zwischen der Einflussvariablen x und der Beobachtungsvariablen y. Im Unterschied zu Abschnitt 1.1.2 ist f

jedoch nicht nur bis auf einige Parameter a, b, c, . . . bestimmt sondern gänzlich bis

auf evtl. qualitative Eigenschaften unbekannt. Ein vielfach verwendetes Verfahren

zur Bestimmung einer Regressionsfunktion f bei gegebener Datenmenge (xi , yi ),

1 ≤ i ≤ n, sind Kernschätzer. Sie basieren auf einem Kern k : R1 → R+ (im Falle

x ∈ R1 ) wie z.B. dem Histogramm-Kern k(y) = 12 1[−1,1] (y) oder dem Gauß1 2

kern k(y) = √12π e− 2 y . Durch einen reellen Parameter h > 0, die Bandweite,

lässt sich aus einem Kern k eine Klasse von Kernen erzeugen

1 y

.

(1.13)

kh (y) := k

h h

Damit erhalten wir nichtparametrische Regressionsschätzer

n

1

kh (x − xi )yi

.

(1.14)

f(x) = fh (x) = n1 i=1

n

i=1 kh (x − xi )

n

f(x) ist ein gewichteter Mittelwert der yi -Werte zu xi -Werten in der ‘Nähe‘

von x. Der Gewichtsfaktor kh (x − xi ) beschreibt den Einfluss der xi in der Nähe

von x. Die Nähe hängt einerseits vom Kern ab. Als gravierender stellt sich aber der

Einfluss der Bandweite h heraus. Für kleine Bandweiten h (h ↓ 0) wird nur über

kleine Umgebungen von x gemittelt, der Regressionsschätzer f(x) wird irregulärer

und passt sich mehr den Daten an, für große Bandweiten h wird f(x) glatter und

gibt eine ‘weitsichtigere‘ Interpolation der Daten (vgl. Abbildung 1.7).

Abbildung 1.7 Regressionsschätzer mit Bandweiten h = 0, 25 (· · · ), h = 0, 5 (− − −) und

h = 1 (—).

Für zu kleine Bandweiten h ist der Bias gering aber die Varianz von f(x) groß

und daher die Prognosefähigkeit von f in Frage gestellt, für zu große Bandweiten h

8

1 Einführung: Datenanalyse und mathematische Statistik

ist die Lage umgekehrt. Dieses ist das berühmte Bias-Varianz-Dilemma. Es lässt

sich am besten in einem stochastischen Modell für die Daten (xi , yi ) beschreiben.

Dann ist der Schätzfehler gegeben durch E(f(x)−f (x))2 . Dieser lässt sich in einem

Bias-Term und einen Varianz-Term zerlegen

E(f(x) − f (x))2 = E(f(x) − E f(x))2 + (E f(x) − f (x))2 .

(1.15)

Unter sehr allgemeinen Bedingungen an das stochastische Modell gilt für

n → ∞ und h = h(n) → 0, so dass n · h → ∞

E fh (x) −→ f (x),

h→0

(1.16)

d.h. der Bias-Term (E fh (x) − f (x))2 ist klein für (nicht zu) kleines h, aber der

Varianzterm E(fh (x) − E f(x))2 ist groß für kleines h. Umgekehrt ist für ‘große‘

Bandweite h der Varianzterm klein, dafür aber der Bias-Fehler groß.

Ein wichtiges Problem bei der Anwendung von nichtparametrischen Regressionsschätzern ist daher die Wahl einer geeigneten Bandweite h.

1.2

Mathematische Statistik –

Entscheidung unter Unsicherheit

Zentrale Aufgabe der mathematischen Statistik ist es, geeignete statistische Modelle

für ein Experiment zu konstruieren und zu evaluieren und basierend auf diesen

Modellen geeignete statistische Verfahren zu konstruieren und zu bewerten. Ziel

dieser Verfahren ist es, Entscheidungen unter Unsicherheit zu treffen und deren

Risiko zu beschreiben. Im Folgenden behandeln wir einige Beispiele, um die Vielfalt

dieser Fragestellung aufzuzeigen.

1.2.1

Ein Auswahlproblem

Zwei Zettel tragen die Zahlen x bzw. y und werden vermischt. Einem ‘Spieler‘

dem die Zahlen x und y nicht bekannt sind, wird ein Zettel (zufällig ausgewählt)

angeboten. Er kann den nun zufälligen Inhalt X dieses Zettels, P (X = x) = P (X =

y) = 12 , akzeptieren oder zu dem Angebot Y des anderen Zettels wechseln und muss

dann diesen akzeptieren. Sein Ziel ist es, mit möglichst großer Wahrscheinlichkeit

eine Entscheidung für die größere der beiden Zahlen zu treffen.

Eine natürliche Frage ist es, ob der Spieler eine Entscheidungsregel finden

kann, die ihm mit größerer Wahrscheinlichkeit als 12 , also bei zufälliger Auswahl,

basierend auf der Kenntnis von X den größeren Gewinn sichert.

Die Unsicherheit in diesem Entscheidungsproblem wird durch das statistische

Modell {Px,y ; x, y ∈ R, x = y} beschrieben mit Px,y ({X = x}) = Px,y ({X = y}) =

1

2 und Px,y ({Y = y | X = x}) = Px,y ({Y = x | X = y}) = 1. Es gilt auch

Px,y ({Y = x}) = Px,y ({Y = y}) = 12 .

1.2 Mathematische Statistik – Entscheidung unter Unsicherheit

9

Gibt es ein Entscheidungsverfahren d : R → {0, 1} mit d(X) = 0 Entscheidung für X, d(X) = 1 Entscheidung für Y , so dass die Erfolgswahrscheinlichkeit

Ed größer als 12 ist:

Ed = P (d(X) = 0, X > Y ) + P (d(X) = 1, X < Y )

1

> .

2

(1.17)

Es ist überraschend, dass die Antwort auf diese Frage positiv ist. Eine Lösung

basiert auf einem randomisierten Entscheidungsverfahren. Sei Z eine Zufallsvariable mit positiver Dichte f > 0 auf R, stochastisch unabhängig von X, Y ; z.B. sei

Z normalverteilt, Z ∼ N (μ, 1). Wir nennen Z eine ‘Splitvariable‘ und definieren

die Entscheidungsregel

1, x ≤ Z,

d(x) =

(1.18)

0, x > Z.

Dann gilt

Ed = P (d(X) = 1{Y ≥X} )

= P (X ≥ Z, X ≥ Y ) + P (X < Y, X < Z)

1

= (P (X, Y < Z) + P (X, Y ≥ Z)) + P (X < Z ≤ Y ) + P (Y < Z ≤ X)

2

1 1

= + (P (X < Z ≤ Y ) + P (Y < Z ≤ X)).

(1.19)

2 2

Es ist also

Ed −

1

1

= P (Z ist ein Split von X, Y ) > 0,

2

2

(1.20)

da Z eine überall positive Dichte hat. Für jede Splitstrategie ist also die Erfolgswahrscheinlichkeit größer als 12 . Hat man keine weiteren Informationen, so gibt es

keine Möglichkeit einen ‘guten‘ oder ‘optimalen‘ Split auszuwählen.

Hat man zusätzliche Informationen über die Verteilung von (X, Y ), so lässt

sich ein guter Split konstruieren und die Erfolgswahrscheinlichkeit vergrößern. Ist

der bedingte Median mx = med(Y | X = x) bekannt, dann ist Z = mX = med(Y |

X) ein optimaler Split. Es gilt für eine Entscheidungsregel d

Ed = P (d(X) = 1(Y ≥X) )

= P (d(X) = 1, Y ≥ X) + P (d(X) = 0, Y < X)

= (d(X)1(Y ≥X) + (1 − d(X))1(Y <X) dP

=

d(X)(1(Y ≥X) − 1(Y <X) )dP + P (Y < X)

=

d(x)(P (Y ≥ x | X = x) − P (Y < x | X = x))dP X (x) + P (Y < X).(1.21)

10

1 Einführung: Datenanalyse und mathematische Statistik

Es gilt:

P (Y ≥ x | X = x) − P (Y < x | X = x)

ist ≥ 0 wenn x ≤ mx und ≤ 0 wenn x > mx .

Daraus folgt, dass

1, für x ≤ mx ,

∗

d (x) =

0, für x > mx ,

(1.22)

eine optimale Entscheidungsfunktion ist, d.h. die Erfolgswahrscheinlichkeit

Ed∗ ist maximal.

Sind X, Y stochastisch unabhängig, ist P X = P Y = Q stetig und c = mX =

med(Q), dann gilt

3

Ed∗ = .

(1.23)

4

Mit Wahrscheinlichkeit 34 lässt sich die größere Zahl finden. Der Median Z =

med(Q) ist eine optimale Split-Variable. In der in diesem Beispiel vorliegenden

Entscheidungssituation unter Unsicherheit ist es möglich eine ‘optimale‘ Entscheidung zu treffen und Erfolgs-/Misserfolgswahrscheinlichkeit genau zu quantifizieren.

1.2.2

Zufällige Folgen

a) Musterverteilungen

Gegeben sei eine 0-1-Folge x1 , . . . , xn . Gesucht ist eine Entscheidungsverfahren um

festzustellen, ob die Folge zufällig erzeugt ist, d.h. die Realisierung eines Bernoulliexperiments P = ⊗ni=1 B(1, 12 ) ist. Die Idee eines solchen Testverfahrens ist es, zu

prüfen, ob geeignete Muster in x1 , . . . , xn in der Häufigkeit vorhanden ist, die man

in einer Bernoullifolge erwarten würde.

Bezeichne etwa Rn die Anzahl der Runs in der 0-1-Folge x1 , . . . , xn , d.h.

die Anzahl der Wechsel von 0- und 1-Sequenzen. Z.B. hat die Folge 1100010000110

eine Anzahl von 6 Runs. Die maximale Runlänge Mn ist 4. Ein geeigneter Test

zur Überprüfung der Hypothese, dass x1 , . . . , xn Realisierungen eines Bernoulliexperimentes sind ist es, die beobachteten Runzahlen rn und mn mit den Verteilungen

von Rn , Mn im Bernoulli-Fall zu vergleichen.

Wir betrachten z.B. die folgenden 0-1-Folgen x, y der Länge n = 36. Welche

der beiden Folgen ist zufällig erzeugt? Eine von ihnen stammt aus einem echten

Zufallsgenerator, die andere Folge ist z.B. eine ‘ausgedachte Zufallsfolge‘.

x = 111001100010010101000001001100001110

y = 101011010011000101100110010110101011

Um die zufällige Folge zu identifizieren bestimmen wir die maximalen Runlängen und die Anzahl der Runs, Mn (x) = 5, Rn (x) = 18, Mn (y) = 3, Rn (y) = 25.

Wir vergleichen diese mit der Verteilung von Rn , Mn unter der Hypothese. Die Verteilung der maximalen Runlänge Mn (vgl. Abbildung 1.8) und der Anzahl der Runs