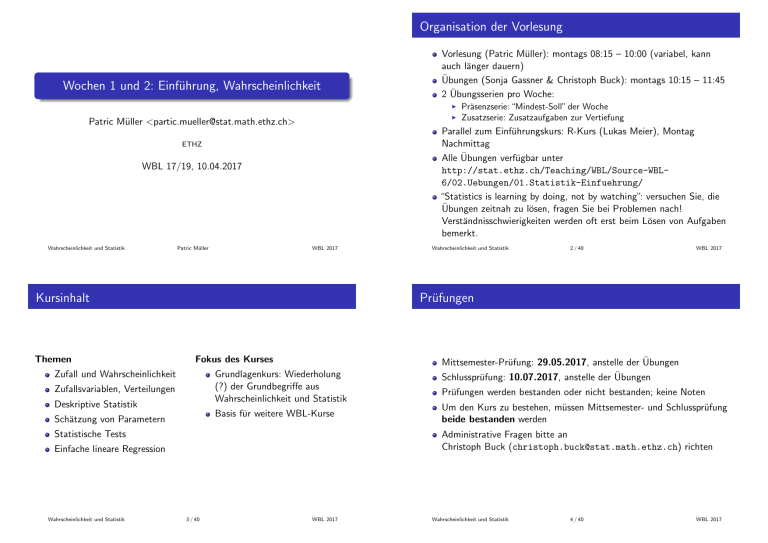

Wochen 1 und 2: Einführung, Wahrscheinlichkeit

Werbung

Organisation der Vorlesung Wochen 1 und 2: Einführung, Wahrscheinlichkeit Vorlesung (Patric Müller): montags 08:15 – 10:00 (variabel, kann auch länger dauern) Übungen (Sonja Gassner & Christoph Buck): montags 10:15 – 11:45 2 Übungsserien pro Woche: I I Patric Müller <[email protected]> Parallel zum Einführungskurs: R-Kurs (Lukas Meier), Montag Nachmittag Alle Übungen verfügbar unter http://stat.ethz.ch/Teaching/WBL/Source-WBL6/02.Uebungen/01.Statistik-Einfuehrung/ “Statistics is learning by doing, not by watching”: versuchen Sie, die Übungen zeitnah zu lösen, fragen Sie bei Problemen nach! Verständnisschwierigkeiten werden oft erst beim Lösen von Aufgaben bemerkt. ETHZ WBL 17/19, 10.04.2017 Wahrscheinlichkeit und Statistik Patric Müller WBL 2017 Kursinhalt Themen Wahrscheinlichkeit und Statistik 2 / 40 WBL 2017 Prüfungen Fokus des Kurses Zufall und Wahrscheinlichkeit Mittsemester-Prüfung: 29.05.2017, anstelle der Übungen Grundlagenkurs: Wiederholung (?) der Grundbegriffe aus Wahrscheinlichkeit und Statistik Zufallsvariablen, Verteilungen Deskriptive Statistik Basis für weitere WBL-Kurse Schätzung von Parametern Statistische Tests Schlussprüfung: 10.07.2017, anstelle der Übungen Prüfungen werden bestanden oder nicht bestanden; keine Noten Um den Kurs zu bestehen, müssen Mittsemester- und Schlussprüfung beide bestanden werden Administrative Fragen bitte an Christoph Buck ([email protected]) richten Einfache lineare Regression Wahrscheinlichkeit und Statistik Präsenzserie: “Mindest-Soll” der Woche Zusatzserie: Zusatzaufgaben zur Vertiefung 3 / 40 WBL 2017 Wahrscheinlichkeit und Statistik 4 / 40 WBL 2017 Literatur Teil I Vorlesungsskript: wird von den Autoren für ihre jeweilige Einführungsvorlesung verwendet. Deckt alle im Kurs behandelten Themen ab. Einführung Werner Stahel: Statistische Datenanalyse, Vieweg und Sohn, 2012 Wahrscheinlichkeit und Statistik 5 / 40 WBL 2017 Statistische Probleme: Beispiele Wahrscheinlichkeit und Statistik 6 / 40 WBL 2017 Beispiel 1: Vererbung in Erbsenpflanzen Experimente Gregor Mendels (1822 – 1884): Züchtung reinerbiger Erbsenpflanzen mit nur runden oder kantigen Samen (Erbsen) Zum Einstieg: 6 Beispiele “einfacher” statistischer Fragestellungen Repräsentativ für Inhalte dieses Einführungskurses Vorlesung basiert auf Kapitel 1 des Skripts. Quelle: Van Norman (1971) Wahrscheinlichkeit und Statistik 7 / 40 WBL 2017 Wahrscheinlichkeit und Statistik 8 / 40 WBL 2017 Beispiel 1: Vererbung in Erbsenpflanzen Beispiel 1: Vererbung in Erbsenpflanzen Genetische Erklärung: Bestäubung von Pflanzen der “Parentalgeneration” (P), die aus runden Erbsen gewachsen sind, mit Pollen solcher, die aus kantigen Erbsen gewachsen sind nur runde Erbsen (“Filialgeneration” F1 ) ein Gen steuert Erbsenform; Allel für runde Erbsen (R) ist dominant gegenüber Allel für kantige Erbsen (r) Kreuzung von Pflanzen aus F1 (“Filialgeneration” F2 ) Generation P: homozygot, Genotyp entweder RR oder rr runde und kantige Erbsen Experiment: runde und kantige Samen nach Kreuzung in F1 zählen (Quelle: http://evolpsychology.blogspot.ch/) Generation F1 : heterozygot, Genotyp Rr Generation F2 : Genotypen RR, Rr und rr im Verhältnis 1 : 2 : 1 Wahrscheinlichkeit und Statistik 9 / 40 WBL 2017 Beispiel 1: Vererbung in Erbsenpflanzen 1 45 12 3.8 2 27 8 3.4 3 24 7 3.4 4 19 10 1.9 5 32 11 2.9 6 26 6 4.3 7 88 24 3.7 8 22 10 2.2 9 28 6 4.7 10 25 7 3.6 Quelle: Stahel (2002) 11 / 40 WBL 2017 Milzbrand: tödliche Infektionskrankheit bei Paarhufern Experiment von Louis Pasteur 1881: 24 Schafe gegen Milzbrand impfen, 24 ungeimpfte Schafe als Kontrollgruppe Alle 48 Schafe mit Milzbrand infizieren Resultat: Stützen diese Zahlen Mendels Vererbungsgesetze? Sind die Zahlen bloss zufällige Abweichungen des erwarteten Verhältnisses 3 : 1? Wahrscheinlichkeit und Statistik 10 / 40 Beispiel 2: Impfung gegen Milzbrand Daten aus Mendels Experimenten: Anzahl runde und kantige Erbsen (F2 ) auf 10 Pflanzen der Generation F1 : Pflanze rund kantig Verhältnis: X : 1 Wahrscheinlichkeit und Statistik WBL 2017 Behandlung Tot Überlebt geimpft 0 24 ungeimpft 24 0 Quelle: Samuels et al. (2012) Wahrscheinlichkeit und Statistik 12 / 40 WBL 2017 Experiment mit Mäusen aus Zuchtlinie mit hoher Tumor-Inzidenz Eine Gruppe keimfrei aufgezogen, eine Gruppe Escherichia coli ausgesetzt Resultat: Behandlung Lebertumor Kein Lebertumor Anteil mit Lebertumor E. coli 8 5 62% Monoaminooxidase (MAO): Enzym, das in der Steuerung des Verhaltens eine Rolle spielt Studie: MAO-Aktivität in 42 Patienten mit unterschiedlichen Formen von Schizophrenie gemessen keimfrei 19 30 39% (Potkin et al., 1978) I Quelle: Mizutani and Mitsuoka (1979) Kann man aus diesen Zahlen schliessen, dass E. coli einen Einfluss auf die Tumorhäufigkeit hat? Wahrscheinlichkeit und Statistik 13 / 40 WBL 2017 Beispiel 5: Zeit zwischen zwei Impulsen eines Neurons MAO−Aktivität 10 15 Beispiel 4: Monoaminooxidase und Schizophrenie 5 Beispiel 3: Einfluss von Bakterien auf Tumore II Schizophrenie−Form III Sind unterschiedliche Formen der Schizophrenie mit einem unterschiedlichen Niveau der MAO-Aktivität verknüpft? Wahrscheinlichkeit und Statistik 14 / 40 WBL 2017 Beispiel 6: Verteilung von Panini-Bildern Kollege Markus K. ist leidenschaftlicher Sammler von Panini-Bildern Abbildung rechts: Verteilung der Zeitintervalle zwischen zwei Impulsen eines Neurons (Nurse, 1981) Wahl beim Kauf von Panini-Bildern: einzelne Packung (5 Bilder) oder Box (500 Bilder)? Wie könnte man die Verteilung der Intervalle zwischen Neuron-Impulsen modellieren, um sie vorherzusagen oder zu simulieren? Markus’ Vermutung: Bilder in Box nicht “zufällig” verteilt; doppelte Bilder werden bewusst vermieden. “Experiment”: Box kaufen, Bilder einkleben. Ergebnis: 477 unterschiedliche Bilder aus 661 möglichen. Ist das mit der Annahme “zufälliger” Verpackung vereinbar? Wahrscheinlichkeit und Statistik 15 / 40 WBL 2017 Wahrscheinlichkeit und Statistik 16 / 40 WBL 2017 Beispiel 6: Verteilung von Panini-Bildern Computer-Simulation: zufällige Stichprobe von 500 Elementen aus 661 erzeugen; zählen, wie viele unterschiedliche Elemente in Stichprobe sind. 250000 Teil II Wahrscheinlichkeit 150000 100000 50000 0 in einer Million Simulationen wurde ein so “extremes Resultat” wie 477 nicht-doppelte Bilder nie beobachtet! Bilder werden “ziemlich sicher” nicht “zufällig” in Boxen verteilt. Anzahl Alben 200000 Simulation eine Million mal wiederholen; Verteilung der nicht-doppelten Bilder: 300 350 400 450 500 Anzahl eingeklebter Bilder Wahrscheinlichkeit und Statistik 17 / 40 WBL 2017 Lernziele Wahrscheinlichkeit und Statistik 18 / 40 WBL 2017 Wahrscheinlichkeitstheorie Sie können. . . . . . die grundlegenden Konzepte der Wahrscheinlichkeitstheorie erläutern: Ereignis, Grundraum, (bedingte) Wahrscheinlichkeit, Unabhängigkeit. . . . den Unterschied zwischen frequentistischer und Bayes’scher Interpretation einer Wahrscheinlichkeit erläutern. . . . Venn-Diagramme zeichnen und lesen. . . . Wahrscheinlichkeitsbäume zeichnen und lesen. . . . bedingte Wahrscheinlichkeiten berechnen, z.B. mit Hilfe des Satzes von Bayes. Fast alles, was Daten generiert, ist ein Zufallsexperiment: ein “Experiment” (naturwissenschaftliches Experiment, Befragung, Aggregieren von Geschäftszahlen, etc.), dessen Ausgang nicht vollständig vorhersehbar ist “Experimente” sind zufällig, weil sie bei Wiederholung unter “gleichen Bedingungen” unterschiedlich ausgehen. Ziel der Wahrscheinlichkeitstheorie: Modellierung von Zufall und Zufallsexperimenten Vorlesungen basieren auf Kapitel 2.1 bis 2.4 im Skript. Wahrscheinlichkeit und Statistik 19 / 40 WBL 2017 Wahrscheinlichkeit und Statistik 20 / 40 WBL 2017 Zufallsexperimente Wichtige Begriffe Definition (Grundraum, Ereignis) Ein Elementarereignis ω ist ein möglicher Ausgang eines Zufallsexperiments. Der Grundraum Ω ist die Menge aller Elementarereignisse eines Zufallsexperiments. Ein Ereignis A ⊂ Ω ist eine Teilmenge des Grundraums, d.h. eine Menge gewisser Elementarereignisse. Zufallsexperiment: Experiment, dessen Ausgang nicht exakt vorhersehbar ist Gründe für Zufälligkeit: I I Inhärenter Zufall: gewisse Prozesse in Natur, Technik und Gesellschaft sind grundsätzlich nicht exakt vorhersagbar Unvollständige Kontrolle experimenteller Bedingungen Beispiel: Beim Würfeln von zwei Würfeln besteht die Grundmenge Ω aus 36 Elementarereignisse. n o Ω = (1, 1); (1, 2); (1, 3); . . . ; (6, 6) Das Ereignis A “Augensumme n ist 10” besteht aus o den drei Elementarereignissen A = (4, 6); (5, 5); (6, 4) . Das Ereignis B “Der erste Würfel ist eine 6” besteht n o aus den sechs Elementarereignissen B = (6, 1); (6, 2); . . . ; (6, 6) . Wahrscheinlichkeit und Statistik 21 / 40 WBL 2017 Verknüpfung von Ereignissen Wahrscheinlichkeit und Statistik 22 / 40 WBL 2017 Weitere Begriffe, Verknüpfungen Visualisierung von Ereignissen mit Venn-Diagrammen: Ω A Ω B A B Ereignisse A und B heissen disjunkt, falls A ∩ B = ∅. Schnittmenge A ∩ B Ω A B Vereinigung A ∪ B Komplement Ac Differenz A \ B Wahrscheinlichkeit und Statistik Satz (Regeln von de Morgan.) Für Ereignisse A und B gilt (A ∩ B)c = Ac ∪ B c and (A ∪ B)c = Ac ∩ B c . Ω A 23 / 40 B Übung: Beweisen Sie die Regeln mit Hilfe von Venn-Diagrammen! WBL 2017 Wahrscheinlichkeit und Statistik 24 / 40 WBL 2017 Wahrscheinlichkeit Interpretation von Wahrscheinlichkeiten I Definition (Wahrscheinlichkeitsmass) Sei Ω ein Grundraum. Ein Wahrscheinlichkeitsmass ist eine Funktion P, die jedem Ereignis A ⊂ Ω eine Wahrscheinlichkeit 0 ≤ P(A) ≤ 1 zuordnet mit den folgenden Eigenschaften: Frequentistische Interpretation: wenn das Experiment “häufig” wiederholt wird, tritt Ereignis A in ca. einem Anteil P(A) der Fälle auf. Bayes’sche Interpretation: P(A) ist ein Mass für den subjektiven Glauben an eine Aussage. i) 0 ≤ P(A) ≤ 1 für jedes Ereignis A ⊂ Ω ii) P(Ω) = 1 iii) P(A ∪ B) = P(A) + P(B) für disjunkte Ereignisse A und B. Wahrscheinlichkeit und Statistik 25 / 40 WBL 2017 26 / 40 WBL 2017 Diskrete Wahrscheinlichkeitsmodelle 0.8 1.0 Interpretation von Wahrscheinlichkeiten II Wahrscheinlichkeit und Statistik fn(A) 0.4 0.6 Endlicher (oder “abzählbarer”) Grundraum: Ω = {ω1 , ω2 , . . .} X P({ωi }) Wahrscheinlichkeit eines Ereignisses A ⊂ Ω: P(A) = i:ωi ∈A 0.2 Normierung: P(Ω) = X P({ωi }) = 1 0.0 i≥1 0 50 100 150 n 200 250 300 Falls Ω endlich ist, sind oft alle Elementarereignisse gleich wahrscheinlich; es gilt dann Frequentistische Interpretation: Relative Häufigkeit des Ereignisses A = “Kopf” bei n Münzwürfen Bayes’sche Interpretation speziell nützlich bei nicht-wiederholbarem Experiment: z.B. “Wahrscheinlichkeit, an einer Stelle in der Nordsee Öl zu finden”; “Wahrscheinlichkeit eines Erdbeben Magnitude ≥ 4.6 in der Zentralschweiz”. Wahrscheinlichkeit und Statistik 27 / 40 WBL 2017 P(A) = |A| “günstige” Ausgänge = |Ω| “mögliche” Ausgänge P heisst dann Laplace-Wahrscheinlichkeit Wahrscheinlichkeit und Statistik 28 / 40 WBL 2017 Bedingte Wahrscheinlichkeit Unabhängigkeit Definition (Bedingte Wahrscheinlichkeit) A und B seien Ereignisse mit P(B) > 0. Die bedingte Wahrscheinlichkeit von A gegeben B ist definiert als P(A | B) = Definition (Unabhängigkeit) P(A ∩ B) . P(B) Ereignisse A und B heissen unabhängig, falls P(A ∩ B) = P(A) · P(B). In Worte heisst P(A | B): “Man weiss, dass B eingetreten ist. Wie gross ist jetzt (gemäss dieser Information) die Wahrscheinlichkeit, dass A eintritt?” Ω A 29 / 40 WBL 2017 Rechenregeln für bedingte Wahrscheinlichkeiten Wahrscheinlichkeit und Statistik 30 / 40 WBL 2017 Bedingte Wahrscheinlichkeit und Unabhängigkeit Solange auf dasselbe Ereignis bedingt wird, gelten Rechenregeln für Wahrscheinlichkeiten auch für bedingte Wahrscheinlichkeiten: A, B: Ereignisse mit P(A) > 0, P(B) > 0 Falls A und B unabhängig sind, gilt P(A ∩ B) = P(A) · P(B) Demnach gilt bei Unabhängigkeit 0 ≤ P(A | B) ≤ 1 P(A1 ∪ A2 | B) = P(A1 | B) + P(A2 | B), falls A1 und A2 disjunkt P(Ac | B) = 1 − P(A | B) P(A | B) = P(A) und P(B | A) = P(B) In Worten: A und B sind unabhängig genau dann, wenn wir aus A nichts über B lernen können und umgekehrt. etc. Wahrscheinlichkeit und Statistik Wenn Ereignisse nicht unabhängig sind, können wir aus dem einen etwas über das andere lernen. Achtung: Unabhängig heisst nicht disjunkt! B Wahrscheinlichkeit und Statistik Unabhängigkeit von Ereignissen wird oft auf Grund technischer Überlegungen postuliert 31 / 40 WBL 2017 Wahrscheinlichkeit und Statistik 32 / 40 WBL 2017 Wahrscheinlichkeitsbäume Wahrscheinlichkeitsbaum: 3 Münzwürfe 0.5 Z3 0.5 Z2 0.5 K3 0.5 Z3 Z1 0. 5 Mehrstufiges Zufallsexperiment kann in einem Wahrscheinlichkeitsbaum dargestellt werden 0.5 K2 0.5 K3 0.5 Z 2 0.5 0.5 K1 0.5 0.5 K2 0.5 Z3 Beispiel: faire Münze dreimal werfen Wahrscheinlichkeit und Statistik 33 / 40 5 0. Ereignisse: K1 , K2 , K3 : Kopf im 1., 2., 3. Wurf; Z1 = K1c , Z2 = K2c , Z3 = K3c : Zahl im 1., 2., 3. Wurf WBL 2017 Rechnen mit Wahrscheinlichkeitsbäumen Was ist die Wahrscheinlichkeit, mindestens zweimal in Folge “Kopf” zu werfen? K3 Z3 K3 Wahrscheinlichkeit und Statistik 34 / 40 WBL 2017 Beispiel: medizinischer Test Medizinischer Test für eine seltene Krankheit 1. Pfadregel: Wahrscheinlichkeit eines Elementarereignisses = Produkt der (bedingten) Wahrscheinlichkeiten auf dessen Pfad im Baum 2. Pfadregel: Wahrscheinlichkeit eines Ereignisses = Summe der Wahrscheinlichkeiten aller Pfade (Wahrscheinlichkeiten der Elementarereignisse), die zum Ereignis gehören Bemerkung: Wahrscheinlichkeitsbäume sind besonders nützlich beim Rechnen mit abhängigen Ereignissen Wahrscheinlichkeit und Statistik 35 / 40 WBL 2017 Test scheint ziemlich präzise: erkennt Krankheit mit 95% Wahrscheinlichkeit (Sensitivität des Tests), und stellt das Fehlen der Krankheit mit 90% Wahrscheinlichkeit fest (Spezifizität des Tests). Ereignis K : Person hat Krankheit; T : Test ist positiv (d.h., zeigt Krankheit an) 1% der Bevölkerung ist von Krankheit betroffen: P(K ) = 0.01. Wie gross ist die Wahrscheinlichkeit, dass eine zufällig ausgewählte Person ein positives Testergebnis erhält? Wahrscheinlichkeit und Statistik 36 / 40 WBL 2017 Wahrscheinlichkeitsbaum Satz der totalen Wahrscheinlichkeit Satz (Satz der totalen Wahrscheinlichkeit) K 1 0.0 K 0.9 9 P(T ∩ K ) = 0.01 · 0.95 = 0.0095 K T| .95 T 0c |K 0.0 5 P(A) = P(T c T |K .1 T c0 |Kc 0.9 P(T ) = P(T |K )P(K ) + ∩ K ) = 0.01 · 0.05 = 5e − 04 k X P(A ∩ Bi ) = i=1 P(T ∩ K c ) = 0.99 · 0.1 = 0.099 c c B1 , B2 , . . . , Bk seien disjunkte Ereignisse mit B1 , B2 , . . . , Bk = Ω. Dann ist die Wahrscheinlichkeit eines beliebigen Ereignisses A k X P(A | Bi )P(Bi ) . i=1 Ω B4 B2 B6 A P(T c ∩ K c ) = 0.99 · 0.9 = 0.891 P(T |K c )P(K c ) Wahrscheinlichkeit und Statistik B1 = 0.0095 + 0.099 = 0.1085 37 / 40 WBL 2017 Formel von Bayes B5 B3 Wahrscheinlichkeit und Statistik 38 / 40 WBL 2017 Literatur Satz (Formel von Bayes) Takeo Mizutani and Tomotari Mitsuoka. Effect of intestinal bacteria on incidence of liver tumors in gnotobiotic C3H/He male mice. Journal of the National Cancer Institute, 63(6):1365–1370, 1979. A und B seien Ereignisse mit P(A) > 0 und P(B) > 0. Dann gilt: P(B | A) = P(A | B) · P(B) . P(A) Colin A Nurse. Interactions between dissociated rat sympathetic neurons and skeletal muscle cells developing in cell culture: II. Synaptic mechanisms. Developmental biology, 88(1):71–79, 1981. Im Setting des Satzes der totalen Wahrscheinlichkeit können wir schreiben P(A | Bi ) · P(Bi ) P(Bi | A) = Pk . j=1 P(A | Bj ) · P(Bj ) Myra L Samuels, Jeffrey A Witmer, and Andrew Schaffner. Statistics for the life sciences. Pearson Education, 2012. Beispiel: medizinischer Test (Forts.) Angenommen, der medizinische Test von vorhin gibt Ihnen ein positives Testergebnis. Wie gross ist die Wahrscheinlichkeit, dass Sie die Krankheit tatsächlich haben? Wahrscheinlichkeit und Statistik 39 / 40 Steven G Potkin, H Eleanor Cannon, Dennis L Murphy, and Richard Jed Wyatt. Are paranoid schizophrenics biologically different from other schizophrenics? New England Journal of Medicine, 298(2):61–66, 1978. WBL 2017 Werner Alfred Stahel. Statistische Datenanalyse. Vieweg und Sohn, Braunschweig, 4. edition, 2002. Richard W Van Norman. Experimental biology. Prentice-Hall, 1971. Wahrscheinlichkeit und Statistik 40 / 40 WBL 2017