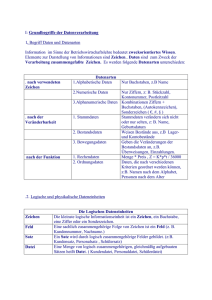

Entwicklung eines Werkzeugs zur Sprachidentifikation in

Werbung