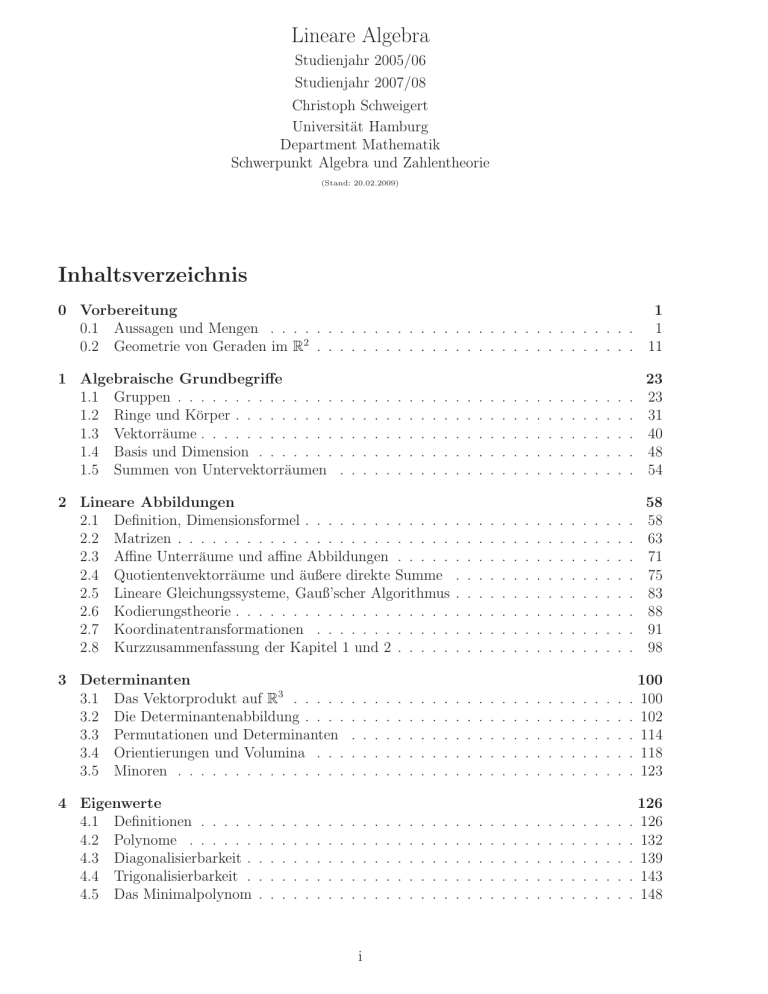

Lineare Algebra Inhaltsverzeichnis

Werbung