Lineare Algebra - Alexander Stoffel

Werbung

Mathematik für den Studiengang

Bachelor Technische Informatik

Zug 1TINb“

”

Lineare Algebra

Alexander Stoffel

Institut für Nachrichtentechnik

Fakultät für Informations-, Medien- und Elektrotechnik

Fachhochschule Köln

16. Januar 2014

1

Einleitung

Dieses Skript ist ausschließlich für die Teilnehmer meiner Lehrveranstaltung Mathematik 1

und Mathematik 2 gedacht — neben dem entsprechenden Skript zur Analysis. Es ist noch

fehlerbehaftet, änderungs- und ergänzungsbedürftig. Für entsprechende Hinweise bin ich

sehr dankbar, insbesondere für Hinweise auf Tippfehler und andere Unstimmigkeiten.

Ansonsten sei hier auf das entsprechende Einleitungskapitel im Skript zur Analysis

verwiesen. Was dort gesagt ist, kann entsprechend auch für die Lineare Algebra angewandt

werden und braucht hier nicht nochmal wiedergegeben werden — mit Ausnahme der

Literaturangaben. Auch die hier angegebene Liste stellt nur eine kleine und teilweise

zufällige Auswahl dar:

(1) Papula, Lothar: Mathematik für Ingenieure 2. 6. Auflage, Vieweg, Braunschweig,

1991.

(2) Andrié, Manfred; Meier, Paul: Lineare Algebra und Analytische Geometrie. Eine

anwendungsbezogene Einführung. Bibliographisches Institut, Mannheim, 1977.

(3) Strang, Gilbert: Introduction to linear algebra. Wellesley-Cambridge Press, Wellesley (USA), 1993.

(4) Strang, Gilbert: Linear algebra and its applications. Third edition, Harcourt Brace

Jovanovich, San Diego (USA), 1988

(5) Meyberg, Kurt; Vachenauer, Peter: Höhere Mathematik 1. Springer, Berlin, 1991

(6) Jänich, Klaus: Lineare Algebra. 4. Auflage, Springer, Berlin, 1991

(7) Penney, Richard: Linear Algebra. Wiley-VCH, New York, 1998

(8) Beutelspacher, Albrecht: Lineare Algebra. Eine Einführung in die Wissenschaft der

Vektoren, Abbildungen und Matrizen. 3. Auflage, Vieweg, Braunschweig/Wiesbaden,

1998

2

Inhaltsverzeichnis

1 Grundbegriffe

1.1 Natürliche und ganze Zahlen .

1.2 Summen- und Produktzeichen,

1.2.1 Summenzeichen . . . .

1.2.2 Produktzeichen . . . .

1.2.3 Vollständige Induktion

1.2.4 Binomischer Lehrsatz .

. . . . . . .

vollständige

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

5

. . . . . . . . . . . . . . . . . . 5

Induktion, binomischer Lehrsatz 5

. . . . . . . . . . . . . . . . . . 5

. . . . . . . . . . . . . . . . . . 7

. . . . . . . . . . . . . . . . . . 7

. . . . . . . . . . . . . . . . . . 8

2 Vektorrechnung

2.1 Addition von Vektoren und Multiplikation mit einem Skalar . .

2.2 Komponentendarstellung von Vektoren . . . . . . . . . . . . . .

2.3 Skalarprodukt und Betrag . . . . . . . . . . . . . . . . . . . . .

2.4 Beschreibung von Geraden . . . . . . . . . . . . . . . . . . . . .

2.4.1 Vektorielle Beschreibung . . . . . . . . . . . . . . . . . .

2.4.2 Beschreibung einer Geraden durch einen Normalenvektor

2.5 Vektorprodukt . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.6 Beschreibung von Ebenen im Raum . . . . . . . . . . . . . . . .

2.6.1 Vektorielle Beschreibung . . . . . . . . . . . . . . . . . .

2.6.2 Beschreibung einer Ebene durch einen Normalenvektor .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 Lineare Gleichungssysteme

3.1 Gauß-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.1.1 Einfaches Beispiel, Rückwärtsauflösen . . . . . . . . . . . . . . . .

3.1.2 Umwandlung in Dreiecksform, einfaches Beispiel . . . . . . . . . .

3.1.3 Weiteres Beispiel zur Umwandlung in Dreiecksform in Kurzschreibweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.1.4 Allgemeines Prinzip des Gauß-Verfahrens . . . . . . . . . . . . . .

3.2 Geometrische Deutung linearer Gleichungssysteme . . . . . . . . . . . . .

3.3 Homogene und inhomogene lineare Gleichungssysteme . . . . . . . . . . .

3.4 Unter- und überbestimmte lineare Gleichungssysteme . . . . . . . . . . .

3.4.1 Unterbestimmte lineare Gleichungssysteme . . . . . . . . . . . . .

3.4.2 Überbestimmte Systeme . . . . . . . . . . . . . . . . . . . . . . .

4 Vektorräume

4.1 Definition des Begriffs Vektorraum“ . . . . .

”

4.2 Der Rn . . . . . . . . . . . . . . . . . . . . . .

4.3 Lineare Abhängigkeit, lineare Unabhängigkeit

4.4 Basis, Dimension . . . . . . . . . . . . . . . .

5 Matrizen

5.1 Matrix als Koeffizientenschema . . . . . . . .

5.2 Lineare Gleichungssysteme und Matrizen . . .

5.3 Lineare Abbildungen und Matrizen . . . . . .

5.4 Matrixmultiplikation und -addition . . . . . .

5.5 Die Umkehrabbildung und die inverse Matrix

5.6 Die transponierte Matrix . . . . . . . . . . . .

5.7 Der Rang einer Matrix . . . . . . . . . . . . .

3

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

11

12

15

18

18

19

21

24

24

25

26

. 26

. 26

. 28

.

.

.

.

.

.

.

29

31

35

42

43

43

44

.

.

.

.

46

47

50

51

56

.

.

.

.

.

.

.

62

62

63

66

71

81

88

90

6 Endliche Körper und ihre Anwendungen

6.1 Restklassen . . . . . . . . . . . . . . . .

6.2 Endliche Körper . . . . . . . . . . . . . .

6.3 Kanalcodierung: Beispiele . . . . . . . .

bei der

. . . . .

. . . . .

. . . . .

7 Determinanten

7.1 Determinanten für n = 2 und n = 3, Cramersche

7.2 Laplacesche Entwicklung . . . . . . . . . . . . .

7.3 Eigenschaften der Determinante . . . . . . . . .

7.4 Determinanten und Permutationen . . . . . . .

Kodierung

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

Regel

. . . .

. . . .

. . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

8 Eigenwerte

8.1 Eigenwerte und Eigenvektoren . . . . . . . . . . . . . . . . . . . . . . . .

8.2 Vielfachheit von Eigenwerten . . . . . . . . . . . . . . . . . . . . . . . .

8.3 Diagonalisierung von Matrizen . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

91

91

96

99

104

104

106

108

109

111

. 111

. 118

. 119

9 Weitere Methoden der Algebra in der Nachrichtentechnik: ein Ausblick122

9.1 Polynome und Körpererweiterungen . . . . . . . . . . . . . . . . . . . . . . 122

9.2 Zyklische Codes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

10 Näherungen

131

10.1 Näherungslösungen für überbestimmte Gleichungssysteme . . . . . . . . . 131

10.2 Beste Näherung durch Vektoren aus einem Unterraum . . . . . . . . . . . 134

A Anhang: Ergänzungen

A.1 Gruppen . . . . . . . .

A.2 Relationen . . . . . . .

A.3 Potenzmenge . . . . .

A.4 Ergänzungen zur Logik

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

143

143

147

151

152

1

1.1

Grundbegriffe

Natürliche und ganze Zahlen

Die Menge der natürlichen Zahlen N wird durch folgende Axiome charakterisiert, die von

dem italienischen Mathematiker Peano stammen:

Axiome 1.1.1

(a) 0 ist eine natürliche Zahl, 0 ∈ N

(b) Jede natürliche Zahl n besitzt genau eine natürliche Zahl als Nachfolger“, der n + 1

”

geschrieben wird.

(c) Wenn die Nachfolger zweier natürlicher Zahlen übereinstimmen, dann stimmen die

urprünglichen Zahlen ebenfalls überein.

(d) 0 ist nicht Nachfolger einer natürlichen Zahl.

(e) Jede Teilmenge M ⊂ N, die die Eigenschaft hat, dass

0∈M

n ∈ M =⇒ n + 1 ∈ M

und

stimmt mit N überein.

Hinweis: Axiom (e) ist die Grundlage der Beweismethode der vollständigen Induktion“,

”

die in Abschnitt 1.2.3 behandelt wird.

Weiterhin vereinbaren wir

N+ := {n ∈ N | n > 0} = N \ {0}

und nennen die Menge der ganzen Zahlen Z, also

Z = {0, +1, −1, +2, −2, +3, −3, +4, −4, +5, −5, . . .}

Leider wird diese Bezeichnungsweise nicht überall verwandt, in einigen Büchern wird von

einer andern Vereinbarung (dies ist auch historisch die ursprüngliche) ausgegangen; dort

gehört die Null nicht zur Menge der natürlichen Zahlen. Die Menge der natürlichen Zahlen

mit der Null wird dort meist mit N0 bezeichnet. Diese Konvention wurde auch bei früheren

Ausgaben dieses Skriptes verwendet. Schauen Sie also beim Benutzen von Büchern nach,

wie der Autor die Menge der natürlichen Zahlen definiert!

1.2

1.2.1

Summen- und Produktzeichen, vollständige Induktion, binomischer Lehrsatz

Summenzeichen

Wir führen hier das Summenzeichen zunächst an Beispielen ein, die allgemeine Definition

wird später gegeben. Nach der Legende wurde der Mathematiker Gauß in seiner Schulzeit

mit der Aufgabe beschäftigt, die ersten 100 Zahlen zu addieren. Wir können diese Aufgabe

mit Pünktchen“ formulieren oder hierzu das Summenzeichen verwenden

”

100

X

1 + 2 + 3 + 4 + · · · + 100 =

k

k=1

5

P

Das Summenzeichen

ist ein großes griechisches Sigma“. Unten steht der Startwert“

”

”

des Summationsindex und oben sein höchster Wert. Der Startwert ist bis zum Erreichen

des Höchstwertes jeweils um 1 zu erhöhen. Wir werden im Abschnitt 1.2.3 eine Formel

beweisen, die es ermöglicht, diese Summe sofort auszurechnen. Weitere Beispiele für die

Verwendung des Summenzeichens:

10

X

1 + 4 + 9 + 16 + 25 + · · · + 100 =

k=1

5

X

13 + 23 + 33 + 43 + 53 =

k2

k 3 = 225

k=1

Auch zur Berechnung dieser Summen werden wir in den Übungen eine einfache Formel

kennenlernen. Beachten Sie, dass die Summe nicht davon abhängt, welchen Buchstaben

wir als Index oder Variable zum Zählen der Summanden verwenden. Es gilt also

5

X

k=1

3

k =

5

X

3

l =

5

X

3

i =

3

m =

m=1

i=1

l=1

5

X

5

X

n3

n=1

Und hier die allgemeine Definition

Definition 1.2.1 ak steht symbolisch für Summanden, die von k abhängen, wobei k ∈ Z

vorausgesetzt wird. Außerdem wird n ≥ m vorausgesetzt. Dann wird definiert

n

X

ak := am + am+1 + am+2 + am+3 + · · · + an−1 + an

k=m

Hinweise:

(a) Die Zahl der Summanden beträgt n − m + 1.

(b) Die Indizes (Mehrzahl von Index) können auch negativ sein, also beispielsweise

2

X

2k = 2−2 + 2−1 + 20 + 21 + 22 =

k=−2

3

1 1

+ +1+2+4=7+

4 2

4

Bei dieser Gelegenheit ein wichtiger Hinweis: In der Mathematik wird vereinbart

(siehe das Skript zur Analysis), dass ein nicht hingeschriebenes Zeichen für eine

Rechenoperation stets als Punkt für die Multiplikation zu interpretieren ist. Bei

Ergebnissen wie 7 + 43 darf also in der Mathematik und in der Nachrichtentechnik

das Plus-Zeichen nicht weggelassen werden, auch wenn dies bei Kartoffelhändlern

üblich ist!

(c) Die Summe ist völlig unabhängig davon, welcher Formelbuchstabe für den Summationsindex verwandt wird, also

n

X

k=m

ak =

n

X

l=m

6

al =

n

X

i=m

ai

1.2.2

Produktzeichen

Das Produktzeichen ist ganz ähnlich zum Summenzeichen definiert, nur dass die auftretenden Zahlen zu multiplizieren sind. Wir haben also beispielsweise

1·2·3·4·5·6 =

1 · 3 · 5 · 7 · 9 · 11 =

6

Y

k

k=1

5

Y

(2k + 1)

k=0

Q

Das Zeichen

ist ein großes griechisches Pi. Auch hier ist unten der Startwert des Index,

der jeweils um 1 zu erhöhen ist, bis der oben angegebene maximale Wert erreicht ist. Die

allgemeine Definition lautet analog zu der des Summenzeichens:

Definition 1.2.2 ak steht symbolisch für Faktoren, die von k abhängen, wobei k ∈ Z

vorausgesetzt wird. Außerdem wird n ≥ m vorausgesetzt. Dann wird definiert

n

Y

ak := am · am+1 · am+2 · am+3 · · · an−1 · an

k=m

Hinweis: Wir haben insgesamt n − m + 1 Faktoren.

Definition 1.2.3 Für alle n ∈ N wird definiert

n

Q k = 1 · 2 · 3 · · · n falls

n! :=

k=1

1

falls

n>0

n=0

(lies n Fakultät“)

”

Hinweise:

(a) Die Definition 0! = 1 mag zwar willkürlich erscheinen, sie vermeidet aber sehr viele

Fallunterscheidungen.

(b) n! wächst mit größer werdendem n sehr stark an, wie die Beispiele

6! = 720,

9! = 362 880,

100! ≈ 0, 9332622 · 10158

zeigen

1.2.3

Vollständige Induktion

Die Beweismethode der vollständigen Induktion beruht darauf, dass man das PeanoAxiom (e) ausnutzt und als Teilmenge M ⊂ N die Menge der natürlichen Zahlen nimmt,

für die eine Aussage A richtig ist. Als Beispiel für eine solche Aussage A wird uns die Glein

P

für n ∈ N dienen. Ein solcher Beweis heißt dann Beweis durch

chung

k = n(n+1)

2

”

k=1

vollständige Induktion“. Nach dem Axiom (e) genügt es also, folgende Beweisschritte

durchzuführen, um die Behauptung A für alle n ∈ N zu beweisen:

7

Induktionsbeginn: Man beweist die Aussage für n = 0 (dies ist meist sehr einfach).

Induktionsannahme: Man nimmt an, die Behauptung A sei für ein festes, aber beliebiges n ∈ N richtig.

Induktionsschluß: Mit Hilfe der Induktionsannahme beweist man, dass die Behauptung

A für n + 1 richtig ist.

Wir beweisen nun als Beispiel die Formel von Gauß, die seine Schulaufgabe löst:

Satz 1.2.1 Für alle n ∈ N gilt

n

X

n(n + 1)

2

k=

k=0

Beweis durch vollständige Induktion:

Induktionsbeginn:

0

P

k=0=

k=0

Induktionsvoraussetzung:

n

P

0·(0+1)

2

k=

k=0

Induktionsbehauptung:

n+1

P

n(n+1)

2

für ein festes n ∈ N

k=

(n+1) (n+1)+1

2

k=0

(überall in der Behauptung A wurde n

durch n + 1 ersetzt.)

Induktionsbeweis: Nach der Definition des Summenzeichens haben wir

n+1

X

k=0

k=

n

X

k+n+1

k=0

Den ersten Summanden auf der rechten Seite können wir mit Hilfe der Induktionsvoraussetzung umformen, also haben wir insgesamt

n+1

X

k=0

k=

n

X

k=0

k+n+1=

n(n + 1)

n(n + 1) + 2(n + 1)

(n + 2)(n + 1)

+n+1=

=

2

2

2

und damit ist die Induktionsbehauptung bewiesen. Und damit ist auch der Satz

bewiesen.

Weitere Beispiele werden in den Übungen besprochen.

1.2.4

Binomischer Lehrsatz

Ziel dieses Abschnitts ist es, eine allgemeine Formel für (a + b)n herzuleiten, die die

binomische Formel (a + b)2 = a2 + 2ab + b2 verallgemeinert. Durch Ausmultiplizieren kann

man für n = 4 erhalten

(a + b)4 = a4 + 4a3 b + 6a2 b2 + 4ab3 + b4

8

Ordnet man die Koeffizienten, die beim Ausmultiplizieren von (a + b)n auftreten, in

einem Dreieck an, dann erhält man das berühmte Pascalsche Dreieck (das nach dem

französischen Philosophen und Mathematiker Blaise Pascal benannt ist):

1

1

1

1

1

1

1

2

3

4

5

6

1

3

6

10

15

1

1

4

10

20

1

5

15

1

6

1

Das Konstruktionsprinzip ist klar erkennbar: die Summe zweier benachbarter Zahlen ergibt die darunterstehende Zahl. Wir geben nun eine Formel an, die es erlaubt, die Zahlen

im Pascalschen Dreieck zu berechnen:

Definition 1.2.4 Für alle n, k ∈ N mit n ≥ k werden die Binomialkoeffizienten durch

n

n!

:=

k!(n − k)!

k

definiert (zu lesen n über k“).

”

4

4

4

4!

4!

= 1, 41 = 1!·3!

= 1·2·3·4

=

4,

=

6,

=

4,

= 1

Zahlenbeispiele: 40 = 0!·4!

1·1·2·3

2

3

4

(Nachrechnen, die Fakultäten nicht ausrechnen, sondern vorher kürzen!) Offensichtlich

erhält man die 4. Zeile des Pascalschen Dreiecks, wenn man beim Zählen mit 0 anfängt.

Eigenschaften der Binomialkoeffizienten:

(a) n0 = 0!n!n! = 1

(b) nn = n!n!0! = 1

n!

(c) n1 = 1!(n−1)!

= 1·2·3···(n−1)·n

=n

1·1·2·3···(n−1)

n

n!

(d) n−1

= (n−1)!

=n

1!

n

n!

n!

= (n−k)!·k!

= nk (Symmetrie!)

(e) n−k

=

(n−k)! n−(n−k) !

(f)

n

k

=

1·2·3···(n−k)·(n−k+1)···n

k!·1·2·3···(n−k)

=

n·(n−1)·(n−2)···(n−k+1)

k!

Diese Identitäten gelten für alle n ∈ N. Sie garantieren bereits, dass die durch Definition 1.2.4 festgelegten Binomialkoeffizienten mit den Zahlen am Rand des Pascalschen

Dreiecks übereinstimmen, wenn man die Zeilen (n) und die waagrechte Position (k) jeweils mit 0 anfängt zu zählen. Die wesentliche Eigenschaft der Zahlen im Pascalschen

Dreieck ist, dass jede Zahl als Summe der beiden darüberstehenden Zahlen entsteht. Das

Dreieck wird mit jeder Zeile nach links (und rechts) größer. Also stehen über der Zahl an

k. waagrechter Position der (n+1). Zeile die Zahlen der n. Zeile an (k −1). (links darüber)

und k. Position (rechts darüber). Die Übereinstimmung der Zahlen im Pascalschen Dreieck mit den Binomialkoeffizienten nach Def. 1.2.4 wird also erst durch den folgenden Satz

geliefert:

9

Satz 1.2.2 Für alle n ∈ N+ und alle k ∈ N+ mit k ≤ n gilt

n+1

n

n

=

+

k

k−1

k

Beweis:

k

n!

(n − k + 1)

n

n

n!

· +

·

+

=

k−1

k

(k − 1)! n − (k − 1) ! k k!(n − k)! (n − k + 1)

n!k + n!(n − k + 1)

n!(k + n − k + 1)

(n + 1)!

=

=

=

k!(n − k + 1)!

k!(n + 1 − k)!

k!(n + 1 − k)!

n+1

=

k

Merke: Die Binomialkoeffizienten nk stehen im Pascalschen Dreieck in der n. Zeile in

der k. Position von links, jeweils von 0 an gezählt.

Satz 1.2.3 (Binomischer Lehrsatz) Für alle n ∈ N0 und für alle a, b ∈ R gilt

n X

n n−k k

n

a b

(a + b) =

k

k=0

Beweis: (durch vollständige Induktion)

Induktionsbeginn: (a + b)0 = 1,

0

P

k=0

0

k

0−k 0

a b = a0 · b 0 = 1

Induktionsvoraussetzung: (a + b)n =

n

P

k=0

Induktionsbehauptung: (a + b)n+1 =

n+1

P

k=0

n

k

an−k bk für ein festes n

n+1

k

n+1−k k

a

b

Induktionsbeweis: Wir multiplizieren beide Seiten der Induktionsvoraussetzung mit

(a + b) und erhalten

n n n X

X

X

n n−k k

n n−k k

n n−k k

n+1

(a + b)

= (a + b)

a b =a·

a b +b·

a b

k

k

k

k=0

k=0

k=0

n n X

X

n n−k k+1

n n−k+1 k

=

a

b +

a b

k

k

k=0

k=0

n n+1

a

+ n1 an b1

+ n2 an−1 b2 + · · · + nn a1 bn

=

0

n n 1

n n−1 2

n

n n+1

1 n

+

a

b

+

a

b

+

·

·

·

+

a

b

+

b

0 1 n−1

n n+1 n+1

n+1 n 1

n+1 n−1 2

n+1 1 n

n+1 n+1

a

+ 1 a b + 2 a b + · · · + n a b + n+1 b

=

0

n+1

P n+1 n+1−k k

=

a

b

k

k=0

n+1

n

Dabei wurde

bei

den

außenstehenden

Summanden

ausgenutzt,

dass

=

=1

0

0

n

n+1

und n = n+1 = 1. Ansonsten wurden die übereinanderstehenden Summanden

(mit denselben Potenzen von a und b) unter Benutzung von Satz 1.2.2 zusammengefaßt.

10

2

2.1

Vektorrechnung

Addition von Vektoren und Multiplikation mit einem Skalar

Vektoren sind gerichtete Größen“, Kraft, Geschwindigkeit, elektrische Feldstärke sind

”

Beispiele aus der Physik. Wir wollen hier Vektoren als geordnete Paare von Punkten

in der Ebene oder im Raum ansehen. Geordnet heißt, dass einer der beiden Punkte der

Anfangspunkt, der andere der Endpunkt ist. Wichtig ist die folgende Vereinbarung:

Zwei Vektoren sind gleich, wenn Sie durch Parallelverschiebung ineinander

übergeführt werden können.

Dies bedeutet, zwei Vektoren sind gleich, wenn sie in Betrag (Länge) und Richtung

übereinstimmen (siehe auch Abb. 1).

Abbildung 1: Zur Gleichheit von Vektoren

Wir werden hier Vektoren durch einen Pfeil über dem Formelbuchstaben wie in ~a, ~b

oder durch Fettdruck a, b gegenüber anderen Größen hervorheben.

Abbildung 2: Zur Addition von Vektoren

Unter dem Antragen eines Vektors in einem Punkt P versteht man an eine Parallelverschiebung des Vektors so, dass sein Anfangspunkt im Punkt P liegt. Ein Vektor ~b

wird zu einem Vektor ~a addiert, indem man ~b im Endpunkt des Vektors ~a anträgt. Der

Vektor ~a + ~b ist dann der Vektor vom Anfangspunkt von ~a zum Endpunkt von ~b. Dies ist

in Abb. 2 veranschaulicht. Geometrisch bedeutet dies:

~a + ~b ist die gerichtete Diagonale des von ~a und ~b aufgespannten Parallelogramms ( Parallelogrammregel“, siehe auch die Abb. 2).

”

11

Der Nullvektor ~0 ist ein Vektor der Länge 0, Anfangs- und Endpukt fallen zusammen.

Der Vektor −~a entsteht aus dem Vektor ~a, indem man Anfangs- und Endpunkt vertauscht,

also seine Richtung umkehrt.

Abbildung 3: Zur Multiplikation von Vektoren mit einem Skalar

Man nennt Größen, die im Unterschied zu Vektoren keine Richtung haben, Skalare.

In der Physik sind beispielsweise Masse, Energie und Zeit Skalare. Hier sind Skalare reelle

Zahlen (wir werden später auch komplexe Zahlen als Skalare zulassen). Die Multiplikation eines Vektors ~a mit einem Skalar t ∈ R ist wie folgt definiert:

• Falls t > 0, dann ist t~a der Vektor derselben Richtung und der t-fachen Länge.

• Falls t < 0, dann ist t~a der Vektor der umgekehrten Richtung (Anfangs- und Endpunkt vertauscht) und der |t|-fachen Länge.

• Falls t = 0, dann ist t~a = ~0, also der Nullvektor.

Dies ist in Abb. 3 veranschaulicht. Es ist plausibel und folgt aus geometrischen Regeln,

dass für die so definierten Rechenoperationen folgende grundlegende Rechenregeln gelten:

Für alle Vektoren ~a, ~b, ~c gilt

~a + ~b = ~b + ~a

(Kommutativgesetz)

(~a + ~b) + ~c = ~a + (~b + ~c)

(Assoziativgesetz)

~

~a + 0 = ~a

(neutrales Element für die Addition)

zu jedem ~a existiert ein −~a mit

~a + (−~a) = ~0

(1)

(2)

(3)

(4)

und für alle Vektoren ~a, ~b und alle Skalare s, t ∈ R gilt

t(~a + ~b)

(s + t)~a

s(t~a)

1 · ~a

=

=

=

=

t~a + t~b

s~a + t~a

(st)~a

~a

(5)

(6)

(7)

(8)

Hinweis: Regel (5) ist der Strahlensatz (siehe Abb. 4).

2.2

Komponentendarstellung von Vektoren

Um mit Vektoren zu rechnen, wählen wir ein Koordinatensystem aus und vereinbaren,

alle Vektoren im Urspung dieses Koordinatensystems anzutragen. Vektoren der Länge 1

heißen Einheitsvektoren. Die Einheitsvektoren in die Richtung der Koordinatenachsen

12

Abbildung 4: Zur Rechenregel (5) (Strahlensatz)

Abbildung 5: Komponentendarstellung von Vektoren

bezeichnen wir mit ~ex , ~ey , ~ez . Betrachten wir einen Vektor ~a in der Ebene (siehe die

Abb. 5). Wir bezeichnen die Koordinanten des Endpunkts mit ax und ay . Wir können

den Vektor ~a also als Summe schreiben

~a = ax · ~ex + ay~ey

Wir bezeichnen dabei ax als Komponente in x-Richtung oder kurz als x-Komponente

und ay als Komponente in y-Richtung. Diese Zerlegung in eine Summe heißt Komponentendarstellung von ~a. Sie gibt Anlaß zu folgender Kurzschreibweise von Vektoren in der

Ebene:

ax

~a =

ay

In dieser Schreibweise wird ~a als Spaltenvektor bezeichnet.

Im Raum geht man analog vor und bezeichnet die Koordinaten des Endpunkts von ~a

mit ax , ay , az . Man erhält die Komponentendarstellung

~a = ax · ~ex + ay~ey + az~ez

und schreibt ~a als Spaltenvektor

ax

~a = ay

az

Der Nullvektor hat die Darstellung

~0 = 0

0

bzw.

13

0

~0 = 0

0

Aus der Parallelogrammregel erhält man die folgende Rechenregel für die Addition von

Abbildung 6: Zur Addition von Vektoren in Komponentendarstellung

Vektoren in Komponentendarstellung (siehe hierzu die Abb. 6)

ax + b x

bx

ax

~

=

+

~a + b =

ay + b y

by

ay

Für Vektoren im Raum gilt eine entsprechende Regel:

ax

bx

ax + b x

~a + ~b = ay + by = ay + by

az

bz

az + b z

Merke: Vektoren werden komponentenweise addiert.

Für die Multiplikation mit einem Skalar erhalten wir in der Komponentendarstellung in

der Ebene

a

tax

t~a = t x =

ay

tay

und im Raum

ax

tax

t~a = t ay = tay

az

taz

Merke: Ein Vektor wird mit einem Skalar multipliziert, indem man alle Komponenten

mit dem Skalar multipliziert.

Hinweis zur Geometrie:

Der Verbindungsvektor von P nach Q (also der Vektor mit Anfangspunkt P und Endpunkt

−→

Q) wird hier mit P Q bezeichnet. Den Ursprung bezeichnen wir mit O. Der Verbindungs−→

vektor OP vom Ursprung zum Punkt P wird der Ortsvektor des Punktes P genannt.

14

Abbildung 7: Verbindungsvektor von P nach Q

Zwischen den Ortsvektoren zweier Punkte P und Q und deren Verbindungsvektor besteht

der nützliche Zusammenhang

−→

−→ −→ −→ −→

P Q = −OP + OQ = OQ − OP

den man sich am besten anhand einer kleinen Skizze klarmacht (siehe Abb. 7).

Wir gehen im weiteren immer davon aus, dass ein festes Koordinatensystem gewählt

−→

wurde und werden meist den Punkt P mit seinem Ortsvektor OP identifizieren.

Hinweis zur Schreibweise:

Eine Spalte aus zwei oder drei Zahlen nimmt satztechnisch sehr viel Platz weg. Es wäre

viel platzsparender, die zwei oder drei Zahlen als Zeile anzuordnen. Um dies zu erreichen,

ist die Schreibweise

a

T

(a, b, c) := b

c

üblich. Allgemein bedeutet AT die transponierte Matrix (wird später behandelt). Bei

einer Zeile bedeutet dieses Symbol also, dass statt dessen die Spalte gemeint ist.

2.3

Skalarprodukt und Betrag

Die Länge eines Vektors ~a wird hier Betrag des Vektors genannt und |~a| geschrieben. Er

läßt sich aus den Komponenten berechnen:

p 2

a + a2y

falls ~a ein Vektor in der Ebene ist

(9)

|~a| = p x2

ax + a2y + a2z falls ~a ein Vektor im Raum ist

In der Ebene folgt dies unmittelbar aus dem Satz von Pythagoras (siehe Abb. 5). Im

Raum (siehe hierzu Abb. 8) kann man zunächst das Lot vom Endpunkt P des Vektors

auf die xy-Ebene fällen, dies liefert den Hilfspunkt Q, dessen Abstand vom Ursprung man

nach Pythagoras als

q

d = a2x + a2y

berechnet. Wendet man nun den Satz von Pythagoras auf das rechtwinklige Dreieck an,

das die Punkte O, P und Q verbindet, so erhält man

q

p

2

2

|~a| = d + az = a2x + a2y + a2z

15

Abbildung 8: Berechnung des Betrags eines Vektors aus den Komponenten (siehe (9)

Abbildung 9: Winkel zwischen zwei Vektoren

Den Winkel α zwischen zwei Vektoren ~a und ~b wählen stets wir so, dass er zwischen

0 und π liegt (beide Randpunkte eingeschlossen), also 0 ≤ α ≤ π (d.h. wir wählen den

kleineren der beiden möglichen Winkel, siehe Abb. 9). Er ist nur sinnvoll, wenn beide

Vektoren nicht mit dem Nullvektor übereinstimmen.

Definition 2.3.1 Das Skalarprodukt zweier Vektoren ist durch

(

ax b x + ay b y

falls ~a und ~b Vektoren in der Ebene sind

~a · ~b :=

ax bx + ay by + az bz falls ~a und ~b Vektoren im Raum sind

definiert.

Hinweise:

(a) Beachten Sie, dass das Ergebnis des Skalarprodukts stets ein Skalar, also eine reelle

Zahl ist! Daher kommt der Name!

(b) Das Skalarprodukt wird manchmal auch inneres“ Produkt genannt.

”

(c) Für das Skalarprodukt sind auch andere Schreibweisen gebräuchlich. In der Mathematik ist

~a · ~b = (~a, ~b)

sehr verbreitet, in den Ingenieurwissenschaften ist auch

a · b = aT b

üblich. Diese Schreibweise wir erst verständlich, wenn wir das Rechnen mit Matrizen

behandelt haben (die Spaltenvektoren a und b werden als Matrizen mit einer Spalte

und zwei bzw. drei Zeilen aufgefaßt, aT ist dann die transponierte Matrix und mit

aT b ist das Produkt von zwei Matrizen gemeint).

16

Abbildung 10: Zum Beweis von Satz 2.3.1

Satz 2.3.1 Für alle Vektoren ~a gilt

|~a| =

√

~a · ~a

und für alle Vektoren ~a und ~b mit ~a 6= ~0 und ~b 6= ~0 gilt

~a · ~b = |~a| · |~b| · cos(ϕ)

wobei ϕ der Winkel zwischen ~a und ~b ist.

Beweis: Die erste Gleichung folgt unmittelbar aus der Definition. Die zweite wird hier

nur für den Fall bewiesen, dass es sich um Vektoren in der Ebene handelt. Für beliebige

Vektoren ~a 6= ~0, ~b 6= ~0 in der Ebene gilt (siehe Abb. 10)

sin(α) =

ay

,

|~a|

cos(α) =

ax

,

|~a|

sin(β) =

by

,

|~b|

cos(β) =

bx

|~b|

Für ϕ = β − α erhalten wir aus dem Additionstheorem

cos(ϕ) = cos(β − α) = cos(β) cos(α) + sin(β) sin(α) =

b y ay

b x ax

+

·

·

|~b| |~a| |~b| |~a|

Multiplikation beider Seiten mit |~a| · |~b| liefert

|~a| · |~b| · cos(ϕ) = ax bx + ay by

Hinweis: Als Folgerung erhalten wir für alle Vektoren ~a 6= ~0, ~b 6= ~0

~a · ~b = 0

⇐⇒

~a und ~b sind orthogonal (senkrecht)

sowie

|~a · ~b| ≤ |~a| · |~b|

(Cauchy-Schwarz-Ungleichung)

17

Satz 2.3.2 (Rechenregeln für das Skalarprodukt) Für alle Vektoren ~a, ~b, ~c und alle

t ∈ R gilt

~a · ~b = ~b · ~a

(~a + ~b) · ~c = ~a · ~c + ~b · ~c

(t~a) · ~b = t · (~a · ~b)

~a · ~a ≥ 0

und

(10)

(11)

~a · ~a = 0 ⇐⇒ ~a = ~0

(12)

(13)

Diese Rechenregeln ergeben sich unmittelbar aus der Definition.

2.4

2.4.1

Beschreibung von Geraden

Vektorielle Beschreibung

Die Richtung einer Geraden kann durch einen Vektor, ihren Richtungsvektor, vorgegeben

werden. Man kann diesen als Verbindungsvektor zweier beliebiger verschiedener Punkte der Geraden erhalten (siehe auch Abb. 11 links). Der Richtungsvektor ist also nicht

eindeutig bestimmt, wir können ihn länger oder kürzer wählen oder auch die Richtung

umkehren, ohne dass sich dadurch die Richtung der Geraden ändert.

Da sich Vektoren durch Parallelverschiebung nicht ändern, ist eine Gerade durch ihren

Richtungsvektor nicht eindeutig bestimmt. Hierfür müssen wir noch einen Punkt auf der

Gerade auswählen (in der Abb. mit P0 bezeichnet). Auch diese Auswahl ist willkürlich.

Den Ortsvektor jedes Punktes P auf der Gerade erhalten wir also, indem wir zum Orts−−→

vektor des ausgewählten Punktes ~a = OP0 ein Vielfaches des Richtungsvektors ~b addieren.

Dies ist in Abb. 11 links veranschaulicht. Jeder Ortsvektor eines Punktes auf der Geraden

hat also die Darstellung

~x(t) = ~a + t · ~b,

t∈R

(14)

und wir erhalten auf diese Weise alle Punkte der Geraden, wenn wir beliebige t ∈ R

zulassen. Wir nennen (14) die vektorielle Form der Geradengleichung.

Auch Geraden im Raum können analog durch eine Gleichung der Form (14) beschrieben werden, wobei dann die Vektoren ~a und ~b Vektoren im Raum sind.

Abbildung 11: links: zur vektoriellen Form der Geradengleichung (14), rechts: zur Beschreibung einer Geraden durch einen Normalenvektor mit Gleichung (15)

18

2.4.2

Beschreibung einer Geraden durch einen Normalenvektor

Die Richtung einer Geraden in der Ebene können wir auch dadurch festlegen, dass wir

einen Vektor ~v 6= 0 angeben, der senkrecht auf der Geraden steht (siehe auch Abb. 11

rechts). Ein solcher Vektor heißt Normalenvektor. Rechnerisch können wir die Bedingung, dass der Verbindungsvektor

→ −→

~b = −−

OP + OQ = −~a + ~x

zweier beliebiger Punkte der Geraden senkrecht auf ~v steht, mit Hilfe des Skalarprodukts

durch

0 = ~v · ~b = ~v · (−~a + ~x) = −~v · ~a + ~v · ~x

ausdrücken. Die Ortsvektoren ~x beliebiger Punkte erfüllen also die Gleichung

~v · ~x = ~v · ~a

(15)

wobei ~a der Ortsvektor eines vorgegebenen Punktes der Geraden und ~v ein Vektor senkrecht auf der Geraden ist. Beachten Sie, dass die Festlegung des Normalenvektors nur die

Richtung der Geraden festlegt. Geraden durch den Ursprung (also der Ortsvektor eines

Punktes der Geraden ist ~0) sind durch ~v · ~x = 0 gegeben.

Wir merken uns:

Alle Punkte der Ebene, deren Ortsvektoren ~x die Gleichung

~v · ~x = r

(16)

mit gegebenem r ∈ R erfüllen, liegen auf einer Geraden senkrecht zu ~v . Wenn ~v und ein

Punkt der Gerade durch seinen Ortsvektor ~a gegeben ist, dann kann daraus die Konstante

r = ~v · ~a berechnet werden.

1

x

Beispiel: Für ~v =

und r = 5 erhalten wir für den Ortsvektor

2

y

x

~v ·

= x + 2y = 5

y

Wenn wir diese Gleichung nach y auflösen, so erhalten wir eine Geradengleichung in

vertrauter Form

1

5

y =− x+

2

2

Wir wollen nun eine Formel zur Berechnung des Abstands d einer Geraden vom Ursprung

herleiten, die durch eine Geradengleichung der Form (16) gegeben ist. Die Vorgehensweise

ist auch aus Abb. 11 rechts ersichtlich. Wir gehen vom Ursprung aus in Richtung des

Normalenvektors ~v so weit, bis wir die Gerade treffen. Wir fällen also das Lot auf die

Gerade. Wir betrachten dazu Ortsvektoren der Form

~x(t) = t · ~v

mit t ∈ R (für den Fall, dass die Gerade auf der anderen Seite liegt und ~v von der Geraden

weg zeigt, müssen wir auch negative t zulassen). Der gesuchte Fußpunkt des Lots hat also

19

einen Ortsvektor dieser Form. Er muss auf der Geraden liegen, der Ortsvektor muss also

die Geradengleichung erfüllen:

~v · ~x(t) = ~v · (t · ~v ) = t(~v · ~v ) = t · |~v |2 = r

Diese Gleichung können wir nach t auflösen, und wir erhalten dadurch den Ortsvektor

zum Fußpunkt des Lots:

r

r

~x(t) = 2 · ~v

t = 2,

|~v |

|~v |

Die Länge des Ortsvektors zu diesem Fußpunkt ist der gesuchte Abstand d der Geraden

vom Ursprung:

r

|r| · |~v |

|r|

d = |~x(t)| = 2 · ~v =

=

2

|~v |

|~v |

|~v |

Wir erhalten das Ergebnis:

Eine Gerade, die durch eine Gleichung der Form (16) gegeben ist, hat den Abstand d vom

Ursprung mit

|r|

d=

(17)

|~v |

Dieses Ergebnis ermöglicht es, die Geradengleichung (16) etwas anders zu schreiben. Falls

r > 0, teilen wir beide Seiten durch |~v | und erhalten

1

r

~v · ~x =

=d

|~v |

|~v |

und falls r < 0, teilen wir beide Seiten durch (−|~v |) und erhalten

−

1

−r

|r|

~v · ~x =

=

=d

|~v |

|~v |

|~v |

Dies legt nahe, den Vektor

(

~u :=

1

~v

|~v |

1

− |~v| ~v

falls r ≥ 0

falls r < 0

zu definieren. Er hat die Eigenschaft

1 |~v |

|~u| = ± ~v =

=1

|~v |

|~v |

ist also ein Einheitsvektor, der senkrecht auf der Geraden steht. Wir haben damit das

Ergebnis gewonnen:

Die Ortsvektoren ~x der Punkte einer Geraden erfüllen eine Gleichung der Form

~u · ~x = d

(18)

Dabei ist ~u ein Einheitsvektor, der senkrecht auf der Geraden steht, und d der Abstand

der Geraden vom Ursprung. Diese Gleichung heißt Hessesche Normalform der Geradengleichung.

20

Hinweise:

(a) Falls uy 6= 0, können wir die Geradengleichung nach der y-Komponente des Ortsvektors auflösen und damit in die Form y = mx + b bringen. Falls dagegen uy = 0,

liegt eine Gerade senkrecht zur x-Achse vor.

(b) Im Raum führt die Verallgemeinerung des obigen Vorgehens zur Hesseschen Normalform der Gleichung einer Ebene im Raum (siehe Abschnitt 2.6.2).

(c) Wenn eine Geradengleichung in der vektorieller Form (14) vorliegt, dann erhalten

wir aus dem Richtungsvektor ~b mit

by

~v =

−bx

einen Normalenvektor und können damit eine Geradengleichung der Form (16) aufstellen.

2.5

Vektorprodukt

Die Kraft auf ein Elektron in einem Magnetfeld ist senkrecht zu seiner Geschwindigkeit

~ (der das magnetische Feld beschreibt). Zur Beschreibung

~v und senkrecht zum Vektor B

dieser Kraft (und für viele andere Anwendungen) wird das Vektorprodukt benötigt. Wir

geben hier zunächst eine geometrische Definition und später eine dazu äquivalente rechnerische Definition.

Definition 2.5.1 (geometrische Definition des Vektorprodukts) Unter dem Vektorprodukt ~c = ~a × ~b zweier Vektoren ~a, ~b im Raum versteht man den Vektor ~c, der

durch folgende Eigenschaften gegeben ist:

(a) ~c ist orthogonal zu ~a und ~b (also ~a · ~c = ~b · ~c = 0).

(b) |~c| = |~a| · |~b| · sin(α), wobei α der Winkel zwischen ~a und ~b ist (also entspricht |~c|

der Fläche des von ~a und ~b aufgespannten Parallelogramms, siehe auch Abb. 12).

(c) Die Vektoren ~a, ~b und ~c bilden ein Rechtssystem wie Daumen, Zeigefinger und Mittelfinger der rechten Hand ( Rechte-Hand-Regel“, siehe Abb. 13).

”

Abbildung 12: sin(α) = |~hb| =⇒ h = |~b| · sin(α), also ist die Fäche des Parallelogamms

|~a| · |~b| · sin(α) (zu (b) in Def. 2.5.1)

21

Abbildung 13: Zur Rechte-Hand-Regel ((c) in Def. 2.5.1)

Satz 2.5.1 Die folgenden Rechenregeln für das Vektorprodukt gelten für alle Vektoren

~a, ~b, ~c im Raum und alle t ∈ R:

~a × ~b = −~b × ~a

(t~a) × ~b = t(~a × ~b) = ~a × (t~b)

~a × (t~a) = ~0

~a × (~b + t~a) = ~a × ~b,

(~a + t~b) × ~b = ~a × ~b

~a × (~b + ~c) = ~a × ~b + ~a × ~c,

(~a + ~c) × ~b = ~a × ~b + ~c × ~b

~ex × ~ey = ~ez ,

~ey × ~ez = ~ex ,

~ez × ~ex = ~ey

(19)

(20)

(21)

(22)

(23)

(24)

Abbildung 14: Die Flächen des von ~a und ~b und des von ~a und ~b + t~a aufgespannten

Parallelogramms sind gleich (zum Beweis von Satz 2.5.1, (22))

Hinweise zum Beweis:

(19) folgt direkt aus der Rechte-Hand-Regel.

(20) folgt aus der entsprechenden Änderung der Fläche des Parallelogramms.

(21) folgt unmittelbar aus (20) und (19).

(22) folgt aus der Tatsache, dass sich die Fläche des entsprechenden Parallelogramms

nicht ändert (siehe die Abb. 14)

22

(23) aus der geometrischen Definition herzuleiten, ist nicht ganz einfach. Es sei daher hier

nur darauf hingewiesen, dass man mit (22) den allgemeinen Fall auf den Sonderfall

zurückführen kann, dass ~b und ~c senkrecht auf ~a sind (für die erste Gleichung) bzw. ~a

und ~c senkrecht auf ~b sind ( für die zweite Gleichung). Aufgrund von (20) kann man

sich dann darauf beschränken, die Gleichung für den Sonderfall von Einheitsvektoren

zu beweisen. Dies wird hier nicht ausgeführt.

(24) folgt unmittelbar aus der Rechte-Hand-Regel, da die aufgespannten Parallelogramme stets Quadrate der Kantenlänge 1 sind (zur Erinnerung: ~ex , ~ey und ~ez sind die

Einheitsvektoren in Achsrichtung)

Mit Hilfe dieser Rechenregeln können wir das Vektorprodukt beliebiger Vektoren ausrechnen:

~a × ~b = (ax~ex + ay~ey + az~ez ) × (bx~ex + by~ey + bz~ez )

= ay bx (~ey × ~ex ) + az bx (~ez × ~ex ) + ax by (~ex × ~ey )

+az by (~ez × ~ey ) + ax bz (~ex × ~ez ) + ay bz (~ey × ~ez )

= −ay bx~ez + az bx~ey + ax by~ez − az by~ex − ax bz~ey + ay bz~ex

= (ay bz − az by )~ex + (az bx − ax bz )~ey + (ax by − ay bx )~ez

Die folgende rechnerische Definition ist also äquivalent zur geometrischen (Definition

2.5.1):

Definition

2.5.2

(rechnerische

Definition des Vektorprodukts) Für beliebige Vekax

bx

toren ~a = ay und ~b = by wird das Vektorprodukt ~a × ~b durch

az

bz

ay b z − az b y

~a × ~b := az bx − ax bz

(25)

ax b y − ay b x

definiert.

Hinweise:

(a) Das Vektorprodukt wird — aufgrund seiner Schreibweise — auch Kreuzprodukt“

”

und zuweilen auch äußeres Produkt“ genannt.

”

(b) Das Assoziativgesetz ist nicht erfüllt, wie das Beispiel

(~ex × ~ey ) × ~ey = ~ez × ~ey = −~ex ,

~ex × (~ey × ~ey ) = ~0

zeigt. Bei Vektorprodukten mit drei (und mehr) Vektoren sind daher Klammern

unbedingt erforderlich!

(c) Vergleicht man die Komponenten auf der rechten Seite von (25), so stellt man fest,

dass die y-Komponente aus der x-Komponente durch folgende Ersetzung vorgeht:

x 7→ y,

y 7→ z,

23

z 7→ x

(26)

Und die z-Komponente erhält man durch dieselbe Substitution aus der y-Komponente.

Diese Substitution nennt man zyklische Vertauschung (es wird im Kreis herum

ersetzt). Entsprechende Beobachtungen kann man bei vielen Formeln machen, bei

denen das Vektorprodukt vorkommt. Auch die Gleichungen (24) gehen durch zyklische Vertauschung ineinander über.

(d) Mit Hilfe von Determinanten (werden später behandelt) kann man die folgende

nützlich Merkregel für das Vektorprodukt formulieren

~ex ax bx ~a × ~b = ~ey ay by ~ez az bz Laplace-Entwicklung nach der 1. Spalte führt gerade auf (25). Es ist anzumerken,

dass es sich dabei nicht um eine richtige“ Determinante handelt, da die Einheits”

vektoren in Achsrichtung (anstelle von Skalaren) als Matrixelemente auftreten.

(e) Das Vektorprodukt ist nur für Vektoren im Raum, also mit drei Komponenten,

definiert!

Satz 2.5.2 Für alle Vektoren ~a, ~b, ~c im Raum gilt

(~a × ~b) × ~c = (~a · ~c) · ~b − (~b · ~c) · ~a

Den Beweis kann man führen, indem man mit etwas Geduld auf der linken und rechten

Seite zunächst die x-Komponente ausrechnet und die Übereinstimmung feststellt (siehe die

entsprechende Übungsaufgabe). Die Übereinstimmung der übrigen beiden Komponenten

erhält man dadurch, dass man sich klarmacht, dass die Ausdrücke für diese Komponenten

durch zyklische Vertauschung aus denen für die x-Komponente hervorgehen.

2.6

2.6.1

Beschreibung von Ebenen im Raum

Vektorielle Beschreibung

Abbildung 15: Der Ortsvektor jedes Punktes der Ebene kann in der Form ~x = t~a + s~b

geschrieben werden.

Der Ortsvektor ~x jedes Punktes in der Ebene kann in der Form

~x = t~a + s~b

24

mit s, t ∈ R geschrieben werden, wenn die beiden Vektoren ~a 6= 0 und ~b 6= 0 erfüllen

und nicht in dieselbe oder in die entgegengesetzte Richtung zeigen. Dies ist in Abb. 15

veranschaulicht. Wenn nun zwei Vektoren im Raum ~a 6= 0 und ~b 6= 0 erfüllen und nicht

in dieselbe oder in die entgegengesetzte Richtung zeigen, dann nennt man die Menge

aller Punkte der Form ~x = t~a + s~b die von ~a und ~b aufgespannten Ebene durch den

Ursprung (denn mit s = 0 und t = 0 erhält man ~x = ~0). Durch Addition eines festen

Vektors ~c verschiebt man diese Ebene. Wir erhalten somit die vektorielle Beschreibung

einer Ebene im Raum durch

E = {~x | ~x = t~a + s~b + ~c, s, t ∈ R}

(27)

Dabei können s, t ∈ R beliebige Werte annehmen. Die Wahl s = t = 0 führt auf ~x = ~c,

also ist ~c Ortsvektor eines Punktes der Ebene. Die Gleichung ~x = t~a + s~b + ~c wird auch

als vektorielle Ebenengleichung bezeichnet. Beachten Sie, dass bei gegebener Ebene (als

Menge von Punkten) die Auswahl der drei Vektoren nicht eindeutig ist. Dies kann man

sich am Spezialfall der xy-Ebene an Abb. 15 leicht klarmachen.

Wenn die Ebene durch die Angabe von drei Punkten P1 , P2 und P3 gegeben ist,

die in der Ebene liegen, dann erhält man die vektorielle Ebenengleichung der Form (27)

beispielsweise durch

−−→

−→

−−→

~b = −

~a = P1 P2 ,

P1 P3 ,

~c = OP1

2.6.2

Beschreibung einer Ebene durch einen Normalenvektor

Die Richtung einer Ebene kann man dadurch festlegen, dass man einen Vektor ~v 6= ~0

angibt, der senkrecht auf der Ebene steht. Dieser Vektor heißt dann Normalenvektor. Alle

Ebenen, die zueinander parallel sind, können durch denselben Normalenvektor beschrieben werden. Beachten Sie, dass der Normalenvektor nicht eindeutig ist, wir können ihn

länger oder kürzer wählen oder seine Richtung umkehren (durch −~v ersetzen), ohne die

Richtung der Ebene zu ändern. Die Ebene wird dann dadurch festgelegt, dass man einen

−→

Punkt P (mit Ortsvektor ~a = OP ) der Ebene angibt. Man kann Abb. 11 rechts als Schnitt

−→

durch eine derartige Ebene auffassen. Der Verbindungsvektor ~b = P Q zu einem beliebigen

−→

Punkt Q mit Ortsvektor ~x = OQ muss dann senkrecht auf dem Normalenvektor stehen,

also muss auch hier gelten

0 = ~v · ~b = ~v · (−~a + ~x) = −~v · ~a + ~v · ~x

Die Ortsvektoren ~x beliebiger Punkte der Ebene erfüllen also die Gleichung

~v · ~x = ~v · ~a

(28)

wobei ~a der Ortsvektor des gegebenen Punktes der Ebene und ~v ein Vektor senkrecht auf

der Ebene ist. Wir haben damit die Gleichung (15) wiedergewonnen mit dem Unterschied,

dass hier eine Ebene im Raum beschrieben wird.

Wir merken uns:

Alle Punkte des Raumes, deren Ortsvektoren ~x die Gleichung

~v · ~x = r

(29)

mit gegebenem r ∈ R erfüllen, liegen auf einer Ebene senkrecht zu ~v . Wenn ~v und ein

Punkt der Ebene durch seinen Ortsvektor ~a gegeben ist, dann kann daraus die Konstante

r = ~v · ~a berechnet werden.

25

Wir fassen weiterhin Abb. 11 rechts als Schnitt durch eine derartige Ebene auf. Dann

können wir die Vorgehensweise von Abschnitt 2.4.2 auf Ebenen übertragen und ganz

analog den Abstand einer Ebene vom Ursprung berechnen, die durch eine Gleichung

der Form (29) gegeben ist. Dabei können wir die Rechnung und die Erklärung von Abschnitt 2.4.2 fast unverändert übernehmen, lediglich das Wort Gerade“ ist durch das

”

Wort Ebene“ zu ersetzen. Wir verlängern oder verkürzen also wieder den Normalen”

vektor ~v , bis wir auf die Ebene treffen, und berechnen so den Fußpunkt des Lotes vom

Ursprung auf die Ebene. Wir erhalten damit ein Ergebnis der selben Form:

Eine Ebene, die durch eine Gleichung der Form (29) gegeben ist, hat den Abstand d vom

Ursprung mit

|r|

(30)

d=

|~v |

Auch hier können wir die Gleichung (29) etwas anders schreiben, indem wir die Vorgehensweise von Abschnitt 2.4.2 unverändert übertragen: Division beider Seiten durch ±|~v |

und Einführung des Vektors

(

1

~v falls r ≥ 0

|~v |

~u :=

1

− |~v| ~v falls r < 0

liefert:

Die Ortsvektoren ~x der Punkte einer Ebene erfüllen eine Gleichung der Form

~u · ~x = d

(31)

Dabei ist ~u ein Einheitsvektor, der senkrecht auf der Ebene steht, und d der Abstand der

Ebene vom Ursprung. Diese Gleichung heißt Hessesche Normalform der Ebenengleichung.

Am Ende von Abschnitt 2.6.1 wurde beschrieben, wie man die vektorielle Beschreibung

einer Ebene erhält, die durch drei Punkte festgelegt ist, deren Ortsvektoren man kennt.

Von der vektoriellen Ebenengleichung (27) erhält man mit Hilfe des Vektorprodukts sofort

einen Normalenvektor durch

~v = ~a × ~b

−−→

Da ein Punkt der Ebene mit Ortsvektor ~c = OP1 bekannt ist, kann man die Konstante

r = ~v ·~c in (29) berechnen. Man kann auf diese Weise die Gleichung einer Ebene aufstellen,

die durch die Angabe dreier Punkte gegeben ist.

3

3.1

3.1.1

Lineare Gleichungssysteme

Gauß-Verfahren

Einfaches Beispiel, Rückwärtsauflösen

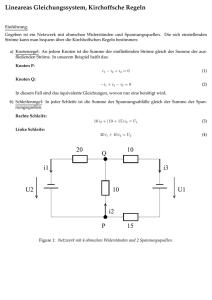

Lineare Gleichungssysteme treten in fast allen Anwendungen der Mathematik in der Technik auf. Betrachten wir als Beispiel das in Abb. 16 gezeigte Beispiel eines elektrischen

Netzes. Wir bezeichnen die unbekannten Ströme mit x1 = I1 , x2 = I2 , x3 = I3 und wollen hier auf die Angabe der Maßeinheit A für Ampère verzichten. Die Anwendung der

26

Abbildung 16: Einfaches Netz: Ströme gesucht

Kirchhoffschen Regeln liefert

x1

−x2 −x3 = 0

10x2 −6x3 = 0

6x3 = 12

Dies ist ein Beispiel für ein lineares Gleichungssystem: linear deswegen, weil die Unbekannten nur in der ersten Potenz und auch nicht als Argument in Funktionen wie der

Wurzel vorkommen, System, weil es sich um mehrere Gleichungen handelt.

Das hier vorliegende Gleichungssystem hat eine sehr spezielle Form: es liegt in Dreiecksform vor, die Terme in der linken unteren Hälfte fehlen (weil die Koeffizienten null

sind). Derartige Gleichungssysteme sind sehr leicht aufzulösen. Wir multiplizieren beide

Seiten der dritten Gleichung mit 61 und erhalten

x3 = 2

Einsetzen in die 2. Gleichung liefert

10x2 − 6 · 2 = 0

Durch Addition von 12 auf beiden Seiten erhält man

10x2 = 12

und Multiplikation beider Seiten mit

1

10

liefert

x2 =

12

= 1, 2

10

Einsetzen der Ergebnisse für x2 und x3 in die 1. Gleichung ergibt

x1 − 1, 2 − 2 = 0

Durch Addition von 3, 2 auf beiden Seiten erhält man daraus

x1 = 3, 2

Dieses Verfahren heißt Rückwärtseinsetzen oder Rückwärtsauflösen.

27

3.1.2

Umwandlung in Dreiecksform, einfaches Beispiel

Wir gehen von folgendem Gleichungssystem aus:

2x1 +3x2 −5x3 = 10

4x1 +8x2 −3x3 = 19

−6x1 +x2 +4x3 = 11

(Z1)

(Z2)

(Z3)

Das Ziel ist es, dieses Gleichungssystem in Dreiecksform umzuwandeln, es also in die Form

zu bringen

∗x1 + ∗ x2 + ∗ x3 = ∗

0x1 + ∗ x2 + ∗ x3 = ∗

0x1 +0x2 + ∗ x3 = ∗

Dabei steht ∗ für noch zu berechnende Zahlen, die also alle verschieden sein können.

Die Umwandlung des ursprünglichen Gleichungssystems soll so erfolgen, dass sich die

Lösungsmenge nicht ändert.

Wir behalten hierzu die oberste Zeile bei (sie hat ja schon die gewünschte Form) und

addieren in einem ersten Schritt Vielfache der ersten Zeile zu den beiden andern Zeilen,

und zwar so, dass in der linken Spalte Nullen entstehen. Addiert man das (−2)-fache der

1. Zeile

−4x1 −6x2 +10x3 = −20

zur 2. Zeile

4x1 +8x2 −3x3 = 19

(Z2)

so erhält man als neue 2. Zeile

0x1 +2x2 +7x3 = −1

(Z20 )

Entsprechend liefert Addition des 3-fachen der 1. Zeile

6x1 +9x2 −15x3 = 30

zur 3. Zeile

−6x1 +x2 +4x3 = 11

(Z3)

die neue 3. Zeile

0x1 +10x2 −11x3 = 41

Durch diese beiden Operationen haben wir

system

2x1 +3x2 −5x3

0x1 +2x2 +7x3

0x1 +10x2 −11x3

(Z30 )

in einem ersten Schritt das neue Gleichungs= 10

= −1

= 41

(Z1)

(Z20 )

(Z30 )

erhalten. Wir setzen diese Methode in einem zweiten Schritt auf das entstandene kleinere

System (ohne die erste Zeile) fort:

+2x2 +7x3 = −1

+10x2 −11x3 = 41

Addition des (−5)-fachen der Zeile (Z20 )

−10x2 −35x3 = 5

28

(Z20 )

(Z30 )

zur untersten Zeile

(Z30 )

+10x2 −11x3 = 41

liefert die neue unterste Zeile (Z300 )

0x2 −46x3 = 46

(Z300 )

Wir haben also insgesamt das ursprüngliche Gleichungssystem in die gewünschte Dreiecksform gebracht

2x1 +3x2 −5x3 = 10

(Z1)

+2x2 +7x3 = −1

(Z20 )

−46x3 = 46

(Z300 )

Rückwärtsauflösen liefert

x3 = −1

2x2 − 7 = −1,

2x2 = 6,

x2 = 3

2x1 + 9 + 5 = 10,

2x1 = −4,

x1 = −2

Für praktische Rechnungen ist die Probe durch Einsetzen der Lösung in das urprüngliche

Gleichungssystem dringend zu empfehlen. Wenn Sie die Lösung mit einem Rechner berechnen, dann lassen Sie den Rechner die Probe durchführen!

Probe:

2 · (−2) + 3 · 3 − 5 · (−1) = −4 + 9 + 5 = 10

4 · (−2) + 8 · 3 − 3 · (−1) = −8 + 24 + 3 = 19

−6 · (−2) + 3 + 4 · (−1) = 12 + 3 − 4 = 11

Zur Erinnerung: Das Morsezeichen ·−“hat in der Mathematik nichts zu suchen. Daher

”

dürfen die Klammern in dieser Rechnung nicht weggelassen werden!

3.1.3

Weiteres Beispiel zur Umwandlung in Dreiecksform in Kurzschreibweise

2x1 +x2 +x3 =

1

4x1 +x2

= −2

−2x1 +2x2 +x3 =

7

Bei der Rechnung kommt es nur auf die Koeffizienten vor den Unbekannten und die Zahlen

auf der rechten Seite an, daher genügt es, nur diese zu notieren. Hierfür sind verschiedene

Kurzschreibweisen üblich.

Hier wird zunächst eine gemäßigte“ Kurzschreibweise für die Lösung des Gleichungs”

systems angegeben. Sie führt zur Schreibweise des Gleichungssystems mit einer Matrix,

die später behandelt wird. Die Vorgehensweise erfolgt analog zu der des vorangegangenen

Unterabschnitts. Es wird jeweils die oberste Zeile unverändert gelassen und es werden

Vielfache dieser obersten Zeile zu den unteren Zeilen addiert, und zwar so, dass ganz links

29

der Koeffizient 0 entsteht.

2

1

1

1

4

1

0 −2

−2

2

1

7

2

1

1

1

0 −1 −2 −4

0

3

2

8

2

1

1

1

0 −1 −2 −4

0

0 −4 −4

·(−2)

←-

·1

↓

←

·3

←-

Das entstehende Gleichungsystem in Dreiecksform ergibt sich aus dem untersten Abschnitt. Ausführlich aufgeschrieben lautet es

2x1 +x2 +x3 =

1

−x2 −2x3 = −4

−4x3 = −4

Rückwärtsauflösen ergibt:

−4x3 = −4,

x3 = 1

−x2 − 2 = −4,

x2 = 2

2x1 + 2 + 1 = 1,

2x1 = −2,

x1 = −1

Eine noch kompaktere Schreibweise für die Lösung des Gleichungssystems entsteht dadurch, dass die Zeilen, die im weiteren Verlauf des Verfahrens nicht weiter verändert

werden, auch nicht mehr aufgeschrieben werden. Sie werden stattdessen durch eine Einrahmung gekennzeichnet:

2

4

−2

1

1

1

1

0 −2

2

1

7

−1 −2 −4

3

2

8

−4 −4

·(−2)

←-

·1

↓

←

·3

←-

Das entstehende Gleichungsystem in Dreiecksform ergibt sich dann am Schluss aus den

eingerahmten Zeilen. Es wird dann durch Rückwärtsauflösen gelöst. Diese sehr kompakte

Kurzschreibweise ist nur zu empfehlen, wenn man das allgemeine Verfahren verstanden

hat und viel Übung besitzt, ansonsten ist die zuerst beschriebene gemäßigte“ Kurz”

schreibweise vorzuziehen, bei der die nicht veränderten Zeilen bei jedem Schritt erneut

aufgeschrieben werden.

30

3.1.4

Allgemeines Prinzip des Gauß-Verfahrens

Die allgemeine Form eines linearen Gleichungssystems von n Gleichungen mit n Unbekannten ist

a11 x1

a21 x1

a31 x1

a41 x1

..

.

+a12 x2

+a22 x2

+a32 x2

+a42 x2

..

.

+a13 x3

+a23 x3

+a33 x3

+a43 x3

..

.

+a14 x4

+a24 x4

+a34 x4

+a44 x4

..

.

+···

+···

+···

+···

...

an1 x1 +an2 x2 +an3 x3 +an4 x4 + · · ·

+a1n xn

+a2n xn

+a3n xn

+a4n xn

..

.

=

=

=

=

b1

b2

b3

b4

..

.

+ann xn = bn

Dabei ist es üblich, dass der Koeffizient in der i. Zeile und der k. Spalte (also der Koeffizient der k. Unbekannten in der i. Zeile) mit aik bezeichnet wird. Die erste Nummer der

Koeffizienten gibt also stets die Nummer der Zeile an. Die Lösungsmenge eines linearen

Gleichungssystems ist die Menge der {x1 , x2 , x3 , x4 , . . . xn }, die dieses Gleichungssystem

erfüllen. Wir setzen hier zunächst voraus, dass wir genausoviele Gleichungen wie Unbekannte haben; der allgemeine Fall wird später behandelt.

Satz 3.1.1 Folgende Operationen lassen die Lösungsmenge eines linearen Gleichungssystems unverändert:

(a) Vertauschen zweier Zeilen

(b) Multiplikation einer Zeile mit einer beliebigen Zahl c 6= 0, c ∈ R

(c) Addition eines beliebigen Vielfachen einer Zeile zu einer andern Zeile

Hinweis: a) und b) sind unmittelbar klar. Entscheidend dafür, dass sich die Lösungsmenge

bei der Umwandlung des Gleichungssystems nicht ändert, ist dass man den Umwandlungsschritt rückgängig machen kann. Die Addition des c-fachen einer Zeile zu einer andern kann

man durch die Addition des −c-fachen dieser Zeile zu der andern Zeile wieder rückgängig

machen. Die Addition des Nullfachen einer Zeile zu einer anderen ändert gar nichts, also

braucht man hier auch keine Voraussetzung an die Konstante c.

Das Gauß-Verfahren besteht nun darin, dass man durch diese Operationen, die die

Lösungsmenge unverändert lassen, ein beliebiges Gleichungssystem in Dreiecksform bringt.

Durch Addition des c-fachen der 1. Zeile zur 2. Zeile entsteht dort als 1. Summand

(c · a11 + a21 )x1 . Damit dieser wegfällt, muss die Bedingung (c · a11 + a21 ) = 0 erfüllt

. Analog kann

sein. Für den Fall, dass a11 6= 0, erreicht man dies durch die Wahl c = − aa21

11

man für die anderen Zeilen vorgehen. Wir haben also als

1. Schritt des Gauß-Verfahrens:

(a) Wenn a11 6= 0, dann führe folgende Operation für k = 2, 3, 4, . . . n durch:

Addiere das − aak1

-fache der 1. Zeile zur k. Zeile.

11

Dadurch hat man nach Durchlaufen dieser Schleife unterhalb von a11 nur noch

Nullen stehen.

(b) Wenn a11 = 0, dann prüft man für k = 2, 3, 4, . . . n, ob ein ak1 6= 0

31

(a) Wenn ein Koeffizient ak1 6= 0, dann vertauscht man die 1. und die k. Zeile und

führt dann den hier beschriebenen 1. Schritt von vorne durch (dann ist das

neue a11 6= 0).

(b) Wenn für alle Koeffizienten der Spalte a11 = 0, a21 = 0, a31 = 0, . . . an1 = 0 gilt

(die erste Spalte also nur aus Nullen besteht), dann geht man eine Spalte nach

rechts und ersetzt a11 durch den Koeffizienten, der in derselben Zeile weiter

rechts steht, also durch a12 und führt alle hier für den 1. Schritt beschriebenen

Operationen durch, wobei überall in der Beschreibung die Koeffizienten ak1

durch ak2 zu ersetzen ist. Wenn dies nicht zum Erfolg führt, wenn also erneut

a12 = 0, a22 = 0, a32 = 0, . . . an2 = 0, dann geht man nochmal eine Spalte

weiter nach rechts und ersetzt in dieser Beschreibung des 1. Schritts a11 durch

a13 (und alle weiteren Koeffizienten ak1 durch ak3 ). Führt dies wieder nicht

zum Erfolg, wenn also alle Koeffizienten der Spalte, in der man arbeitet, Null

sind, dann geht man nochmal eine Spalte weiter nach rechts. Dies wird so lange

fortgesetzt, bis man auf einen Koeffizienten stößt, der von Null verschieden ist.

Wenn dies nicht der Fall ist, dann stehen nur noch Nullen im Gleichungssystem,

und man hat nichts mehr zu tun.

Als Ergebnis dieses 1. Schrittes erhält man ein Gleichungssystem der Form

a011 x1

0x1

0x1

0x1

..

.

0x1

+a012 x2

+a022 x2

+a032 x2

+a042 x2

..

.

+a013 x3

+a023 x3

+a033 x3

+a043 x3

..

.

+a014 x4

+a024 x4

+a034 x4

+a044 x4

..

.

+···

+···

+···

+···

...

+a0n2 x2 +a0n3 x3 +a0n4 x4 + · · ·

+a01n xn

+a02n xn

+a03n xn

+a04n xn

..

.

=

=

=

=

b01

b02

b03

b04

..

.

+a0nn xn = b0n

Dabei wurden die Koeffizienten hier mit a0ik bezeichnet, da sie sich durch die Rechenoperationen des ersten Schritts geändert haben (die erste Zeile hat sich nur bei einem

Zeilentausch geändert).

Im nächsten Schritt wird die erste Zeile unverändert gelassen und nur noch das kleinere

Gleichungssystem

a022 x2 +a023 x3

a032 x2 +a033 x3

a042 x2 +a043 x3

..

..

.

.

0

0

an2 x2 +an3 x3

+a024 x4 + · · ·

+a034 x4 + · · ·

+a044 x4 + · · ·

..

...

.

+a0n4 x4 + · · ·

+a02n xn = b02

+a03n xn = b03

+a04n xn = b04

..

..

.

.

0

+ann xn = b0n

weiterbearbeitet. Im zweiten Schritt werden dieselben Operationen wie im ersten Schritt

durchgeführt, nur dass jetzt von a022 ausgegangen wird. Im einzelnen heißt dies:

2. Schritt des Gauß-Verfahrens:

(a) Wenn a022 6= 0, dann führe folgende Operation für k = 3, 4, . . . n durch:

a0

Addiere das − ak2

0 -fache der 2. Zeile zur k. Zeile.

22

Dadurch hat man nach Durchlaufen dieser Schleife unterhalb von a022 nur noch

Nullen stehen.

32

(b) Wenn a022 = 0, dann prüft man für k = 3, 4, . . . n, ob ein a0k2 6= 0

(a) Wenn ein Koeffizient a0k2 6= 0, dann vertauscht man die 2. und die k. Zeile und

führt dann den hier beschriebenen 2. Schritt von vorne durch (dann ist das

neue a022 6= 0).

(b) Wenn für alle Koeffizienten der Spalte a022 = 0, a032 = 0, . . . a0n2 = 0 gilt (die

zweite Spalte also nur aus Nullen besteht), dann geht man eine Spalte nach

rechts und ersetzt a022 durch den Koeffizienten, der in derselben Zeile weiter

rechts steht, also durch a023 und führt alle hier für den 2. Schritt beschriebenen

Operationen durch, wobei überall in der Beschreibung die Koeffizienten ak2

durch ak3 zu ersetzen ist. Wenn dies nicht zum Erfolg führt, wenn also erneut

a023 = 0, a033 = 0, . . . a0n3 = 0, dann geht man nochmal eine Spalte weiter nach

rechts und ersetzt in dieser Beschreibung des 2. Schritts a022 durch a024 (und

alle weiteren Koeffizienten a0k2 durch a0k4 ). Führt dies wieder nicht zum Erfolg,

wenn also alle Koeffizienten der Spalte, in der man arbeitet, Null sind, dann

geht man nochmal eine Spalte weiter nach rechts. Dies wird so lange fortgesetzt,

bis man auf einen Koeffizienten stößt, der von Null verschieden ist. Wenn dies

nicht der Fall ist, dann stehen nur noch Nullen im Gleichungssystem, und man

hat nichts mehr zu tun.

Als Ergebnis dieses 2. Schrittes erhält man ein Gleichungssystem der Form

a0022 x2 +a0023 x3

0x2 +a0033 x3

0x2 +a0043 x3

..

..

.

.

0x2 +a00n3 x3

+a0024 x4 + · · ·

+a0034 x4 + · · ·

+a0044 x4 + · · ·

..

...

.

+a00n4 x4 + · · ·

+a002n xn = b002

+a003n xn = b003

+a004n xn = b004

..

..

.

.

+a00nn xn = b00n

Dabei wurden die Koeffizienten hier mit a00ik bezeichnet, da sie sich durch die Rechenoperationen des zweiten Schritts geändert haben. Im nächsten Schritt wird die zweite Zeile

unverändert gelassen und nur noch das kleinere Gleichungssystem

a0033 x3 +a0034 x4 + · · ·

a0043 x3 +a0044 x4 + · · ·

..

..

..

.

.

.

00

00

an3 x3 +an4 x4 + · · ·

+a003n xn = b003

+a004n xn = b004

..

..

.

.

00

+ann xn = b00n

weiterbearbeitet. Im dritten Schritt werden dieselben Operationen wie in den ersten beiden Schritten durchgeführt, nur dass jetzt von a0033 ausgegangen wird. Im einzelnen heißt

dies:

3. Schritt des Gauß-Verfahrens:

(a) Wenn a0033 6= 0, dann führe folgende Operation für k = 4, 5, . . . n durch:

a00

Addiere das − ak3

00 -fache der 3. Zeile zur k. Zeile.

33

Dadurch hat man nach Durchlaufen dieser Schleife unterhalb von a0033 nur noch

Nullen stehen.

33

(b) Wenn a0033 = 0, dann prüft man für k = 4, 5, . . . n, ob ein a0k3 6= 0

(a) Wenn ein Koeffizient a00k3 6= 0, dann vertauscht man die 2. und die k. Zeile und

führt dann den hier beschriebenen 2. Schritt von vorne durch (dann ist das

neue a0033 6= 0).

(b) Wenn für alle Koeffizienten der Spalte a0033 = 0, a0043 = 0, . . . a00n3 = 0 gilt (die

zweite Spalte also nur aus Nullen besteht), dann geht man eine Spalte weiter

nach rechts. Dies wird so lange fortgesetzt, bis man auf einen Koeffizienten

stößt, der von Null verschieden ist. Wenn dies nicht der Fall ist, dann stehen

nur noch Nullen im Gleichungssystem, und man hat nichts mehr zu tun.

Als Ergebnis dieses 3. Schrittes erhält man ein Gleichungssystem der Form

000

a000

33 x3 +a34 x4 + · · ·

0x3 +a000

44 x4 + · · ·

..

..

..

.

.

.

000

0x3 +an4 x4 + · · ·

000

+a000

3n xn = b3

000

+a000

4n xn = b4

..

..

.

.

000

+ann xn = b000

n

Dabei wurden die Koeffizienten hier mit a000

ik bezeichnet, da sie sich durch die Rechenoperationen des dritten Schritts geändert haben. Man setzt das Verfahren nun mit dem

kleineren Gleichungssystem

a000

44 x4 + · · ·

..

..

.

.

000

an4 x4 + · · ·

000

+a000

4n xn = b4

..

..

.

.

000

+ann xn = b000

n

in einem 4. Schritt analog zu den bisherigen fort. Nach insgesamt (n − 1) derartigen

Schritten hat man das ursprüngliche Gleichungsystem umgewandelt in ein System in

Dreiecksform

a11 x1 +a12 x2 +a13 x3 +a14 x4

a22 x2 +a23 x3 +a24 x4

a33 x3 +a34 x4

a44 x4

+···

+···

+···

+···

...

+a1n xn

+a2n xn

+a3n xn

+a4n xn

..

.

ann xn

=

=

=

=

b1

b2

b3

b4

..

.

= bn

Dabei wurde zur Vereinfachung wieder die ursprüngliche Bezeichnungsweise aik der Koeffizienten gewählt — ohne die Striche, die andeuteten, dass sich die Koeffizienten bei der

Durchführung der Umwandlung ändern, also nicht mit denen des ursprünglichen Systems

übereinstimmen.

Zur Berechnung der Unbekannten hat man folgende Fälle zu unterscheiden:

(a) Wenn ann 6= 0, dann können die Unbekannten sofort durch Rückwärtseinsetzen

n

berechnet werden: xnn = abnn

, an−1,n−1 xn−1 + an−1,n xn = bn−1 und damit

xn−1 =

bn−1 − an−1,n ·

bn

ann

an−1,n−1

und entsprechend für die weiteren Unbekannten. Wie man aus der Umwandlung in

die Dreiecksform sieht, ist es nur möglich, dass ann 6= 0, wenn bei der Umwandlung

34

in Dreiecksform nirgends der Sonderfall auftritt, dass eine vollständige Spalte von

Nullen vorliegt und die weitere Bearbeitung eine Spalte weiter rechts fortgesetzt

werden muss. Wenn ann 6= 0, dann gilt in der Dreiecksform für alle übrigen Diagonalelemente a11 6= 0, a22 6= 0, a33 6= 0, . . . an−1,n−1 6= 0. Das Rückwärtsauflösen führt

dann zu einer eindeutigen Lösung x1 , x2 , x3 . . . xn .

(b) Falls ann = 0 und bn 6= 0, dann hat das Gleichungssystem keine Lösung, d.h. die

Lösungsmenge ist dann leer, denn die letzte Zeile in Dreiecksform 0 · xn = bn hat

keine Lösung xn ∈ R.

(c) Falls ann = 0 und bn = 0, dann ist die letzte Zeile in Dreiecksform 0·xn = 0 für beliebige xn ∈ R erfüllt. Man hat dann auf jeden Fall unendlich viele Lösungen, und man

kann mit Hilfe des Gleichungssystems in Dreiecksform versuchen, die Lösungsmenge

zu charakterisieren. Dies soll zunächst an den Beispielen besprochen werden.

Definition 3.1.1 Ein lineares Gleichungssystem mit n Gleichungen und n Unbekannten

heißt singulär, wenn nach der Umwandlung in Dreiecksform mit dem Gauß-Verfahren

der Koeffizient ann = 0 erfüllt. Wenn dagegen ann 6= 0, dann heißt das Gleichungssystem

nichtsingulär.

Hinweis: Ein singuläres Gleichungssystem kann also keine oder unendlich viele Lösungen

haben, ein nichtsinguläres Gleichungssystem hat stets eine eindeutig bestimmte Lösung.

3.2

Geometrische Deutung linearer Gleichungssysteme

Schauen wir uns zunächst ein Beispiel an der Form

a11 x1 +a12 x2 = b1

a21 x1 +a22 x2 = b2

(32)

Wenn wir die in der ersten Zeile stehenden Koeffizienten und die Unbekannten zu einem

Vektor zusammenfassen, also

a11

x1

~u :=

und

~x :=

x2

a12

definieren, dann können wir die erste Zeile schreiben als

~u · ~x = b1

Dies ist die Gleichung einer Geraden senkrecht zu ~u in der Form der Gleichung (16). Wenn

a12 6= 0, dann können wir die erste Zeile des Gleichungssytems mit x1 = x und x2 = y

auch in der gewohnten Form einer Geradengleichung

y=−

a11

b1

x+

a12

a12

schreiben.

Analog können wir mit

a21

~v :=

a22

35

die zweite Gleichung als Gleichung einer Geraden senkrecht zu ~v in der Form

~v · ~x = b2

oder, falls a22 6= 0, in der vertrauten Form

y=−

b2

a21

x+

a22

a22

schreiben.

Das Gleichungssystem zu lösen bedeutet also, den Schnittpunkt zweier Geraden in der

Ebene zu berechnen! Hier können verschiedene Situationen vorliegen:

(a) Im allgemeinen schneiden sich die beiden Geraden in genau einem Punkt. Dann hat

das Gleichungssystem genau eine Lösung.

(b) Es kann aber auch vorkommen, dass die beiden Geraden parallel, aber verschieden

sind. Dann haben sie keinen Schnittpunkt, und die Lösungsmenge des Gleichungssystems ist leer. In diesem Fall haben die beiden Normalenvektoren dieselbe (oder

entgegengesetzte) Richtung, also ein Normalenvektor ist ein Vielfaches des anderen,

~u = s~v

oder

~v = t~u

und durch Addition des (−t)-fachen der ersten Zeile zur zweiten kann man diese in

die Form

0x1 + 0x2 = b2 − tb1

bringen. Wenn die beiden Geraden verschieden sind, dann ist b2 − tb1 6= 0 und diese

Gleichung hat keine Lösung. Das Gleichungssystem ist in diesem Fall aufgrund der

angegebenen neuen Form der zweiten Zeile singulär.

(c) Wenn die beiden Geraden zusammenfallen, dann sind alle Punkte dieser Gerade

Elemente der Lösungsmenge des Gleichungssystems. Rechnerisch heißt dies, dass

die zweite Zeile ein Vielfaches des ersten ist (oder umgekehrt). Dann können wir

mit dem Gauß-Verfahren die zweite Zeile in die Form

0x1 + 0x2 = 0

bringen. Auch in diesem Fall ist das Gleichungssystem singulär. Hier sind alle reellen

Zahlen x1 und x2 Lösung dieser Gleichung. Dann können wir beispielsweise für

x2 eine beliebige reelle Zahl t wählen, also x2 = t schreiben und dann die erste

Gleichung nach x1 auflösen:

a12

b1

−

t

x1 =

a11 a11

Man kann das Ergebnis dann auch vektoriell schreiben

b1 a12 − a11

~x = a11 + t

1

0

Das ist die vektorielle Form einer Geradengleichung.

36

Ob der Normalfall“ (genau eine Lösung) oder einer der beiden Sonderfälle“ (keine oder

”

”

unendlich viele Lösungen, Gleichungssystem singulär) auftreten, sieht man an den beiden

Vektoren ~u und ~v . Wenn ~u = s~v oder ~v = t~u, dann ist das System singulär und es

liegt einer der beiden Sonderfälle“ vor (welcher, das hängt von der rechten Seite ab).

”

Beachten Sie, dass zwei parallele Geraden identisch sind, wenn sie einen gemeinsamen

Punkt haben. Wenn b1 = b2 = 0, dann gehen beide Geraden durch den Ursprung, und

das Gleichungssystem hat genau eine oder unendlich viele Lösungen.

Schauen wir uns ein konkretes Beispiel an:

3x1 +x2 = 4

(33)

2x1 +x2 = 2

3

2

Wir erhalten ~u =

und ~v =

. Die beiden Geradengleichungen lauten in der

1

1

vertrauten Form

y = −3x + 4

und

y = −2x + 2

2

Die beiden Geraden schneiden sich im Punkt ~x =

(siehe auch die Abbildung 17)

−2

Es gibt noch eine zweite geometrische Interpretation unseres Gleichungssystems (32). Wir

Abbildung 17: geometrische Interpretationen des linearen Gleichungssystems (33): links

als Schnittpunkt der Geradengleichungen ~u · ~x = 4 und ~v · ~x = 2, rechts Darstellung

~b = x1 w

~ + x2~z

betrachten die spaltenweise aus den Koeffizienten der linken und rechten Seite gebildeten

Vektoren

a11

a12

~b := b1

w

~=

,

~z :=

und

a21

a22

b2

Wir können damit unser Gleichungssystem schreiben als

a11

a

x1

+ x2 12 = x1 · w

~ + x2 · ~z = ~b

a21

a22

37

Zu drei gegebenen Vektoren w,

~ ~z und ~b suchen wir also Skalare so, dass wir den dritten

~

Vektor b als Summe von Vielfachen der beiden anderen schreiben können. Machen Sie sich

anhand der Abbildung 17 klar, dass dies immer möglich ist, wenn die beiden Vektoren der

linken Seite ein Parallelogramm aufspannen. Dort sind die Zahlenwerte unseres Beispiels

(33) zugrunde gelegt.