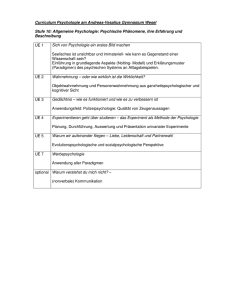

Paradigmen der Psychologie Kap8_9

Werbung