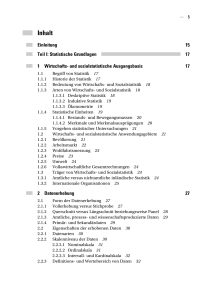

Statistik

Werbung