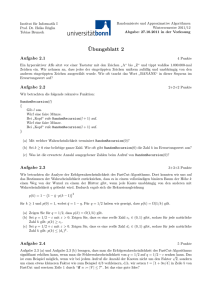

4 Diskrete Wahrscheinlichkeitsverteilungen

Werbung

4

Diskrete Wahrscheinlichkeitsverteilungen

4.1

Wahrscheinlichkeitsräume, Ereignisse und Unabhängigkeit

Definition: Ein diskreter Wahrscheinlichkeitsraum ist ein Paar (Ω, p), wobei Ω eine

endliche oder abzählbar unendliche Menge von elementaren Ereignissen und p : Ω −→

[0, 1] eine Wahrscheinlichkeitsverteilung ist, die jedem

P ω ∈ Ω seine Wahrscheinlichkeit

p(ω) zuordnet. Außerdem wird gefordert, daß ω∈Ω p(ω) = 1 ist. Wenn Ω = n

endlich ist für alle ω ∈ Ω auch p(ω) = n1 gilt, dann wird p eine Gleichverteilung

genannt.

Beispiele:

1) Für einen (fairen) Würfel ist Ω = {1, 2, 3, 4, 5, 6} und p(1) = p(2) = . . . = p(6) = 16

eine Gleichverteilung.

2) Der diskrete Wahrscheinlichkeitsraum für einen Münzwurf besteht aus Ω = {0, 1}

mit p(0) = p(1) = 1/2 (Gleichverteilung), wobei 0 den Kopf und 1 die Zahl der Münze

bezeichnet.

3) Der diskrete Wahrscheinlichkeitsraum für zwei Münzwürfe besteht aus

Ω = {(0, 0), (0, 1), (1, 0), (1, 1)} mit der Gleichverteilung p(i, j) = 1/4. Dabei geht

man davon aus, daß die beiden Würfe voneinander unabhängig sind und entweder

hintereinander oder gleichzeitig mit zwei unterscheidbaren Münzen erfolgen.

4) Betrachtet man den gleichzeitigen Wurf von zwei ununterscheidbaren Münzen so

ist Ω = {{0, 0}, {0, 1}, {1, 1}}. In diesem Fall ist p (faire Münzen vorausgesetzt) keine

Gleichverteilung, denn p({0, 0}) = p({1, 1}) = 1/4 und p({0, 1}) = 1/2.

5) Definiert man eine Folge von Münzwürfen, bis das erste Mal Zahl (also 1) fällt,

als elementares Ereignis, dann gibt es offensichtlich für jedes n ∈ N+ ein elementares

n

Ereignis, nämlich die Folge ωn = 0, 0, . . . , 0, 1. Bei einer fairen Münze ist p(ωn ) = 12

| {z }

(n−1) mal

und damit ist auch für diesen unendlichen Raum die Summenbedingung erfüllt:

∞

X

n=1

p(ωn ) =

∞ n

X

1

n=1

2

=1

Definition: Eine

P beliebige Untermenge A ⊆ Ω wird Ereignis genannt, und man

definiert p(A) = ω∈A p(ω). Dadurch wird die Verteilungsfunktion zu einem Wahrscheinlichkeitsmaß über der Menge P(Ω) aller Ereignisse erweitert. Die Verwendung der

gleichen Bezeichnung p für die Verteilung und das Wahrscheinlichkeitsmaß ist eine

kleine technische Unsauberkeit, die aber in der Literatur weit verbreitet ist.

Beispiel: Die Wahrscheinlichkeit, eine gerade Zahl zu würfeln, ist gleich der Summe

der Wahrscheinlichkeiten, eine 2, 4 oder 6 zu würfeln, also 1/2.

Aus der Definition und dem kombinatorischen Basiswissen folgt:

1. p(Ω) = 1 und p(∅) = 0

33

2. A ⊆ B =⇒ p(A) ≤ p(B)

3. p(A ∪ B) = p(A) + p(B) − p(A ∩ B)

P

S

4. p(A) = ki=1 p(Ai ) für jede Partition A = ki=1 Ai

5. p(Ω \ A) = 1 − p(A)

S

P

6. p( ki=1 Ai ) ≤ ki=1 p(Ai ).

Oft taucht das Problem auf, die Wahrscheinlichkeit eines Ereignisses A unter der

zusätzlichen Voraussetzung zu bestimmen, daß ein anderes Ereignis B eingetreten ist.

So ist offensichlich unter der Vorausetzung, daß eine gerade Zahl gewürfelt wurde,

die Wahrscheinlichkeit der 1 gleich Null und die Wahrscheinlichkeit der 2 gleich 1/3.

Definition: Seien A und B Ereignisse und p(B) > 0. Dann ist die bedingte Wahrscheinlichkeit von A unter B definiert als

p(A|B) =

p(A ∩ B)

p(B)

Beispiel: Würfelt man mit zwei unabhängigen und unterscheidbaren Würfeln, dann

ist Ω = {(i, j) | 1 ≤ i, j ≤ 6} und p((i, j)) = 1/36 für jedes Paar (i, j) aus Ω.

Bezeichne A1 = {(i, j) ∈ Ω | i = 1} das Ereignis, daß der erste Würfel eine 1 zeigt und

der zweite beliebig ist. Analog kann man die Ereignisse A2 , . . . , A6 definieren. Ähnlich

können durch Festlegung der Augenzahl des zweiten Würfels Ereignisse B1 = {(i, j) ∈

Ω | j = 1}, B2 , . . . , B6 definiert werden. Offensichlich ist die Wahrscheinlichkeit

dieser Ereignisse jeweils 1/6 und Durchschnitte wie A1 ∩ B3 = {(1, 3)} haben die

Wahrscheinlichkeit 1/36. Folglich ist

p(A1 |B3 ) =

p(A1 ∩ B3 )

1/36

1

=

=

p(B3 )

1/6

6

und analog ist die bedingte Wahrscheinlichkeit von jedem Ai unter einem beliebigen

Bj gleich 1/6, also gleich der Wahrscheinlichkeit von Ai selbst. Diese Eigenschaft ist

durch die Unabhängikeit der beiden Würfel begründet.

Definition: Zwei Ereignisse A und B werden unabhängig genannt, falls p(A ∩ B) =

p(A)p(B).

Lemma: Sind A und B zwei unabhängige Ereignisse mit

p(A ∩ B) > 0, dann gilt p(A|B) = p(A) und p(B|A) = p(B).

Ereignisse mit positver Wahrscheinlichkeit, die einander ausschließen, wie zum Beispiel

A1 und A2 aus dem letzten Beispiel sind voneinander nicht unabhängig, also abhängig.

Ein Beispiel für abhängige Ereignisse beim Spiel mit einem Würfel ist der Wurf einer

geraden Zahl und der Wurf einer 2 oder auch der Wurf einer geraden Zahl und der

Wurf einer Zahl ≤ 3. Auch im folgenden Beispiel geht es um die Abhängigkeit von

Ereignissen.

34

Beispiel: Ein Krebstest fällt mit 96% Wahrscheinlichkeit positiv aus, wenn der Patient Krebs hat und mit 94% Wahrscheinlichkeit negativ, wenn der Patient keinen

Krebs hat. Bei einem Patienten in dessen Altersgruppe 0.5% aller Personen Krebs

haben, fällt der Test positiv aus. Wie wahrscheinlich ist es, dass er tatsächlich Krebs

hat?

Wir betrachten die folgenden Ereignisse

K zufälliger Patient hat Krebs

p(K) = 0.005

N zufälliger Patient hat keinen Krebs p(K) = 0.995

T

Test positiv bei zufälligen Patienten p(T ) =

)

Gesucht ist die bedingte Wahrscheinlichkeit p(K|T ) = p(K∩T

.

p(T )

)

Aus p(T |K) = p(K∩T

= 0.96 kann man p(K ∩ T ) = 0.005 · 0.96 ausrechnen.

p(K)

Dagegen ist p(T |N ) = 1 − p(T |N ) = 1 − 0.94 = 0.06. Zur Bestimmung von P (T )

überlegt man sich, dass das Ereignis T die disjunkte Vereinigung (T ∩K)∪(T ∩N ) ist

und sich die Wahrscheinlichkeiten der beiden Komponenten wieder durch bedingte

Wahrscheinlichkeiten ausdrücken lassen:

p(T ) = p(T |K) · p(K) + p(T |N ) · p(N ) = 0.96 · 0.005 + 0.06 · 0.995. Letzlich erhalten

wir

p(K ∩ T )

0.005 · 0.96

p(K|T ) =

=

= 0.0744 . . .

p(T )

0.96 · 0.005 + 0.06 · 0.995

Damit ist die Wahrscheinlichkeit, dass der Patient mit positiven Test wirklich Krebs

hat nur ca. 7.4%.

Definition: Sind (Ω1 , p1 ) und (Ω2 , p2 ) zwei Wahrscheinlichkeitsräume, dann ist der

Produktraum (Ω1 × Ω2 , p) definiert durch

p((ω1 , ω2 )) = p1 (ω1 )p2 (ω2 ).

Diese Definition impliziert Unabhägigkeiten der folgenden Form: für alle A ⊆ Ω1 und

B ⊆ Ω2 sind die Ereignisse A × Ω2 und Ω1 × B voneinander unabhängig. Ein Beispiel

dafür wurde bereits behandelt, denn der Wahrscheinlichkeitsraum für zwei Würfel ist

das Produkt des Raums eines Würfel mit sich selbst. Im folgenden werden endliche

Produkte des Münzwurfraums genauer analysiert:

• Sei eine faire Münze gegeben, die sechsmal geworfen wird. Der zugehörige

Wahrscheinlichkeitsraum besteht aus allen 0/1–Folgen der Länge 6, wobei die

Wahrscheinlichkeit jeder Folge gleich 216 ist. Wie groß ist die Wahrscheinlichkeit

des Ereignisses, daß genau zwei Einsen in der Folge auftreten? Die Anzahl

solcher Folgen stimmt offensichtlich mit der Anzahl der 2–Kombinationen

einer

6–Menge überein. Folglich hat das Ereignis die Wahrscheinlichkeit 62 /26 .

• Sei eine “unfaire” Münze gegeben, die mit Wahrscheinlichkeit q (0 < q < 1)

Zahl (d.h. 1) und mit Wahrscheinlichkeit 1 − q Kopf (d.h. 0) liefert. Betrachtet

man den Wahrscheinlichkeitsraum für n Münzwürfe, dann ist die Wahrscheinlichkeit einer festen Folge der Länge n mit genau k Einsen gleich q k (1 − q)n−k .

Die Wahrscheinlichkeit

des Ereignisses, daß eine Folge genau k Einsen enthält

ist nk q k (1 − q)n−k . Deshalb werden Verteilungen dieser Art auch Binomialverteilungen genannt.

35

4.2

Zufallsvariable und Erwartungswert

Definition: Sei (Ω, p) ein Wahrscheinlichkeitsraum. Eine Zufallsvariable oderZufallsgröße ist eine Funktion X : Ω −→ R.

Im Fall eines Würfels oder eine zufällig gezogenen Zahl aus einer Urne fällt der Unterschied zwischem elementaren Ereignis und Zufallsvariable nicht auf, weil das Ereignis

selbst schon eine Zahl ist, d.h. man kann die identische Abbildung als eine Zufallsvariable ansehen. Die folgenden Beispiele zeigen, dass man viele Zufallsexperimente auf

sehr natürliche Weise mit Zufallsvariablen beschreiben kann.

Beispiele:

1) Der diskrete Wahrscheinlichkeitsraum Ω = {1, 2, . . . , 6} × {1, 2, . . . , 6} für zwei

Münzwürfe sind Zufallsvariablen für die Summe und die Differenz der beiden Werte

interessant: X(a, b) = a + b

Y (a, b) = |a − b|.

2) Auf dem Wahrscheinlichkeitsraum für n Münzwürfe Ω = {0, 1}n interessiert man

sich vor allen für die Zufallsvariablen, welche die Anhzahl der Zahl- bzw. Kopfergebnisse in einer solchen Serie Zählen, d.h.

X(a1 , a2 , . . . , an ) = |{i | 1 ≤ i ≤ n und ai = 1}|

Y (a1 , a2 , . . . , an ) = |{i | 1 ≤ i ≤ n und ai = 0}| = n − X(a1 , a2 , . . . , an )

Man nennt X und Y (auch im Fall einer unfaieren Münze) binomialverteilt.

3) Bei der Wiederholung von Münzwürfen bis zur ersten Zahl (oder bis zum ersten

Kopf) ist offensichtlich die Länge des Experiments eine interessante zufälige Größe:

X(0, 0, . . . , 0, 1) = n

| {z }

(n−1) mal

Definition:

Der Erwartungswert der Zufallsvariablen X ist definiert als E(X) =

P

ω∈Ω X(ω)p(ω).

Im ersten und dritten Beispiel kann man Erwartungswerte relativ leicht ausrechen:

70

;

1) E(X) = 7 und E(Y ) = 36

P∞

1

3) E(X) = n=1 n · 2n = 2 (ist etwas schwerer);

Im zweiten Beispiel wäre eine direkte Auswertung recht schwierig, aber der folgende

Fakt macht die Berechnung sehr einfach.

Lemma: Der Erwartungswert ist additiv, d.h. für beliebige Zufallsvariable X, Y :

Ω −→ R gilt E(X + Y ) = E(X) + E(Y ) wobei die neue Variable X + Y in naheliegender Weise durch (X + Y )(w) = X(w) + Y (w) definiert ist.

Anwendungen:

• Wir betrachten die binomialverteilte Zufallsvariable X aus Beispiel 2, die jedem

0/1–Tupel der Länge n die Anzahl seiner Einsen zuordnet. Um das Beispiel

noch etwas allgemeiner zu machen, betrachten wir eine unfaire Münze, die mit

Wahrscheinlichkeit q eine 1 (Zahl) und mit Wahrscheinlichkeit 1 − q eine 0

36

(Kopf) liefert. Gruppiert man die Folgen derart, daß alle

P Folgenmit genau k

Einsen einer Gruppe angehören, so erhält man E(X) = nk=0 k nk q k (1 − q)n−k

und es ist relativ aufwändig daraus E(X) = nq abzuleiten. Durch Nutzung der

Additivität der Erwartungswerte kann man diese Formel einfacher erhalten:

Offensichtlich ist X = X1 + X2 + . . . + Xn wobei die Variable Xi angewendet

auf eine Folge von Münzwurfergebnissen (a1 , . . . , an ) das Ergebnis des i-ten

Wurfs auswertet, also Xi ((a1 , . . . , an )) = ai . Da die Erwartungswerte dieser

Summanden jeweils q sind folgt E(X) = E(X1 ) + . . . + E(Xn ) = nq.

• 2) Eine Versicherung macht folgende Kalkulation: Jeder Versicherte zahlt 100

DM ein. Mit Wahrscheinlichkeit von 1/20 (also 5 %) muß eine Leistung von

1000 DM und mit Wahrscheinlichkeit 1/10 eine muß eine Leistung von 400

DM erbracht werden. Wie hoch ist der Erwartetungswert für den Gewinn (pro

Versicherungsnehmer)?

Der zu betrachtende Wahrscheinlichkeitsraum hat drei Elementarereignisse ω1 , ω2

und ω3 mit p(ω1 ) = 1/20, p(ω2 ) = 1/10 und p(ω3 ) = 1 − 1/20 − 1/10 = 17/20.

Die Zufallsvariable X beschreibt den Gewinn für die einzelnen Ereignisse: X(ω1 ) =

100 − 1000 = −900, X(ω2 ) = 100 − 400 = −300 und X(ω3 ) = 100. Nach Definition erhalten wir für den Erwartungswert

1

1

− 300 10

+ 100 17

=

E(X) = −900 20

20

−900−600+1700

20

= 10

Wichtige Anwendungen in der Informatik sind die Analyse der durchschnittlichen

Laufzeit eines Algorithmus (Ω besteht aus den Eingaben und X(ω) ist die Laufzeit

für die Eingabe ω) und die Analyse randomisierter Algorithmen (d.h. die Arbeit des

Algorithmus wird durch eingebaute Zufälle gesteuert).

37