Kapitel 18 Die Maximum

Werbung

Kapitel 18

Die Maximum-Likelihood

Methode

18.1

Grundidee

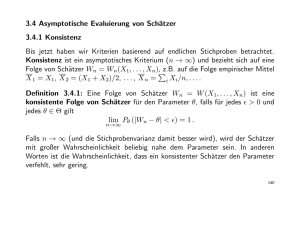

Wir haben bisher (fast) ausschließlich die OLS-Methode angewandt um Schätzer für

die Parameter eines Regressionsmodells zu bestimmen. Obwohl die OLS-Methode

einige sehr angenehme Eigenschaften besitzt – unter den Gauss-Markov Annahmen

sind OLS-Schätzer BLUE – sind sie in komplexeren Fällen manchmal nicht anwendbar, zum Beispiel, wenn der zu schätzende Zusammenhang nicht linear ist. In

solchen und vielen anderen Fällen greifen Ökonometrikerinnen häufig auf ein alternatives Verfahren für die Schätzung unbekannter Parameter zurück, nämlich auf die

Maximum-Likelihood Methode.

Die Grundidee der Maximum-Likelihood Methode ist relativ einfach. Stellen Sie

sich vor, Sie und ihr Partner besitzen exakt den gleichen MP3 Player, der nur einen

Shuffle Mode und keine optische Anzeige hat. Sie wissen, dass auf Ihrem eigenen

Player insgesamt fünf Alben gespeichert sind und auf dem Player ihres Partners insgesamt 20 Alben. Zusätzlich wissen Sie, dass auf auf beiden Playern (selbstverständlich!) ein Album mit den Cello Suiten von J.S. Bach befinden. Unglücklicherweise

haben Sie die beiden MP3 Player aber vertauscht und wissen nicht, um welches

Gerät es sich handelt. Deshalb schalten Sie einen Player im Shuffle-Modus ein und

hören die Sarabande aus den Bach Cello Suiten (welch ein Glück!). Was würden

Sie vermuten, handelt es sich um ihren eigenen Player oder den ihres Partners?

Natürlich gibt es nach dieser ersten ‘Ziehung’ keine sichere Methode um dies festzustellen, aber wenn Sie wetten müssten würden Sie vermutlich tippen, dass es ihr

eigener Player ist, denn die Wahrscheinlichkeit die Sarabande zu hören ist auf einem

Player mit nur 5 Alben deutlich größer als auf einem Player mit 20 Alben. Genau

auf dieser einfachen Idee beruht die Maximum-Likelihood Methode.

Die Maximum Likelihood (ML) Methode ist in der Statistik vermutlich die am

häufigsten eingesetzte Schätzmethode. Sie beruht auf einer expliziten Spezifizierung

der auf die erklärenden Variablen bedingten Verteilung der abhängigen Variable.

Allerdings muss dazu die Verteilung a priori bekannt sein. Die OLS Methode ist in

0

Dieses Kapitel folgt weitgehend Long (1997).

1

Empirische Wirtschaftsforschung

2

dieser Hinsicht weniger restriktiv, im einfachsten Fall wird für die Störterme lediglich angenommen εi ∼ i.i.d.(0, σ 2 ) sowie cov(εi , xjh ) = 0 (für i, j = 1, . . . , n und

h = 1, . . . , k), aber im Unterschied zur OLS Methode eignet sich die ML Methode auch für die Schätzung nichtlinearer Zusammenhänge. Die GMM Methode stellt

ebenfalls weniger Ansprüche bezüglich der Verteilungsannahmen, da die geschätzten

Parameter ausschließlich aus den Momentbedingungen des Modells folgen. Deshalb

müssen für eine GMM Schätzung nur gewisse Momente der Verteilung, aber nicht

die gesamte Verteilung bekannt sein. Im Gegensatz zum GMM Schätzer liefert die

ML Methode aber einen einheitlichen Ansatz zur Parameterschätzung und zur Interferenzstatistik.

Außerdem haben ML-Schätzer eine Reihe sehr angenehmer Eigenschaften, man kann

ganz allgemein zeigen, dass sie asymptotisch erwartungstreu, konsistent, asymptotisch effizient und asymptotisch normalverteilt sind. Allerdings sind ML-Schätzer

häufig wenig robust gegenüber Verletzungen der zugrunde liegenden Annahmen.

Im Kern geht es bei der ML Methode darum, dass wir eine konkrete Stichprobe

vorliegen haben und uns fragen, welche Parameterwerte θ (z.B. Mittelwert und/oder

Varianz) das Zustandekommen dieser konkreten Stichprobe ‘am wahrscheinlichsten’

macht. Dazu müssen wir allerdings a-priori wissen, aus welcher Verteilung diese

Stichprobe gezogen wurde. Im vorhergehenden Beispiel haben wir z.B. angenommen,

dass die Ziehungen des Shuffle-Programms aus einer Gleichverteilung erfolgen.

Wenn wir z.B. eine Stichprobe von drei Zahlen (Realisationen) y1 , y2 und y3 aus

einer gegebenen diskreten Verteilung ziehen gibt uns die Wahrscheinlichkeitsfunktion f (y1 , y2 , y3) die Wahrscheinlichkeit an, mit der diese drei Realisationen gezogen

werden. Wenn wir annehmen, dass es sich dabei um eine Zufallsstichprobe handelt,

die einzelnen Ziehungen also identisch und unabhängig verteilt sind (i.i.d.), dann

folgt aufgrund der stochastischen Unabhängigkeit

f (y1 , y2 , y3) = f (y1 )f (y2 )f (y3)

Diese Wahrscheinlichkeit hängt natürlich von den Parametern der Verteilung θ ab.

Wenn z.B. eine normalverteilte Zufallsvariable Y den Erwartungswert 5 und eine

Varianz 1 hat ist es viel wahrscheinlicher eine Stichprobe mit den drei Realisationen 4.5, 5.1 und 5.3 zu erhalten als eine Stichprobe 26, 47 und 15. Um dies zu

verdeutlichen schreibt man häufig f (y1, y2 , y3 |θ), bzw. bei Unabhängigkeit

f (y1 , y2 , y3 |θ) = f (y1|θ)f (y2 |θ)f (y3|θ)

Fassen wir zusammen: Y sei eine diskrete Zufallsvariable, deren Wahrscheinlichkeitsverteilung durch einen unbekannten Parameter(vektor) θ charakterisiert ist. Die

Wahrscheinlichkeitsfunktion f (y|θ) gibt für jede Ausprägung die Wahrscheinlichkeit

ihres Auftretens für ein gegebenes θ an

f (y|θ) = Pr(Y = yi |θ)

Wenn eine Zufallsstichprobe y1 , y2 , . . . , yn mit n erklärenden Beobachtungen vorliegt, und die Beobachtungen unabhängig verteilt sind, erhalten wir die gemeinsame Wahrscheinlichkeitsfunktion, indem wir die entsprechenden individuellen Wahrscheinlichkkeitsfunktionen multiplizieren.

3

Empirische Wirtschaftsforschung

f (y1, . . . , yn |θ) = f (Y = y1 |θ) · f (Y = y2 |θ) · · · f (Y = yn |θ) =

n

Y

i=1

f (Y = yi |θ)

Dies gibt uns die Wahrscheinlichkeit der Realisation dieser Stichprobe für gegebene

Parameter θ an.1

Die Likelihoodfunktion L interpretiert diese gemeinsame Wahrscheinlichkeitsfunktion (bzw. im stetigen Fall Dichtefunktion) als Funktion unbekannter Parameter

θ für gegebene Beobachtungen!

Man beachte den feinen Unterschied: für die Wahrscheinlichkeitsfunktion interessierten wir uns, weil sie uns die Eintrittswahrscheinlichkeiten von Realisationen für

gegebene Parameter θ angibt. Bei der Likelihoodfunktion nehmen wir die Stichprobe als gegeben an und interessieren uns für den unbekannten Parameter θ, der die

Realisation der gegebenen Stichprobe ‘am wahrscheinlichsten’ macht.

Um dies zu verdeutlichen wird die Likelihood Funktion üblicherweise folgendermaßen

angeschrieben:

L(θ|Y ) = l(θ|Y = y1 ) · l(θ|Y = y2 ) · · · l(θ|Y = yn ) =

n

Y

l(θ|yi )

i=1

Angenommen wir kennen die Verteilung der Grundgesamtheit (d.h. die

Wahrscheinlichkeits- bzw. Dichtefunktion f ) und haben das Ergebnis einer Stichprobenziehung vorliegen, dann suchen wir den Parameter θ, für den die Realisierung der

konkreten Stichprobe ‘am wahrscheinlichsten’ ist. Das ist natürlich nichts anderes

als eine einfache Maximierungsaufgabe.

Die Bedingungen 1. und 2. Ordnung für ein Maximum sind:

∂L

=0

∂θ

und

∂2L

<0

∂θ2

Die Grundidee einer ML-Schätzung besteht also darin, solche Werte als Schätzer für

die unbekannten Parameter heranzuziehen, die die Wahrscheinlichkeit der Realisation einer gegebenen Stichprobe maximieren!

Die ML Schätzer θb für θ folgen direkt aus den Bedingungen erster Ordnung dieses

Maximierungsproblems

b

L(θ|D)

= sup L(θ|D)

θ∈Θ

1

Analoges gilt auch für stetige Zufallsvariablen. Wenn Y stetig ist, ist die Wahrscheinlichkeit

eine Stichprobe vom Umfang n zu erhalten, bei der die Stichprobenwerte in den Intervallen

Y1 ≤ Y ≤ Y1 + ∆Y, Y2 ≤ Y ≤ Y2 + ∆Y, . . . , Yn ≤ Y ≤ Yn + ∆Y,

liegen, näherungsweise

f (Y1 ; θ)∆Y · f (Y2 ; θ)∆Y · · · f (Yn ; N )∆Y = f (Y1 ; θ) · f (Y2 ; ) · · · f (Yn ; θ)(∆Y )n

Kürzen wir durch (∆Y )n sehen wir, dass auch in diesem Fall die gesuchte Wahrscheinlichkeit

proportional zum Ausdruck

L = f (Y1 ; θ) · f (Y2 ; θ) · · · f (Yn ; θ)

ist.

4

Empirische Wirtschaftsforschung

wobei die Lösung θb eine reelle Zahl aus dem nichtleeren Parameterraum Θ für die

Daten D ist. (supremum der Likelihood Funktion). Die Funktion sup steht für Supremum und bezeichnet die kleinste obere Schranke (obere Grenze). Das Supremum

ist ist eng verwandt mit dem Maximum einer Menge, und in den allermeisten Fällen

können wir uns einfach das Maximum vorstellen.

Abbildung 18.1 zeigt eine Stichprobe Y = (4.5, 3.5, 3.8, 4.0, 4.2, 4.7, 5.0, 5.2, 7.0,

8.1) und einige Dichtefunktionen. Wenn diese Stichprobe aus einer Normalverteilung

gezogen wurde, so sind für diese Daten die Populationsparameter µ = 5 und σ 2 = 1.9

am wahrscheinlichsten (durchgezogene Dichtefunktion).

f (θ)

µ = 5.5, σ = 0.5

0.5

0.4

µ = 4, σ = 0.9

µ = 7, σ = 1

0.3

µ = 5, σ = 1.4

0.2

0.1

µ = 6, σ = 3

b

0

0

1

2

3

b b b

4

b b

b b

5

b

6

7

b

8

9

10

11

12

13

14

y

Abbildung 18.1: Maximum Likelihood Methode: Wenn wir wissen, dass die

Stichprobe aus einer normalverteilten Grundgesamtheit gezogen

wurde, welcher Mittelwert µ und welche Varianz σ 2 macht die

Stichprobendaten ‘am wahrscheinlichsten’ ?

Da Logarithmieren eine monotone Transformation ist kann ebensogut (und einfacher!) der Logarithmus der Likelihood Funktion, die sogenannte Log-Likelihood

Funktion, maximiert werden

ln L(θ|D) = ln[l(θ|y1 )] + ln[l(θ|y2 )] + · · · + ln[l(θ|yn )] =

∂ ln L

=0

∂θ

und

n

X

ln[l(θ|yi )]

i=1

∂ 2 ln L

<0

∂θ2

Die Ableitung ∂ ln(L)/∂θ wird auch ‘score’ oder Gradient genannt. Ein einzelnes

Element der Summe ln Li = ln[f (yi , θ)] ist der Beitrag einer einzelnen Beobachtung

i zur Loglikelihood Funktion.

5

Empirische Wirtschaftsforschung

Die erste Ableitung ist die Steigung der Log-Likelihood Funktion (Gradient), und

die zweite Ableitung die Steigung des Gradienten, d.h. die zweite Ableitung ist

ein Maß für die Krümmung der Log-Likelihood Funktion. Je stärker gekrümmt

die Log-Likelihood Funktion ist, d.h. je größer der Absolutwert der zweiten Ableitung im Punkt θb ist, desto betonter ist der Extremwert, und desto präziser kann

θ geschätzt werden. Deshalb liegt es nahe, die zweite Ableitung als Ausgangspunkt

für die Schätzung der Varianz der ML Schätzer heranzuziehen.

Konkret kann man zeigen, dass

b =

var(θ)

1

− E[ln L(θ|D)′′ ]

wobei D für die Daten steht und ln L(θ|D)′′ die zweite Ableitung der Log-Likelihood

Funktion bezeichnet. Der negative Wert davon − ln L(θ|D)′′ wird als beobachtete

Fisher Information bezeichnet und der Erwartungswert davon als erwartete Fisher

Information. Die Varianz eines ML Schätzers θ ist also die Inverse der erwarteten

Fisher Information.

18.2

Beispiele

18.2.1

ML-Schätzer für Mittelwert und Varianz einer normalverteilten Zufallsvariablen

Den Mittelwert µ und die Varianz σ 2 einer normalverteilten (univariaten) Zufallsvariablen Y ∼ N(µ, σ 2 ) wird nach der Maximum Likelihood Methode folgendermaßen

berechnet:

Die Dichtefunktion von Y ist

1

2

2

f (yi , µ, σ 2) = √ e−(yi −µ) /(2σ ))

σ 2π

wobei e die Eulersche Zahl bezeichnet und π = 3.14159 . . ..

In anderer Schreibweise

1

f (yi , µ, σ 2) = √

exp −(yi − µ)2 /(2σ 2)

σ 2π

1

2

2

√

L(µ, σ | y) =

exp −(yi − µ) /(2σ )

σ 2π

i=1

n

h X

i

1

√

=

exp −

(yi − µ)2 /(2σ 2 )

σ 2π

2

n Y

Durch Logarithmierung erhält man die Log-Likelihood Funktion

ln L = −n ln σ − n ln

√

2π −

1 X

(yi − µ)2

2σ 2

(18.1)

6

Empirische Wirtschaftsforschung

ln(L)

10

µ

b

0

1

2

3

b b b

4

b b

b b

5

b

6

7

b

8

y

−10

−20

−30

−40

−50

−60

−70

−80

−90

Abbildung 18.2: Log-Likelihood Funktion für Daten aus Abbildung 18.1

Abbildung 18.2 zeigt diese Log-Likelihood Funktion für die Daten aus Abbildung

18.1. Die Form dieser Log-Likelihood Funktion wird sich bei wiederholten Ziehungen von Stichprobe zu Stichprobe unterscheiden, aber für eine gegebene Stichprobe

erlaubt sie uns eine Schätzung für den Parameterwert µ zu berechnen, der diese

konkrete Stichprobe ‘am wahrscheinlichsten macht’.

Das Maximum dieser Funktion kann wie üblich bestimmt werden, indem man die ersten Ableitungen der Log-Likelihood Funktion Null setzt und nach den unbekannten

Parameterwerten µ und σ 2 löst.

∂ ln L

2 X

=

(yi − µ) = 0

∂µ

2σ 2

X

yi = nµ

P

yi

µ̂ =

= ȳ

n

∂ ln L

n

1 X

= − + 3

(yi − µ)2 = 0

∂σ

σ σ

X

2

(yi − µ) = nσ 2

P

(yi − µ̂)2

2

σ̂ =

n

7

Empirische Wirtschaftsforschung

Wir erhalten als ML-Schätzer für den ‘wahren’ Parameter µ also wieder den Mittelwert. In diesem einfachen Fall liefert die OLS-und ML-Methode also das gleiche

Resultat! Wie man aber sieht ist der Maximum Likelihood Schätzer σ̂ 2 in kleinen

Stichproben kein unverzerrter Schätzer für die Varianz

der Grundgesamtheit σ 2 (ein

P

unverzerrter Schätzer für σ 2 ist s2 = 1/(n − 1)[ (yi − ȳ)2 ]), aber der Unterschied

verschwindet mit zunehmendem Stichprobenumfang n. Generell ist die Maximum

Likelihood Schätzung für σ 2 asymptotisch erwartungstreu.

Man sieht außerdem, dass für die Normalverteilung der Maximum Likelihood

Schätzer für den Mittelwert nicht von der Varianz σ 2 abhängt, obwohl die Likelihood Funktion davon abhängt.

Wichtig ist, dass unterschiedliche Stichproben zu verschiedenen Log-Likelihood

Funktionen führen, da die Log-Likelihood Funktion eine Funktion der Stichprobendaten ist (siehe Gleichung 18.1). Abbildungen 18.3 – 18.5 zeigen dreidimensionale

Darstellungen der Log-Likelihood für drei verschiedene Stichproben, die alle den

gleichen Mittelwert ȳ = 5, aber unterschiedliche – von Abbildung zu Abbildung

zunehmende – Varianzen s2 haben.

Offensichtlich ist die Log-Likelihood umso flacher, je größer die Varianz der Stichprobe ist. Wenn die Log-Likelihood aber sehr flach ist können schon geringfügig

unterschiedliche Stichproben zu sehr verschiedenen Parameterschätzungen führen;

man kann sich vorstellen, die Schätzungen werden ‘störanfälliger’. Dies ist wenig

überraschend, wir wissen bereits, dass eine große Varianz der Störterme zu ungenaueren Schätzungen führt.

-20

lnHLL

8

-30

6

-40

0

4

Σ

2

4

µ

2

6

8

Abbildung 18.3: Log-Likelihood Funktion für die Stichprobe y = {4.5, 4.6, 4.8, 4,

4.2, 4.7, 5, 5.2, 7, 6} (ȳ = 5, σ = 0.85)

8

Empirische Wirtschaftsforschung

-20

lnHLL

8

-30

6

-40

0

4

Σ

2

4

µ

2

6

8

Abbildung 18.4: Log-Likelihood Funktion für die Stichprobe y = {4.5, 3.5, 3.8, 4,

4.2, 4.7, 5, 5.2, 7, 8.1} (ȳ = 5, σ = 1.4)

-30

lnHLL

8

-40

-50

6

0

4

Σ

2

4

µ

2

6

8

Abbildung 18.5: Log-Likelihood Funktion für die Stichprobe y = {1.5, 2, 3.8, 4,

4.2, 4.7, 5, 5.2, 10, 9.6} (ȳ = 5, σ = 2.66)

9

Empirische Wirtschaftsforschung

18.2.2

ML-Schätzer für das multivariate Regressionsmodell

Dieses Prinzip kann einfach für das multivariate Regressionsmodell angewandt werden

y = Xβ + ε,

mit ε ∼ N(0, σε2 )

Die multivariate Dichtefunktion für ε ist

f (ε; β, σε2 ) =

1

′

2

e−ε ε/2σε

2

n/2

(2πσε )

Man kann zeigen, dass die bedingte multivariate Dichtefunktion von y einfach2

f (y|X) =

′

2

1

e−[(y−Xβ) (y−Xβ)/2σε ]

2

n/2

(2πσε )

da ε = y − Xβ.

Die Likelihood Funktion interpretiert diese Dichtefunktion wieder als Funktion der

unbekannten Parameter β und σε2 für die gegebenen Beobachtungen y und X

L(β, σε2 ; y, X) =

1

′

2

e−[(y−Xβ) (y−Xβ)/2σε ]

2

n/2

(2πσε )

Wegen der Monotonität der logarithmischen Transformation kann man auch einfacher die Log-Likelihood Funktion maximieren

n

n

1

ln(L) = − ln(2π) − ln(σε2 ) − 2 [(y − Xβ)′ (y − Xβ)]

2

2

2σε

Die Parameterwerte, die diese Funktion maximieren, folgen aus den Bedingungen

erster Ordnung

1 ∂ [(y − Xβ)′ (y − Xβ)] !

∂ ln(L)

= − 2

=0

∂β

2σε

∂β

∂ ln(L)

n

1

!

=

−

+

[(y − Xβ)′ (y − Xβ)] = 0

∂σε2

2σε2 2σε4

Die erste dieser beiden Gleichungen minimiert wie der OLS-Schätzer die Quadratsumme der Residuen. Wir erinnern uns von der Herleitung des OLS-Schätzers, dass

∂ [(y − Xβ)′ (y − Xβ)]

!

= 2X ′ y − 2X ′ Xβ = 0

∂β

Daraus folgt, dass der ML-Schätzer für β gleich dem OLS-Schätzer ist

β̂ = (X ′ X)−1 X ′ y

2

Dies folgt aus dem Gesetz des Austauschs von Variablen in Dichtefunktionen. Wenn ε und y

jeweils Spaltenvektoren mit n Variablen sind und f die Dichtefunktion bezeichnet, dann gilt

∂ε f (y) = f (ε) ∂y

wobei |∂ε/∂y| den Absolutwert der Determinante von der Matrix mit den partiellen Ableitungen

bezeichnet (Jacobi Determinante). Da in diesem einfachen Fall |∂ε/∂y| = 1 gilt f (y) = f (ε) (siehe

z.B. Johnston & DiNardo 1997, S. 64 & 158).

Empirische Wirtschaftsforschung

10

Aus der zweiten Bedingung erster Ordnung erhalten wir direkt den ML-Schätzer für

σε2

i ε̂′ε̂

1 h

σ̂ε2 =

(y − X β̂)′ (y − X β̂) =

n

n

Wie schon erwähnt ist dieser Schätzer für kleine Stichproben verzerrt, da er keine Korrektur für die Freiheitsgrade berücksichtigt, ein unverzerrter Schätzer wäre

wieder

ε̂′ ε̂

s2ε =

n−k

Abbildung 18.6, entnommen aus Murray (2005), zeigt einige grafische Beispiele für

mögliche Log-Likelihood Funktionen.

Abbildung 18.6: Log-Likelihoodfunktionen für bivariate Modelle;

Quelle: Murray, siehe http://wps.aw.com/aw_murray_economtrcs_1/

18.2.3

Binominal verteilte Zufallsvariablen

Ein wesentlicher Vorteil der Maximum-Likelihood Methode besteht darin, dass die

Schätzer auch für spezifische Verteilungen ermittelt werden können, allerdings muss

die Verteilung der Grundgesamtheit bekannt sein.

11

Empirische Wirtschaftsforschung

Angenommen wir interessieren uns für die Wahrscheinlichkeit eine gegebene Zahl

von Männern in einer Stichprobe zu finden.3 Die Wahrscheinlichkeit s Männer in

einer Stichprobe der Größe n mit dem Populationsparameter π zu finden ist nach

der Binominalverteilung

Pr(s|π, n) =

n!

π s (1 − π)n−s

s!(n − s)!

mit z! = z × (z − 1) × (z − 2) × · · · × 2 × 1.

Wenn der Anteil der Männer in der Grundgesamtheit ein Halb ist (π = 0.5), dann

ist die Wahrscheinlichkeit in einer Stichprobe der Größe n = 10 drei Männer zu

finden (s = 3)

Pr(s = 3|π = 0.5, n = 10) =

10! 3

0.5 (1 − 0.5)7 = 0.117

3!7!

In diesem Fall kennen wir den Wert von π und n und interessieren uns für die

Wahrscheinlichkeit einer Realisation s (d.h. s ist eine Variable). Deshalb wird obige

Funktion Wahrscheinlichkeitsfunktion (probability funcion) genannt.

Bei der Maximum Likelihood Schätzung nehmen wir hingegen s und n als gegeben

an und untersuchen, wie sich diese Funktion in Abhängigkeit des zu schätzenden

Populationsparameters π ändert. Deshalb wird diese Funktion Likelihood Funktion

genannt. Die Maximum Likelihood (ML) Schätzung ist dann der Populationsparameter π, der die beobachteten Daten ‘am wahrscheinlichsten’ macht.

Die Likelihood Funktion im obigen Beispiel ist

10! 3

π (1 − π)7

3!7!

Da der Logarithmus eine monotone Transformation ist können wir auch die logLikelihood Funktion maximieren

10!

ln[L(π|s = 3, n = 10)] = ln

+ 7 ln π + 7 ln(1 − π)

3!7!

L(π|s = 3, n = 10) =

Die Maximum Likelihood Schätzung für π ist der Wert π

b, der die Wahrscheinlichkeit eine Stichprobe mit drei Männern zu finden maximiert. Die Bedingung erster

Ordnung dafür ist

∂ ln L(π|s = 3, n = 10)

=0

∂π

∂ ln L(π|s = 3, n = 10)

3∂ ln π ∂ 7 ln(1 − π) ∂(1 − π)

= 0+

+

∂π

∂π

∂(1 − π)

∂π

3

7

!

=

−

=0

π 1−π

bzw. 3(1 − π) = 7π → 3 = 10π; daraus folgt der ML-Schätzer π

b = 0.3 = s/n. In

diesem einfachen Fall ist der ML Schätzer genau gleich dem Anteil der Männer in

der Stichprobe.

3

Dieses Beispiel stammt aus Long, Scott J., Regression Models for Categorical and Limited

Dependent Variables, Sage 1997.

Empirische Wirtschaftsforschung

18.3

12

Eigenschaften von ML Schätzfunktionen

Wir haben gerade gesehen, dass der ML-Schätzer für σε2 in kleinen Stichproben verzerrt sein kann (z.B. ist der erwartungstreue Schätzer für die Varianz der Störterme

s2 = ε̂′ ε̂/(n − k)).

Dennoch besitzen Maximum-Likelihood Schätzer eine Reihe wünschenswerter Eigenschaften. Unter sehr allgemeinen Bedingungen gilt:

b =θ

1. ML-Schätzer sind konsistent: plim(θ)

√

d

2. ML-Schätzer sind asymptotisch normalverteilt: n(θb − θ) → N(θ, I −1 (θ))

(die Informationsmatrix I wird im nächsten Kapitel diskutiert.)

3. ML-Schätzer sind asymptotisch erwartungstreu;

4. ML-Schätzer sind asymptotisch effizient, d.h. die Varianz von θb erreicht asymptotisch die minimale Varianz, √

die ein konsistenter Schätzer erreichen kann

b = I −1 ).

(Cramér-Rao Schranke: as. Var[ nθ]

5. Invarianz: Sei g(θ) eine stetige Funktion. Dann ist der ML-Schätzer von g(θ)

b

gleich g(θ).

Aufgrund dieser Eigenschaften sind ML-Schätzer sehr beliebt, allerdings haben sie

auch einige Nachteile:

• ML-Schätzer beruhen auf einer Verteilungsannahme. Ist diese verletzt können

ML-Schätzer inkonsistente Ergebnisse liefern. Wird die ML-Methode angewandt, obwohl die Störterme nicht normalverteilt sind, spricht man von einer

Quasi-Maximum Likelihood Schätzung.

• ML-Schätzer sind oft eine komplizierte Funktion der unbekannten Parameter,

für die es keine analytischen Lösungen gibt. In solchen Fällen muss auf iterative

numerische Verfahren zurückgegriffen werden.

• Die Vorteile der ML-Schätzer sind asymptotischer Natur, in kleinen Stichproben können andere Schätzer bessere Eigenschaften haben.

18.3.1

Übungsaufgaben

1. Die Dichtefunktion einer Zufallsvariable x mit exponentieller Wahrscheinlichkeitsverteilung ist

(

(1/θ) e−x/θ für x > 0,

f (x) =

0

sonst

Zeigen

P Sie mit Hilfe der ML-Methode, dass die ML-Schätzung von θ gleich

θ̂ = xi /n ist (n ist die Stichprobengröße).

13

Empirische Wirtschaftsforschung

2. Ermitteln Sie die ML-Schätzer für β1 , β2 und σ 2 für das bivariate Regressionsmodell yi = β1 + β2 xi + εi .

Hinweis:

−(yi − β1 − β2 xi )2

1

exp

f (yi ) = √

2σ 2

σ 2π

3. Zeigen Sie, dass im vorhergehenden Beispiel die Bedingungen 2. Ordnung

erfüllt sind.

18.4

Die Varianz von ML-Schätzern

Die Maximum Likelihood Methode erlaubt auch einige allgemeine Aussagen über

die Varianz der geschätzten Parameter. Eine umfassende Darstellung geht weit über

den Rahmen dieses Skript hinaus, im folgenden seien deshalb nur die wichtigsten

Ergebnisse zitiert.

Sei θ ein Vektor mit zu schätzenden Parametern. Im einfachen Regressionsmodell

yi = β1 + β2 xi + εi mit var(ε|x) = σ 2 ist θ = [β1 β2 σ]′ .

Die Hess’sche Matrix der 2. Ableitungen ist

∂ 2 ln L(θ)

∂θ∂θ ′

oder in unserem bivariaten Regressionsbeispiel

H(θ) =

∂ 2 ln L(θ)

∂β ∂β

2 1 1

L(θ)

H(θ) = ∂∂βln2 ∂β

1

∂ 2 ln L(θ)

∂σ∂β1

∂ 2 ln L(θ)

∂β1 ∂β2

∂ 2 ln L(θ)

∂β1 ∂σ

∂ 2 ln L(θ)

∂β2 ∂β2

∂ 2 ln L(θ)

∂β2 ∂σ

∂ 2 ln L(θ)

∂σ∂β2

∂ 2 ln L(θ)

∂σ∂σ

Die zweite Ableitung ist ein Maß für die Krümmung der Log-Likelihood Funktion.

Wenn z.B. die zweite Ableitung ∂ 2 ln L(θ)/(∂β2 ∂β2 ) klein ist ändert sich die LogLikelihood nur wenig, wenn sich β2 ändert.

Die Informationsmatrix I ist definiert als der negative Erwartungswert der

Hess’schen Matrix

I(θ) = − E[H(θ)]

Unter sehr allgemeinen Bedingungen kann man zeigen, dass die Inverse der Informationsmatrix die asymptotische Varianz-Kovarianz Matrix der ML Schätzer ist

bzw. für unser Beispiel

b = I −1 (θ) = − E[H(θ)]−1

as. var(θ)

∂ 2 ln L(θ)

∂β1 ∂β1

∂ 2 ln L(θ)

∂β1 ∂β2

∂ 2 ln L(θ)

∂β1 ∂σ

−1

−E

−E

−E

2

2

2

∂ ln L(θ)

∂ ln L(θ)

∂ ln L(θ)

b

as. var(θ) = − E ∂β2 ∂β1

− E ∂β2 ∂β2

− E ∂β2 ∂σ

2

2

2

∂ ln L(θ)

∂ ln L(θ)

∂ ln L(θ)

− E ∂σ∂β1

− E ∂σ∂β2

− E ∂σ∂σ

14

Empirische Wirtschaftsforschung

Beispiel: Für das frühere Beispiel einer normalverteilten Zufallsvariable X ∼

N(µ, σ 2 ) haben wir folgende Likelihood, Log-Likelihood und Scores berechnet:

n

h X

i

1

2

√

exp −

(xi − µ)2 /(2σ 2 )

L(µ, σ | x) =

σ 2π

√

1 X

ln L = −n ln σ − n ln 2π − 2

(xi − µ)2

2σ

2 X

∂ ln L

=

(xi − µ) = 0

∂µ

2σ 2

∂ ln L

n

1 X

= − + 3

(xi − µ)2 = 0

∂σ

σ σ

Anhand dieser können wir nun die Hess’sche Matrix berechnen:

2

P

2

H(µ, σ) =

∂ ln L

∂µ2

∂ ln L

∂µ∂σ

∂ 2 ln L

∂µ∂σ

∂ 2 ln L

∂σ2

=

−n

2

Pσ

−2 (xi −µ)

σ3

−2σ

n

σ2

−

(xi −µ)

σ4

P

3 (xi −µ)2

σ4

=

−n

σ2

0

0

−2n

σ2

!

Der letzte P

Schritt derPobigen Gleichung ergibt P

sich aus Einsetzen der Lösungen

µ̂ = (1/n) P xi →

xi P

= nµ̂, woraus folgt (xi − µ̂) = nµ̂ − nµ̂ = 0, sowie

σ̂ 2 = (1/n) (xi − µ̂)2 →

(xi − µ̂)2 = nσ̂ 2 .

Die asymptotische Varianz-Kovarianzmatrix ist die Inverse der Informationsmatrix

I(µ, σ) = − E[H(µ, σ)], also

as. var(µ, σ) =

n

σ2

0

0

2n

σ2

!−1

=

σ2

n

0

0

σ2

2n

!

Da die Nebendiagonalelemente Null sind folgt, dass µ̂ und σ̂ asymptotisch unkorreliert sind.

Für das lineare Regressionsmodell y = Xβ + ε mit ε ∼ N(0, σ 2 ) wird z.B. in

Johnston and Dinardo (1996, 145f) gezeigt, dass

1

2 ′ −1

′

σ (X X)

0

0

β

β

2 (X X)

−1

σ

I(θ) = I

=

bzw. I

=

n

2σ4

0

σ2

σ2

0

2σ4

n

Dieses Ergebnis gilt nur asymptotisch. Für kleine Stichproben gilt die Cramer-Rao

Ungleichung, derzufolge

b ≥ I −1 (θ)

var(θ)

Dies erlaubt die Bestimmung einer Untergrenze für die Varianz eines jeden unverzerrten Schätzers, dessen Verteilung bekannt ist.

Zum Beispiel wissen wir, dass die Varianz des Mittelwertes var(x̄) = σ 2 /n ist. Da dies

im obigen Beispiel tatsächlich das erste Element von I −1 ist können wir schließen,

dass dieser Schätzer für normalverteilte Zufallsvariablen effizient ist.

15

Empirische Wirtschaftsforschung

18.5

Likelihood Ratio (LR), Wald and Langrange

Multiplier (LM)- Tests

Die Likelihood Ratio (LR)-, Wald- und Langrange Multiplier (LM)- Tests sind die

Troika der klassischen Teststatistik. Alle drei Tests beruhen auf einem Vergleich

eines Modells mit Restriktionen mit einem Modell ohne Restriktionen.

Das Grundprinzip dieser drei Tests kann einfach anhand der Log-Likelihood Funktion erklärt werden. Für das bivaritae Regressionsmodell yi = β1 + β2 xi + εi mit

εi ∼ N(0, σ 2 ) ist die Log-Likelihood Funktion

√ P(y − β − β x )2

i

1

2 i

2

2π −

ln L(β) = −n ln σ − n ln

2

2σ

18.5.1

Likelihood Ratio Tests

Likelihood Ratio-Tests beruhen auf einem Vergleich des Wertes der (maximalen)

Log-Likelihood Funktion an der Stelle ohne der Restriktion (d.h. an der Stelle

der unrestringierten ML-Schätzer β̂) und des Wertes an der Stelle mit Restriktion

(der restringierten ML-Schätzers β̂r ). Das Likelihood-Verhältnis (likelihood ratio)

ist durch

L(β̂r )

λ=

L(β̂)

definiert. Der Nenner von λ kann nicht kleiner als der Zähler sein, da der Wert an

der Stelle ohne Restriktion (β̂) immer größer ist, als an der Stelle mit Restriktion

(β̂r , vgl. Abb. 18.7). Deshalb gilt 0 ≤ λ ≤ 1. Die Null-Hypothese ist β = βr .

Für große Stichproben ist die LR-Statistik

a

LR = −2 ln λ = 2[ln L(β̂) − ln L(β̂r )] ∼ χ2q

d.h. die Likelihood Ratio-Teststatistik asymptotisch Chi-quadrat verteilt mit q Freiheitsgraden, wobei q die Anzahl der Restriktionen bezeichnet.

Die LR-Statistik beruht auf der vertikalen Distanz in Abbildung 18.7: je größer die

vertikale Distanz ln L(β̂) − ln L(β̂r ), umso eher wird die Nullhypothese verworfen.

b

ln L(β)

ln L(βbr )

bc

∂ 2 ln L

∂β 2

bc

∂ ln L

∂β

βbr

Abbildung 18.7: Wald, LR und LM Tests

βb

β

In Abbildung 18.8 (Seite 16) wird dies anhand einer sehr flach verlaufenden LogLikelihood Funktion (strichliert gezeichnet) veranschaulicht.

16

Empirische Wirtschaftsforschung

ln L

bc

bc

∂ 2 ln L

∂β 2

β

βb

Abbildung 18.8: Wald, LR und LM Tests bei einer flach verlaufenden LogLikelihood Funktion

18.5.2

Wald Tests

Wald Tests beruhen auf einem Vergleich von βb und βbr , d.h. der horizontalen Distanz in Abbildung 18.7, wobei diese Distanz mit der Krümmung der Log-Likelihood

Funktion an der Stelle βb (d.h. ∂ 2 ln L/∂ βb2 ) gewichtet wird. Umso größer die zweite

Ableitung ist umso stärker ist die Log-Likelihood Funktion gekrümmt.

Wenn Log-Likelihood Funktion an der Stelle βb sehr flach verläuft erlaubt selbst eine

große Differenz zwischen den Parametern des restringierten und nicht restringierten

Modells nicht die Verwerfung der Null-Hypothese (vgl. Abb. 18.8).

Ein Vorteil dieses Testprinzips besteht darin, dass nur die nicht restringierten

ML-Schätzer berechnet werden müssen. Allerdings muss die Krümmung der LogLikelihood Funktion an dieser Stelle berechnet werden.

Man kann zeigen, dass die übliche F-Statistik

Fq,n−k =

(ε̂′r ε̂ − ε̂′ ε̂)/q

ε̂′ ε̂/(n − k)

ein Spezialfall eines Wald-Tests für lineare Restriktionen ist.

18.5.3

Lagrange Multiplier Tests

Bei Lagrange Multiplier Tests wird der Wert der Log-Likelihoodfunktion an der

b

Stelle βbr berechnet, wobei die Steigung der Log-Likelihoodfunktion (= ∂ ln L/∂ β)

und die Krümmung (= ∂ 2 ln L/∂ βb2 ) an dieser Stelle berücksichtigt wird. Wenn die

Nullhypothese wahr ist sollte die Steigung an der Stelle βbr sehr klein sein.

In der grafischen Abbildung 18.7 beruht die LM-Statistik auf dem Anstieg der Tangente im Punkt βbr sowie der Krümmung in diesem Punkt. Der Vorteil dieses Testprinzips besteht darin, dass nur die restringierten ML-Schätzer berechnet werden

müssen.

In Matrixschreibweise hat die LM-Statistik die Form

a

LM = S ′ (β̂r )I −1 (β̂r )S(β̂r ) ∼ χ2q

17

Empirische Wirtschaftsforschung

ln L

die erste Ableitung der Likelihood Funktion an der Stelle β = βbr

wobei S(β̂r ) = ∂ ∂β

bezeichnet und I die Informationsmatrix ist. Diese Statistik ist asymptotisch χ2

verteilt mit q Freiheitsgraden, wobei q die Anzahl der Restriktionen ist.

Engle (1982) hat gezeigt, dass der LM-Test relativ einfach mit Hilfe einer ‘Hilfsregression’ durchgeführt werden kann. Er beruht darauf, dass die Lagrange Multiplier

(LM-) Teststatistik auch als

LM =

ε̂′r ε̂ − ε̂′ ε̂ a 2

∼ χq

ε̂′r ε̂/n

geschrieben werden kann.

Unter Berücksichtigung von TSS = ESS + RSS (Total Sum Squared =

Explained Sum Squared + Residual Sum Squared, mit RSS = ε̂′ ε̂) kann die LMStatistik auch unter Verwendung des R2 einer Hilfsregression der Residuen des restringierten Modells auf die erklärenden Variablen des nicht restringierten Modells

geschätzt werden

LM = nR2

Dieser Test kann z.B. verwendet werden um abzuschätzen, ob zusätzliche erklärende

Variablen in ein Regressionsmodell aufgenommen werden sollen (LM-Test for adding

variables). Angenommen, wir haben ein (kurzes) Modell R mit Restriktionen und

ein (langes) Modell U ohne Restriktionen:

R:

U:

y = β1 + β2 x2 + ε

y = β1 + β2 x2 + β3 x3 + · · · + βk xk + ε∗

H0 : β3 = β4 = · · · = βk = 0

H1 : mindestens eines dieser βh 6= 0 (mit h = 3, . . . , k).

Ein LM-Test für die Nullhypothese H0 :

Schritten durchgeführt werden:

β3 = β4 = · · · = βk = 0 kann in folgenden

1. Schätze das Modell mit Restriktion R.

2. Berechne die geschätzten Residuen dieses restringierten Modells R ε̂r :

ε̂r = y − βb1 − βb2 x2

Wenn das “wahre Modell” U korrekt ist erwarten wir, dass diese Residuen mit

den Variablen x2 , . . . , xk korreliert sein werden.

3. Regressiere die geschätzten Residuen ε̂r auf das Interzept und alle x, d.h.

ε̂r = γ̂1 + γ̂2 x2 + γ̂3 x3 + · · · + γ̂k xk + ν

4. Das Bestimmtheitsmaß dieser ‘Hilfsregression’ multipliziert mit der Anzahl

der Beobachtungen n ist nach Engle (1982) asymptotisch Chi-quadrat verteilt

mit q Freiheitsgraden, wobei q wieder die Anzahl der Restriktionen unter der

Null-Hypothese ist:

a

LM = nR2 ∼ χ2q

18

Empirische Wirtschaftsforschung

Beispiel in EViews:

’ LM-Test for Adding Variables ’ Example Gujarati (1995) pp. 219 & 463

equation EQ_R.ls COST c OUTPUT

series E_hat = resid

equation EQ_Ehat.ls E_hat c OUTPUT OUTPUT^2 OUTPUT^3

scalar LM_Stat = EQ_Ehat.@regobs * EQ_Ehat.@r2

scalar LM_pval = 1-@cchisq(LM_Stat,2)

’ Result: LM_Stat = 9.8956; p-val = 0.0071

In großen Stichproben sollten der Wald-, LR- und LM Test sehr ähnliche Resultate

liefern (d.h. sie sind asymptotisch äquivalent). Engel (1982) und Buse (1982) haben

gezeigt, dass in linearen Modellen generell gilt

W ≥ LR ≥ LM

Die Unterschiede dieser Teststatistiken in kleinen Stichproben gehen im wesentlichen

auf die Verwendung entweder des unverzerrten Schätzers s2 oder des verzerrten, aber

konsistenten ML-Schätzers σ˜2 für die Varianz der Störterme σε2 zurück.

Vorsicht bei fehlenden Beobachtungen: diese Tests setzen voraus, dass die Modelle

mit und ohne Restriktionen auf den selben Beobachtungen beruhen. Bei fehlenden

Beobachtungen (missing values) kann es zu Unterschieden in der Anzahl der Beobachtungen kommen.

18.6

Numerische Methoden zur Berechnung von

ML-Schätzungen

Wir haben bereits früher gezeigt, dass die ML-Schätzer im einfachen Regressionsmodell (d.h. wenn alle Gauss-Markov Annahmen erfüllt sind) einfach berechnet werden

können, indem man die ersten Ableitungen (Gradienten) Null setzt und nach den

unbekannten Parametern löst. In diesem einfachsten Fall stimmen die ML Schätzer

für die Koeffizienten mit den OLS Schätzern überein (nicht aber die Schätzungen

für die Standardfehler, warum?).

Für nichtlineare Modelle ist die algebraische Berechnung der Lösungen selten

möglich, deshalb muss in diesen Fällen meist zu numerischen Methoden gegriffen werden. Im Prinzip wird dabei meist iterativ vorgegangen: Man berechnet den

Lösungsvektor θ (z.B. θ = β1 β2 σ)′ ) mit ‘beliebigen’ Startwerten θ0 , berechnet dafür

den Wert der Log-Likelihood Funktion, und addiert anschließend einen Vektor ψ0

zum Parametervektor θ um eine bessere Schätzung zu erhalten. Dieses Verfahren

wird wiederholt, bis der Wert der Log-Likelihood Funktion annähernd ein Maximum

erreicht hat, d.h. bis sich der Wert kaum noch verändert.

θ1 = θ0 + ψ 0

..

.

θm+1 = θm + ψm

19

Empirische Wirtschaftsforschung

Wenn eine Lösung θb gefunden werden kann, der Gradient der Log-Likelihood Funktion also annähernd Null wird , spricht man von Konvergenz.

Das Problem ist einen Vektor ψm zu finden, der einfach zu berechnen ist und der zu

einer schnellen Konvergenz führt. Dazu wurden mehrere Methoden vorgeschlagen.

• ‘Method of Steepest Ascent’: Bei dieser Methode wird die Steigung der

Log-Likelihood Funktion verwendet

θm+1 = θm +

∂ ln L

∂θm

Der Wert des Schätzers wird bei einem weiteren Durchgang vergrößert, wenn

die Ableitung (der Gradient) positiv ist, und verkleinert, wenn der Gradient

negativ ist. Der Nachteil dieser Methode liegt darin, dass sie nur die Steigung

in einem Punkt, aber nicht die Krümmung der Log-Likelihood Funktion in

diesem Punkt berücksichtigt, weshalb die Konvergenz eher langsam ist. Die

nächsten drei Methoden berücksichtigen deshalb zusätzlich die Krümmung

der Log-Likelihood Funktion um die Konvergenz zu beschleunigen.

• Newton-Raphson Methode: Die Krümmung (d.h. die Änderung der Steigung) kommt in der 2. Ableitung zu Ausdruck, d.h. in der Hess’schen Matrix

∂ ln L/∂θ∂θ ′ . Wenn θ = (β1 β2 )′ ist die Hess’sche Matrix

2

∂ ln L(θ)

∂ 2 ln L(θ)

2

∂ ln L

∂β1 ∂β1

∂β1 ∂β2

H(θ) =

= 2

′

∂ ln L(θ)

∂ 2 ln L(θ)

∂θ∂θ

∂β2 ∂β1

∂β2 ∂β2

Wenn z.B. ∂ 2 ln L(θ)/∂β1 ∂β1 sehr groß ist (die Log-Likelihood Funktion also

stark gekrümmt ist) und ∂ 2 ln L(θ)/∂β2 ∂b1 klein ist sollte die Anpassung von

β1 in kleineren Schritten erfolgen als die Anpassung von b1 . Deshalb wird die

Inverse der Hess’schen Matrix für die Gewichtung verwendet.

θm+1 = θm −

∂ ln L2

∂θ∂θ ′

−1

∂ ln L

∂θm

Auch für die Schätzung der Varianz-Kovarianz Matrix der ML Schätzer wird

häufig von der negativen Hess’schen Matrix ausgegangen (der sogenannten beobachteten Informationsmatrix anstelle der tatsächlichen Informationsmatrix),

b =−

var

c 1 (θ)

n

X

∂ ln L2

i

i=1

b θb ′

∂ θ∂

!−1

Eine Verfeinerung der Newton-Raphson Methode ist die ‘quadratic hillclimbing’ Methode, die z.B. in EViews zur Verfügung steht. Dabei werden

die Hauptdiagonalelemente der Hess’sche Matrix modifiziert um die Konvergenz zu beschleunigen (anstelle der Hess’schen Matrix H wird eine Matrix

Hα = H + αI verwendet, wobei α eine positive Konstante und I die Einheitsmatrix ist).

20

Empirische Wirtschaftsforschung

• ‘Method of Scoring’: Die ‘Method of Scoring’ verwendet anstelle der

Hess’schen Matrix die Informationmatrix − E(H)

−1

∂ ln L2

∂ ln L

θm+1 = θm + E

∂θ∂θ ′

∂θm

I(θ) = − E[H(θ)]

Da die Inverse der Informationsmatrix die asymptotische Varianz-Kovarianz

Matrix der ML Schätzer ist kann dies zur Schätzung der Varianz-Kovarianz

Matrix verwendet werden

−1

∂ ln L2

−1 b

b

var

c 2 (θ) = I (θ) = − E

b θb ′

∂ θ∂

• BHHH Methode: Die beiden vorhin genannten Methoden benötigen die

2. Ableitungen der Log-Likelihood Funktion. Im Gegensatz dazu benötigt die

BHHH Methode4 nur die ersten Ableitungen. Sie beruht darauf, dass das äußere Produkt der Gradienten eine Approximation der Informationsmatrix ist

M

X

∂ ln Li ∂ ln Li ′

∂θm ∂θm

i=1

wobei ln Li der Wert der Log-Likelihood Funktion für die i-te Beobachtung ist.

Diese Approximation ist meist einfacher zu berechnen und führt zu folgender

Iteration

!−1

M

X

∂ ln Li ∂ ln Li ′

∂ ln L

θm+1 = θm −

∂θm ∂θm

∂θm

i=1

Der in EViews implementierte Marquardt Algorithmus ist eine ähnliche Modifikation der BHHH-Methode wie die ‘quadratic hill climbing’ Methode des

Newton-Raphson Algorithmus.

Mit der BHHH-Methode wird die Varianz-Kovarianz Matrix der ML Schätzer

meist geschätzt als

!−1

n

X

∂

ln

L

∂

ln

L

i

i

b =

var

c 3 (θ)

∂ θb

∂ θb ′

i=1

Obwohl alle drei Schätzungen der Varianz-Kovarianz Matrix asymptotisch

äquivalent sind können sich die unterschiedlichen Schätzmethoden in kleinen

Stichproben stark unterscheiden.

• Numerische Ableitungen: Wenn die Gradienten nicht berechnet werden

können müssen diese numerisch appoximiert werden. Für einen einzelnen Parameter θ z.B. durch

∂ ln L

ln L(θ + ∆) − ln L(θ)

≈

∂θ

∆

4

benannt nach Berndt, E., B. Hall, R. Hall, and J. Hausman (1974): Estimation and inference

in nonlinear structural models. Annals of Economic and Social Measurement 3:653-665); ausgesprochen B-triple-H

21

Empirische Wirtschaftsforschung

wobei ∆ eine relativ zu θ kleine Zahl ist. Diese Methoden sind sehr rechenintensiv und führen häufig zu Problemen mit der Konvergenz. Es empfiehlt sich

unterschiedliche Startwerte zu versuchen, um die Robustheit der Ergebnisse

zu sicherzustellen.

Häufige Ursachen für Konvergenz-Probleme sind z.B.

1. eine zu geringe Anzahl von Beobachtungen.

Sehr grobe Faustregel: Für ML Schätzungen sollten mindestens gegen 100

Beobachtungen vorliegen; mehr, wenn viele Parameter zu schätzen sind.

2. eine sehr unterschiedliche Skalierung der Variablen: wenn die Dimensionen der

X-Variablen sehr unterschiedlich sind (z.B. eine Variable eine Größenordnung

von 1000000 und eine andere Variable eine Größenordnung von 0.1 hat). Probleme dieser Art sind eher unwahrscheinlich, wenn das Verhältnis der größten

zur kleinsten Standardabweichung kleiner als 10 ist.

3. Multikollinearität u.ä.

Übungsbeispiel: Gegeben sei die Dichtefunktion

f (xi |θ) =

e−θ θxi

,

xi !

xi = 0, 1, 2, . . .

1. Berechnen Sie den Maximum Likelihood Schätzer für θ.

2. Angenommen, aus dieser Verteilung wird folgende (i.i.d.) Stichprobe gezogen:

3, 0, 1, 2, 4.

Testen Sie mit Hilfe eines Likelihood Ratio Tests die Nullhypothese: θ = 1.

[Hinweis: 0! = 1, 1! = 1, 2! = 2 × 1 = 2, 3! = 3 × 2 × 1 = 6, 4! = 24]

Lösung: Die Dichtefunktion der diskreten Poisson-Verteilung ist

f (xi |θ) =

e−θ θxi

,

xi !

xi = 0, 1, 2, . . .

Da die einzelnen Beobachtungen unabhängig gezogen wurden ist die Wahrscheinlichkeit genau diese Stichprobe zu erhalten

f (x1 , x2 , . . . , xn |θ) =

bzw. für die Stichprobe {3, 0, 1, 2, 4}

n

Y

i=1

e−nθ θ

f (xi |θ) = Qn

Pn

i=1

e−5θ θ

f (x1 , x2 , . . . , x5 |θ) = Q5

P5

i=1

i=1

xi !

xi

=

i=1

xi !

e−5θ θ10

288

xi

22

Empirische Wirtschaftsforschung

Die Log-Likelihood Funktion ist

ln L(θ|x) = −nθ + ln θ

also

n

X

i=1

xi −

n

X

ln(xi !)

i=1

n

1X

∂ ln L(θ|x)

!

= −n +

xi = 0

∂θ

θ i=1

Daraus folgt der ML-Schätzer

n

θ̂M L =

1X

xi = x̄

n i=1

Für die Stichprobenbeobachtungen

ln L(θ|x) = −5θ + 10 ln θ − 5.66296

und

∂ ln L(θ|x)

10 !

= −5 +

=0

∂θ

θ

⇒

θ̂ML = 2

Der Wert der Log-Likelihood Funktion des nicht restringierten Modells ist

ln L(θ = 2|x) = −5 · 2 + 10 ln(2) − 5.66296 = −8.7314887

Der Wert der Log-Likelihood Funktion des restringierten Modells ist

ln L(θ = 1|x) = −5 · 1 + 10 ln(1) − 5.66296 = −10.662960

Also ist

a

LR = −2 ln λ = 2[−8.7314887 + 10.662960] = 3.8629426 ∼ χ21

Der kritische Wert (5%) der χ2 - Verteilung mit einem Freiheitsgrad ist 3.84, die

Nullhypothese θ = 1 kann also auf dem 5% Niveau verworfen werden.

18.7

Ein Beispiel in EViews

In den meisten Programmen sind die üblichen Routinen für Maximum Likelihood

Schätzungen bereits fix programmiert, so auch in EViews. Sollte man ein spezielles

Problem haben kann man aber auch einfach eine beliebige Log-Likelihood Funktion

maximieren. In EViews steht dazu das LOGL-Objekt zur Verfügung.

Wir erinnern uns, die Log-Likelihood Funktion für normalverteilte Zufallsvariablen

ist

n Y

1

2

′

2

2

√

L(β, σ ) =

exp −(yi − xi β) /(2σ )

σ 2π

i=1

n

h X

i

1

√

=

exp −

(yi − x′i β)2 /(2σ 2 )

σ 2π

23

Empirische Wirtschaftsforschung

wobei x′i ein (1 × k) Zeilenvektor für die i-te Beobachtung ist, d.h. x′i β = β2 xi1 +

β3 xi2 + · · · + βk xik . Durch Logarithmierung erhält man die Log-Likelihood Funktion

√

1 X

(yi − x′i β)2

ln L = −n ln σ − n ln 2π − 2

2σ

Dies kann auch als Summe geschrieben werden

n X

√

1

′

2

ln L =

− ln σ − ln 2π − 2 (yi − xi β)

2σ

i=1

Der Beitrag einer einzelnen Beobachtung zur Log-Likelihood Funktion ist deshalb

ln Li = −0.5 ln(σ 2 ) − 0.5 ln(2π) −

1

(yi − x′i β)2

2

2σ

Die Maximum Likelihood Methode findet die Schätzwerte der Parameter, die den

Wert der Log-Likelihood Funktion für die gegebenen Beobachtungen maximiert.

Man beachte, dass diese Beiträge einfacher mit Hilfe der Dichtefunktion φ geschrieben werden kann

1

√

exp −(yi − x′i β)2 /(2σ 2 )

σ 2π

1

ln(φ) = −0.5 ln(σ 2 ) − 0.5 ln(2π) − 2 (yi − x′i β)2

2σ

φ = f (β, σ 2 ) =

φ ist die Dichtefunktion einer N(0, σ 2 ) verteilten Zufallsvariablen. EViews stellt

mit der Funktion @dnorm(·) die Dichte einer N(0, 1) verteilten Zufallsvariablen zur

Verfügung. Deshalb empfiehlt es sich den Wert in der Dichtefunktion durch σ zu

dividieren und eine entsprechende Anpassung vorzunehmen. Die Beiträge zur LogLikelihood Funktion können deshalb auch geschrieben werden

(yi − x′i β)

ln σ 2

√

ln Li = ln φ

−

2

σ2

Dies ist in EViews einfach umzusetzen. Es wird ein logl-Objekt angelegt und in

diesem Objekt wird mit der Funktion @logl seriesname die Datenreihe definiert, die

die einzelnen Beiträge zur Log-Likelihood Funktion (d.h. ln Li ) aufnimmt. Darüber

hinaus müssen zuerst die zu schätzenden Parameter initialisiert werden (d.h. es

müssen ihnen Startwerte zugeordnet werden) und es können neue Datenreihen angelegt werden, die die Berechnungen erleichtern können. Für eine einfache Schätzung

eines linearen Regressionsmodells mit normalverteilten Störterm würde der EViews

Code etwa folgendermaßen aussehen

wfcreate u 100

rndseed 12345

series x = @trend

series y = 100 + 2*x + 9*@rnorm

logl ll1

’ define logl-object

24

Empirische Wirtschaftsforschung

’ set starting values c(1), c(2) and c(3) to OLS equation

eq1.ls y c x

c(3) = @se^2

ll1.append @logl logl1

ll1.append res = y-c(1)-c(2)*x

ll1.append logl1 = log(@dnorm(res/@sqrt(c(3))))-log(c(3))/2

’ or more complicated

’ ll1.append logl2 = -0.5*(log(c(3))) - 0.5*log(2*3.14159) _

’

- (res)^2 / (2*c(3))

ll1.ml

show ll1

Dieses Progrämmchen erzeugt folgenden Output:

LogL: LL1

Method: Maximum Likelihood (Marquardt)

Sample: 1 100

Included observations: 100

Evaluation order: By observation

Convergence achieved after 21 iterations

C(1)

C(2)

C(3)

Log likelihood

Avg. log likelihood

Number of Coefs.

Coefficient

101.6890

1.993070

75.02867

−357.7889

−3.577889

3

Std. Error z-Statistic

Prob.

2.077847

48.93961

0.0000

0.033901

58.79021

0.0000

10.51438

7.135817

0.0000

Akaike info criterion

7.215777

Schwarz criterion

7.293932

Hannan-Quinn criter. 7.247408

wobei c(1) und c(2) die geschätzten Koeffizienten und c(3) die Schätzung für die

Varianz σ 2 ist.

Zum Vergleich die OLS-Schätzung:

Dependent Variable: Y

Method: Least Squares

Included observations: 100

Variable

C

X

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

Coefficient

101.6896

1.993063

0.977834

0.977608

8.749979

7503.090

−357.7889

1.727446

Std. Error t-Statistic

1.736952

58.54483

0.030312

65.75089

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

Prob.

0.0000

0.0000

200.3462

58.47342

7.195777

7.247880

4323.179

0.000000

Die OLS-Schätzung der Varianz σ 2 ist das Quadrat des Standardfehlers der Regression (S.E. of regression), also 8.7499792 = 76.56213, die sich etwas von der ML

Schätzung unterscheidet, was nicht erstaunt, denn bekanntlich ist die ML-Schätzung

der Varianz in kleinen Stichproben verzerrt.

Empirische Wirtschaftsforschung

25

Literaturverzeichnis

Engle, R. (1982), ‘A General Approach to Lagrangian Multiplier Model Diagnostics’,

Journal of Econometrics 20, 83–104.

Johnston, J. and Dinardo, J. (1996), Econometric Methods, 4 edn, McGrawHill/Irwin.

Long, J. S. (1997), Regression Models for Categorical and Limited Dependent Variables (Advanced Quantitative Techniques in the Social Sciences), 1 edn, Sage

Publications, Inc.

Murray, M. P. (2005), Econometrics: A Modern Introduction (Addison-Wesley Series

in Economics), us ed edn, Addison Wesley.