"Lineare Modelle in der Statistik" und - Mathematik

Werbung

Exkurse

zur Linearen Algebra, Wahrscheinlichkeitstheorie

und Statistik für die Skri pte

Lineare Modelle in der Statistik

Generaliserte Lineare Modelle

von

Gerhard Osius

0.4

0

2

0.2

0. 0 -~=:r::::.,__...,......:;::::....,......~~;=,-..,....::;:::::::;::=;=-;::::;::::::;:::=:;==;==-'I"""""T'".:::;:::;:::::;:::::;

-5

0

5

10

15

20

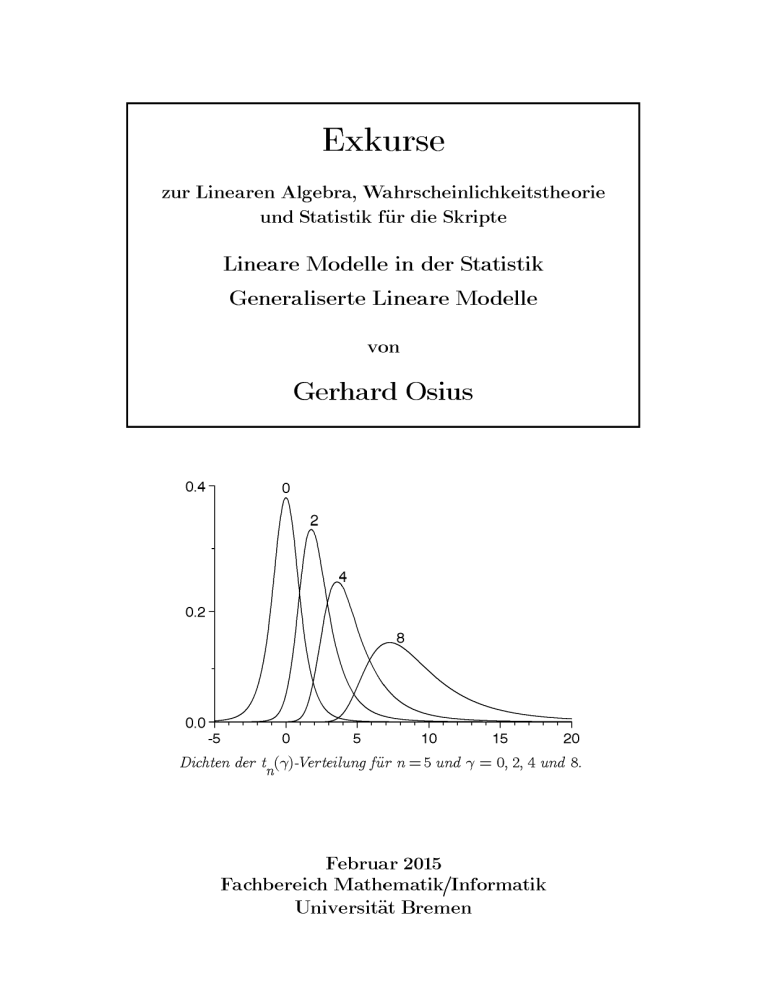

Dichten der t ('-y)-Verteilung für n = 5 und"(= 0, 2, 4 und 8.

n

Februar 2015

Fachbereich Mathematik/Informatik

Universität Bremen

Vorwort

Dies ist eine Zusammenstellung von Resultaten (vorwiegend aus der Wahrscheinlichkeitstheorie und der Linearen Algebra) die in meinen Skripten zu den Lehrveranstaltungen Lineare Modelle in der Statistik und Generalisierte Lineare Modelle verwendet werden. Die Exkurse behandeln unter anderem die univariaten Standardverteilungen von Teststatistiken (Chiquadrat-, t- und F- Verteilungen, auch nichtzentral), die multivariate Normalverteilung - deren Darstellung an Rao (1973) Linear

Statistical lnference and its Applications angelehnt ist - sowie Verteilungskonvergenz

in euklidischen Räumen - die weitgehend Billingsley (1968) Convergence of Probility

Measures und Billingsley (1979) Probability and Measure entnommen ist.

Die Beweise der Resultate die nicht als "Standardwissen" vorausgesetzt sind werden

am Ende des jeweiligen Exkurses mehr oder weniger vollständig zusammengestellt

oder es wird auf eine Literaturstelle verwiesen. Das "Standardwissen" kann in den

einschlägigen Lehrbüchern nachgelesen werden, z.B. wenn es sich um Verteilungen

handelt, bei Johnson und Kotz (1970-72) Distributions in Statistics.

Gegenüber der Auflage vom Februar 2014 sind nur gerinfügige Änderungen und

Korrekturen vorgenommen.

Bremen, im Februar 2015

Gerhard Osius

Inhaltsverzeichnis

27.2.15

Inhalt

1

(Seiten pro Kapitel)

Verteilungen

V

Die zentralen und nichtzentralen Chiquadrat-, tund F- Verteilungen

1

Die Chiquadrat-Verteilung

1.1 Die zentrale Chiquadrat-Verteilung

1.2 Die nichtzentrale Chiquadrat-Verteilung

1.3 Grenzwertsätze und Approximationen

(6)

2

Die t- Verteilung

2.1 Die zentrale t- Verteilung

2.2 Die nichtzentrale t- Verteilung

2.3 Approximationen der nichtzentralen t- Verteilung

(5)

3

Die F- Verteilung

3.1 Die zentrale F- Verteilung

3.2 Die F- Verteilung mit reellen Freiheitsgraden

3.3 Die nichtzentrale F- Verteilung

3.4 Approximationen der nichtzentralen F- Verteilung

(7)

Beweise

1

2

3

Die Chiquadrat-Verteilung

Die t- Verteilung

Die F- Verteilung

MN

Die multivariate Normalverteilung

1.

2.

3.

4.

5.

6.

Die eindimensionale Normalverteilung

Definition der multivariaten Normalverteilung

Eigenschaften der multivariaten Normalverteilung

Quadratische Formen von normalverteilten Variablen

Bedingte Normalverteilungen

Die zweidimensionale Normalverteilung

Beweise

3. Eigenschaften der multivariaten Normalverteilung

4. Quadratische Formen von normalverteilten Variablen

5. Bedingte Normalverteilungen

(7)

(7)

(6)

(17)

(15)

Inhaltsverzeichnis

27.2.15

M

Die Multinomialverteilung

1.

2.

3.

4.

5.

6.

7.

Definition

Auftreten

Randverteilungen, Erwartungswert, Covarianz

Erzeugende Funktionen

Multinomial-Grenzwertsatz

Darstellung als bedingte Poisson-Verteilung

Darstellung als Exponential-Familie

Q

1

2

(10)

(13)

Beweise

3.

4.

5.

6.

7.

2

Randverteilungen, Erwartungswert, Covarianz

Erzeugende Funktionen

Multinomial-Grenzwertsatz

Darstellung als bedingte Poisson-Verteilung

Darstellung als Exponential-Familie

Quantile von Verteilungen

(6)

Definition und elementare Eigenschaften

1.1 Binomialverteilung

1.2 Poisson-Verteilung

Verteilungskonvergenz und Quantile

Beweise

(8)

Inhaltsverzeichnis

27.2.15

3

Maß- und Wahrscheinlichkeitstheorie

CF

Charakteristische, Momente- und Kumulanten-erzeugende

Funktionen

1.

2.

3.

4.

5.

Definition der charakteristischen Funktion

Definition der Momente- und Kumulanten-erzeugenden Funktion

Die Eindeutigkeitssätze

Rechenregeln

Momente und Kumulanten eindimensionaler Verteilungen

5.1 Charakteristische Funktion und Momente

5.2 Moment-erzeugende Funktion und Momente

5.3 Kumulanten-erzeugende Funktion und Kumulanten

6.

Spezielle Verteilungen

6.1 Eindimensionale Normalverteilung

6.2 Multivariate Normalverteilung

6.3 Binomial-Verteilung

6.4 Multinomial-Verteilung

6.5 Poisson-Verteilung

Erwartungswert und Covarianzmatrix von Zufallsvektoren

7.

Beweise (noch unvollständig)

KV

1.

2

3

4

5

6

7

8

9

10

11

12

13

14

Konvergenz nach Verteilung in euklidischen Räumen

(11)

(1)

(12)

Definition der Verteilungskonvergenz

Konvergenz von Bildmaßen

Konvergenz von Produkt-Maßen

Konvergenz nach Wahrscheinlichkeit gegen eine Konstante

Rechenregeln von Slutzky über Konvergenz nach Verteilung

und Wahrscheinlichkeit

Die Reduktionsmethode von Cramer-Wald

Der Stetigkeitssatz für charakteristische Funktionen

Der Stetigkeitssatz für Moment-erzeugende Funktionen

Der Darstellungssatz von Skorohod

Stochastische Beschränktheit und der Satz von Prohorov

Konvergenz gegen Unendlich

Konvergenz von Wahrscheinlichkeiten

Konvergenz von Quantilen

Differenzierbare Transformation (Delta-Methode)

Beweise

(9)

Inhaltsverzeichnis

27.2.15

ZGS

Der zentrale Grenzwertsatz für reelle Zufallsvariablen

1.

2.

3.

4.

Die allgemeinen Resultate von Lindeberg und Ljapunov

Resultate für identische Verteilungen

Linearkombinationen unabhängiger Verteilungen

Die Ungleichung von Berry-Esseen

4

(9)

Beweise

(7)

BV

Bedingte Verteilungen

(9)

1.

Definition

1.1 Diskreter Fall

1.2 Allgemeiner Fall

2.

Methoden zur Bestimmung bedingter Verteilungen

2.1

2.2

2.3

2.4

3.

Stochastische Unabhängigkeit

Bildmaße bedingter Verteilungen

Unabhängigkeits-Transformationen

Bedingte Dichten

Erwartungswerte bedingter Verteilungen

3.1 Nicht-negative meßbare Abbildunden

3.2 Beliebige meßbare Abbildunden

Beweise

(2)

BEC Bedingte Erwartung und Covarianz-Matrix zufälliger Vektoren (3)

1.

2.

Grundlagen

Lineares Modell mit homogenen bedingten Covarianzen-

Beweise

COV Covarianz-Matrizen zufälliger Vektoren

Beweise

(2)

(1)

Inhaltsverzeichnis

27.2.15

5

WM Wurzeln positiv-semidefiniter Matrizen

(2)

Lineare Algebra

1.

2.

3.

Definition

Wurzeln positiv-definiter Matrizen

Die Cholesky-Wurzel

Beweise

(3)

SP

Skalarprodukte und orthogonale Projektionen

(5)

1.

2.

3.

Definitionen

Eigenschaften der Projektionen

Projektionen und Exponentialfunktion

Beweise

GI

Generalisierte Inverse einer Matrix

Beweise

(14)

(2)

(7)

Inhaltsverzeichnis

27.2.15

6

Statistik

MTK Multiple Tests und Konfidenzbereiche

2.

3.

Simultane Tests

Simultane Konfidenzbereiche

Sequentielle Tests

MS

Minimale und maximale gewichtete Streuung

1.

Problemstellung

Minimierung

Maximierung

Äquidistante Werte und konstante Gewichte

1.

2.

3.

4.

(6)

(7)

Beweise

(3)

CPR Cross-Product-Ratios

(5)

1.

2.

Der Cross-Product-Ratio einer 2x2-Tafel

Der Cross-Product-Ratio einer Tafel

Beweise

(2)

Exkurse

zur Linearen Algebra, Wahrscheinlichkeitstheorie

und Statistik für die Skri pte

Lineare Modelle in der Statistik

Generaliserte Lineare Modelle

von

Gerhard Osius

0.4

0

2

0.2

0. 0 -~=:r::::.,__...,......:;::::....,......~~;=,-..,....::;:::::::;::=;=-;::::;::::::;:::=:;==;==-'I"""""T'".:::;:::;:::::;:::::;

-5

0

5

10

15

20

Dichten der t ('-y)-Verteilung für n = 5 und"(= 0, 2, 4 und 8.

n

Februar 2014

Fachbereich Mathematik/Informatik

Universität Bremen

Vorwort

Dies ist eine Zusammenstellung von Resultaten (vorwiegend aus der Wahrscheinlichkeitstheorie und der Linearen Algebra) die in meinen Skripten zu den Lehrveranstaltungen Lineare Modelle in der Statistik und Generalisierte Lineare Modelle verwendet werden. Die Exkurse behandeln unter anderem die univariaten Standardverteilungen von Teststatistiken (Chiquadrat-, t- und F- Verteilungen, auch nichtzentral), die multivariate Normalverteilung - deren Darstellung an Rao (1973) Linear

Statistical lnference and its Applications angelehnt ist - sowie Verteilungskonvergenz

in euklidischen Räumen - die weitgehend Billingsley (1968) Convergence of Probility

Measures und Billingsley (1979) Probability and Measure entnommen ist.

Die Beweise der Resultate die nicht als "Standardwissen" vorausgesetzt sind werden

am Ende des jeweiligen Exkurses mehr oder weniger vollständig zusammengestellt

oder es wird auf eine Literaturstelle verwiesen. Das "Standardwissen" kann in den

einschlägigen Lehrbüchern nachgelesen werden, z.B. wenn es sich um Verteilungen

handelt, bei Johnson und Kotz (1970-72) Distributions in Statistics.

Gegenüber der Auflage vom Februar 2012 sind nur gerinfügige Änderungen und

Korrekturen vorgenommen.

Bremen, im Februar 2014

Gerhard Osius

Inhaltsverzeichnis

4.2.14

Inhalt

1

(Seiten pro Kapitel)

Verteilungen

V

Die zentralen und nichtzentralen Chiquadrat-, tund F- Verteilungen

1

Die Chiquadrat-Verteilung

1.1 Die zentrale Chiquadrat-Verteilung

1.2 Die nichtzentrale Chiquadrat-Verteilung

1.3 Grenzwertsätze und Approximationen

(6)

2

Die t- Verteilung

2.1 Die zentrale t- Verteilung

2.2 Die nichtzentrale t- Verteilung

2.3 Approximationen der nichtzentralen t- Verteilung

(5)

3

Die F- Verteilung

3.1 Die zentrale F- Verteilung

3.2 Die F- Verteilung mit reellen Freiheitsgraden

3.3 Die nichtzentrale F- Verteilung

3.4 Approximationen der nichtzentralen F- Verteilung

(7)

Beweise

1

2

3

Die Chiquadrat-Verteilung

Die t- Verteilung

Die F- Verteilung

MN

Die multivariate Normalverteilung

1.

2.

3.

4.

5.

6.

Die eindimensionale Normalverteilung

Definition der multivariaten Normalverteilung

Eigenschaften der multivariaten Normalverteilung

Quadratische Formen von normalverteilten Variablen

Bedingte Normalverteilungen

Die zweidimensionale Normalverteilung

Beweise

3. Eigenschaften der multivariaten Normalverteilung

4. Quadratische Formen von normalverteilten Variablen

5. Bedingte Normalverteilungen

(7)

(7)

(6)

(17)

(15)

Inhaltsverzeichnis

4.2.14

M

Die Multinomialverteilung

1.

2.

3.

4.

5.

6.

7.

Definition

Auftreten

Randverteilungen, Erwartungswert, Covarianz

Erzeugende Funktionen

Multinomial-Grenzwertsatz

Darstellung als bedingte Poisson-Verteilung

Darstellung als Exponential-Familie

Q

1

2

(10)

(13)

Beweise

3.

4.

5.

6.

7.

2

Randverteilungen, Erwartungswert, Covarianz

Erzeugende Funktionen

Multinomial-Grenzwertsatz

Darstellung als bedingte Poisson-Verteilung

Darstellung als Exponential-Familie

Quantile von Verteilungen

(6)

Definition und elementare Eigenschaften

1.1 Binomialverteilung

1.2 Poisson-Verteilung

Verteilungskonvergenz und Quantile

Beweise

(8)

Inhaltsverzeichnis

4.2.14

3

Maß- und Wahrscheinlichkeitstheorie

CF

Charakteristische, Momente- und Kumulanten-erzeugende

Funktionen

1.

2.

3.

4.

5.

Definition der charakteristischen Funktion

Definition der Momente- und Kumulanten-erzeugenden Funktion

Die Eindeutigkeitssätze

Rechenregeln

Momente und Kumulanten eindimensionaler Verteilungen

5.1 Charakteristische Funktion und Momente

5.2 Moment-erzeugende Funktion und Momente

5.3 Kumulanten-erzeugende Funktion und Kumulanten

6.

Spezielle Verteilungen

6.1 Eindimensionale Normalverteilung

6.2 Multivariate Normalverteilung

6.3 Binomial-Verteilung

6.4 Multinomial-Verteilung

6.5 Poisson-Verteilung

Erwartungswert und Covarianzmatrix von Zufallsvektoren

7.

(11)

Beweise (noch unvollständig)

KV

1.

2

3

4

5

6

7

8

9

10

11

12

13

14

Konvergenz nach Verteilung in euklidischen Räumen

(12)

Definition der Verteilungskonvergenz

Konvergenz von Bildmaßen

Konvergenz von Produkt-Maßen

Konvergenz nach Wahrscheinlichkeit gegen eine Konstante

Rechenregeln von Slutzky über Konvergenz nach Verteilung

und Wahrscheinlichkeit

Die Reduktionsmethode von Cramer-Wald

Der Stetigkeitssatz für charakteristische Funktionen

Der Stetigkeitssatz für Moment-erzeugende Funktionen

Der Darstellungssatz von Skorohod

Stochastische Beschränktheit und der Satz von Prohorov

Konvergenz gegen Unendlich

Konvergenz von Wahrscheinlichkeiten

Konvergenz von Quantilen

Differenzierbare Transformation (Delta- Methode)

Beweise

(9)

Inhaltsverzeichnis

4.2.14

ZGS

Der zentrale Grenzwertsatz für reelle Zufallsvariablen

1.

2.

3.

4.

Die allgemeinen Resultate von Lindeberg und Ljapunov

Resultate für identische Verteilungen

Linearkombinationen unabhängiger Verteilungen

Die Ungleichung von Berry-Esseen

4

(9)

Beweise

(7)

BV

Bedingte Verteilungen

(9)

1.

Definition

1.1 Diskreter Fall

1.2 Allgemeiner Fall

2.

Methoden zur Bestimmung bedingter Verteilungen

2.1

2.2

2.3

2.4

3.

Stochastische Unabhängigkeit

Bildmaße bedingter Verteilungen

Unabhängigkeits-Transformationen

Bedingte Dichten

Erwartungswerte bedingter Verteilungen

3.1 Nicht-negative meßbare Abbildunden

3.2 Beliebige meßbare Abbildunden

Beweise

(2)

BEC Bedingte Erwartung und Covarianz-Matrix zufälliger Vektoren (3)

1.

2.

Grundlagen

Lineares Modell mit homogenen bedingten Covarianzen-

Beweise

COV Covarianz-Matrizen zufälliger Vektoren

Beweise

(2)

(1)

Inhaltsverzeichnis

4.2.14

5

WM Wurzeln positiv-semidefiniter Matrizen

(2)

Lineare Algebra

1.

2.

3.

Definition

Wurzeln positiv-definiter Matrizen

Die Cholesky-Wurzel

Beweise

(3)

SP

Skalarprodukte und orthogonale Projektionen

(5)

1.

2.

3.

Definitionen

Eigenschaften der Projektionen

Projektionen und Exponentialfunktion

Beweise

GI

Generalisierte Inverse einer Matrix

Beweise

(14)

(2)

(7)

Inhaltsverzeichnis

4.2.14

6

Statistik

MTK Multiple Tests und Konfidenzbereiche

2.

3.

Simultane Tests

Simultane Konfidenzbereiche

Sequentielle Tests

MS

Minimale und maximale gewichtete Streuung

1.

Problemstellung

Minimierung

Maximierung

Äquidistante Werte und konstante Gewichte

1.

2.

3.

4.

(6)

(7)

Beweise

(3)

CPR Cross-Product-Ratios

(5)

1.

2.

Der Cross-Product-Ratio einer 2x2-Tafel

Der Cross-Product-Ratio einer Tafel

Beweise

(2)

V

Die zentralen und nichtzentralen Chiquadrat-,

t- und F-Verteilungen

Gerhard Osius

1

Die Chiquadrat-Verteilung

1.1

1.2

1.3

2

Die t- Verteilung

2.1

2.2

2.3

3

Die zentrale Chiquadrat-Verteilung

Die nichtzentrale Chiquadrat-Verteilung

Grenzwertsätze und Approximationen

Die zentrale t- Verteilung

Die nichtzentrale t- Verteilung

Approximationen der nichtzentralen t- Verteilung

Die F- Verteilung

3.1

3.2

3.3

3.4

Die zentrale F- Verteilung

Die F- Verteilung mit reellen Freiheitsgraden

Die nichtzentrale F- Verteilung

Approximationen der nichtzentralen F- Verteilung

V

Die zentralen und nichtzentralen Chiquadrat-,

t- und F-Verteilungen

Gerhard Osius

1

Die Chiquadrat-Verteilung

1.1

1.2

1.3

2

Die t- Verteilung

2.1

2.2

2.3

3

Die zentrale Chiquadrat-Verteilung

Die nichtzentrale Chiquadrat-Verteilung

Grenzwertsätze und Approximationen

Die zentrale t- Verteilung

Die nichtzentrale t- Verteilung

Approximationen der nichtzentralen t- Verteilung

Die F- Verteilung

3.1

3.2

3.3

3.4

Die zentrale F- Verteilung

Die F- Verteilung mit reellen Freiheitsgraden

Die nichtzentrale F- Verteilung

Approximationen der nichtzentralen F- Verteilung

G. Osius: Die Chiquadrat-Verteilung

8.7.10

1

Die Chiquadrat-Verteilung

1.1

Die zentrale Chiquadrat- Verteilung

V1-1

U = (U , ..., U ) sei ein n-dimensionaler Zufallsvektor, dessen Komponenten unab1

n

hängige reelle Zufallsvariablen mit Standard-Normalverteilung sind, d.h. L(U.)

Z

N(O, 1) für alle i = 1, ..., n. Die Verteilung der Quadratsumme

heißt eine zentrale Chiquadrat-Verteilung mit n Freiheitsgraden, die mit dem Symbol

2

X bezeichnet wird:

n

(2)

Da der Zufallsvektor U eine n-dimensionale Standard-Normalverteilung besitzt

n

(3)

L(U) = N (0,11 ) =

n

n

TI N(O, 1) ,

. 1

Z=

läßt sich die X2 -Verteilung auch suggestiv schreiben als das Normquadrat der n-din

mensionalen Standard-Normalverteilung

(4)

Die X2 - Verteilung besitzt eine Dichte cp , die nur auf den positiven Bereich (0,00)

n

n

konzentriert ist, und dort gegeben ist durch:

(5)

wobei

für

x> 0,

r die Eulersche Gamma/unktion ist:

00

(6)

r(a) = jtcx-1e-tdt.

o

Die Dichte cpn beschreibt auf (0,00) im Fall n < 2 eine fallende Kurve und im Fall

n> 2 eine schiefe Glockenkurve mit der Maximalstelle in x = n- 2 und zwei Wende-

punkten in x = (n- 2) ±

stelle.

J 2 (n -

2) also im Abstand

J 2 (n -

2) von der Maximal-

G. Osius: Die Chiquadrat-Verteilung

Vl-2

8.7.10

....Q)

..c

ü

(5

0.2

o. 0 +-Ä---.---.--....--,:::::;::::::::;:==;=-.,..::::;:::::::;::=r=;;;;;:=M=;=""T"'".,....-~:::;::=;=:;=;

o

5

10

15

20

25

2

Dichten der X -Verteilung jür die Freiheitsgrade m = 1,3,5 und 10.

m

Die Verteilungsjunktion P der X2 -Verteilung ist auf (0,00) streng monoton wachn

n

send und dort gegeben durch

x

(7)

Pn(x)

=P{x~ <x} =J cpn(u)du

für

x> o.

o

Das (obere) a-Quantil x~. et der x~ -Verteilung ist dann gegeben durch

,

(8)

X2

ni et

=p-1 (1-a)

n

bzw.

p{X 2 >X2

n-

Für den Freiheitsgrad n=l lassen sich P 1 bzw.

P bzw. das obere

~ -Quantil

}=a

ni et

xi.

et

fürO<a<1.

durch die Verteilungsfunktion

z et/2 = P- (1_ ~)' der Standard-Normalverteilung

1

N(O,l) beschreiben:

(9)

(10)

1- 2P(-JX)

für

x> 0,

für 0< a< 1.

Der Erwartungswert von X 2 ist der Freiheitsgrad n,und die Varianz ist der doppelte

n

Freiheitsgrad

(11)

G. Osius: Die Chiquadrat-Verteilung

8.7.10

Vl-3

Die Faltung von X2- Verteilungen ist wieder eine solche

2

xm

und X 2 stochastisch unabhängig

n

(12)

::::}

Für wachsenden Freiheitsgrad konvergiert die standardisierte X2 -Verteilung nach

n

Verteilung gegen die Standard-Normalverteilung

(x~ - n)/ y'2n ~ N(O,l)

(13)

für n ---+

00,

für n ---+

00.

und es folgt

x~/n

(14)

p)

1

Die X2 -Verteilung ist eine spezielle Gamma-Verteilung

n

X~ = Gam(~,2),

(15)

und hieraus kann man weitere (und teilweise auch obige) Eigenschaften der

X - Verteilungen herleiten. Eine Gamma-Verteilung der Form Garn ( ~, 2) mit belie2

bigem v> 0 wird daher auch als Chiquadrat-Verteilung mit Freiheitsgrad v bezeichnet:

Gam( ~,2)

(16)

1.2

für v> o.

Die nichtzentrale Chiquadrat-Verteilung

U = (U , ..., U ) sei ein n-dimensionale Zufallsvektor, dessen Komponenten unabhän1

n

gige reelle Zufallsvariablen mit folgneder Normalverteilung sind

(1)

L(U.)

z = N(fL·,l)

z

für i = 1,...,n.

Dann hängt die Verteilung der Quadratsumme

nur noch über die sogenannte Nichtzentralität

vom Vektor Jl = (fLl' ... ,fL ) der Erwartungswerte ab. Diese Verteilung

n

G. Osius: Die Chiquadrat-Verteilung

Vl-4

8.7.10

heißt die nichtzentrale X 2- Verteilung mit n Freiheitsgraden und Nichtzentraltität 8. Da

der Zufallsvektor U n-dimensional normalverteilt ist mit Erwartungsvektor Jl

n

(5)

cL'(U) = N (Jl,ll ) = TI N(Jlo,l) ,

n

n

i=l

z

läßt sich die X2 (8)- Verteilung auch suggestiv schreiben als

n

(6)

Für 8 =

mit

°bzw. Jl

2

= 0 liegt die zentrale X - Verteilung vor:

(7)

Die Faltung von nichtzentralen X2- Verteilungen ist wieder eine solche mit der

Summe der Freiheitsgerade bzw. Nichtzentralitäten als Freiheitsgrad bzw. Nichtzentralität:

Für den Freiheitsgrad n = 1 ist

und die Dichte <Pl6 bzw. Verteilungsfunktion P 1 6 von X; (8) ergeben sich aus der

,

,

Dichte <P bzw. Verteilungsfunktion P der Standardnormalverteilung N( 0,1) :

(10)

p(JX-j6) - p(-JX -)6)

(11)

(<p(JX-ß) + <p(-JX -J6))/2VX >

2

2

fürx>O,

°

fürx>O.

2

Für n> 1 läßt sich die X (8) als Faltung von X (8) mit der zentralen X l-Verteilung

n

l

ndarstellen

(12)

X; (8) und X~-l unabhängig

Hieraus ergibt sich für die Dichte <P

=*

xi( 8) + X~-l = X~( 8).

2

n,us: und Verteilungsfunktion P n,us: von X n(8):

00

(13)

(14)

<pni

, x)

Pn,6(x)

Folglich ist <P

folgt

J <Pl6 (x-y)

o00 '

. <Pn-l (y) dy >0

J P1 6 (x- y) . <P n-l (y) dy

o

für x> 0, n > 1,

für x> 0, n > 1.

'

2

n,us: auf (0,00) positiv, und für die Verteilungsfunktion Pn,us: von Xn(8)

G. Osius: Die Chiquadrat-Verteilung

Vl-5

8.7.10

P s: ist streng wachsend auf (0,00).

(15)

n,u

Die Verteilungsfunktion hängt von der Nichtzentralität wie folgt ab

Pn 8(x) = P{X~(8) < x}

(16)

,

ist streng wachsend in x> 0

und streng fallend in 8>0 für x> O.

Für 8 ---+ 00 ergeben sich - aus (9) für n= 1 und mit (11) für nE W - die Grenzwerte

für 8 ---+ 00,

(17)

P n,oo (x) = 0

(18)

für x

> o.

Das obere a-Quantil von X2 (8) ist definiert durch

n

2

X

(19)

1

n,et

2

2

(8) = P- s:(1-a) bzw. P{X n > X n ,,,(8)} = a

n,u

,u-

für 0< a< 1,

und es gilt

(20)

X

2

n,et

(8) ist streng fallend in a und streng wachsend in 8

sowie (vgl. z.B. Agresti 1990, p.98)

(21)

Pn,8 (X~ ,et) = P{X~(8) < X~ ,et} ist streng wachsend in n.

Der Erwartungswert und die Varianz von X2 (8) lauten

n

2

(22)

Var{x (8)} = 2(n

n

+ 28) .

o

0.1

o. 0 ~r--T""---r--"'T"'""""""T---r-~.....----T----r----r--T"'"""""'T---':=:::;=::;:::=;:~~

o

5

10

15

20

Dichten der X2 (8)-Verteilung für n = 5 und Nichtzentralitäten 8 = 0, 1, 2 und 4.

n

G. Osius: Die Chiquadrat-Verteilung

Vl-6

8.7.10

Allgemeiner ist die k-te Kumulante von X2 (8) gegeben durch (vgl. Johnson-Kotz

n

1970-72, Chap. 28, Sec. 4):

Hieraus ergeben sich speziell die Kumulanten und zentralen Momente 3. und 4.

Ordnung zu

(24)

~3(X~( 8))

fL3(X~( 8)) = 8 (n- 38) ,

(25)

~iX~(8))

48 (n- 48) ,

(26)

fL3(X~( 8))

~4(X~(8)) + 3 (Var{x~(8)})2

1.3

48(n-48)

+ 12(n+28)2.

Grenzwertsätze und Approximationen

Die nichtzentrale X2 (8)-Verteilung ist nach 1.3 (8) die n-fache Faltung von

n

X~( Verteilungen. Hieraus ergibt sich mit dem Zentralen Grenzwertsatz die

%)-

asymptotische Normalverteilung der Standardisierung von X2 (8) für n---+ 00

n

X~(8) - (n+8)

(1)

J2(n + 28)

L

)

N(O, 1) ,

n-HX!

die für 8 = 0 zu 1.1 (13) reduziert. Für nicht zu kleines n erhält man hieraus die Normal-Approximation von X2 (8)

n

(2)

fL = n+8,

mit

a=

J 2(n + 28)

.

Eine andere Approximation, die auch für kleines n gilt, hat Patnaik (Biometrika 36,

1949, 202-232) vorgeschlagen. Hierbei wird die nichtzentrale Verteilung X2 (8) durch

n

2

das Vielfache c· X einer zentralen Verteilung approximiert, wobei c> 0 und v> 0

v

so gewählt werden, daß die ersten beiden Momente beider Verteilung übereinstimmen (vgl. auch Johnson-Kotz 1970-72, Ch. 28, Sec. 8)

n+28

(3)

c =

n

+8

(n+8)2

v =

n

+ 28

Hieraus ergibt sich die Gamma-Approximation von X2 (8)

n

(4)

mit der sich die Dichte und Verteilungsfunktion von X2 (8) approximieren lassen.

n

G. Osius: Die t- Verteilung

V2-1

8.7.10

2

Die t- Verteilung

2.1

Die zentrale t- Verteilung

Sind U und V unabhängige reelle Zufallsvariablen mit den Verteilungen

L(U) = N(O, 1L

(1)

L(V) =

X

2

n!

so heißt die Verteilung des Quotienten

(2)

T=

U

V1n V

eine zentrale t-Verteilung mit n Freiheitsgraden, die mit t bezeichnet wird

n

tn : = L(T) = cL( U/

(3)

V~ V ) .

Die t -Verteilung läßt sich suggestiv auch schreiben als

n

(4)

tn

:=

N(O,l)

/V1n X2n

für unabhängige N(O, 1) und X2 .

n

Die t -Verteilung besitzt auf IR folgende Dichte ep

n

n

x2 )-(n+ 1)/2

(5)

epn ( x ) = an ( 1 + -n

für x E IR ,

wobei die Konstante a unter Verwendung der Eulerschen-Gammafunktion

n

niert ist durch

(6)

a

n

r(n~1 ) / (r( ~ );:;;;-).

Die Dichte ep beschreibt eine um

n

depunkten in x = ± Jn/(n+2) .

Die Verteilungs/unktion P mit

n

x=o symmetrische Glockenkurve

mit den Wen-

x

Pn(x) =P{tn <x} =

-

(7)

r defi-

J epn(u)du

00

ist eine streng monoton wachsende sigmoide Kurve, die drehsymmetrisch im Punkt

(0,

(8)

+)

ist:

P (-x) = 1- P (x).

n

n

Das obere a-Quantil t

(9)

1

n,(X

der t -Verteilung ist dann gegeben durch

t : = p- (1- a)

n,(X

n

n

bzw.

P {t

>t

n- n,(X

}= a

für 0< a < 1.

G. Osius: Die t- Verteilung

V2-2

8.7.10

500

004

0.3

0.2

0.1

o. 0 ~"""""=;=::;::~T""'T"""T""T"""r-T""'1r-r-r"""T""'T""T""'T""T""T'""'T""T'""'T""T""T""'T"""T""'T"""T'""'T""'1r-r=:;==;=-r..,....;r::;

-4

-3

-1

-2

o

2

3

4

Dichten der t -Verteilung für die Freiheitsgrade n = 1, 2, 5 und 500.

n

Der Erwartungswert existiert nur für n> 1 und lautet

(10)

für n> 1.

E{tn } = 0

Und die Varianz existiert erst für n> 2 und ist dann

(11 )

Var {t } = n/ (n - 2)

n

>1

für n>2.

Für wachsenden Freiheitsgrad konvergiert die t

n

Verteilung gegen die Standard-

Normalverteilung

(12)

t

n

cf)

N(O,l)

für n

---+ 00,

d.h. es gilt

(13)

lim P (x) = P (x)

n

n---+oo

für alle x E IR

wobei P die Verteilungsfunktion von N(O,l) ist. Folglich konvergieren auch die zugehörigen Quantile

(14)

lim t

n---+oo

n,(X

= z

(X

für alle O<a<l,

wobei z(X = p-1 (1- a) das obere a-Quantil von N( 0,1) ist. Außerdem konvergieren

auch die Dichten cp punktweise gegen die Dichte cp von N(O,l):

n

(15)

lim

n---+oo

cp (x) = cp(x)

n

für alle xE IR.

G. Osius: Die t- Verteilung

2.2

V2-3

8.7.10

Die nichtzentrale t- Verteilung

Sind U und V unabhängige reelle Zufallsvariablen mit den Verteilungen

(1)

L(U) = Nb, 1),

so heißt die Verteilung des Quotienten

(2)

T=

U

V1n V

eine doppelt nichtzentrale t-Verteilung mit n Freiheitsgraden und den Nichtzentralitäten

"( und 8, die mit t ("(,8) bezeichnet wird

n

(3)

tn ("(,8):= L(T) =

4U / V~ V).

Die t ("(,8)-Verteilung läßt sich suggestiv auch schreiben als

n

2

(4)

für unabhängige N("( ,1) und X (8).

n

Für 8 = 0 ergibt sich die (einfach) nichtzentrale t b)- Verteilung mit Nichtzentralität "(

n

(5)

t ("() : = t ("(,0) = Nb, 1) /

n

n

V1n X2n

2

für unabhängige N("( ,1) und X .

n

Und für "( = 8 = 0 erhält man die zentrale t -Verteilung

n

(6)

t = t (0) = t (0,0).

n

n

n

0.4

0

0.2

o. 0 -k::::'-r4-,...4.---'---'~'T"""""r"::::;::::'=r=-';::::;::::;==:;:=;==-~:::;::::;:::::;=;

-5

o

5

10

15

20

Dichten der t ("()-Verteilung für n = 5 und Nichtzentralitäten "( = 0, 2, 4 und 8.

n

G. Osius: Die t- Verteilung

Die Dichte cp

V2-4

8.7.10

, von t ("(,8) läßt sich unter Verwendung der Dichten cp von N( 0,1)

n,"f,V

n

2

und cp ,von X (8) angeben:

n,v

n

00

(7)

cp

n,"(,

8(x) =

2

2

J

2nw .cp(wx-"().cp 8(nw )dw >

0

n,

Und die Verteilungsfunktion P

0

für xEIR.

, von t ("(,8) ergibt sich

n,"(,v

n

(8)

für xEIR.

Im Zusammenhang mit Schärfebetrachtungen von Tests sind folgende MonotonieEigenschaften der Verteilungsfunktion von Interesse:

(9)

P n, "( , 8(x) ist streng monoton wachsend in x E IR,

(10)

Pn,"(, 8( x) ist streng monoton fallend in "(E IR,

(11)

Pn,"(, 8( x) ist für x> 0 streng monoton wachsend in 8> 0,

wobei sich für "( ---+

(12)

± 00 bzw. 8 ---+ 00 folgende Grenzwerte ergeben

P n,-oo, 8(x) = 1,

P n, +00, 8(x)=0

P n, "(,00 (x) = 1

für x> 0

für xE IR

weil

p

(13)

tn ("(, 8) -------+ ± 00

(14)

tn ("(, 8)

p

-------+

0

für "( ---+

± 00,

für 8 ---+

00.

Ein Vorzeichenwechsel der Nichtzentralität "( bewirkt eine Spiegelung der Verteilung um Null

(15)

tn (-"(,8) = - tn ("(,8),

und hieraus ergibt sich für die Verteilungsfunktion

(16)

P

,(x) = 1-pn,

n,-"(,v

,(-x)

für xEIR.

"(,v

Erwartungswert und Varianz der einfach nichtzentralen Verteilung lauten

(17)

"( .fiif2 . r ( n;-l )/ r ( ~ )

(18)

(1

+ "(2)n/(n-2)

- E{t ("()}2

n

für n> 1,

für n>2.

G. Osius: Die t- Verteilung

2.3

V2-5

8.7.10

Approximationen der nichtzentralen t- Verteilung

Wir betrachten die doppelt-nichtzentral-t-verteilte Zufallsvariable

(1)

U

Tn

mit stochastisch unabhängigen

)1 V

n n

(2)

Für n ---+ 00 gilt

(3)

)1n Vn

S :=

n

P

----+l

n---+ 00

1

und somit

(4)

Tn

L

n---+ 00

l

Nb,l)

bzw.

tn ('Y,8)

N( 'Y, 1)

n---+ 00

Die zugehörigen Approximationen

(5)

S

n

~

für großes n

1,

sind allerding relativ grob. Aus der asymptotischen Normalverteilung von S

(6)

n

mit

(7)

ergibt sich als Präzisierung von (3) die Normalapproximation

(8)

mit

f-L

n

-----+

a

1,

n

-----+

O.

Daraus erhält man folgende Approximation der doppelt-nicht-zentralen t- Verteilungsfunktion für nicht zu kleines n

(9)

<!>

n,

,(x)

"(,u

~

<!>(u)

mit

u

Für die einfach-nicht-zentrale t- Verteilung reduziert dies zur Approximation

(10)

<!>

n, "{,

o(x)

~

<!>(u)

mit

U

=

X-,

V 1+ 2n

x2

die auf Johnson & Welch (1940, Biometrika 31, 362-389) zurückgeht, vgl. auch

Scheffe (1959, The Analysis

1970-72, eh. 31, Sec. 6.

01 Variance)

problem IV.4, p. 415) sowie Johnson & Kotz

G. Osius: Die F- Verteilung

V3-1

8.7.10

3

Die F- Verteilung

3.1

Die zentrale F- Verteilung

Sind U und V unabhängige reelle Zufallsvariablen mit Chiquadrat-Verteilungen

2

(1)

L( V) = X2n ,

L(U) = X ,

m

so heißt die Verteilung des Quotienten

(2)

lU

m

F

lV

n

eine zentrale F-Verteilung mit Zähler-Freiheitsgrad m und Nenner-Freiheitsgrad n) die

mit F

m,n

(3)

bezeichnet wird

F

Die F

m,n

m,n

= L(F) = L((lU)/(lV)).

n

m

-Verteilung läßt sich suggestiv auch schreiben als

1

(4)

2

mXm

Fm,n

2

2

für unabhängige Xm und X n .

12

nXn

Die F

m,n

-Verteilung besitzt eine Dichte cp

m,n

,die nur auf dem positiven Bereich

(0,00) von Null verschieden ist, und dort gegeben ist durch

(x) = d

. ~1 (mx

(5)

cp

(6)

p = ~ m,

(7)

dm,n - m n . r(p). r(q) ,

wobei

m,n

m,n

_

+ n)-(p+q) >

°

q= ~ n

p q

mit

und

r(p+q)

r die Eulersche Gammafunktion ist.

Die Dichte cp mn beschreibt für positive Argumente x im Fall m

,

fallende Kurve und im Fall

··

- n(m-2) 1

f ur

x - m(n+2) < .

Die Verteilungsjunktion P

< 2 eine monoton

m> 2 eine

schiefe "Glockenkurve" mit einem Maximum

der F

-Verteilung ist auf (0,00) streng monoton

m,n

m,n

wachsend und dort gegeben durch

x

(8)

P m,n (x) =P{Fm,n <x} =

Das obere a-Quantil F

m,n;o:

der F

m,n

J cp m,n (u)du.

o

-Verteilung ist dann gegeben durch

G. Osius: Die F- Verteilung

F

(9)

:=

m,n;Oi

V3-2

8.7.10

p-l (1- a)

bzw.

m,n

P{Fmn>Fmn·Oi }=a

,

,,

für O<a<1.

Der Erwartungswert existiert nur für n> 2 und hängt nicht von m ab:

(10)

E{ Fm,n } = --.I!:-2

n-

>

für n> 2.

1

Und die Varianz existiert erst für n> 4 und ist dann

2

2n (m+n-2)

(11)

Var{F

m,n

} =

m (n-

2)

2

(n-

für n>4.

4)

Bei Vertauschen beider Freiheitsgrade ergibt sich

(12)

F

1

n,m

F

m,n

(13)

p

(14)

F

n,m

(x)=l-P m,n (1)

X

für x

1

n,m;Oi

> 0,

für 0 < a< 1.

F

m,n;l-Oi

Für den Zähler-Freiheitsgrad m = 1 ergeben sich folgende Zusammenhänge zur zentralen t -Verteilung und deren Verteilungsfunktion P :

n

n

2

(15)

F

(16)

Pl ,n ( x) = 1 - 2 P n (-

l,n

= t

n

JX)

für x

64

> 0,

64

m = 1, 4, 16, 64

m=8

n = 1, 4, 16, 64

n=8

0.5

0.5

o ...fL.r---.-T"""""T'"...,.....,---.-...,......,--.--,.......,...,..::;:::::;=:~;;;;=;;;;;;;;;;

o

2

Dichten der F

3

m,n

4

O-t-'-f'---r""--"""""'''''--'''''''''''--'--T"""""T"--r-T"""""T"--r-T""""T--r-.,.....,

o

2

3

-Verteilung für verschiedene Freiheitsgrade mund n.

4

G. Osius: Die F- Verteilung

2

F1,n;Ct = tn;Ct/2

(17)

V3-3

8.7.10

für

°< a<

Für wachsenden Nenner-Freiheitsgrad n konvergiert die F

m,n

skalierte X2- Verteilung:

(18)

ci:

Fm,n

1

2

-·X

m

m

-------+

1.

-Verteilung gegen eine

für n ---+ 00.

Im Zusammenhang mit der Konstruktion von Konfidenzintervallen ist noch folgende Monotonie der Quantile bzgl. des Zählerfreiheitsgrades von Interesse:

(19)

3.2

m· F

m,n,Ct

ist für

°< a< 1 streng monoton wachsend bzgl.

mElN.

Die F- Verteilung mit reellen Freiheitsgraden

Aus der Darstellung der Chiquadrat-Verteilung als Gamma-Verteilung

ergibt sich die zentrale F- Verteilung wie folgt

1. Gam(:0 1)

(2)

m

Fm,n

2'

für unabhängige Gam(!J], l)und Gam(%, 1).

1. Gam(!!:. 1)

n

2'

Ersetzt man die natürlichen Zahlen m, n durch positive reelle Zahlen r, s > 0, so erhält man die (zentrale) F -Verteilung mit reellen Freiheitsgraden r, s

r,s

(3)

1.

Gam(I...2' 1)

r

Fr,s

für unabhängige Gam(~, l)und Gam(~, 1).

1. Gam(~ 1)

2'

S

Die F -Verteilung besitzt eine Dichte cp ,die nur auf dem positiven Bereich

r~

r~

(0,00) von Null verschieden ist, und dort gegeben ist durch

d

. ~1 (rx

(5)

cpr/

, x)

(6)

P=2'

(7)

dr,s = "p sq. r(p+q)

r,s

r

+ s)-(p+q)

>

°

q=2..

mit

und

2

r(p)· r(q)

Die F- Verteilung läßt sich in eine Beta-Verteilung transformieren und umgekehrt.

Für die streng wachsende Funktion g: (0, (0)

-----+

(0,1)

G. Osius: Die F- Verteilung

(8)

1

1 + s/(rx)

rx

rx + s

g(x)

V3-4

8.7.10

ergibt sich

(9)

rFrs,

r Frs, + s

g(Fr,s)

1

1 + s/(r Fr ,s)

Insbesondere läßt sich die Verteilungsfunktion <P

(10)

<P

r,s (x):= P{Fr,s <x}

P{Frs>x}

,

r,s

'""-'

B(p, q) .

von F

r,s

wie folgt berechnen

P{ B(p, q) < g(x)} = I(g(x) p, q)

1

P{B(p,q) >g(x)} = I(l-g(x)lq,p)

mit 1(-1 p, q) als unvollständiger Beta-Quotienten-Funktion (vgl. Exkurs Beta-Vertei-

lung).

Die nichtzentrale F- Verteilung

3.3

Sind U und V unabhängige reelle Zufallsvariablen mit den Verteilungen

2

L(U) = Xm

(8),

(1)

so heißt die Verteilung des Quotienten

F =

(2)

lU

m

lV

n

eine (doppelt) nichtzentrale F- Verteilung mit dem Zähler- und Nenner-Freiheitsgrad m

und n, sowie den Zähler- und Nenner-Nichtzentralitäten 8 und c, die mit F

m,n

(8, c) be-

zeichnet wird:

(3)

Fm,n (8,c) = L(F) = L((lU)j(lV)).

m

n

Die F

m,n

(8, c)-Verteilung läßt sich suggestiv auch schreiben als

1

(4)

F

m,n

(8,c) =

2

(8)

X

;:

m

lX (c)

2

n n

Speziell für c = 0 ergibt sich die (einfach) nichtzentrale F

m,n

Nichtzentralität 8

2

für unabhängige Xm (8) und X n (c).

(8)-Verteilung mit der

G. Osius: Die F- Verteilung

(5)

2

Fm,n (8) = Fm,n (8,0) =

m,n

F

m,n

Die Dichte cp

cp

nf

2

m

= F

m,n

-Verteilung

(0) = F m,n (0,0).

s: von F

m,n,u,e

2

für unabhängige Xm (8) und Xn .

Und für 8 = c = 0 erhält man die zentrale F

(6)

V3-5

8.7.10

m,n

2

(8,c) läßt sich unter Verwendung der Dichten cp

s: und

m,u

von X (8) und X (c) angeben:

n

00

(7)

J mnv'cpm,us:(mvx)·cpn,e (nv)

cpm,n,u,e

s: (x) =

(8)

s: von X2 (8) zu

m,u

P

>

für

0

x> O.

o

Und die Verteilungsjunktion P

funktion P

dv

s: von F

m,n,u,e

m,n

(8,c) ergibt sich mit der Verteilungs-

m

m,n,b,e

(x)

P{ Fm,n(8,c) <x}

00

oJ n·P m, b(mvx).cpn,e (nv) dv

für

x> O.

Bei Vertauschen beider Freiheitsgrade und Nichtzentralitäten ergibt sich

(9)

1

Fn ,m(c,8) = F

(8 c)

m,n '

(10)

P

n,m,e,b

(x)=l-P

(1)

für x

m,n,b,e x

> 0,

m=8

n = 16

8 = 0, 1, 2, 4

0.5

o. 0 ~--r---r---r----r----r-----r-----r~---,-.----r--..----r--~--r---r---r----,

o

Dichten der F

m,n

1

(8)- Verteilung jür

2

m = 8)

3

n = 16 und verschiedene Nichtzentralitäten 8.

G. Osius: Die F- Verteilung

V3-6

8.7.10

Für den Zähler-Freiheitsgrad m = 1 erhält man folgenden Zusammenhang zur

nichtzentralen t- Verteilung:

(11)

F1,n (8,c)=t2n (j6,c).

Im Zusammenhang mit Schärfebetrachtungen von Tests sind folgende MonotonieEigenschaften der Verteilungsfunktion von Interesse:

(12)

p

s:

m,n,u,e

(x) ist

• streng wachsend in xE (0,00),

• streng wachsend in c> 0

für x> 0,

8 >0

für x> o.

• streng fallend in

(13)

p

s:

(~) ist für x>O streng monoton fallend in mElN.

m,n,u,e m

Für 8 ---+ 00 bzw. c ---+ 00 ergeben sich mit 1.2 (17) folgende Grenzwerte

(14)

F

P

(8,c) -------+

00

(15)

F

(8,c)

n,m

n,m

p

-------+

0

für 8 ---+ 00,

für c ---+ 00,

und somit insbesondere

(16)

p

p

s:

m,n,u,oo

m,n,oo,e

(x) = 1

für x >0,

(x) = 0

für x

> O.

G. Osius: Die F- Verteilung

3.4

V3-7

8.7.10

Approximationen der nichtzentralen F- Verteilung

Nach Severo & Zelen (1960, Biometrika 47, 411-416) läßt sich die Verteilungsfunktion

P

s: der (einfach) nichtzentralen F

(8)-Verteilung wie folgt durch die Verteim,n,u

m,n

lungsfunktion P von N(O,l) approximieren:

(1)

Pm,n,D (x) ~

p( u I JV)

mit

u = (1-~n)wl/3_(1-a),

a =

v = a

2 (m + 28)

9(m+8)2 '

2 3

+ 9n

2 w /

'

mx

m+8

w =--

Tiku (1966, Biometrika 52, 415-427) gibt eine Approximation der (einfach) nichtzen-

tralen F (8)-Verteilung durch eine zentrale F- Verteilung

m,n

(2)

[Fm,n (8)

+ c] /

b ~ Fr,n

(three-moment central-F approximation)!

wobei der reelle Freiheitsgrad r und die Parameter b, c so gewählt sind, daß die ersten drei Momente der beiden Verteilungen in (2) übereinstimmen:

(3)

r

~(n-2) h/1/(1-4K3IH2) -1],

(4)

b =

r·H

m K (2r + n - 2) ,

(5)

H= 2(m + 8)3

c =

n (b -1- 151m)

n-2

mit

+ 3 (m + 8)(m + 28)(n- 2) + (m + 38)(n- 2)2 ,

K= (m + 8)2 + (n- 2)(m + 28) .

Die Three-moment central-F approximation ist nach Tiku (1966, Biometrika 53, 606-610)

genauer als die Normalapproximation (1). Aus (2) ergibt sich nach 3.2 (10) folgende

Approximation der nicht-zentralen F (8)-Verteilungsfunktion durch die Verteim,n

lungsfunktion einer Beta-Verteilung bzw. durch die unvollständige Betaquotienten-Funktion I

(6)

(7)

P m,n, D(x) = P{Fmn

, (8) < x}

,.....,

,.....,

p{ B(%,%) < u}

I(ul%,%)

bzw.

P{Fmn

, (8) > x}

,.....,

,.....,

p{ B(%,%) > u}

I(l- u l%,%)

mit

u

1

l+ nbl(r[x+c]) ,

1- u

1+

1

r[x+c]/(nb)

Beweise zu: Chiquadrat-Verteilung

B V 1-1

11.8.06

Beweise zu:

1.1

Die zentrale Chiquadrat-Verteilung

Wir geben hier nur kurz die Beweisidee an, auf deren Grundlage man leicht einen

vollständigen Beweis erarbeiten kann. Die Reihenfolge entspricht hierbei aus beweisökonomischen Gründen nicht der Darstellung im Text.

Die Aussagen

(9)

(12)

für

x> 0,

2

xm

und x2 stochastisch unabhängig ::::}

n

sind bereits als Spezialfälle für 8 = 0 im Abschnitt 1.2 enthalten als

1.2 (10)

<P1 6(x) = <P( JX-/6)

-

<P( -JX- J6)

für

x>O,

'

1.2 (8)

und werden dort bewiesen.

Beweis von:

(5)

für

x> 0,

Der Beweis erfolgt durch Induktion über den Freiheitsgrad n. Der Induktionsanfang

n = 1 ergibt sich durch Differenzieren von (9). Und der Induktionsschritt n r----+ n + 1

verwendet (12) für m = 1 und n + 1 statt n.

Beweis von:

(10)

2

xl·a

'

(10) folgt direkt aus (9).

für 0 < a

< 1.

Beweise zu: Chiquadrat-Verteilung

11.8.06

B V 1-2

Beweis von:

(11)

Der Beweis erfolgt durch Induktion über den Freiheitsgrad n. Der Induktionsanfang

n = 1 verwendet das 2. und 4. Moment der Standard-Normalverteilung

E(N(0.1)

2

)

= 1,

Und der Induktionsschritt ergibt sich aus (12) in Verbindung mit den Rechenregeln

über Erwartungswert und Varianz.

Beweis von:

(13)

(x~-n)jy"'n ~ N(0,1)

für n ---+ oo ,

(14)

x~/n

für n ---+ oo .

_P----+ 1

(13) bzw. (14) folgen direkt aus der Darstellung (1) in Verbindung mit dem Zentralen Grenzwert bzw. dem Gesetz der großen Zahlen.

Beweise zu: Chiquadrat-Verteilung

B V 1-3

11.8.06

Beweise zu:

1.2 Die nichtzentrale Chiquadrat-Verteilung

Beweis von:

Dann hängt die Verteilung der Quadratsumme

nur noch über die sogenannte Nichtzentralität

(3)

2

8 = II llll = Jli

+... + Jl~

vom Vektor Jl = (Jll' ... ,Jln) der Erwartungswerte ab.

2

Zu zeigen ist, daß L(IIU 11 ) nur über 8 von Jl = (Jll' ... ,Jln) abhängt, wobei für Jl = 0

bzw. 8 = 0 nichts zu zeigen ist. Sei also Jl :;= 0. Wir zeigen erst, daß die Verteilung

von IIU 11 2 invariant ist gegenüber einer einer orthorrormalen Transformation. Für

eine orthorrormale Matrix C gilt

(i)

ccT = 11

also

IICUII2 = urcrcu = uru = IIUII2

(ii)

2

2

L(IIUII ) = L(IICUII ).

d.h.

n

und somit

Es genügt daher ein geeignetes C anzugeben, für das die Verteilung von CU nur

noch über 8 von Jl abhängt. Hierzu ergänzen wir den normierten Vektor ji

= llllii-1Jl

zu einer Orthonormal-Basis des IR n und betrachten die orthorrormale Matrix C deren Zeilen diese Orthonormal-Basis bilden. Da ji die erste Spalte von CT ist, folgt

für den ersten Einheitsvektor e = (1, 0, ... , 0)

1

(iii)

C -1 e 1 =

cT e

1

= ,,_-

bzw.

r

Die zentrierten Variablen

(iv)

Z. = U.- Jl·

z

z

z

mit

L(Z.)

= N(O, 1),

z

sind ebenfalls stochastisch unabhängig und daher gilt

(v)

L(Z) = N n (0, 11 n )

Aus der Darstellung

sow1e

L(CZ) = N n (0, CCT) = N n (0, 11 n )

Beweise zu: Chiquadrat-Verteilung

B V 1-4

11.8.06

(vi)

vgl. (iii)

ergibt sich dann mit (v), daß L(CU) nur noch über

IIJ.LII = J6 von J.L abhängt.

D

Beweis von (8)

Für stochastisch unabhängige reelle Zufallsvariablen V1' ... ,Vm' U1'" .. ,Un mit

L(V.) = N(.A.,1)

für j = 1, ... ,m.

L(U.)z = N(p,.,1)

z

für i = 1, ... ,n

J

J

gilt nach Definition der x2- Verteilung

Da I U

IIJ.LII 2,

mit

8=

mit

"f=II-AII 2 ,

mit

T

= IIJ.LII 2 + II-AII 2 = -A+8.

1 2 und I V 1 2 stochastisch unabhängig sind, folgt hieraus (8).

D

Beweis von (10) (11)

(10)

<P1 6(x) = <P( JX-/6)

-

<P( -JX- J6)

für x> 0,

'

Für x>O gilt:

P{xi(8)<x}

2

= P{N(J"6,1) < x}

= P{IN(J6))1

< Jx}

= P{-JX <N(J6,1) <)X}

=

P{ -JX -J6 <N(0,1) <

Jx -J6}

= <P(Jx -J6)- <P (-JX -J6).

Also gilt (10), und (11) ergibt sich durch Differenzieren von (10) für x> 0

D

Beweise zu: Chiquadrat-Verteilung

B V 1-5

11.8.06

Beweis von:

(12)

x~ (8) und x~_ 1 unabhängig

=?

xi (8) + X~+ 1 = X~ (8) .

Dies ist ein Spezialfall von (8).

D

Beweis von:

00

1 cp18(x-y)·cpn-1(y)dy

(13)

0

für x > 0, n > 1,

>0

'

00

1 p 1 8 (x- Y)

(14)

0

für x > 0, n > 1.

· cp n-1 ( Y) dY

'

Beide Integraldarstellungen folgen direkt aus der Faltungseigenschaft (12).

Die Ungleichung cp ,

n,u

> 0 auf dem Intervall (O,oo)

vgl. (11),

folgt aus den Ungleichungen

cpn-1

> O,

vgl. (15),

die ebenfalls beide auf dem Intervall (O,oo) gelten.

D

Beweis von:

(15)

P , ist streng wachsend auf (O,oo).

n,u

Die Behauptung folgt sofort aus cp ,( x) > 0 für x> 0, vgl. (13).

n,u

Beweis von:

(16)

P n 8(x) = P{x~(8) < x}

'

ist streng wachsend in x> 0

und streng fallend in 8> 0 für x > 0.

Der Beweis erfolgt durch Induktion über den Freiheitsgrad n.

Induktionsanfang: n = 1

Wegen

(i)

xi(8) =

2

N(c:,1) mit c: =

Pn,8(z

2

)

J6 ergibt sich für z =

2

P{xi (8) < z

}

P{ -z < N(c:,1) < z}

<I>(z-c:)- <1>(-z-c:).

JX>O:

D

Beweise zu: Chiquadrat-Verteilung

B V 1-6

11.8.06

Differenzieren nach z bzw. c liefert mit cp = P 1 :

(ii)

8~

(iii)

2

;e p1 78(z )

P1,8( z

2

cp(z-E)

)

+ cp(z-E) > 0

- cp(z-E)

da cp> 0,

+ cp( -Z-E)

da cp symmetrisch.

- cp(lz-cl) + cp(lz+cl)

Für c > 0 gilt

-(z+c) < z-E <z+c

und somit

wobei die Gleichheit gerrau für c = 0 gilt. Da cp auf der positiven Achse (0, oo)

streng monoton fallend ist, folgt

(iv)

bzw.

wobei die Gleichheit gerrau für c = 0 gilt. Folglich ist P

sogar streng fallend für c > 0, also auch streng fallend in c

Und wegen (ii) ist P

16

16

(z2 ) fallend für c > 0, und

>0 und in 8

=

c2 .

(z2 ) streng wachsend in z > 0, also auch in x = z2 .

'

lnduktionsschritt: n

f-----t

n+ 1

Da X~t ( 8) die Faltung von

1

(v)

xi( 8) und X~ ist, gilt folgende Darstellung

i

P n+ 1, x) = P { U + V

< x}

= P { U < x- V} ,

wobei U, V stochastisch unabhängige Zufallsvariablen sind mit

L(V) = x2n .

Die Dichte cp von V ist nach Induktionsvoraussetzung (für 8 = 0) positiv auf (O,oo ),

n

und es gilt

X

P{U< x-V}

1 cpn(v) · P{U<x-v} dv

0

X

1 cpn(v) · <I> 1,8 (x-v) dv.

0

Der Integrand ist für 0

send in x

send in x

<v<x

positiv und nach Induktionsanfang streng wach-

> 0 und streng fallend in 8 > 0. Damit ist auch das Integral streng wach> 0 und streng fallend in 8 > 0, und (16) ist für n + 1 gezeigt.

D

1108006

Beweise zu: Chiquadrat-Verteilung

B V 1-7

Beweise zu:

1.3 Grenzwertsätze und Approximationen

Beweis von:

(1)

N(O, 1),

n---+ oo

V2(n + 28)

Anwendung des Zentralen Grenzwertsatzes auf die zentrierte Dreiecksfolge Xnk mit

k = 1, 000, no

für

Wegen

a~ := Var(Xn1 )

und

E(X~ 1 ) = 48(n-4%) + 12(n+2%)

=

2(1 + 2%)

2

n---+oo

2

48n + 12 n 2

n---+ oo

ist die Ljapunov-Bedingung erfüllt (vgl. Exkurs Der Zentrale Grenzwertsatz für reelle

Zufallsvariablen, 2. Kriterium 2) und somit folgt (1), weil

Var(Xn+) = 2(n + 28) 0

D

Beweis von:

(3)

c

=

n + 28

n+8

V=

+ 8) 2

n + 28

(n

Gleichsetzen der ersten beiden Momente von x~ (8) und Garn ( ~, 2 c) liefert:

(i)

(ii)

E{Gam( ~,2c)},

cv

Var{x~ (8)} =

2(n + 28)

2vc

2

= Var{Gam( ~,2c)}

0

Einsetzen von (i) in (ii) ergibt 2(n + 28) = 2 (n+8) c und somit c aus (1)0 Aus (i)

ergibt sich weiter v = (n+8)/c und somit v aus (1)0

D

Beweise zu: t- Verteilung

B V 2-1

16.7.10

Beweise zu:

2.1 Die zentrale t- Verteilung

Beweis von:

(15)

cpn (x) = cp(x)

lim

n---+oo

Für festes x E IR ist für n

---+

für alle xE IR.

oo zu zeigen

Nun ist

cpn (x)

(21r)- 1/ 2 · b (c d )-1/ 2

bn

r ( n~1 ) [ r ( ~ )

cn

( 1 + ~x2r

dn

(1+ ~x

2

2

0

~l-1

).

d

für n---+ oo

Aus

c ---+ exp { x },

n

folgt

( c d )-1/2 -----+ exp {- 12 x2},

n

mit

n n n

n

---+

1

n

und für (i) bleibt nur noch zu zeigen

(ii)

b

n

-----+

1

für n ---+ oo .

Setzen wir z = ~ , so ist

Wir zeigen jetzt allgemeiner

(iii)

log T(z

+ ~)-log T(z)-

~ log(z)-----+ 0

für z---+ oo

woraus sich sofort log b ---+ 0 und somit (ii) ergibt. Der Nachweis von (iii) verwenn

det folgende Variante der Stirlingschen Formel- vgl. z.B. Abramowitz & Stegun (1970),

Handbook of Mathematical Functions, 6.1.40, p. 257) für z---+ oo:

(iv)

log T(z) = (z- ~) log(z)- z

Entsprechend ist

+~

log(27r)

+ o(1).

Beweise zu: t- Verteilung

B V 2-2

1607010

und somit folgt

+ ~) -log T(z) z [ log (z + ~ ) - log (z)] log T(z

~ log(z) =

~

+ o (1)

und für (iii) bleibt zu zeigen

(v)

z[log(z + ~) -log(z)]-----+ ~

für z---+ ooo

Nach dem Mittelwertsatz gibt es zu jedem z ein ~(z) E (z, z + ~) so daß

~) -log(z)

(vi)

log(z +

Wegen

z < ~(z) < z + ~

folgt

<

z

z

+ 1/2

_z_

~

(z)

=

~ ~~z)

<

...!.._

0

z

0

1.

Zusammen mit (vi) ergibt sich daher

1..

2

z/

0

z+ 1

2

< z (log (z + 12 ) -

log( z))

<

1

2

0

Wegen

z

z +1/2

folgt hieraus (v)o

für z---+ oo

D

Beweise zu: t- Verteilung

B V 2-3

1607010

Beweise zu:

2.2 Die nichtzentrale t- Verteilung

Beweis von:

00

(7)

cpn,'"'(,D (X)

1 2nw 2

0

(8)

p n,'"'(,D(x)

P{tn ( ')', 8) < x}

0

cp( wx -')') cp

0

n,cp

00

1 2nw

0

0

<!>( wx -')') cp

0

n,cp

(nw 2 ) dw

>

0

(nw 2 ) dw

für xEIRO

für xEIR

0

Die Verteilungsfunktion von W =~ergibt sich aus der von V bzwo x2 ( 8) mit

n

<~>w(w) = P{W<w} = P{V<nw 2 } = Px;(nw 2 )

für w>O,

und für die Dichte von W folgt

für w> 00

(i)

Zusammen mit der Dichte von U

für uEIR,

(ii)

ergibt sich daher die Dichte des Quotienten T= U /W (vgl. zo B. Skripte zur Stochastik

6.3 oder zur Maß- und Wahrscheinlichkeitstheorie 14)

00

cpT(x) =

1 wocpu(wx) ocpw(w) dwo

0

Mit (i) und (ii) ergibt sich hieraus (7), und (8) erhält man aus (7) wie folgt:

X

1 cpn,'"'(,D(t) dt

Pn,'"'(,D(x) =

-00

X

00

1 1 2nw 2

-00

0

J2nw 20

0

(

0

cp( wt -')') cp n,cp (nw 2 ) dw dt

0

Jcp(wt-')')dt) ocpn,cp (nw 2 )dw

-00

00

1

2nwo<I>(wx-'Y)ocp (nw 2 )dwo

0

n,cp

D

Beweise zu: t- Verteilung

B V2-4

16.7.10

Beweise von:

(9)

P n,'"'(, 8 ( x) ist streng monoton wachsend in xE IR,

(10)

P n, , 8 ( x) ist streng monoton fallend in 'Y E IR,

1

(11)

P n,'"'(, 8 ( x) ist für x > 0 streng monoton wachsend in 8> 0,

Nach Definition der t (')',8)-Verteilung gilt folgende Darstellung

n

(i)

Pn,'"'(,u,(x) =P{tn ('Y,8)<x}

=P{Z+'Y<Vx},

wobei Z, V stochastisch unabhängige Zufallsvariable sind mit

L(Z) = N(O))

Mit den Dichten cp bzw. f von Z bzw. V ergibt sich daher

(ii)

<!>

,(x) =P{Z<Vx-'Y}

n,'"'(,u

J

f(v)·cp(z)d(v,z)

{z::::;vx-1}

VX-'"'(

00

=

J(f(v)· J

0

cp(z)dz)dv

-00

00

=

J (f(v)·<I>(vx-'Y))dv.

0

ad (9-10}: Der Integrand f( v) · P (vx- 'Y) ist für jedes v > 0 positiv und

• streng wachsend in x,

• streng fallend in ')',

weil P streng wachsend ist. Damit hat auch das Integral P

,( x) dieselben Mono-

n,'"'(,u

tonie-Eigenschaften, d.h. (9) und (10) gelten.

ad {11):

Wir integrieren wir in (ii) erst über z und dann über

00

(iii)

J cp(z)·(

-oo

J

f(v)· dv)dz

{z::::;vx-1}

00

J cp(z) ·P{z<Vx-'Y} dz

-oo

v

Beweise zu: t- Verteilung

Nun ist für z >-

B V 2-5

16.7.10

r bzw. z + r > 0

P{z<Vx-r} = P{V>(z+r)/x}

=

P{ n V 2 > n(z + r) 2j x 2}

=

P{x~(8) > n (z + r) 2/ x 2}

= 1-<P n u,(h(z))

7

für z>-r

und <P , als Verteilungsfunktion von x2 (8).

n,u

n

Und für z <-

r bzw. z + r < 0 ist

P{z<Vx-r} = P{V>(z+r)/x}

1

für z <- ')'.

Damit ergibt sich aus (iii)

-'"'(

<P n,'"'(,u,(x) =

1

00

1 <p(z) ·(1-<Pn,8(h(z)))

<p(z) dz +

-oo

dz

-'"Y

00

+

<P(-r)

1 <p(z) ·(1-<Pn,8 (h(z)))

dz

1

-'"Y

und für (11) bleibt nur zu zeigen, daß das Integral

00

1 <p(z) ·(1-<Pn,8(h(z)))

dz

-'"Y

für x > 0 streng wachsend in 8 ist. Und dies ergibt sich daraus, daß der (positive) In-

tegrand <p(z) ·(1-<P n u,(h(z))) für z>-8 und somit h(z)>O nach 1.2 (16) streng

7

wachsend in 8 ist.

D

Beweise von:

p

± oo

(13)

tn (')', 8)

(14)

tn (')',8) ~ 0

-----+

für 1'---+

± oo,

für 8---+ oo.

Die Behauptungen ergeben sich mit Exkurs KV 11 (1) und (5) aus

N(r,1) ~ ± oo

für 1' ---+ ± oo

x2n (8) ~ oo

für 8 ---+ oo ,

vgl. 1.2 (17).

D

Beweise zu: t- Verteilung

B V 2-6

16.7.10

Beweise zu:

2.3 Approximationen der nichtzentralen t- Verteilung

Beweis von:

(3)

sn ·-- ~

n n

(6)

(S -p, )ja

n

n

n

(7)

I-Ln

p

1

n---+ oo

L

n---+ oo

N(O, 1)

= (1+~//2

n

'

mit

a

2n

-

1.(1.+1)

n 2

n

Ausgangspunkt für (6) ist die asymptotische Normalverteilung von

s2 = 1. 2 ( 8)

n

(i)

c

z

c

n

(5 2-z )

n

n

L

n---+ oo

2

E(Sn )

n

n

d.h. (vgl. 1.3 (1))

nxn

= Var(s

1.(n+8)

n

r

2 112

n

N(O, 1)

n (2n + 48f1/ 2 =

mit

1+1

n

Vn (2 +

n---+ oo

~ 8f1/2

n---+ oo

1'

00

Für die Transformation F(x) = x1/ 2 mit F'(x) = ~ x - 1/ 2 ergibt sich aus (i) mit der

Delta-Methode (vgl. Exkurs Konvergenz nach Verteilung in euklidischen Räumen, Ab-

schnitt 14)

(ii)

cn(S;;p,n)

1-L

n

n:oo

F'(1) ·N(0,1)

N(o, ~)

mit

= z1/2 = (1 + 1)1/2 .

n

n

Hieraus erhält man (6) mit

Aus (ii) folgt mit c ---+ oo und p, ---+ 1 auch (3).

n

n

D

Beweise zu: t- Verteilung

B V 2-7

16.7.10

Beweis von:

(9)

mit

u

Für W '"'"'"'N(p, 1 a 2 ) stochastisch unabhängig von U'"'"'"' N('Y, 1) ergibt sich

n

n n

(i)

<I>

,(x) = P{ U/ Sn < x}

n, "(,u

~ P{U/Wn<x}

vgl. (8)

Wegen

folgt

P { U- x W n

< 0}

Xf-Ln -

u =

Mit (i) ergibt sich (9).

"(

wobei

= <!>( u)

X~

-

"(

D

Beweise zu: F- Verteilung

B V 3-1

8.7.10

Beweise zu:

3.1 Die zentrale F- Verteilung

Beweise von:

(5)

mit

1

1

(6)

p =2m,

(7)

P q F(p+q)

dm,n- m n . r(p). r(q).

und

q=2n

Vgl. den Beweis von 3.2 (5) für r = m und s = n.

D

Beweise von (10)-(18 ) fehlen noch!!!

Beweis von (19) unter Verwendung von 3.3 (13)

(19)

m ·F

m,n;o:

ist für 0 < a

< 1 streng monoton wachsend bzgl. mE W.

Für 1 < k < m ist zu zeigen

(i)

k·Fk,n;o: <m·Fm,n;o: .

Mit x = m · F

m,n;o:

> 0 ergibt sich

1- a = Pmn (Fmn·o: )

'

' '

nach 3.3 (13) mit 8=c:=0.

Da mit Pk

,n

auch Pk-1 streng monoton wachsend ist, folgt weiter

,n

1

Fk ,n,o:

. = P-k ,n (1- a)

< ;;

r;;

d.h. (i) gilt.

D

Beweise zu: F- Verteilung

B V 3-2

8.7.10

Beweise zu:

3.2 Die F- Verteilung mit reellen Freiheitsgraden

Beweise von:

(x) = d · ~ 1 (rx

r,s

(5)

cp

(6)

p = ~ r,

(7)

dr,s -

r,s

'I

0

mit

q= ~ s

v q

-

+ s)-(p+q) >

s

0

und

r(p +q)

r(p) r(q) '

0

Für stochastisch unabhängige X"' Gam(p, 1) und Y"' Gam(q, 1) mit Dichten

_ 1 p-1 -X

f X (X) - F(p) X e ,

(i)

f Y (Y) -

q-1 -y

1

r(q) Y

e

'

ergibt sich die Dichte des Quotienten Z =X/ Y zu (vgl. Skript ,,Stochastik", Kap. 6.3)

00

fz(z) =

J y -fx(zy) -fy(y) dy

0

00

1

r(p) . r(q) z

p- 1

J

o Y

p+q- 1 -y(1 +z) d

e

Y

Substitution:

1

y = (1+zr u

1

dy = (1+zr du

00

1

r(p) . r(q) z

p-1 (

1+ z

J u p+q-1 e-u du

)-p-q

u = y(1+z)

0

r(p + q) zP- 1(1 + zr(p+q)

r(p) · r(q)

Die Dichte von F

für z

>0

0

1

r,s

= (Xjp)j(Yjq)) = qp- Z ist daher (vgl. z.B. Skript ,,Stochastik",

Kap. 4.4)

cp

r,s

(x) = pq-1-f(pq-1x)

r(p + q)

-1 ( -1 )p-1 ( 1 + -1 )-(p+q)

r(p) . r(q) P q . P q x

Pq x

F(p+q) JJ -p. J!-1( -1( + ))-(p+q)

r(p) . r(q) Y q

q q Px

r(p + q) JJ q. xP-1( + ) -(p+q)

r(p) . r(q) Y q

q Px

r(p + q) (2p)P (2q)q. xP- 1(2q + 2p x) -(p+q)

r(p). r(q)

da r = 2p, s = 2q.

D

Beweise zu: F- Verteilung

B V 3-3

8.7.10

Beweise von:

(9)

g(Fr,s)

1

1 + sj(r Fr 8 )

rFrs

r Frs + s

'

,.....__

B(p, q).

'

Wir knüpfen an den Beweis von (5) an.

Aus

XjY = Z = pFr,s jq

folgt

g(Fr,s)

1

rFr,s / s

1

1 + sj(r Fr 8

'

)

1+ Y/X

X

X+Y

,.....__

B(p, q).

D

Beweise zu: F- Verteilung

B V 3-4

8.7.10

Beweise zu:

3.3 Die nicht-zentrale F- Verteilung

Beweise von:

00

(7)

cpmn 8 e(x) =

' ' '

(8)

<[>

1 m n v · cpm,u,(m v x) · cpn,e (n v) dv > 0

für x > 0.

0

(x)

m,n,87e

00

1 n·Pm, 8 (mvx) ·cpn,e (nv) dv

für x

> 0.

0

(9)

(10)

Fn,m (c:,8) = F

<[>

1

(b c)

m,n '

(x)=1-P

(l)

n7m7e78

m,n,87e x

für x

> 0,

(11)

Die Dichte und Verteilungsfunktion von X =.l U und Y =.l V ergeben sich aus (1):

m

n

(i)

x> 0,

fx(x) = m cpm,im x),

FX(x) =<I> m,im x)

für

fy(Y) = ncpne(ny),

Fy(Y) = <I> n e (n y)

für y > 0.

7

'

Hieraus erhält man die Dichte und Verteilungsfunktion des Quotienten F=X/Y

(vgl. z.B. Skript zur Stochastik 6.3)

00

(ii)

für

X

(iii)

<[>

m,n,8,e

(x)

x> 0

oo

1 1 v-fjvw) -fy(v) dv dw

für x > 0

0 0

l'[!

fjvw) v dw ]!y(v) dv

00

1 Fjvx) -fy(v) dv

0

Mit (i) ergeben sich (7) und (8) aus (ii) und (iii). (9) ergibt sich aus (4). (10) folgt aus

(9), da g(x) = 1/x eine streng fallende Funktion in x > 0 ist. Und (11) ergibt sich durch

quadrieren aus 2.2 (4).

D

Beweise zu: F- Verteilung

B V 3-5

807010

Beweise von:

(12)

P

,

m 7n 7u7e

(x) ist • streng wachsend in xE (O,oo ),

• streng wachsend in c > 0

• streng fallend in

Nach Definition der F

m,n

<!>

8

(8,c)-Verteilung gilt für

x> 0,

für x> 00

für

>0

x> 0 folgende

Darstellung

P{Fm,n (8,c) < x} = P{U < Vx},

, (x) =

m 7n 7u7e

wobei U, V stochastisch unabhängige Zufallsvariable sind L( U)

L( ~ V)

= x~( c )0 Mit der Dichte f von V ergibt sich

xm2 (8)

und

00

J f(v)

Pm,n,D,e (x) =

0

P{U<vx} dv

0

0

00

J f(v)

2

0 P{xm(8)

< vx} 0 dv

0

0

Für v > 0 ist f( v)

> 0 nach

1.2 (13) und somit ist auch der Integrand

>0

0

Nach 1.2

2

(16) ist der Integrand f( v) P{x m

( 8) < vx} und damit auch das Integral P

, (x)

m 7n 7u7e

streng wachsend in x > 0 und streng fallend in 80

0

Die Monotonie von P

nie bzgl. 80

, (x) bzgl. c folgt mit (10) aus der eben gezeigten Monoto-

m,n,u7e

D

Beweise zu: F- Verteilung

B V 3-6

807010

Beweis von:

(13)

<[>

(~)

ist für x > 0 streng monoton fallend in m E W

m,n,87e m

0

Für 1 < k < m und x > 0 ist zu zeigen

(i)

<[>

m,n,87e (~)<<!>

m

k,n,87e (~)0

k

Seien U, V, W stochastisch unabhängige Zufallsvariable mit folgenden Verteilungen

(ii)

L( U) = x~( 8),

L(V) =

x~-k'

L(W) = x~(c)jno

Wir setzen

(iii)

X

U/k

(iv)

y

(U+ V)/m

w

w

mit

L(X) =Fk ,n, 8 e ,

7

mit

L(Y) = Fm,n, 8 e

7

°

Dann gilt

(v)

<[>

(_E_)

P{kX <x}

k,n,87e k

P{U*<x}

(vi)

<I>

, (__E__) =

m 7n 7u 7e m

mit

U* == u jw,

mit

V*:=V/Wo

P{mY<x}

= P{U*+ V*<x}

Die Zufallsvariable U* hat auf (0, oo) eine Dichte f> 0 mit

nach (v),

und somit gilt

(vii)

p { U*

+ V* < X}

X

= J

j( U) p {V* < X- U} dU

o

o

0

Wegen L(V*j(m-k)) = Fm -k ,n, 0 e gilt

7

(viii)

P{V*< x-u} < P{V*< x}

p

(-X ) <

m-knOe m-k

1

für O<u<x,

'''

und somit folgt aus (vii) weiter

X

P{U*+V*<x} < P{V*<x} Jf(u)du = P{V*<x}P{U*<x} < P{U*<x}o

0

Zusammen mit (v), (vi) und (viii) ergibt sich jetzt (i) aus

(ix)

D

MN Die multivariate Normalverteilung

Gerhard Osius

1.

Die eindimensionale Normalverteilung

2.

Definition der multivariaten Normalverteilung

3.

Eigenschaften der multivariaten Normalverteilung

4.

Quadratische Formen von normalverteilten Variablen

5.

Bedingte Normalverteilungen

6.

Die zweidimensionale Normalverteilung

G. Osius: Multivariate Normalverteilung

1.

17.5.108

MN-2

Die eindimensionale Normalverteilung

Wir gehen aus von den eindimensionalen Normalverteilungen N(p"a 2) mit p,EIR,

17

> o. Für

17 ---+

0 konvergiert N(p"

(7

2

) nach Verteilung gegen die Einpunkt-Vertei-

lung mit Träger {p,}, die wir daher suggestiv mit N(p" 0) bezeichnen und auch als

(degenerierte) Normalverteilung ansehen. Die Klasse aller eindimensionalen Normalverteilungen ist clann

Diese Klasse ist abgeschlossen gegenüber affinen Transformationen und Faltungen,

cl.h. es gilt

JY;:,

cL'( aX + b) E JY;: .

(2)

cL'(X) E

(3)

Für stochastisch unabhängige X ,X gilt

a, bE IR

1

Durch Induktion ergibt sich, daß

JY;:

2

gegen "unabhängige Linearkombination" abge-

schlossen ist, cl.h. es gilt:

(4)

Für stochastisch unabhängige Xl'" ..,X gilt

J

cL'(X) E JY;: für alle j=l, ,J

cL'( t 1Xl

=*

+ + tJXJ ) E JY;:

Die charakteristische Funktion 'Y( -I p" (7 2 ) von N(p"

(5)

(7

2

) ist

für sEIR,

und die Moment-erzeugende Funktion M( -I p,,( 2 ) von N(p"a 2 ) lautet

(6)

für sEIR.

G. Osius: Multivariate Normalverteilung

2.

17.5.108

MN-3

Definition der multivariaten Normalverteilung

Wir geben drei verschiedene Definitionen der multivariaten Normalverteilung und

weisen anschließend deren Äquivalenz nach.

1. Definition: konstruktiv

Die erste Definition ist konstruktiv in dem Sinn, daß die multivariaten Normalverteilungen aus stochastisch unabhängigen (eindimensionalen) Standard-Normalverteilungen N (0,1) konstruiert werden. Hierzu seien Z1' ...,ZJ stochastisch unabhängige

1

Zufallsvariable mit

(0)

L(Zj) = N (0,1)

für alle j = 1, ..., J

1

Für eme beliebige IxJ- Matrix C mit Rang (C) = J < I und beliebiges fL E IRI betrachten wir die affine Einbettung G: IR] ---+ IRI mit

(1)

G(z) = Cz

·· zE IR] .

f ur

+ fL

Fassen wir Z = (Zl' ...,ZJ) Tals J-dimensionalen Zufallsvektor auf, so ist

(2)

X = G(Z) = C z

+ fL

eine I-dimensionale ZV. Die Verteilung von X hängt nur von C und Jl ab und wird

als eine I-dimensionale Normalverteilung vom Rang J wie folgt (vorläufig) bezeichnet

Formal gesehen ist N/fLl C) das Bildrnaß der Verteilung L(Z) unter G. Erwartungswert und Covarianzmatrix von X ergeben sich

(4)

(5)

E = Cov(X) = CC

T

mit

Rang(E) = Rang(C) = J.

Wir erweitern diese Definition noch, indem wir die Einpunktverteilungen auch als

Normalverteilungen vom Rang 0 auffassen und wie folgt bezeichnen

(6)

N/fL I0) = L(X)

falls

P{X=fL} = 1.

Es wird sich noch herausstellen, daß N/fL IC) nur noch über E von C abhängt.

Speziell für C = 11J (Einheitsmatrix), fL = 0 ist X = Z und somit ist

G. Osius: Multivariate Normalverteilung

MN-4

17.5.108

Aus der Verteilungsfunktion P von N( 0,1) ergibt sich sofort die Verteilungsfunktion

PJ und die Dichte cpJ von Z bzw. N/ü 1 11J)

J

(8)

TI

PJ(x) =

p(x.)

j=l

J

J

TI

cpi x )

cp(x.)

j=l

J

= (21r)-J/2. exp{ -

~ x T x}

für x = (xl' ...'xJ ) EIRJ .

2. Definition: Charakterisierung via Linearkombinationen

Die zweite Definition charakterisiert die multivariate Normalverteilung durch die

Verteilungen aller ihrer Linearkombinationen. Formal ist die Klasse

JVf aller I-di-

mensionalen Normalverteilungen definiert.

(9)

cL'(Y) E

JVf

{}

Y ist I-dimensionaler Zufallsvektor mit

cL'(tTy) E~

für alle tE IRI ,

bzw. mit Wahrscheinlichkeits-Maßen formuliert:

(10)

PE JVj

{}

Für jedes tE IRI ist das Bildmaß von P unter t T :IRI

---+

IR aus

~.

Für I-dimensionales Y = (Yl'" ..,Y )T mit cL'(Y) E JVj gilt speziell cL'(Y ) E ~ und

1

i

somit existieren alle Momente von Y. für i = 1, ,... ,1. Damit existieren auch Erwarz

tungsvektor und Covarianzmatrix von Y:

(11)

Jl = E(Y),

E= Cov(Y).

Für beliebiges tE IRI folgt dann

d.h. cL'(tTy) ist für jedes t bereits durch Jl und E festgelegt. Damit ist (nach dem

Eindeutigkeitssatz für mehrdimensionale Verteilungen) auch cL'(Y) bereits durch Jl

und E festgelegt und wird wie folgt bezeichnet

Der Rang der multivariaten Normalverteilung N/Jl,E) ist definiert als der Rang ihrer Covarianzmatrix E, d.h. als Rang (E) .

G. Osius: Multivariate Normalverteilung

MN-5

17.5.108

3. Definition: via charakteristischer Funktion

Die dritte Definition beschreibt die multivariate Normalverteilung durch ihre charakteristische Funktion (kurz: CF). Für beliebiges p, E IRI und eine (I x I) -Matrix E definieren wir eine Funktion "( ( -I p" E) : IRI ---+ <C durch

für tEIRI

(14)

und betrachten die Funktionenklasse

(15)

ß[ = {"(( -1p,E) 1

p,E IRI , E symmetrische, positiv-semidefinite (lxI) -Matrix}.

Nach der dritten Definition heißt eine I-dimensionale Zufallsvariable Y normalverteilt, falls ihre charakteristische Funktion CPy zu der Klasse ß[ gehört.

Äquivalenz der drei Definitionen

Es soll jetzt die Aquivalenz aller drei Definitionen nachgewiesen werden. Zuerst zeigen wir, daß die erste Definition die zweite impliziert, d.h. es ist zu zeigen

(16)

N[(p,1 C)

E

JVj.

Für cL'(X) =Nip,IC) mit X aus (2) und C vom Rang J> 0 ist

tTX = (CTt)T Z + t T p,

für jedes tEIRI .

Nach 1 (4) ist cL'{( CTt) TZ} E JV;:, also auch t TXE JV;:, und es folgt cL'(X) E JVj.

Für cL'(X) = Nip,1 0) ist X Einpunktverteilt in p, und somit ist cL'(t TX) eine Einpunktverteilt in t Tp" die ebenfalls zur Klasse

JV;: gehört. Und damit ist (16) gezeigt.

Als nächstes zeigen wir, daß aus der zweiten Definition die dritte folgt, d.h.

(17)

CPy = "(( -I p"E) E ß r

Hierzu bestimmen wir für beliebiges cL'(Y) = N/p" E) die charakteristische Funktion CPy von Y. Für beliebiges tE IRI ist cL'( t TY) = N (t Tp" t TE t) und unter Ver1

wendung der charakteristischen Funktion CPtTy von tTy gilt

cpt T y(l)

exp {i t TP, - ~ t TE t },